Лайтцера

Обновлено на 2024.12.10 Lightzer-V0.1.0

Английский | 简体中文 (упрощенный китайский) | Документация | Lightzero Paper | Unize Paper | Рецепт бумаги

Lightzero-это легкий, эффективный и простой для понимания инструментарий алгоритма с открытым исходным кодом, который сочетает в себе поиск дерева Монте-Карло (MCT) и глубокое обучение подкреплению (RL). По любым вопросам о Lightzero вы можете проконсультироваться с помощником по вопросам и ответам на основе RAG: Zeropal.

? Фон

Интеграция поиска по дереву Монте -Карло и глубокого подкрепления, примером которого является Альфазеро и Музеро, достигла беспрецедентных уровней производительности в различных играх, включая Go и Atari. Эта передовая методология также добилась значительных успехов в научных областях, таких как прогноз структуры белка и поиск алгоритмов умножения матрицы. Ниже приведен обзор исторической эволюции серии алгоритмов поиска Монте -Карло:

Приведенная выше рисунок - это рамочный трубопровод Lightzero. Мы кратко представляем три основных модуля ниже:

Модель : Model используется для определения сетевой структуры, включая функцию __init__ для инициализации структуры сети и forward функции для вычисления прямого распространения сети.

Политика : Policy определяет способ обновления сети и взаимодействия с окружающей средой, включая три процесса: процесс learning , процесс collecting и процесс evaluation .

MCTS : MCTS определяет структуру дерева поиска Монте -Карло и то, как он взаимодействует с политикой. Реализация MCT включает в себя два языка: Python и C ++, реализованные в ptree и ctree , соответственно.

Для структуры файла Lightzero, пожалуйста, см. Lightzero_file_structure.

? Интегрированные алгоритмы

Lightzero - это библиотека с реализацией алгоритмов MCTS Pytorch (иногда в сочетании с цинтоном и CPP), включая:

- Альфазеро

- Музеро

- Спорный Музеро

- Стохастический музеро

- Эффективно

- Gumbel Muzero

- Рецепт

- Unizer

Среда и алгоритмы, которые в настоящее время поддерживаются Lightzero, показаны в таблице ниже:

| Env./algo. | Альфазеро | Музеро | Спорный Музеро | Эффективно | SAMPLED EFFIFITCERO | Gumbel Muzero | Стохастический музеро | Unizer | SAMPLED UNIZERO | Рецепт |

|---|

| Tictactoe | ✔ | ✔ | | | | ✔ | | ✔ | | |

| Гомоку | ✔ | ✔ | | | | ✔ | | ✔ | | ✔ |

| Connect4 | ✔ | ✔ | | | | | | ✔ | | ✔ |

| 2048 | --- | ✔ | | | | | ✔ | ✔ | | |

| Шахматы | | | | | | | | | | |

| Идти | | | | | | | | | | |

| Кусок | --- | ✔ | | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ |

| Маятник | --- | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ | |

| Lunarlander | --- | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | |

| Bipedalwalker | --- | ✔ | ✔ | ✔ | ✔ | ✔ | | | ✔ | |

| Атари | --- | ✔ | | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ |

| DeepMind Control | --- | --- | ✔ | --- | ✔ | | | | ✔ | |

| Mujoco | --- | ✔ | | ✔ | ✔ | | | | | |

| Минигрид | --- | ✔ | | ✔ | ✔ | | | ✔ | | |

| Bsuite | --- | ✔ | | ✔ | ✔ | | | ✔ | | |

| Память | --- | ✔ | | ✔ | ✔ | | | ✔ | | |

| Sumtothree (бильярд) | --- | | | | ✔ | | | | | |

| Метадрив | --- | | | | ✔ | | | | | |

(1): «✔» означает, что соответствующий элемент закончен и хорошо проверен.

(2): «» означает, что соответствующий элемент находится в списке ожидания (работа в процессе).

(3): «---» означает, что этот алгоритм не поддерживает эту среду.

Установка

Вы можете установить новейший Lightzero в разработке из исходных кодов GitHub со следующей командой:

git clone https://github.com/opendilab/LightZero.git

cd LightZero

pip3 install -e .

Пожалуйста, обратите внимание, что Lightzero в настоящее время поддерживает компиляцию только на платформах Linux и macOS . Мы активно работаем над продлением этой поддержки на платформу Windows . Ваше терпение во время этого перехода очень ценится.

Установка с Docker

Мы также предоставляем DockerFile, который устанавливает среду со всеми зависимостями, необходимыми для запуска библиотеки Lightzero. Это изображение Docker основано на Ubuntu 20.04 и устанавливает Python 3.8, а также другие необходимые инструменты и библиотеки. Вот как использовать наш Dockerfile для создания изображения Docker, запустить контейнер из этого изображения и выполнить код Lightzero внутри контейнера.

- Загрузите Dockerfile : Dockerfile расположен в корневом каталоге репозитория Lightzero. Загрузите этот файл на локальную машину.

- Подготовьте контекст сборки : создайте новый пустой каталог на вашей локальной машине, переместите Dockerfile в этот каталог и перейдите в этот каталог. Этот шаг помогает избежать отправки ненужных файлов в Docker Daemon в процессе сборки.

mkdir lightzero-docker

mv Dockerfile lightzero-docker/

cd lightzero-docker/

- Создайте изображение Docker : используйте следующую команду для создания изображения Docker. Эту команду следует запускать изнутри каталога, который содержит Dockerfile.

docker build -t ubuntu-py38-lz:latest -f ./Dockerfile .

- Запустите контейнер с изображения : используйте следующую команду, чтобы запустить контейнер из изображения в интерактивном режиме с оболочкой Bash.

docker run -dit --rm ubuntu-py38-lz:latest /bin/bash

- Выполните код Lightzero внутри контейнера : как только вы находитесь в контейнере, вы можете запустить пример сценария Python со следующей командой:

python ./LightZero/zoo/classic_control/cartpole/config/cartpole_muzero_config.py

Быстрый старт

Тренируйте агент Muzero, чтобы играть в Cartpole:

cd LightZero

python3 -u zoo/classic_control/cartpole/config/cartpole_muzero_config.py

Тренируйте агент Muzero, чтобы играть в поннг:

cd LightZero

python3 -u zoo/atari/config/atari_muzero_segment_config.py

Тренируйте агента Muzero, чтобы играть в Tictactoe:

cd LightZero

python3 -u zoo/board_games/tictactoe/config/tictactoe_muzero_bot_mode_config.py

Тренируйте агент Unizer, чтобы играть в Pong:

cd LightZero

python3 -u zoo/atari/config/atari_unizero_segment_config.py

Документация

Документацию Lightzero можно найти здесь. Он содержит учебники и ссылку API.

Для тех, кто заинтересован в настройке сред и алгоритмов, мы предоставляем соответствующие руководства:

- Настроить среды

- Настроить алгоритмы

- Как установить файлы конфигурации?

- Система регистрации и мониторинга

Если у вас есть какие -либо вопросы, не стесняйтесь обращаться к нам за поддержкой.

Эталон

Нажмите, чтобы расширить

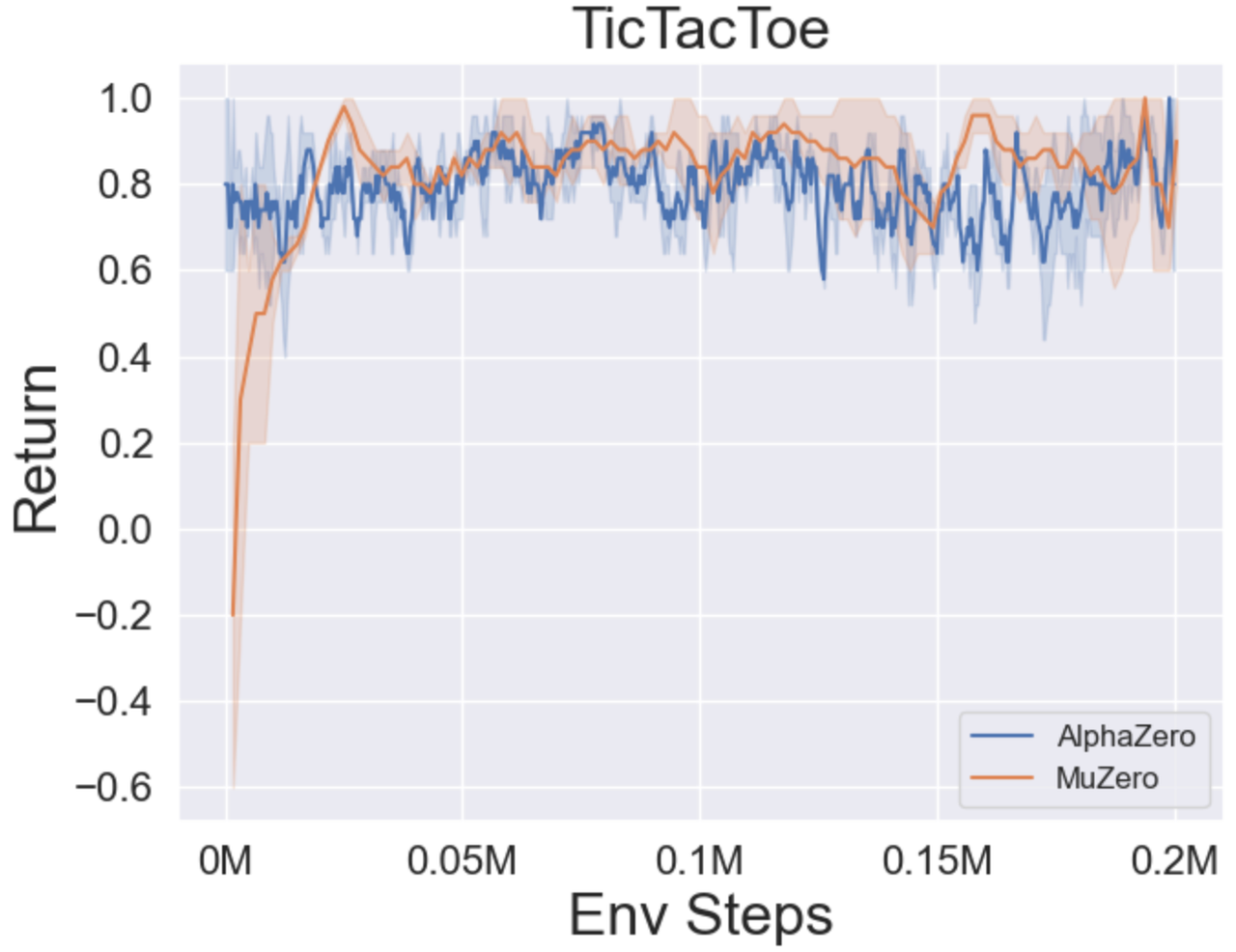

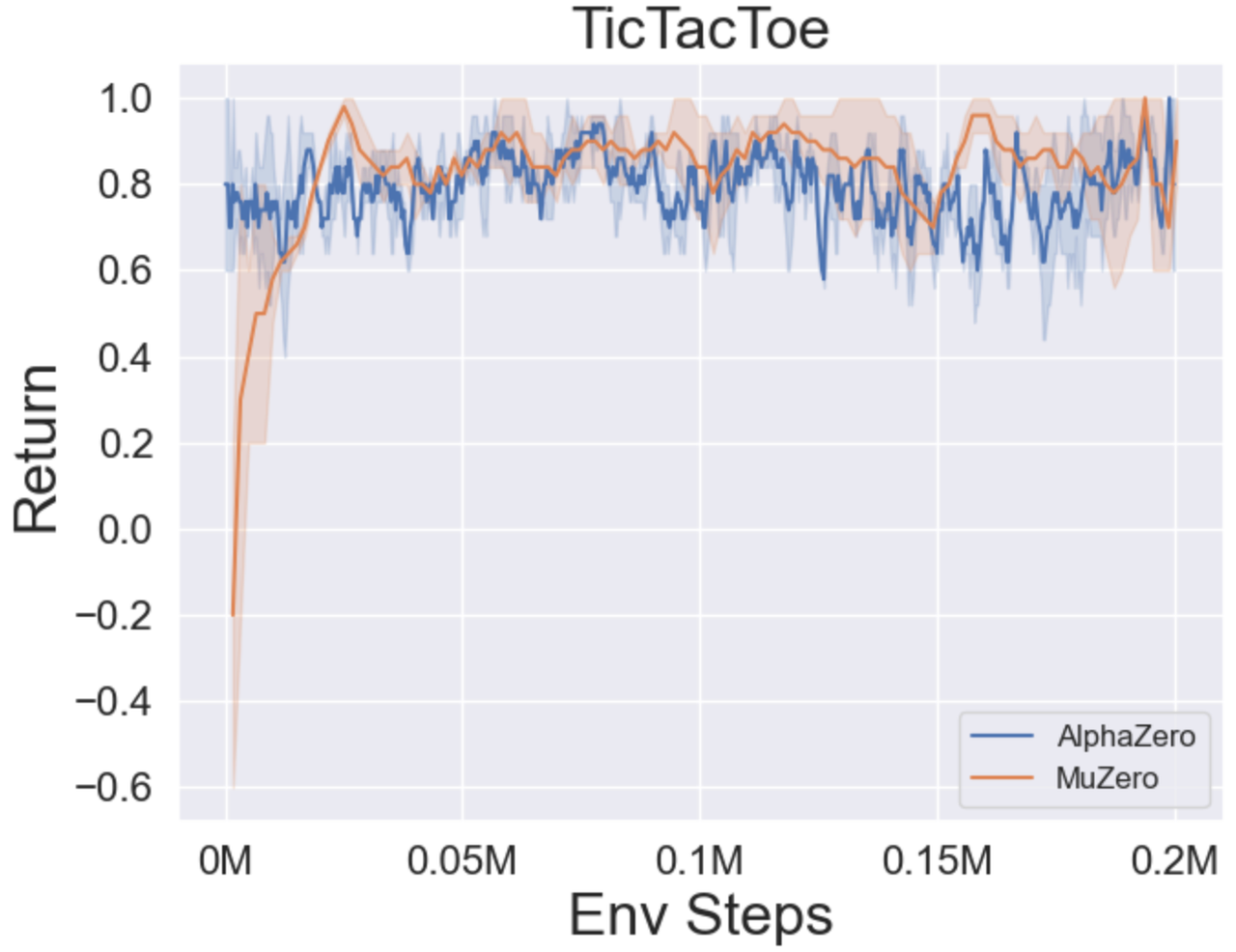

- Ниже приведены контрольные результаты Альфазеро и Музеро на трех настольных играх: Tictactoe, Connect4, Gomoku.

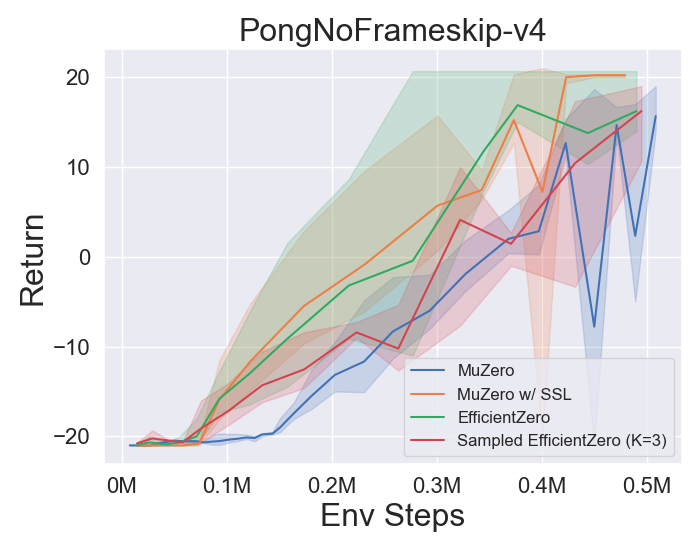

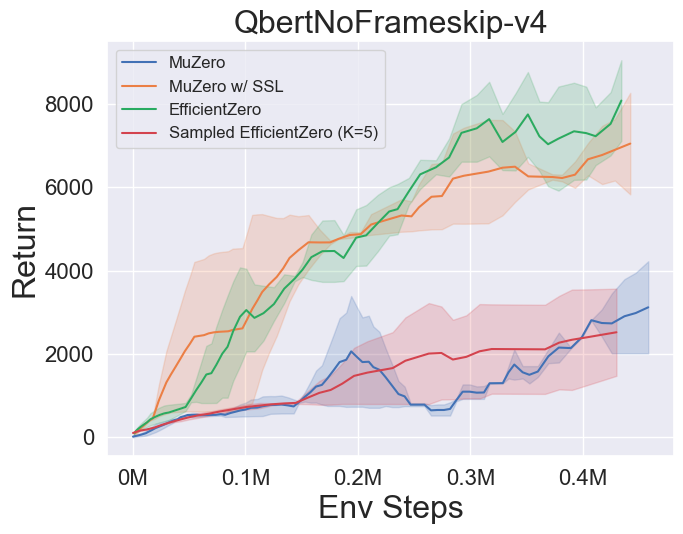

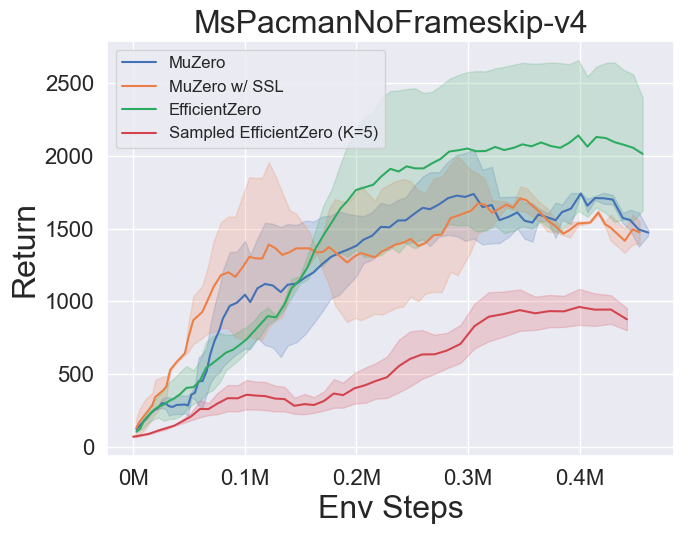

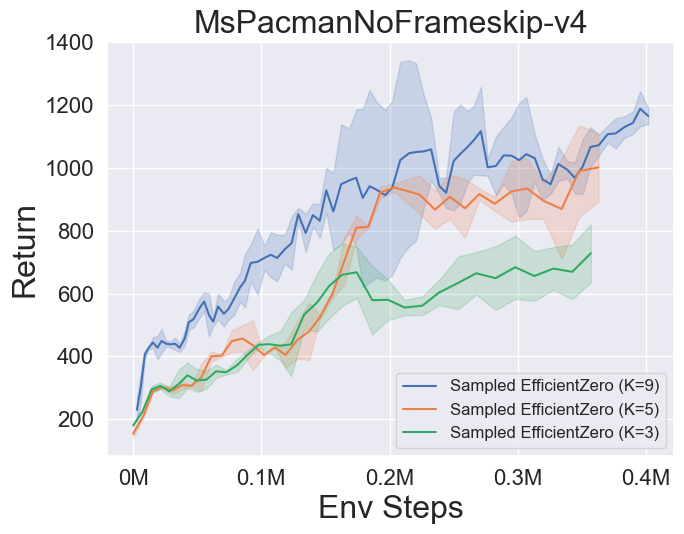

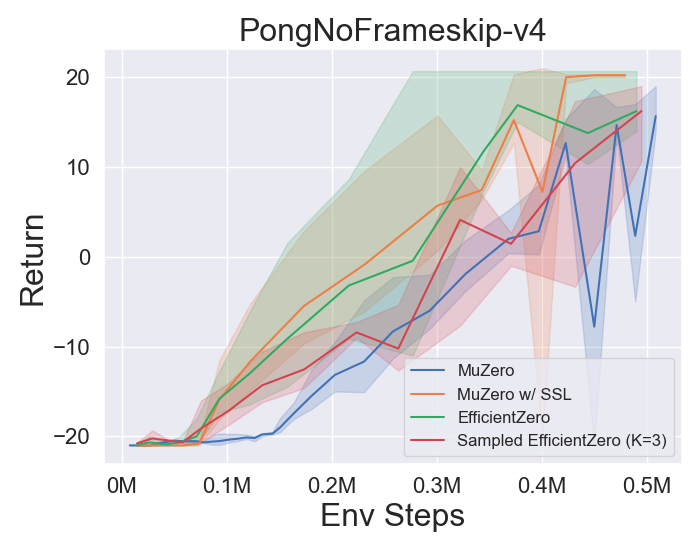

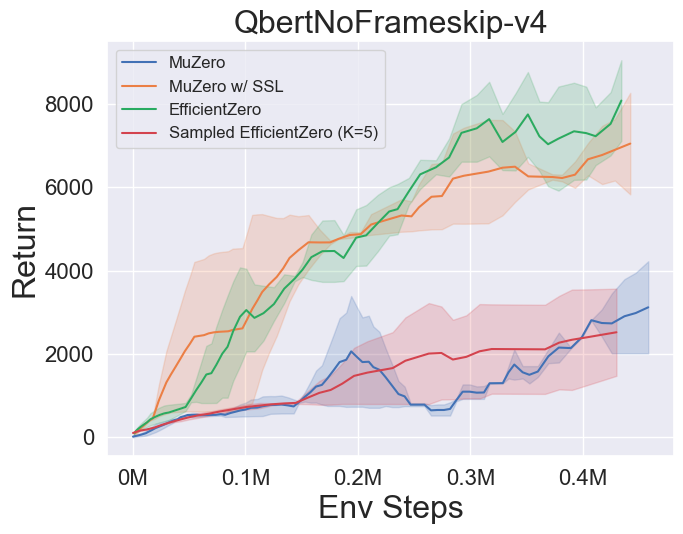

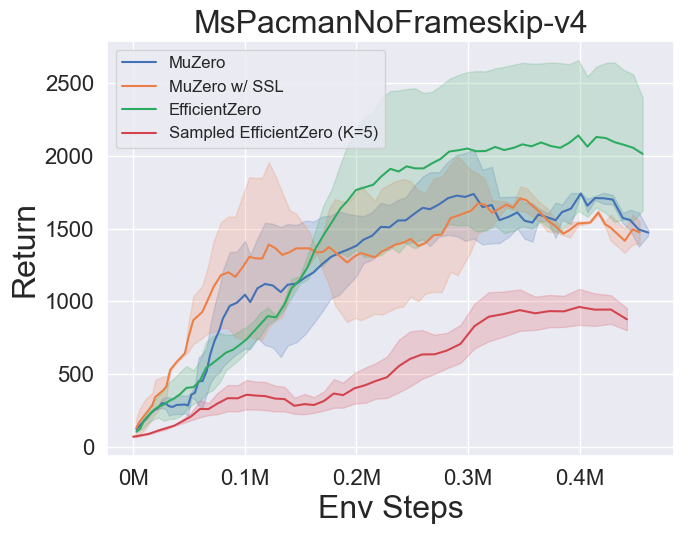

- Ниже приведены эталонные результаты Muzero, Muzero w/ SSL, Effectiverze и Spected Effactzer на трех отдельных космических играх в Атари.

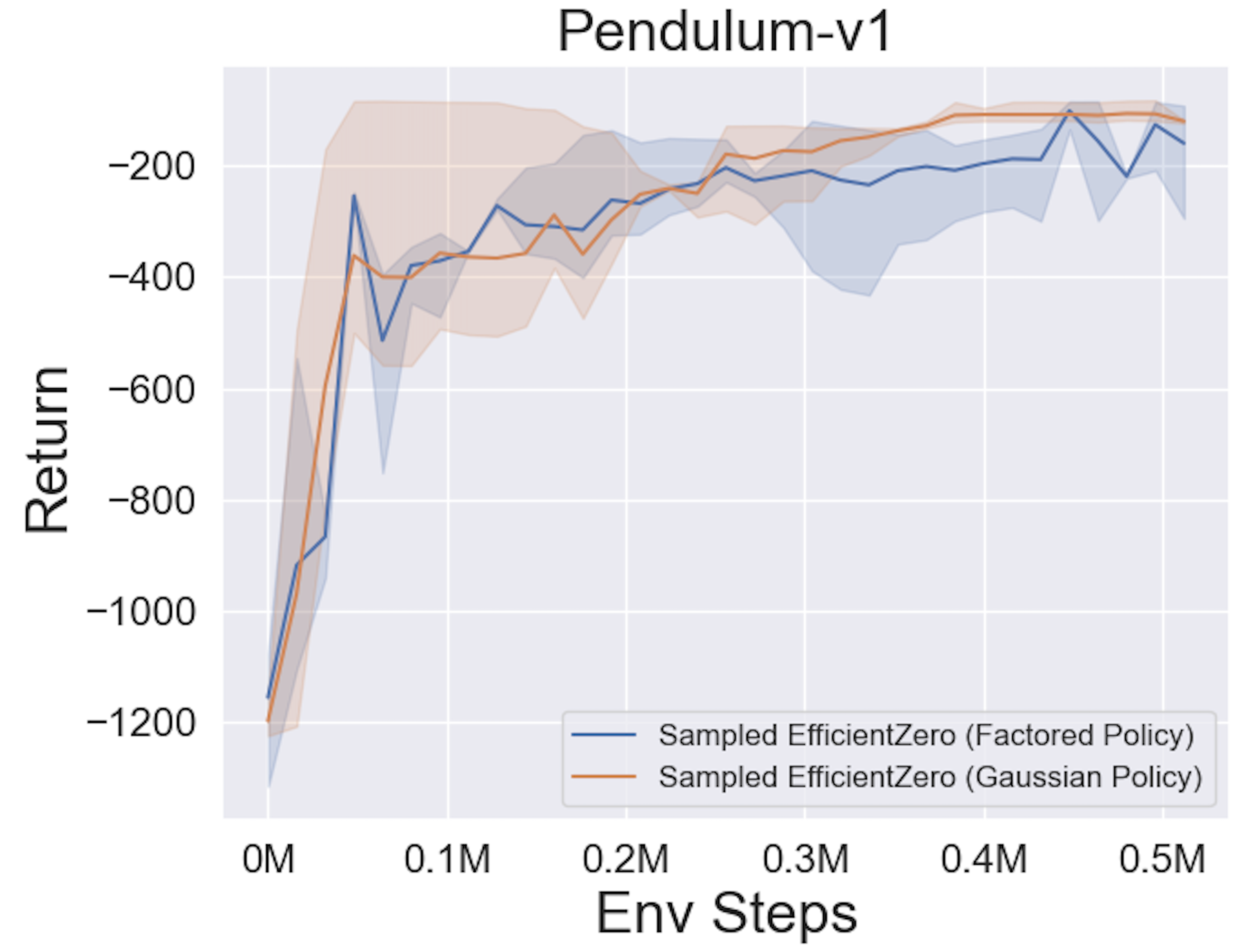

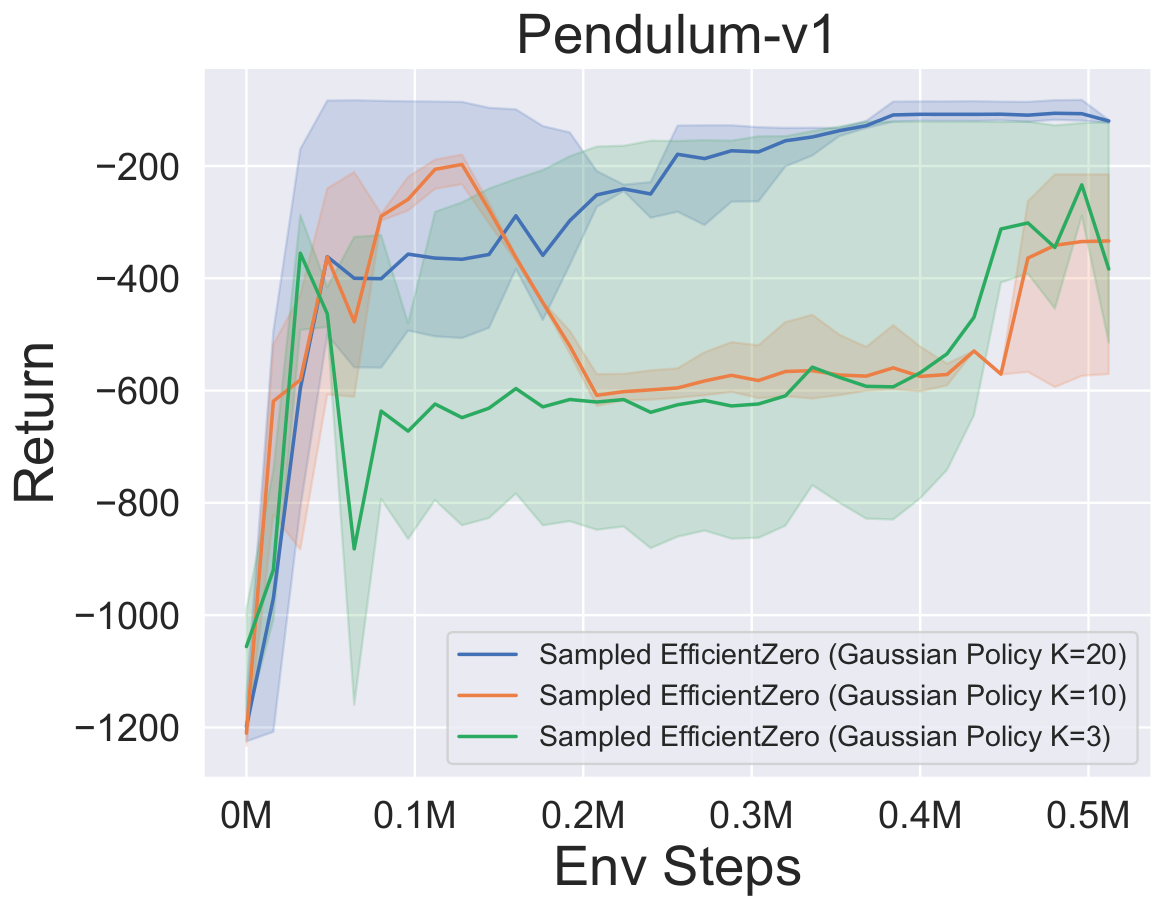

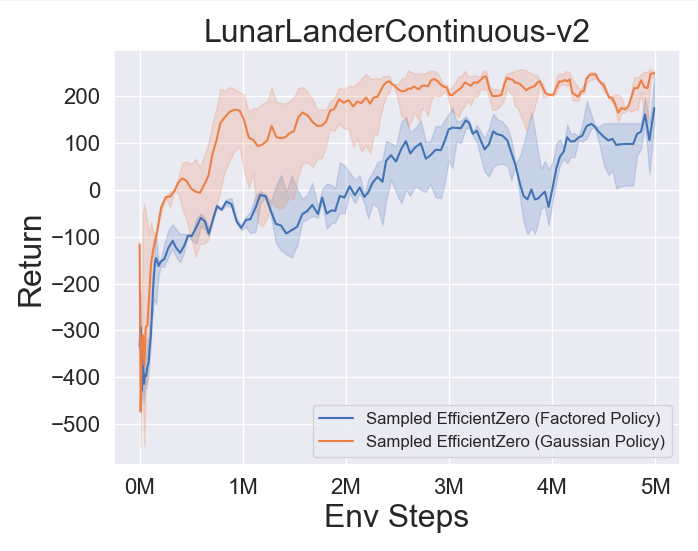

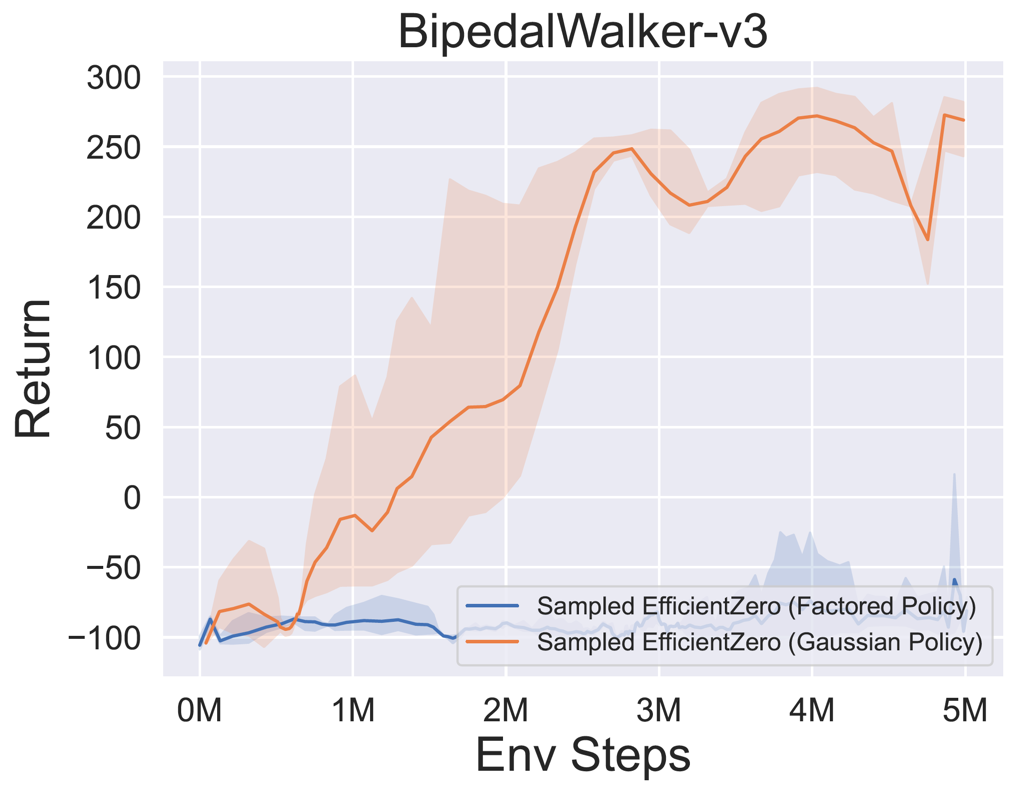

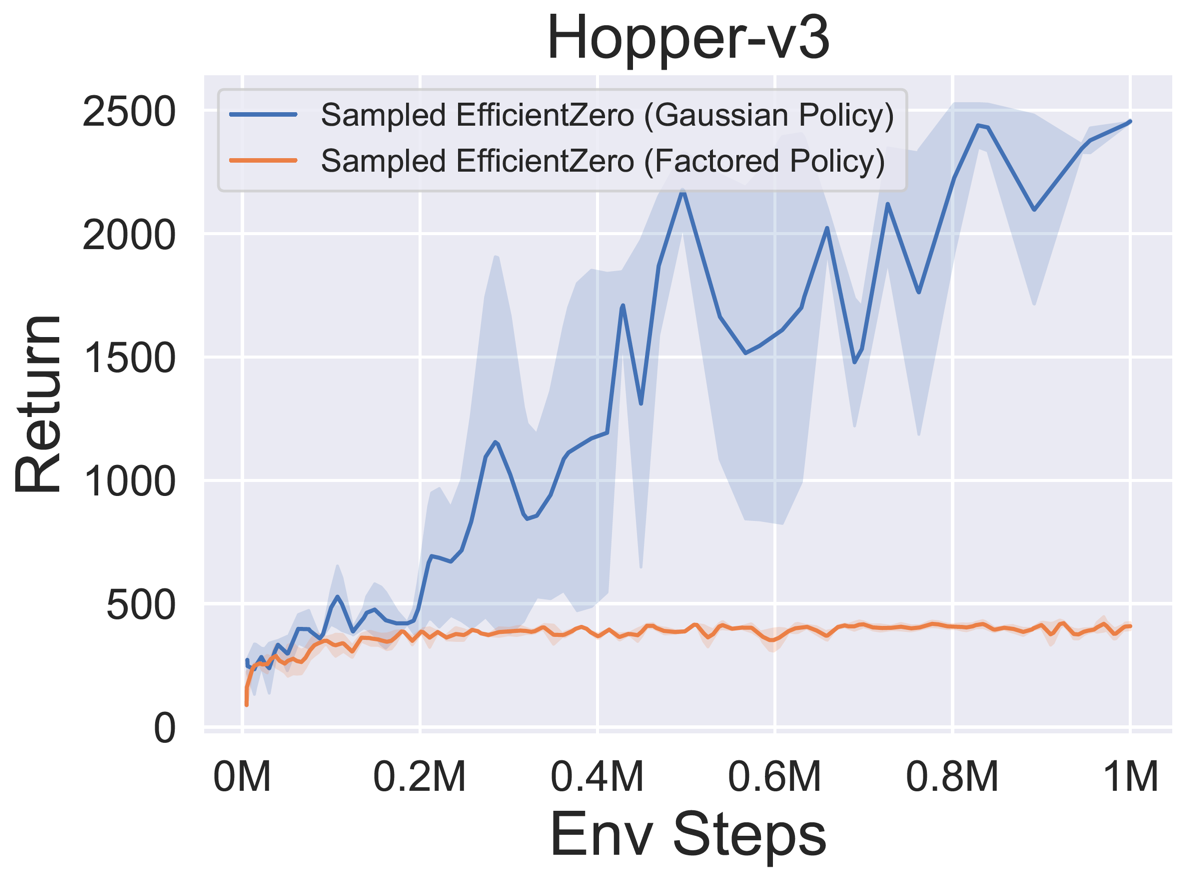

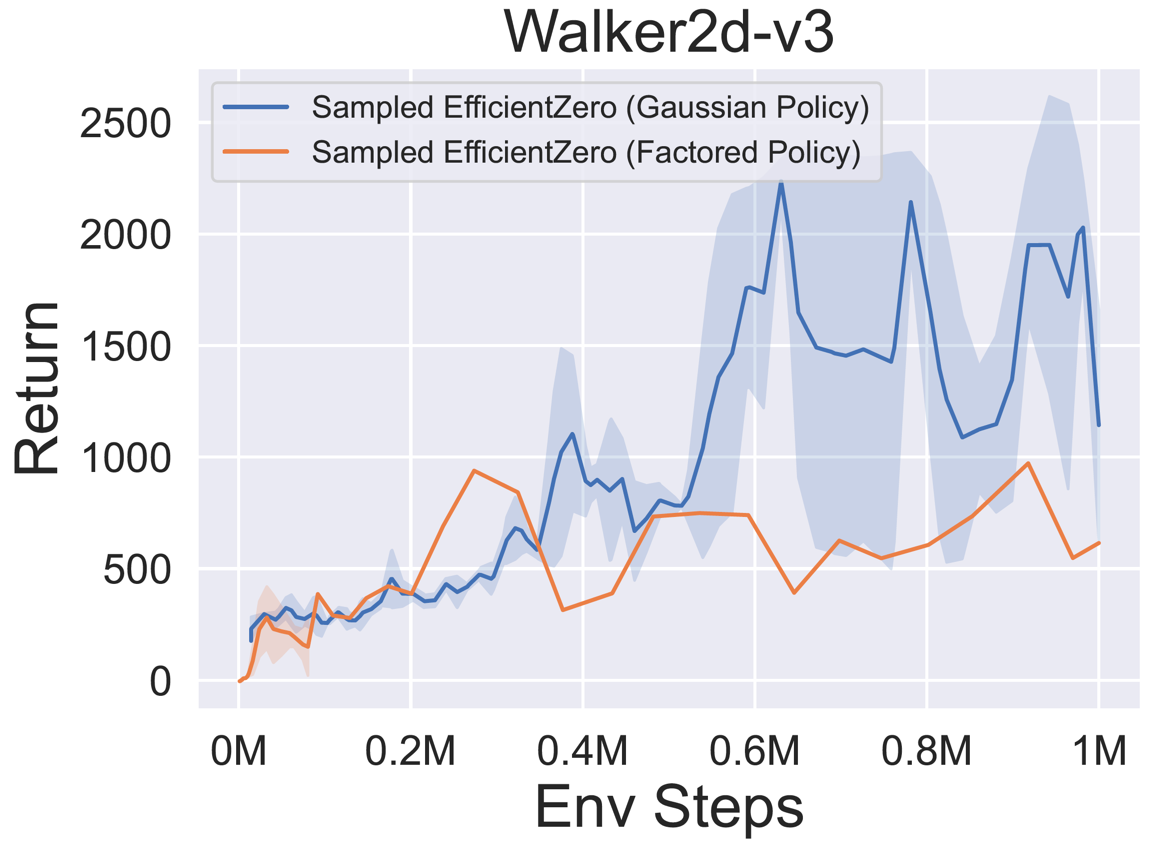

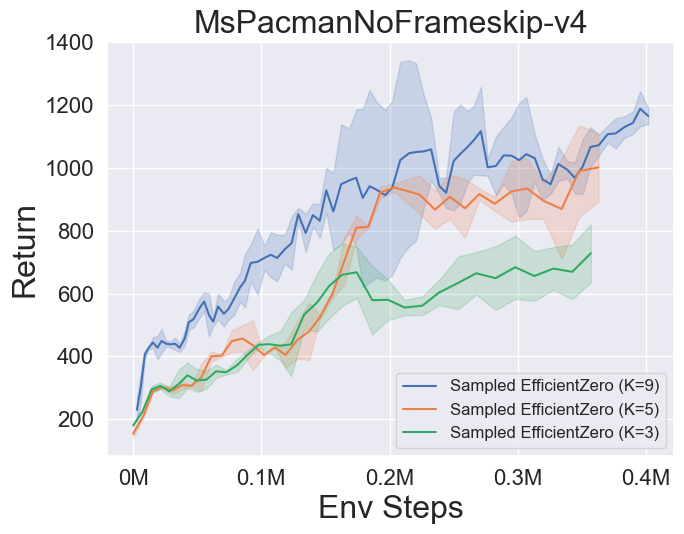

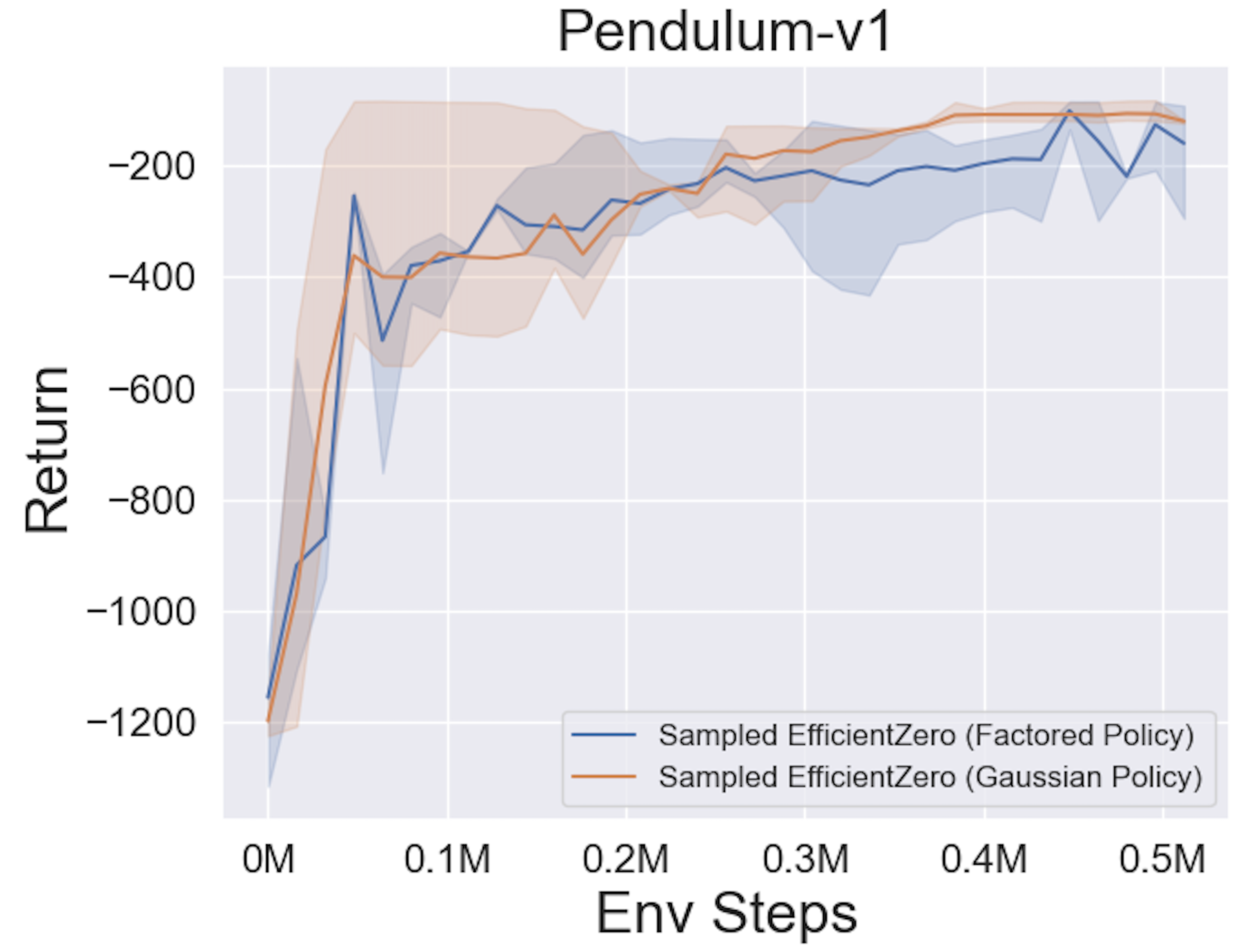

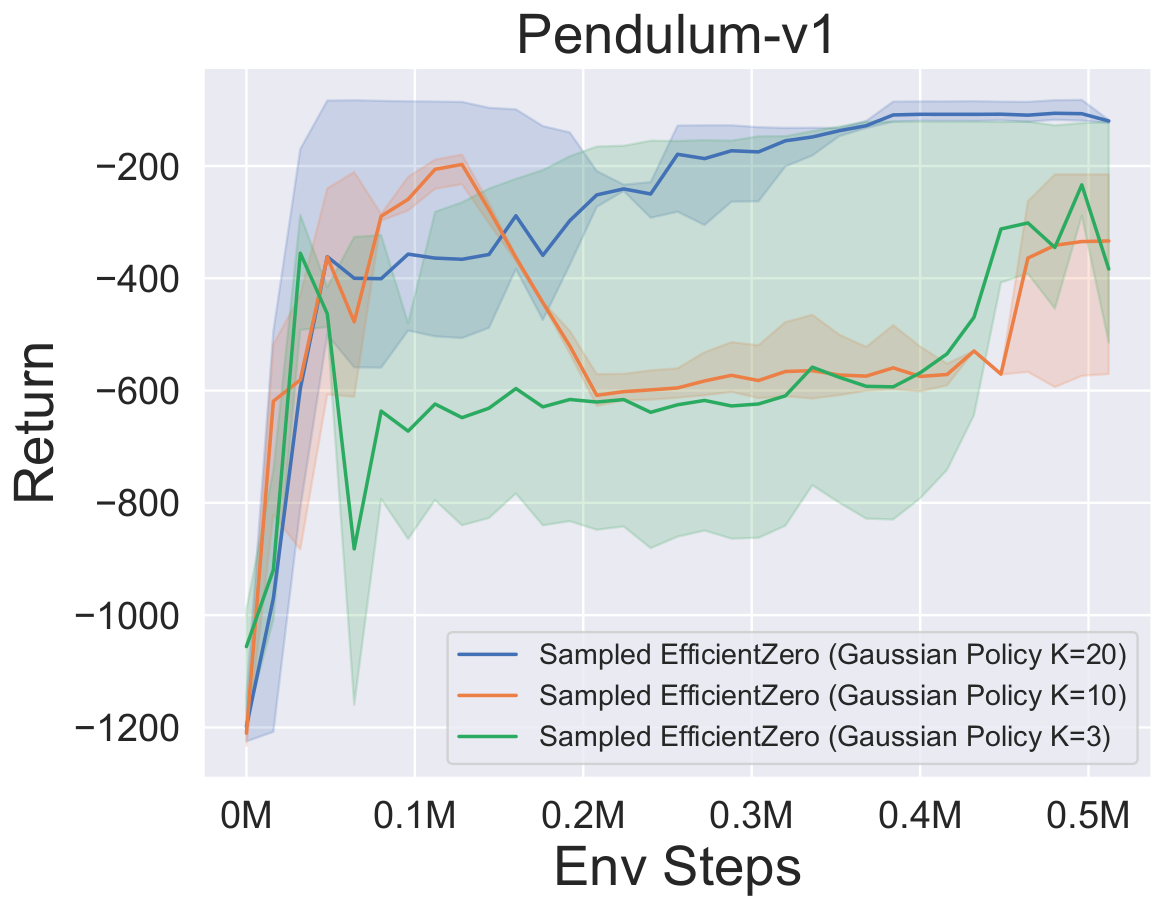

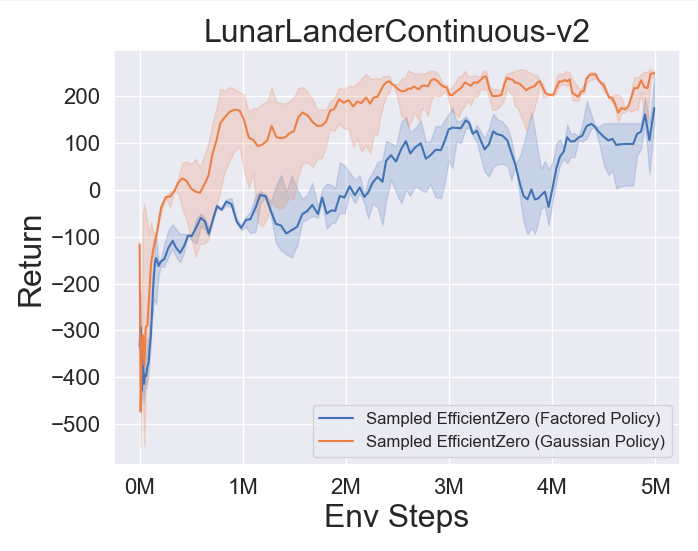

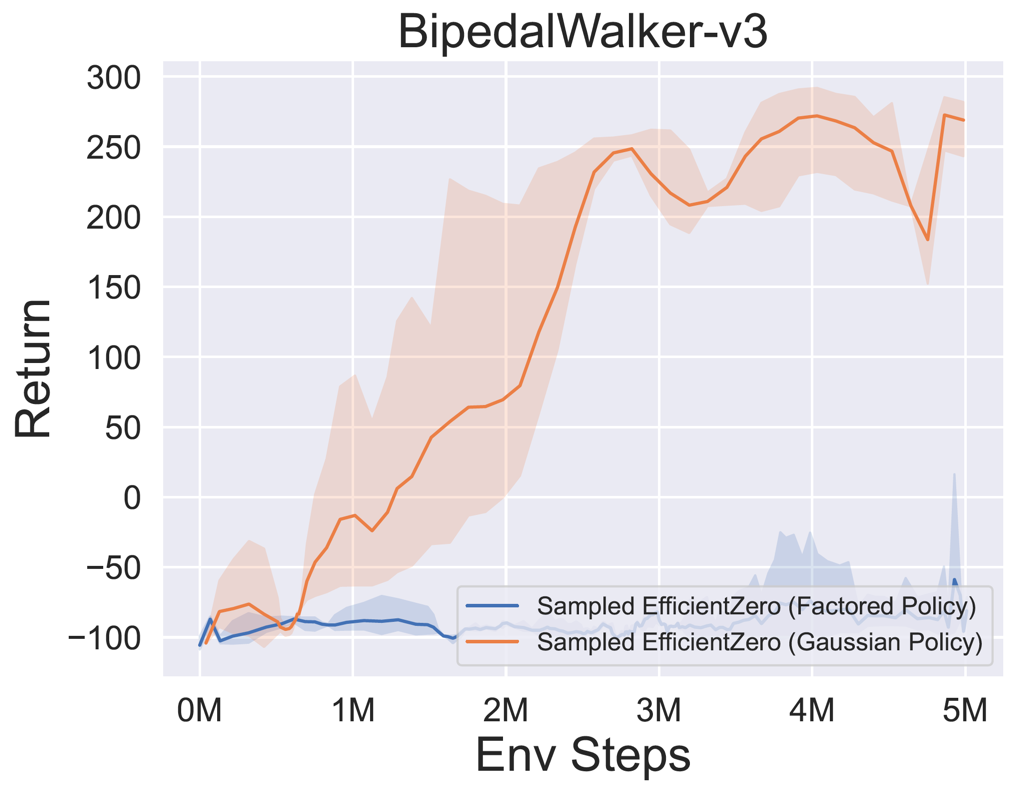

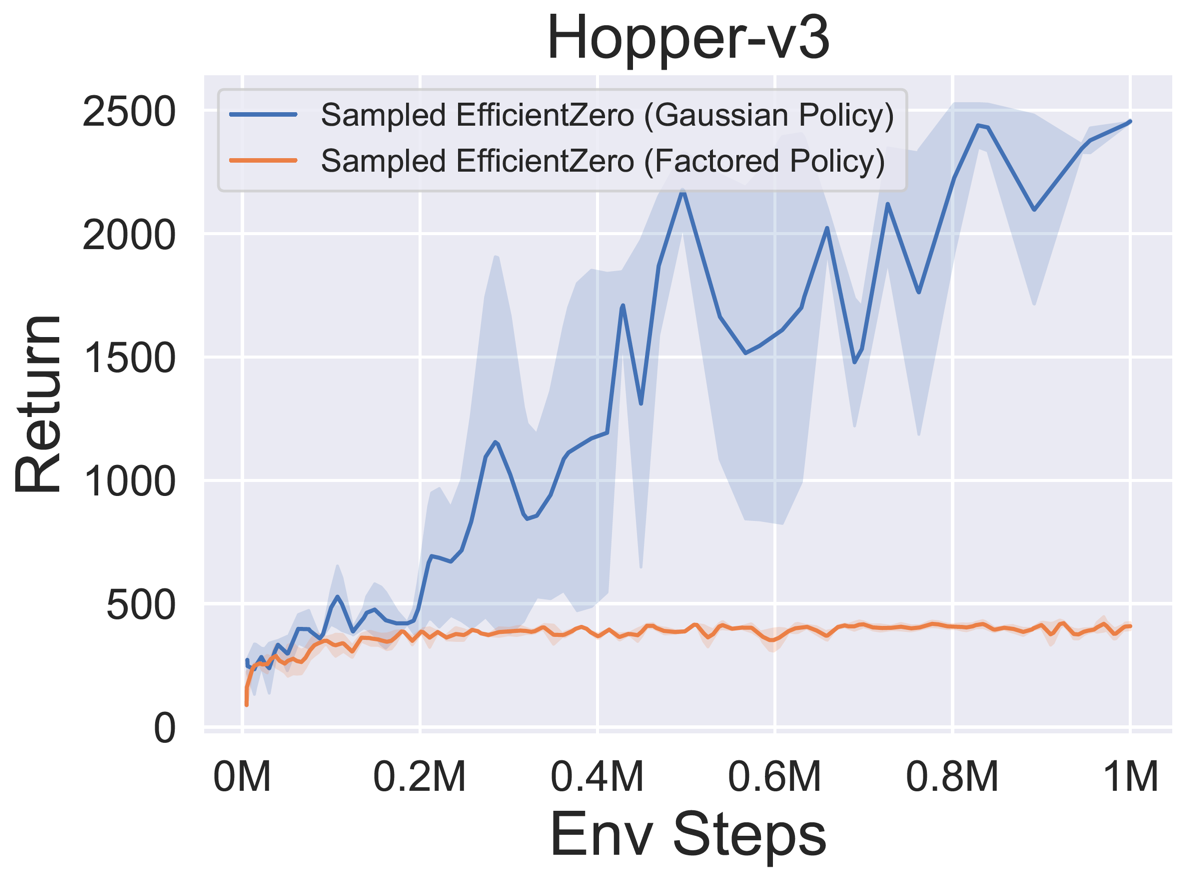

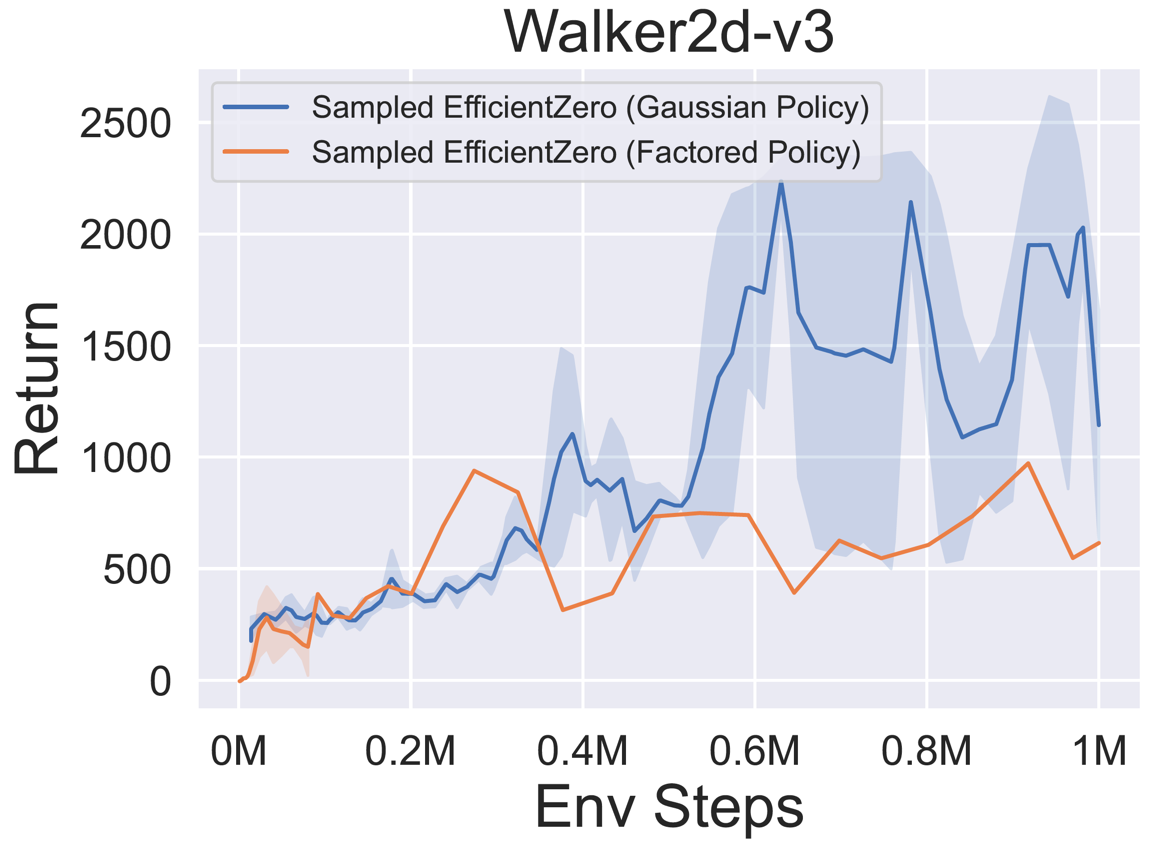

- Ниже приведены эталонные результаты выбранного эффективного контроля с

Factored/Gaussian политическим представлением на трех классических непрерывных космических играх: Pendulum-V1, Lunarlandercontinount-V2, Bipedalwalker-V3 и две непрерывные действия Mujoco Space Games: Hopper-V3, Walker2d-V3.

«Факторная политика» указывает на то, что агент изучает сеть политики, которая выводит категорическое распределение. После ручной дискретизации размеры пространства действий для пяти сред составляют 11, 49 (7^2), 256 (4^4), 64 (4^3) и 4096 (4^6), соответственно. С другой стороны, «Гауссовая политика» относится к агенту, изучая сеть политики, которая напрямую выводит параметры (MU и Sigma) для гауссового распределения.

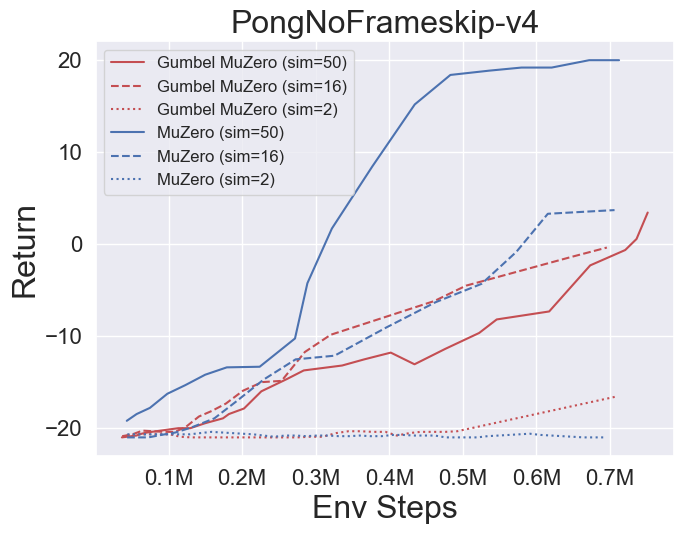

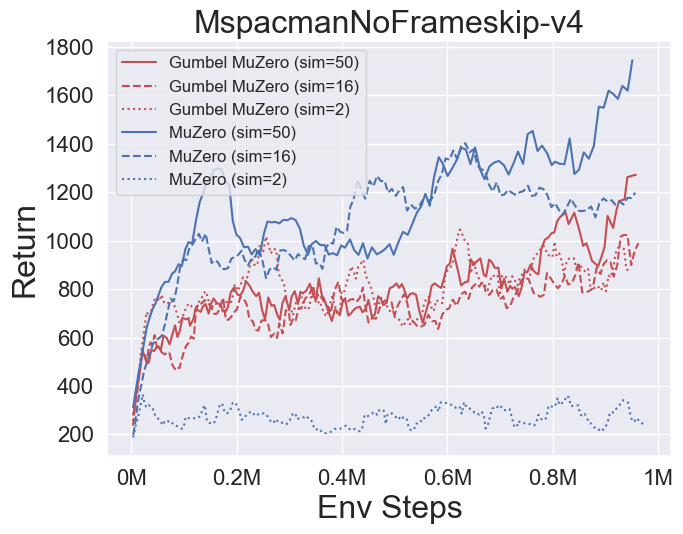

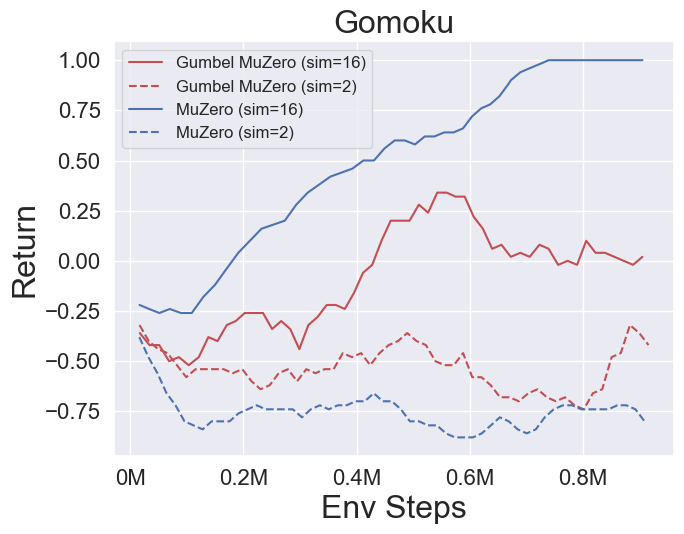

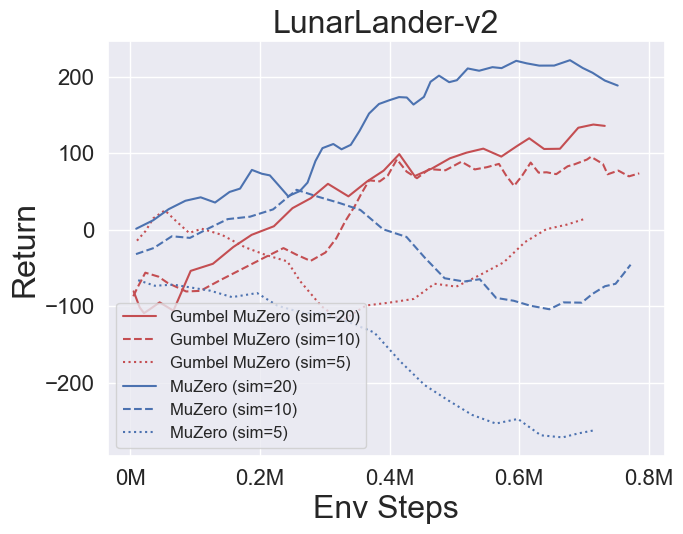

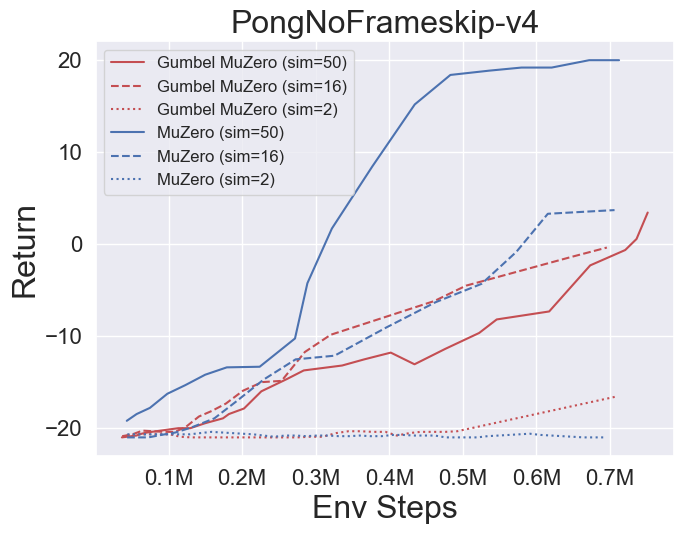

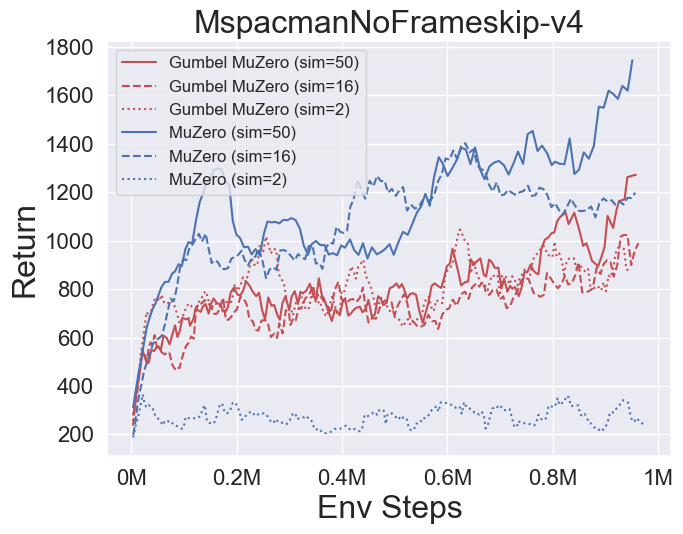

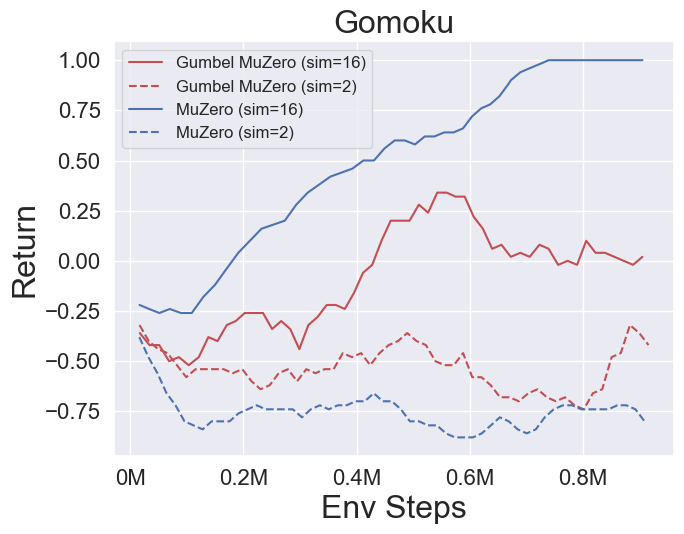

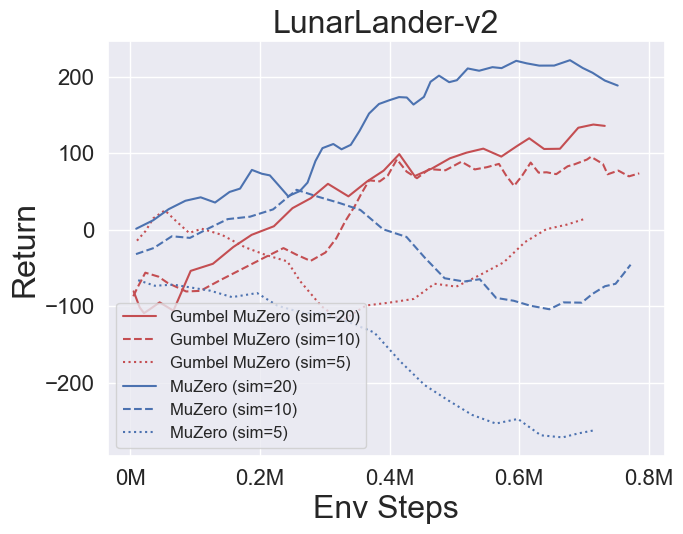

- Ниже приведены эталонные результаты Gumbelmuzero и Muzero (по разным затратам на моделирование) в четырех средах: Pongnoframeskip-V4, Mspacmannoframeskip-V4, Gomoku и Lunarlandercontinount-V2.

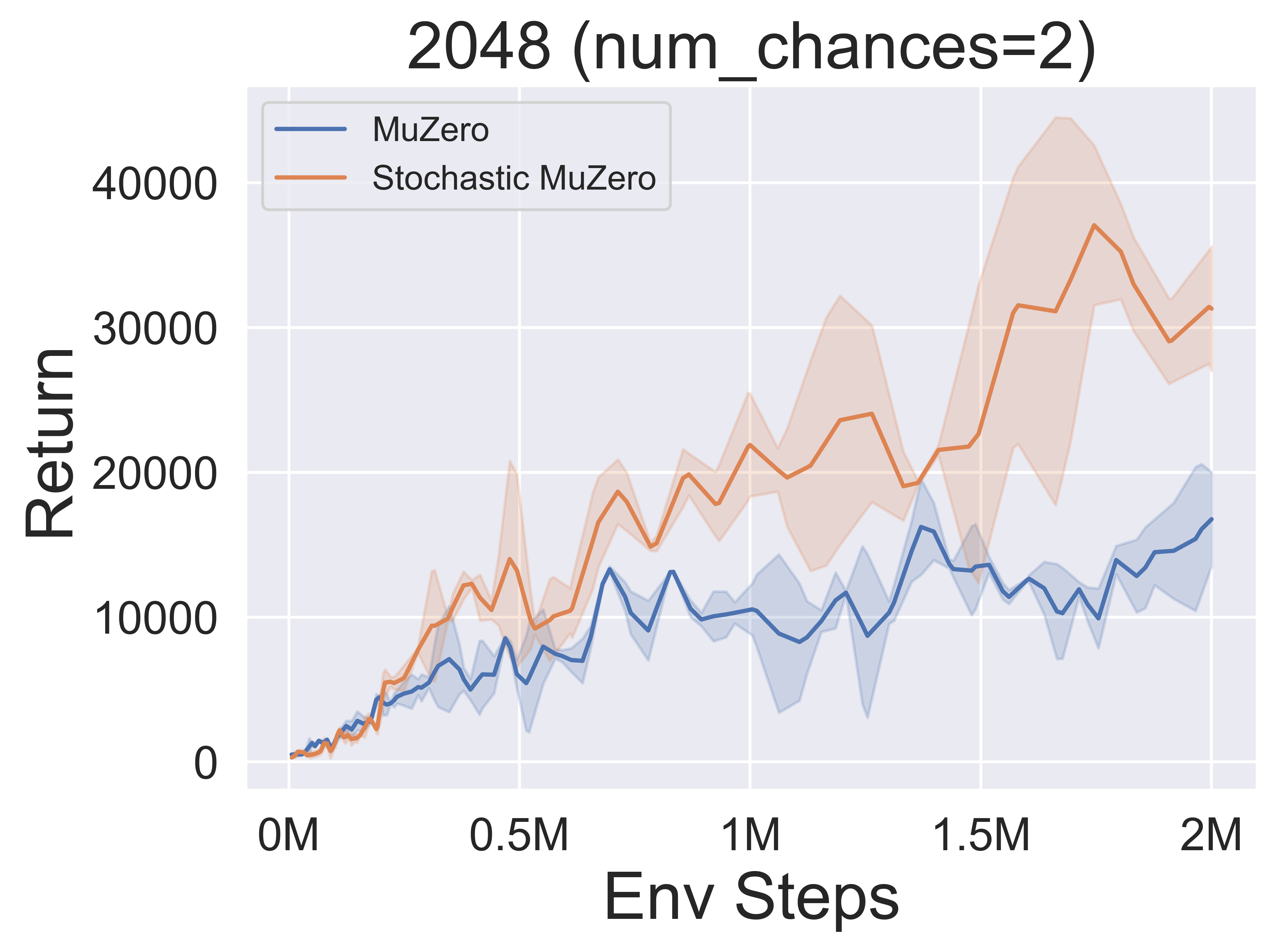

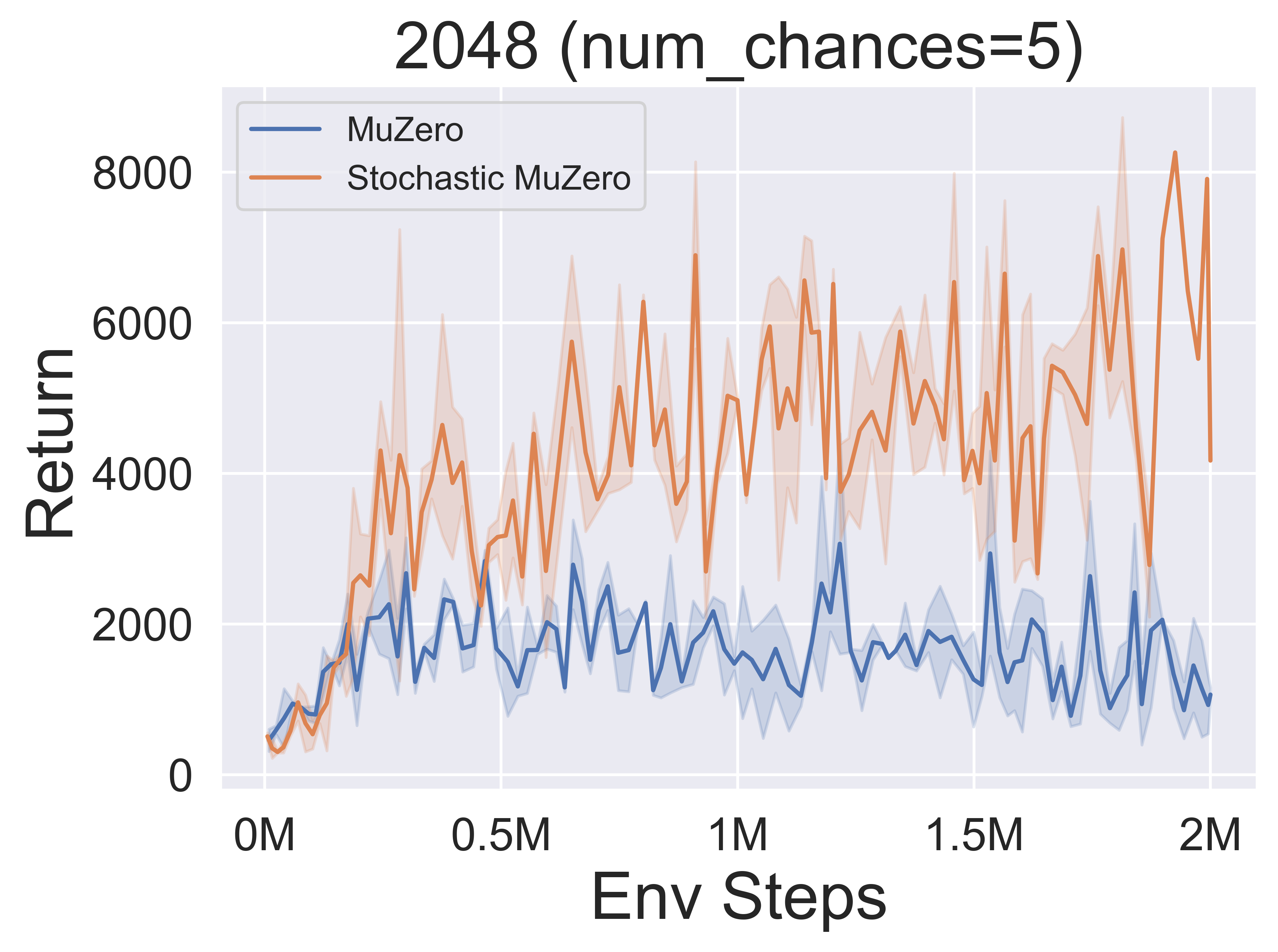

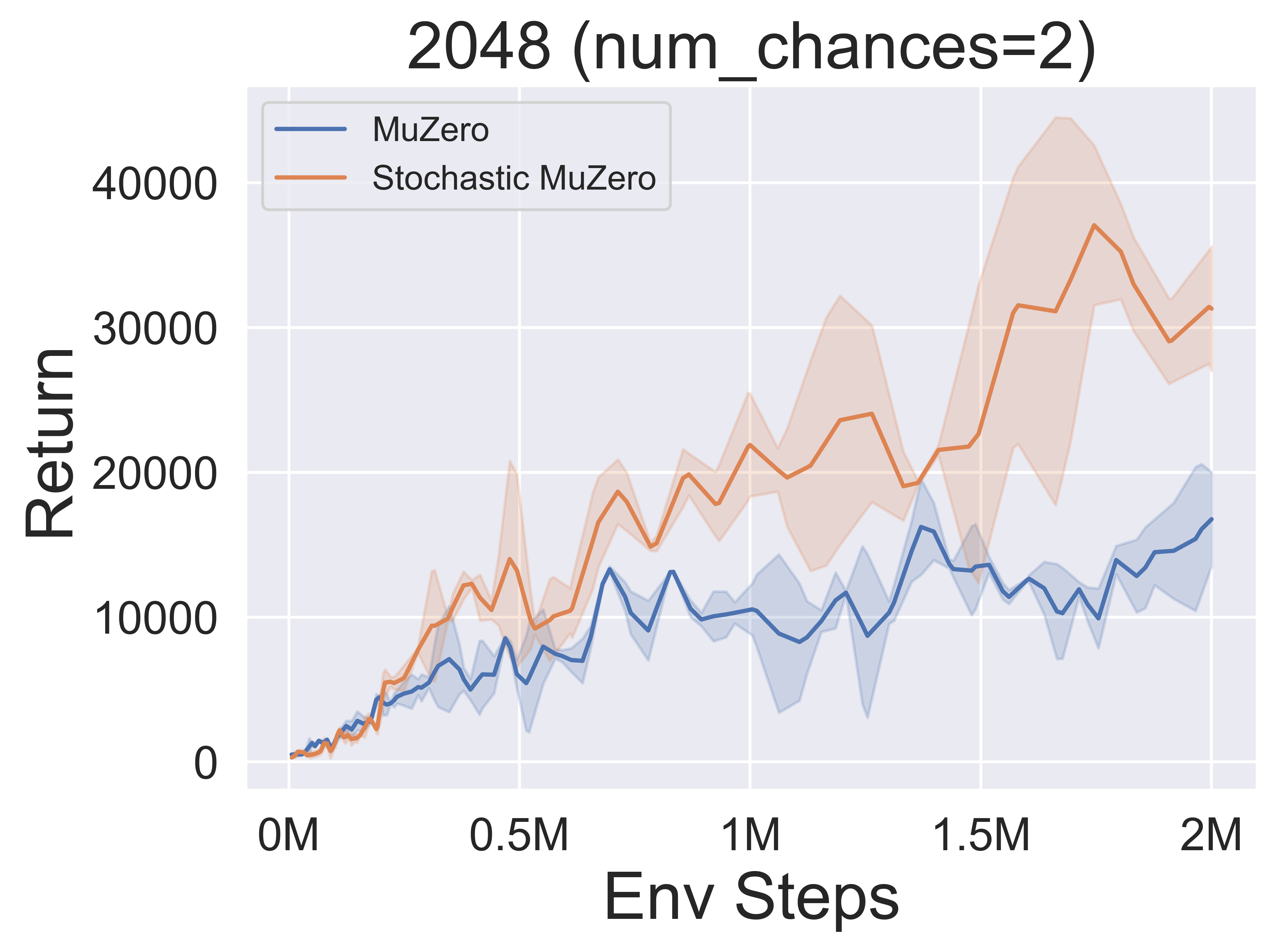

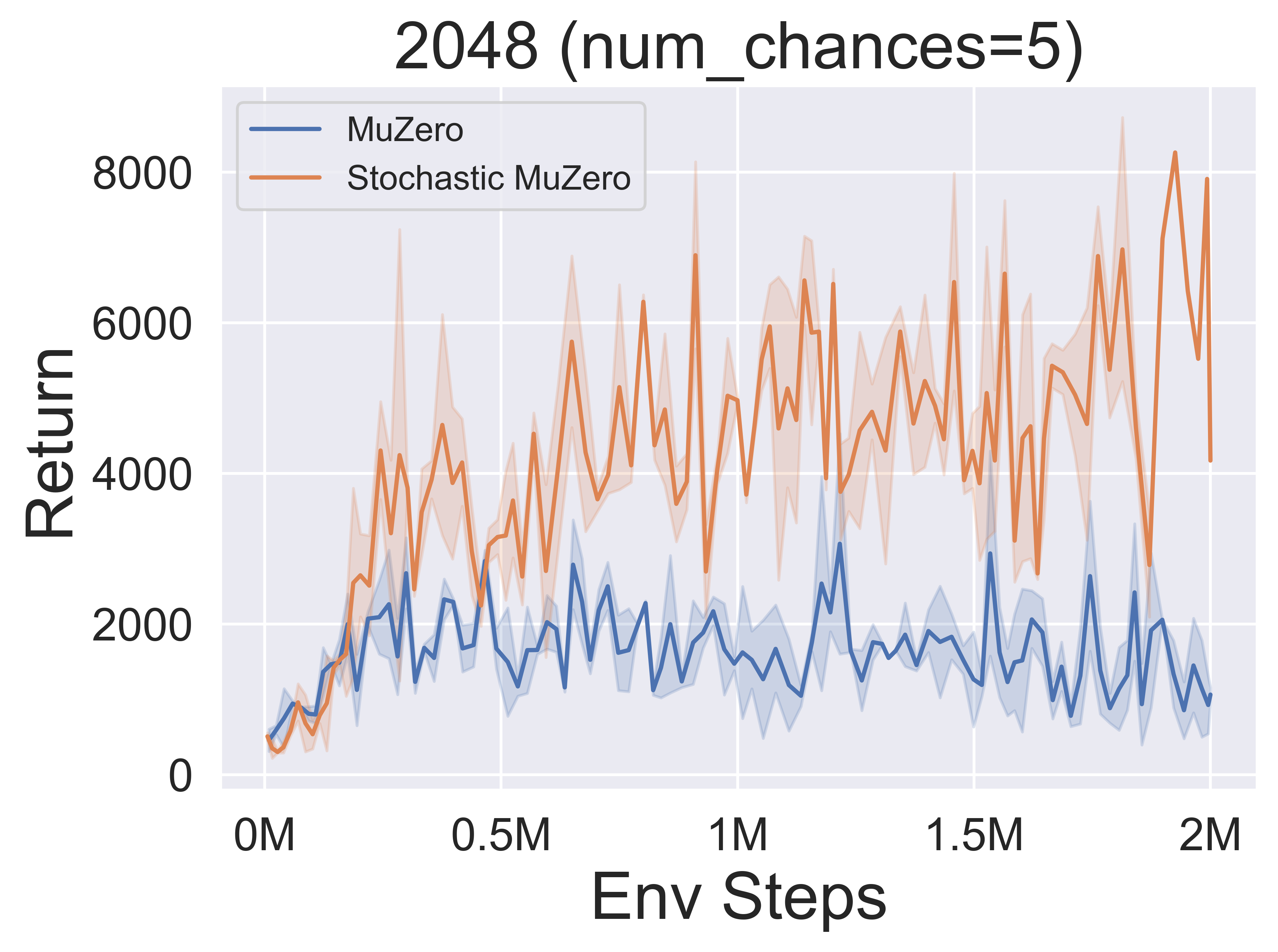

- Ниже приведены контрольные результаты Stochasticmuzero и Muzero в среде 2048 года с различными уровнями случайности (num_chance = 2 и 5).

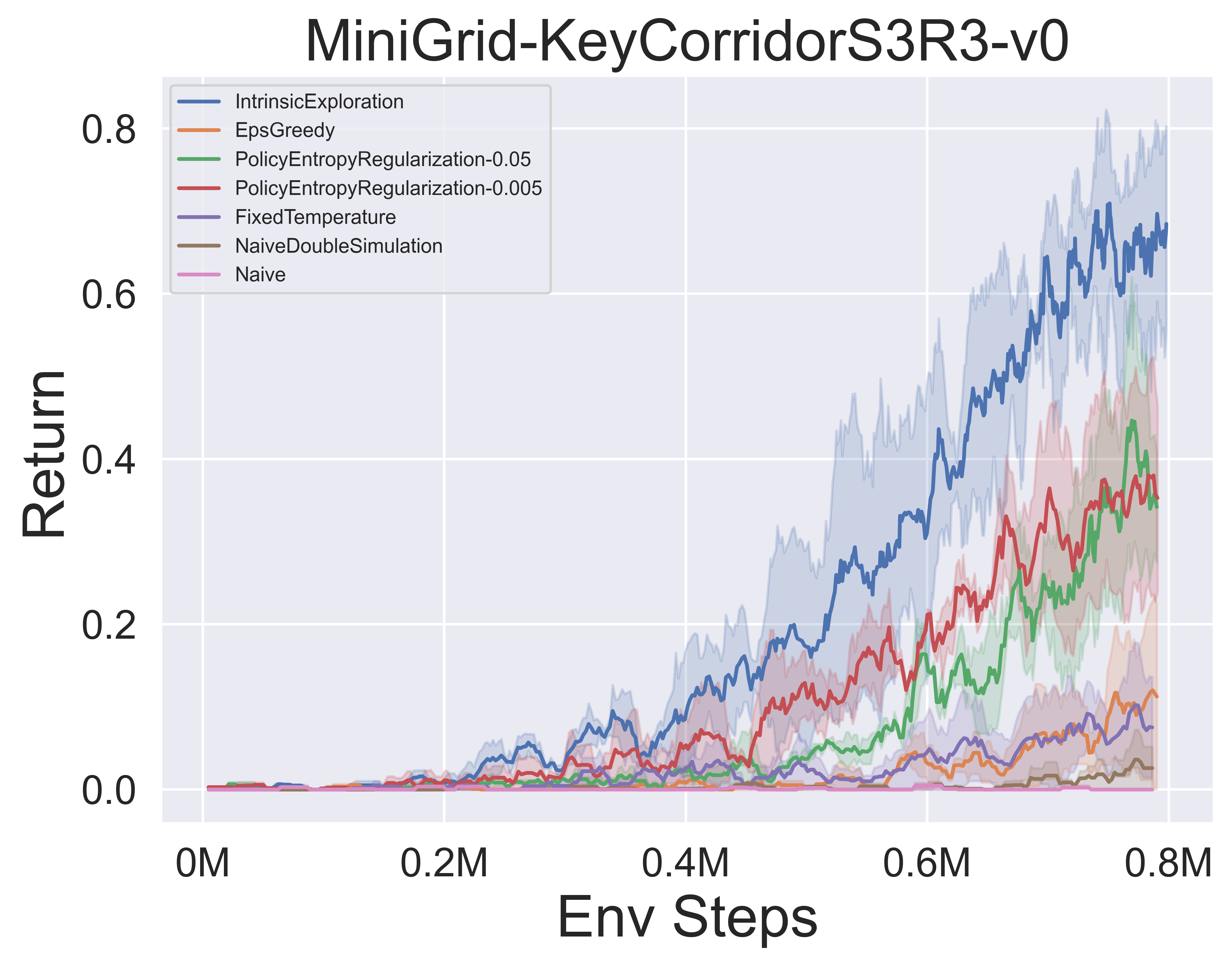

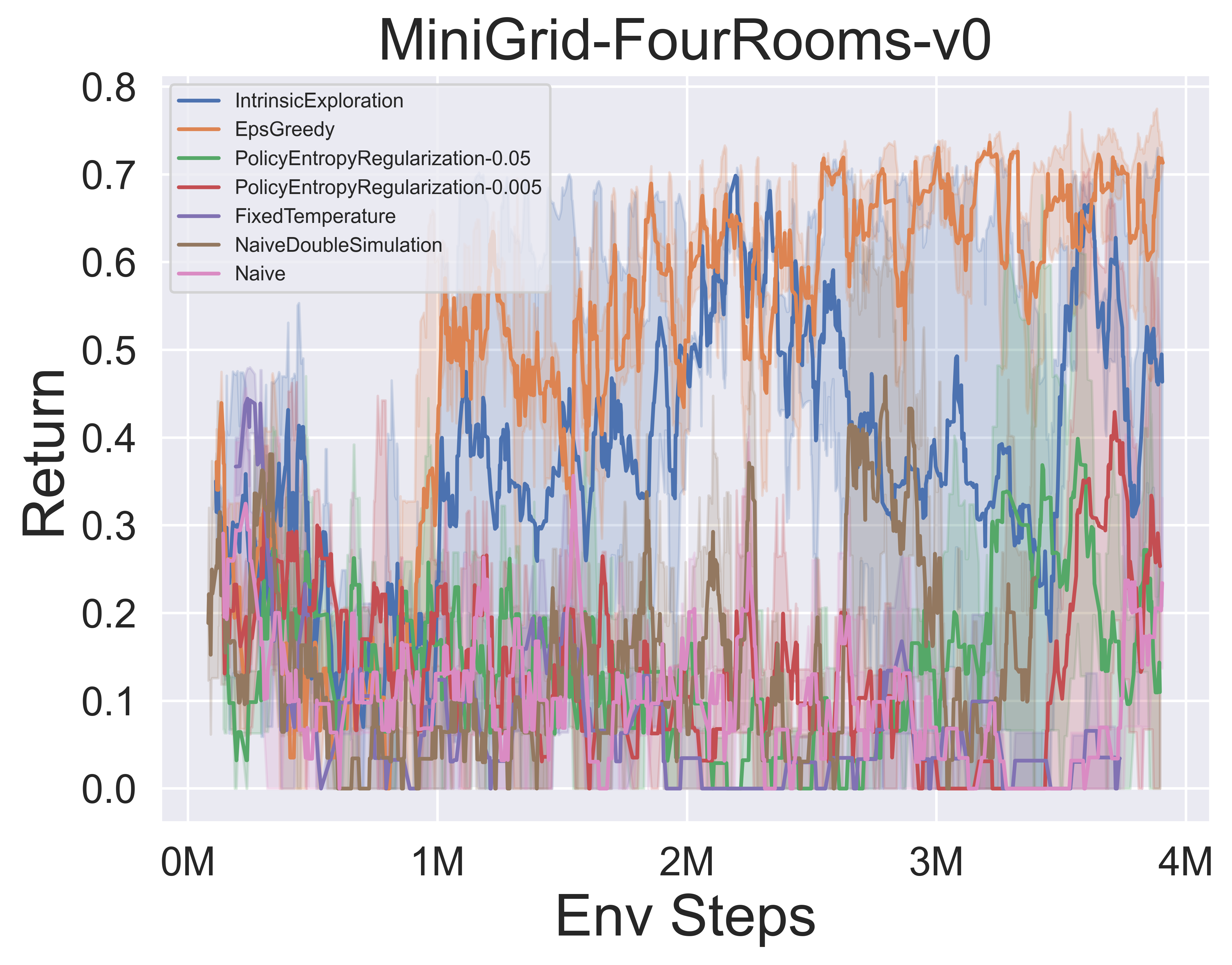

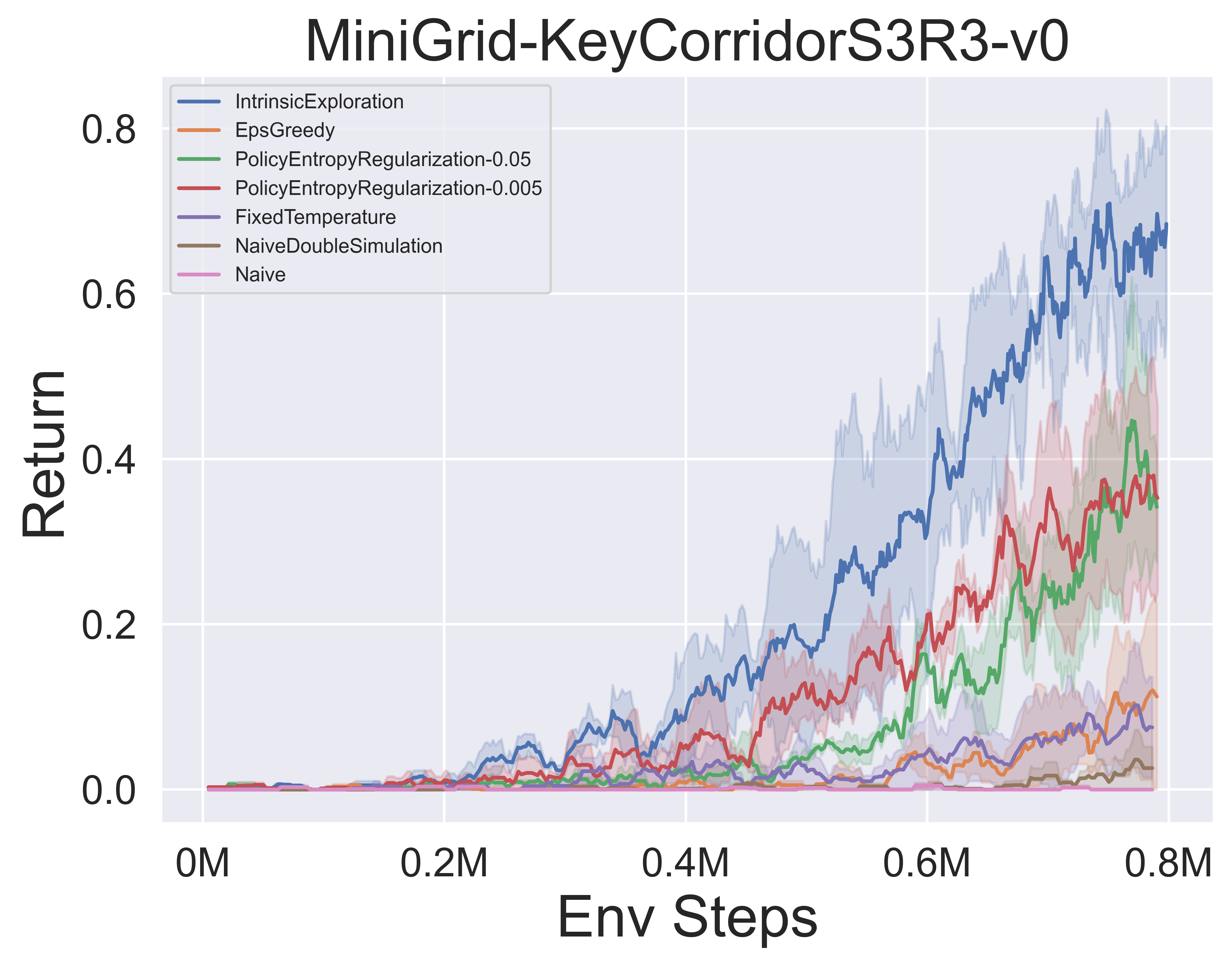

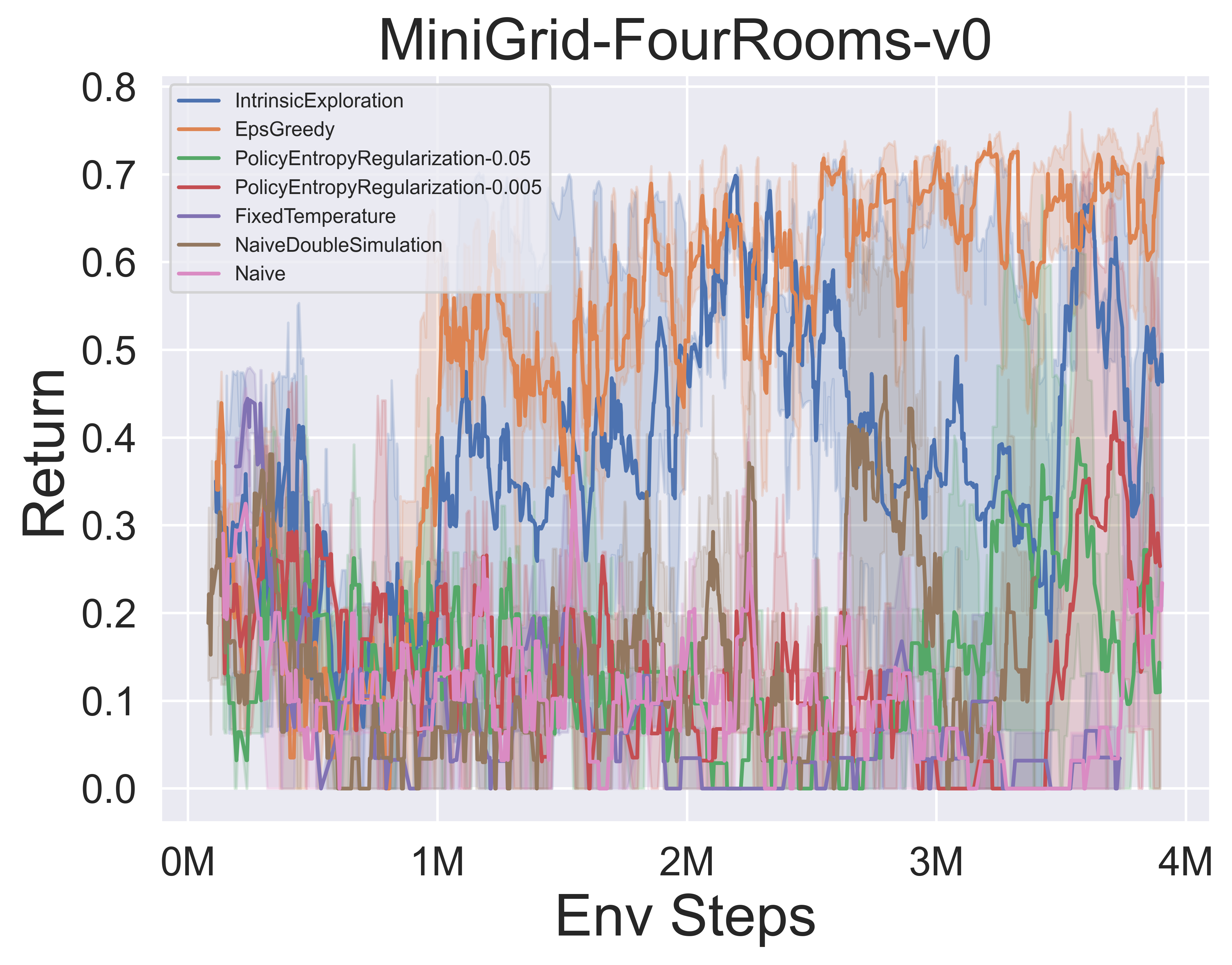

- Ниже приведены эталонные результаты различных механизмов разведки MCTS Muzero с SSL в минигридной среде.

Awesome-MCT-заметки

Бумажные заметки

Ниже приведены подробные бумажные заметки (на китайском языке) из приведенных выше алгоритмов:

Нажмите, чтобы обрушиться

- Альфазеро

- Музеро

- Эффективно

- Sampledmuzero

- Gumbelmuzero

- Stochasticmuzero

- Нотация

Вы также можете обратиться к соответствующей колонке Zhihu (на китайском языке): углубленный анализ теорий и приложений по границе MCTS+RL.

Алго Обзор

Ниже приведены обзор принципов MCTS приведенных выше алгоритмов:

Нажмите, чтобы расширить

- МС

- Альфазеро

- Музеро

- Эффективно

- Sampledmuzero

- Gumbelmuzero

- Stochasticmuzero

Awesome-MCTS

Вот коллекция исследовательских работ о поиске дерева Монте -Карло . Этот раздел будет постоянно обновляться для отслеживания границы MCT.

Ключевые документы

Нажмите, чтобы расширить

Lightzero реализовал серию

- 2018 Science Alphazero: общий алгоритм обучения подкреплению, который магистр шахмат, Shogi и проходит самостоятельную работу

- Muzero 2019: Освоение Atari, Go, Chess и Shogi, планируя с учебной моделью

- 2021 Effectiverzero: освоение игр Atari с ограниченными данными

- 2021 Sampled Muzero: обучение и планирование в сложных пространствах действий

- 2022 Stochastic Muzero: Планирование в стохастических средах с учебной моделью

- 2022 Gumbel Muzero: улучшение политики путем планирования с Gumbel

Альфаго серия

- 2015 Nature Alphago овладеть игрой в глубокие нейронные сети и поиск деревьев

- 2017 Nature Alphago Zero овладевает игрой в Go Bound

- 2019 ELF OpenGO: анализ и открытая ревментирование Alphazero

- 2023 Студент игр: единый алгоритм обучения как для идеальных, так и для несовершенных информационных игр

Серия Muzero

- 2022 онлайн и офлайновый подкрепление

- 2021 векторные квантовые модели для планирования

- 2021 MUESLI: объединение улучшений в оптимизации политики.

Анализ MCTS

- 2020 г. Поиск дерева Монте-Карло в качестве регулярной оптимизация политики

- 2021 Самоусовершенные модели и ценности

- 2022 Политика состязательной политики победил профессиональный уровень Go AIS

- 2022 ПНА

Приложение MCTS

- 2023 Символическая физика Ученик физики: обнаружение управляющих уравнений через поиск дерева Монте -Карло

- 2022 Природа Обнаружение более быстрого алгоритмам умножения матрицы с обучением подкрепления

- 2022 Muzero с самообслуживанием для контроля скорости при сжатии видео VP9

- 2021 Douzero: Освоение Дудижу с самостоятельным обучением

- 2019 г. Сочетание планирования и обучения глубокому подкреплению при принятии тактических решений для автономного вождения

Другие документы

Нажмите, чтобы расширить

ICML

- Масштабируемое улучшение безопасной политики через Поиск Монте -Карло Tree 2023

- Альберто Кастеллини, Федерико Бьянчи, Эдоардо Зорзи, Тиаго Д. СИМАО, Алессандро Фаринелли, Маттиджс Т.Дж.

- Ключ: безопасное улучшение политики онлайн с использованием стратегии на основе MCTS, безопасное улучшение политики с базовой начальной загрузкой

- Expenv: Gridworld и Sysadmin

- Эффективное обучение для Alphazero через консистенцию пути 2022

- Денгвей Чжао, Шикуи Ту, Лей Сюй

- Ключ: ограниченное количество самостоятельных игроков, оптимальность по согласованности пути (ПК)

- Expenv: Go, Othello, Gomoku

- Визуализация Muzero Models 2021

- Журнал А. де Врис, Кен С. Воскуил, Томас М. Моерленд, Aske Plaat

- Ключ: визуализация модели эквивалентной динамики значения, траектории действий расходятся, два метода регуляризации

- Expenv: Cartpole и Mountaincar.

- Выпуктная регуляризация в Поиск дерева Монте-Карло 2021

- Туан Дам, Карло Д'Арамо, Ян Питерс, Джони Пахаринен

- Ключ: Резервное копирование энтропии-регуляризации, анализ сожаления, Tsallis etropy,

- Expenv: синтетическое дерево, atari

- Дерево фильтров частиц информации: онлайн-алгоритм для POMDP с вознаграждениями, основанными на убеждениях, на непрерывных доменах 2020

- Йоханнес Фишер, Омер Сахин Тас

- Ключ: непрерывный POMDP, дерево фильтров частиц, информация о формировании вознаграждения, сбором информации.

- Expenv: Pomdps.jl Framework

- Код

- Ретро*: Обучение ретросинтетическое планирование с нейронным управлением A* Search 2020

- Binghong Chen, Chengtao Li, Hanjun Dai, Le Song

- Ключ: Химическое ретросинтетическое планирование, нейронный алгоритм Andor Andor, Andor Tree

- Expenv: наборы данных USPTO

- Код

ICLR

- Структура эквивалентности обновления для планирования принятия решений 2024

- Сэмюэль Сокота, Габриэле Фарина, Дэвид Дж. Ву, Хенгьюан Ху, Кевин А. Ван, Дж. Зико Колтер, Ноам Браун

- Ключ: Игры несовершенной информации, поиск, планирование времени принятия решений, эквивалентность обновления

- Expenv: Ханаби, 3х3 резкий темный шестнадцатеричный и фантомный

- Эффективное многоагентное обучение подкреплению путем планирования 2024

- Цихан Лю, Цзянинг Йе, Сяотенг М.А., Джун Ян, бин Лян, Чонджи Чжан

- Ключ: многоагентное обучение подкреплению, планирование, многоагентные MCTS

- Expenv: SMAC, Lunarlander, Mujoco и Google Research Football

- Станьте опытным игроком с ограниченными данными с помощью просмотра Pure Video 2023

- Вейруи Йе, Юншенг Чжан, Питер Аббейл, Ян Гао

- Ключ: предварительное обучение из видео без действий, объектива по консистенции прямого цикла (FICC), основанная на квантовании вектора, фазе предварительного обучения, фаза тонкой настройки.

- Expenv: Atari

- Политическая самообслуживание для проблем планирования 2023

- Джонатан Пирнай, Квирин Геттл, Якоб Бургер, Доминик Герхард Гримм

- Ключ: самообъекция, найдите сильные траектории, планируя против возможных стратегий его прошлого.

- EXPENV: Проблема с продавцом и проблемами планирования работы.

- Объяснение моделей временных графиков через Explorer-Navigator Framework 2023

- Wenwen Xia, Mincai Lai, Caihua Shan, Yao Zhang, Xinnan Dai, Xiang Li, Dongsheng Li

- КЛЮЧ: Themalal GNN Explicter, исследователь, чтобы найти подмножества событий с MCTS, навигатором, который изучает корреляции между событиями и помогает уменьшить пространство поиска.

- Expenv: Википедия и Reddit, синтетические наборы данных

- Speedyzero: освоить Atari с ограниченными данными и временем 2023 года

- Yixuan Mei, Jiaxuan Gao, Weirui Ye, Shaohuai Liu, Yang Gao, Yi Wu

- Ключ: распределенная система RL, приоритетное обновление, обрезанный LARS

- Expenv: Atari

- Эффективная оптимизация политики в автономном режиме с помощью обученной модели 2023

- Zichen Liu, Siyi Li, Wee Sun Lee, Shuicheng Yan, Zhongwen Xu

- Ключ: регуляризованный одноэтапный алгоритм на основе модели для офлайн-RL

- Expenv: atari , Bsuite

- Код

- Включение произвольных целей перевода с адаптивным поиском дерева 2022

- Wang Ling, Wojciech Stokowiec, Domenic Donato, Chris Dyer, Lei Yu, Laurent Sartran, Austin Matthews

- Ключ: адаптивный поиск деревьев, модели перевода, авторегрессивные модели,

- Expenv: китайский -английский и пуш что -английские задачи от WMT2020, немецкий -английский от WMT2014

- Что не так с глубоким обучением в поиске деревьев для комбинаторной оптимизации 2022

- Maximili1an Böther, Otto Kißig, Martin Taraz, Sarel Cohen, Karen Seidel, Tobias Friedrich

- Ключ: комбинаторная оптимизация, набор тестов с открытым исходным кодом для максимальной проблемы с независимым набором NP-Hard, углубленный анализ популярного алгоритма поиска с гидом, сравните реализации поиска деревьев с другими решателями

- Expenv: NP-Hard Максимальный независимый набор.

- Код

- Планирование и обучение Монте-Карло с оценками ценности действий. 2021

- Youngsoo Jang, Seokin Seo, Jongmin Lee, Kee-Eung Kim

- Ключ: Поиск дерева Monte-Carlo с языковым исследованием, локально оптимистичные оценки языковой ценности.

- Expenv: интерактивные фантастические (если) игры

- Практический массовый параллельный поиск дерева Монте-Карло, применяемый к молекулярному дизайну 2021

- Xiufeng Yang, Tanuj Kr Aasawat, Kazuki Yoshizoe

- Ключ: Массивно параллельный поиск дерева Монте-Карло, молекулярный дизайн, хеш-управляемый параллельный поиск,

- Expenv: коэффициент раздела октанол-воды (LOGP), наказываемый синтетической доступностью (SA) и большим штрафом кольца.

- Следите за неисправностью: простой подход к параллелизированию Поиска Монте -Карло Tree 2020

- Анджи Лю, Цзяншу Чен, Мингзе Ю, Ю Чжай, Сюевен Чжоу, Джи Лю

- Ключ: Параллельный поиск дерева Монте-Карло, эффективно разделяйте дерево на подтисты, сравните коэффициент наблюдения каждого процессора.

- Expenv: Сравнение ускорения и производительности в игре Joy-City, средний эпизод возврат Atari Game

- Код

- Обучение планировать в высоких измерениях с помощью нейронных исследований-эксплуатационных деревьев 2020

- Binghong Chen, Bo Dai, Qinjie Lin, Guo Ye, Han Liu, Le Song

- Ключ: Алгоритм планирования мета -пути, использует новую нейронную архитектуру, которая может изучать многообещающие направления поиска из проблемных структур.

- Expenv: 2D Workspace с 2 DOF (градусов свободы) точечный робот, робот из 3 DOF и робот из 5 DOF Snake

Невра

- Lightzero: унифицированный эталон для поиска Tree Monte Carlo в общих последовательных сценариях решения 2023

- Yazhe Niu, Yuan Pu, Zhenjie Yang, Xueyan Li, Tong Zhou, Jiyuan Ren, Shuai Hu, Hongsheng Li, Yu Liu

- Ключ: первый унифицированный эталон для развертывания MCTS/Muzero в общих сценариях последовательных решений.

- Expenv: ClassicControl, Box2d, Atari, Mujoco, Gobigger, Minigrid, Tictactoe, Connectfour, Gomoku, 2048 и т. Д.

- Большие языковые модели как знания здравого смысла для крупномасштабного планирования задач 2023

- Зируи Чжао, Wee Sun Lee, David Hsu

- Ключ: World Model (LLM) и индуцированная LLM-индуцированная политика могут быть объединены в MCT, чтобы расширить планирование задач.

- Expenv: умножение, планирование путешествия, перестройка объекта

- Поиск дерева Монте -Карло с разведкой Больцмана 2023

- Майкл Пейнтер, Мохамед Байуми, Ник Хоус, Бруно Лакерда

- Ключ: Исследование Больцмана с MCTS, оптимальные действия для максимальной энтропийной цели не обязательно соответствуют оптимальным действиям для исходной цели, двух улучшенных алгоритмов.

- Expenv: окружающая среда замороженного озера, проблема с парусом, уйти

- ОБЩИЙ Взвешенный путь для освоения игр Atari 2023

- Денгвей Чжао, Шикуи Ту, Лей Сюй

- Ключ: Обобщенная консистенция взвешенного пути, механизм взвешивания.

- Expenv: Atari

- Ускорение поиска дерева Монте -Карло с абстракцией состояния дерева вероятности 2023

- Янцин Фу, Мин Сан, Букин Ни, Юэ Гао

- Ключ: Ограничение погрешности состояния дерева вероятности, транзитивность и ошибка агрегации

- Expenv: Atari, Cartpole, Lunarlander, Gomoku

- Расходы на размышление мудро: ускорение MCT с виртуальными расширениями 2022

- Вейруи Йе, Питер Аббейл, Ян Гао

- Ключ: комбинируйте вычисления по сравнению с эксплуатацией, виртуальными расширениями, адаптивно провести время.

- Expenv: atari, 9x9 go

- Планирование образца эффективного имитационного обучения 2022

- Zhao-Heng Yin, Weirui Ye, Qifeng Chen, Yang Gao

- Ключ: поведенческое клонирование , Adversarial имитационное обучение (AIL) , RL на основе MCTS.

- Expenv: DeepMind Control Suite

- Код

- Оценка за пределы работы задачи: анализ концепций в Alphazero в Hex 2022

- Чарльз Ловринг, Джессика Зоса Форде, Джордж Конидарис, Элли Павлик, Майкл Л. Литтман

- Ключ: внутренние представления Alphazero, модель -исследовательские и поведенческие тесты, как эти концепции захватываются в сети.

- Expenv: Hex

- Альфазеро, подобные агентам, устойчивы к состязательным возмущениям? 2022

- Ли-Ченг Лан, Хуан Чжан, Ти-Ронг Ву, Менг-Ю Цай, I-Чен Ву, 4 Чо-Юи Сих

- Ключ: состязательные государства, первая состязательная атака на Go AIS.

- Expenv: Go

- Монте-Карло Дерево спуск для оптимизации черного ящика 2022

- Ягуан Чжай, Сикун Гао

- Ключ: оптимизация черного ящика, как дальнейшая интеграция спуска на основе образцов для более высокой оптимизации.

- Expenv: синтетические функции для нелинейной оптимизации, проблемы обучения в области обучения в средах локомоции Mujoco, а также проблемы оптимизации в поиске нейронной архитектуры (NAS).

- Выбор переменных на основе поиска дерева Монте -Карло для байесовской оптимизации 2022

- Lei Song ∗, Ke Xue ∗, Xiaobin Huang, Chao Qian

- Ключ: низкоразмерное подпространство через MCTS, оптимизизируя в подпространстве с любым алгоритмом байесовской оптимизации.

- Expenv: проблемы NAS-Bench и Mujoco Locomotion

- Поиск дерева Монте -Карло с итеративно уточняющим абстракции состояний 2021

- Сэмюэль Сокота, Калеб Хо, Захин Ахмад, Дж. Зико Колтер

- Ключ: стохастические среды, прогрессивное расширение, уточнение абстракции

- Expenv: блэкджек, ловушка, пять на пять ходов.

- Глубокое синоптическое планирование Монте -Карло в разведывании слепых шахмат 2021

- Грегори Кларк

- Ключ: несовершенная информация, состояние убеждения с невзвешенным фильтром частиц, новая стохастическая абстракция информационных состояний.

- Expenv: разведка слепые шахматы

- Поли-хот: Планирование Монте-Карло в непрерывном пространстве MDP с неасимптотическим анализом 2020

- Weichao Mao, Kaiqing Zhang, Qiaomin Xie, Tamer Ba¸sar

- Ключ: Пространства непрерывного состояния, иерархическая оптимистическая оптимизация.

- Expenv: Cartpole, перевернутый маятник, качание и лунный.

- Разделение пространства поиска обучения для оптимизации черного ящика с использованием Monte Carlo Tree Search 2020

- Линнан Ван, Родриго Фонсека, Юандонг Тянь

- Ключ: изучает разделение пространства поиска, используя несколько образцов, нелинейную границу принятия решений и изучает локальную модель для выбора хороших кандидатов.

- Expenv: Mujoco Mocomotion Задачи, мелкие тесты,

- Смешивание и совпадение: оптимистичный подход к поиску деревьев для обучения моделей из распределений смеси 2020

- Мэтью Фоу, Раджат Сен, Картикеян Шанмугам, Константин Караманис, Санджай Шаккоттай

- Ключ: Ковариатная проблема сдвига, микс и совпадение объединяет стохастический градиентный спуск (SGD) с оптимистичным поиском дерева и повторном использовании модели (развитие частично обученных моделей с образцами из разных распределений смесей)

- Код

Другая конференция или журнал

- Обучение остановке: динамическое моделирование Monte-Carlo Tree Search Aaai 2021.

- О поиске и подкреплении Monte Carlo Tree Tree Journal Journal of Artifical Intelligence Research 2017.

- Образец, эффективный поиск нейронной архитектуры, обучающий действия для поиска Tree Tree Monte Carlo Trasters Transactions по анализу паттернов и машинного интеллекта 2022.

Обратная связь и вклад

Подать проблему на GitHub

Откройте или участвуйте в нашем дискуссионном форуме

Обсудить на сервере Discord Lightzero

Свяжитесь с нашим электронным письмом ([email protected])

Мы ценим все отзывы и вклад в улучшение Lightzero, как алгоритмов, так и системных конструкций.

? Цитирование

@article{niu2024lightzero,

title={LightZero: A Unified Benchmark for Monte Carlo Tree Search in General Sequential Decision Scenarios},

author={Niu, Yazhe and Pu, Yuan and Yang, Zhenjie and Li, Xueyan and Zhou, Tong and Ren, Jiyuan and Hu, Shuai and Li, Hongsheng and Liu, Yu},

journal={Advances in Neural Information Processing Systems},

volume={36},

year={2024}

}

@article{pu2024unizero,

title={UniZero: Generalized and Efficient Planning with Scalable Latent World Models},

author={Pu, Yuan and Niu, Yazhe and Ren, Jiyuan and Yang, Zhenjie and Li, Hongsheng and Liu, Yu},

journal={arXiv preprint arXiv:2406.10667},

year={2024}

}

@article{xuan2024rezero,

title={ReZero: Boosting MCTS-based Algorithms by Backward-view and Entire-buffer Reanalyze},

author={Xuan, Chunyu and Niu, Yazhe and Pu, Yuan and Hu, Shuai and Liu, Yu and Yang, Jing},

journal={arXiv preprint arXiv:2404.16364},

year={2024}

}? Благодарности

Этот проект был разработан частично основан на следующих новаторских работах по репозиториям GitHub. Мы выражаем глубокую благодарность за эти основополагающие ресурсы:

- https://github.com/opendilab/di-engine

- https://github.com/deepmind/mctx

- https://github.com/yewr/effiftzero

- https://github.com/werner-duvaud/muzero General

Мы хотели бы выразить нашу особую благодарность следующим участникам @paparazz1, @karroyan, @nighood, @jayyoung0802, @timothijoe, @tutuhuss, @harryxuancy, @puyuan1996, @hansbug за их ценные взносы и поддержку этой библиотеке Algorithm.

Спасибо всем, кто внес свой вклад в этот проект:

? ️ лицензия

Весь код в этом репозитории находится под лицензией Apache 2.0.

(Вернуться к вершине)