Lightzero

2024.12.10 Lightzero-V0.1.0に更新

英語| 简体中文(単純化された中国人)|ドキュメント| Lightzero Paper | Unizero Paper | Rezero Paper

Lightzeroは、モンテカルロツリー検索(MCTS)とディープ補強学習(RL)を組み合わせた軽量で効率的で、理解しやすいオープンソースアルゴリズムツールキットです。 Lightzeroに関するご質問については、RAGベースのQ&AアシスタントであるZeropalを参照できます。

?背景

AlphazeroとMuzeroによって例示されるモンテカルロツリー検索とディープ補強学習の統合は、GoやAtariを含むさまざまなゲームで前例のないパフォーマンスレベルを達成しました。この高度な方法論は、タンパク質構造予測やマトリックス増殖アルゴリズムの検索などの科学的領域にも大きな進歩を遂げました。以下は、モンテカルロツリー検索アルゴリズムシリーズの歴史的進化の概要です。

上の写真は、Lightzeroのフレームワークパイプラインです。以下の3つのコアモジュールを簡単に紹介します。

モデル: Model 、ネットワーク構造を初期化するための__init__関数と、ネットワークのフォワード伝播を計算するためのforward関数を含むネットワーク構造を定義するために使用されます。

ポリシー: Policy 、ネットワークの更新方法を定義し、 learningプロセス、 collectingプロセス、 evaluationプロセスの3つのプロセスを含む環境と対話します。

MCTS : MCTS 、モンテカルロ検索ツリーの構造と、ポリシーとの対話方法を定義します。 MCTSの実装には、PythonとC ++の2つの言語がそれぞれptreeとctreeに実装されています。

LightZeroのファイル構造については、Lightzero_file_structureを参照してください。

?統合アルゴリズム

Lightzeroは、MCTSアルゴリズムのPytorch実装(CythonとCPPと組み合わせた場合もある)を含むライブラリです。

- アルファゼロ

- ムゼロ

- サンプリングされたムゼロ

- 確率的ムゼロ

- EfficientYzero

- Gumbel Muzero

- Rezero

- Unizero

Lightzeroによって現在サポートされている環境とアルゴリズムは、以下の表に示されています。

| Env./Algo。 | アルファゼロ | ムゼロ | サンプリングされたムゼロ | EfficientYzero | サンプリングされたEfficientZero | Gumbel Muzero | 確率的ムゼロ | Unizero | サンプリングされたUnizero | Rezero |

|---|

| Tictactoe | ✔ | ✔ | | | | ✔ | | ✔ | | |

| ゴモク | ✔ | ✔ | | | | ✔ | | ✔ | | ✔ |

| Connect4 | ✔ | ✔ | | | | | | ✔ | | ✔ |

| 2048 | --- | ✔ | | | | | ✔ | ✔ | | |

| チェス | | | | | | | | | | |

| 行く | | | | | | | | | | |

| カートポール | --- | ✔ | | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ |

| 振り子 | --- | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ | |

| Lunarlander | --- | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | |

| Bipedalwalker | --- | ✔ | ✔ | ✔ | ✔ | ✔ | | | ✔ | |

| アタリ | --- | ✔ | | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ |

| DeepMindコントロール | --- | --- | ✔ | --- | ✔ | | | | ✔ | |

| ムホコ | --- | ✔ | | ✔ | ✔ | | | | | |

| Minigrid | --- | ✔ | | ✔ | ✔ | | | ✔ | | |

| bsuite | --- | ✔ | | ✔ | ✔ | | | ✔ | | |

| メモリ | --- | ✔ | | ✔ | ✔ | | | ✔ | | |

| sumtothree(ビリヤード) | --- | | | | ✔ | | | | | |

| メタドライブ | --- | | | | ✔ | | | | | |

(1):「✔」とは、対応するアイテムが完成し、適切にテストされていることを意味します。

(2): ""は、対応するアイテムが待機リストにあることを意味します(進行中の作業)。

(3): "---"は、このアルゴリズムがこの環境をサポートしないことを意味します。

インストール

次のコマンドを使用して、GitHubソースコードから開発中の最新のLightZeroをインストールできます。

git clone https://github.com/opendilab/LightZero.git

cd LightZero

pip3 install -e .

Lightzeroは現在、 LinuxプラットフォームとmacOSプラットフォームでのみコンピレーションをサポートしていることに注意してください。このサポートをWindowsプラットフォームに拡張することに積極的に取り組んでいます。この移行中のあなたの忍耐は大歓迎です。

Dockerでのインストール

また、Lightzeroライブラリを実行するために必要なすべての依存関係を備えた環境をセットアップするDockerFileも提供します。このDocker画像はUbuntu 20.04に基づいており、Python 3.8をインストールし、他の必要なツールやライブラリをインストールします。 DockerFileを使用してDocker画像を構築し、この画像からコンテナを実行し、コンテナ内でLightzeroコードを実行する方法を次に示します。

- DockerFileをダウンロード:DockerFileは、LightZeroリポジトリのルートディレクトリにあります。このファイルをローカルマシンにダウンロードしてください。

- ビルドコンテキストの準備:ローカルマシンに新しい空のディレクトリを作成し、DockerFileをこのディレクトリに移動し、このディレクトリに移動します。このステップは、ビルドプロセス中に不必要なファイルをDockerデーモンに送信しないようにするのに役立ちます。

mkdir lightzero-docker

mv Dockerfile lightzero-docker/

cd lightzero-docker/

- Docker画像の作成:次のコマンドを使用して、Docker画像を作成します。このコマンドは、DockerFileを含むディレクトリ内から実行する必要があります。

docker build -t ubuntu-py38-lz:latest -f ./Dockerfile .

- 画像からコンテナを実行します。次のコマンドを使用して、バッシュシェルを使用してインタラクティブモードで画像からコンテナを起動します。

docker run -dit --rm ubuntu-py38-lz:latest /bin/bash

- コンテナ内でLightZeroコードを実行します。コンテナ内に入ったら、次のコマンドでPythonスクリプトの例を実行できます。

python ./LightZero/zoo/classic_control/cartpole/config/cartpole_muzero_config.py

クイックスタート

ムゼロエージェントを訓練してカートポールをプレイします。

cd LightZero

python3 -u zoo/classic_control/cartpole/config/cartpole_muzero_config.py

Muzeroエージェントを訓練してPongをプレイします。

cd LightZero

python3 -u zoo/atari/config/atari_muzero_segment_config.py

Muzeroエージェントを訓練してTictactoeをプレイします。

cd LightZero

python3 -u zoo/board_games/tictactoe/config/tictactoe_muzero_bot_mode_config.py

Unizeroのエージェントを訓練してPongをプレイします。

cd LightZero

python3 -u zoo/atari/config/atari_unizero_segment_config.py

ドキュメント

Lightzeroのドキュメントはこちらをご覧ください。チュートリアルとAPIリファレンスが含まれています。

環境とアルゴリズムのカスタマイズに興味がある人には、関連するガイドを提供します。

- 環境をカスタマイズします

- アルゴリズムをカスタマイズします

- 構成ファイルを設定する方法は?

- ロギングおよび監視システム

ご質問がある場合は、お気軽にお問い合わせください。

ベンチマーク

クリックして展開します

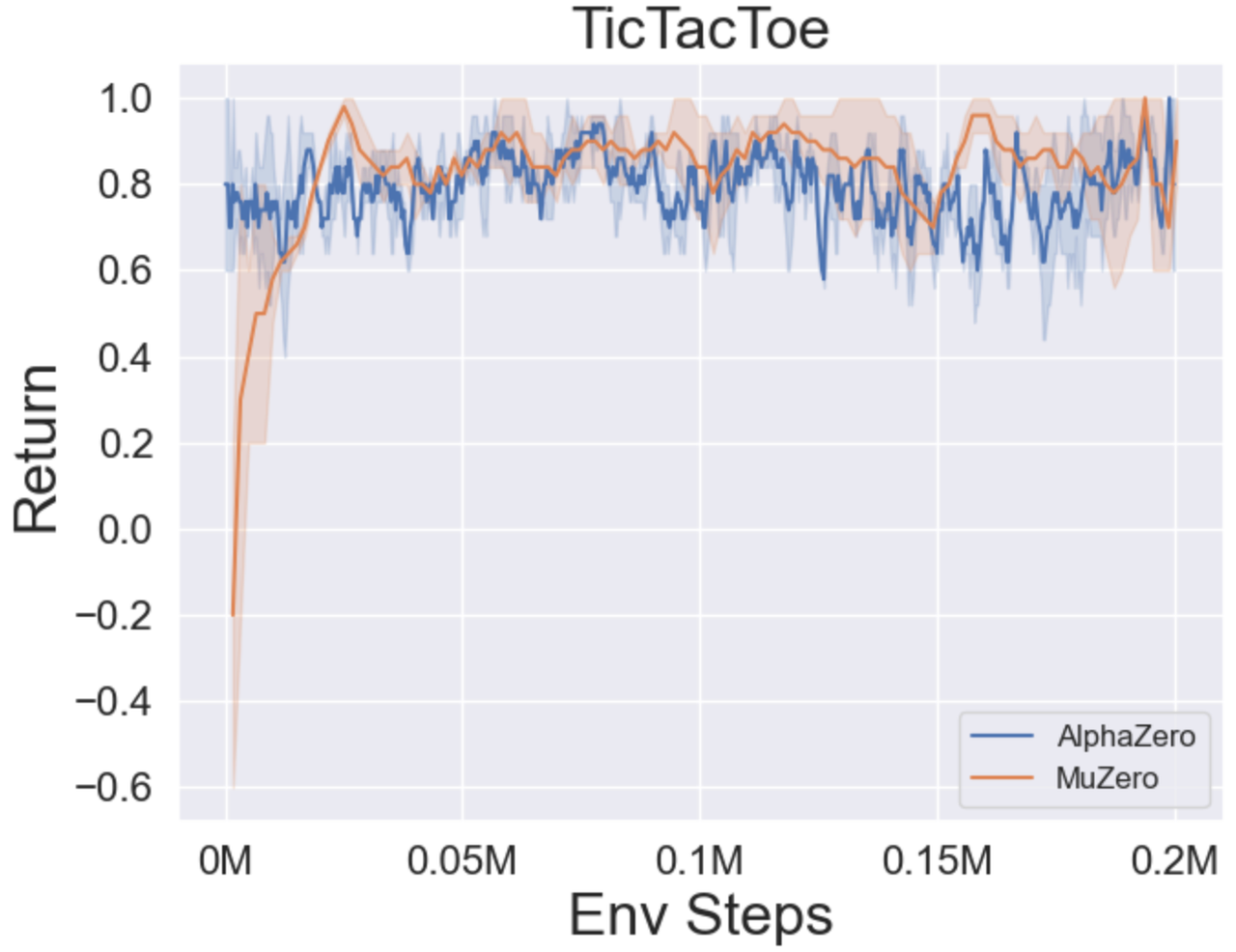

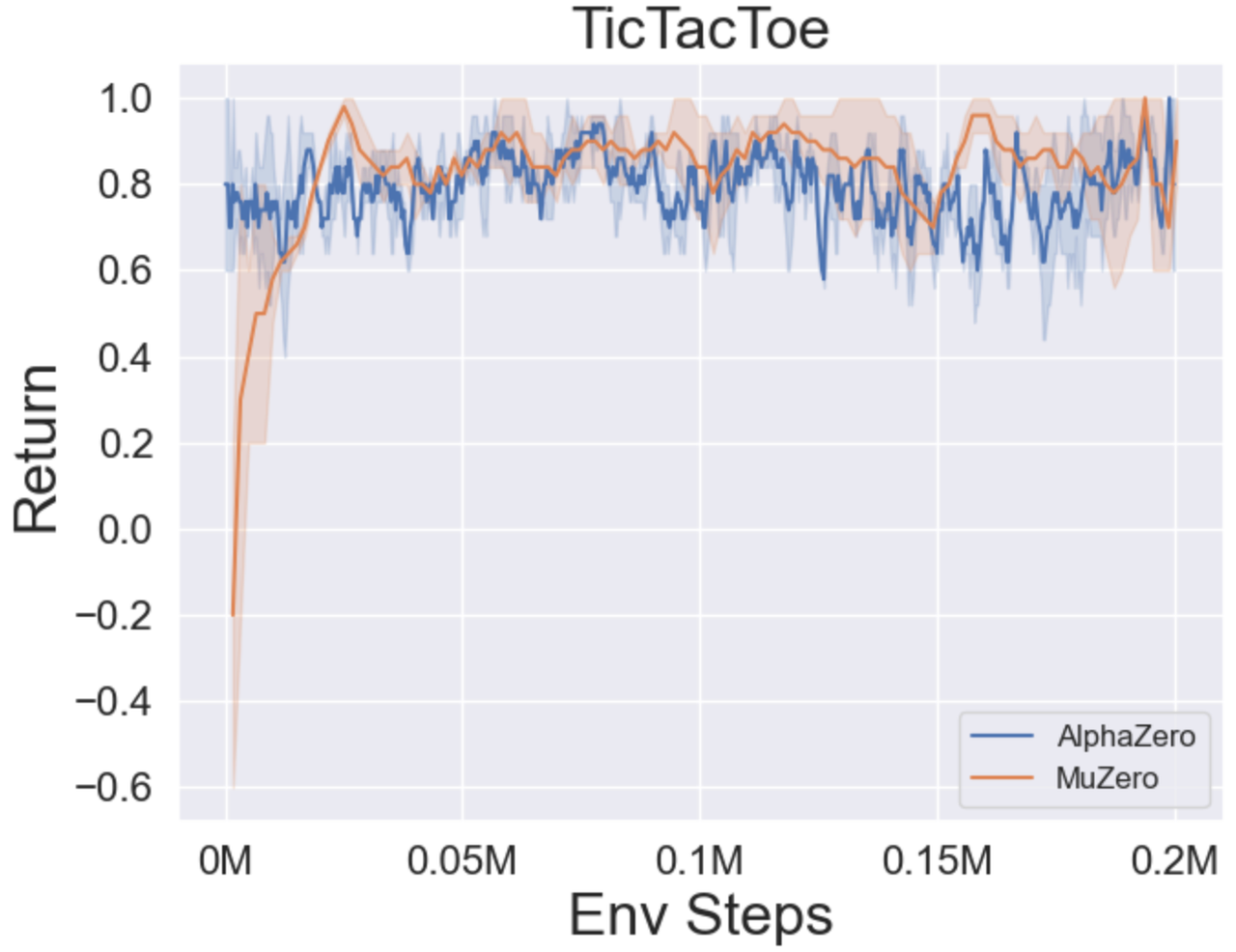

- 以下は、3つのボードゲームのAlphazeroとMuzeroのベンチマークの結果です:Tictactoe、Connect4、Gomoku。

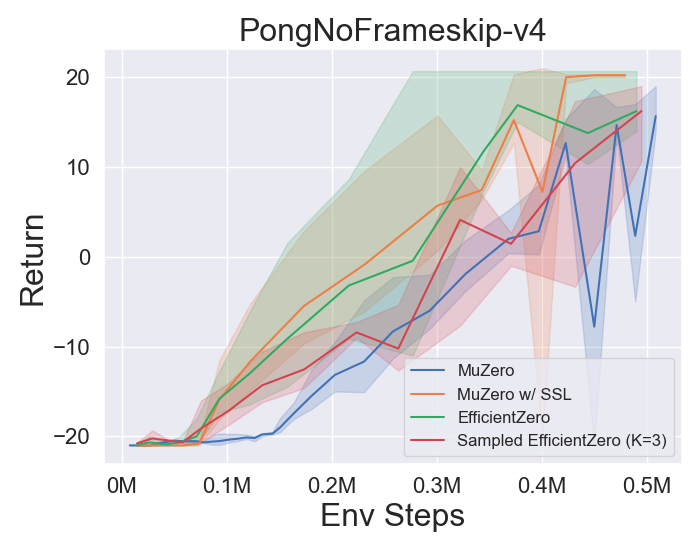

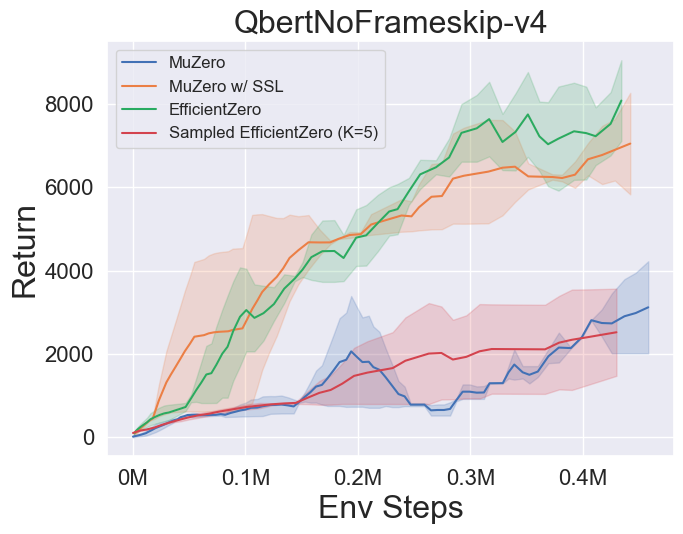

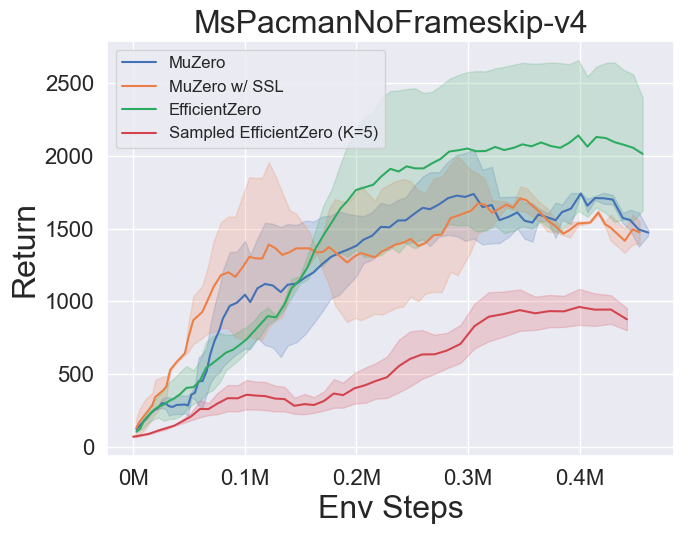

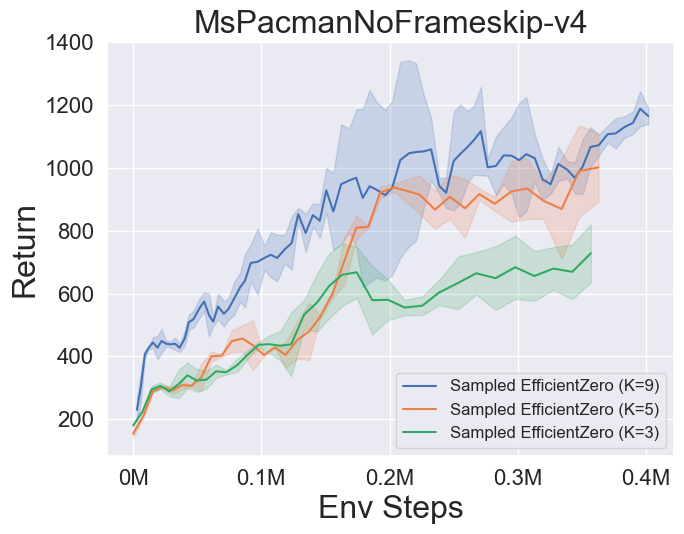

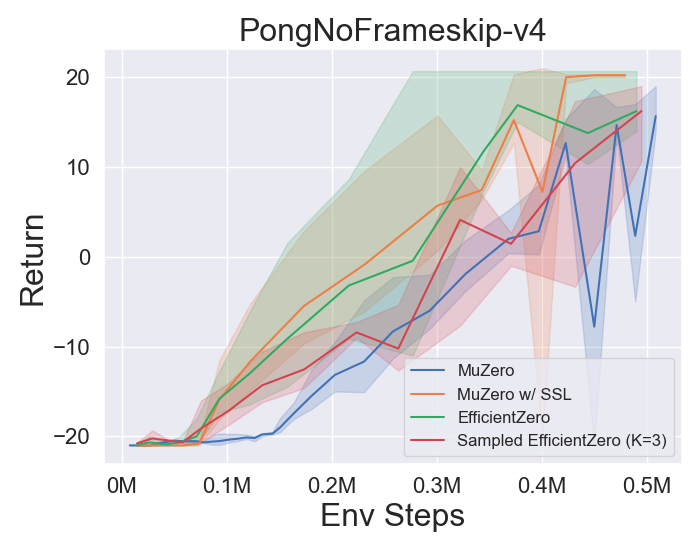

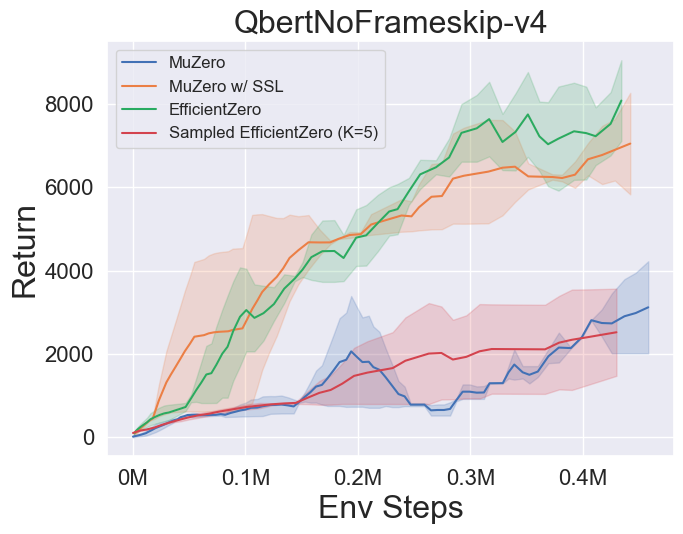

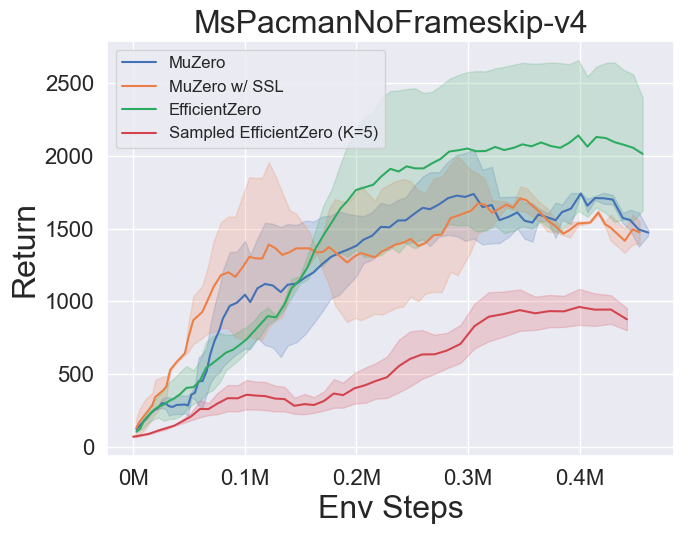

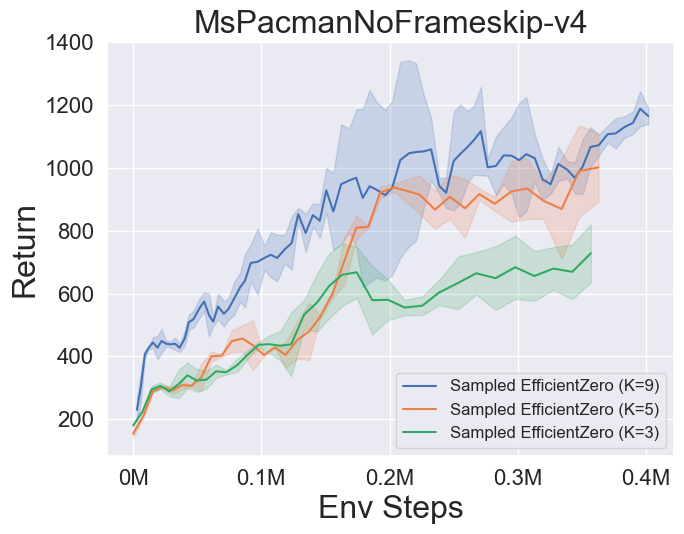

- 以下は、Atariの3つの離散アクションスペースゲームでMuzero、Muzero W/ SSL、EfficientyZero、およびEfficientZeroのサンプリングのベンチマーク結果です。

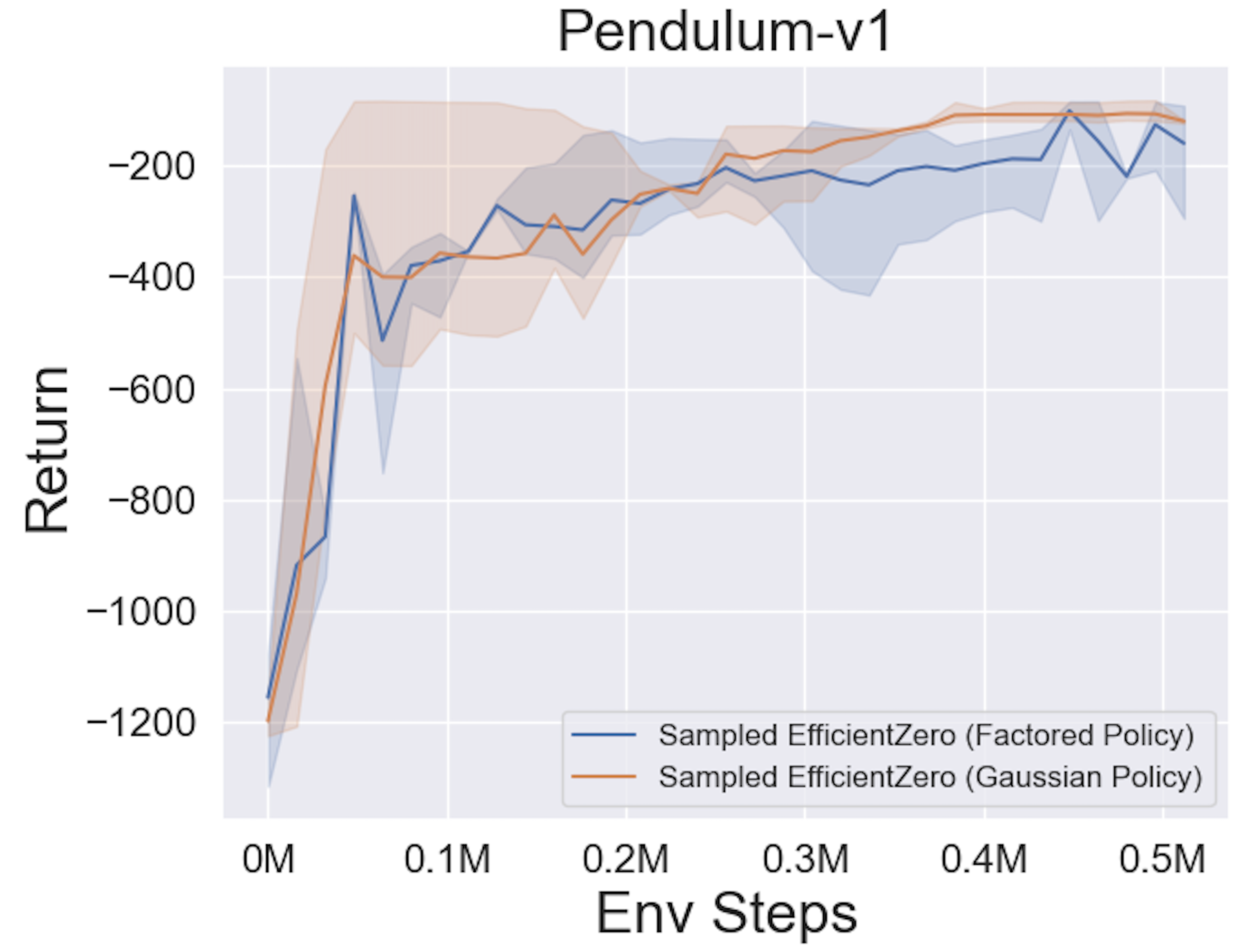

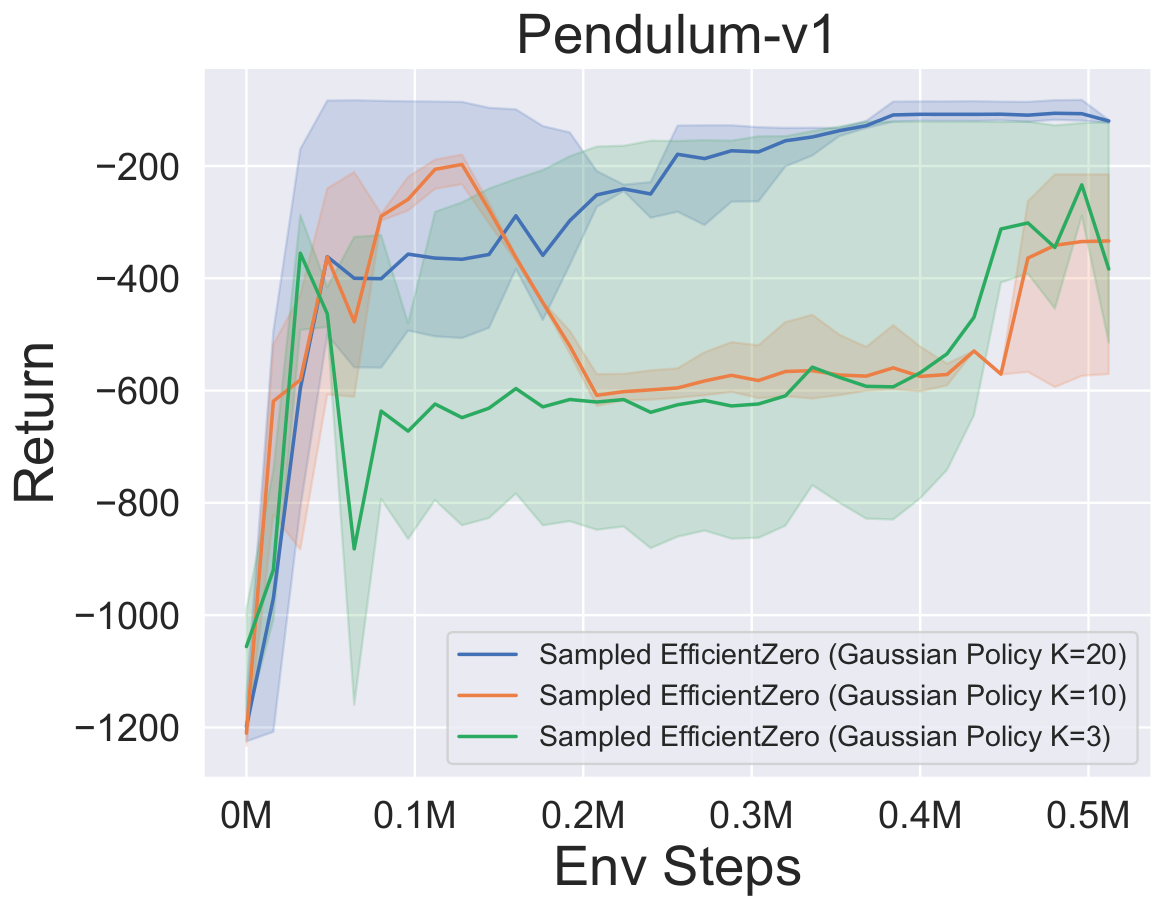

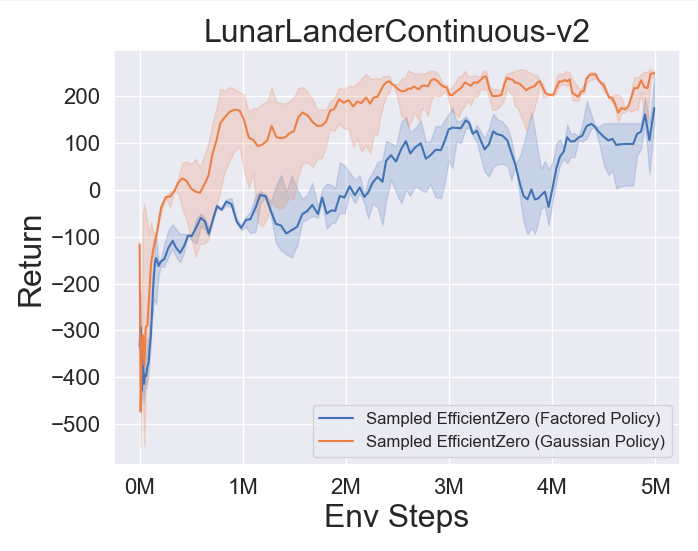

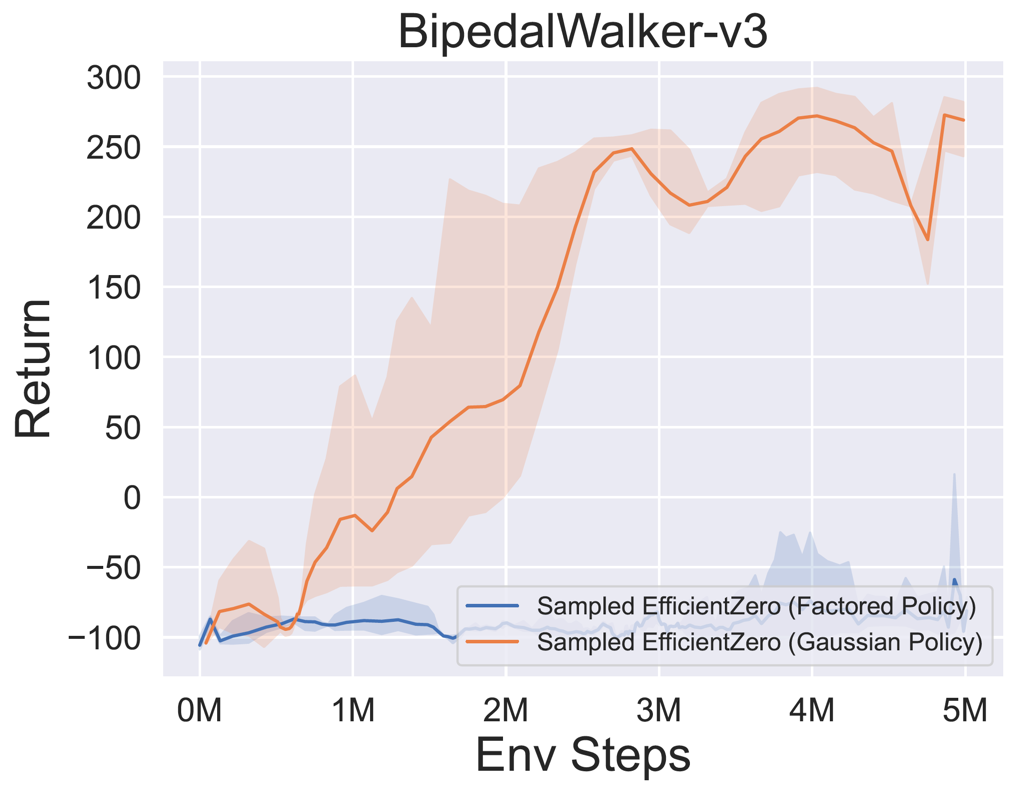

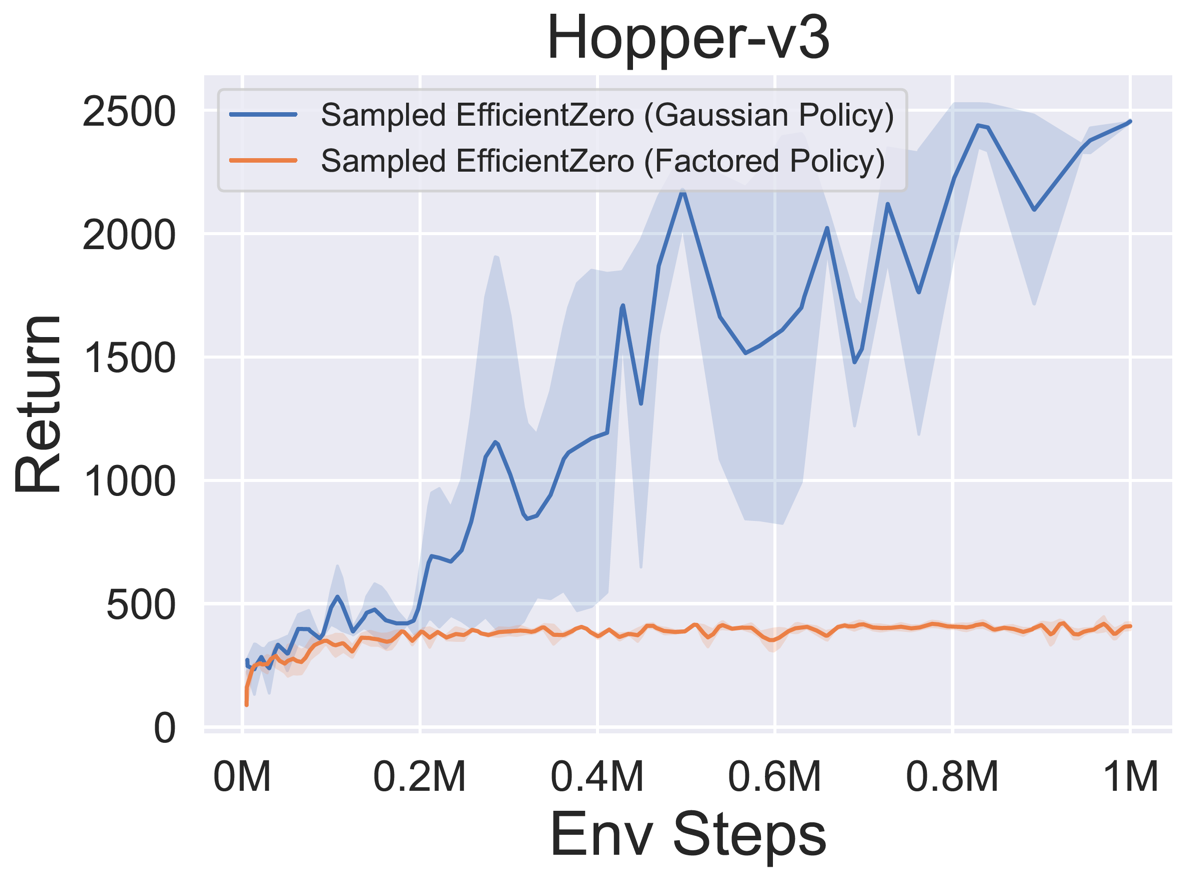

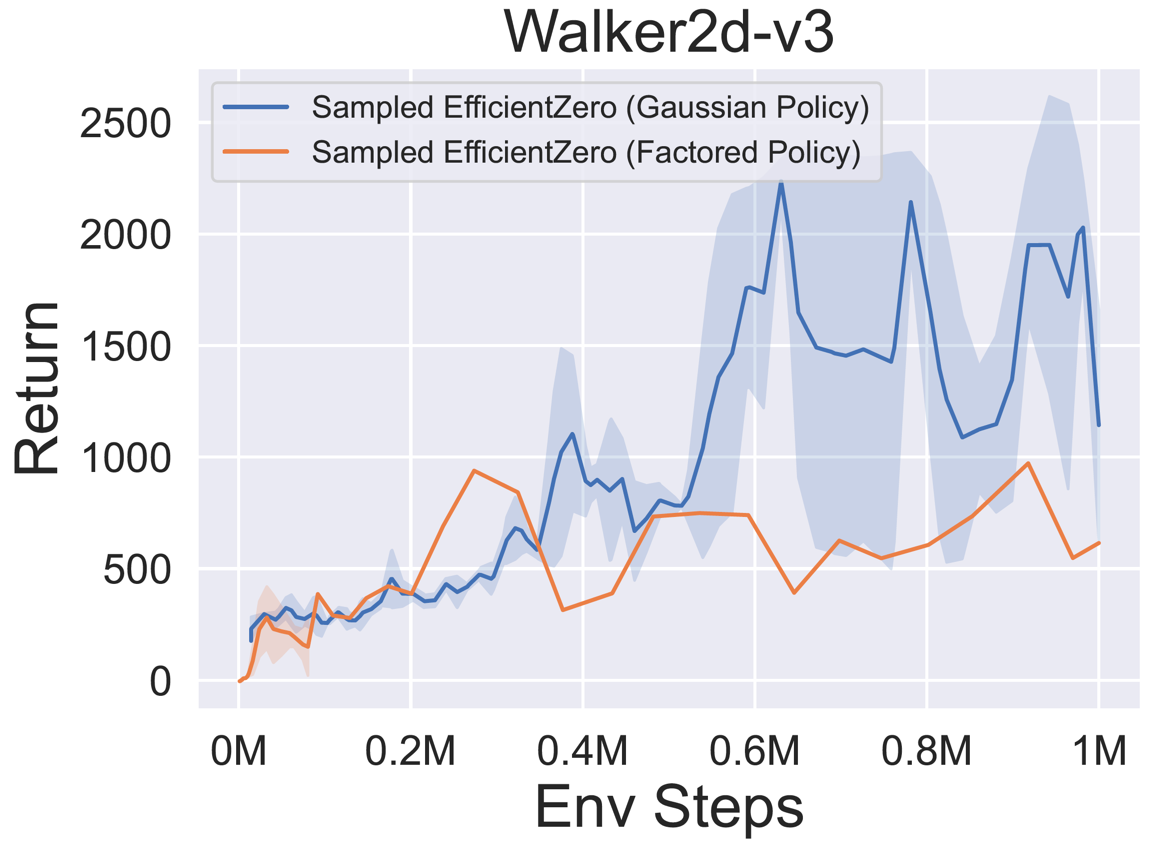

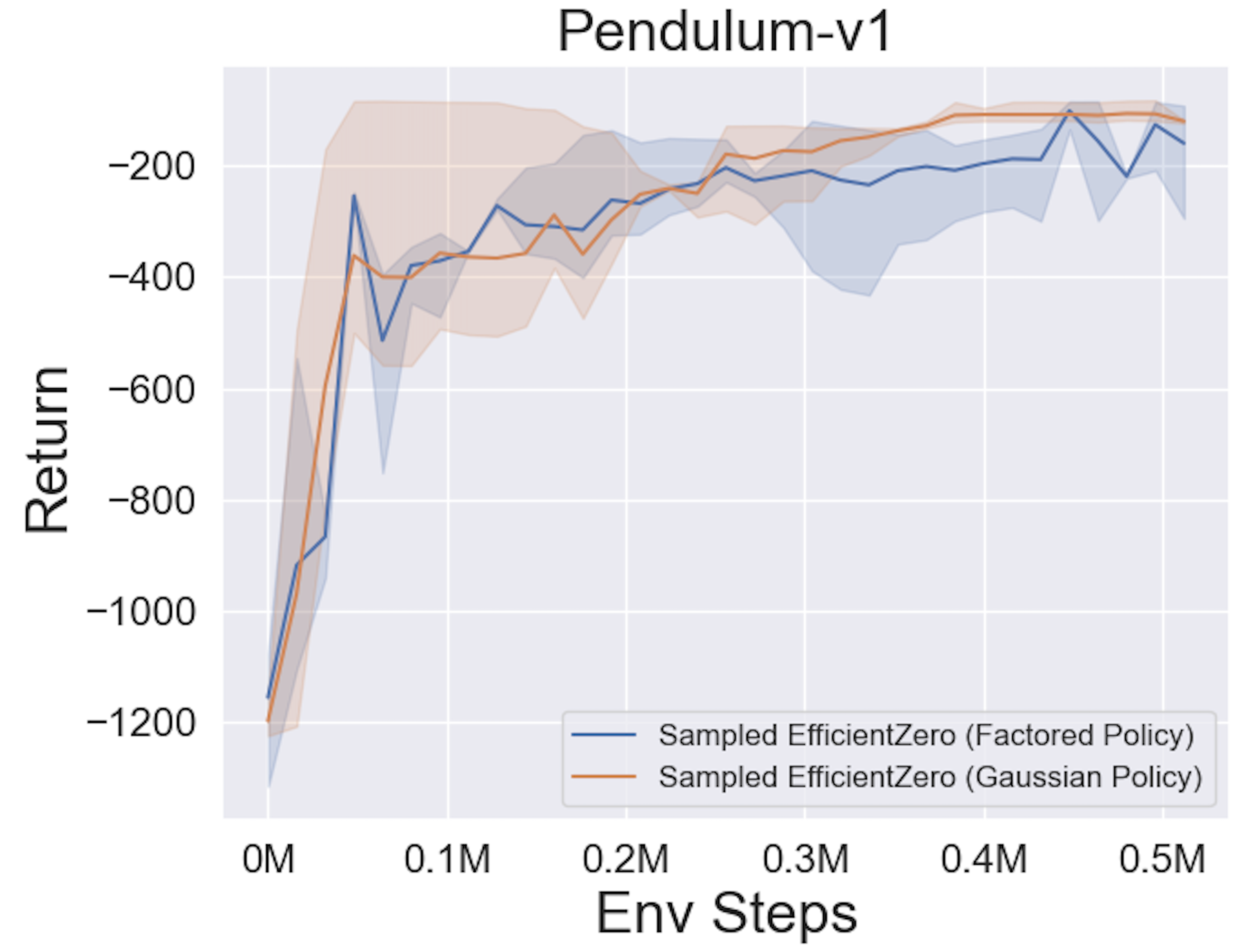

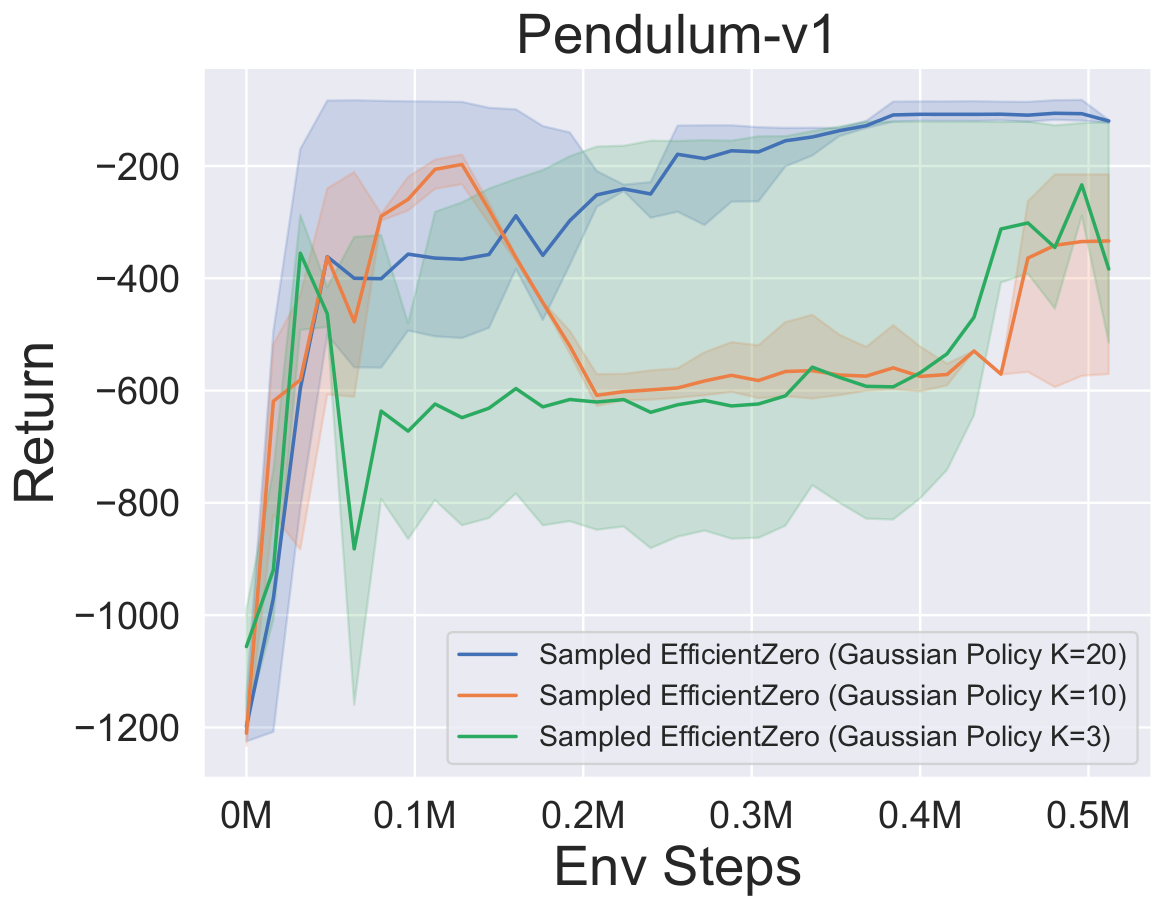

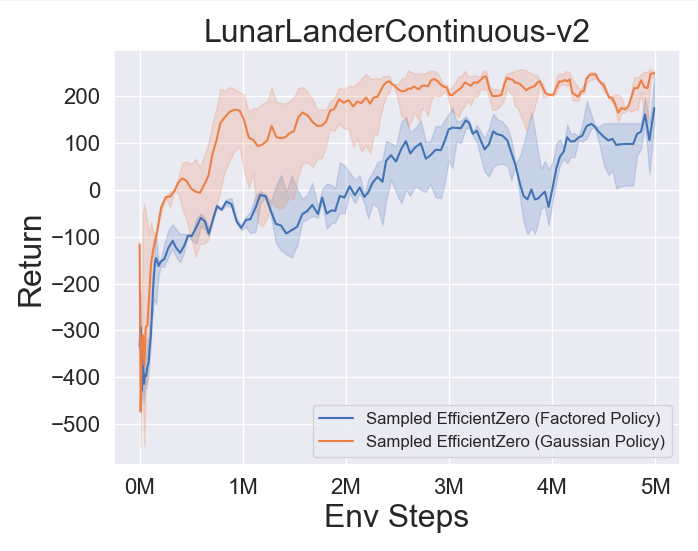

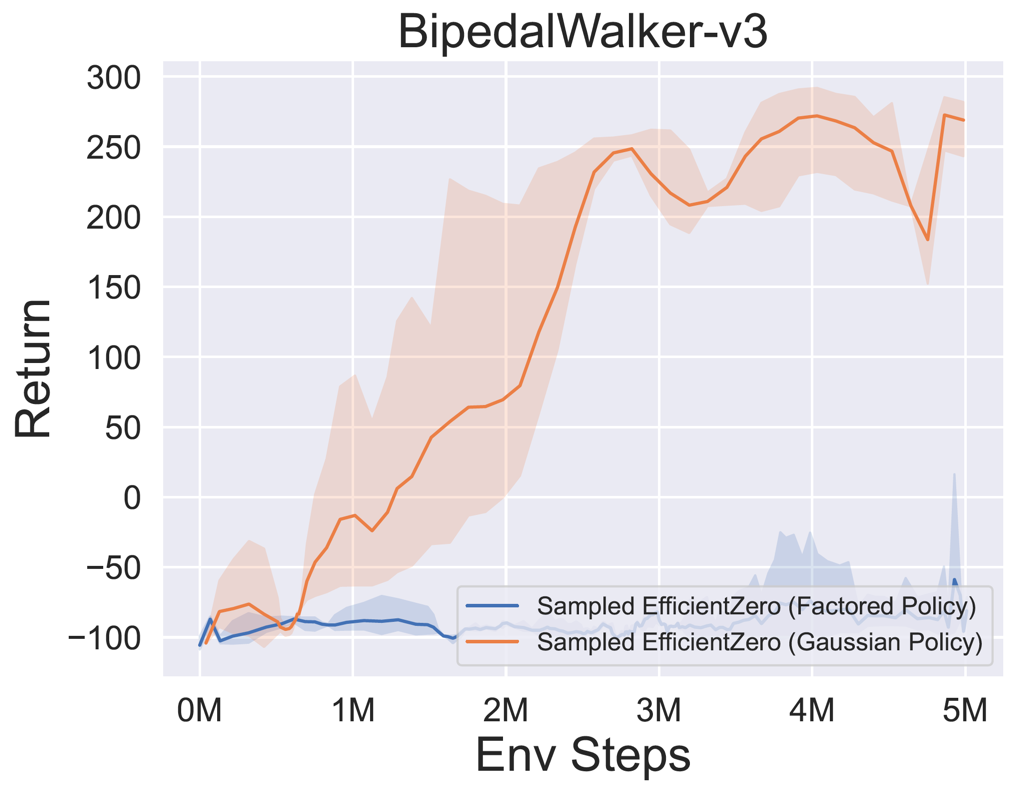

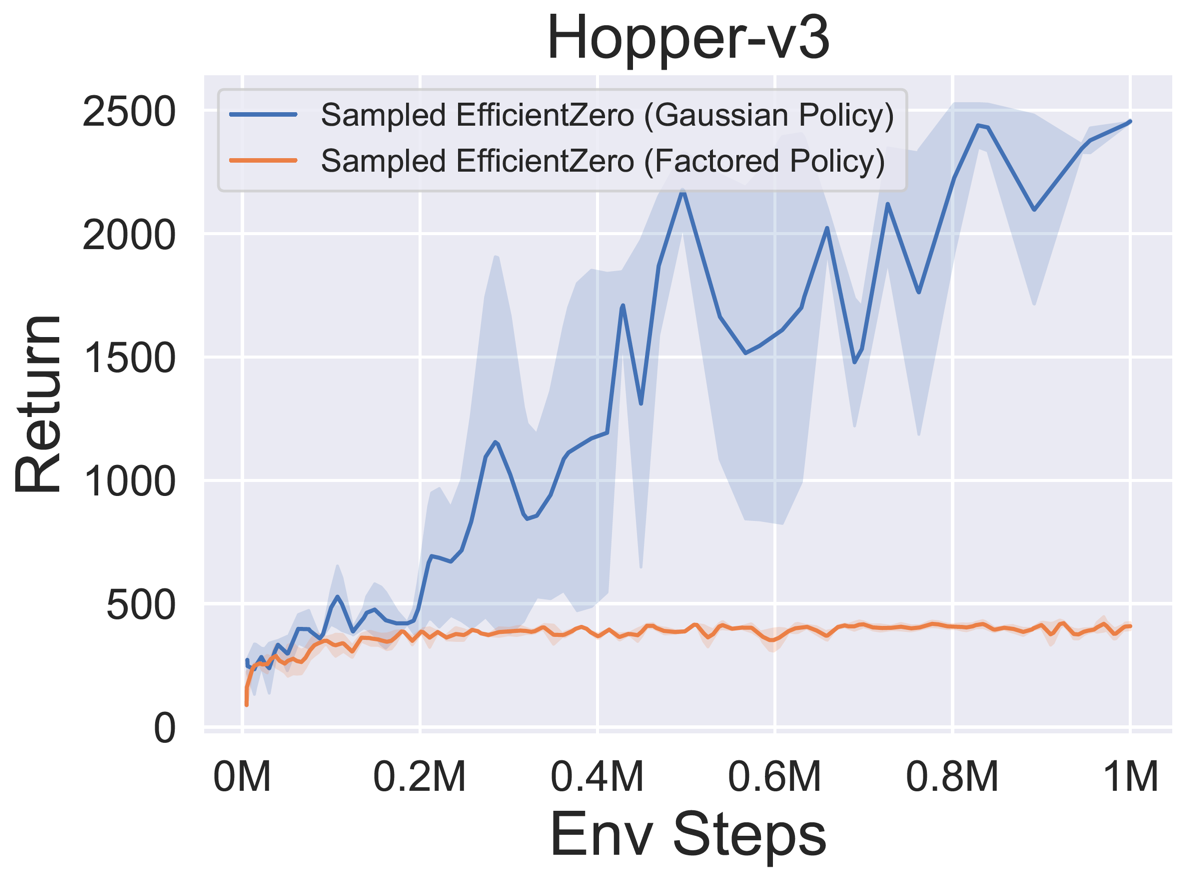

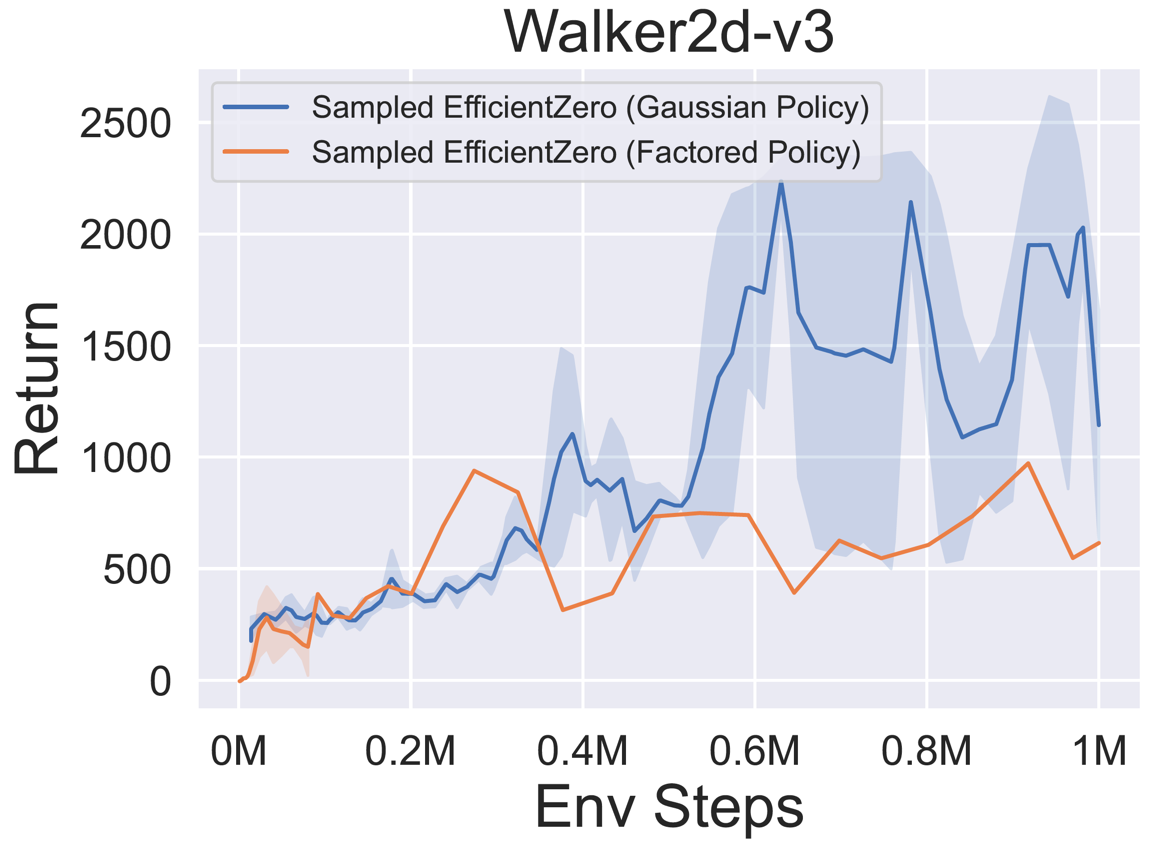

- 以下は、3つの古典的な連続アクションスペースゲームの

Factored/Gaussianポリシー表現を備えたサンプルされたEfficientZeroのベンチマーク結果です:Pendulum-V1、LunlanderContinuous-V2、Bipedalwalker-V3および2つのMujoco連続アクションスペースゲーム:Hopper-V3、Walker2D-V3。

「Factored Policy」は、エージェントがカテゴリー分布を出力するポリシーネットワークを学習することを示しています。手動の離散化後、5つの環境のアクション空間の寸法は、それぞれ11、49(7^2)、256(4^4)、64(4^3)、および4096(4^6)です。一方、「ガウスポリシー」とは、ガウス分布のパラメーター(MUおよびSIGMA)を直接出力するポリシーネットワークを学習するエージェントを指します。

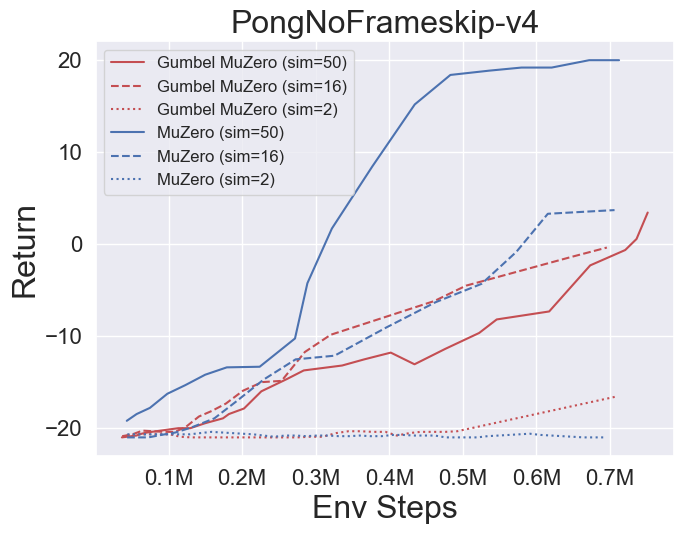

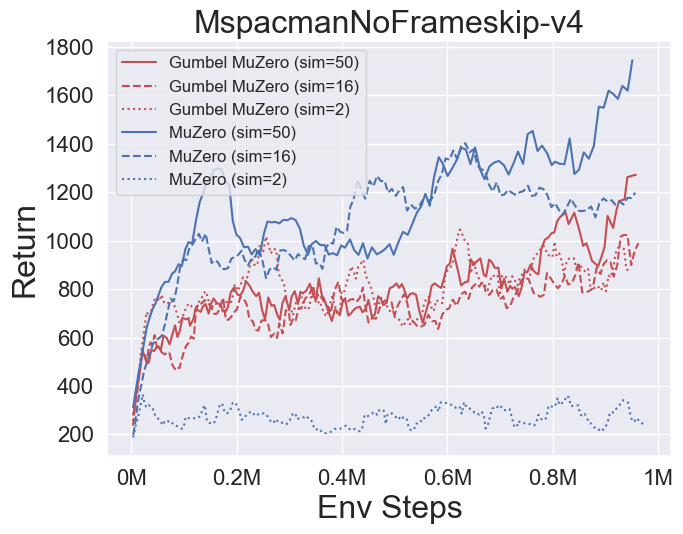

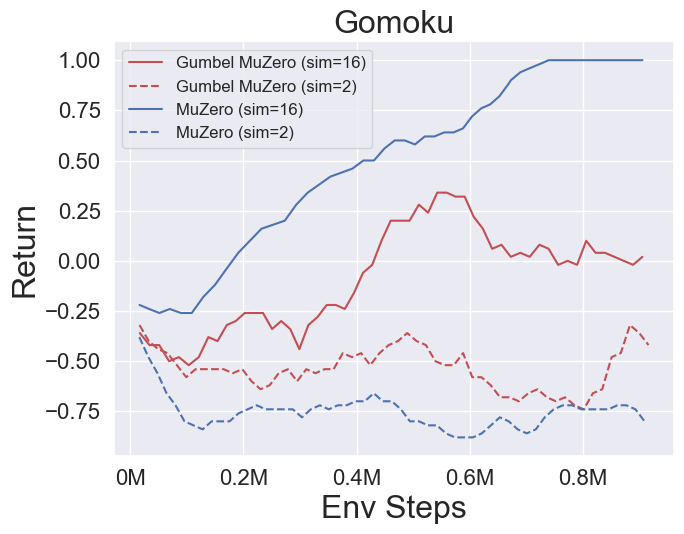

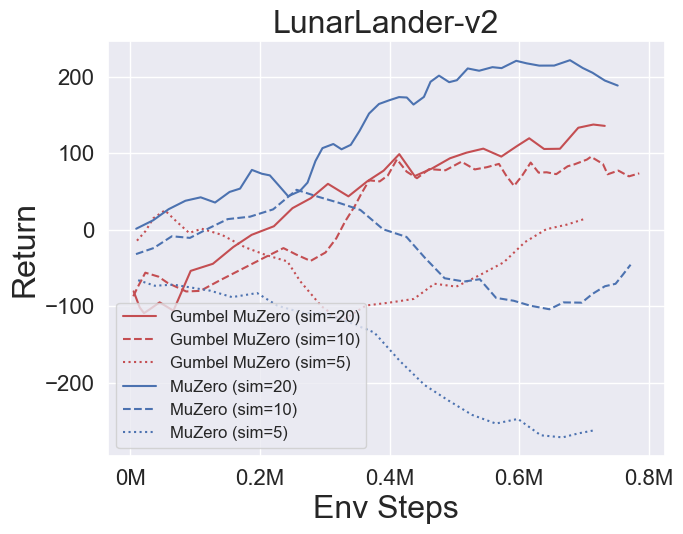

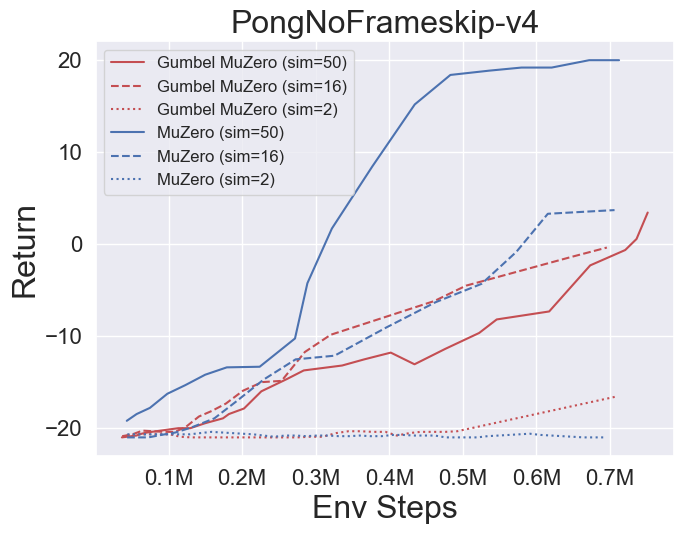

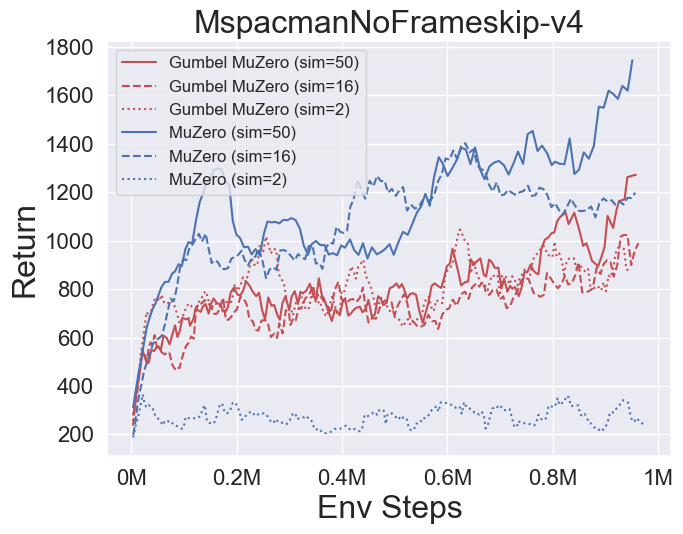

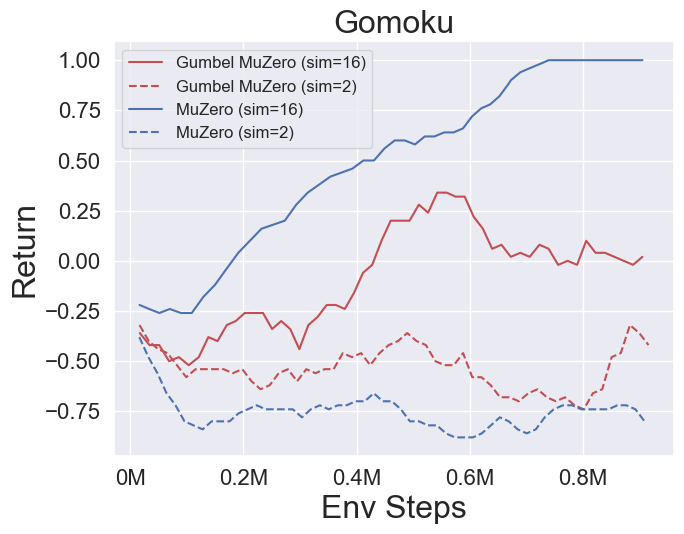

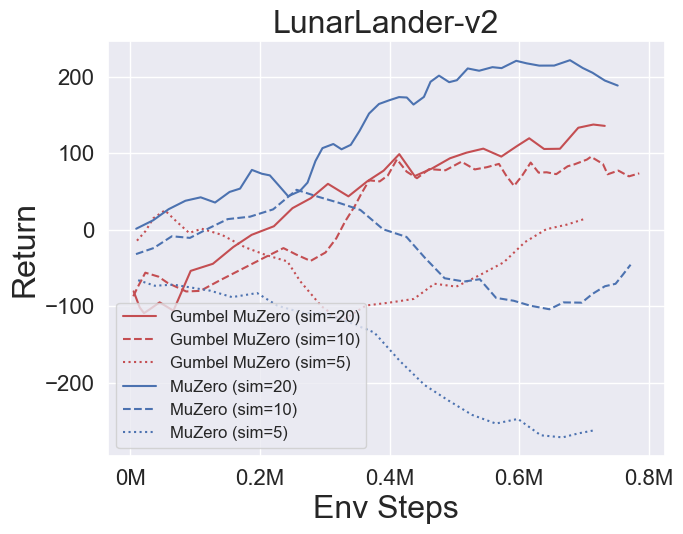

- 以下は、4つの環境でのGumbelmuzeroとMuzero(異なるシミュレーションコストの下)のベンチマーク結果です:Pongnoframeskip-V4、MSPACMANNOFRAMESKIP-V4、GOMOKU、およびLUNARLANDERCERCONTINUOUS-V2。

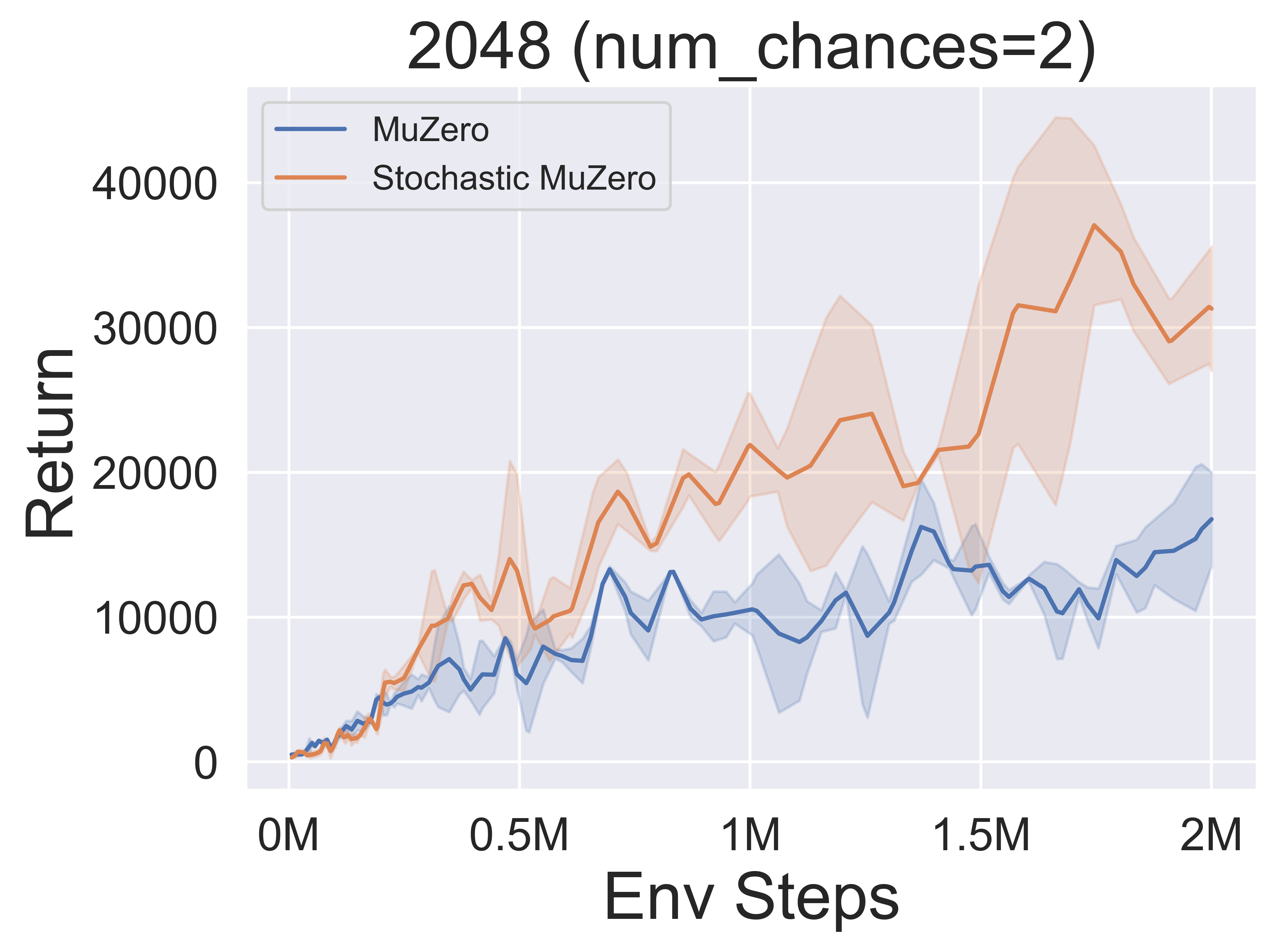

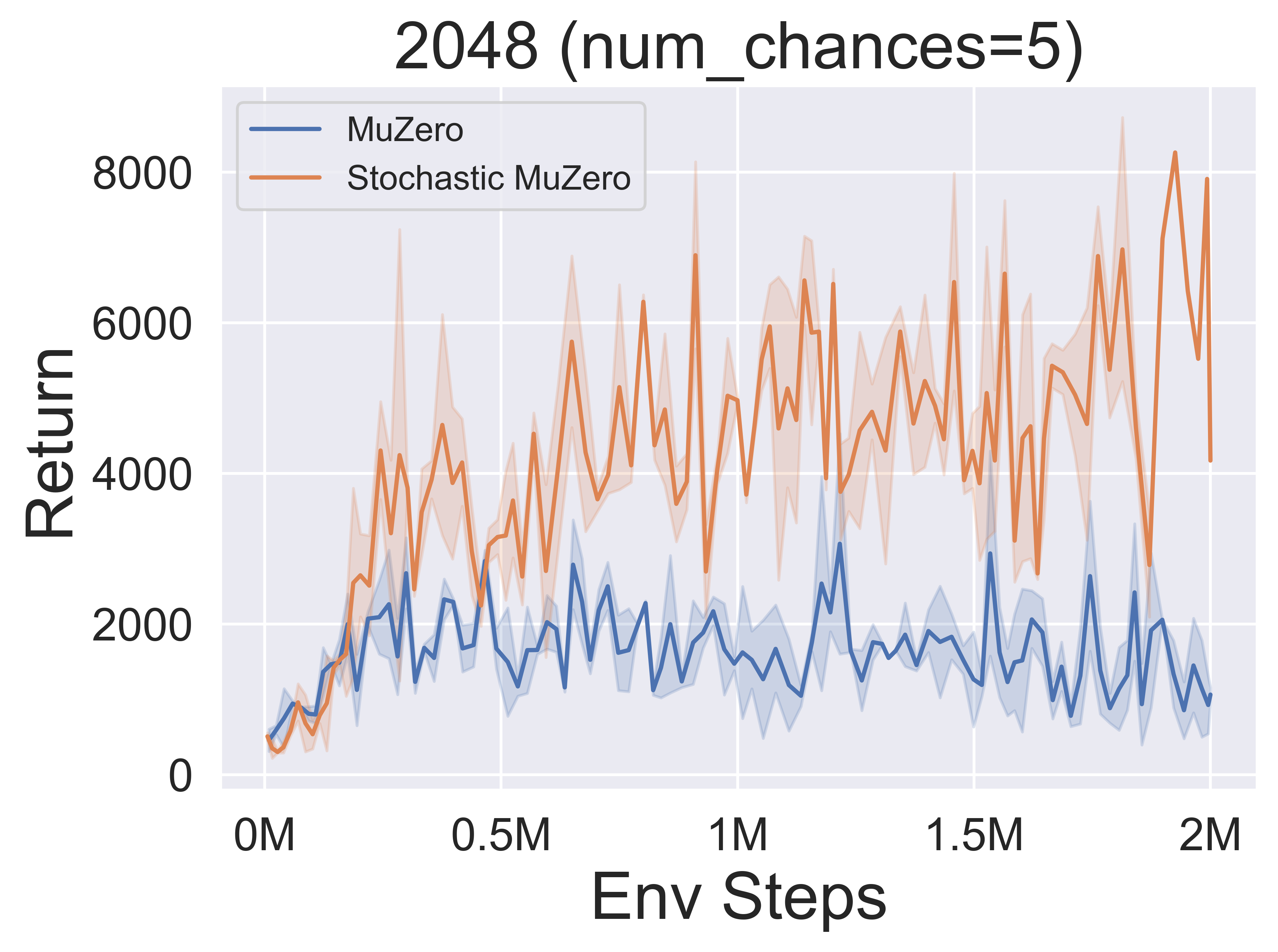

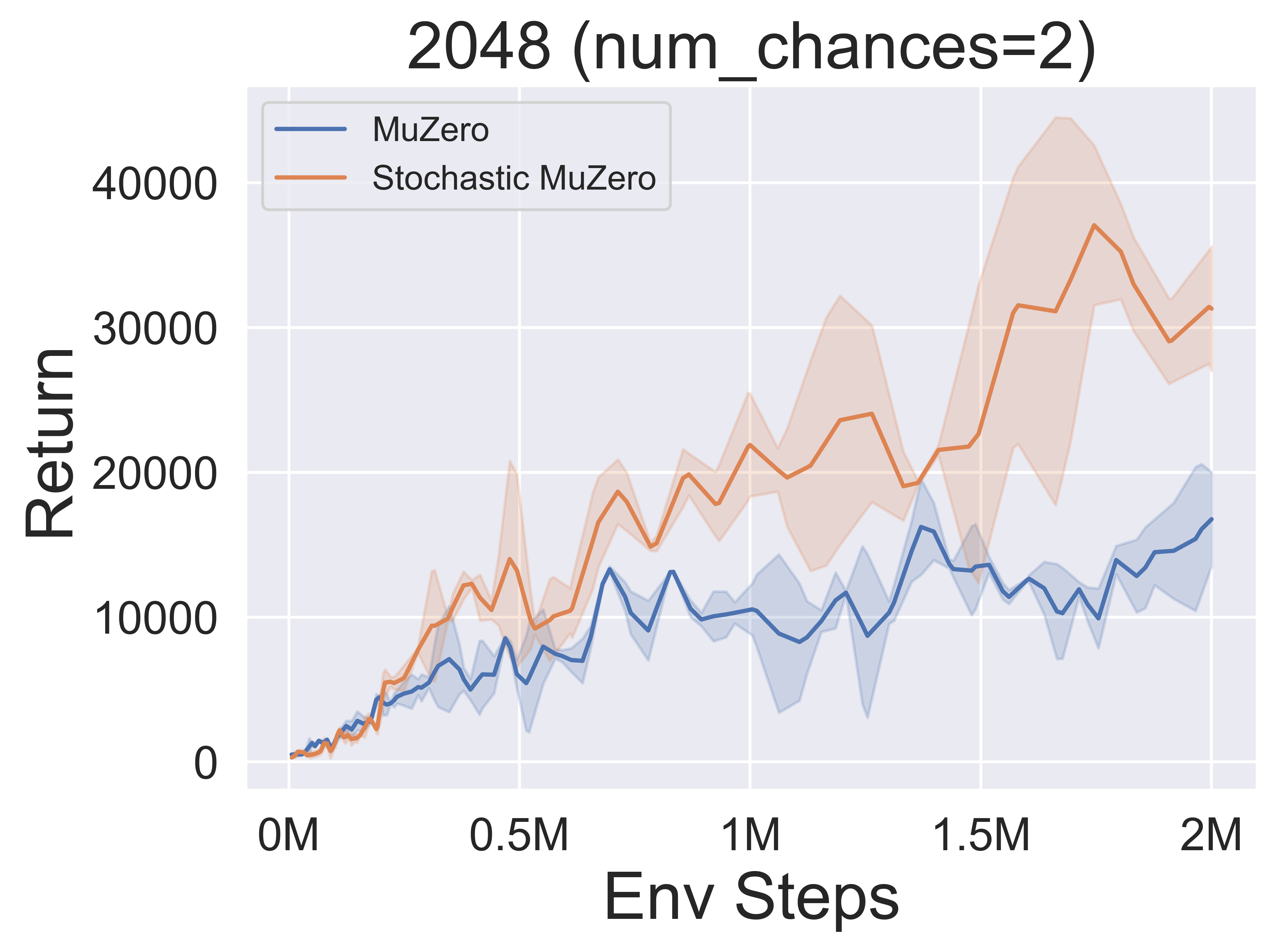

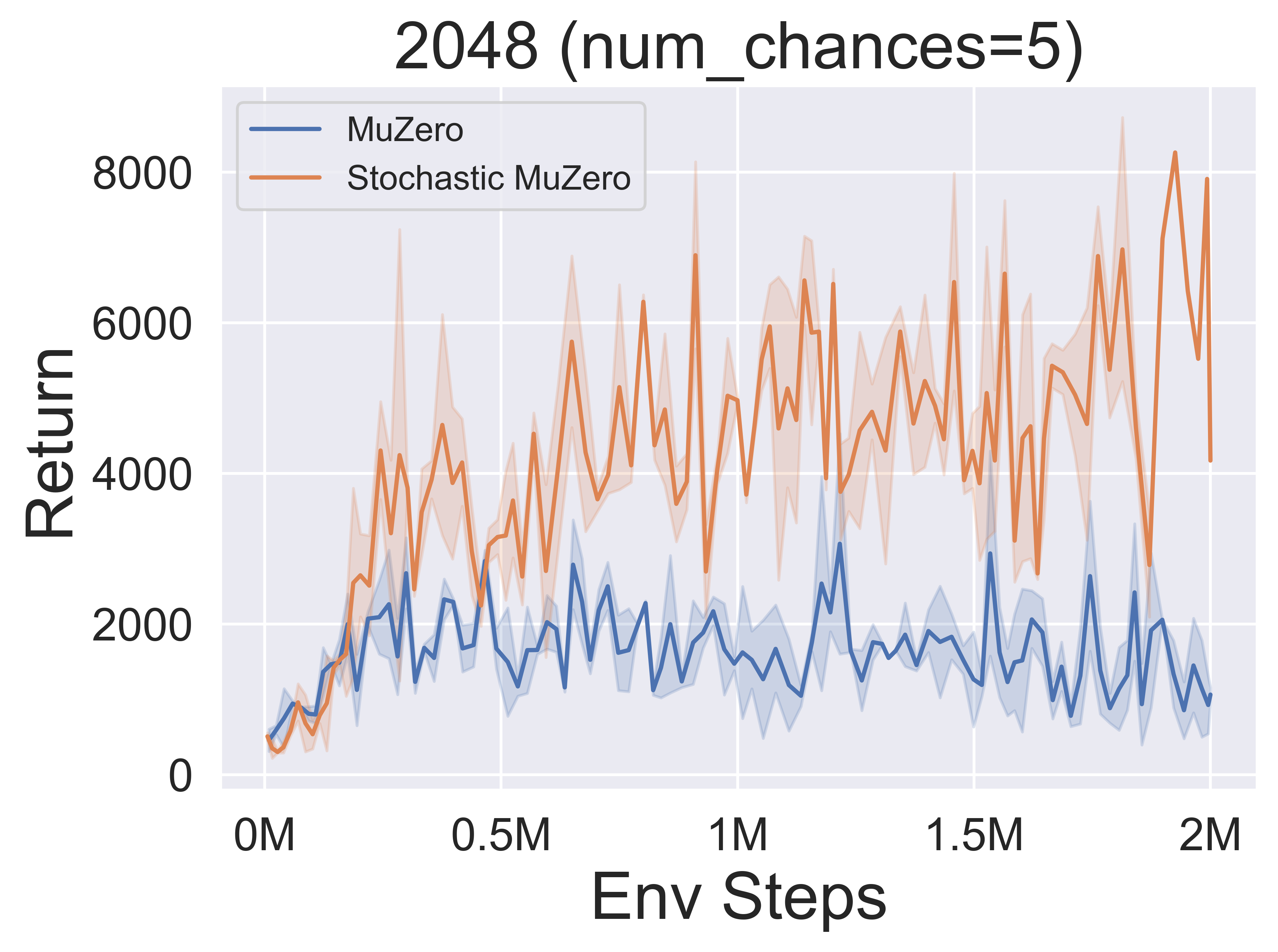

- 以下は、さまざまなレベルの偶然の2048環境での確率的ムゼロとMuzeroのベンチマーク結果です(num_chances = 2および5)。

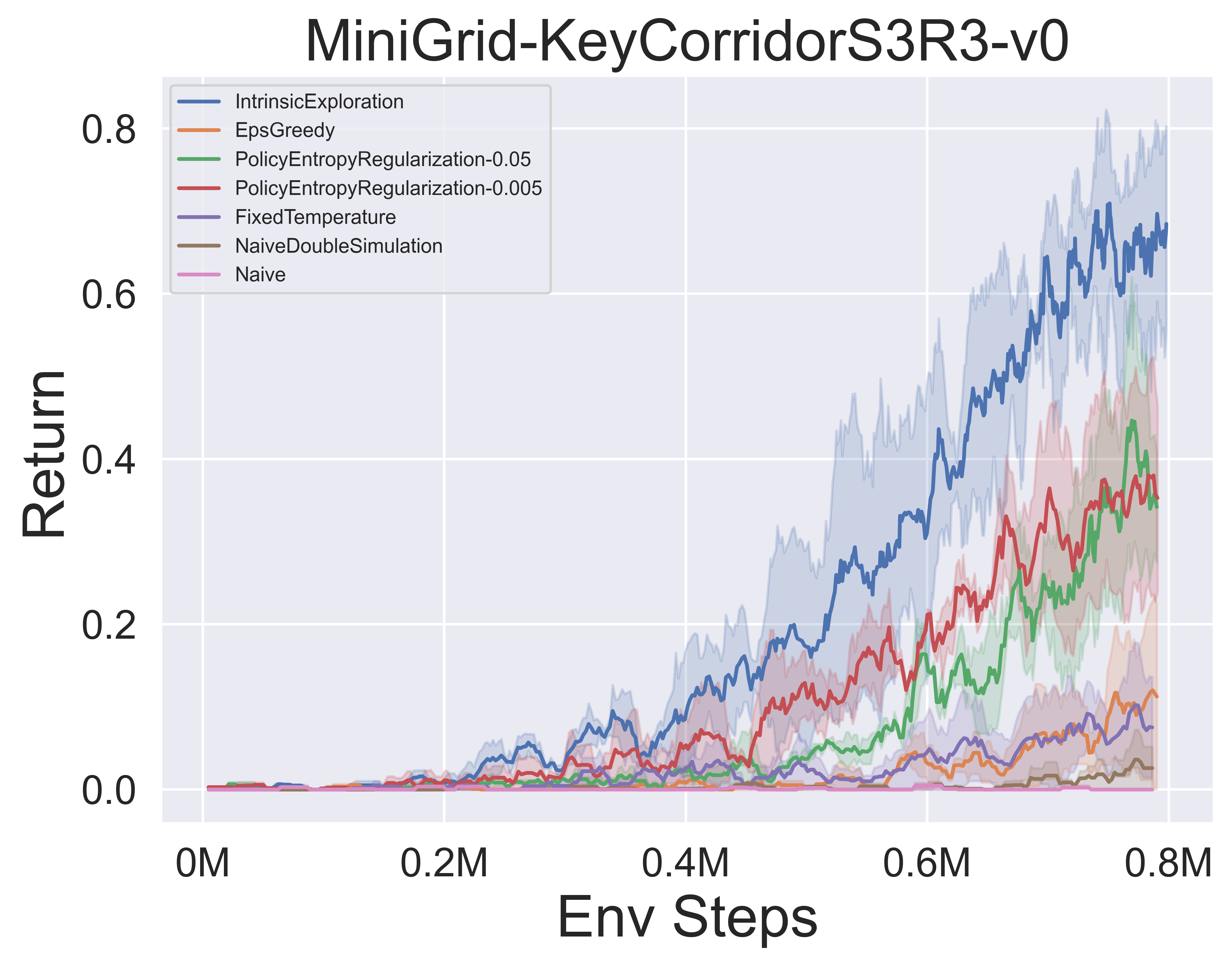

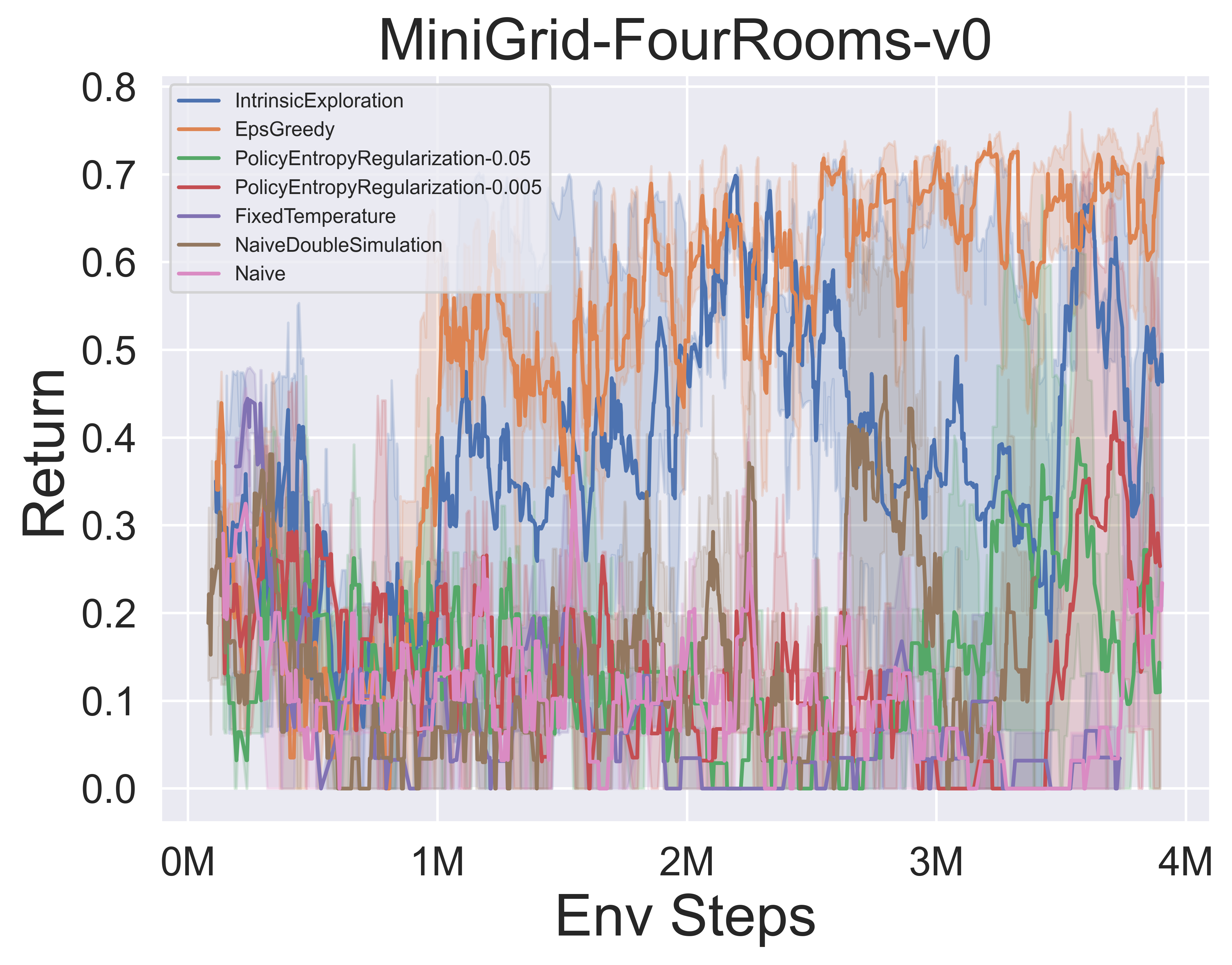

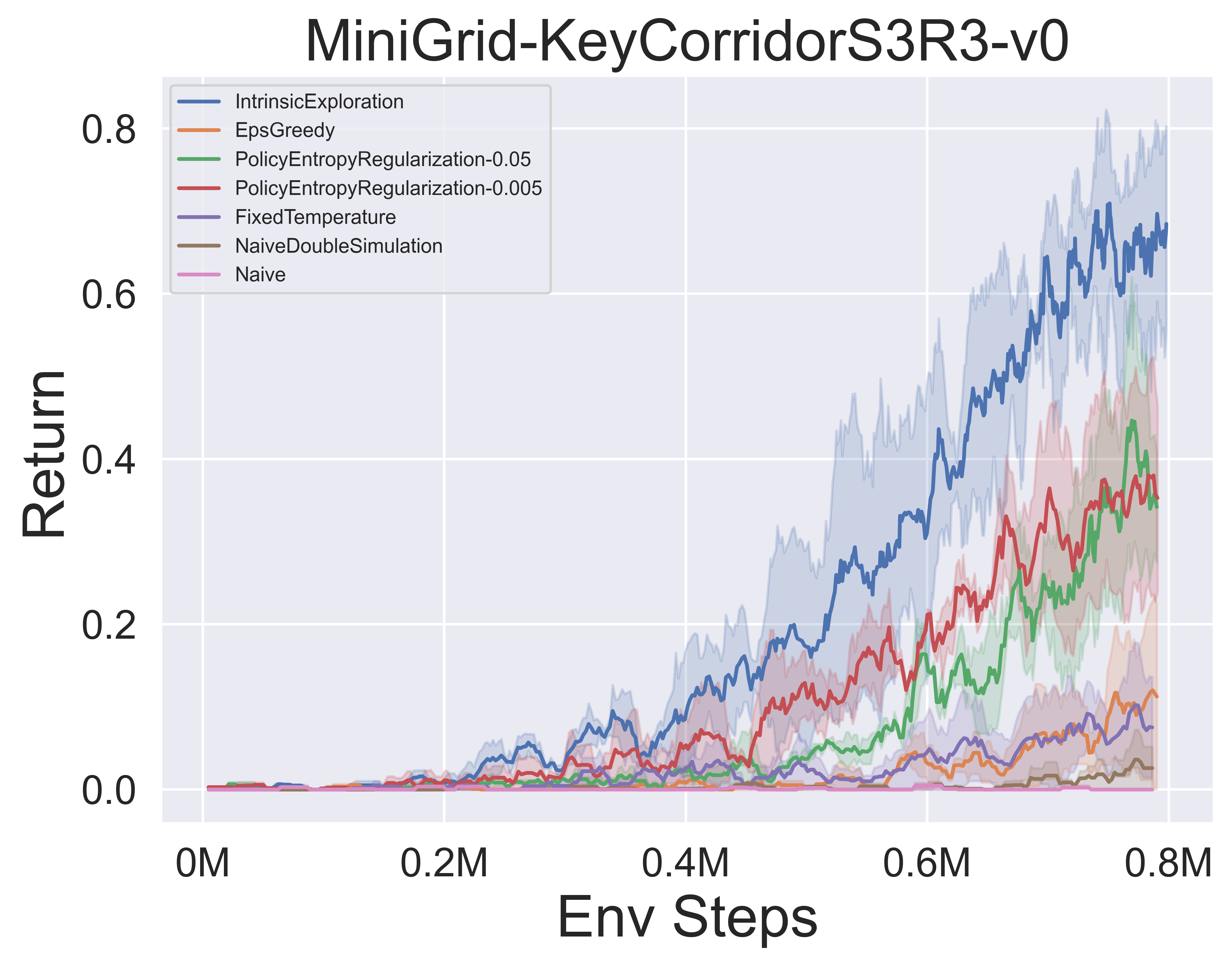

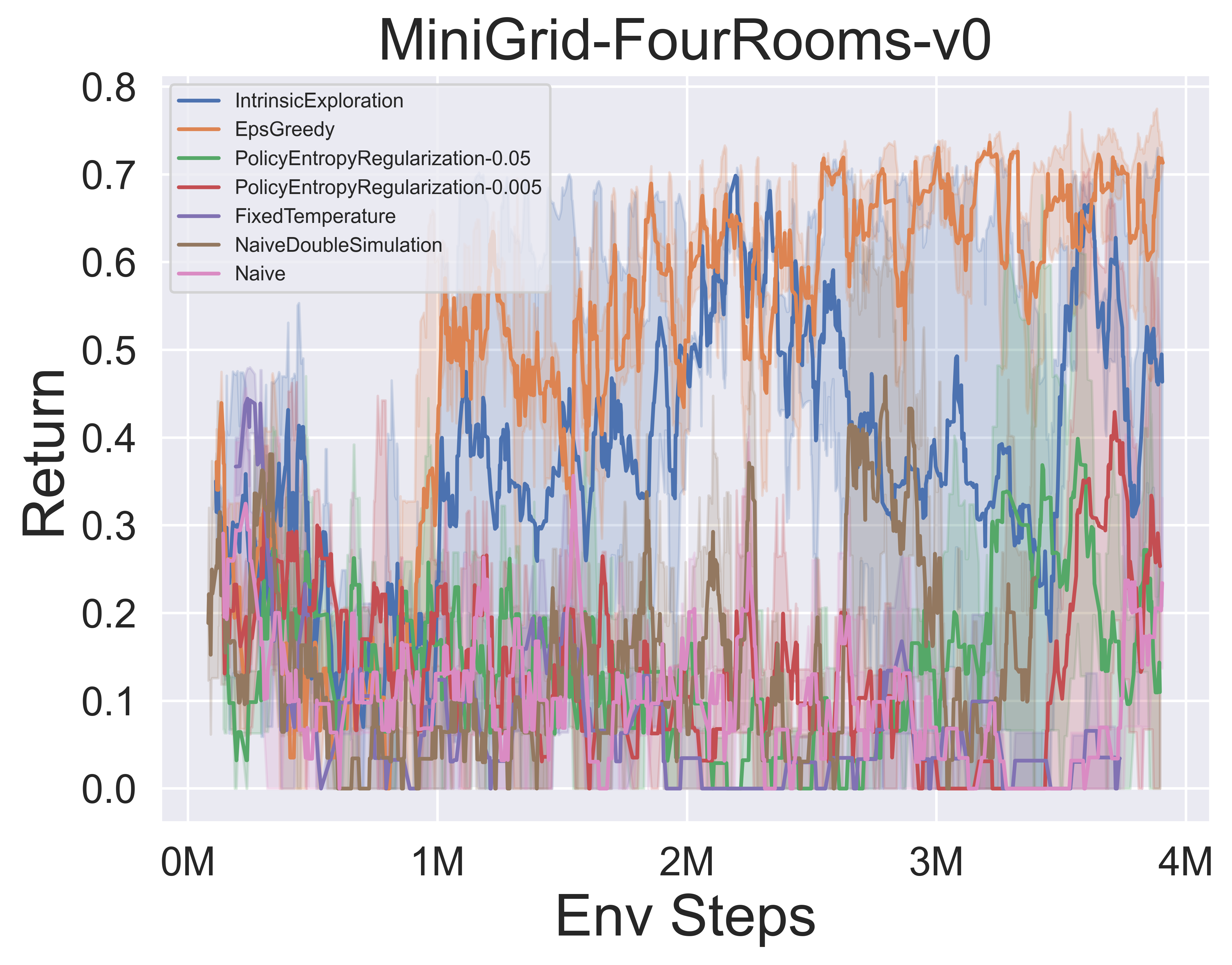

- 以下は、MIGRID環境におけるMUZERO W/ SSLのさまざまなMCTS探査メカニズムのベンチマーク結果です。

Awesome-MCTSノート

紙のメモ

以下は、上記のアルゴリズムの詳細な紙(中国語)です。

クリックして崩壊します

- アルファゼロ

- ムゼロ

- EfficientYzero

- sampledmuzero

- Gumbelmuzero

- StochasticMuzero

- NotationTable

また、関連するZhihu列(中国語):MCTS+RLフロンティア理論とアプリケーションの詳細な分析を参照することもできます。

アルゴ。概要

以下は、上記のアルゴリズムの概要MCTS原理図です。

クリックして展開します

- mcts

- アルファゼロ

- ムゼロ

- EfficientYzero

- sampledmuzero

- Gumbelmuzero

- StochasticMuzero

Awesome-MCTS論文

これは、モンテカルロツリー検索に関する研究論文のコレクションです。このセクションは、MCTSのフロンティアを追跡するために継続的に更新されます。

重要な論文

クリックして展開します

Lightzero実装シリーズ

- 2018 Science Alphazero:チェス、望、自己プレイを行う一般的な強化学習アルゴリズム

- 2019 Muzero:Atari、Go、Chess、Shogiの習得により、学んだモデルを計画して

- 2021 EfficientZero:データが限られているAtariゲームのマスター

- 2021サンプリングされたMuzero:複雑なアクションスペースでの学習と計画

- 2022 Stochastic Muzero:学習モデルを備えた確率的環境での計画

- 2022 Gumbel Muzero:Gumbelとの計画による政策改善

アルファゴシリーズ

- 2015 Nature Alphago深いニューラルネットワークとツリー検索でGoのゲームをマスターする

- 2017 Nature Alphago Zero人間の知識なしにGOのゲームをマスターする

- 2019 Elf Opengo:Alphazeroの分析と開放再実装

- 2023ゲームの学生:完璧な情報ゲームと不完全な情報ゲームの両方の統一学習アルゴリズム

Muzeroシリーズ

- 2022オンラインおよびオフラインの強化学習モデルを計画することによる学習

- 2021計画のためのベクトル量子化モデル

- 2021 Muesli:政策最適化の改善を組み合わせた。

MCTS分析

- 2020年のモンテカルロツリー検索として、正規化されたポリシーの最適化

- 2021自己整合的なモデルと価値

- 2022敵対的な政策は、プロのレベルのGO AIを打ち負かしました

- 2022 Alphazeroにおけるチェス知識のPNAS買収。

MCTSアプリケーション

- 2023シンボリック物理学学習者:モンテカルロツリー検索を介して統治方程式の発見

- 2022自然補強学習を伴うより速いマトリックス増殖アルゴリズムの発見

- 2022 VP9ビデオ圧縮のレートコントロールのための自己競争を備えたMuzero

- 2021 Douzero:自己プレイの深い補強学習でDoudizhuを習得

- 2019自律運転のための戦術的意思決定における計画と深い補強学習の組み合わせ

他の論文

クリックして展開します

ICML

- モンテカルロツリー検索によるスケーラブルな安全なポリシー改善2023

- アルベルト・カステリーニ、フェデリコ・ビアンキ、エドアルド・ゾルジ、チアゴ・D・シマオ、アレッサンドロ・ファリネリ、マティジスTJスパン

- キー:MCTSベースの戦略を使用した安全なポリシー改善オンライン、ベースラインブートストラップによる安全なポリシー改善

- Expenv:GridworldとSysadmin

- パスの一貫性2022を介したアルファゼロの効率的な学習

- Dengwei Zhao、Shikui Tu、Lei Xu

- キー:限られた量のセルフプレイ、パスの一貫性(PC)の最適性

- Expenv:Go、Othello、Gomoku

- Muzeroモデル2021の視覚化

- Joery A. De Vries、Ken S. Voskuil、Thomas M. Moerland、Aske Plaat

- キー:値等価ダイナミクスモデルの視覚化、アクションの軌跡が分かれ、2つの正規化手法

- Expenv:カートポールとマウンテンカー。

- モンテカルロツリー検索2021の凸状の正規化

- Tuan Dam、Carlo D'Eramo、Jan Peters、Joni Pajarinen

- キー:エントロピー - 正規化バックアップ演算子、後悔、Tsallis Etropy、

- Expenv:合成ツリー、アタリ

- 情報パーティクルフィルターツリー:連続ドメインで信念に基づく報酬を持つPOMDPのオンラインアルゴリズム2020

- ヨハネス・フィッシャー、ÖmerSahinTas

- キー:連続POMDP、粒子フィルターツリー、情報ベースの報酬形状、情報収集。

- Expenv:pomdps.jlフレームワーク

- コード

- レトロ*:ニューラルガイド付きA*検索2020を使用したレトロシンセティック計画の学習2020

- Binghong Chen、Chengtao Li、Hanjun Dai、Le Song

- キー:化学的翻訳計画、ニューラルベースのA*様アルゴリズム、Andor Tree

- Expenv:USPTOデータセット

- コード

ICLR

- 2024年の決定時間計画のための更新等価フレームワーク

- サミュエル・ソコタ、ガブリエーレ・ファリーナ、デビッド・J・ウー、ヘンギュアン・フー、ケビン・A・ワン、J ZICOコルター、ノーム・ブラウン

- キー:不完全な情報ゲーム、検索、意思決定時間計画、更新の等価性

- Expenv:Hanabi、3x3急激な暗い16進体、Phantom tic-tac-toe

- 2024年の計画による効率的なマルチエージェント補強学習

- Qihan Liu、Jianing Ye、Xiaoteng MA、Jun Yang、Bin Liang、Chongjie Zhang

- キー:マルチエージェント強化学習、計画、マルチエージェントMCT

- Expenv:Smac、Lunarlander、Mujoco、Google Research Football

- 純粋なビデオを見ることで、データが限られている熟練したプレーヤーになる2023

- Weirui Ye、Yunsheng Zhang、Pieter Abbeel、Yang Gao

- キー:アクションフリービデオからの事前トレーニング、前方逆サイクルの一貫性(FICC)目的ベクトル量子化、トレーニング前フェーズ、微調整フェーズ。

- Expenv:Atari

- 計画問題のためのポリシーベースの自己競争2023

- Jonathan Pirnay、QuirinGöttl、Jakob Burger、Dominik Gerhard Grimm

- キー:自己競争、過去の自己の可能な戦略に反対することにより、強い軌跡を見つけます。

- Expenv:旅行セールスマンの問題とジョブショップのスケジューリングの問題。

- Explorer-Navigator Framework 2023を介した一時的なグラフモデルの説明

- Wenwen Xia、Mincai Lai、Caihua Shan、Yao Zhang、Xinnan Dai、Xiang Li、Dongsheng Li

- キー:時間GNN説明者、MCTSを使用したイベントサブセットを見つけるための探索者であるExplorer、イベント間の相関関係を学習し、検索スペースを減らすのに役立つナビゲーター。

- Expenv:ウィキペディアとReddit、合成データセット

- Speedyzero:2023年に限られたデータと時間を使用してAtariをマスターします

- yixuan mei、jiaxuan gao、weirui ye、shaohuai liu、yang gao、yi wu

- キー:分散型RLシステム、優先度の更新、クリップラー

- Expenv:Atari

- 学習モデル2023を使用した効率的なオフラインポリシーの最適化

- Zichen Liu、Siyi Li、Wee Sun Lee、Shuicheng Yan、Zhongwen Xu

- キー:オフラインRLの正規化されたワンステップモデルベースのアルゴリズム

- Expenv:Atari、bsuite

- コード

- 適応型ツリー検索で任意の翻訳目標を有効にする2022

- Wang Ling、Wojciech Stokowiec、Domenic Donato、Chris Dyer、Lei Yu、Laurent Sartran、Austin Matthews

- キー:アダプティブツリー検索、翻訳モデル、自己回帰モデル、

- Expenv:WMT2020の中国語と英語と英語のタスク、WMT2014のドイツ語 - 英語のタスク

- 組み合わせの最適化のためのツリー検索の深い学習の何が問題になっていますか2022

- Maximili1anBöther、OttoKißig、Martin Taraz、Sarel Cohen、Karen Seidel、Tobias Friedrich

- キー:組み合わせの最適化、NPハード最大独立したセット問題のオープンソースベンチマークスイート、人気のあるガイド付きツリー検索アルゴリズムの詳細な分析、ツリー検索の実装を他のソルバーと比較する

- Expenv:NPハード最大独立セット。

- コード

- 言語アクション価値の推定値を使用したモンテカルロの計画と学習2021

- Youngsoo Jang、Seokin Seo、Jongmin Lee、Kee-Eung Kim

- キー:言語主導の探索によるモンテカルロツリー検索、ローカルに楽観的な言語価値の推定値。

- Expenv:インタラクティブフィクション(if)ゲーム

- 分子設計2021に適用される実用的な並列モンテカルロツリー検索

- Xiufeng Yang、Tanuj Kr aasawat、吉沢kazuki

- キー:非常に並行してモンテカルロツリー検索、分子設計、ハッシュ駆動並列検索、

- Expenv:合成アクセシビリティ(SA)および大規模なリングペナルティスコアによってペナルティを科されるオクタノール水パーティション係数(LOGP)。

- 観察されていないことを見る:モンテカルロツリー検索2020を並列化するための簡単なアプローチ

- Anji Liu、Jianshu Chen、Mingze Yu、Yu Zhai、Xuewen Zhou、Ji Liu

- キー:並列モンテカルロツリー検索、ツリーをサブツリーに効率的に分割し、各プロセッサの観測比を比較します。

- Expenv:Joy-Cityゲームのスピードアップとパフォーマンスの比較、Atariゲームの平均エピソードリターン

- コード

- ニューラル探査 - 爆発ツリーを介して高次元で計画することを学ぶ2020

- Binghong Chen、Bo Dai、Qinjie Lin、Guo Ye、Han Liu、Le Song

- キー:Meta Path Planning Algorithmは、問題構造から有望な検索指示を学ぶことができる新しいニューラルアーキテクチャを活用します。

- Expenv:2 DOF(自由度)ポイントロボット、3 DOFスティックロボット、5 DOFヘビロボットを備えた2Dワークスペース

ニューリップ

- Lightzero:一般的な決定シナリオ2023でのモンテカルロツリー検索の統一ベンチマーク

- Yazhe Niu、Yuan PU、Zhenjie Yang、Xueyan Li、Tong Zhou、Jiyuan Ren、Shuai Hu、Hongsheng Li、Yu Liu

- キー:一般的な順次決定シナリオでMCT/Muzeroを展開するための最初の統一ベンチマーク。

- Expenv:ClassicControl、Box2D、Atari、Mujoco、Gobigger、Minigrid、Tictactoe、ConnectFour、Gomoku、2048など。

- 大規模なタスク計画のための常識的な知識としての大規模な言語モデル2023

- Zirui Zhao、Wee Sun Lee、David Hsu

- キー:ワールドモデル(LLM)とLLM誘発ポリシーをMCTで組み合わせて、タスク計画を拡大することができます。

- Expenv:乗算、旅行計画、オブジェクトの再配置

- Boltzmann Exploration 2023によるモンテカルロツリー検索

- マイケル・ペインター、モハメド・バイウミー、ニック・ホーズ、ブルーノ・ラセルダ

- キー:MCTを使用したボルツマン探査、最大エントロピー目的の最適なアクションは、元の目的の最適なアクション、2つの改良されたアルゴリズムに必ずしも対応するものではありません。

- Expenv:凍った湖の環境、セーリングの問題、行く

- Atari Games 2023を習得するための一般化された加重パスの一貫性

- Dengwei Zhao、Shikui Tu、Lei Xu

- キー:一般化された加重パスの一貫性、重み付けメカニズム。

- Expenv:Atari

- 確率ツリー状態の抽象化でモンテカルロツリー検索を加速する2023

- Yangqing Fu、Ming Sun、Buqing Nie、Yue Gao

- キー:確率ツリー状態の抽象化、推移性、集約エラーバウンド

- Expenv:Atari、Cartpole、Lunarlander、Gomoku

- 思考時間を賢く過ごす:仮想拡張でMCTを加速2022

- Weirui Ye、Pieter Abbeel、Yang Gao

- キー:コンピューティングとパフォーマンスのトレードオフ、仮想拡張、適応的に思考に時間を費やします。

- Expenv:Atari、9x9 Go

- サンプルの効率的な模倣学習2022の計画

- Zhao-Heng Yin、Weirui Ye、Qifeng Chen、Yang Gao

- キー:行動クローニング、敵対的模倣学習(AIL)、MCTSベースのRL。

- Expenv:DeepMind Control Suite

- コード

- タスクのパフォーマンスを超えた評価:HEX 2022のアルファゼロの概念の分析

- チャールズ・ラバー、ジェシカ・ゾサ・フォーデ、ジョージ・コニダリス、エリー・パブリック、マイケル・L・リットマン

- キー:Alphazeroの内部表現、モデルの調査、行動テスト、これらの概念がネットワークでどのようにキャプチャされるか。

- Expenv:16進

- アルファゼロのようなエージェントは敵対的な摂動に対して堅牢ですか? 2022

- Li-Cheng Lan、Huan Zhang、Ti-Rong Wu、Meng-Yu Tsai、I-Chen Wu、4 Cho-Jui Hsieh

- キー:敵対国、Go AISに対する最初の敵対的攻撃。

- Expenv:Go

- ブラックボックスの最適化2022のモンテカルロツリー降下

- Yaoguang Zhai、Sicun Gao

- キー:ブラックボックスの最適化、より速い最適化のためにサンプルベースの降下をさらに統合する方法。

- Expenv:非線形最適化の合成機能、Mujoco移動環境における補強学習問題、および神経構造検索(NAS)の最適化問題。

- 高次元のベイジアン最適化のためのモンテカルロツリー検索ベースの可変選択2022

- Lei Song ∗、Ke Xue ∗、Xiaobin Huang、Chao Qian

- キー:MCTを介した低次元サブスペースは、ベイジアン最適化アルゴリズムを使用して部分空間で最適化します。

- Expenv:NASベンチの問題とムホコの移動

- 繰り返し精製された状態抽象化によるモンテカルロツリー検索2021

- サミュエル・ソコタ、カレブ・ホー、ザヒーン・アフマド、J・ジコ・コルター

- キー:確率的環境、進歩的な拡大、抽象化の精製

- Expenv:ブラックジャック、トラップ、5 x 5 go。

- 偵察における深い総観モンテカルロ計画2021

- グレゴリー・クラーク

- キー:不完全な情報、非加重粒子フィルター、情報状態の新しい確率的抽象化を備えた信念状態。

- Expenv:偵察ブラインドチェス

- ポリフット:非皮質分析を伴う連続宇宙MDPでのモンテカルロ計画2020

- ワイチャオ・マオ、カイチン・チャン、Qiaomin Xie、TamerBaīsar

- キー:継続的な状態アクションスペース、階層的な楽観的な最適化。

- Expenv:Cartpole、倒立振り子、スイングアップ、Lunarlander。

- モンテカルロツリー検索2020を使用したブラックボックスの最適化のための検索スペースパーティションの学習2020

- リンナン・ワン、ロドリゴ・フォンセカ、Yuandong Tian

- キー:いくつかのサンプル、非線形決定境界を使用して検索スペースのパーティションを学び、優れた候補者を選択するためのローカルモデルを学習します。

- Expenv:Mujoco移動タスク、小規模ベンチマーク、

- ミックスとマッチ:混合分布からモデルを学習するための楽観的なツリーサーチアプローチ2020

- マシュー・フォー、ラジャット・セン、カーシケヤン・シャンムガム、コンスタンティン・カラマニス、サンジェイ・シャッコットイ

- キー:共変量シフトの問題、ミックス&マッチは、確率的勾配降下(SGD)と楽観的なツリー検索とモデルの再利用(異なる混合分布からのサンプルを使用して部分的に訓練されたモデルを進化させる)を組み合わせています

- コード

その他の会議またはジャーナル

- 停止する学習:動的シミュレーションモンテカルロツリー検索AAAI 2021。

- Monte Carlo Tree Search and Rehnecortion Learning Journal of人工知能研究2017

- モンテカルロツリー検索のアクションを学習することによるサンプル効率の高いニューラルアーキテクチャ検索IEEEパターン分析とマシンインテリジェンス2022。

フィードバックと貢献

githubに問題を提出します

ディスカッションフォーラムにオープンまたは参加してください

Lightzero Discord Serverで話し合います

メール([email protected])にお問い合わせください

アルゴリズムとシステム設計の両方であるLightzeroを改善するためのすべてのフィードバックと貢献に感謝します。

?引用

@article{niu2024lightzero,

title={LightZero: A Unified Benchmark for Monte Carlo Tree Search in General Sequential Decision Scenarios},

author={Niu, Yazhe and Pu, Yuan and Yang, Zhenjie and Li, Xueyan and Zhou, Tong and Ren, Jiyuan and Hu, Shuai and Li, Hongsheng and Liu, Yu},

journal={Advances in Neural Information Processing Systems},

volume={36},

year={2024}

}

@article{pu2024unizero,

title={UniZero: Generalized and Efficient Planning with Scalable Latent World Models},

author={Pu, Yuan and Niu, Yazhe and Ren, Jiyuan and Yang, Zhenjie and Li, Hongsheng and Liu, Yu},

journal={arXiv preprint arXiv:2406.10667},

year={2024}

}

@article{xuan2024rezero,

title={ReZero: Boosting MCTS-based Algorithms by Backward-view and Entire-buffer Reanalyze},

author={Xuan, Chunyu and Niu, Yazhe and Pu, Yuan and Hu, Shuai and Liu, Yu and Yang, Jing},

journal={arXiv preprint arXiv:2404.16364},

year={2024}

}?謝辞

このプロジェクトは、GitHubリポジトリの次の先駆的な作品に基づいて部分的に開発されています。私たちはこれらの基本的なリソースに深い感謝を表明します。

- https://github.com/opendilab/di-engine

- https://github.com/deepmind/mctx

- https://github.com/yewr/efficientzero

- https://github.com/werner-duvaud/muzero-general

次の貢献者 @paparazz1、 @karroyan、 @nighood、 @jayyoung0802、 @timothijoe、 @tutuhuss、 @harryxuancy、 @puyuan1996、@hansbugに感謝します。

このプロジェクトに貢献したすべての人に感謝します:

?§ライセンス

このリポジトリ内のすべてのコードは、Apacheライセンス2.0に基づいています。

(トップに戻る)