LightZero

Atualizado em 2024.12.10 LightZero-V0.1.0

Inglês | 简体中文 (chinês simplificado) | Documentação | Papel LightZero | Papel UNIZERO | Papel ReZero

A LightZero é um kit de ferramentas de algoritmo de código aberto leve, eficiente e fácil de entender que combina a busca de árvores de Monte Carlo (MCTS) e o aprendizado de reforço profundo (RL). Para qualquer dúvida sobre a LightZero, você pode consultar o assistente de perguntas e respostas baseado em RAG: Zeropal.

? Fundo

A integração da busca de árvores de Monte Carlo e aprendizado de reforço profundo, exemplificado por Alphazero e Muzero, alcançou níveis de desempenho sem precedentes em vários jogos, incluindo Go e Atari. Essa metodologia avançada também fez avanços significativos em domínios científicos, como a previsão da estrutura de proteínas e a busca por algoritmos de multiplicação de matrizes. A seguir, é apresentada uma visão geral da evolução histórica da série Algoritmo de Pesquisa em Árvores Monte Carlo:

A figura acima é o pipeline da estrutura de LightZero. Apresentamos brevemente os três módulos principais abaixo:

Modelo : Model é usado para definir a estrutura de rede, incluindo a função __init__ para inicializar a estrutura da rede e a função forward para calcular a propagação avançada da rede.

Política : Policy define a maneira como a rede é atualizada e interage com o ambiente, incluindo três processos: o processo learning , o processo collecting e o processo evaluation .

MCTS : MCTS define a estrutura da árvore de busca de Monte Carlo e a maneira como ela interage com a política. A implementação do MCTS inclui dois idiomas: Python e C ++, implementados no ptree e ctree , respectivamente.

Para a estrutura do arquivo do LightZero, consulte LightZero_File_Structure.

? Algoritmos integrados

A LightZero é uma biblioteca com uma implementação de Pytorch de algoritmos MCTS (às vezes combinados com Cython e CPP), incluindo:

- Alphazero

- MuZero

- Amostrado muzero

- MuZero estocástico

- Eficientezinho

- Gumbel MuZero

- ReZero

- UNIZERO

Os ambientes e algoritmos atualmente suportados pelo LightZero são mostrados na tabela abaixo:

| Env./algo. | Alphazero | MuZero | Amostrado muzero | Eficientezinho | Amostrado eficientezero | Gumbel MuZero | MuZero estocástico | UNIZERO | UNIZERO Amostrado | ReZero |

|---|

| Tictactoe | ✔ | ✔ | | | | ✔ | | ✔ | | |

| Gomoku | ✔ | ✔ | | | | ✔ | | ✔ | | ✔ |

| Connect4 | ✔ | ✔ | | | | | | ✔ | | ✔ |

| 2048 | ---- | ✔ | | | | | ✔ | ✔ | | |

| Xadrez | | | | | | | | | | |

| Ir | | | | | | | | | | |

| Cartpole | ---- | ✔ | | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ |

| Pêndulo | ---- | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ | |

| Lunarlander | ---- | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | |

| Bipedalwalker | ---- | ✔ | ✔ | ✔ | ✔ | ✔ | | | ✔ | |

| Atari | ---- | ✔ | | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ |

| Controle DeepMind | ---- | ---- | ✔ | ---- | ✔ | | | | ✔ | |

| Mujoco | ---- | ✔ | | ✔ | ✔ | | | | | |

| Minigrid | ---- | ✔ | | ✔ | ✔ | | | ✔ | | |

| Bsuite | ---- | ✔ | | ✔ | ✔ | | | ✔ | | |

| Memória | ---- | ✔ | | ✔ | ✔ | | | ✔ | | |

| SumTothree (bilhar) | ---- | | | | ✔ | | | | | |

| Metadrive | ---- | | | | ✔ | | | | | |

(1): "✔" significa que o item correspondente está finalizado e bem testado.

(2): "" significa que o item correspondente está na lista de espera (trabalho em andamento).

(3): "---" significa que esse algoritmo não suporta esse ambiente.

Instalação

Você pode instalar o mais recente LightZero em desenvolvimento a partir dos códigos de origem do GitHub com o seguinte comando:

git clone https://github.com/opendilab/LightZero.git

cd LightZero

pip3 install -e .

Observe que atualmente o LightZero suporta compilação apenas nas plataformas Linux e macOS . Estamos trabalhando ativamente para estender esse suporte à plataforma Windows . Sua paciência durante esta transição é muito apreciada.

Instalação com Docker

Também fornecemos um DockerFile que configura um ambiente com todas as dependências necessárias para executar a Biblioteca LightZero. Esta imagem do Docker é baseada no Ubuntu 20.04 e instala o Python 3.8, juntamente com outras ferramentas e bibliotecas necessárias. Veja como usar o nosso Dockerfile para criar uma imagem do Docker, executar um contêiner a partir desta imagem e executar o código LightZero dentro do contêiner.

- Faça o download do Dockerfile : O Dockerfile está localizado no diretório raiz do repositório LightZero. Faça o download deste arquivo para sua máquina local.

- Prepare o contexto de compilação : crie um novo diretório vazio em sua máquina local, mova o Dockerfile neste diretório e navegue neste diretório. Esta etapa ajuda a evitar o envio de arquivos desnecessários ao Docker Daemon durante o processo de construção.

mkdir lightzero-docker

mv Dockerfile lightzero-docker/

cd lightzero-docker/

- Crie a imagem do Docker : use o seguinte comando para construir a imagem do Docker. Este comando deve ser executado de dentro do diretório que contém o DockerFile.

docker build -t ubuntu-py38-lz:latest -f ./Dockerfile .

- Execute um contêiner da imagem : use o seguinte comando para iniciar um contêiner da imagem no modo interativo com um shell bash.

docker run -dit --rm ubuntu-py38-lz:latest /bin/bash

- Execute o código LightZero dentro do contêiner : Depois de dentro do contêiner, poderá executar o exemplo do script python com o seguinte comando:

python ./LightZero/zoo/classic_control/cartpole/config/cartpole_muzero_config.py

Início rápido

Treine um agente muzero para jogar Cartpole:

cd LightZero

python3 -u zoo/classic_control/cartpole/config/cartpole_muzero_config.py

Treine um agente muzero para jogar Pong:

cd LightZero

python3 -u zoo/atari/config/atari_muzero_segment_config.py

Treine um agente muzero para jogar Tictactoe:

cd LightZero

python3 -u zoo/board_games/tictactoe/config/tictactoe_muzero_bot_mode_config.py

Treine um agente da Unigone para jogar Pong:

cd LightZero

python3 -u zoo/atari/config/atari_unizero_segment_config.py

Documentação

A documentação da LightZero pode ser encontrada aqui. Ele contém tutoriais e a referência da API.

Para os interessados em personalizar ambientes e algoritmos, fornecemos guias relevantes:

- Personalizar ambientes

- Personalize algoritmos

- Como definir arquivos de configuração?

- Sistema de registro e monitoramento

Se você tiver alguma dúvida, não hesite em entrar em contato conosco para obter suporte.

Benchmark

Clique para expandir

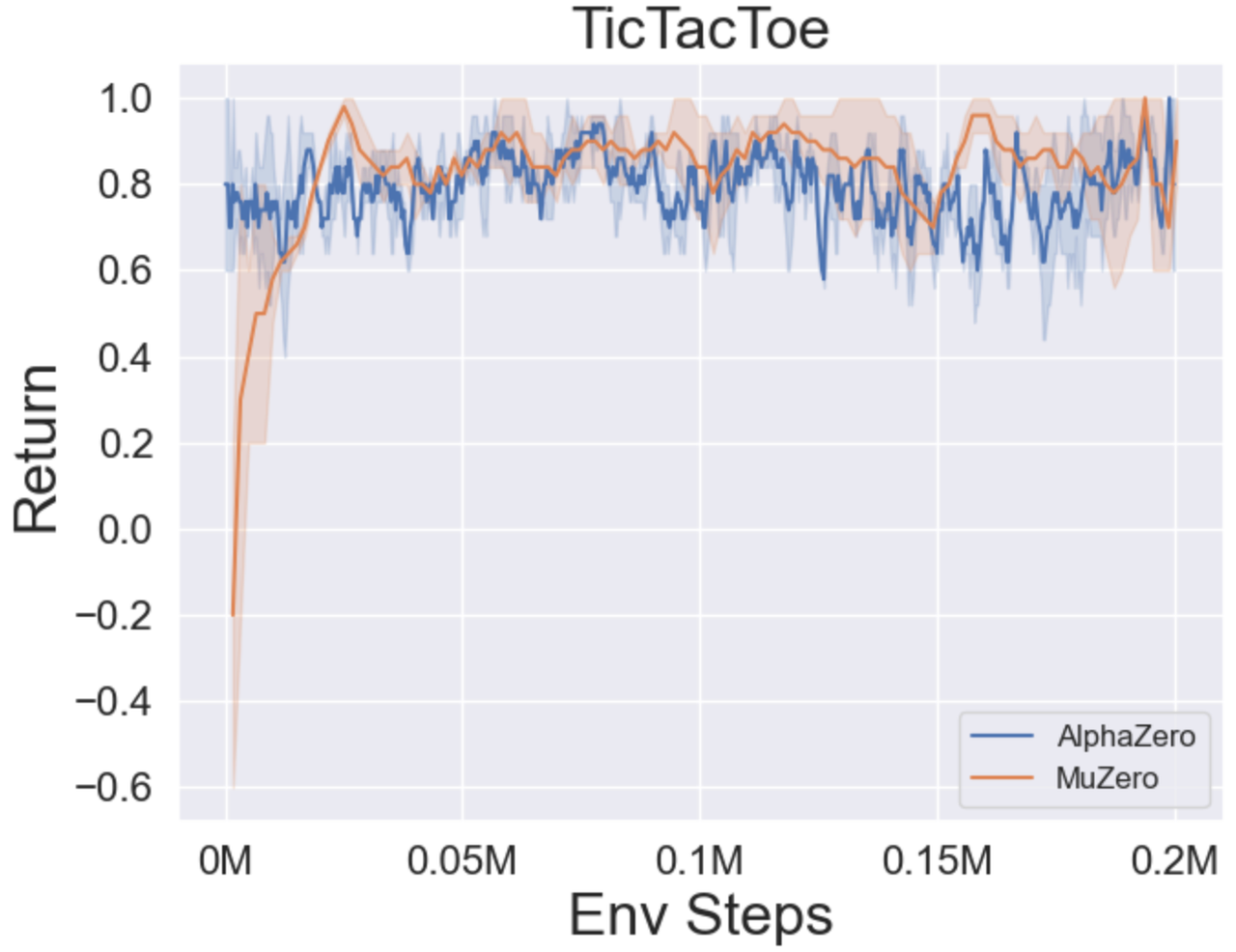

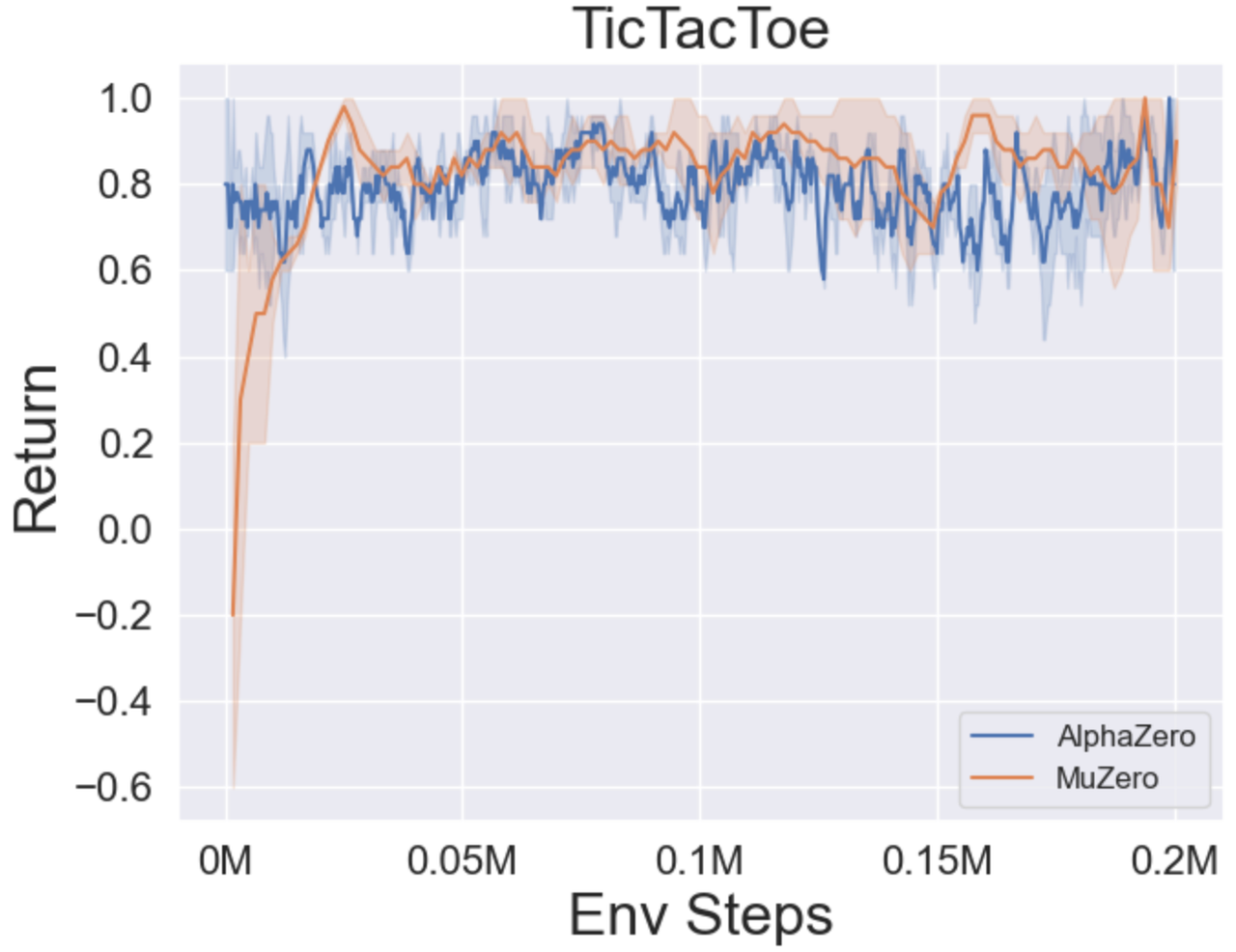

- Abaixo estão os resultados de referência de Alphazero e Muzero em três jogos de tabuleiro: Tictactoe, Connect4, Gomoku.

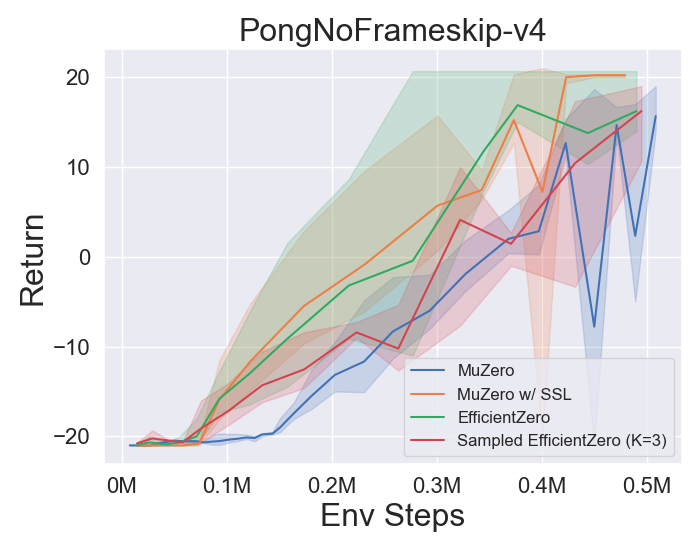

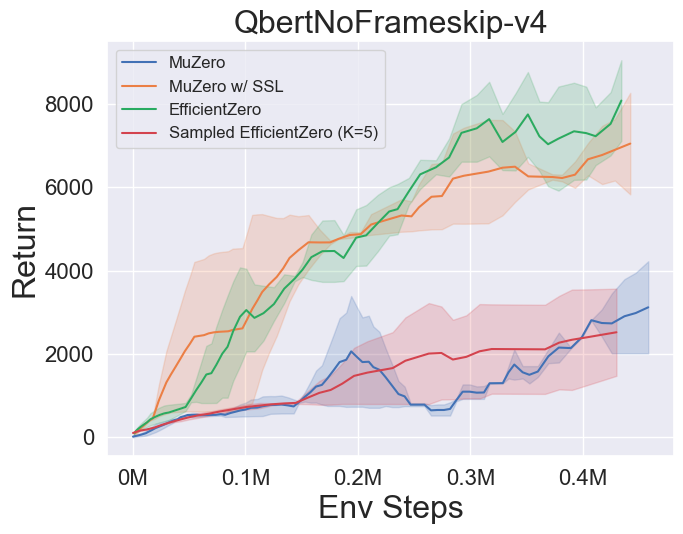

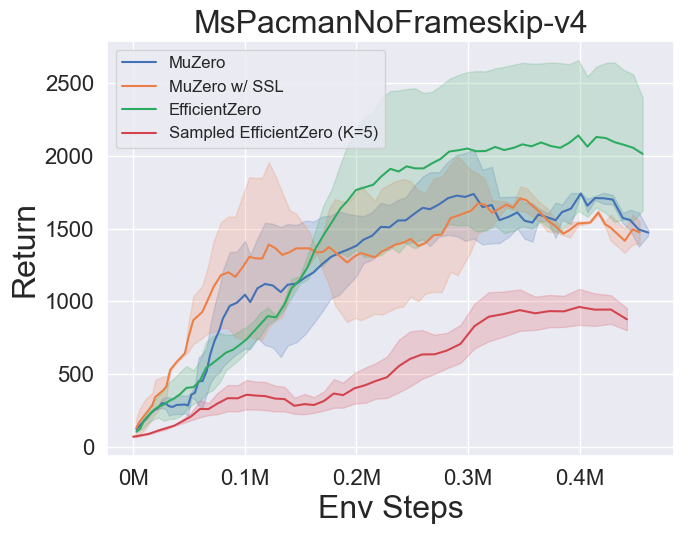

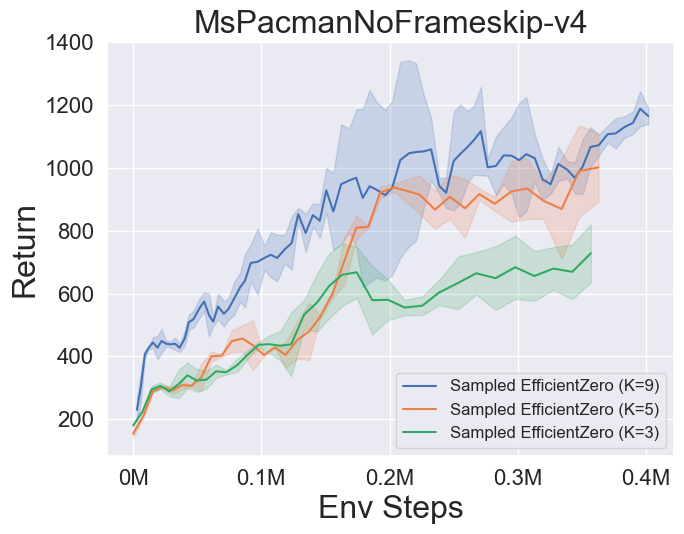

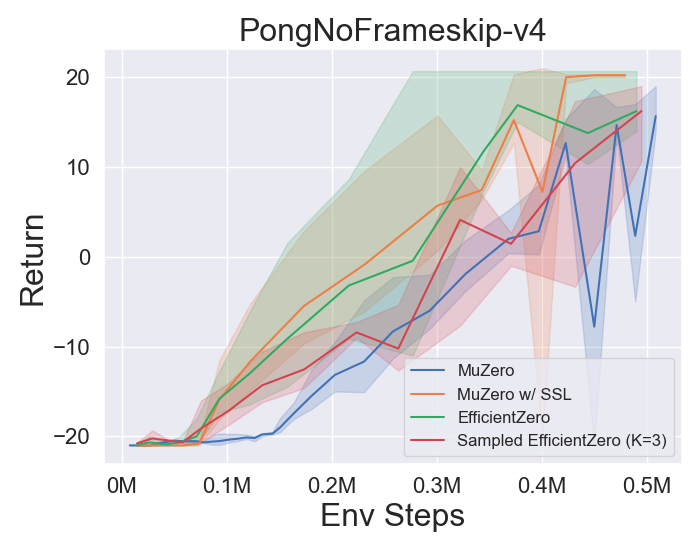

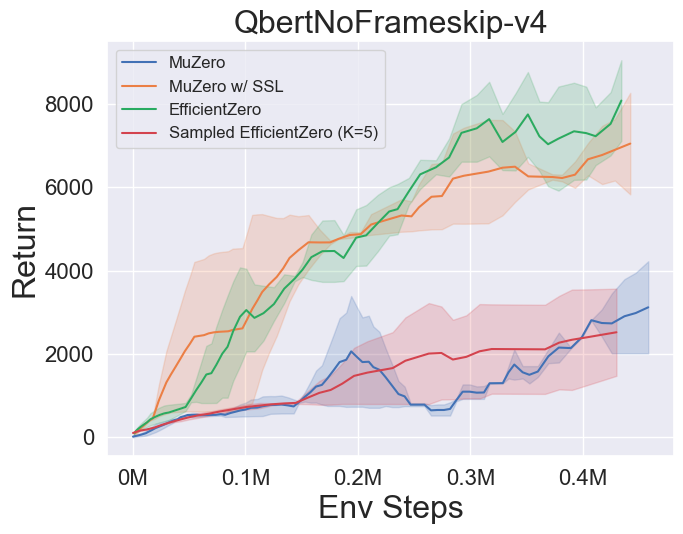

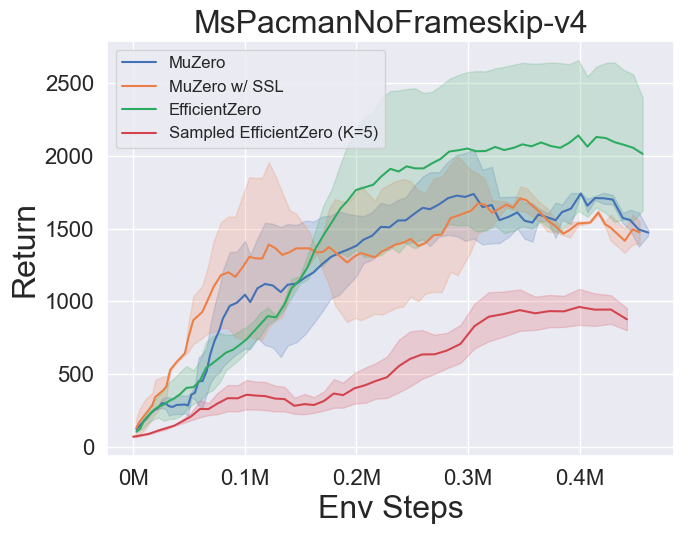

- Abaixo estão os resultados de benchmark de Muzero, MuZero W/ SSL, EfientZero e Amostred EfientZero em três jogos de espaço de ação discretos em Atari.

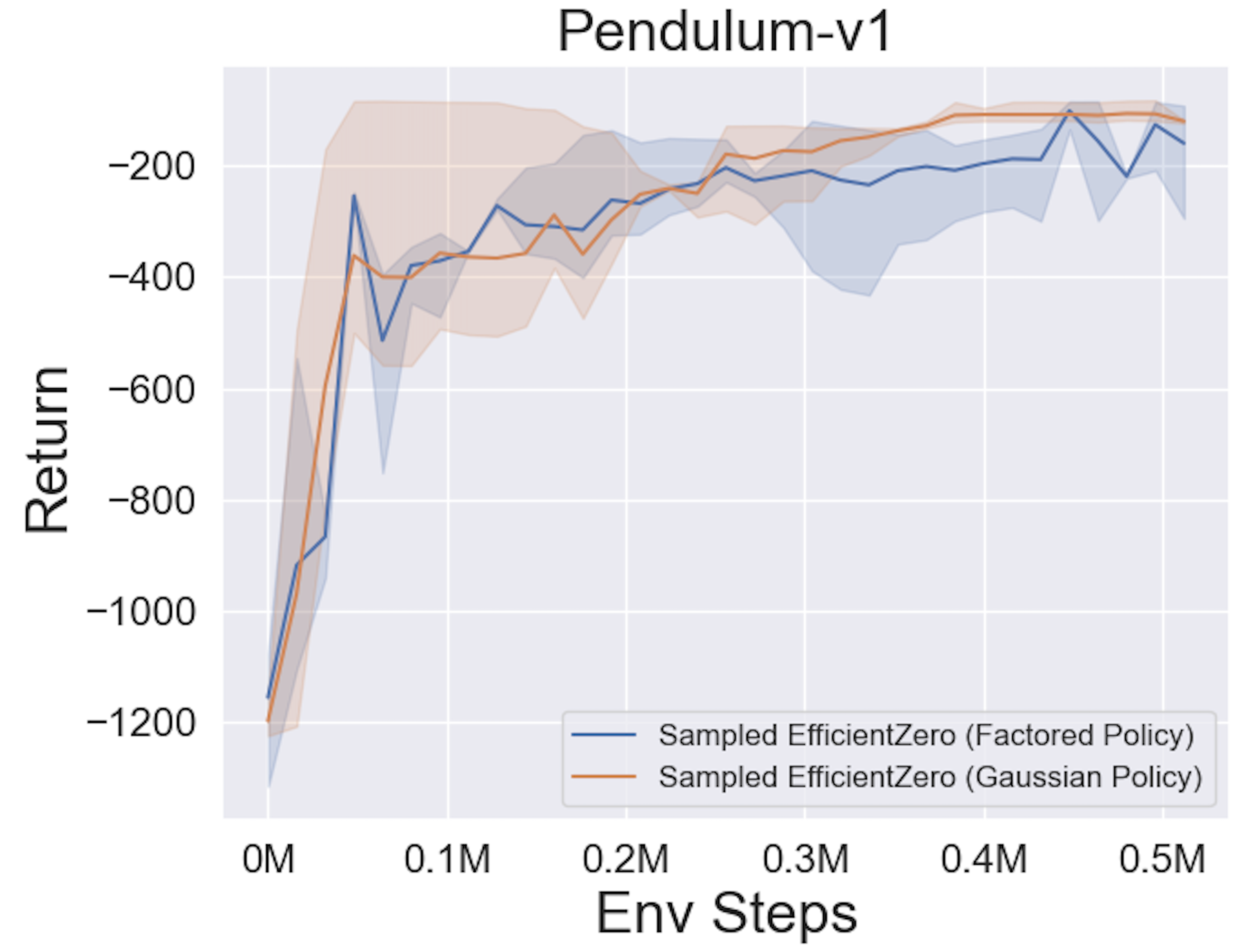

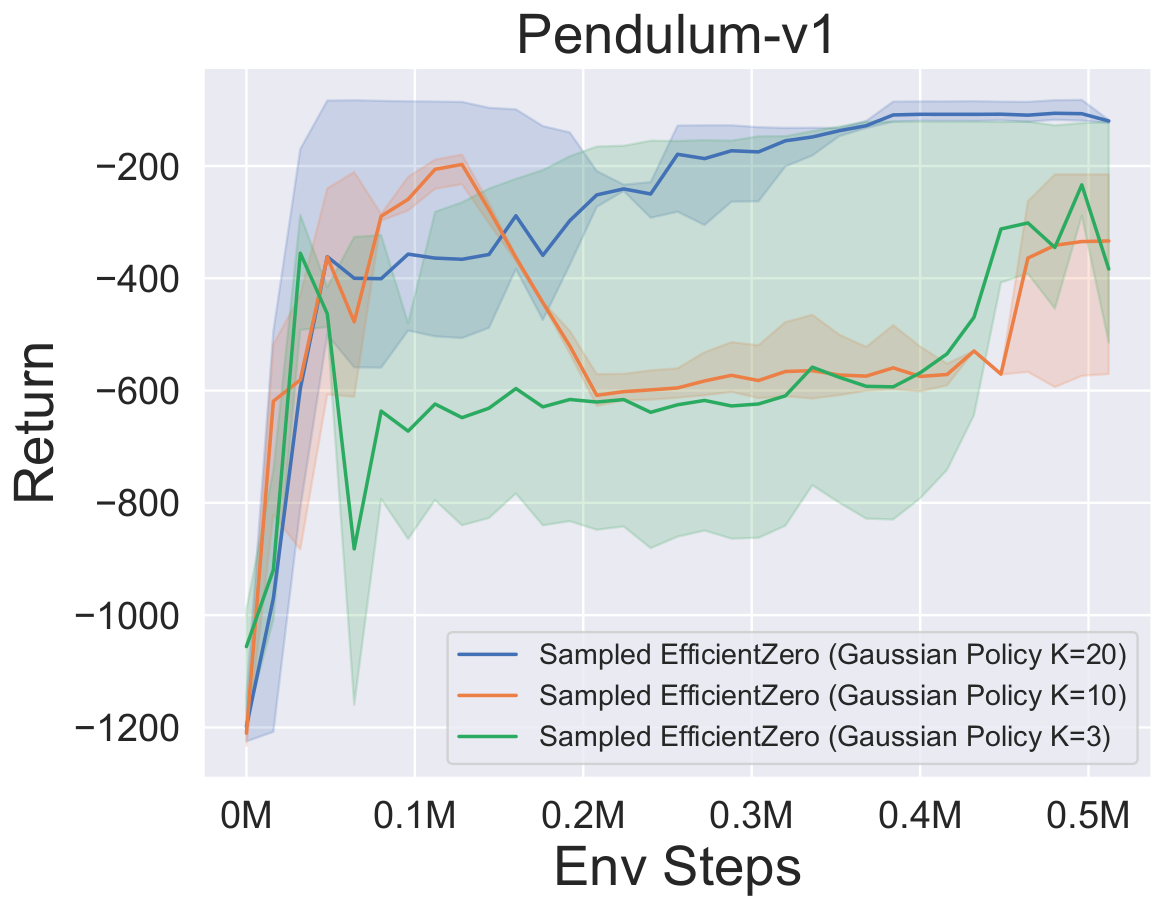

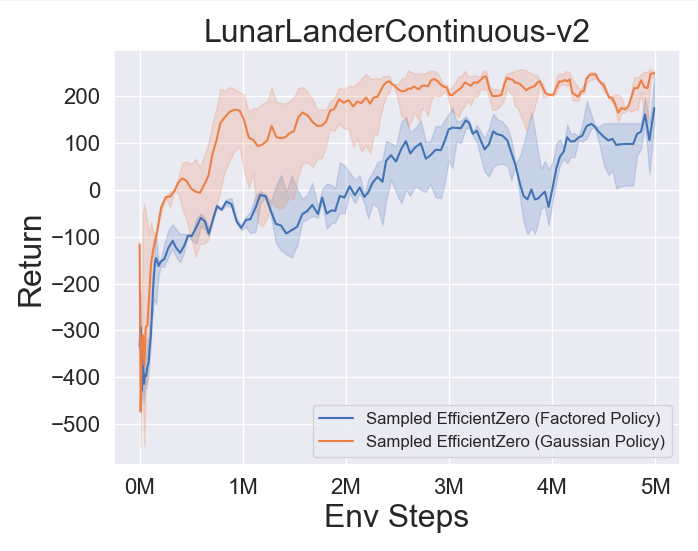

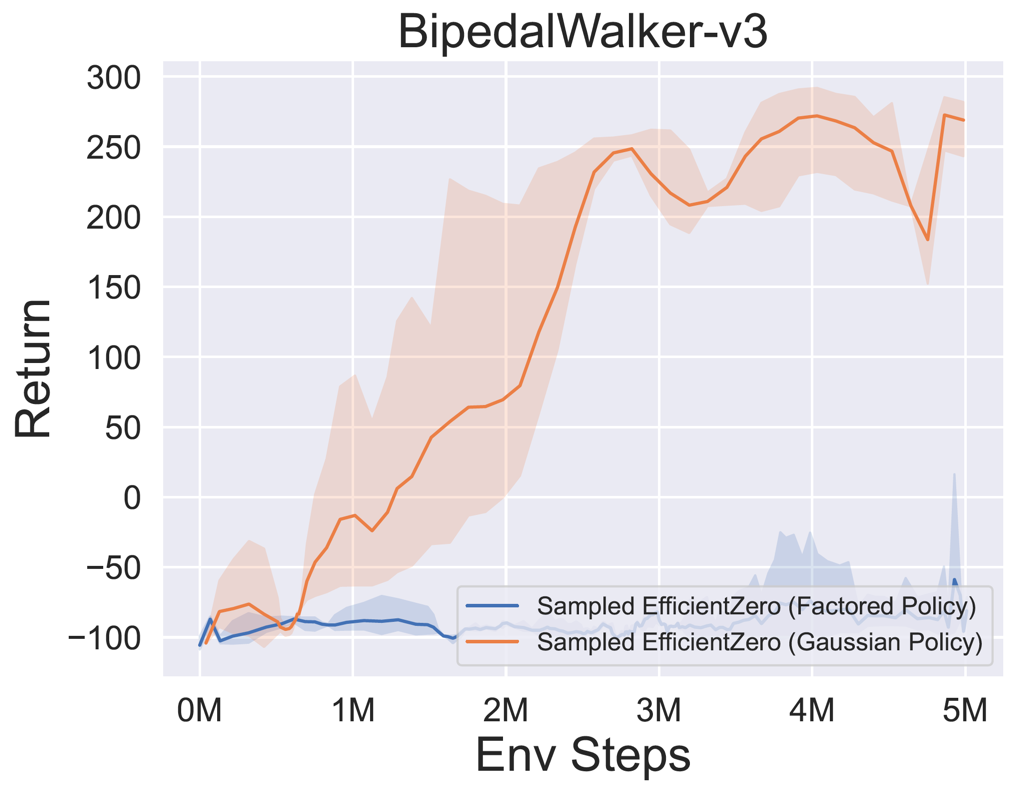

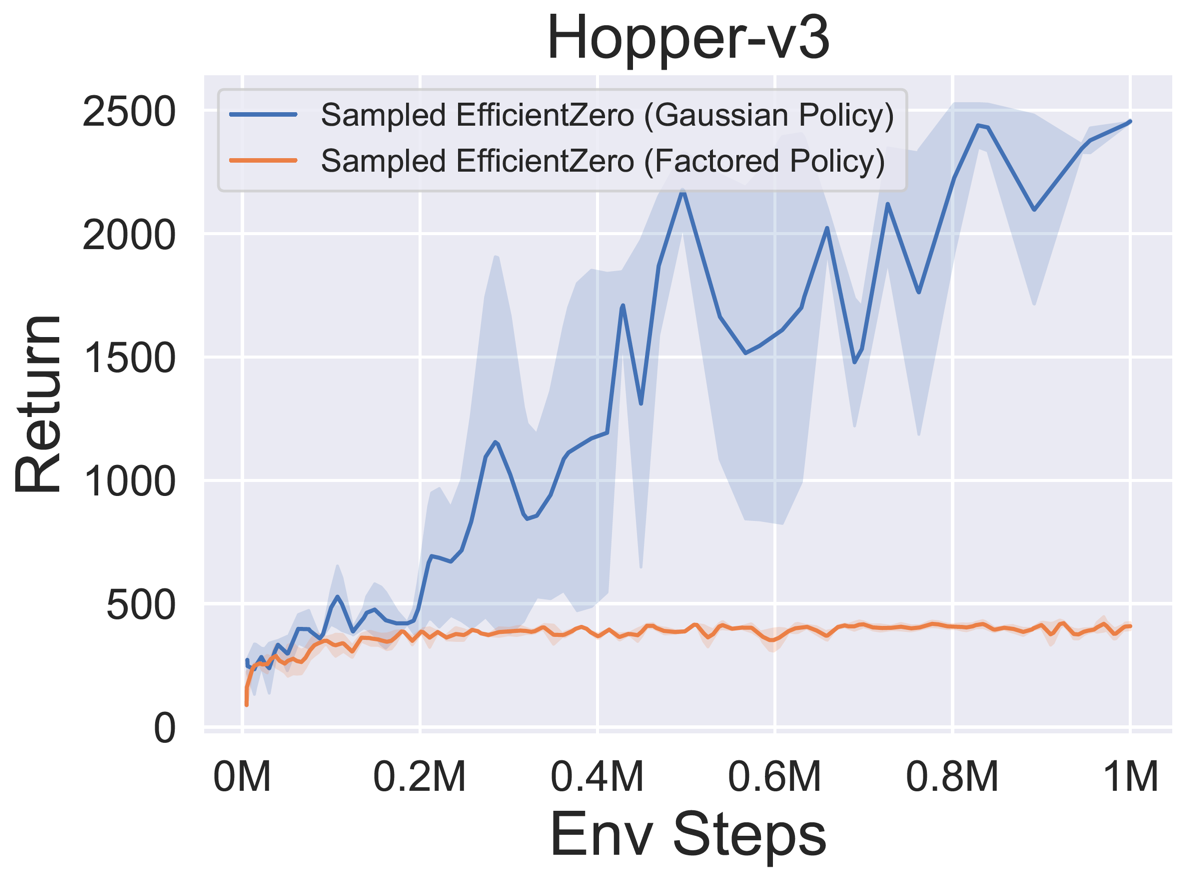

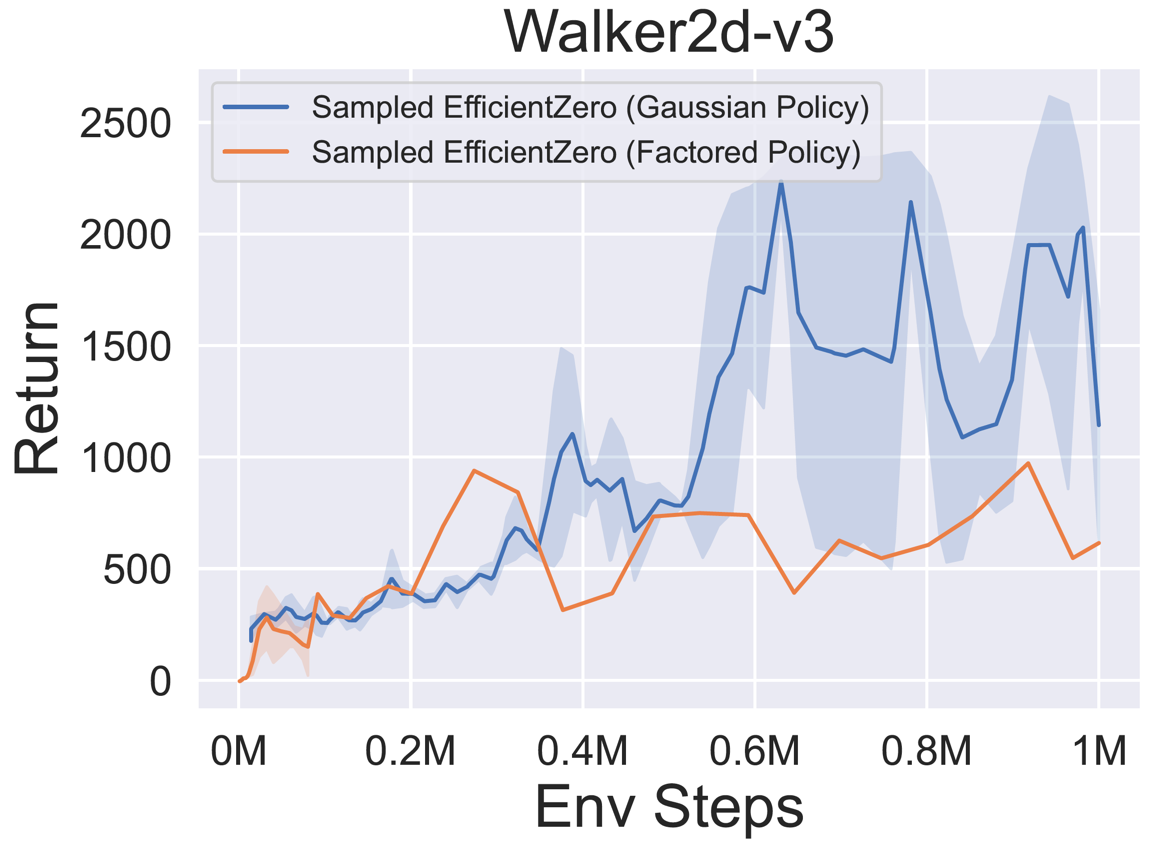

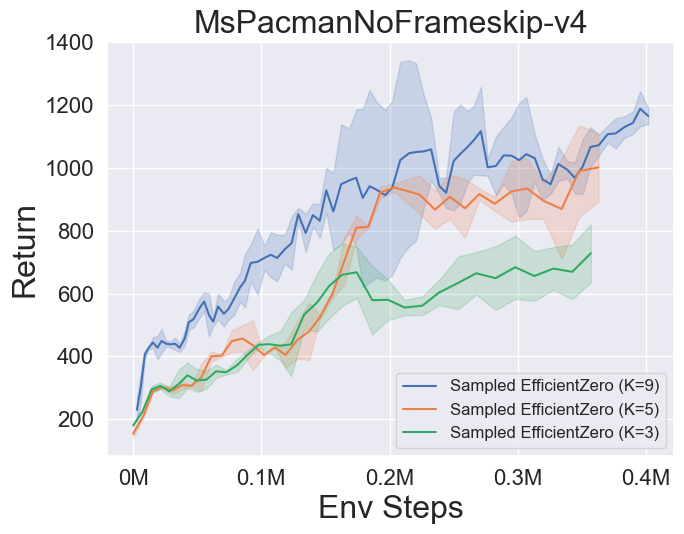

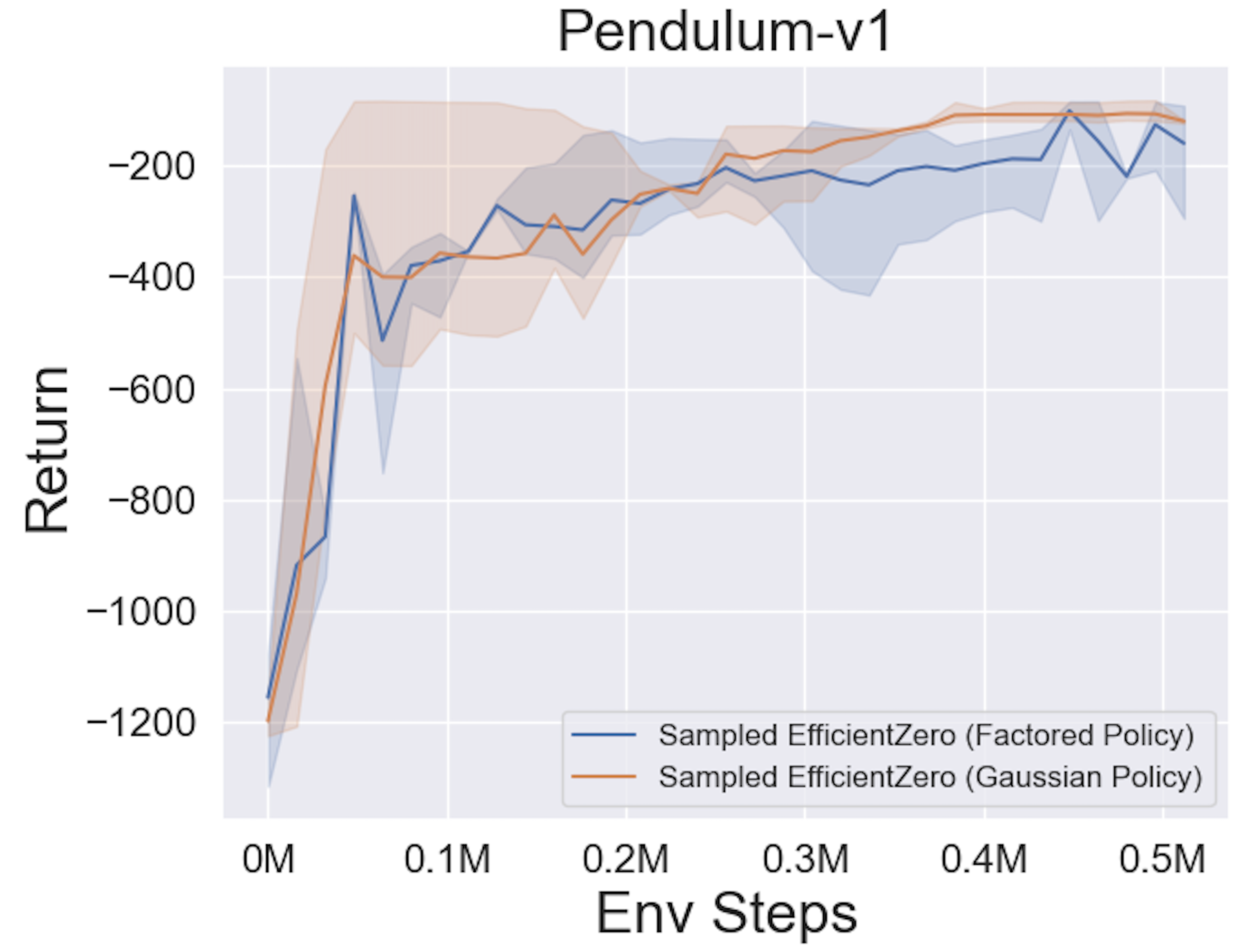

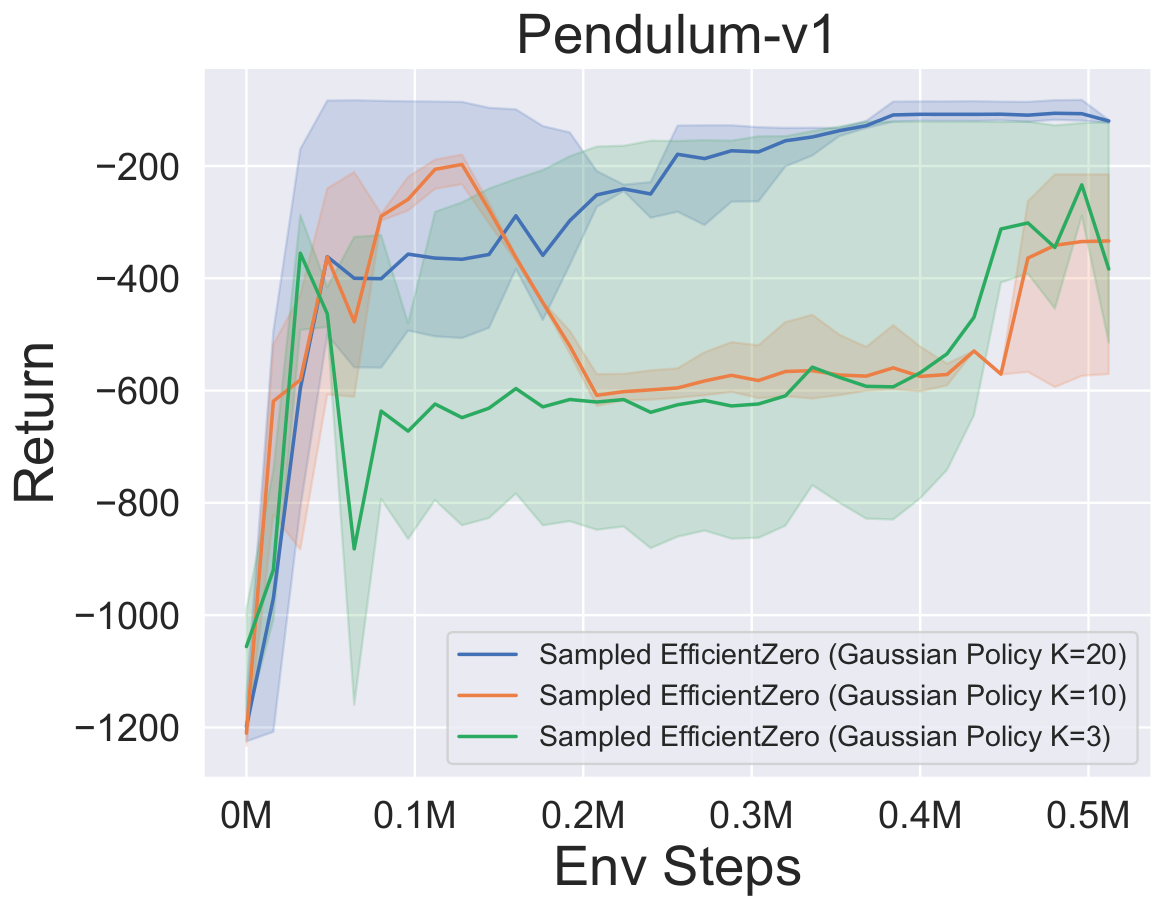

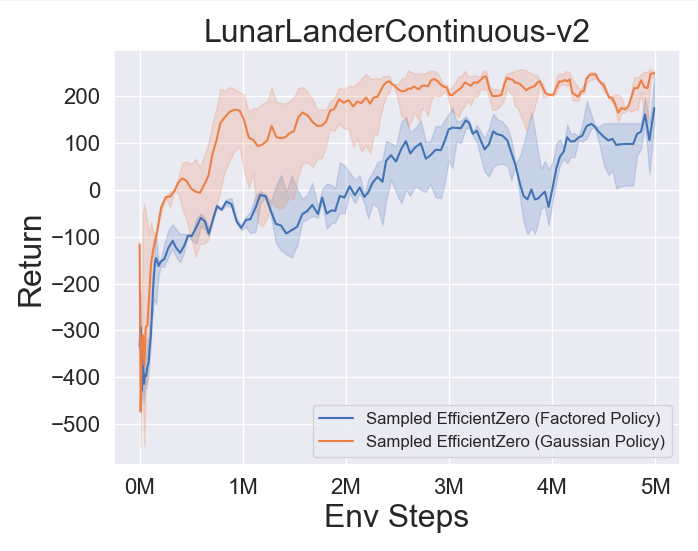

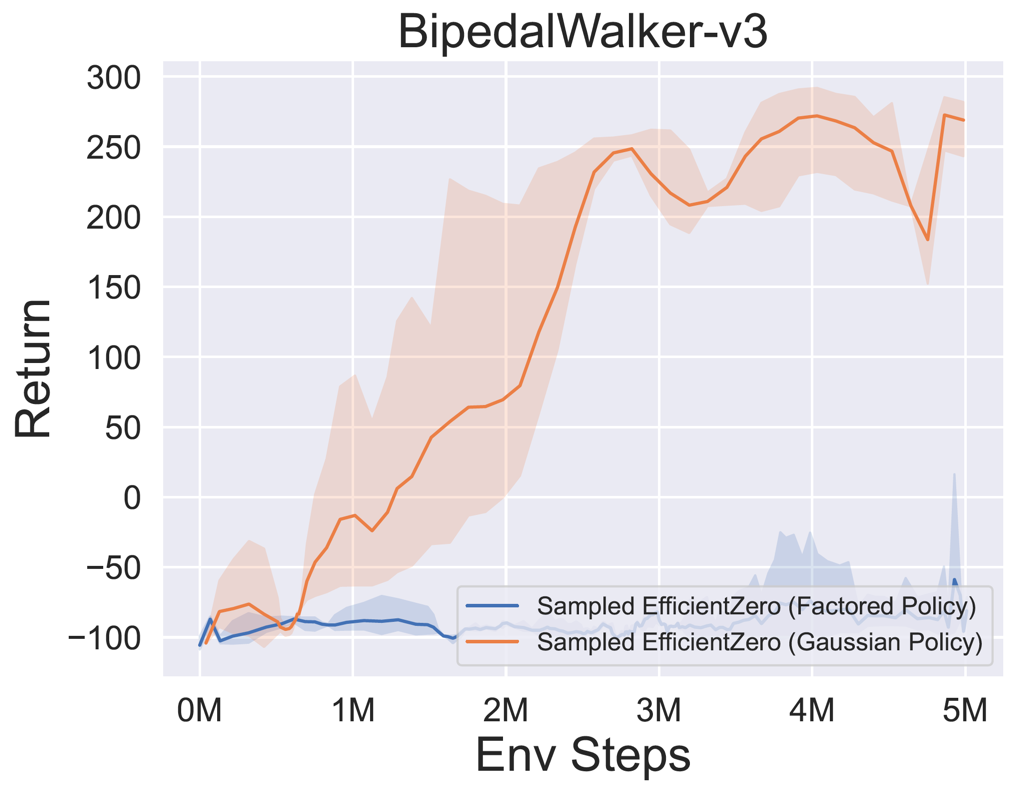

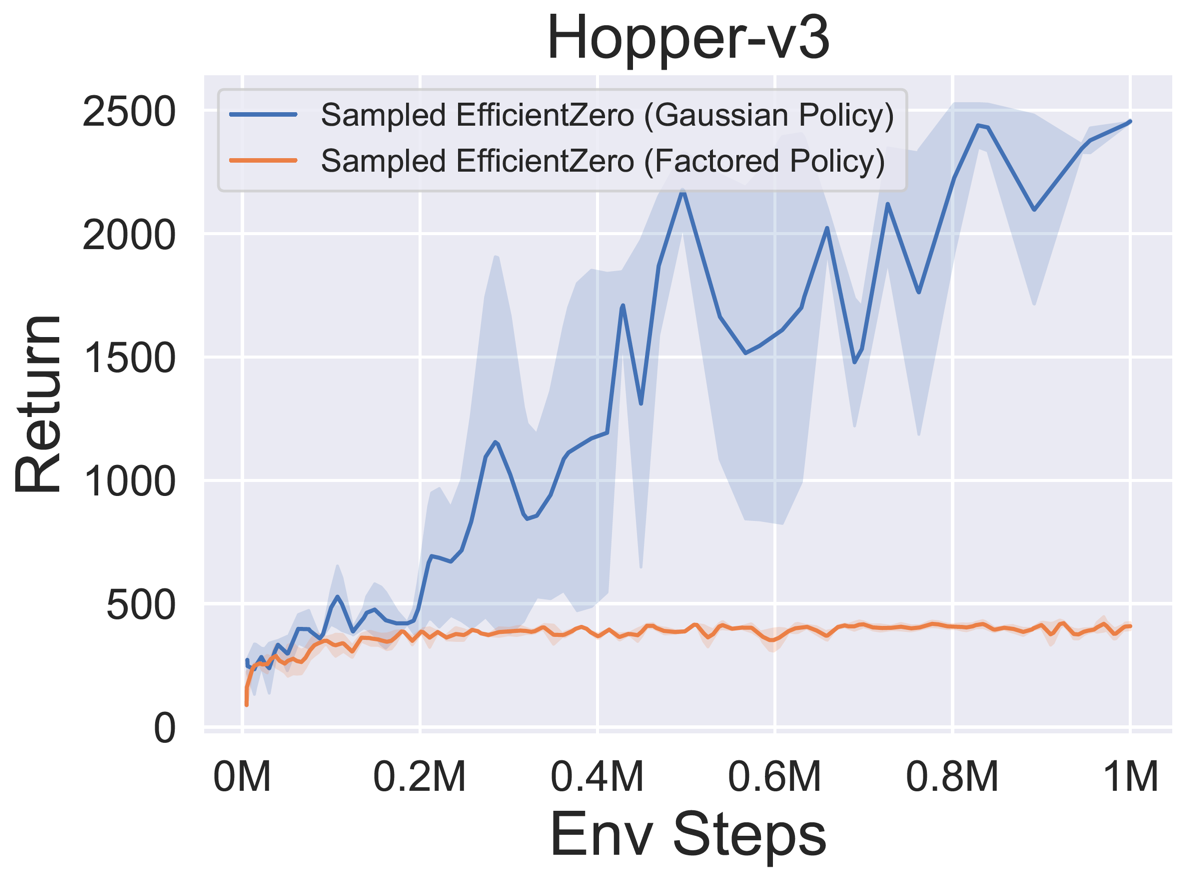

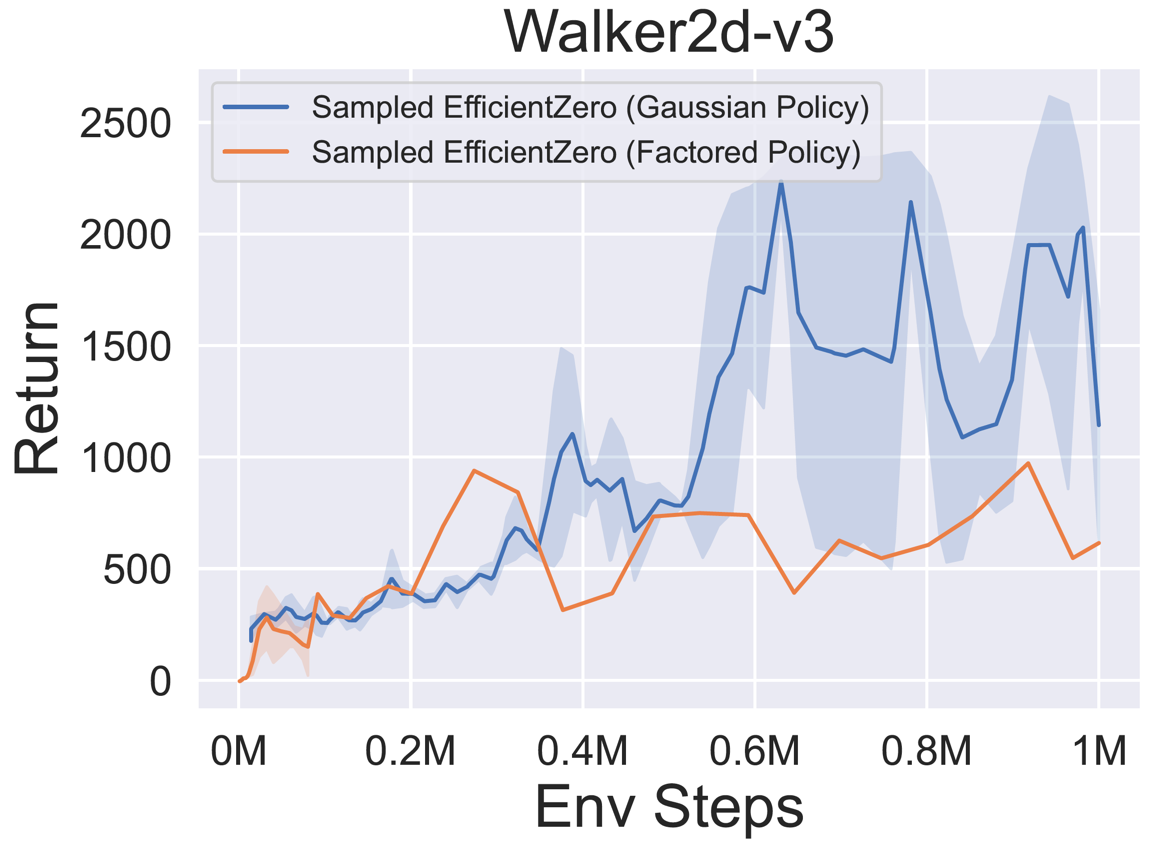

- Abaixo estão os resultados de referência da amostrada eficientezinha com representação de políticas

Factored/Gaussian em três jogos clássicos de ação contínua: Pendulum-V1, LunarLanderContinuous-V2, Bipedalwalker-V3 e dois jogos de espaço de ação contínua de Mujoco: Hopper-V3, Walker2D-V3.

"Política fatorada" indica que o agente aprende uma rede de políticas que gera uma distribuição categórica. Após a discretização manual, as dimensões do espaço de ação para os cinco ambientes são 11, 49 (7^2), 256 (4^4), 64 (4^3) e 4096 (4^6), respectivamente. Por outro lado, "Política Gaussiana" refere -se ao agente que aprende uma rede de políticas que gera diretamente parâmetros (MU e Sigma) para uma distribuição gaussiana.

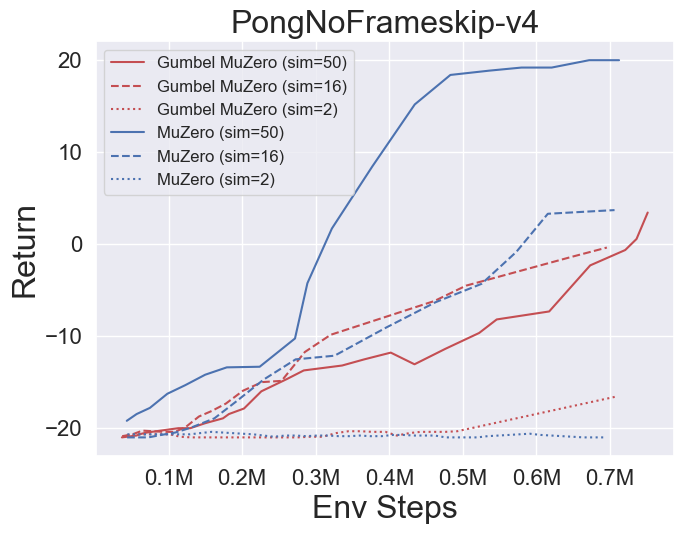

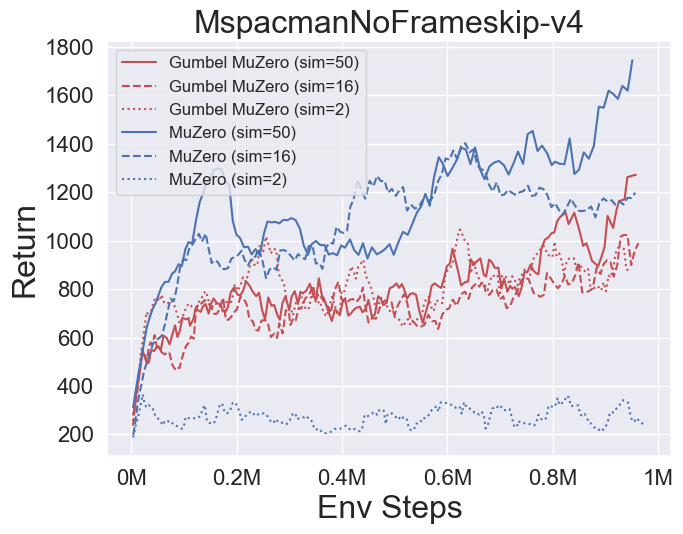

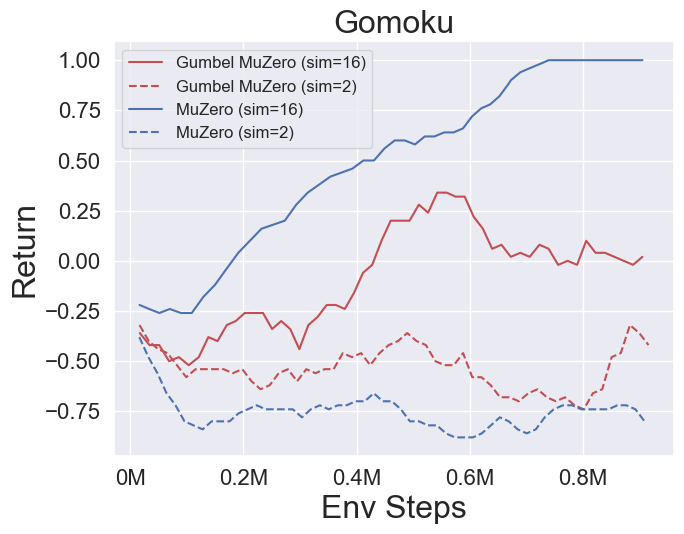

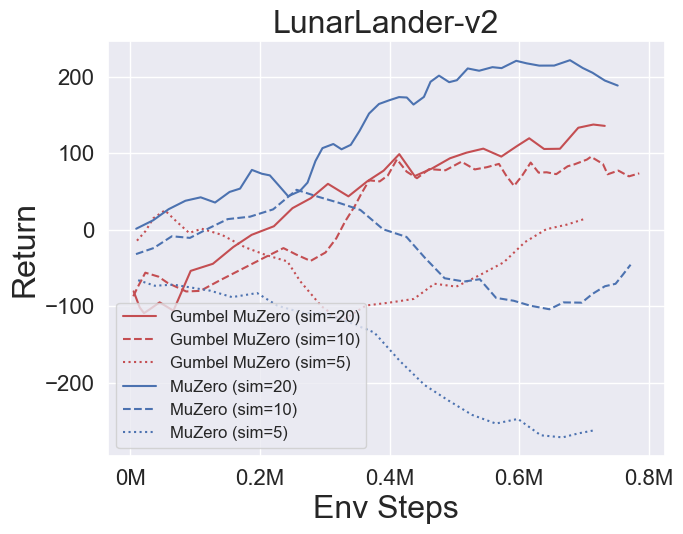

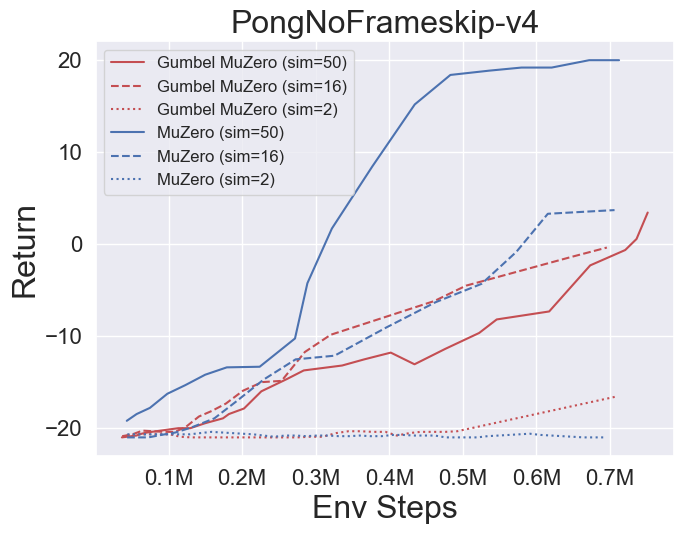

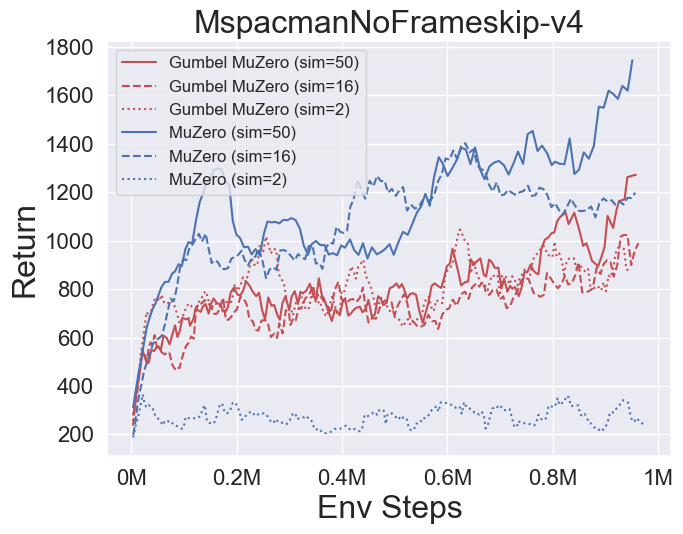

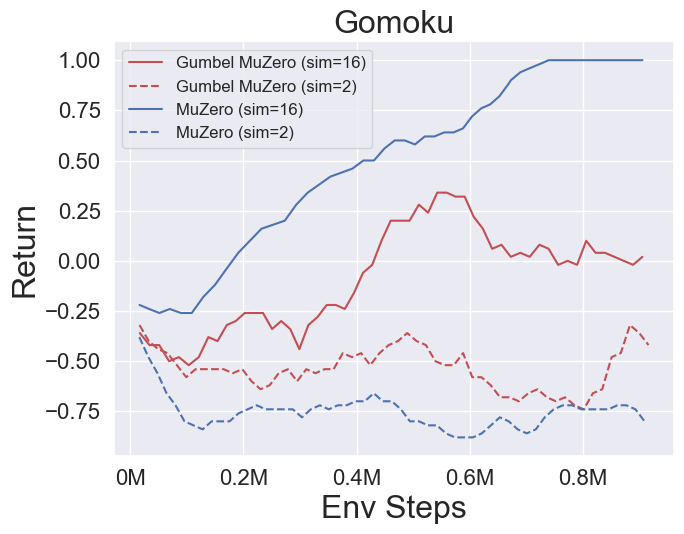

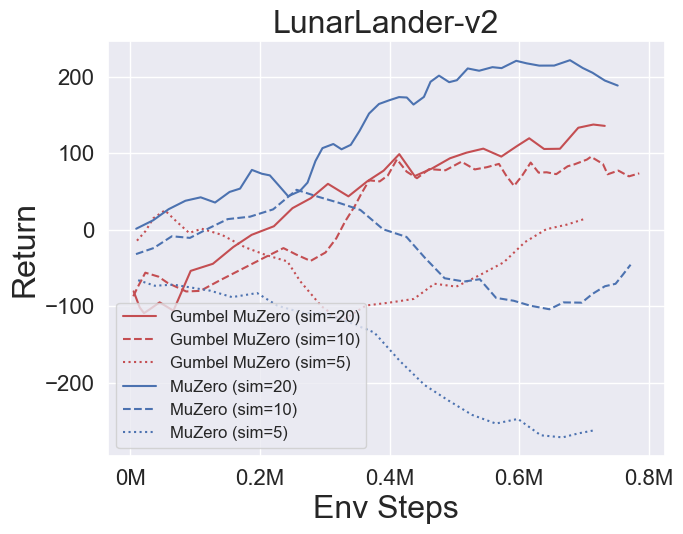

- Abaixo estão os resultados de referência de Gumbelmuzero e Muzero (sob diferentes custos de simulação) em quatro ambientes: pongnoframeskip-v4, mspacmannoframeskip-v4, gomoku e lunarlandercontinuou-v2.

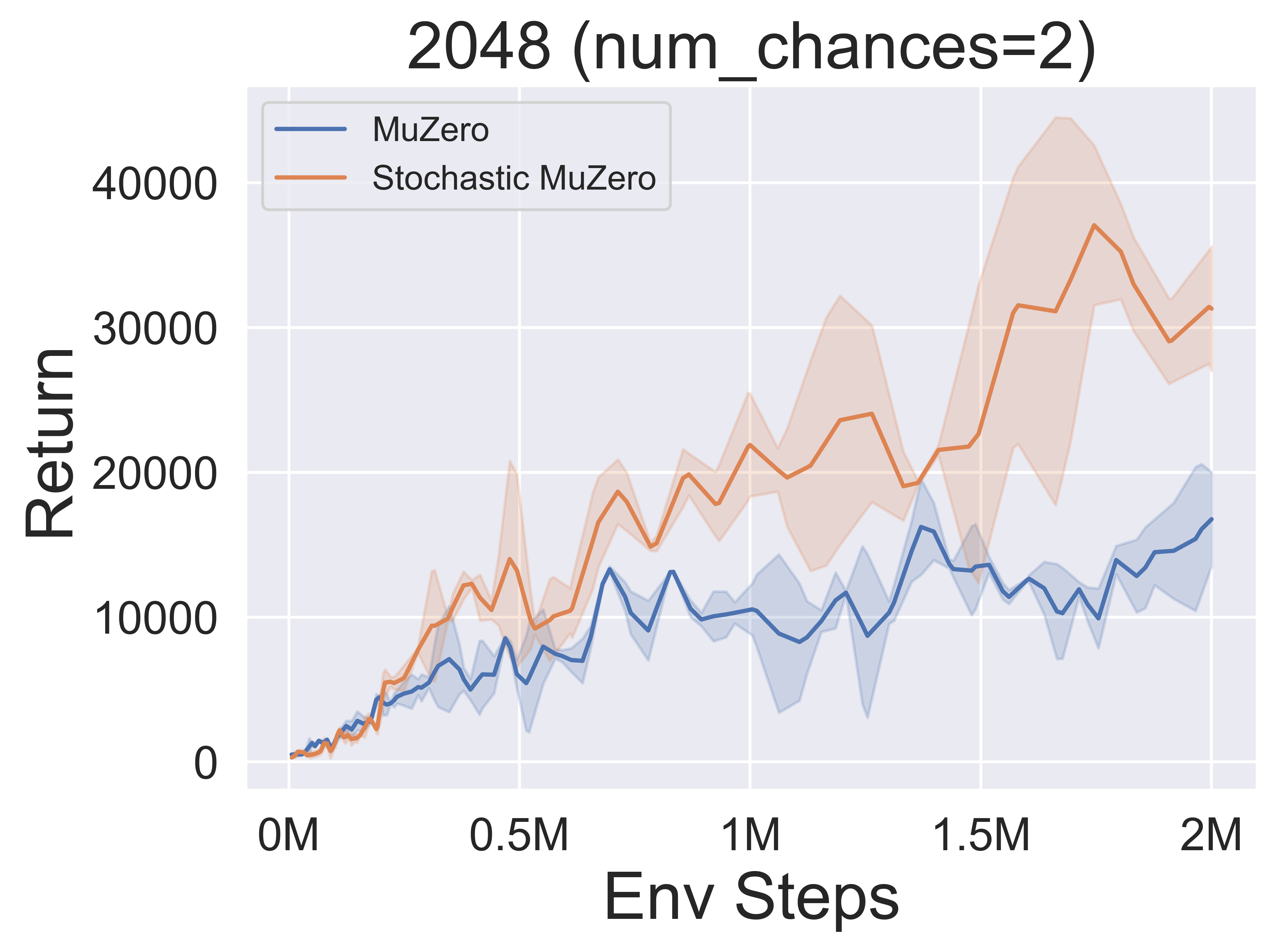

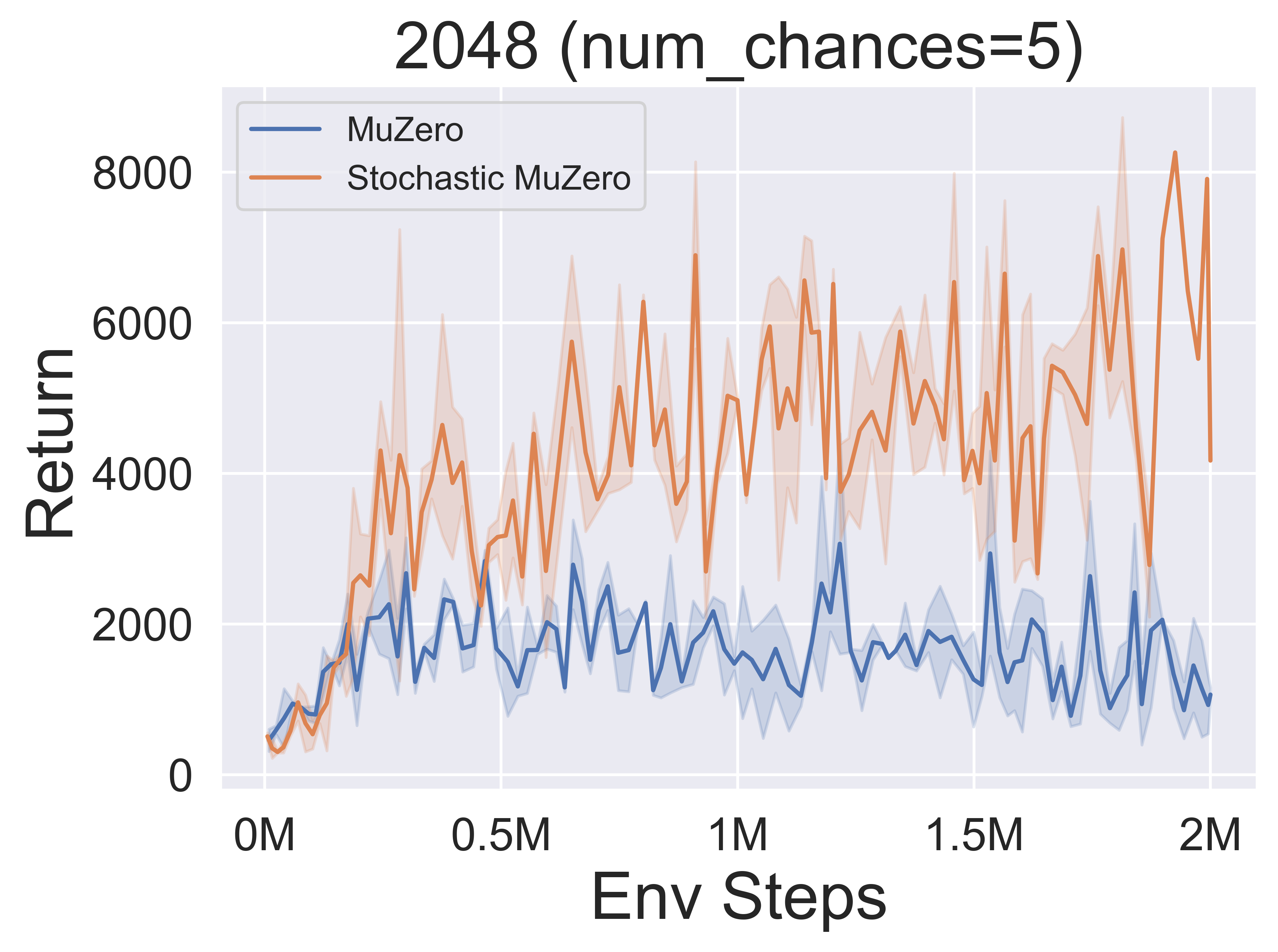

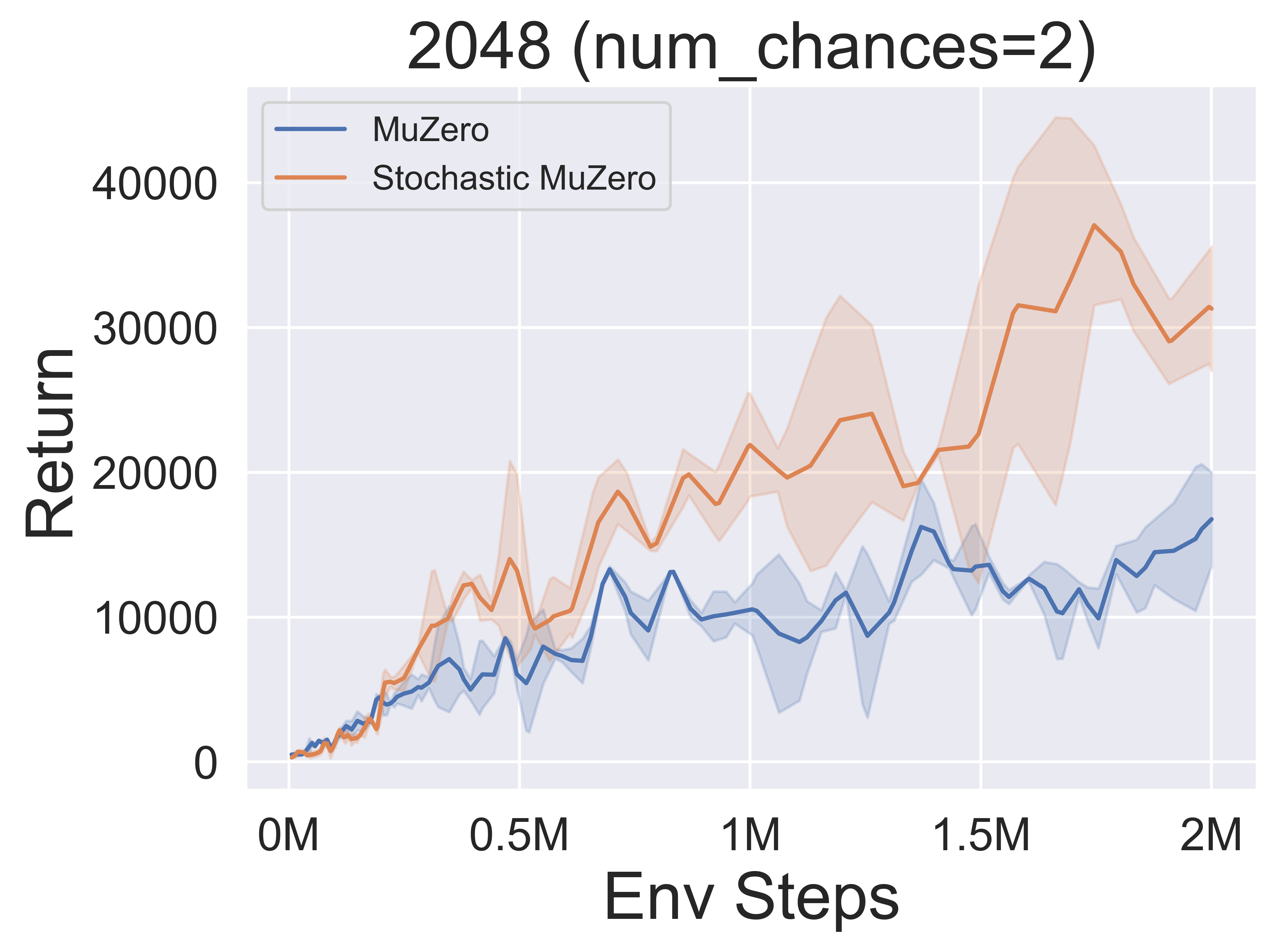

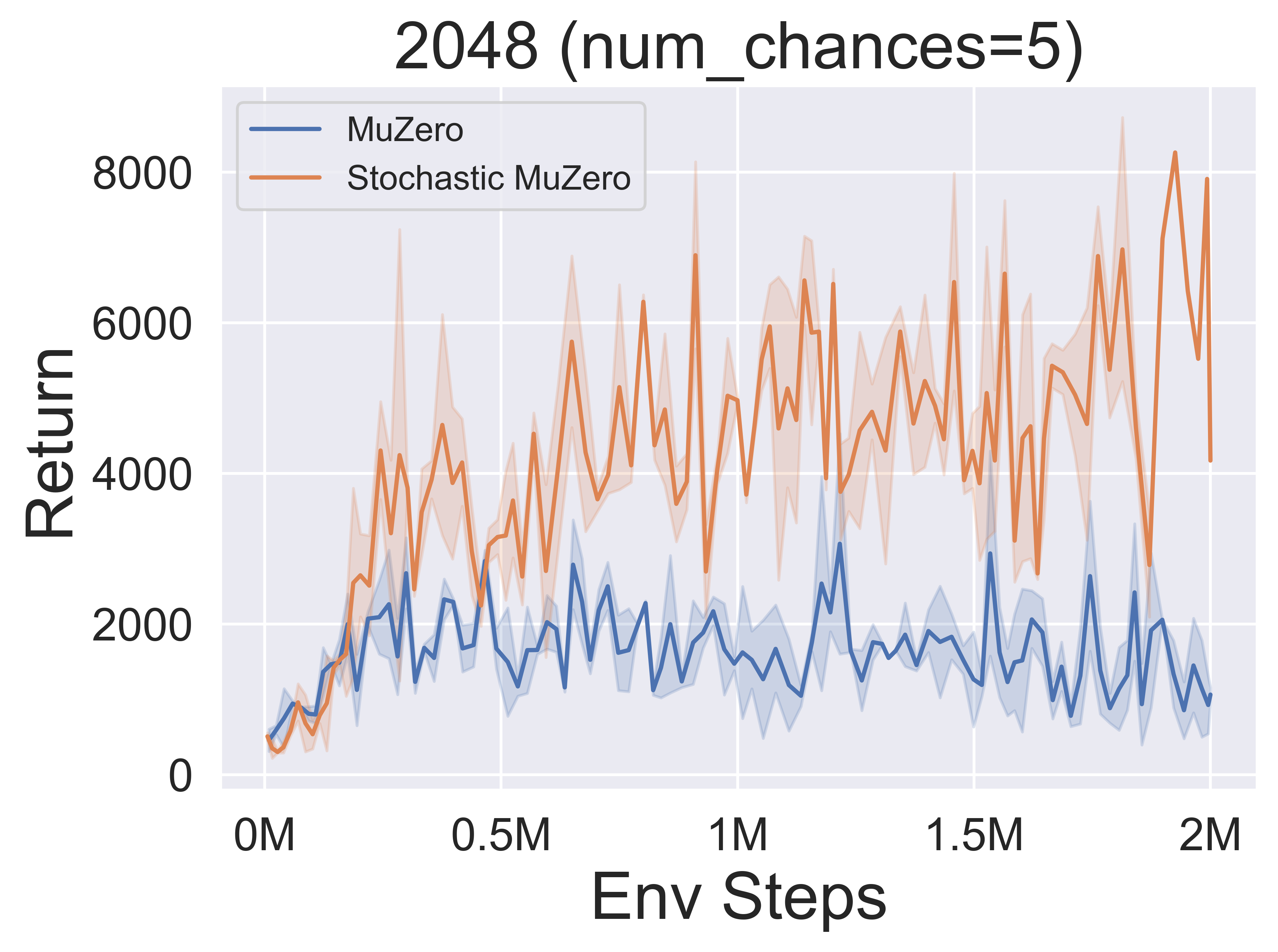

- Abaixo estão os resultados de referência de estocasticmuzero e muzero no ambiente 2048 com níveis variados de acaso (num_chances = 2 e 5).

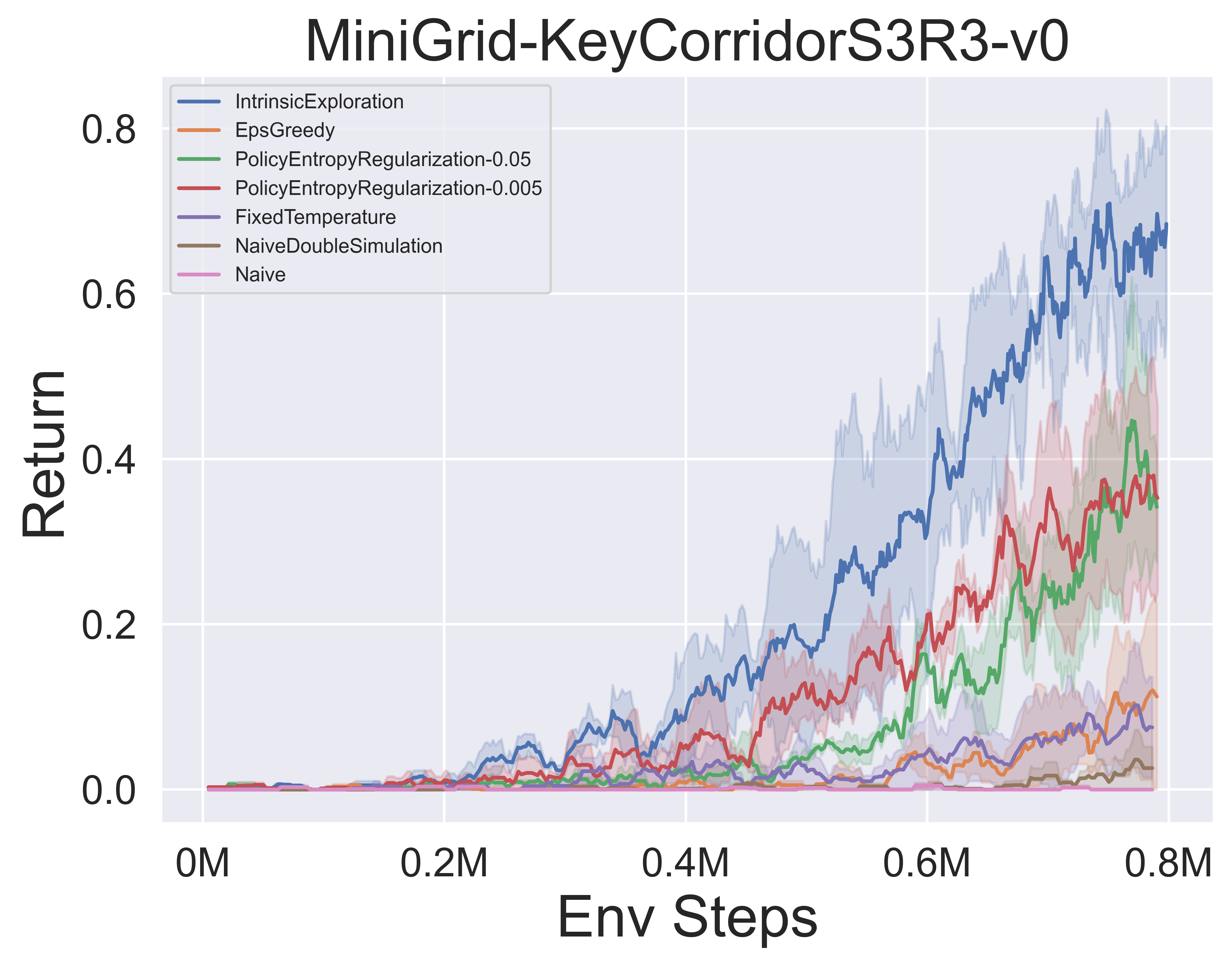

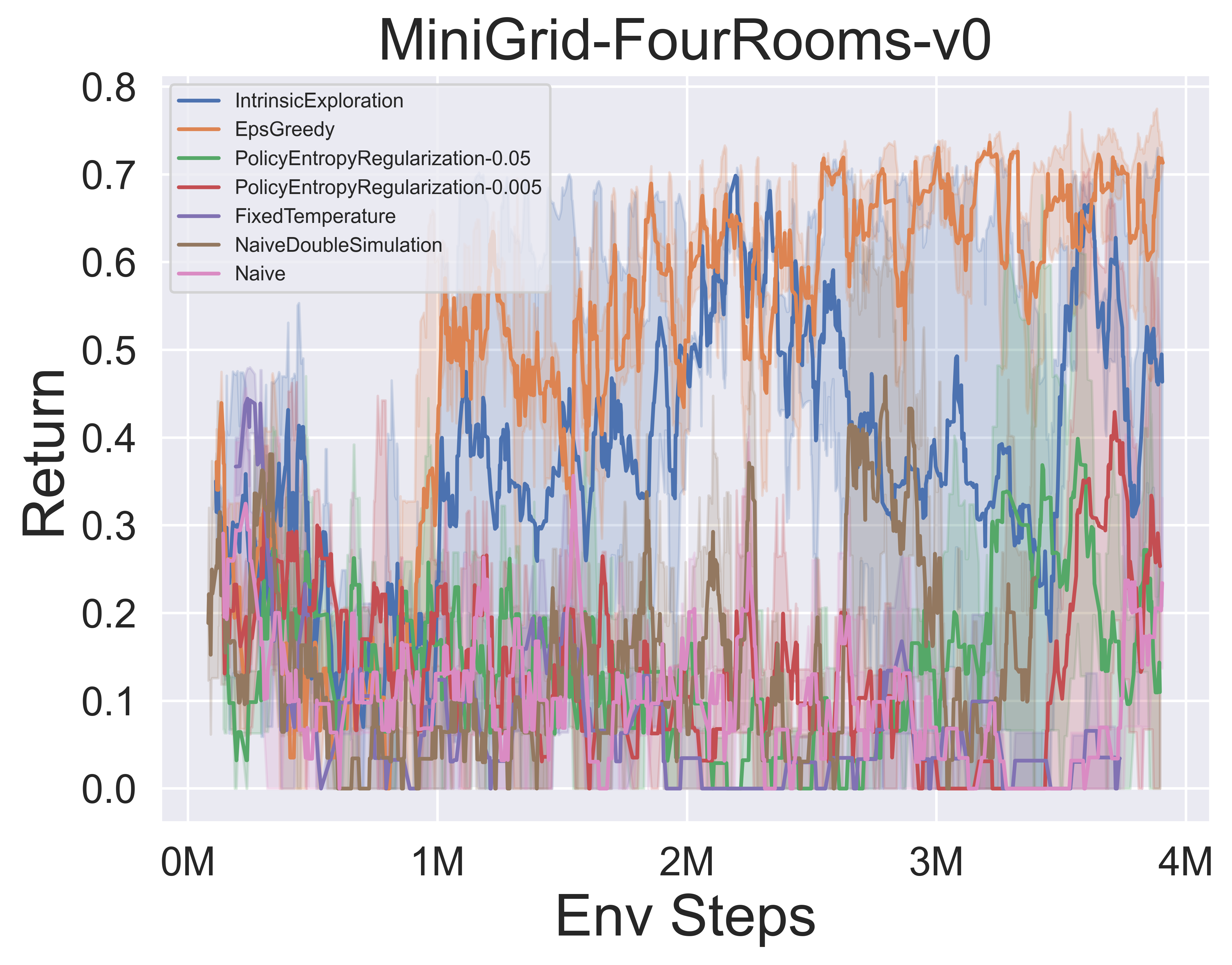

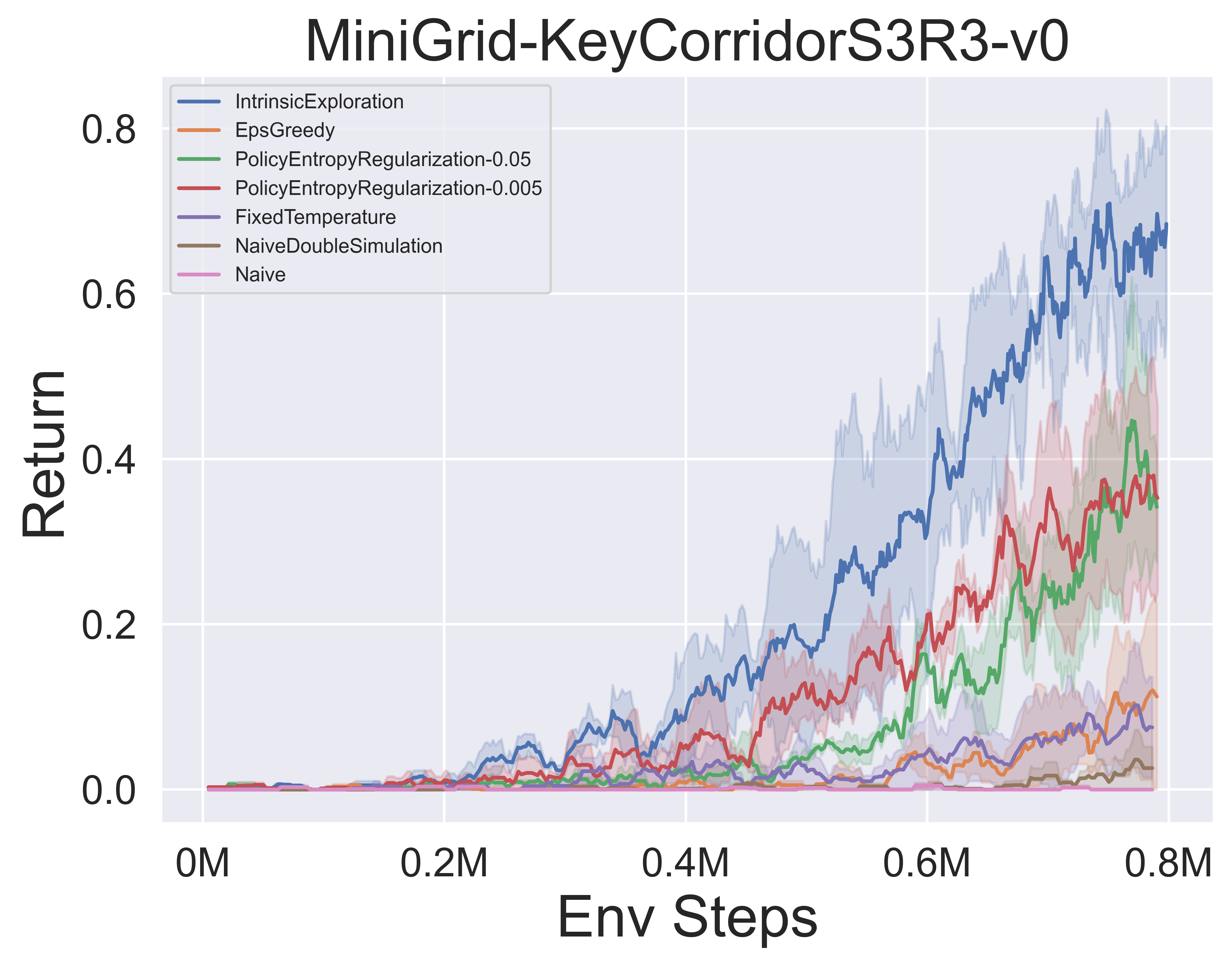

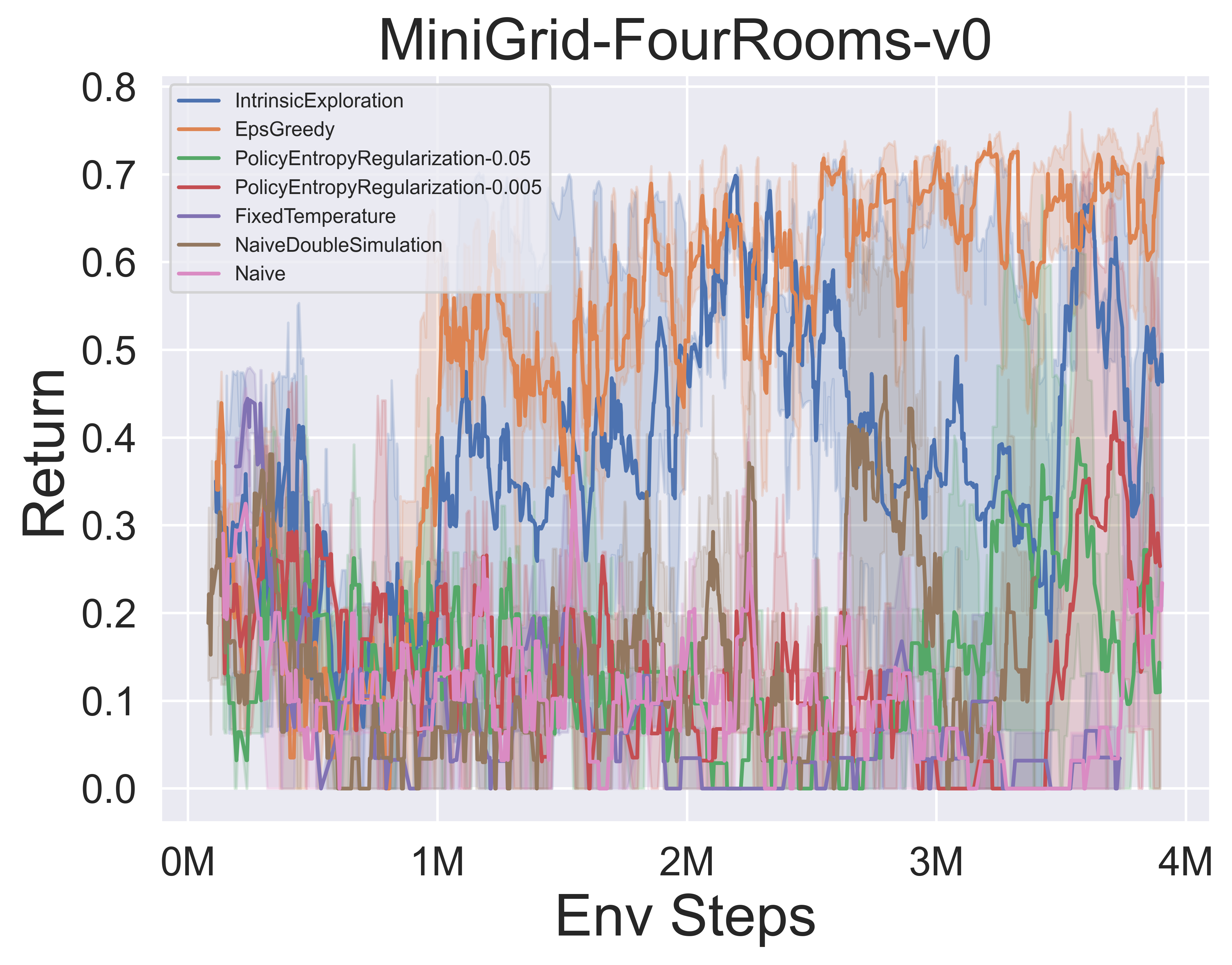

- Abaixo estão os resultados de referência de vários mecanismos de exploração do MCTS de muzero com SSL no ambiente de minigrídeos.

Notas Awesome-MCTs

Notas em papel

A seguir, estão as notas de papel detalhadas (em chinês) dos algoritmos acima:

Clique para entrar em colapso

- Alphazero

- MuZero

- Eficientezinho

- SampledmuZero

- GumbelmuZero

- STOCHASTICMUZERO

- Notação

Você também pode se referir à coluna Zhihu relevante (em chinês): análise aprofundada das teorias e aplicações da fronteira MCTS+RL.

Algo. Visão geral

A seguir, são apresentados os diagramas de princípios dos MCTs da visão geral dos algoritmos acima:

Clique para expandir

- McTs

- Alphazero

- MuZero

- Eficientezinho

- SampledmuZero

- GumbelmuZero

- STOCHASTICMUZERO

Documentos de MCTs impressionantes

Aqui está uma coleção de trabalhos de pesquisa sobre a busca de árvores de Monte Carlo . Esta seção será atualizada continuamente para rastrear a fronteira do MCTS.

Papéis -chave

Clique para expandir

LightZero implementou séries

- 2018 Science Alphazero: um algoritmo de aprendizado de reforço geral que mestre mestre xadrez, shogi, e passa por auto-jogo

- 2019 MuZero: Mastering Atari, Go, Chess e Shogi planejando com um modelo instruído

- 2021 eficientezero: dominar os jogos do Atari com dados limitados

- 2021 amostrado muzero: aprendizado e planejamento em espaços de ação complexos

- 2022 MuZero estocástico: planejamento em ambientes estocásticos com um modelo instruído

- 2022 Gumbel Muzero: Melhoria de Políticas Planejando com Gumbel

Série Alphago

- 2015 Nature Alphago, dominando o jogo de Go com redes neurais profundas e pesquisa de árvores

- 2017 Nature alphago zero dominando o jogo de go sem conhecimento humano

- 2019 ELF OpenGo: uma análise e reimplementação aberta de Alphazero

- 2023 Aluno de jogos: um algoritmo de aprendizado unificado para jogos de informação perfeitos e imperfeitos

Série MuZero

- 2022 Aprendizagem de reforço online e offline planejando com um modelo instruído

- 2021 Modelos quantizados de vetor para planejar

- 2021 Muesli: Combinando melhorias na otimização de políticas.

Análise MCTS

- 2020 Pesquisa de árvore de Monte-Carlo como otimização de políticas regularizada

- 2021 Modelos e valores autoconsistentes

- 2022 Políticas adversárias vencem em nível profissional Ais

- 2022 Aquisição de conhecimentos de xadrez PNAs em Alphazero.

Aplicação MCTS

- 2023 Aprendiz de física simbólica: Descobrindo equações de governo via Monte Carlo Tree Search

- 2022 Natureza descobrindo algoritmos de multiplicação de matriz mais rápidos com aprendizado de reforço

- 2022 MUZERO com autocompetição para controle de taxas na compactação de vídeo VP9

- 2021 DOUZERO: Dominando Doudizhu com Aprendizagem de Reforço Profundo do Auto-Play

- 2019 Combinando planejamento e aprendizado de reforço profundo na tomada de decisão tática para direção autônoma

Outros papéis

Clique para expandir

ICML

- Melhoria de política segura escalável via Monte Carlo Tree Search 2023

- Alberto Castellini, Federico Bianchi, Edoardo Zorzi, Thiago D. Simão, Alessandro Farinelli, Matthijs TJ Spaan

- Chave: Melhoria de Política Segura Online usando uma estratégia baseada em MCTs, melhoria segura de políticas com bootstrapping de linha de base

- Evenv: Gridworld e Sysadmin

- Aprendizagem eficiente para Alphazero via Consistência do Path 2022

- Dengwei Zhao, Shikui Tu, Lei Xu

- Chave: quantidade limitada de auto-jogadas, consistência do caminho (PC) otimização

- EVNV: vá, Otelo, Gomoku

- Visualizando os modelos MuZero 2021

- Joery A. de Vries, Ken S. Voskuil, Thomas M. Moerland, Aske Plaat

- Chave: Visualizando o modelo de dinâmica equivalente a valor, trajetórias de ação divergentes, duas técnicas de regularização

- EVNV: Cartpole e Mountaincar.

- Regularização convexa na pesquisa de árvores de Monte-Carlo 2021

- Barragem de Tuan, Carlo d'eramo, Jan Peters, Joni Pajarinen

- Chave: operadores de backup de entropia-regulação, análise de arrependimento, etropy de tsallis,

- EVNV: Árvore Sintética, Atari

- Tree de filtro de partículas de informação: um algoritmo online para POMDPs com recompensas baseadas em crenças em domínios contínuos 2020

- Johannes Fischer, Ömer Sahin Tas

- Chave: POMDP contínuo, árvore de filtro de partículas, modelagem de recompensa baseada em informações, coleta de informações.

- EVNV: POMDPS.JL Framework

- Código

- Retro*: Aprendendo planejamento retrosintético com guiado neural A* Pesquisa 2020

- Binghong Chen, Chengtao Li, Hanjun Dai, LE Song

- Chave: Planejamento retrosintético químico, algoritmo A*semelhante a neural, Andor Tree

- EVNV: conjuntos de dados do USPTO

- Código

ICLR

- A estrutura de equivalência de atualização para o planejamento do tempo de decisão 2024

- Samuel Sokota, Gabriele Farina, David J. Wu, Hengyuan Hu, Kevin A. Wang, J Zico Kolter, Noam Brown

- Chave: jogos de informações imperfeitas, pesquisa, planejamento de tempo de decisão, equivalência de atualização

- Evenv: Hanabi, 3x3 Hex-escuro abrupto e fantasma tic-tac-toe

- Aprendizagem de reforço multi-agente eficiente planejando 2024

- Qihan Liu, Jianing Ye, Xiaoteng MA, Jun Yang, Bin Liang, Chongjie Zhang

- Chave: Aprendizagem de reforço multi-agente, planejamento, MCTs multi-agente

- EVNV: SMAC, Lunarlander, Mujoco e Google Research Football

- Torne -se um jogador proficiente com dados limitados ao assistir a vídeos Pure 2023

- Weirui Ye, Yunsheng Zhang, Pieter Abbeel, Yang Gao

- Chave: pré-treinamento de vídeos sem ação, consistência do ciclo-inverso a termo (FICC) Objetivo com base na quantização de vetores, fase de pré-treinamento, fase de ajuste fino.

- EVNV: Atari

- Autocompetição baseada em políticas para problemas de planejamento 2023

- Jonathan Pirnay, Quirin Göttl, Jakob Burger, Dominik Gerhard Grimm

- Chave: Autocompetição, encontre fortes trajetórias planejando contra possíveis estratégias de seu eu passado.

- EVNV: Problema de vendedor ambulante e o problema de agendamento da loja de empregos.

- Explicando modelos de gráficos temporais por meio de uma estrutura exploradora-navigadora 2023

- Wenwen Xia, Mincai Lai, Caihua Shan, Yao Zhang, Xinnan Dai, Xiang Li, Dongsheng LI

- Chave: Explorador temporal do GNN, um explorador para encontrar os subconjuntos de eventos com o MCTS, um navegador que aprende as correlações entre os eventos e ajuda a reduzir o espaço de pesquisa.

- EVNV: Wikipedia e Reddit, conjuntos de dados sintéticos

- Speedyzero: dominar o Atari com dados limitados e tempo 2023

- Yixuan Mei, Jiaxuan Gao, Weirui Ye, Shaohuai Liu, Yang Gao, Yi Wu

- Chave: Sistema RL distribuído, atualização de prioridade, Lars cortado

- EVNV: Atari

- Otimização de políticas offline eficiente com um modelo aprendido 2023

- Zichen Liu, Siyi Li, Wee Sun Lee, Shuicheng Yan, Zhongwen Xu

- Chave: algoritmo baseado em modelo de uma etapa regularizado para Offline-RL

- EVNV: Atari , bsuite

- Código

- Ativando objetivos de tradução arbitrária com pesquisa de árvore adaptativa 2022

- Wang Ling, Wojciech Stokowiec, Domenic Donato, Chris Dyer, Lei Yu, Laurent Sartran, Austin Matthews

- Chave: Pesquisa de árvore adaptativa, modelos de tradução, modelos autoregressivos,

- EVNV: Tarefas chinesas -inglesas e pashto -inglês do WMT2020, alemão -inglês do WMT2014

- O que há de errado com o aprendizado profundo na pesquisa de árvores para otimização combinatória 2022

- Maximili1an Böther, Otto Kißig, Martin Taraz, Sarel Cohen, Karen Seidel, Tobias Friedrich

- Chave: otimização combinatória, suíte de referência de código aberto para o problema do conjunto independente máximo de NP, uma análise aprofundada do popular algoritmo de busca de árvores guiadas, compare as implementações de pesquisa de árvores com outros solucionadores

- EVNV: conjunto independente máximo de NP.

- Código

- Planejamento e aprendizado de Monte-Carlo com Estimações de valor de ação do idioma 2021

- Youngsoo Jang, Seokin Seo, Jongmin Lee, Kee-Eung Kim

- Chave: Pesquisa de árvore de Monte-Carlo com exploração orientada a idiomas, estimativas de valor da linguagem otimista localmente.

- EVNV: jogos de ficção interativa (se)

- Practical Massamente paralelo Monte-Carlo Tree Search Aplicada ao Design Molecular 2021

- Xiufeng Yang, Tanuj Kr Aasawat, Kazuki Yoshizoe

- Chave: Pesquisa de árvore de Monte-Carlo, em massa de paralelo, design molecular, pesquisa paralela orientada a hash,

- EVNV: Coeficiente de partição octanol-água (LOGP) Penalizado pela acessibilidade sintética (SA) e pela grande pontuação de penalidade do anel.

- Assista ao não observado: uma abordagem simples para paralelize a busca de Monte Carlo Tree 2020

- Anji Liu, Jianshu Chen, Mingze Yu, Yu Zhai, Xuewen Zhou, Ji Liu

- Chave: Pesquisa paralela de árvore de Monte-Carlo, particionar a árvore em sub-árvores com eficiência, compare a taxa de observação de cada processador.

- EVNV: Comparação de aceleração e desempenho no jogo Joy-City, Episódio médio Retorno no jogo Atari

- Código

- Aprendendo a planejar em altas dimensões via árvores de exploração neural de exploração 2020

- Binghong Chen, Bo Dai, Qinjie Lin, Guo Ye, Han Liu, Le Song

- Chave: o algoritmo de planejamento do meta caminho, explora uma nova arquitetura neural que pode aprender instruções promissoras de pesquisa das estruturas de problemas.

- EVNV: Um espaço de trabalho 2D com um robô de 2 DOF (graus de liberdade), um robô de 3 DOF e um robô de 5 DOF Snake

Neurips

- LightZero: um benchmark unificado para a busca de árvores de Monte Carlo em cenários de decisão seqüencial geral 2023

- Yazhe Niu, Yuan Pu, Zhenjie Yang, Xueyan Li, Tong Zhou, Jiyuan Ren, Shuai Hu, Hongsheng Li, Yu Liu

- Chave: O primeiro benchmark unificado para implantar o MCTS/MUZERO em cenários de decisão seqüencial geral.

- EVNV: ClassicControl, Box2D, Atari, Mujoco, Gobigger, Minigrid, Tictactoe, ConnectFour, Gomoku, 2048, etc.

- Modelos de idiomas grandes como conhecimento comum para o planejamento de tarefas em larga escala 2023

- Zirui Zhao, Wee Sun Lee, David Hsu

- Chave: o Modelo Mundial (LLM) e a Política Induzida por LLM podem ser combinados no MCTS, para ampliar o planejamento de tarefas.

- EVNV: multiplicação, planejamento de viagens, rearranjo de objetos

- Pesquisa de árvore de Monte Carlo com Boltzmann Exploration 2023

- Michael Painter, Mohamed Baioumy, Nick Hawes, Bruno Lacerda

- Chave: exploração de Boltzmann com MCTs, ações ideais para o objetivo máximo de entropia não correspondem necessariamente a ações ideais para o objetivo original, dois algoritmos aprimorados.

- Evenv: o ambiente do lago congelado, o problema de navegação, vá

- Consistência generalizada do caminho ponderado para dominar os jogos Atari 2023

- Dengwei Zhao, Shikui Tu, Lei Xu

- Chave: Consistência do caminho ponderado generalizado, um mecanismo de ponderação.

- EVNV: Atari

- Acelerando a pesquisa de árvores de Monte Carlo com a abstração do estado da árvore de probabilidade 2023

- Yangqing fu, ming sol, buqing nie, yue gao

- Chave: Abstração do estado da árvore de probabilidade, transitividade e erro de agregação limitado

- EVNV: Atari, Cartpole, Lunarlander, Gomoku

- Passar o tempo de pensamento com sabedoria: acelerando MCTs com expansões virtuais 2022

- Weirui ye, Pieter Abbeel, Yang Gao

- Chave: troca de computação versus performancem, expansões virtuais, gaste o tempo de pensar de forma adaptativa.

- EVNV: Atari, 9x9 Go

- Planejamento para amostra de imitação eficiente aprendizado 2022

- Zhao-heng yin, weirui ye, qifeng chen, yang gao

- Chave: Clonagem Comportamental , Aprendizagem de Imitação Adversária (AIL) , RL baseado em MCTS.

- Evenv: DeepMind Control Suite

- Código

- Avaliação além do desempenho da tarefa: Analisando conceitos em Alphazero em Hex 2022

- Charles Lovering, Jessica Zosa Ford, George Konidaris, Ellie Pavlick, Michael L. Littman

- Chave: representações internas do Alphazero, testes de sondagem e comportamento do modelo, como esses conceitos são capturados na rede.

- EVNV: Hex

- Os agentes do tipo Alphazero são robustos às perturbações adversárias? 2022

- Li-Cheng Lan, Huan Zhang, Ti-Rong Wu, Meng-Yu Tsai, I-Chen Wu, 4 Cho-Jui Hsieh

- Chave: Estados adversários, primeiro ataque adversário a Go Ais.

- EVENV: Vá

- Descida de árvore de Monte Carlo para otimização de caixa preta 2022

- Yaoguang Zhai, Sicun Gao

- Chave: Otimização de caixa preta, como integrar ainda mais a descida baseada em amostra para uma otimização mais rápida.

- EVNV: Funções sintéticas para otimização não linear, problemas de aprendizado de reforço em ambientes de locomoção de Mujoco e problemas de otimização na pesquisa de arquitetura neural (NAS).

- Seleção variável baseada em pesquisa de árvores de Monte Carlo para otimização bayesiana de alta dimensão 2022

- Música de Lei ∗, Ke Xue ∗, Xiaobin Huang, Chao Qian

- Chave: Um subespaço de baixa dimensão via MCTS, otimiza no subespaço com qualquer algoritmo de otimização bayesiano.

- EVNV: Problemas de bancada NAS e locomoção mujoco

- Seguar

- Samuel Sokota, Caleb Ho, Zaheen Ahmad, J. Zico Kolter

- Chave: ambientes estocásticos, alargamento progressivo, refino de abstração

- EVNV: Blackjack, Trap, Cinco por Cinco GO.

- Deep Synoptic Monte Carlo Planning in Reconnaissance Blind Chess 2021

- Gregory Clark

- Chave: Informação imperfeita, estado de crença com um filtro de partículas não ponderadas, uma nova abstração estocástica dos estados da informação.

- Evenv: Reconnaissance Blind Chess

- Poly-hoot: planejamento de Monte-Carlo em MDPs de espaço contínuo com análise não asintótica 2020

- Weichao Mao, Kaiqing Zhang, Qiaomin Xie, Tamer Ba)

- Chave: Espaços de ação estatal contínua, otimização otimista hierárquica.

- EVNV: Cartpole, pêndulo invertido, swing-up e lunarlander.

- Aprendizagem Pesquisa Espaço Partição para otimização de caixa preta usando Monte Carlo Tree Search 2020

- Linnan Wang, Rodrigo Fonseca, Yuandong Tian

- Chave: aprende a partição do espaço de pesquisa usando algumas amostras, um limite de decisão não linear e aprende um modelo local para escolher bons candidatos.

- EVNV: tarefas de locomoção Mujoco, benchmarks de pequena escala,

- Misture e corresponda: uma abordagem otimista de pesquisa de árvores para aprender modelos de distribuições de mistura 2020

- Matthew Faw, Rajat Sen, Karthikeyan Shanmugam, Constantine Caramanis, Sanjay Shakkottai

- Chave: Problema de mudança de covariável, Mix & Match combina descida de gradiente estocástica (SGD) com pesquisa otimista de árvores e reutilização de modelos (evoluindo modelos parcialmente treinados com amostras de diferentes distribuições de mistura)

- Código

Outra conferência ou diário

- Aprendendo a parar: simulação dinâmica Monte-Carlo Tree Search AAAI 2021.

- No Monte Carlo Tree Search and Reforcment Learning Journal of Artificial Intelligence Research 2017.

- Pesquisa de arquitetura neural com eficiência de amostra, aprendendo ações para pesquisas de árvore de Monte Carlo Transações IEEE sobre análise de padrões e inteligência de máquina 2022.

Feedback e contribuição

Arquivar um problema no GitHub

Abra ou participe do nosso fórum de discussão

Discuta no servidor LightZero Discord

Entre em contato com nosso email ([email protected])

Agradecemos todos os comentários e contribuições para melhorar a LightZero, tanto os algoritmos quanto os projetos de sistemas.

? Citação

@article{niu2024lightzero,

title={LightZero: A Unified Benchmark for Monte Carlo Tree Search in General Sequential Decision Scenarios},

author={Niu, Yazhe and Pu, Yuan and Yang, Zhenjie and Li, Xueyan and Zhou, Tong and Ren, Jiyuan and Hu, Shuai and Li, Hongsheng and Liu, Yu},

journal={Advances in Neural Information Processing Systems},

volume={36},

year={2024}

}

@article{pu2024unizero,

title={UniZero: Generalized and Efficient Planning with Scalable Latent World Models},

author={Pu, Yuan and Niu, Yazhe and Ren, Jiyuan and Yang, Zhenjie and Li, Hongsheng and Liu, Yu},

journal={arXiv preprint arXiv:2406.10667},

year={2024}

}

@article{xuan2024rezero,

title={ReZero: Boosting MCTS-based Algorithms by Backward-view and Entire-buffer Reanalyze},

author={Xuan, Chunyu and Niu, Yazhe and Pu, Yuan and Hu, Shuai and Liu, Yu and Yang, Jing},

journal={arXiv preprint arXiv:2404.16364},

year={2024}

}? Agradecimentos

Este projeto foi desenvolvido parcialmente com base nos seguintes trabalhos pioneiros nos repositórios do GitHub. Expressamos nossa profunda gratidão por esses recursos fundamentais:

- https://github.com/opendilab/di-engine

- https://github.com/deepmind/mctx

- https://github.com/yewr/effectero

- https://github.com/werner-duvaud/muzero-general

Gostaríamos de agradecer aos seguintes colaboradores @paparazz1, @karroyan, @nigheod, @jayyoung0802, @timothijoe, @tutuhuss, @harryxuancy, @puyuan1996, @Hansbug por suas contribuições valiosas e apoio a este algara.

Obrigado a todos que contribuíram para este projeto:

? Sustce

Todo o código dentro deste repositório está em Licença Apache 2.0.

(De volta ao topo)