Lightzero

Diperbarui pada 2024.12.10 Lightzero-V0.1.0

Bahasa Inggris | 简体中文 (Cina disederhanakan) | Dokumentasi | Kertas Lightzero | Kertas Unizero | Kertas Rezero

Lightzero adalah alat algoritma open-source yang ringan, efisien, dan mudah dipahami yang menggabungkan pencarian pohon Monte Carlo (MCTS) dan pembelajaran penguatan mendalam (RL). Untuk setiap pertanyaan tentang Lightzero, Anda dapat berkonsultasi dengan asisten tanya jawab berbasis RAG: Zeropal.

? Latar belakang

Integrasi pencarian pohon Monte Carlo dan pembelajaran penguatan mendalam, yang dicontohkan oleh Alphazero dan Muzero, telah mencapai tingkat kinerja yang belum pernah terjadi sebelumnya di berbagai permainan, termasuk Go dan Atari. Metodologi canggih ini juga telah membuat langkah yang signifikan dalam domain ilmiah seperti prediksi struktur protein dan pencarian algoritma multiplikasi matriks. Berikut ini adalah tinjauan evolusi historis dari seri algoritma pencarian pohon Monte Carlo:

Gambar di atas adalah pipa kerangka Lightzero. Kami secara singkat memperkenalkan tiga modul inti di bawah ini:

Model : Model digunakan untuk mendefinisikan struktur jaringan, termasuk fungsi __init__ untuk menginisialisasi struktur jaringan dan fungsi forward untuk menghitung propagasi maju jaringan.

Kebijakan : Policy menentukan cara jaringan diperbarui dan berinteraksi dengan lingkungan, termasuk tiga proses: proses learning , proses collecting , dan proses evaluation .

MCTS : MCTS mendefinisikan struktur pohon pencarian Monte Carlo dan cara berinteraksi dengan kebijakan tersebut. Implementasi MCTS mencakup dua bahasa: Python dan C ++, masing -masing diimplementasikan di ptree dan ctree .

Untuk struktur file Lightzero, silakan merujuk ke Lightzero_File_Structure.

? Algoritma terintegrasi

Lightzero adalah perpustakaan dengan implementasi algoritma MCTS Pytorch (kadang -kadang dikombinasikan dengan Cython dan CPP), termasuk:

- Alphazero

- Muzero

- Sampled Muzero

- Stochastic Muzero

- Efisiensizero

- Gumbel Muzero

- Rezero

- Unizero

Lingkungan dan algoritma yang saat ini didukung oleh Lightzero ditampilkan pada tabel di bawah ini:

| Env./Algo. | Alphazero | Muzero | Sampled Muzero | Efisiensizero | Sampled Efficientzero | Gumbel Muzero | Stochastic Muzero | Unizero | Sampled Unizero | Rezero |

|---|

| Tictactoe | ✔ | ✔ | | | | ✔ | | ✔ | | |

| Gomoku | ✔ | ✔ | | | | ✔ | | ✔ | | ✔ |

| Connect4 | ✔ | ✔ | | | | | | ✔ | | ✔ |

| 2048 | --- | ✔ | | | | | ✔ | ✔ | | |

| Catur | | | | | | | | | | |

| Pergi | | | | | | | | | | |

| Kartpol | --- | ✔ | | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ |

| Bandul | --- | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ | |

| Lunarlander | --- | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | |

| Bipedalwalker | --- | ✔ | ✔ | ✔ | ✔ | ✔ | | | ✔ | |

| Atari | --- | ✔ | | ✔ | ✔ | ✔ | ✔ | ✔ | | ✔ |

| Kontrol DeepMind | --- | --- | ✔ | --- | ✔ | | | | ✔ | |

| Mujoco | --- | ✔ | | ✔ | ✔ | | | | | |

| Minigrid | --- | ✔ | | ✔ | ✔ | | | ✔ | | |

| Bsuite | --- | ✔ | | ✔ | ✔ | | | ✔ | | |

| Ingatan | --- | ✔ | | ✔ | ✔ | | | ✔ | | |

| Sumtothree (biliar) | --- | | | | ✔ | | | | | |

| Metadrive | --- | | | | ✔ | | | | | |

(1): "✔" berarti bahwa item yang sesuai selesai dan diuji dengan baik.

(2): "" berarti bahwa item yang sesuai ada dalam daftar tunggu (bekerja dalam proses).

(3): "---" berarti bahwa algoritma ini tidak mendukung lingkungan ini.

Instalasi

Anda dapat menginstal Lightzero terbaru dalam pengembangan dari kode sumber GitHub dengan perintah berikut:

git clone https://github.com/opendilab/LightZero.git

cd LightZero

pip3 install -e .

Mohon perhatikan bahwa Lightzero saat ini mendukung kompilasi hanya pada platform Linux dan macOS . Kami secara aktif bekerja untuk memperluas dukungan ini ke platform Windows . Kesabaran Anda selama transisi ini sangat dihargai.

Instalasi dengan Docker

Kami juga menyediakan DockerFile yang mengatur lingkungan dengan semua ketergantungan yang diperlukan untuk menjalankan perpustakaan Lightzero. Gambar Docker ini didasarkan pada Ubuntu 20.04 dan menginstal Python 3.8, bersama dengan alat dan perpustakaan lain yang diperlukan. Inilah cara menggunakan DockerFile kami untuk membangun gambar Docker, menjalankan wadah dari gambar ini, dan menjalankan kode Lightzero di dalam wadah.

- Unduh DockerFile : DockerFile terletak di direktori root dari repositori Lightzero. Unduh file ini ke mesin lokal Anda.

- Siapkan Konteks Bangun : Buat direktori kosong baru di mesin lokal Anda, pindahkan Dockerfile ke direktori ini, dan navigasikan ke direktori ini. Langkah ini membantu menghindari mengirim file yang tidak perlu ke daemon Docker selama proses pembangunan.

mkdir lightzero-docker

mv Dockerfile lightzero-docker/

cd lightzero-docker/

- Bangun gambar Docker : Gunakan perintah berikut untuk membangun gambar Docker. Perintah ini harus dijalankan dari dalam direktori yang berisi Dockerfile.

docker build -t ubuntu-py38-lz:latest -f ./Dockerfile .

- Jalankan wadah dari gambar : Gunakan perintah berikut untuk memulai wadah dari gambar dalam mode interaktif dengan shell bash.

docker run -dit --rm ubuntu-py38-lz:latest /bin/bash

- Jalankan kode Lightzero di dalam wadah : Setelah Anda berada di dalam wadah, Anda dapat menjalankan contoh skrip Python dengan perintah berikut:

python ./LightZero/zoo/classic_control/cartpole/config/cartpole_muzero_config.py

Awal yang cepat

Latih agen Muzero untuk bermain cartpole:

cd LightZero

python3 -u zoo/classic_control/cartpole/config/cartpole_muzero_config.py

Latih agen muzero untuk bermain pong:

cd LightZero

python3 -u zoo/atari/config/atari_muzero_segment_config.py

Latih agen Muzero untuk bermain tictactoe:

cd LightZero

python3 -u zoo/board_games/tictactoe/config/tictactoe_muzero_bot_mode_config.py

Latih agen unizero untuk bermain pong:

cd LightZero

python3 -u zoo/atari/config/atari_unizero_segment_config.py

Dokumentasi

Dokumentasi Lightzero dapat ditemukan di sini. Ini berisi tutorial dan referensi API.

Bagi mereka yang tertarik untuk menyesuaikan lingkungan dan algoritma, kami memberikan panduan yang relevan:

- Kustomisasi lingkungan

- Kustomisasi algoritma

- Bagaimana cara mengatur file konfigurasi?

- Sistem penebangan dan pemantauan

Jika Anda memiliki pertanyaan, jangan ragu untuk menghubungi kami untuk mendapatkan dukungan.

Benchmark

Klik untuk memperluas

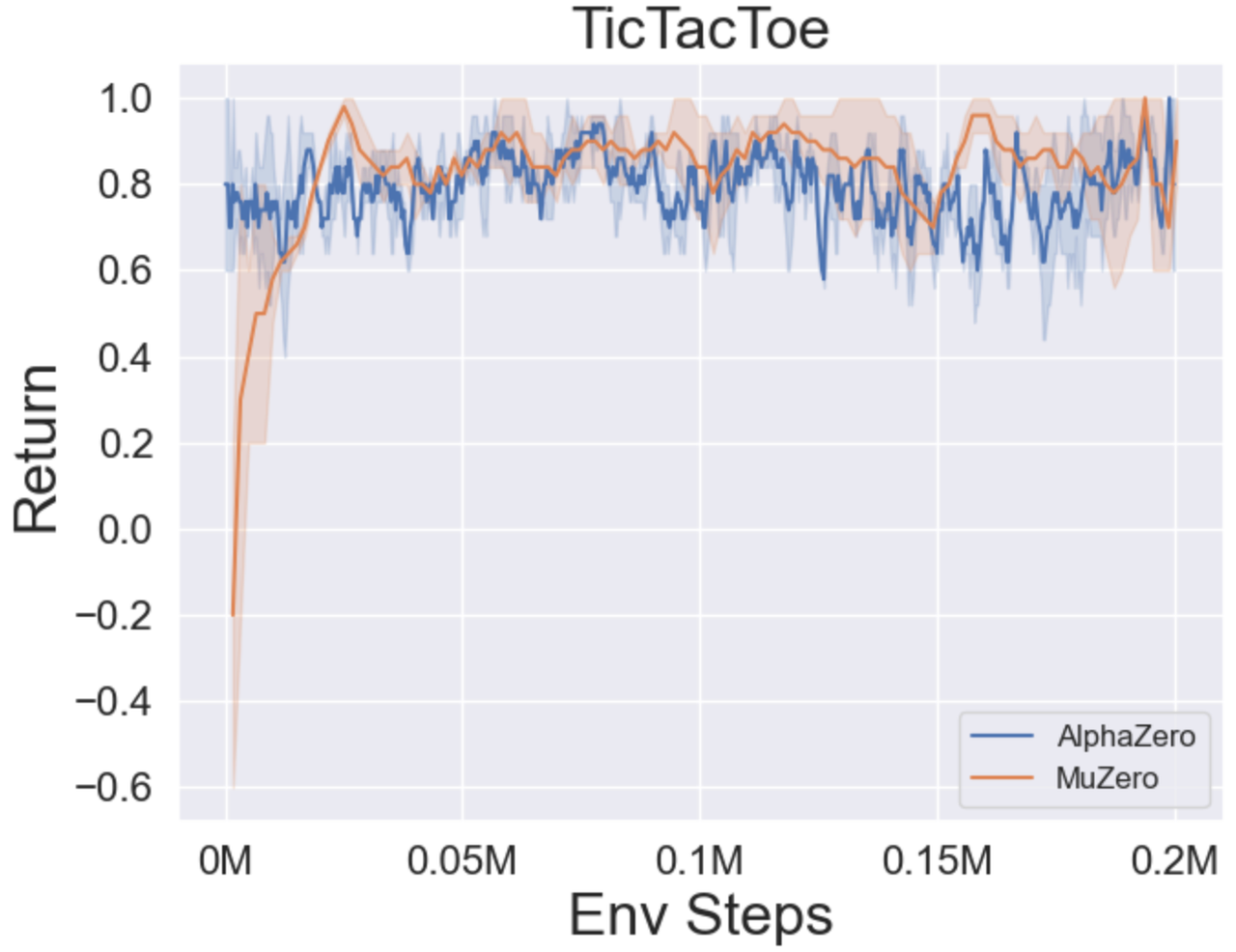

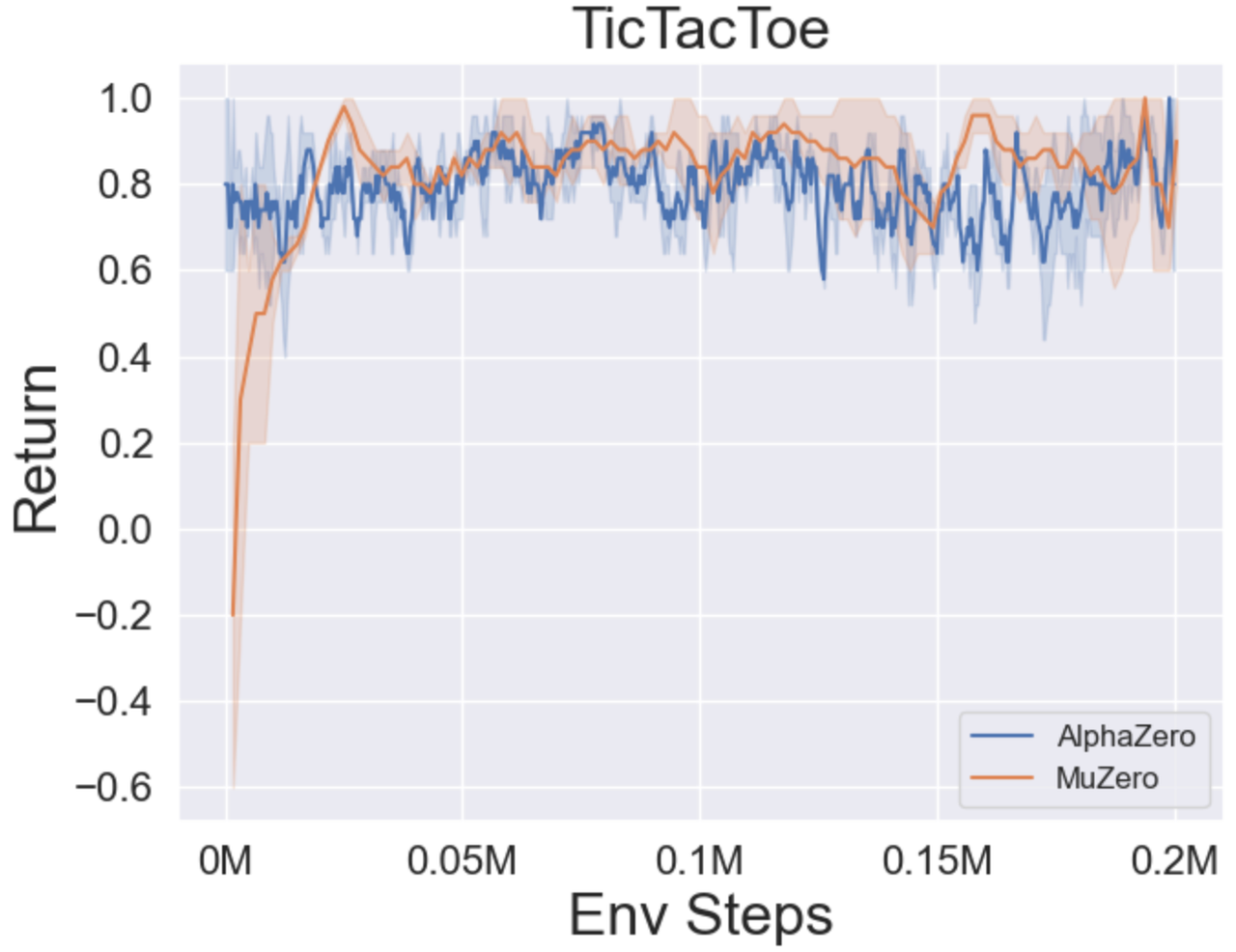

- Di bawah ini adalah hasil patokan Alphazero dan Muzero pada tiga permainan papan: Tictactoe, Connect4, Gomoku.

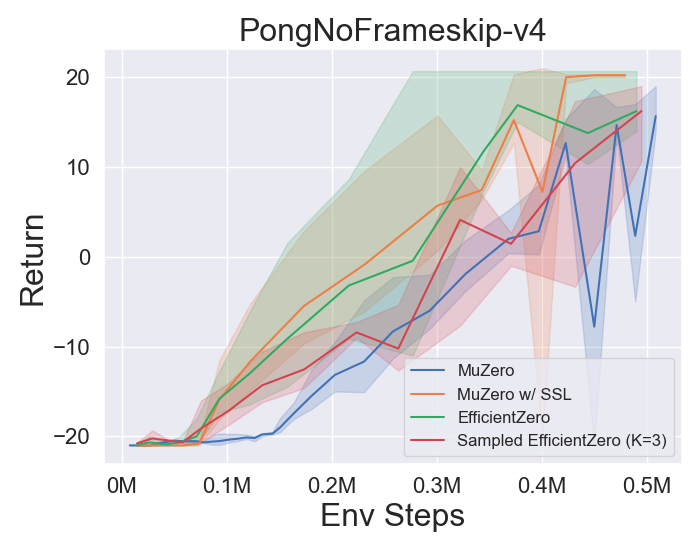

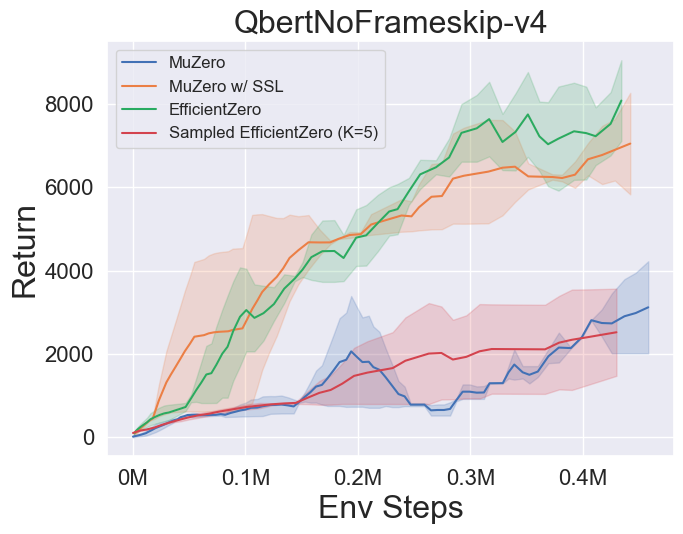

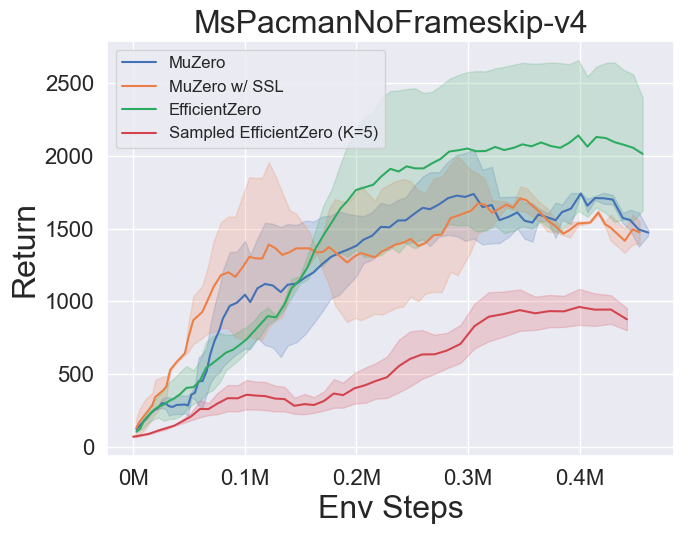

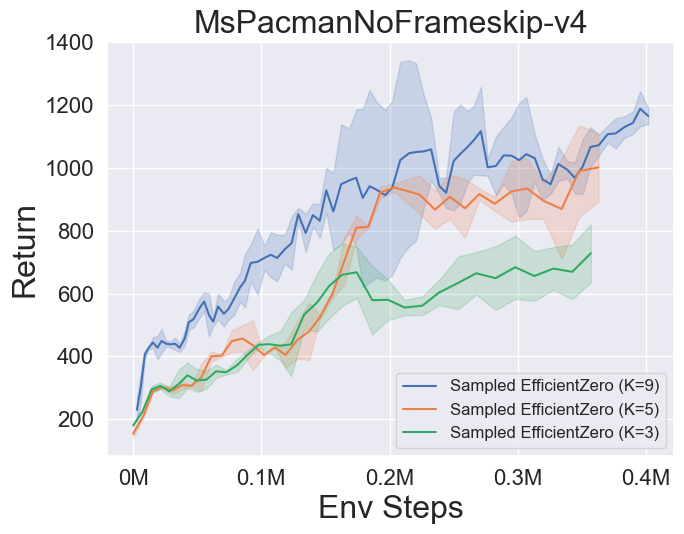

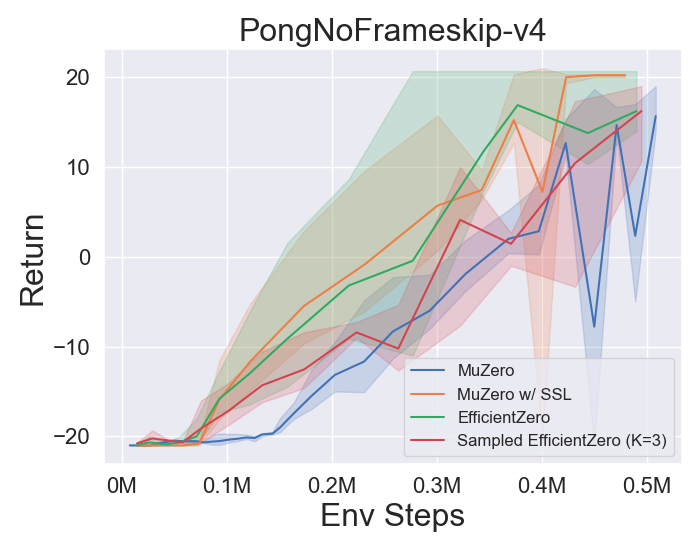

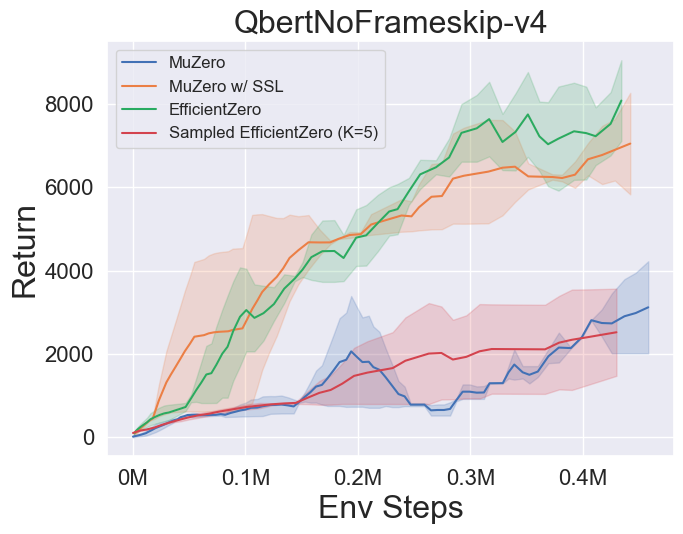

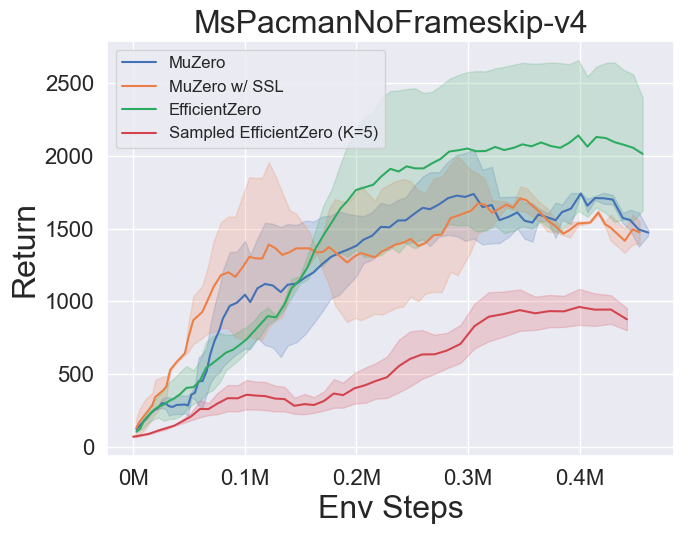

- Di bawah ini adalah hasil tolok ukur Muzero, Muzero W/ SSL, Efficientzero dan Sampled EfficientZero pada tiga game ruang aksi diskrit di Atari.

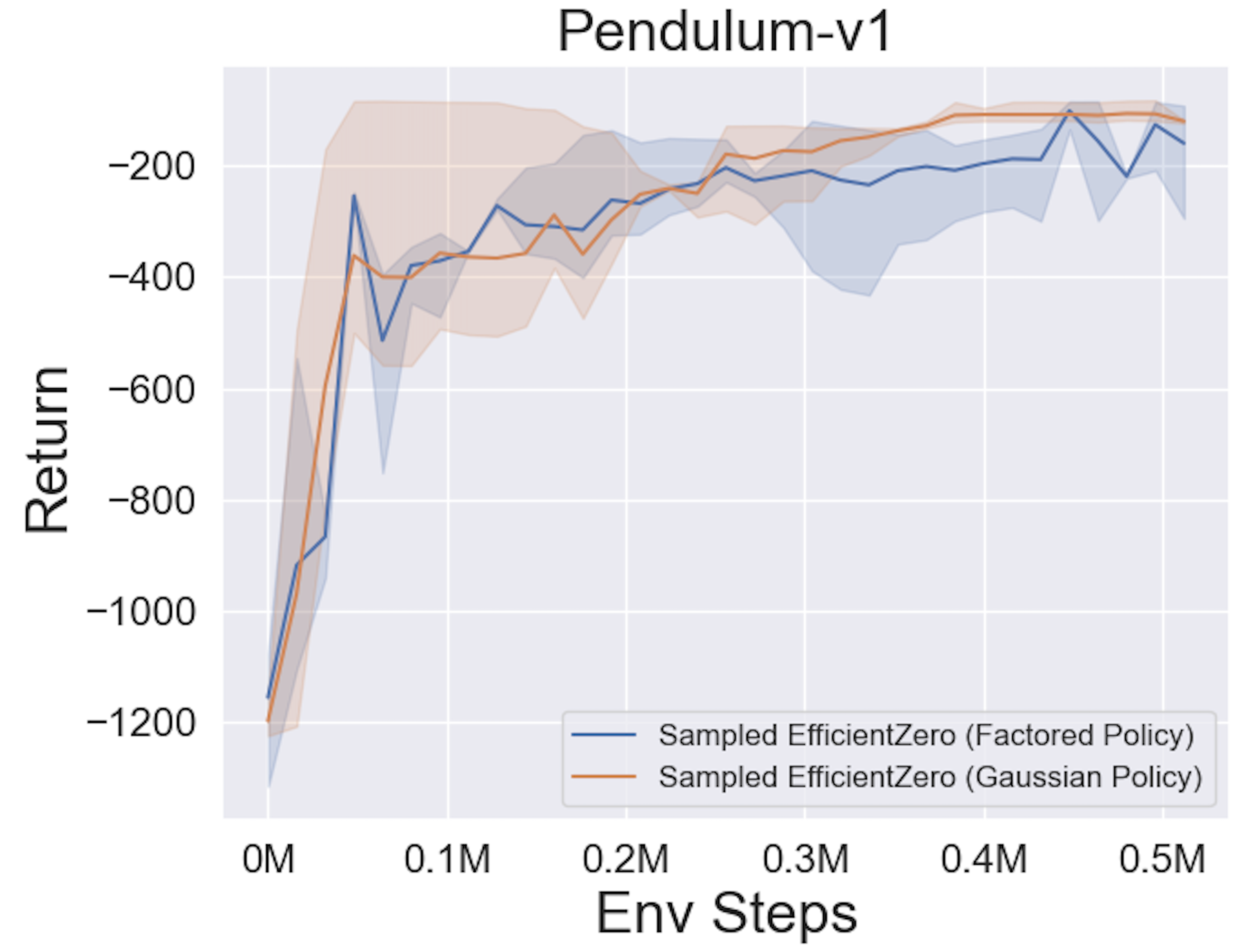

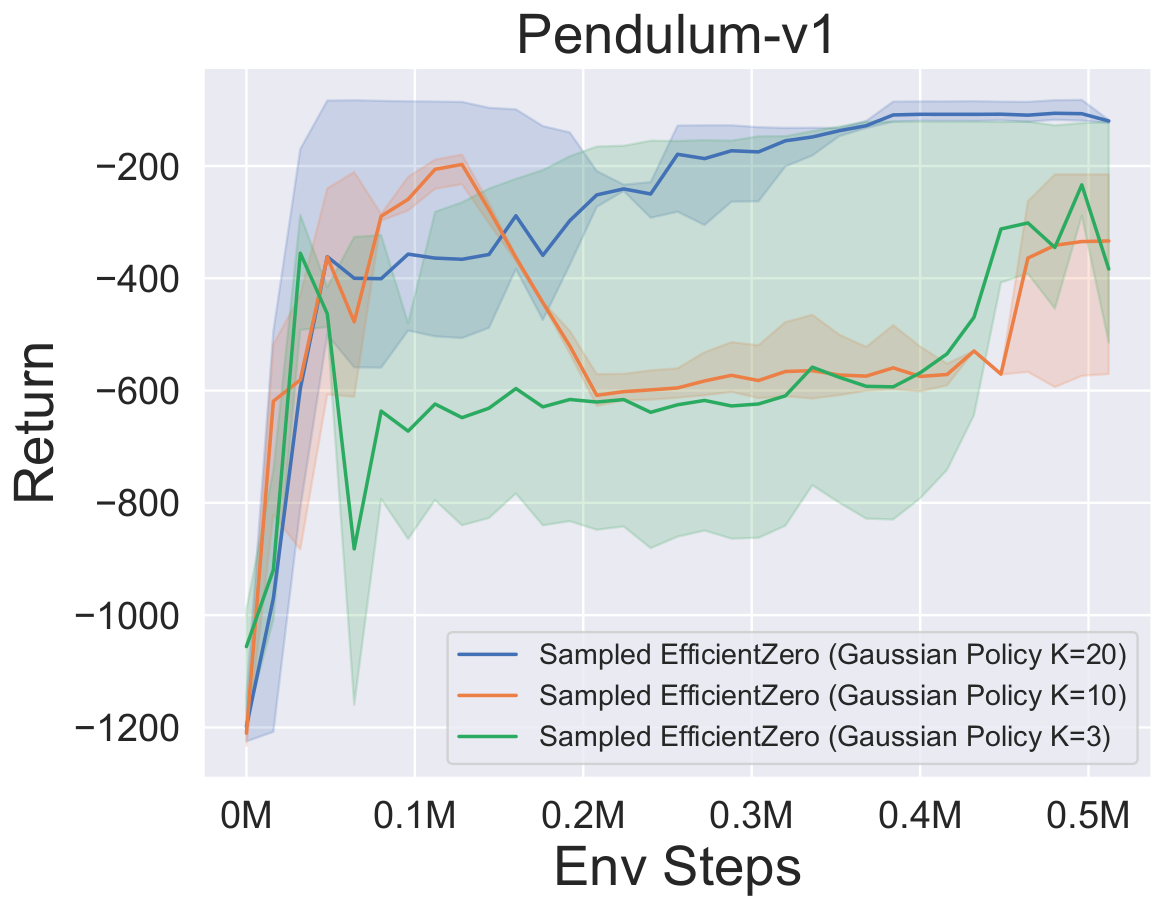

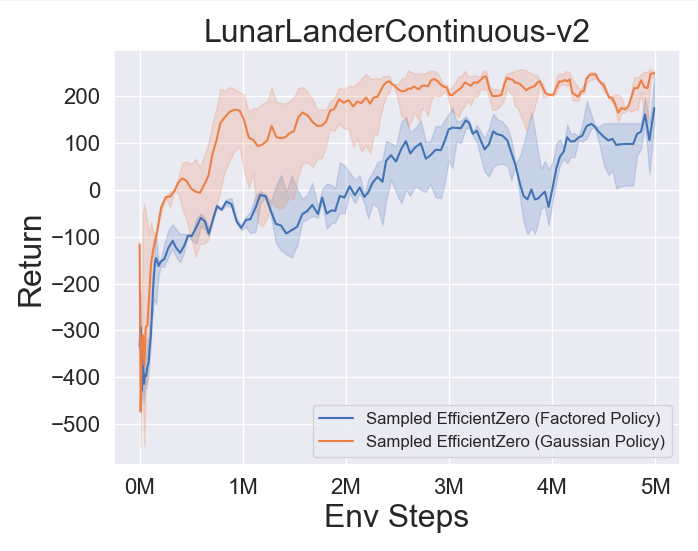

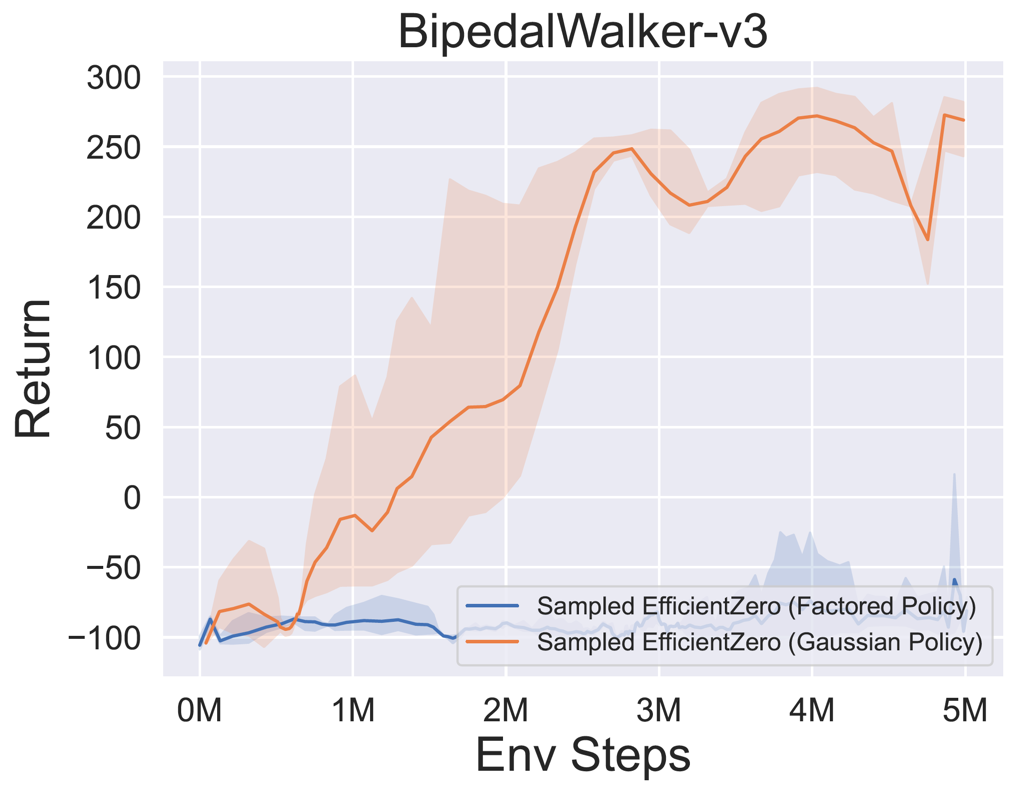

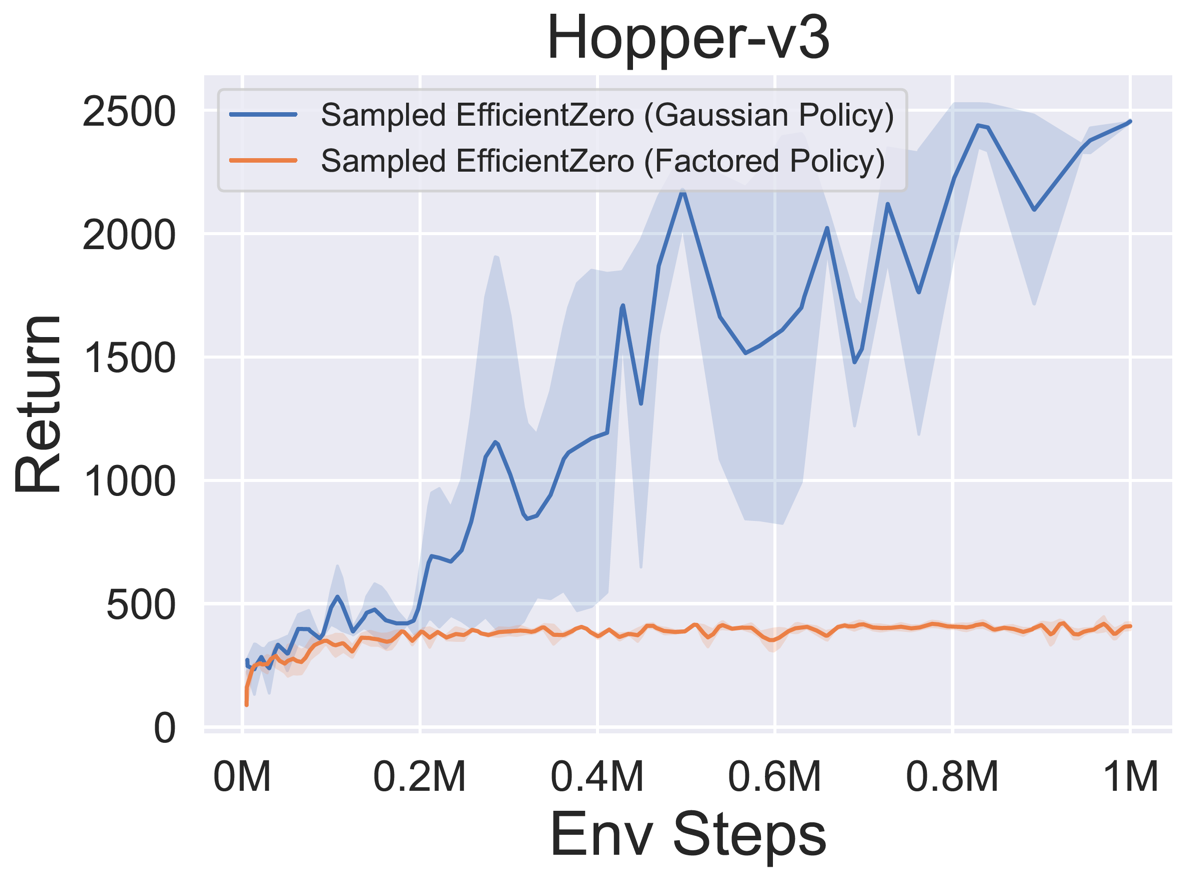

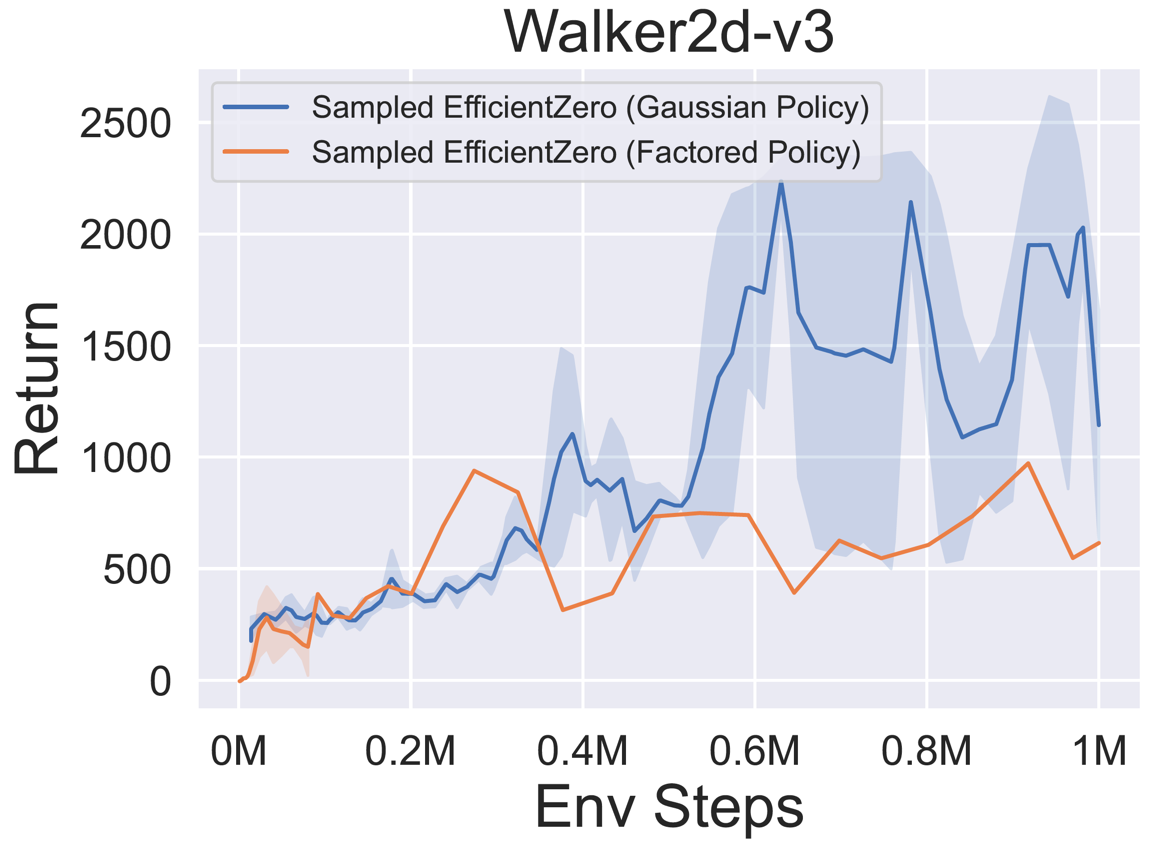

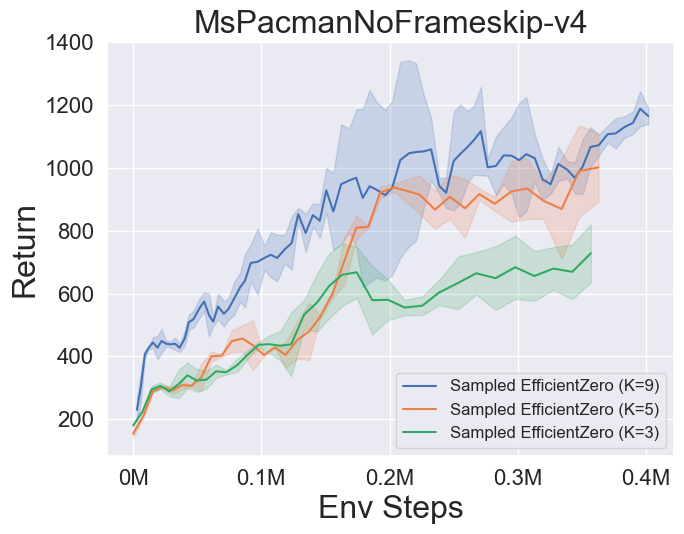

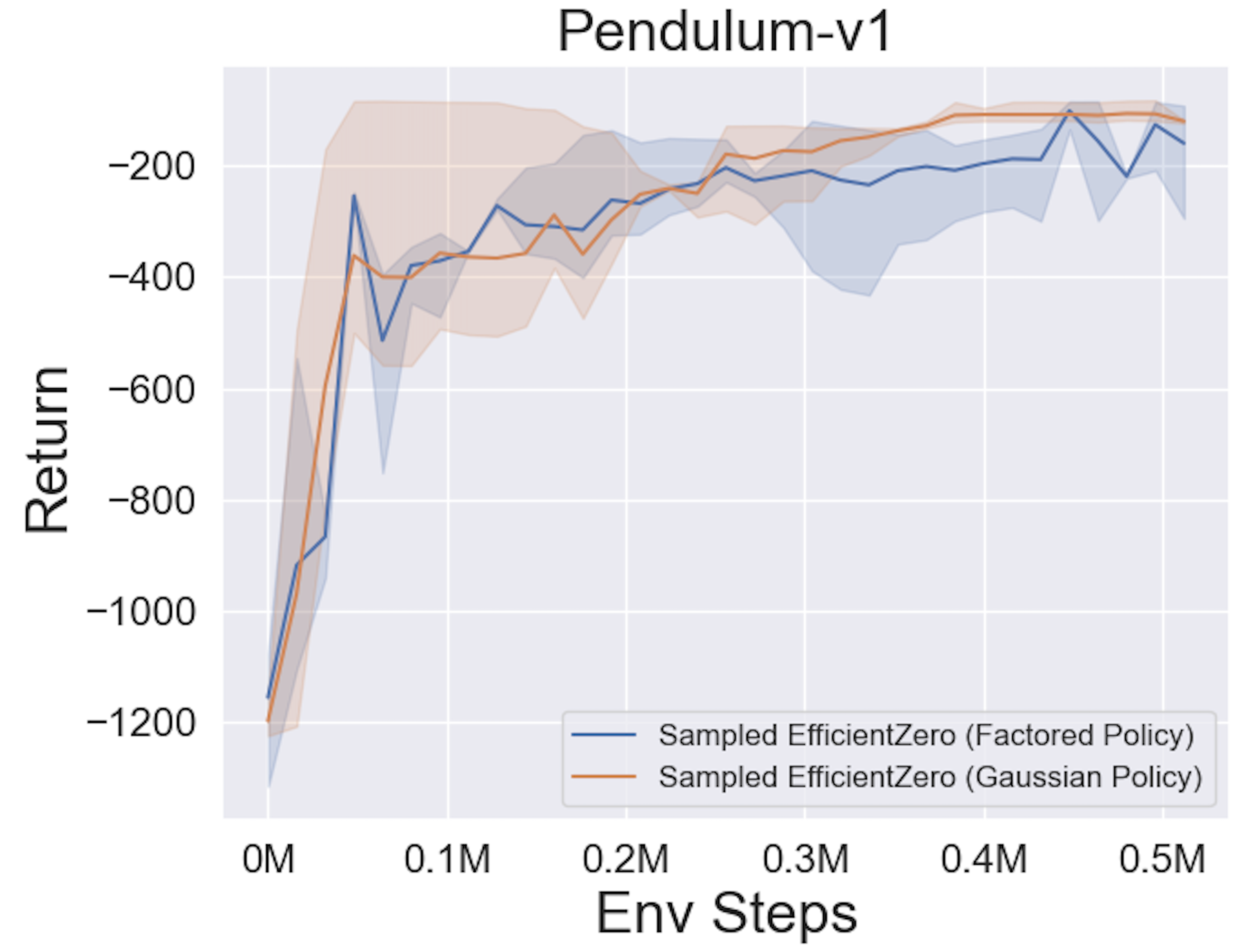

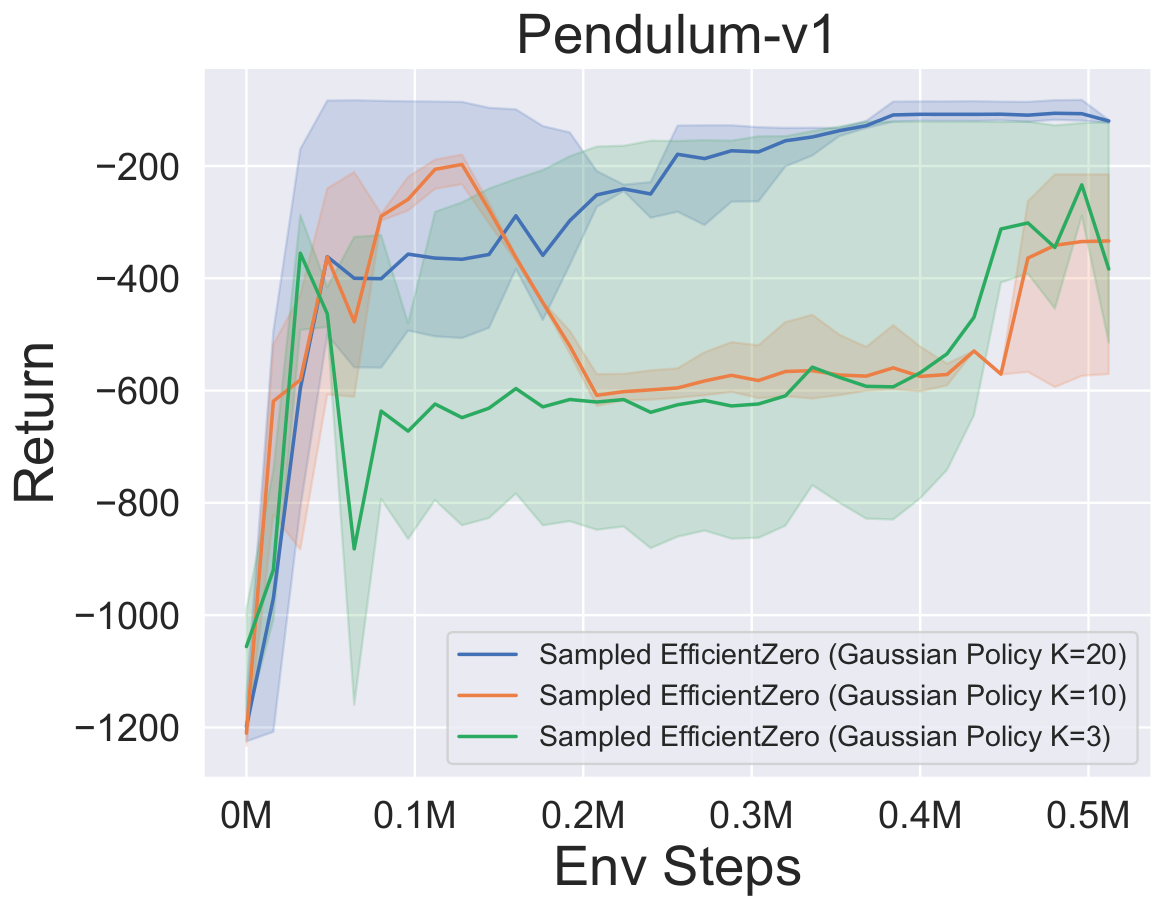

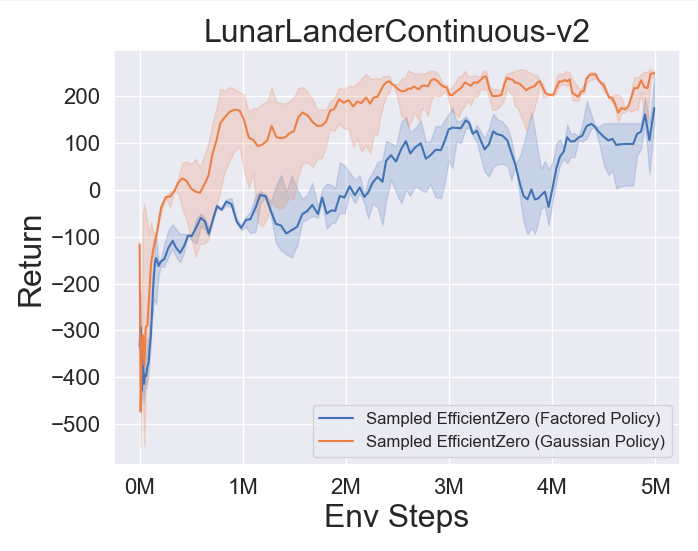

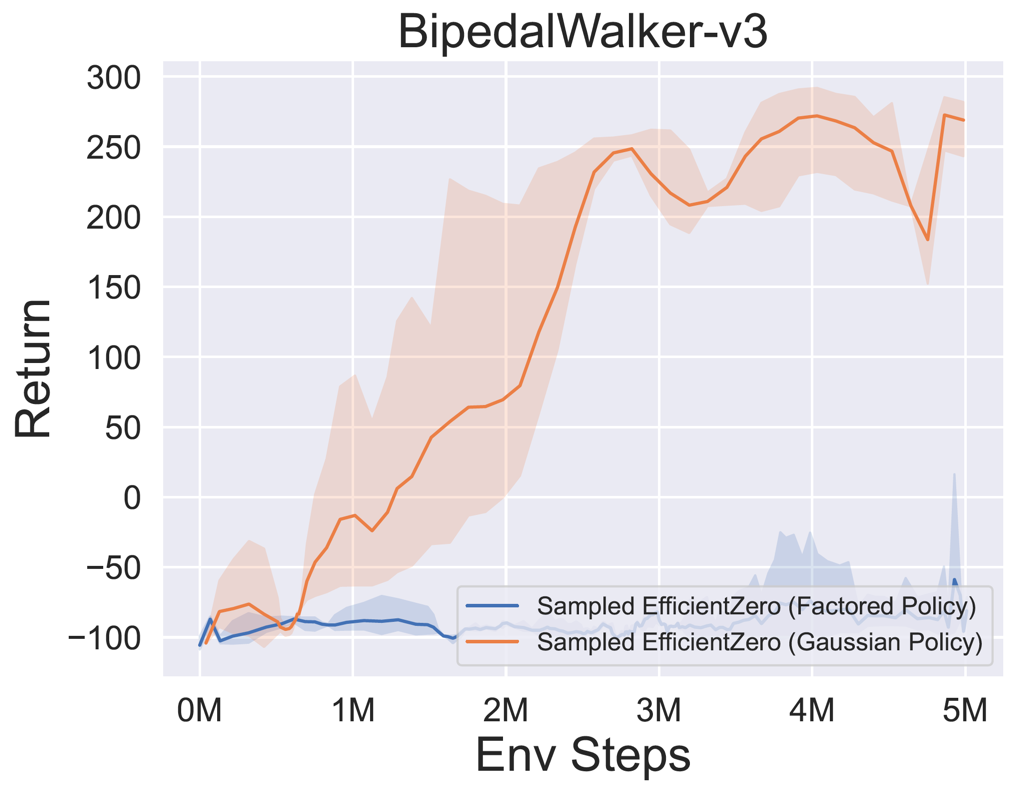

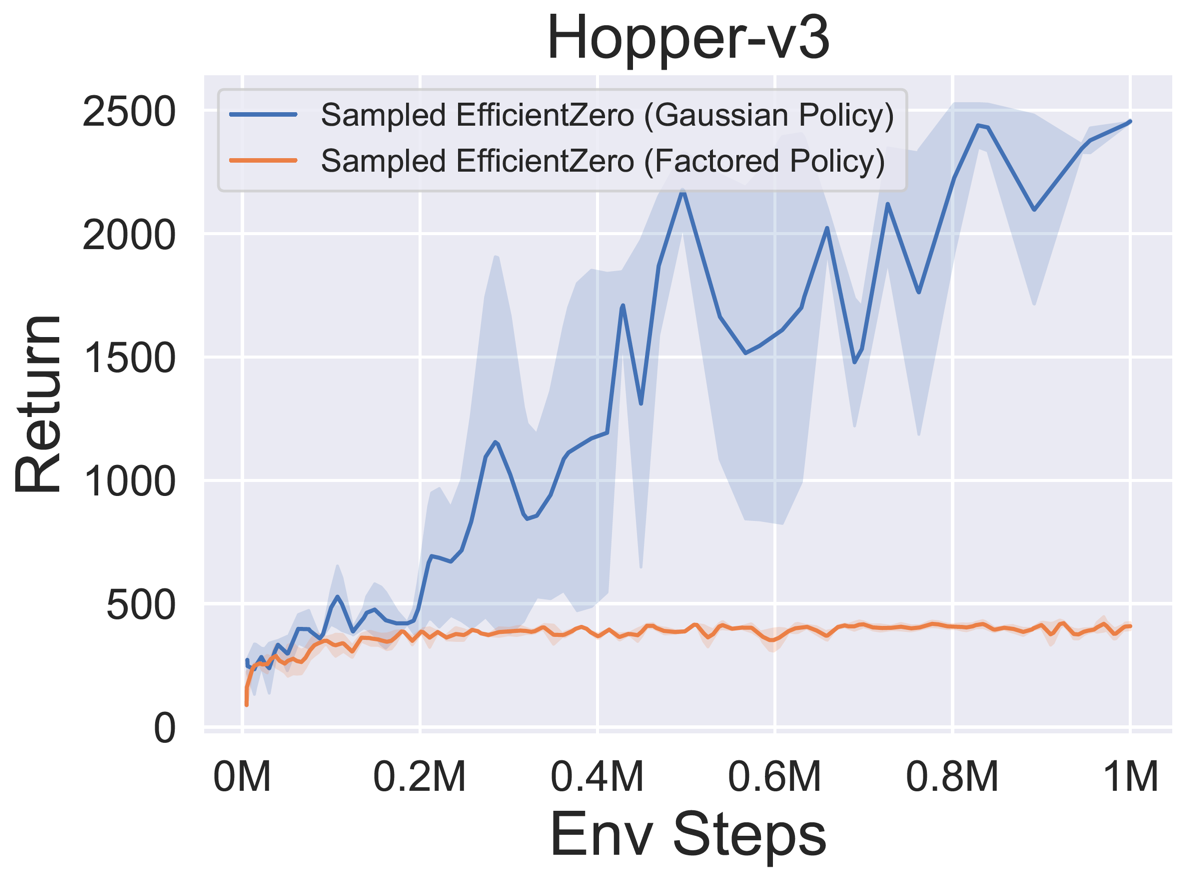

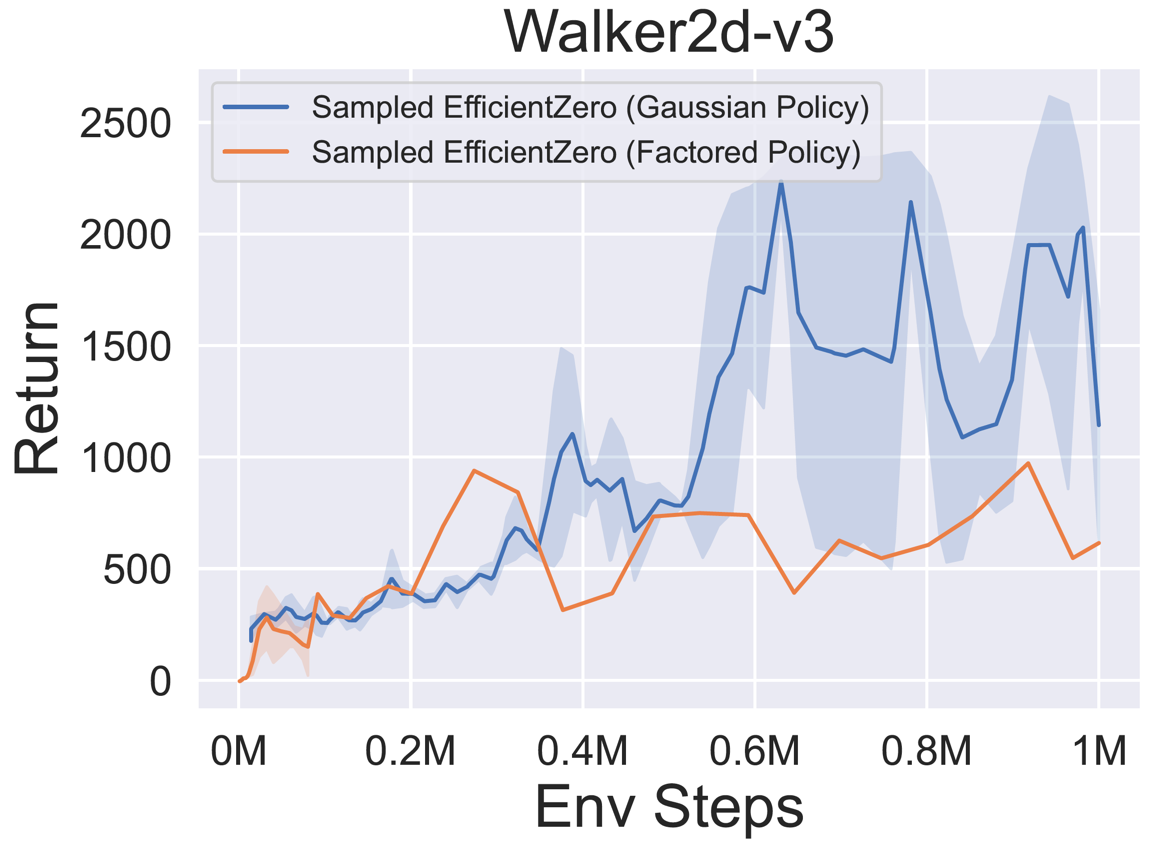

- Di bawah ini adalah hasil tolok ukur dari EfficientZero sampel dengan representasi kebijakan

Factored/Gaussian pada tiga permainan ruang aksi kontinu klasik: Pendulum-V1, LunarlanderContinuous-V2, Bipedalwalker-V3 dan dua Game Ruang Aksi Berkelanjutan Mujoco: Hopper-V3, Walker2D-V3.

"Kebijakan yang diperhitungkan" menunjukkan bahwa agen mempelajari jaringan kebijakan yang menghasilkan distribusi kategorikal. Setelah diskritisasi manual, dimensi ruang aksi untuk lima lingkungan adalah 11, 49 (7^2), 256 (4^4), 64 (4^3), dan 4096 (4^6), masing -masing. Di sisi lain, "Kebijakan Gaussian" mengacu pada agen yang mempelajari jaringan kebijakan yang secara langsung menghasilkan parameter (MU dan Sigma) untuk distribusi Gaussian.

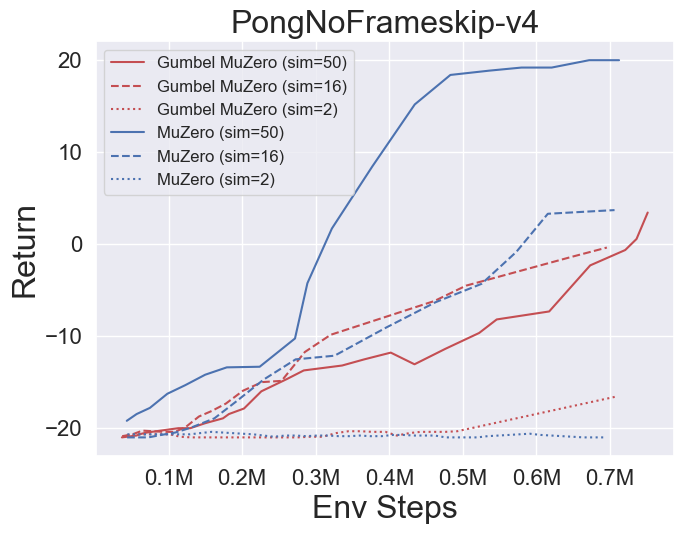

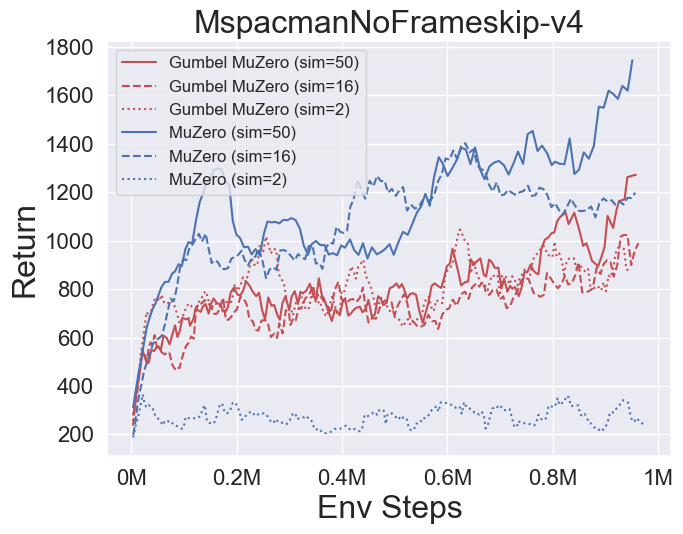

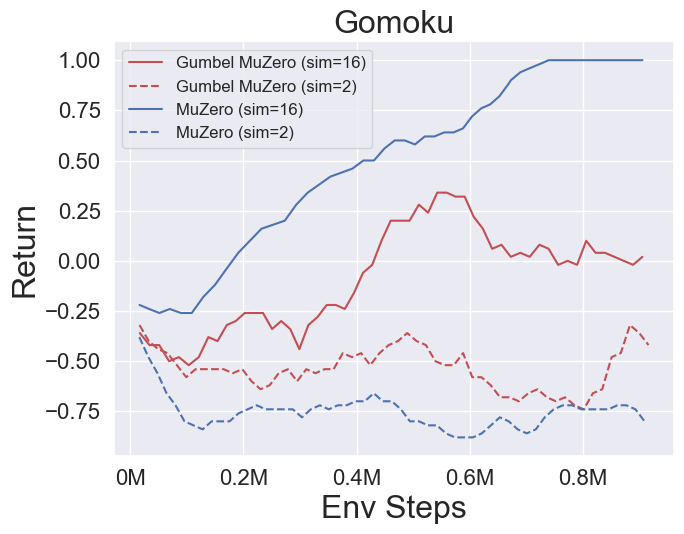

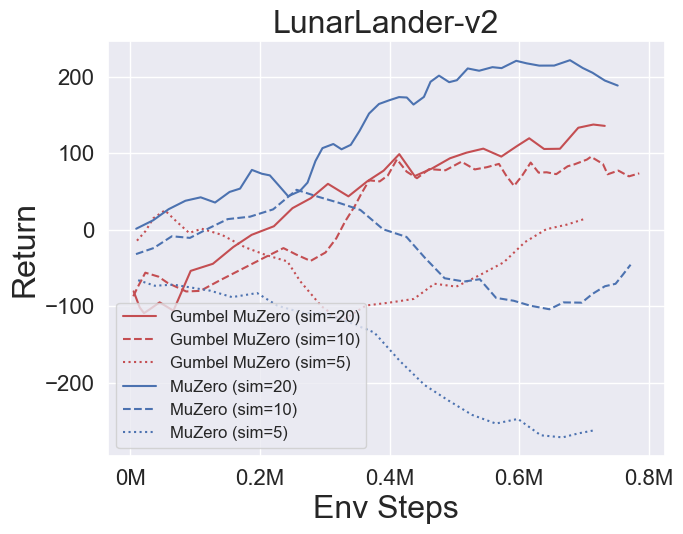

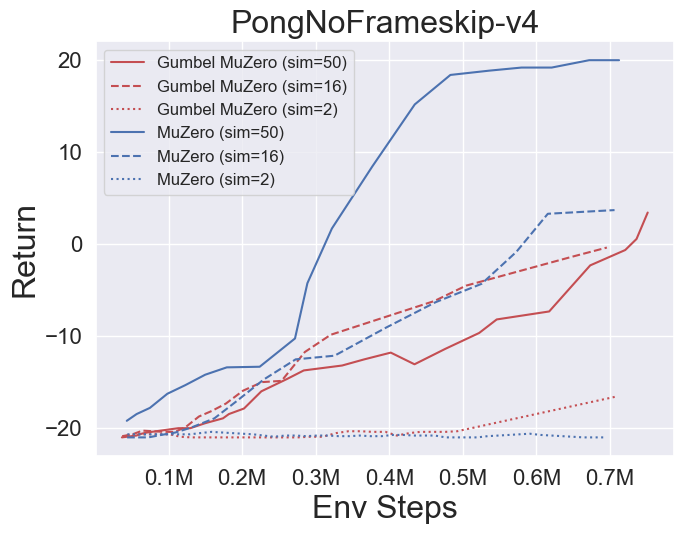

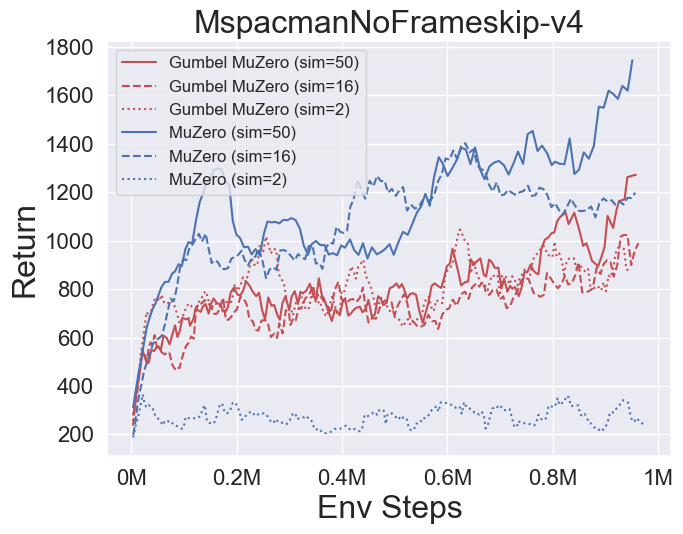

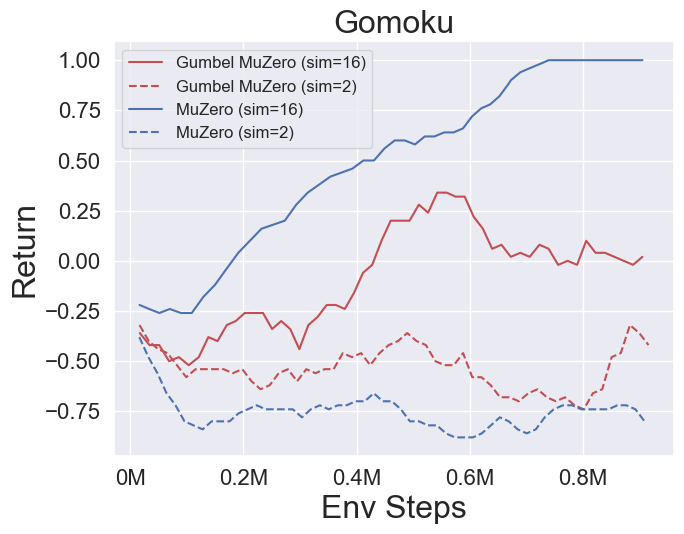

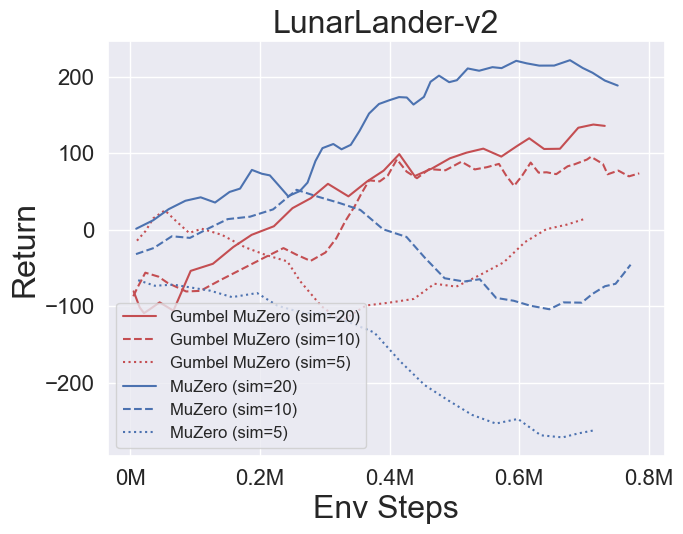

- Di bawah ini adalah hasil patokan Gumbelmuzero dan Muzero (di bawah biaya simulasi yang berbeda) pada empat lingkungan: Pongnoframeskip-V4, MSPACMANNOFRAMESKIP-V4, Gomoku, dan Lunarlandercontinuous-V2.

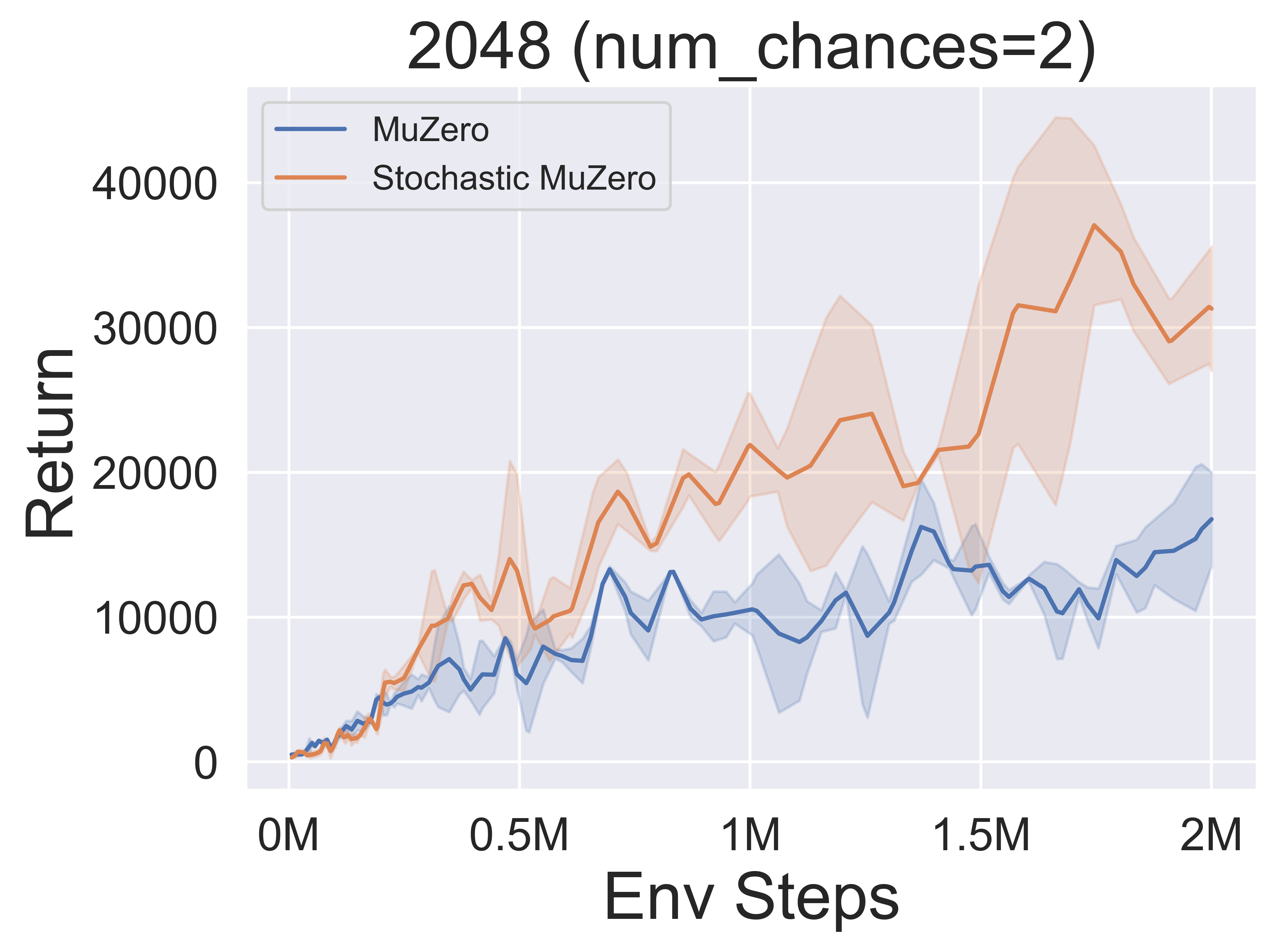

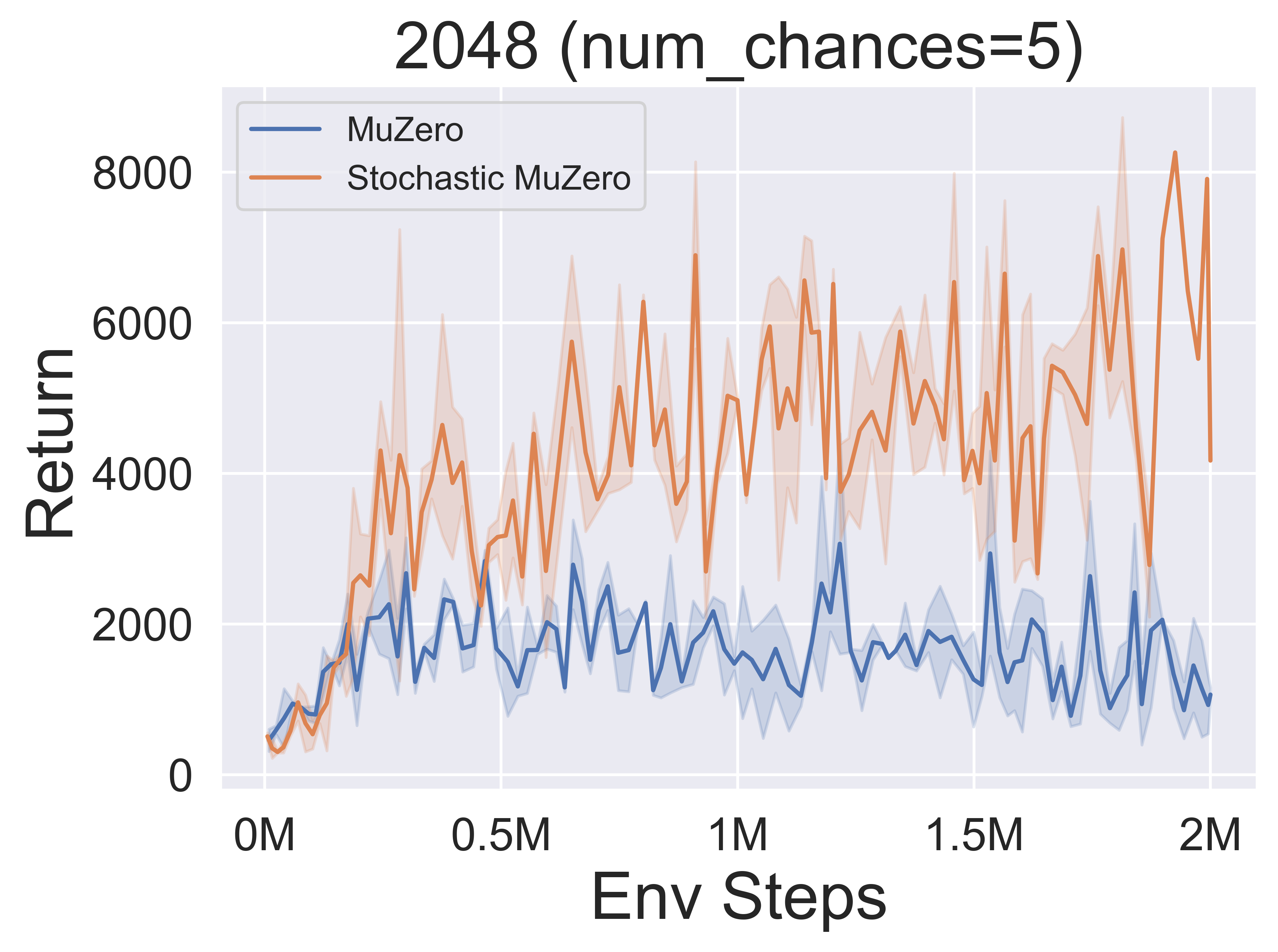

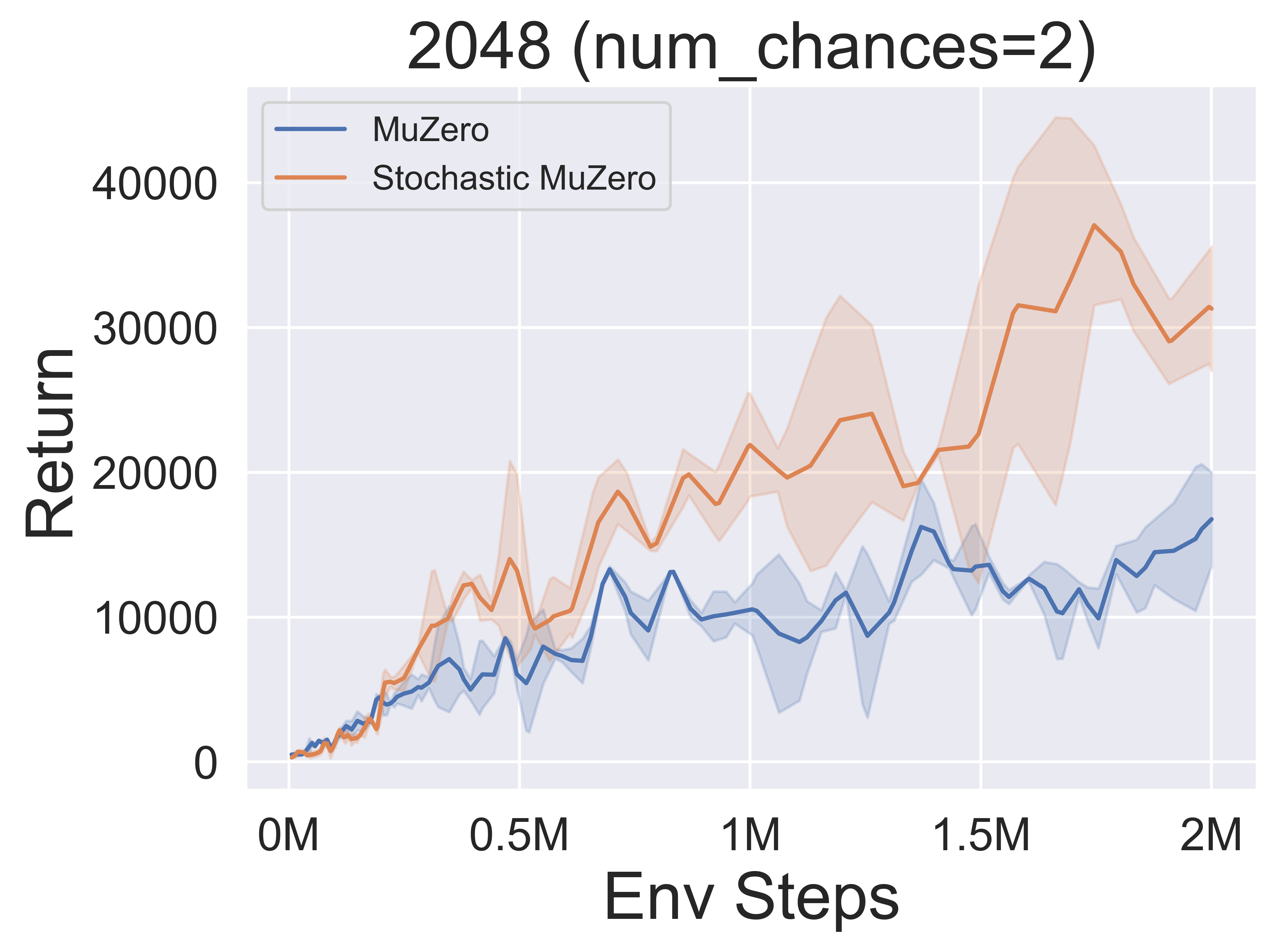

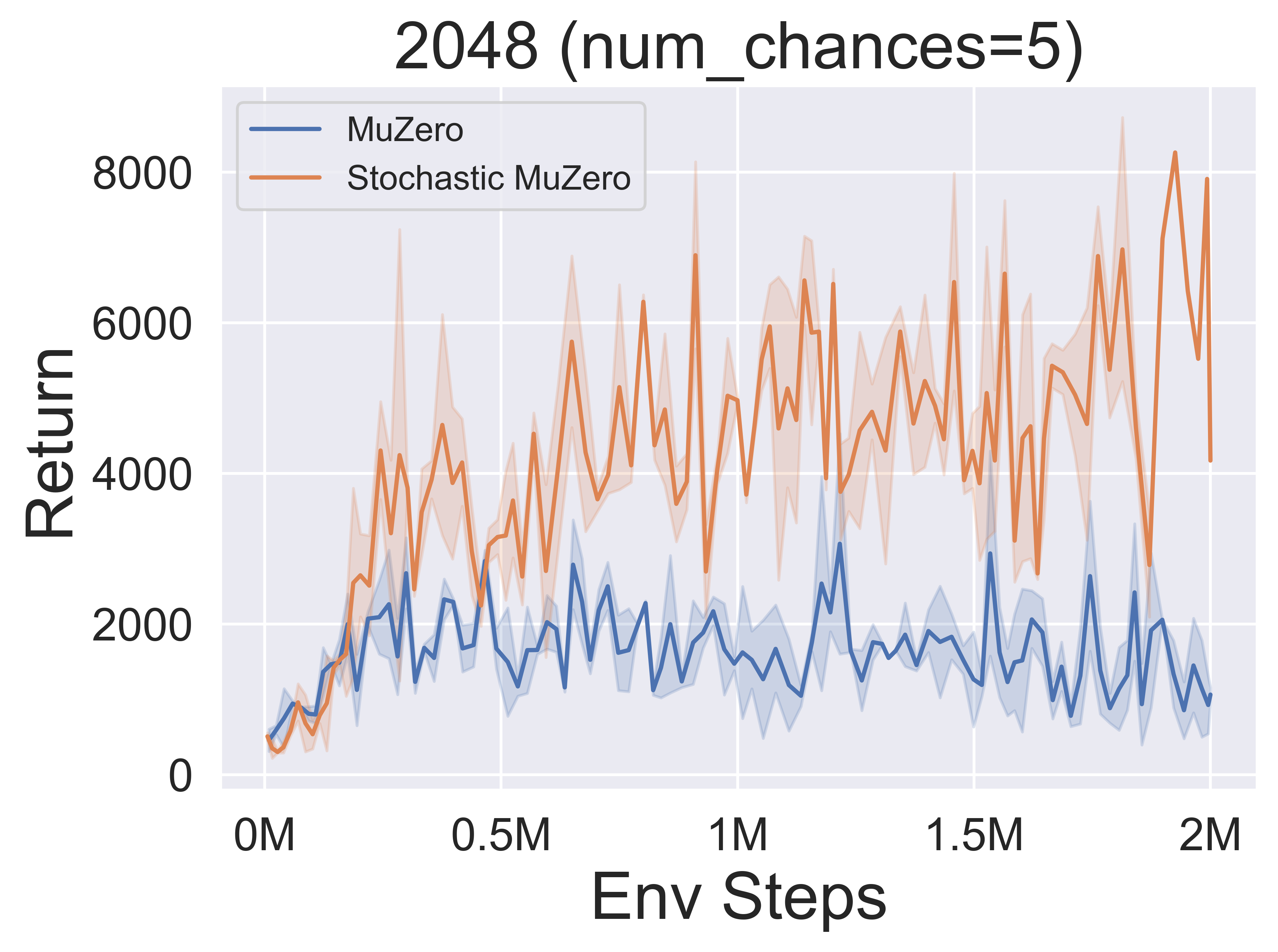

- Di bawah ini adalah hasil patokan StochasticMuzero dan Muzero pada lingkungan 2048 dengan berbagai tingkat peluang (num_chances = 2 dan 5).

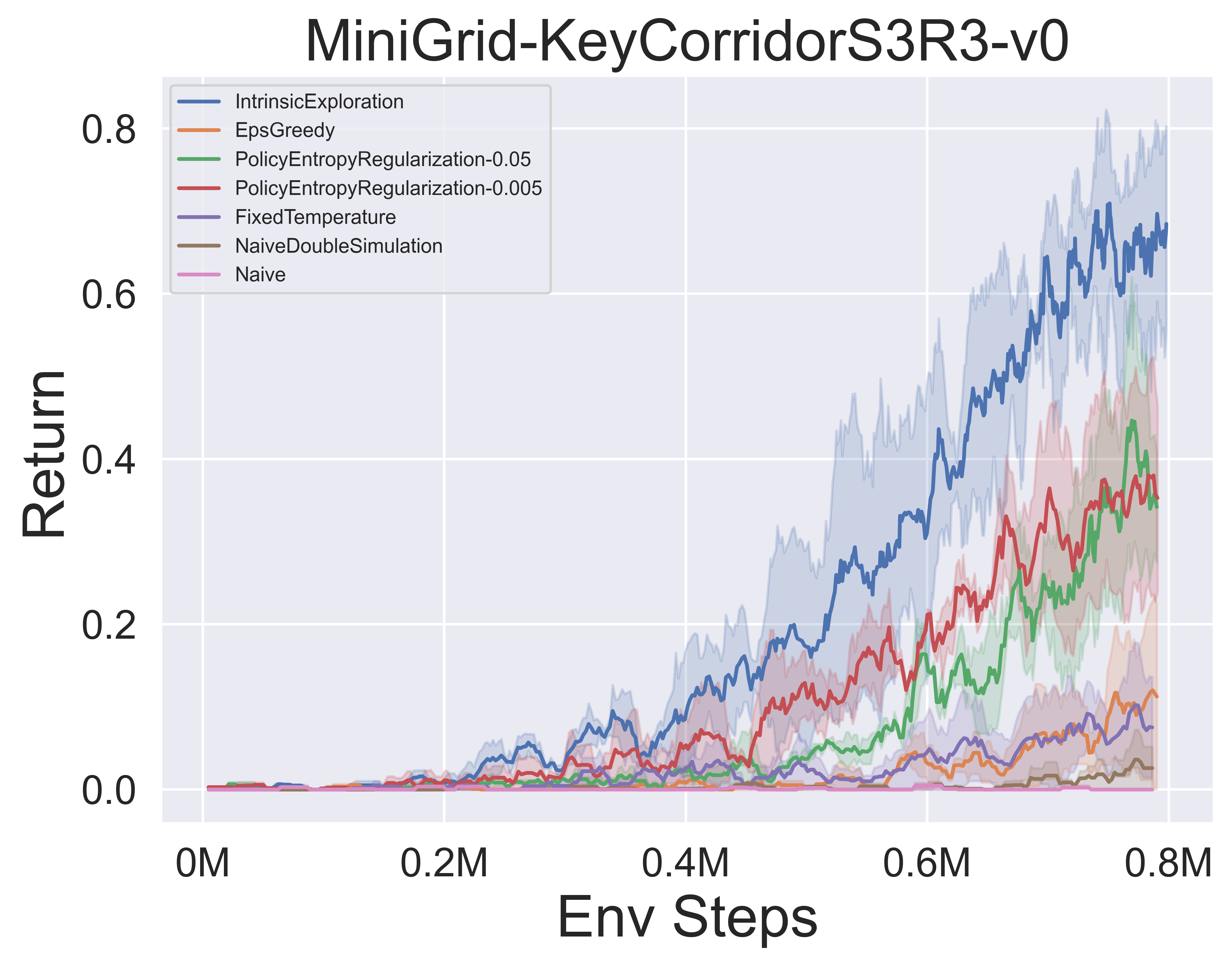

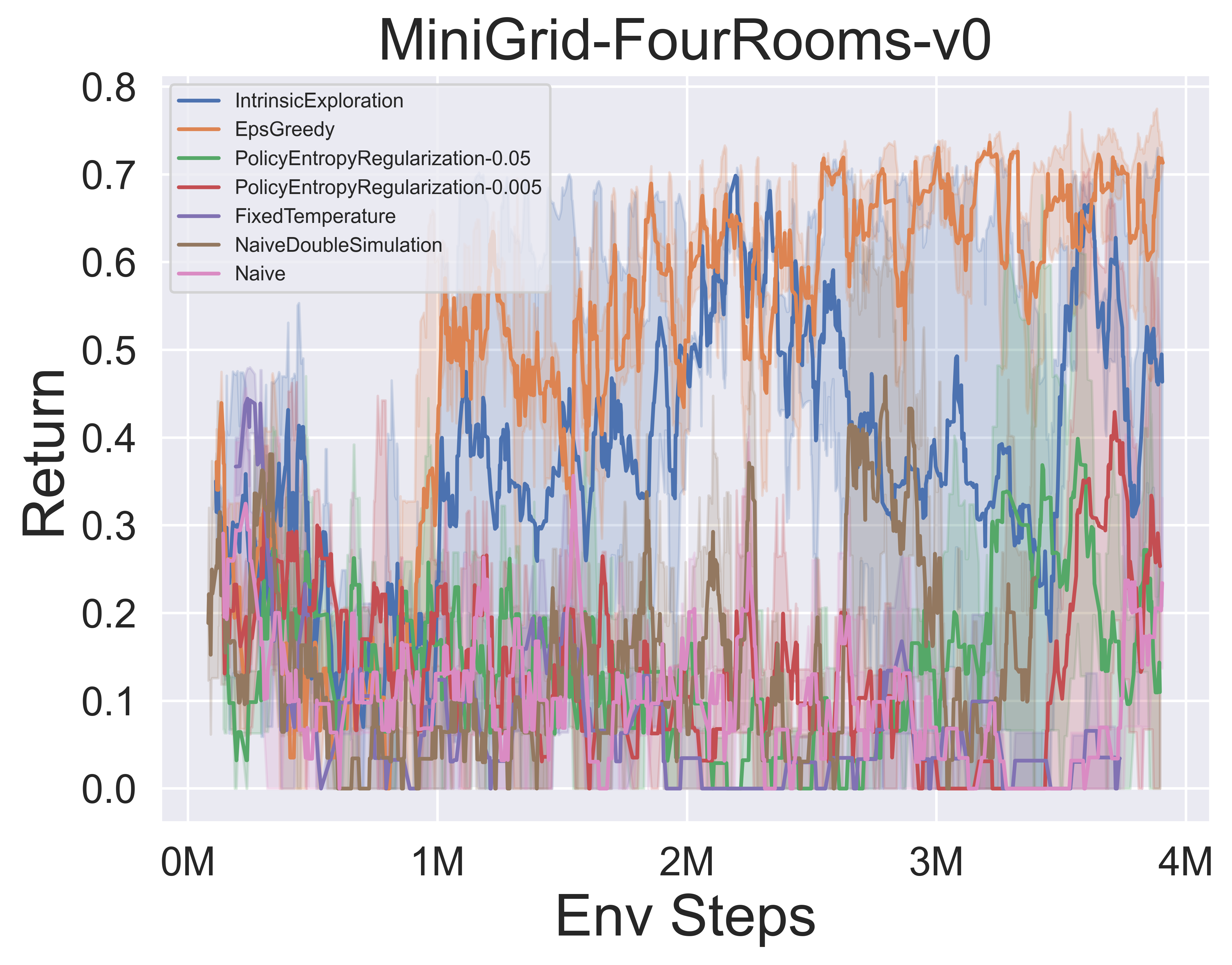

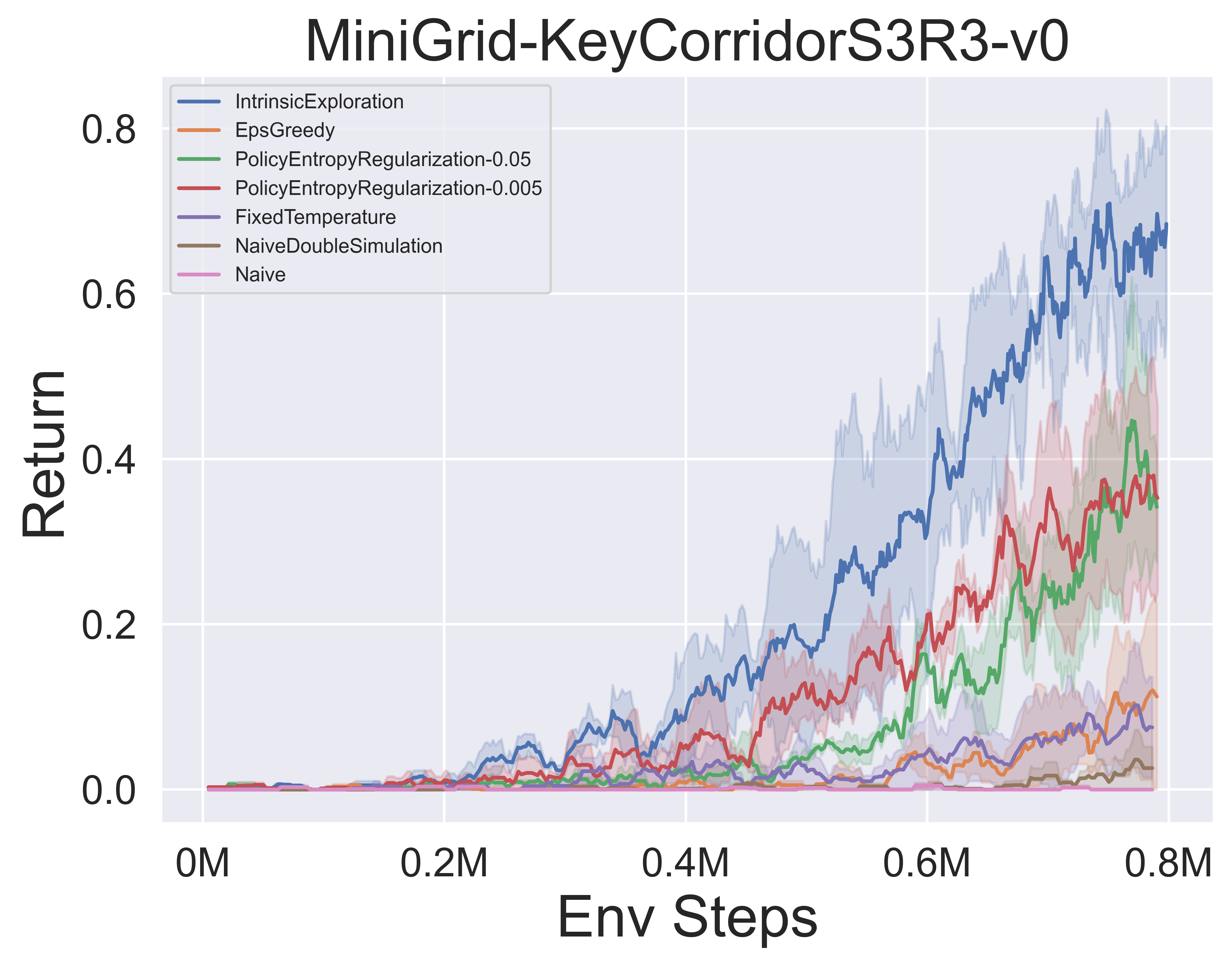

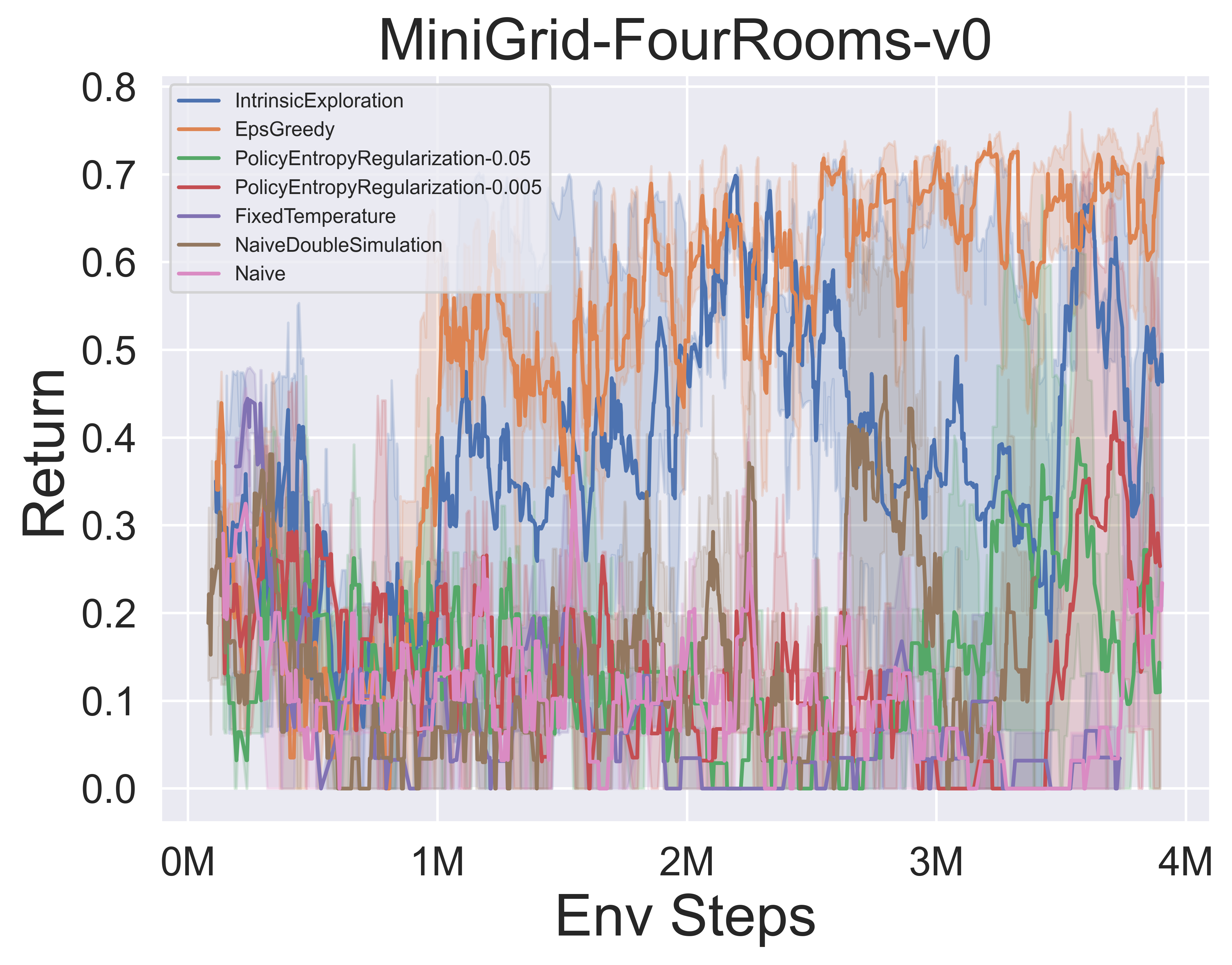

- Di bawah ini adalah hasil benchmark dari berbagai mekanisme eksplorasi MCTS Muzero W/ SSL di lingkungan minigrid.

Catatan Awesome-MCTS

Catatan kertas

Berikut ini adalah catatan kertas terperinci (dalam bahasa Cina) dari algoritma di atas:

Klik untuk runtuh

- Alphazero

- Muzero

- Efisiensizero

- SampledMuzero

- Gumbelmuzero

- StochasticMuzero

- Notationtable

Anda juga dapat merujuk ke kolom Zhihu yang relevan (dalam bahasa Cina): Analisis mendalam dari teori dan aplikasi perbatasan MCTS+RL.

Algo. Ringkasan

Berikut ini adalah ikhtisar diagram prinsip MCTS dari algoritma di atas:

Klik untuk memperluas

- MCTS

- Alphazero

- Muzero

- Efisiensizero

- SampledMuzero

- Gumbelmuzero

- StochasticMuzero

Kertas yang mengagumkan-MCTS

Berikut adalah kumpulan makalah penelitian tentang pencarian pohon Monte Carlo . Bagian ini akan terus diperbarui untuk melacak perbatasan MCTS.

Kertas kunci

Klik untuk memperluas

Seri Lightzero diimplementasikan

- 2018 Science Alphazero: Algoritma Pembelajaran Penguatan Umum That Masters Catur, Shogi, dan melalui bermain mandiri

- 2019 Muzero: Menguasai Atari, Go, Catur dan Shogi dengan merencanakan dengan model yang dipelajari

- 2021 Efficientzero: Menguasai game atari dengan data terbatas

- 2021 Sampled Muzero: Belajar dan Perencanaan di Ruang Aksi Kompleks

- 2022 Stochastic Muzero: Perencanaan di lingkungan stokastik dengan model yang dipelajari

- 2022 Gumbel Muzero: Peningkatan Kebijakan dengan Perencanaan dengan Gumbel

Seri Alphago

- Nature Alphago 2015 Menguasai permainan Go dengan jaringan saraf yang dalam dan pencarian pohon

- Nature Alphago Nol 2017 Menguasai permainan Go Tanpa Pengetahuan Manusia

- 2019 Elf OpenGo: Analisis dan Implementasi Terbuka Alphazero

- 2023 Mahasiswa Permainan: Algoritma Pembelajaran Terpadu untuk Game Informasi yang Sempurna dan Tidak Sempurna

Seri Muzero

- 2022 Pembelajaran Penguatan Online dan Offline dengan Merencanakan dengan Model yang Dipelajari

- 2021 model vektor kuantisasi untuk perencanaan

- 2021 Muesli: Menggabungkan peningkatan dalam optimasi kebijakan.

Analisis MCTS

- 2020 Monte-Carlo Tree Search Sebagai Optimalisasi Kebijakan Termasuk

- 2021 model dan nilai yang konsisten diri sendiri

- 2022 Kebijakan permusuhan mengalahkan AIS tingkat profesional

- 2022 Akuisisi PNAS Pengetahuan Catur di Alphazero.

Aplikasi MCTS

- 2023 Pelajar Fisika Simbolik: Menemukan Persamaan yang Mengatur melalui Pencarian Pohon Monte Carlo

- 2022 Nature Menemukan Algoritma Multiplikasi Matriks yang Lebih Cepat dengan Pembelajaran Penguatan

- 2022 Muzero dengan kompetisi diri untuk kontrol laju dalam kompresi video VP9

- 2021 Douzero: Menguasai Doudizhu dengan mandiri belajar penguatan yang mendalam

- 2019 menggabungkan perencanaan dan pembelajaran penguatan mendalam dalam pengambilan keputusan taktis untuk mengemudi otonom

Kertas lain

Klik untuk memperluas

ICML

- Peningkatan Kebijakan Aman yang Dapat Diukur melalui Pencarian Pohon Monte Carlo 2023

- Alberto Castellini, Federico Bianchi, Edoardo Zorzi, Thiago D. Simão, Alessandro Farinelli, Matthijs TJ SPaan

- Kunci: Peningkatan Kebijakan Aman Online Menggunakan Strategi Berbasis MCTS, Peningkatan Kebijakan yang Aman dengan Bootstrap Baseline

- Expenv: GridWorld dan Sysadmin

- Pembelajaran yang efisien untuk Alphazero melalui konsistensi jalur 2022

- Dengwei Zhao, Shikui Tu, Lei Xu

- Kunci: jumlah yang terbatas dari permainan mandiri, konsistensi jalur (PC) optimalitas

- Expenv: Go, Othello, Gomoku

- Memvisualisasikan model muzero 2021

- Joery A. De Vries, Ken S. Voskuil, Thomas M. Moerland, Aske Plaat

- Kunci: Memvisualisasikan model dinamika setara nilai, lintasan aksi berbeda, dua teknik regularisasi

- Expenv: Cartpole dan Mountaincar.

- Cembung Cembung di Monte-Carlo Tree Search 2021

- Tuan Dam, Carlo D'Eramo, Jan Peters, Joni Pajarinen

- Kunci: Operator cadangan pengatur-entropi, analisis penyesalan, etropi tsallis,

- Expenv: pohon sintetis, atari

- Informasi Pohon Filter Partikel: Algoritma Online untuk PomDP dengan Hadiah Berbasis Keyakinan pada Domain Berkelanjutan 2020

- Johannes Fischer, Ömer Sahin Tas

- Kunci: POMDP kontinu, pohon filter partikel, pembentukan hadiah berbasis informasi, pengumpulan informasi.

- Expenv: Pomdps.jl Framework

- Kode

- Retro*: Belajar Perencanaan Retrosintetik Dengan Saraf Tangan A* Pencarian 2020

- Binghong Chen, Chengtao LI, Hanjun Dai, Le Song

- Kunci: Perencanaan retrosintetik kimia, algoritma seperti A*berbasis saraf, Andor Tree

- EXPENV: Dataset USPTO

- Kode

Iclr

- Kerangka Kesetaraan Pembaruan untuk Perencanaan Keputusan 2024

- Samuel Sokota, Gabriele Farina, David J Wu, Hengyuan Hu, Kevin A. Wang, J Zico Kolter, Noam Brown

- Kunci: Permainan Informasi yang Tidak Sfect, Pencarian, Perencanaan Waktu Keputusan, Kesetaraan Pembaruan

- Expenv: Hanabi, 3x3 tiba-tiba hex dan phantom tic-tac-toe

- Pembelajaran Penguatan Multi-Agen yang Efisien dengan Perencanaan 2024

- Qihan Liu, Jianing Ye, Xiaoteng MA, Jun Yang, Bin Liang, Chongjie Zhang

- Kunci: Pembelajaran Penguatan Multi-Agen, Perencanaan, MCTS Multi-Agen

- Expenv: SMAC, Lunarlander, Mujoco, dan Google Research Football

- Menjadi pemain yang mahir dengan data terbatas melalui menonton video murni 2023

- Weirui Ye, Yunsheng Zhang, Pieter Abbeel, Yang Gao

- KUNCI: Pra-pelatihan dari video bebas aksi, konsistensi siklus maju (FICC) objektif berdasarkan kuantisasi vektor, fase pra-pelatihan, fase penyempurnaan.

- Expenv: Atari

- Kompetisi diri berbasis kebijakan untuk masalah perencanaan 2023

- Jonathan Pirnay, Quirin Göttl, Jakob Burger, Dominik Gerhard Grimm

- Kunci: Kompetisi diri, temukan lintasan yang kuat dengan perencanaan terhadap strategi yang mungkin dari diri masa lalunya.

- ExpenV: Masalah wisatawan bepergian dan masalah penjadwalan toko pekerjaan.

- Menjelaskan model grafik temporal melalui kerangka kerja Explorer-Navigator 2023

- Wenwen Xia, Minsai Lai, Caihua Shan, Yao Zhang, Xinnan Dai, Xiang Li, Dongsheng LI

- Kunci: Penjelajah GNN temporal, seorang penjelajah untuk menemukan subset acara dengan MCTS, navigator yang mempelajari korelasi antara peristiwa dan membantu mengurangi ruang pencarian.

- Expenv: Wikipedia dan Reddit, set data sintetis

- Speedyzero: Menguasai Atari dengan Data dan Waktu Terbatas 2023

- Yixuan Mei, Jiaxuan Gao, Weirui Ye, Shaohuai Liu, Yang Gao, Yi Wu

- Kunci: Sistem RL terdistribusi, penyegaran prioritas, terpotong Lars

- Expenv: Atari

- Optimalisasi Kebijakan Offline yang Efisien Dengan Model 2023 yang Dipelajari

- Zichen Liu, Siyi Li, Wee Sun Lee, Shuicheng Yan, Zhongwen Xu

- Kunci: Algoritma berbasis model satu langkah yang diatur untuk Offline-RL

- Expenv: Atari , Bsuite

- Kode

- Mengaktifkan tujuan terjemahan sewenang -wenang dengan pencarian pohon adaptif 2022

- Wang Ling, Wojciech Stokowiec, Domenic Donato, Chris Dyer, Lei Yu, Laurent Sartran, Austin Matthews

- Kunci: Pencarian Pohon Adaptif, Model Terjemahan, Model Autoregressive,

- Expenv: Tugas Cina -Inggris dan Pashto -Inggris dari WMT2020, Jerman -Inggris dari WMT2014

- Apa yang salah dengan pembelajaran mendalam dalam pencarian pohon untuk optimasi kombinatorial 2022

- Maximili1an Böther, Otto Kißig, Martin Taraz, Sarel Cohen, Karen Seidel, Tobias Friedrich

- Kunci: Optimalisasi kombinatorial, rangkaian tolok ukur sumber terbuka untuk masalah set independen maksimum NP-hard, analisis mendalam dari algoritma pencarian pohon berpemandu yang populer, bandingkan implementasi pencarian pohon dengan pemecah lainnya

- Expenv: NP-Hard Maksimum Set Independen.

- Kode

- Perencanaan dan Pembelajaran Monte-Carlo dengan Estimasi Nilai Tindakan Bahasa 2021

- Youngsoo Jang, Seokin Seo, Jongmin Lee, Kee-Eung Kim

- Kunci: Pencarian pohon Monte-Carlo dengan eksplorasi berbasis bahasa, estimasi nilai bahasa optimis lokal.

- Expenv: Game Fiksi Interaktif (IF)

- Pencarian pohon monte-carlo paralel yang praktis secara paralel diterapkan pada desain molekuler 2021

- Xiufeng Yang, Tanuj Kr Aasawat, Kazuki Yoshizoe

- Kunci: Pencarian pohon Monte-Carlo yang paralel secara masif, desain molekuler, pencarian paralel yang digerakkan hash,

- EXPENV: Koefisien partisi octanol-water (logp) yang dihukum oleh aksesibilitas sintetis (SA) dan skor penalti cincin besar.

- Tonton The Unegnserved: Pendekatan Sederhana untuk Paralelisasi Pencarian Pohon Monte Carlo 2020

- Anji Liu, Jianshu Chen, Mingze Yu, Yu Zhai, Xuewen Zhou, Ji Liu

- Kunci: Pencarian pohon Monte-Carlo paralel, partisi pohon menjadi sub-pohon secara efisien, bandingkan rasio pengamatan masing-masing prosesor.

- Expenv: Perbandingan Speedup dan Kinerja pada Game Joy-City, Rata-rata Episode Pengembalian pada Game Atari

- Kode

- Belajar merencanakan dalam dimensi tinggi melalui pohon eksplorasi saraf 2020

- Binghong Chen, Bo Dai, Qinjie Lin, Guo Ye, Han Liu, Le Song

- Kunci: Algoritma perencanaan meta jalur, mengeksploitasi arsitektur saraf baru yang dapat mempelajari arahan pencarian yang menjanjikan dari struktur masalah.

- Expenv: ruang kerja 2D dengan robot titik 2 dof (derajat kebebasan), robot 3 dof stick dan robot ular 5 dof

Neurips

- Lightzero: Benchmark terpadu untuk pencarian pohon Monte Carlo secara umum skenario keputusan berurutan 2023

- Yazhe niu, pu yuan, zhenjie yang, xueyan li, tong zhou, jiyuan ren, shuai hu, hongsheng li, yu liu

- Kunci: Benchmark terpadu pertama untuk menggunakan MCTS/Muzero dalam skenario keputusan berurutan umum.

- Expenv: ClassicControl, Box2D, Atari, Mujoco, Gobigger, Minigrid, Tictactoe, ConnectFour, Gomoku, 2048, dll.

- Model Bahasa Besar Sebagai Pengetahuan Advonsense Untuk Perencanaan Tugas Skala Besar 2023

- Zirui Zhao, Wee Sun Lee, David Hsu

- Kunci: Model Dunia (LLM) dan kebijakan yang diinduksi LLM dapat digabungkan dalam MCTS, untuk meningkatkan perencanaan tugas.

- Expenv: Perkalian, Perencanaan Perjalanan, Penataan Penataan Objek

- Pencarian Pohon Monte Carlo dengan Boltzmann Exploration 2023

- Michael Painter, Mohamed Baioumy, Nick Hawes, Bruno Lacerda

- Kunci: Eksplorasi Boltzmann dengan MCT, tindakan optimal untuk tujuan entropi maksimum tidak selalu sesuai dengan tindakan optimal untuk tujuan asli, dua algoritma yang ditingkatkan.

- Expenv: Lingkungan Danau Beku, Masalah Berlayar, Pergi

- Konsistensi jalur tertimbang umum untuk menguasai game atari 2023

- Dengwei Zhao, Shikui Tu, Lei Xu

- Kunci: Konsistensi jalur tertimbang umum, mekanisme pembobotan.

- Expenv: Atari

- Pencarian Pohon Monte Carlo Monte dengan Abstraksi Status Pohon Probabilitas 2023

- Yangqing Fu, Ming Sun, Buqing Nie, Yue Gao

- Kunci: Probabilitas Keadaan Pohon Abstraksi, Transitivitas, dan Kesalahan Agregasi Terikat

- Expenv: Atari, Cartpole, Lunarlander, Gomoku

- Pengeluaran waktu berpikir dengan bijak: mempercepat MCT dengan ekspansi virtual 2022

- Weirui ye, biara pieter, Yang Gao

- KUNCI: Pertukaran komputasi versus performancem, ekspansi virtual, menghabiskan waktu berpikir secara adaptif.

- Expenv: atari, 9x9 go

- Perencanaan untuk Pembelajaran Imitasi Efisien Contoh 2022

- Zhao-Heng Yin, Weirui Ye, Qifeng Chen, Yang Gao

- Kunci: Kloning perilaku, pembelajaran imitasi permusuhan (AIL), RL berbasis MCTS.

- Expenv: DeepMind Control Suite

- Kode

- Evaluasi Beyond Task Performance: Menganalisis Konsep di Alphazero di Hex 2022

- Charles Lovering, Jessica Zosa Forde, George Konidaris, Ellie Pavlick, Michael L. Littman

- Kunci: Representasi internal Alphazero, model penyelidikan dan tes perilaku, bagaimana konsep -konsep ini ditangkap dalam jaringan.

- Expenv: Hex

- Apakah agen seperti Alphazero kuat untuk gangguan permusuhan? 2022

- Li-Cheng Lan, Huan Zhang, Ti-Rong Wu, Meng-Yu Tsai, I-Chen Wu, 4 Cho-Jui Hsieh

- Kunci: Negara -negara yang bermusuhan, serangan permusuhan pertama di Go AIS.

- Expenv: Pergi

- Keturunan pohon Monte Carlo untuk optimasi kotak hitam 2022

- Yaoguang Zhai, Sicun Gao

- Kunci: Optimalisasi kotak hitam, bagaimana mengintegrasikan lebih lanjut keturunan berbasis sampel untuk optimasi yang lebih cepat.

- ExpenV: Fungsi sintetis untuk optimasi nonlinier, masalah pembelajaran penguatan di lingkungan penggerak mujoco, dan masalah optimisasi dalam pencarian arsitektur saraf (NAS).

- Pemilihan Variabel Berbasis Pencarian Pohon Monte Carlo Untuk Optimasi Bayesian Dimensi Tinggi 2022

- Lei Song ∗, Ke Xue ∗, Xiaobin Huang, Chao Qian

- Kunci: Subruang dimensi rendah melalui MCTS, mengoptimalkan subruang dengan algoritma optimasi Bayesian apa pun.

- Expenv: Masalah NAS-Bench dan Mujoco Locomotion

- Pencarian Pohon Monte Carlo dengan Abstraksi Negara Bagian yang Memperbaiki Secara iteratif 2021

- Samuel Sokota, Caleb Ho, Zaheen Ahmad, J. Zico Kolter

- Kunci: Lingkungan stokastik, pelebaran progresif, penyulingan abstraksi

- Expenv: Blackjack, Trap, lima kali lima pergi.

- Sinoptik dalam Monte Carlo Perencanaan dalam Pengintaian Buta Catur 2021

- Gregory Clark

- Kunci: Informasi yang tidak sempurna, keadaan kepercayaan dengan filter partikel yang tidak tertimbang, abstraksi stokastik baru dari keadaan informasi.

- Expenv: Pengintaian Catur Buta

- Poly-Hoot: Perencanaan Monte-Carlo dalam MDP Ruang Kontinu dengan Analisis Non-Asymptotic 2020

- Weichao Mao, Kaiqing Zhang, Qiaomin Xie, Tamer Ba¸sar

- Kunci: Ruang aksi negara kontinu, optimasi optimis hierarkis.

- Expenv: Cartpole, Pendulum Terbalik, Swing-Up, dan Lunarlander.

- Mempelajari Partisi Ruang Pencarian untuk Optimalisasi Kotak Hitam Menggunakan Pencarian Pohon Monte Carlo 2020

- Linnan Wang, Rodrigo Fonseca, Yuandong Tian

- Kunci: Pelajari partisi ruang pencarian menggunakan beberapa sampel, batas keputusan nonlinier dan mempelajari model lokal untuk memilih kandidat yang baik.

- Expenv: tugas penggerak mujoco, tolok ukur skala kecil,

- Mix and Match: Pendekatan pencarian pohon yang optimis untuk model pembelajaran dari distribusi campuran 2020

- Matthew Faw, Rajat Sen, Karthikeyan Shanmugam, Constantine Caramanis, Sanjay Shakkottai

- Kunci: Masalah shift kovariat, Mix & Match menggabungkan stochastic gradient descent (SGD) dengan pencarian pohon optimis dan penggunaan model kembali (mengembangkan model yang dilatih sebagian dengan sampel dari distribusi campuran yang berbeda)

- Kode

Konferensi atau jurnal lainnya

- Belajar Berhenti: Simulasi Dinamis Pencarian Pohon Monte-Carlo AAAI 2021.

- Tentang Monte Carlo Tree Search and Reinforcement Learning Journal of Artificial Intelligence Research 2017.

- Pencarian arsitektur saraf yang efisien sampel dengan tindakan belajar untuk transaksi IEEE pohon Monte Carlo pada analisis pola dan kecerdasan mesin 2022.

Umpan balik dan kontribusi

Ajukan masalah di GitHub

Buka atau berpartisipasi dalam forum diskusi kami

Diskusikan di Lightzero Discord Server

Hubungi email kami ([email protected])

Kami menghargai semua umpan balik dan kontribusi untuk meningkatkan Lightzero, baik algoritma maupun desain sistem.

? Kutipan

@article{niu2024lightzero,

title={LightZero: A Unified Benchmark for Monte Carlo Tree Search in General Sequential Decision Scenarios},

author={Niu, Yazhe and Pu, Yuan and Yang, Zhenjie and Li, Xueyan and Zhou, Tong and Ren, Jiyuan and Hu, Shuai and Li, Hongsheng and Liu, Yu},

journal={Advances in Neural Information Processing Systems},

volume={36},

year={2024}

}

@article{pu2024unizero,

title={UniZero: Generalized and Efficient Planning with Scalable Latent World Models},

author={Pu, Yuan and Niu, Yazhe and Ren, Jiyuan and Yang, Zhenjie and Li, Hongsheng and Liu, Yu},

journal={arXiv preprint arXiv:2406.10667},

year={2024}

}

@article{xuan2024rezero,

title={ReZero: Boosting MCTS-based Algorithms by Backward-view and Entire-buffer Reanalyze},

author={Xuan, Chunyu and Niu, Yazhe and Pu, Yuan and Hu, Shuai and Liu, Yu and Yang, Jing},

journal={arXiv preprint arXiv:2404.16364},

year={2024}

}? Ucapan Terima Kasih

Proyek ini telah dikembangkan sebagian berdasarkan pada pekerjaan perintis berikut pada repositori gitub. Kami mengucapkan terima kasih yang mendalam atas sumber daya dasar ini:

- https://github.com/opendilab/di- engine

- https://github.com/deepmind/mctx

- https://github.com/yewr/efficientzero

- https://github.com/werner-duvaud/muzero-general

Kami ingin menyampaikan terima kasih khusus kami kepada kontributor berikut @paparazz1, @karroyan, @nighood, @jayyoung0802, @timothijoe, @tutuhuss, @harryxuanancy, @puyuan1996, @hansbug untuk kontribusi mereka yang berharga dan dukungan ini.

Terima kasih untuk semua yang berkontribusi pada proyek ini:

? ️ Lisensi

Semua kode dalam repositori ini berada di bawah Lisensi Apache 2.0.

(Kembali ke atas)