llama index RAG

1.0.0

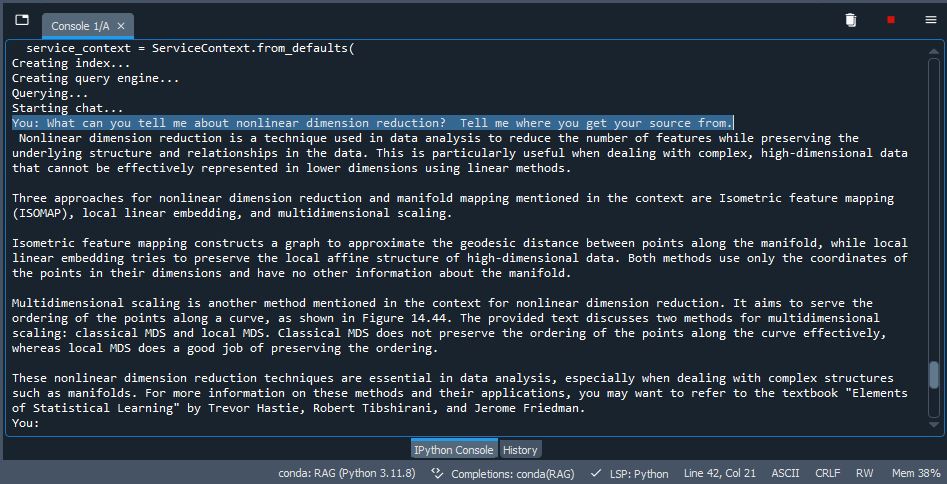

Реализация RAG на индексе Llama с использованием Qdrant в качестве хранилища. Возьмите несколько PDF -файлов (вы можете использовать тестовые PDF -файлы, включающие в себя /данные или удалить и использовать свои собственные документы), индекс /встроить их в VDB, использовать LLM для вывода и генерировать вывод. Довольно изящный.

pip install -r /path/to/requirements.txt вollama run mistral или какой -либо моделью, которую вы выберете. Если вы используете новую Ollama для Windows, то не требуется, поскольку он работает в фоновом режиме (убедитесь, что он активен).