llama index RAG

1.0.0

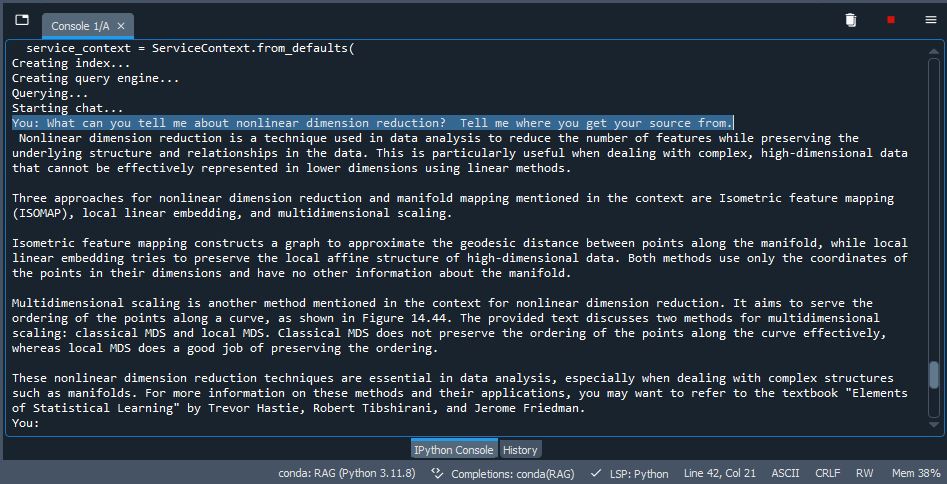

QDRANT를 저장으로 사용하여 LLAMA 인덱스의 래그 구현. 일부 PDF를 사용하십시오 ( /데이터를 포함하여 테스트 PDF를 사용하거나 삭제하고 자신의 문서를 사용할 수 있음), VDB에 색인 /포함 된 LLM을 사용하여 추론 및 출력을 생성하십시오. 꽤 멋진.

pip install -r /path/to/requirements.txt 를 입력하십시오ollama run mistral 또는 선택한 모델로 터미널에서 Ollama를 활성화하십시오. Windows 용 New Ollama를 사용하는 경우 백그라운드에서 실행되기 때문에 필요하지 않습니다 (활성화되도록).