llama index RAG

1.0.0

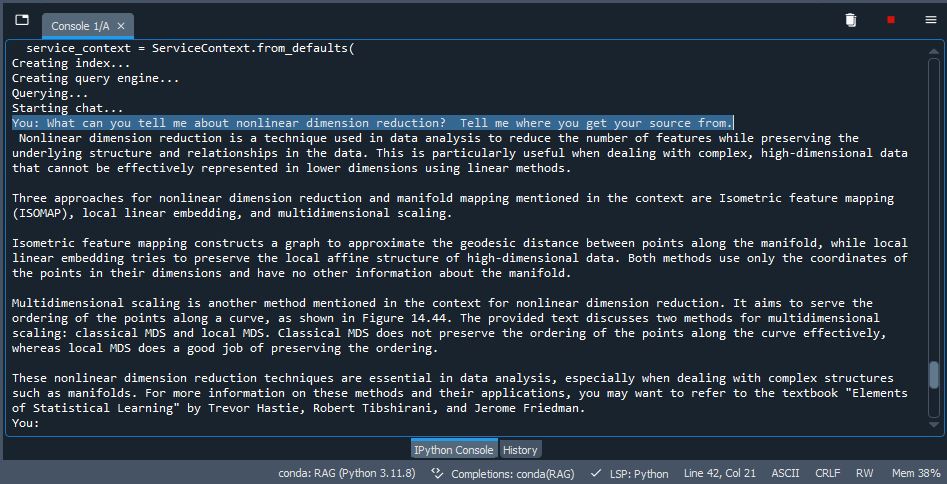

ストレージとしてQDRANTを使用したLLAMAインデックスのRAG実装。いくつかのPDFを取得し(テストPDFを使用する /データ /データを使用するか、独自のドキュメントを削除して使用できます)、VDBにインデックス /埋め込み、LLMを使用して推論して出力を生成します。かなり気の利いた。

pip install -r /path/to/requirements.txt入力しますollama run mistralまたはあなたが選んだあらゆるモデルを使用して、ターミナルでOllamaをアクティブにします。 Windowsに新しいOllamaを使用している場合は、バックグラウンドで実行されるため、必要ありません(アクティブであることを確認してください)。