llama index RAG

1.0.0

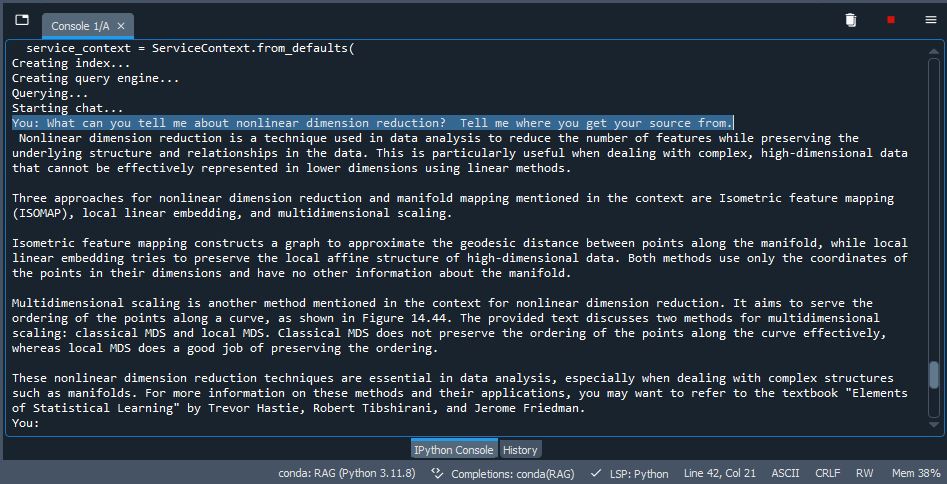

Una implementación de trapo en el índice de LLAMA utilizando QDRANT como almacenamiento. Tome algunos PDF (puede usar los PDF de prueba incluyen In /Data o Eliminar y usar sus propios documentos), indexar /incrustarlos en un VDB, usar LLM para inferir y generar salida. Bastante ingenioso.

pip install -r /path/to/requirements.txt en el indicador CMDollama run mistral o cualquier modelo que elija. Si está utilizando el nuevo Ollama para Windows, entonces no es necesario ya que se ejecuta en segundo plano (asegúrese de que esté activo).