llama index RAG

1.0.0

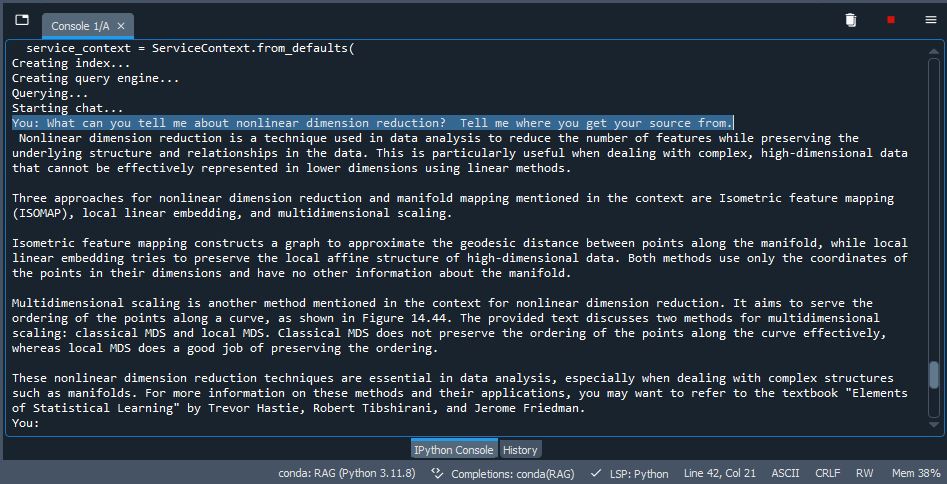

Uma implementação de pano no índice de llama usando o QDRANT como armazenamento. Pegue alguns PDFs (você pode usar os PDFs de teste incluem em /dados ou excluir e usar seus próprios documentos), indexá -los /incorporá -los em um VDB, use LLM para inferência e gerar saída. Muito bacana.

pip install -r /path/to/requirements.txt no prompt de cmdollama run mistral ou qualquer modelo que você escolher. Se você estiver usando o novo Ollama para o Windows, não é necessário, pois ele é executado em segundo plano (verifique se está ativo).