llama index RAG

1.0.0

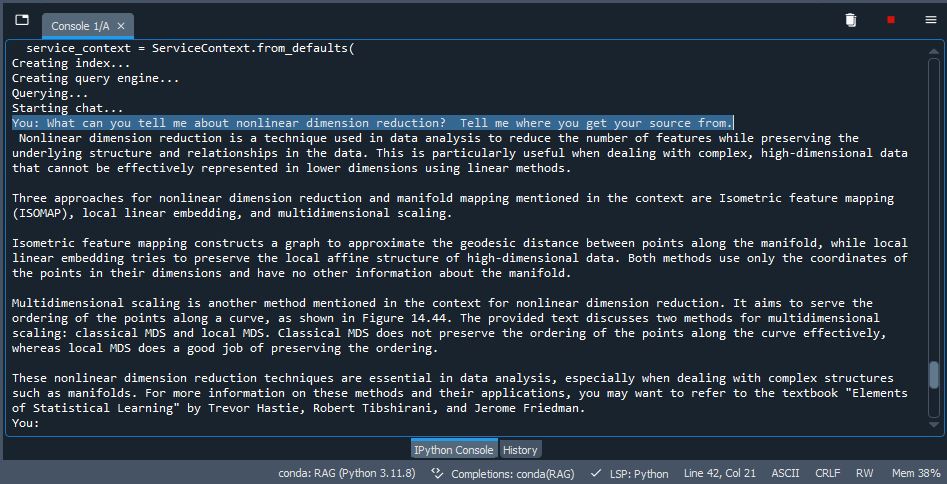

Une implémentation de chiffon sur l'indice LLAMA utilisant QDRANT comme stockage. Prenez des PDF (vous pouvez soit utiliser le test que les PDF incluent dans / Data ou supprimer et utiliser vos propres documents), index / intégrer dans un VDB, utiliser LLM pour inférer et générer une sortie. Assez nifty.

pip install -r /path/to/requirements.txt dans l'invite CMDollama run mistral ou quel que soit le modèle que vous choisissez. Si vous utilisez le nouveau Olllama pour Windows, il n'est pas nécessaire car il s'exécute en arrière-plan (assurez-vous qu'il est actif).