Langchain Rag Application

Реализация RAG на Langchain с использованием Chroma в качестве хранения. Возьмите несколько PDF -файлов (вы можете использовать тестовые PDF -файлы, включающие в себя /данные или удалить и использовать свои собственные документы), индекс /встроить их в VDB, использовать LLM для вывода и генерировать вывод.

Как использовать

- Создать локальный путь и подпапку данных

- Создайте Virtual Env с помощью Conda или как вы выберете

- Установить требования.txt

- Активируйте Ollama в терминале с «Ollama Run Mistral» или любой моделью, которую вы выберете. Если вы используете новую Ollama для Windows, то не требуется, поскольку он работает в фоновом режиме (убедитесь, что он активен).

- Открыть langchain_rag.py

- Обновление строки 15 и 16 с вашими локальными путями #FOR PDFS и где база данных Chroma будет хранить куски

- Обновление строки 50 с помощью модели выбора

- Сохраните и запустите сценарий

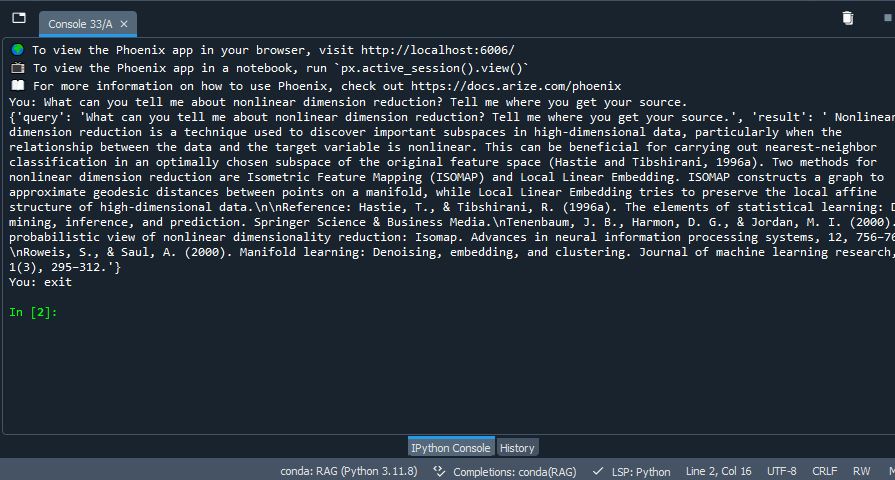

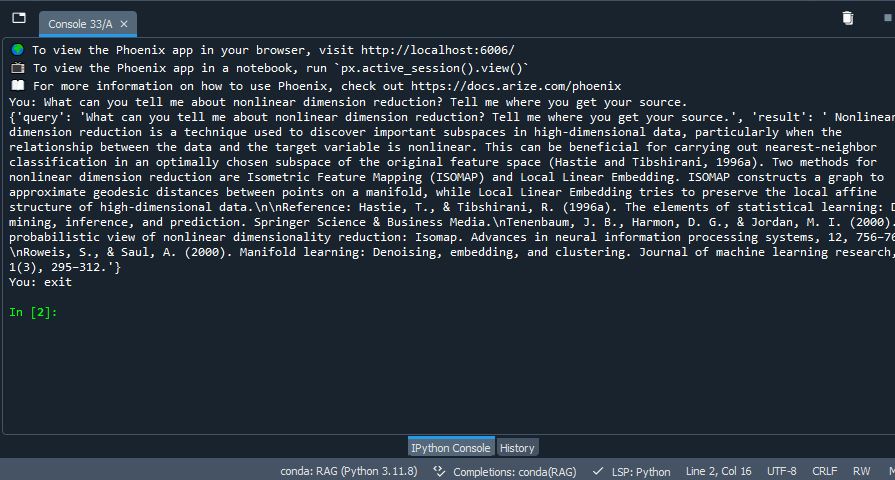

- Наблюдайте за результатами, аналогичными: