Aplicación langchain trapo

Una implementación de trapo en Langchain utilizando croma como almacenamiento. Tome algunos PDF (puede usar los PDF de prueba incluyen In /Data o Eliminar y usar sus propios documentos), indexar /incrustarlos en un VDB, usar LLM para inferir y generar salida.

Cómo usar

- Crear ruta local y subcarpeta de datos

- Crear env virtual con condena o como elija

- Instalar requisitos.txt

- Active Ollama en la terminal con "Ollama Run Mistral" o cualquier modelo que elija. Si está utilizando el nuevo Ollama para Windows, entonces no es necesario ya que se ejecuta en segundo plano (asegúrese de que esté activo).

- Abra langchain_rag.py

- Actualizar la línea 15 y 16 con sus rutas locales #para PDFS y donde la base de datos de Chroma almacenará fragmentos

- Actualizar la línea 50 con su modelo de elección

- Guardar y ejecutar el script

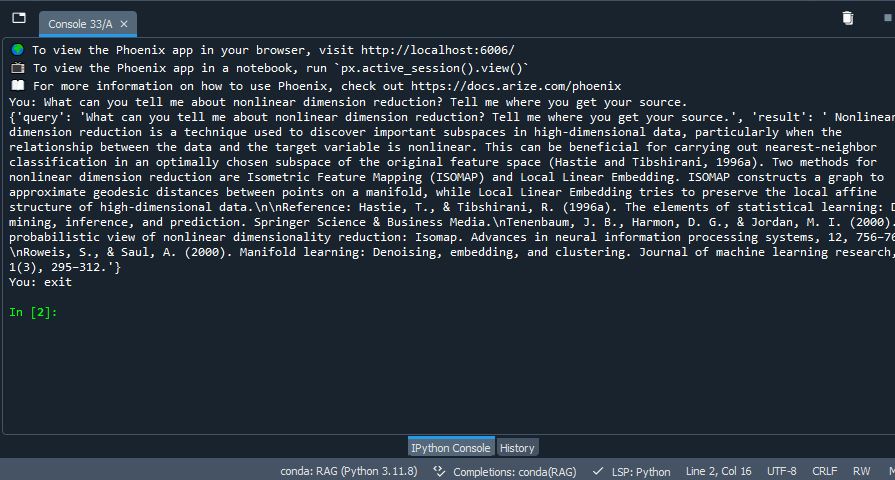

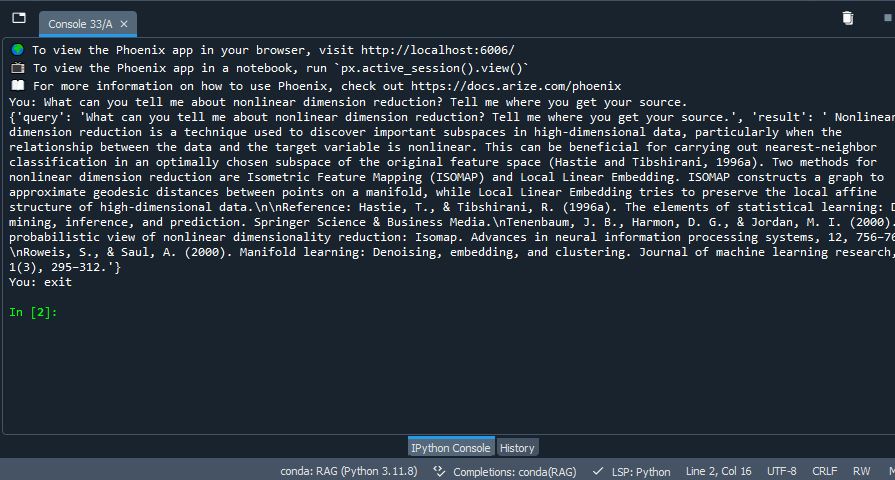

- Observe resultados similares a: