Aplicação de pano de Langchain

Uma implementação de RAG no Langchain usando o Chroma como armazenamento. Pegue alguns PDFs (você pode usar os PDFs de teste incluem em /dados ou excluir e usar seus próprios documentos), indexá -los /incorporá -los em um VDB, use LLM para inferência e gerar saída.

Como usar

- Crie o caminho local e a subpasta de dados

- Crie Env virtual usando conda ou como você escolher

- Instale requisitos.txt

- Ative Ollama no Terminal com "Ollama Run Mistral" ou qualquer modelo que você escolher. Se você estiver usando o novo Ollama para o Windows, não é necessário, pois ele é executado em segundo plano (verifique se está ativo).

- Abra Langchain_rag.py

- Atualizar a linha 15 e 16 com seus caminhos locais #para pdfs e onde o banco de dados Chroma armazenará pedaços

- Atualizar a linha 50 com seu modelo de escolha

- Salve e execute o script

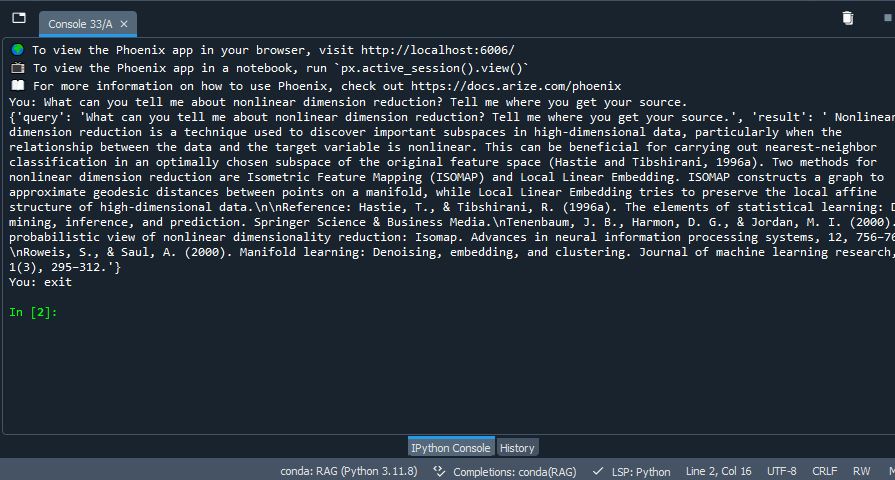

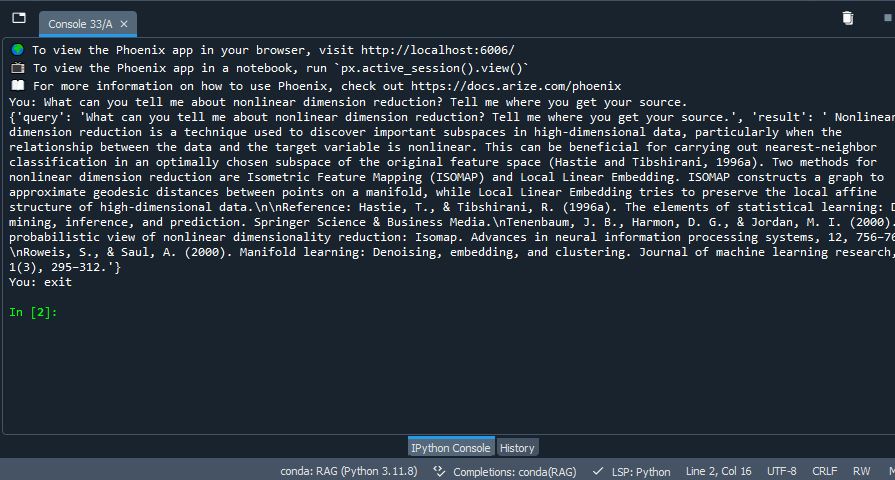

- Observe resultados semelhantes a: