Agentops помогает разработчикам создавать, оценивать и контролировать агенты ИИ. От прототипа до производства.

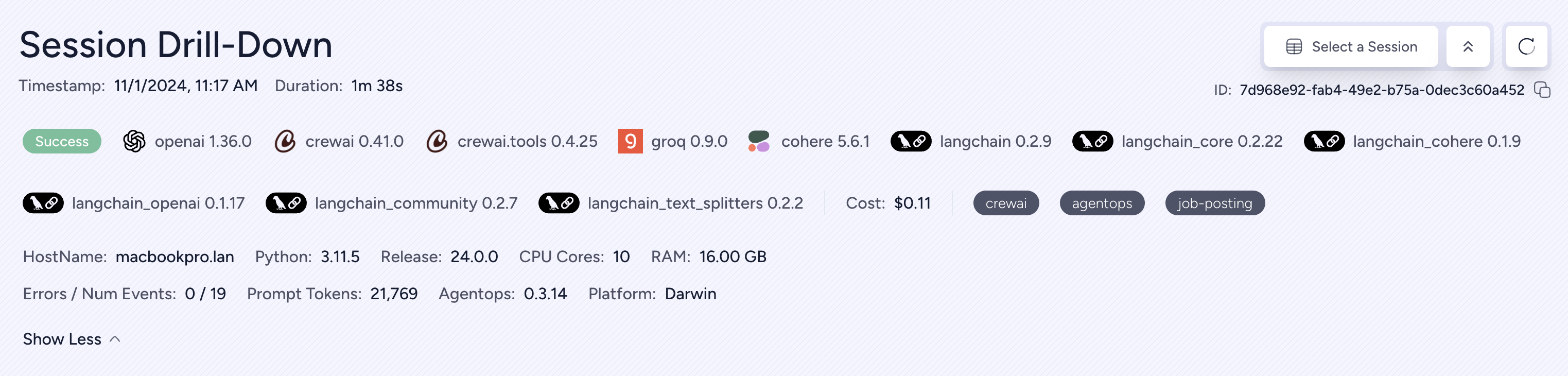

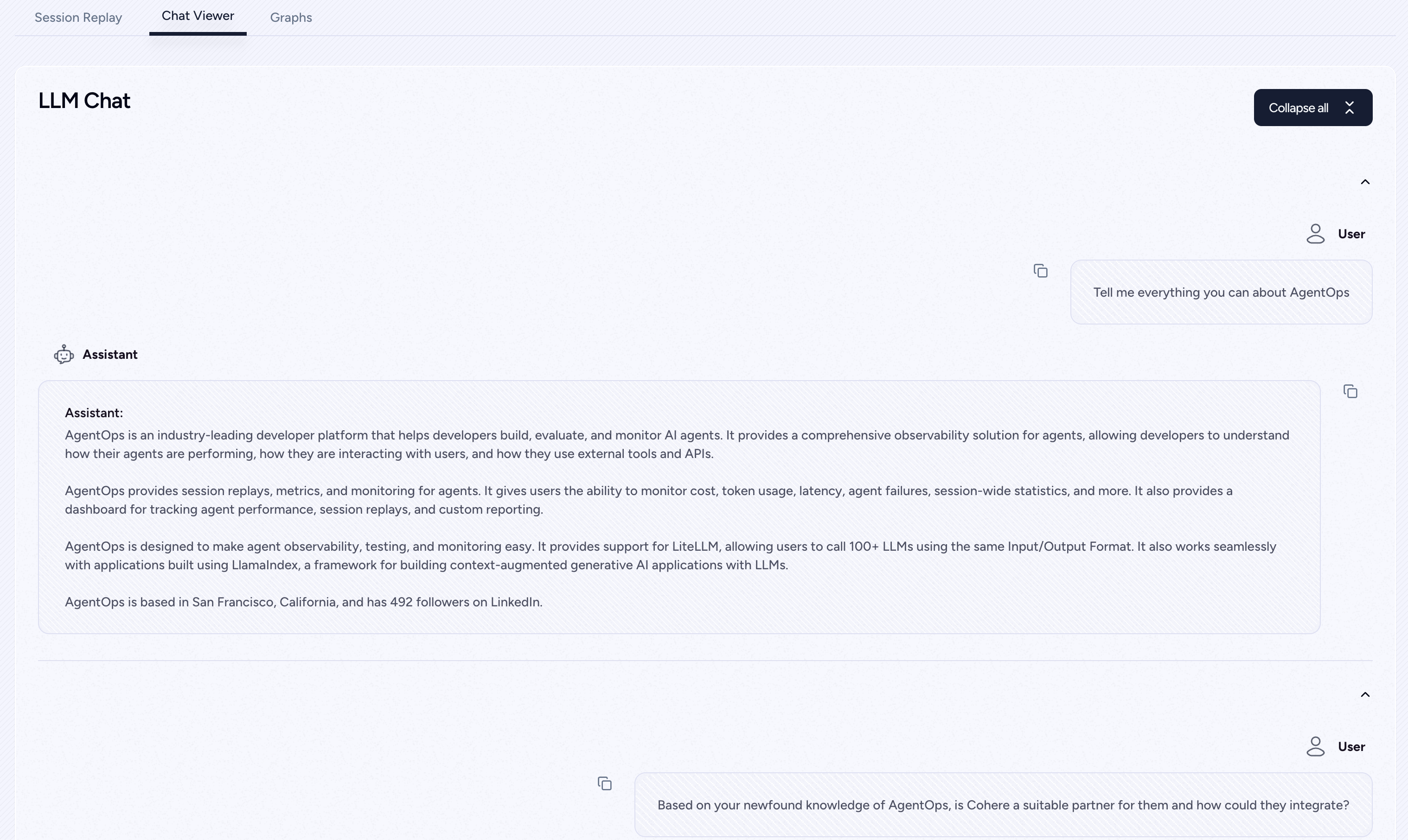

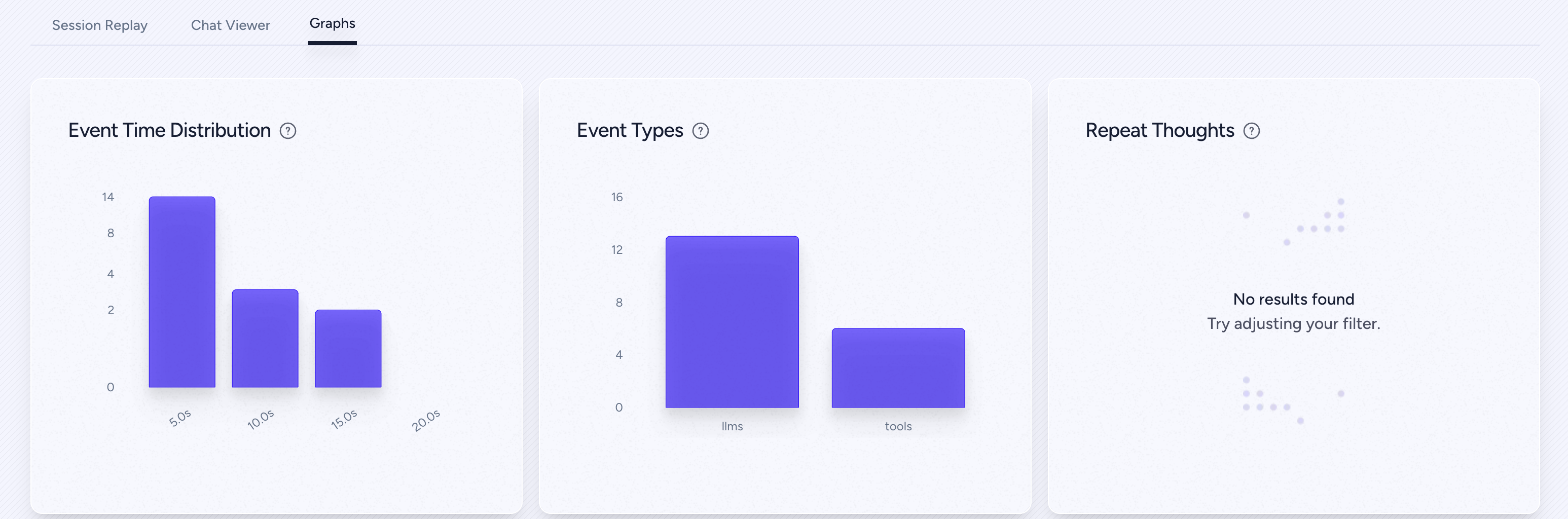

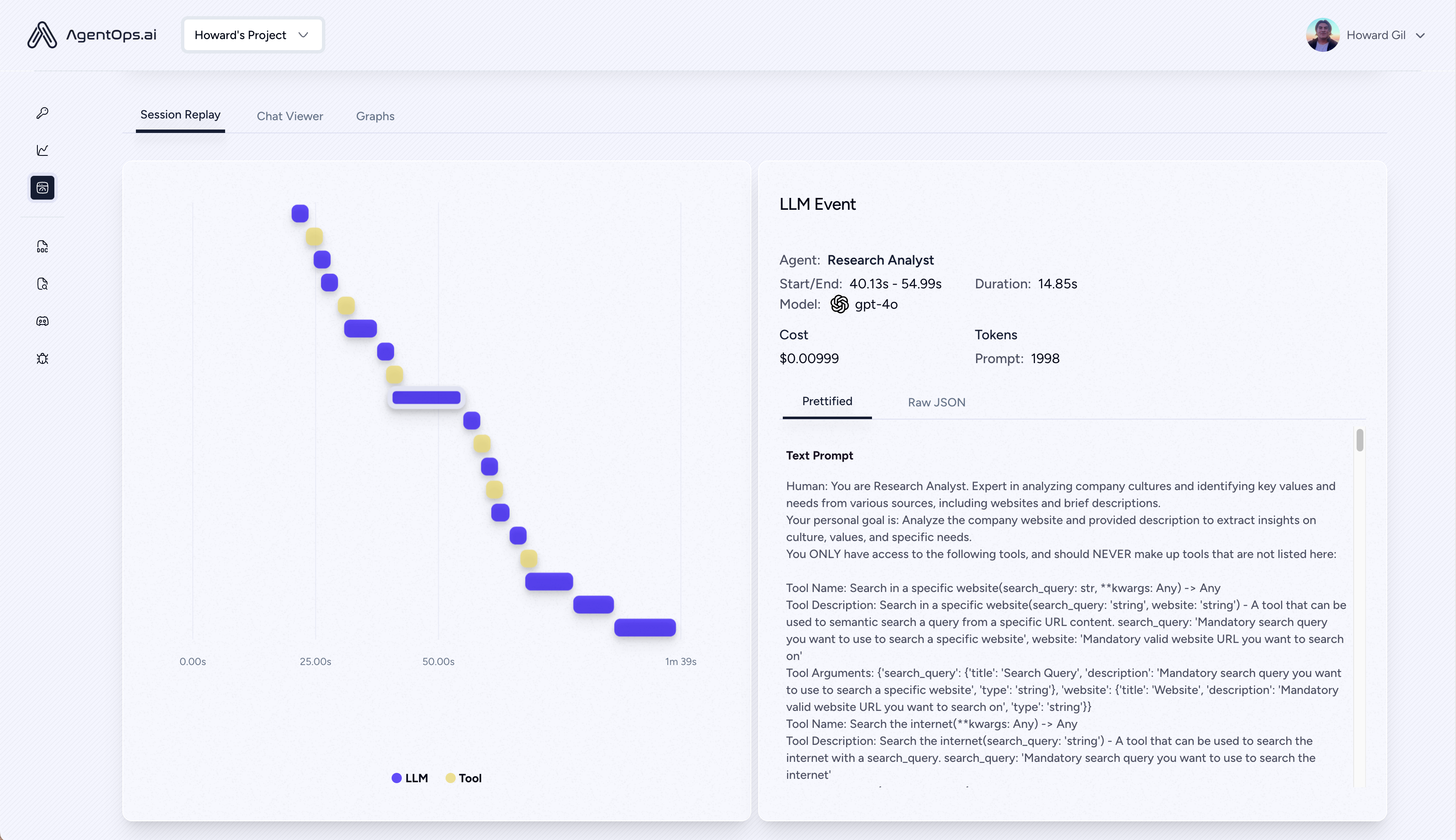

| Аналитика воспроизведения и отладку | Пошаговые графики выполнения агента |

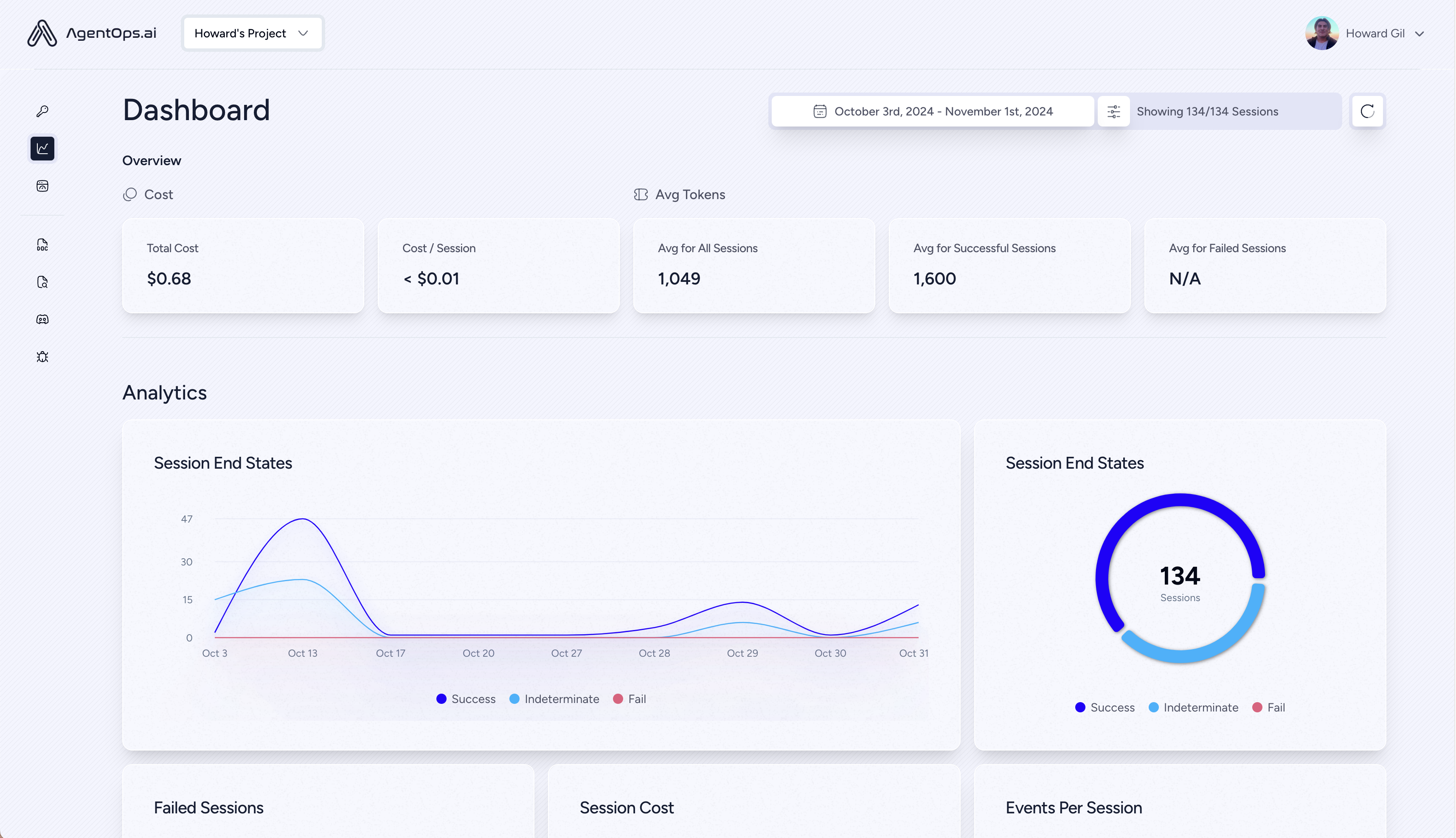

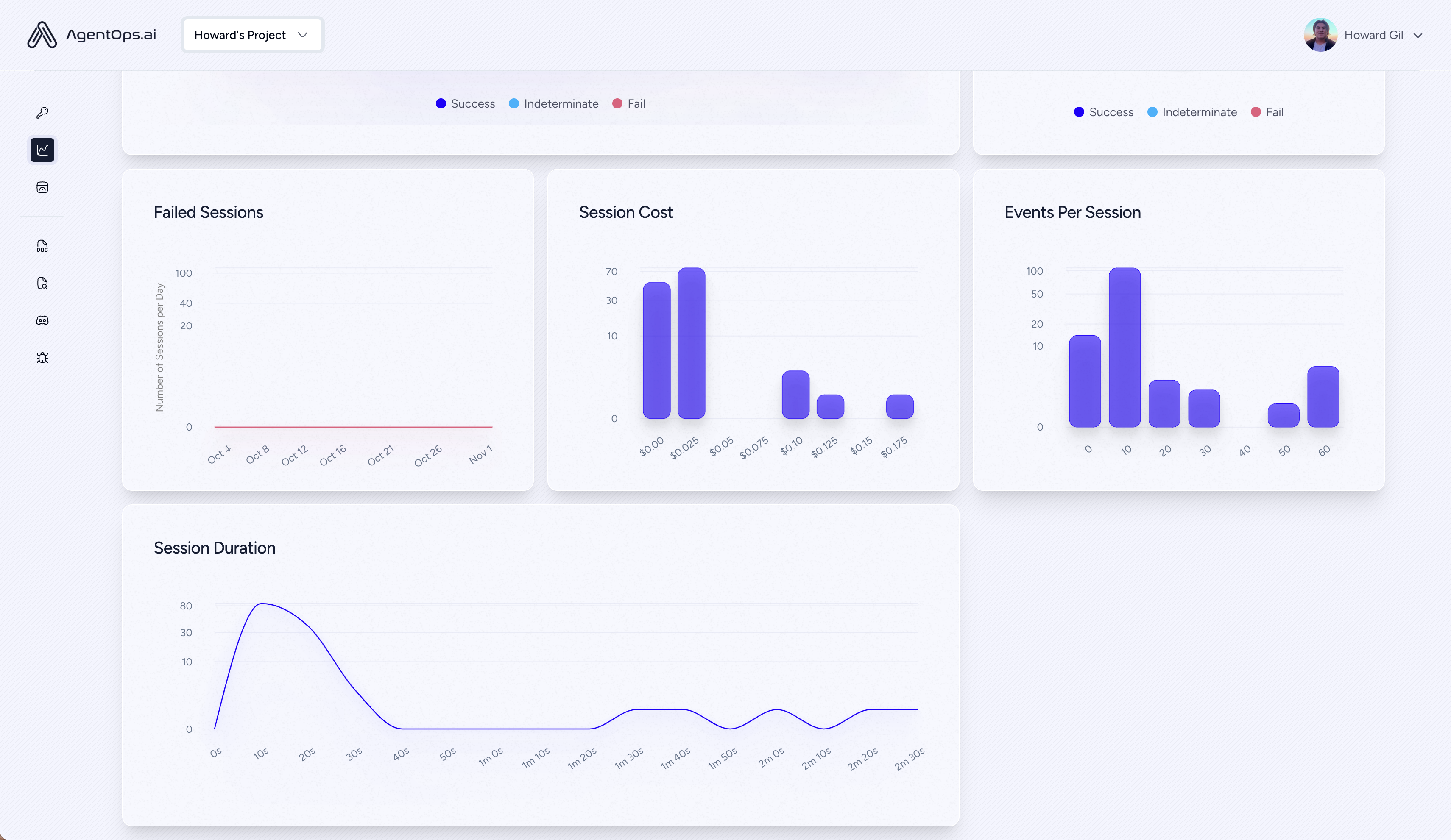

| ? LLM Управление затратами | Треки расходы с поставщиками моделей Foundation LLM |

| ? Агент | Проверьте свои агенты на 1000+ evals |

| ? Соответствие и безопасность | Обнаружение общих эксплуатационных эксплуатационных эксплуатаций |

| ? Фреймворк интеграции | Нативные интеграции с Crewai, Autogen и Langchain |

pip install agentopsИнициализируйте клиент Agentops и автоматически получайте аналитику на всех ваших вызовах LLM.

Получите ключ API

import agentops

# Beginning of your program (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

...

# End of program

agentops . end_session ( 'Success' ) Все ваши сеансы можно просмотреть на панели панели Agentops

Добавьте мощную наблюдением к вашим агентам, инструментам и функциям с максимально небольшим кодом: по одной строке за раз.

Обратитесь к нашей документации

# Automatically associate all Events with the agent that originated them

from agentops import track_agent

@ track_agent ( name = 'SomeCustomName' )

class MyAgent :

... # Automatically create ToolEvents for tools that agents will use

from agentops import record_tool

@ record_tool ( 'SampleToolName' )

def sample_tool (...):

... # Automatically create ActionEvents for other functions.

from agentops import record_action

@ agentops . record_action ( 'sample function being record' )

def sample_function (...):

... # Manually record any other Events

from agentops import record , ActionEvent

record ( ActionEvent ( "received_user_input" )) Стройте агенты экипажа с наблюдением только с 2 строками кода. Просто установите AGENTOPS_API_KEY в вашей среде, и ваши команды получат автоматический мониторинг на панели панели Agentops.

pip install ' crewai[agentops] ' Только две строки кода добавьте полную наблюдению и мониторинг к агентам автогена. Установите AGENTOPS_API_KEY в вашей среде и вызовите agentops.init()

Agentops беспрепятственно работает с приложениями, созданными с использованием Langchain. Чтобы использовать обработчик, установите Langchain в качестве дополнительной зависимости:

pip install agentops[langchain]Чтобы использовать обработчик, импортировать и установить

import os

from langchain . chat_models import ChatOpenAI

from langchain . agents import initialize_agent , AgentType

from agentops . partners . langchain_callback_handler import LangchainCallbackHandler

AGENTOPS_API_KEY = os . environ [ 'AGENTOPS_API_KEY' ]

handler = LangchainCallbackHandler ( api_key = AGENTOPS_API_KEY , tags = [ 'Langchain Example' ])

llm = ChatOpenAI ( openai_api_key = OPENAI_API_KEY ,

callbacks = [ handler ],

model = 'gpt-3.5-turbo' )

agent = initialize_agent ( tools ,

llm ,

agent = AgentType . CHAT_ZERO_SHOT_REACT_DESCRIPTION ,

verbose = True ,

callbacks = [ handler ], # You must pass in a callback handler to record your agent

handle_parsing_errors = True )Проверьте ноутбук Langchain примеров для получения более подробной информации, включая асинхронные обработчики.

Поддержка первого класса для cohere (> = 5.4.0). Это живая интеграция, если вам нужна дополнительная функциональность, сообщите нам о Discord!

pip install cohere import cohere

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

co = cohere . Client ()

chat = co . chat (

message = "Is it pronounced ceaux-hear or co-hehray?"

)

print ( chat )

agentops . end_session ( 'Success' ) import cohere

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

co = cohere . Client ()

stream = co . chat_stream (

message = "Write me a haiku about the synergies between Cohere and AgentOps"

)

for event in stream :

if event . event_type == "text-generation" :

print ( event . text , end = '' )

agentops . end_session ( 'Success' )Трековые агенты, построенные с антропным Python SDK (> = 0,32,0).

pip install anthropic import anthropic

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = anthropic . Anthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

message = client . messages . create (

max_tokens = 1024 ,

messages = [

{

"role" : "user" ,

"content" : "Tell me a cool fact about AgentOps" ,

}

],

model = "claude-3-opus-20240229" ,

)

print ( message . content )

agentops . end_session ( 'Success' )Потоковая передача

import anthropic

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = anthropic . Anthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

stream = client . messages . create (

max_tokens = 1024 ,

model = "claude-3-opus-20240229" ,

messages = [

{

"role" : "user" ,

"content" : "Tell me something cool about streaming agents" ,

}

],

stream = True ,

)

response = ""

for event in stream :

if event . type == "content_block_delta" :

response += event . delta . text

elif event . type == "message_stop" :

print ( " n " )

print ( response )

print ( " n " )Асинхро

import asyncio

from anthropic import AsyncAnthropic

client = AsyncAnthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

async def main () -> None :

message = await client . messages . create (

max_tokens = 1024 ,

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async agents" ,

}

],

model = "claude-3-opus-20240229" ,

)

print ( message . content )

await main ()Трековые агенты, построенные с антропным Python SDK (> = 0,32,0).

pip install mistralaiСинхронизированный

from mistralai import Mistral

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

message = client . chat . complete (

messages = [

{

"role" : "user" ,

"content" : "Tell me a cool fact about AgentOps" ,

}

],

model = "open-mistral-nemo" ,

)

print ( message . choices [ 0 ]. message . content )

agentops . end_session ( 'Success' )Потоковая передача

from mistralai import Mistral

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

message = client . chat . stream (

messages = [

{

"role" : "user" ,

"content" : "Tell me something cool about streaming agents" ,

}

],

model = "open-mistral-nemo" ,

)

response = ""

for event in message :

if event . data . choices [ 0 ]. finish_reason == "stop" :

print ( " n " )

print ( response )

print ( " n " )

else :

response += event . text

agentops . end_session ( 'Success' )Асинхро

import asyncio

from mistralai import Mistral

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

async def main () -> None :

message = await client . chat . complete_async (

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async agents" ,

}

],

model = "open-mistral-nemo" ,

)

print ( message . choices [ 0 ]. message . content )

await main ()Асинхронизированная потоковая передача

import asyncio

from mistralai import Mistral

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

async def main () -> None :

message = await client . chat . stream_async (

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async streaming agents" ,

}

],

model = "open-mistral-nemo" ,

)

response = ""

async for event in message :

if event . data . choices [ 0 ]. finish_reason == "stop" :

print ( " n " )

print ( response )

print ( " n " )

else :

response += event . text

await main ()Agentops обеспечивает поддержку Litellm (> = 1.3.1), что позволяет вам вызовать 100+ LLMS, используя тот же формат ввода/вывода.

pip install litellm # Do not use LiteLLM like this

# from litellm import completion

# ...

# response = completion(model="claude-3", messages=messages)

# Use LiteLLM like this

import litellm

...

response = litellm . completion ( model = "claude-3" , messages = messages )

# or

response = await litellm . acompletion ( model = "claude-3" , messages = messages )Agentops бесстрально работает с приложениями, созданными с использованием LmamainDex, структуры для создания генеративных приложений искусственного интеллекта для контекста с LLMS.

pip install llama-index-instrumentation-agentopsЧтобы использовать обработчик, импортировать и установить

from llama_index . core import set_global_handler

# NOTE: Feel free to set your AgentOps environment variables (e.g., 'AGENTOPS_API_KEY')

# as outlined in the AgentOps documentation, or pass the equivalent keyword arguments

# anticipated by AgentOps' AOClient as **eval_params in set_global_handler.

set_global_handler ( "agentops" )Проверьте документы LmamainDex для получения более подробной информации.

Попробуйте!

(вскоре!)

| Платформа | Приборная панель | Эвал |

|---|---|---|

| ✅ Python Sdk | ✅ Многосессионные и перекрестные метрики | ✅ Пользовательские показатели оценки оценки |

| ? Оценка Builder API | ✅ Пользовательское отслеживание тегов событий | Агентные показатели |

| ✅ Javascript/TypeScript SDK | ✅ Session Replays | Оценка игровая площадка + таблица лидеров |

| Тестирование производительности | Среда | Тестирование LLM | Рассуждение и выполнение тестирования |

|---|---|---|---|

| ✅ Анализ задержки событий | Нестационарное тестирование окружающей среды | LLM Недотерминированное обнаружение функции | ? Бесконечные петли и рекурсивное обнаружение мышления |

| ✅ Цены на выполнение рабочего процесса агента | Многомодальная среда | ? Токен предельные флаги переполнения | Неисправное обнаружение рассуждений |

| ? Валидаторы успеха (внешняя) | Контейнеры выполнения | Флаги переполнения контекста | Генеративные валидаторы кода |

| Контроллеры агента/тесты на навыки | ✅ Honeypot и быстрое обнаружение инъекций (rasmerarmor) | API BILL BRECKING | Анализ точки останова ошибок |

| Информационный контекст тестирование ограничений | Анти-агентные дорожные блоки (т.е. капчас) | CI/CD Интеграция проверки | |

| Регрессионное тестирование | Многоагентная структура визуализация |

Без правильных инструментов агенты ИИ медленные, дорогие и ненадежные. Наша миссия состоит в том, чтобы доставить вашего агента из прототипа до производства. Вот почему Agentops выделяется:

Agentops предназначена для облегчения наблюдения, тестирования и мониторинга агента.

Проверьте наш рост в сообществе:

| Репозиторий | Звезда |

|---|---|

| Geekan / Metagpt | 42787 |

| Run-Llama / llama_index | 34446 |

| crewaiinc / crewai | 18287 |

| Верблюд-ай / верблюд | 5166 |

| Superagent-AI / Superagent | 5050 |

| Iyaja / llama-fs | 4713 |

| На основе HARDWARE / OMI | 2723 |

| Mervinpraison / Praisonai | 2007 |

| AgentOps-AI / Jaiqu | 272 |

| Strnad / Crewai-Studio | 134 |

| Alejandro-Ao / Exa-Crewai | 55 |

| tonykipkemboi / youtube_yapper_trapper | 47 |

| Sethcoast / Cover-Builder | 27 |

| Bhancockio / Chatgpt4-Analysis | 19 |

| Breakstring / Agentic_story_book_workflow | 14 |

| Multi-On / Multition-Python | 13 |

Сгенерированные с использованием github-info, от Николаса Вуйльямии