Agenteps ayuda a los desarrolladores a construir, evaluar y monitorear los agentes de IA. De prototipo a producción.

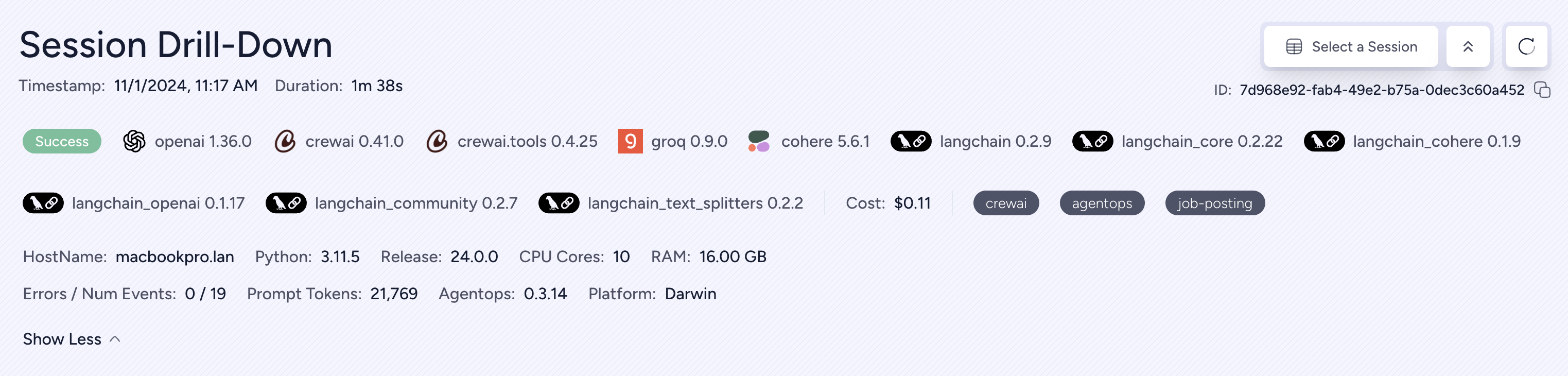

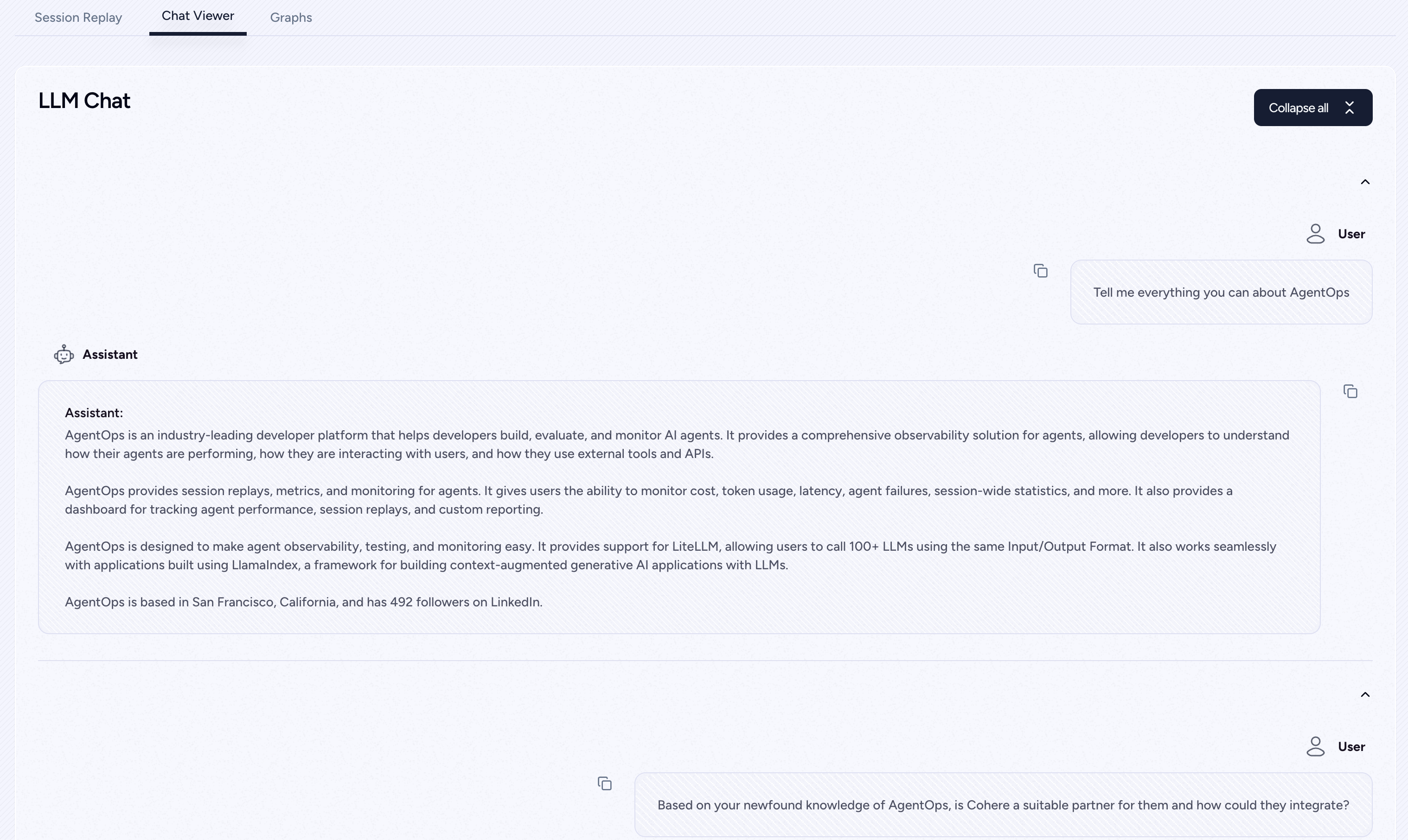

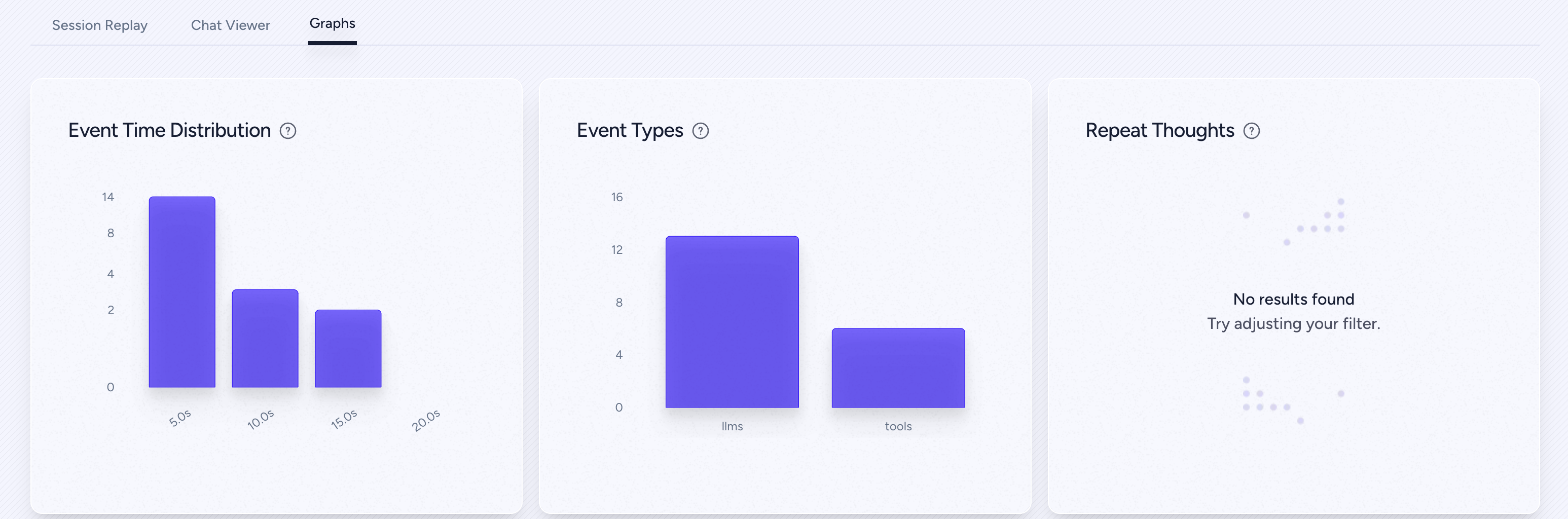

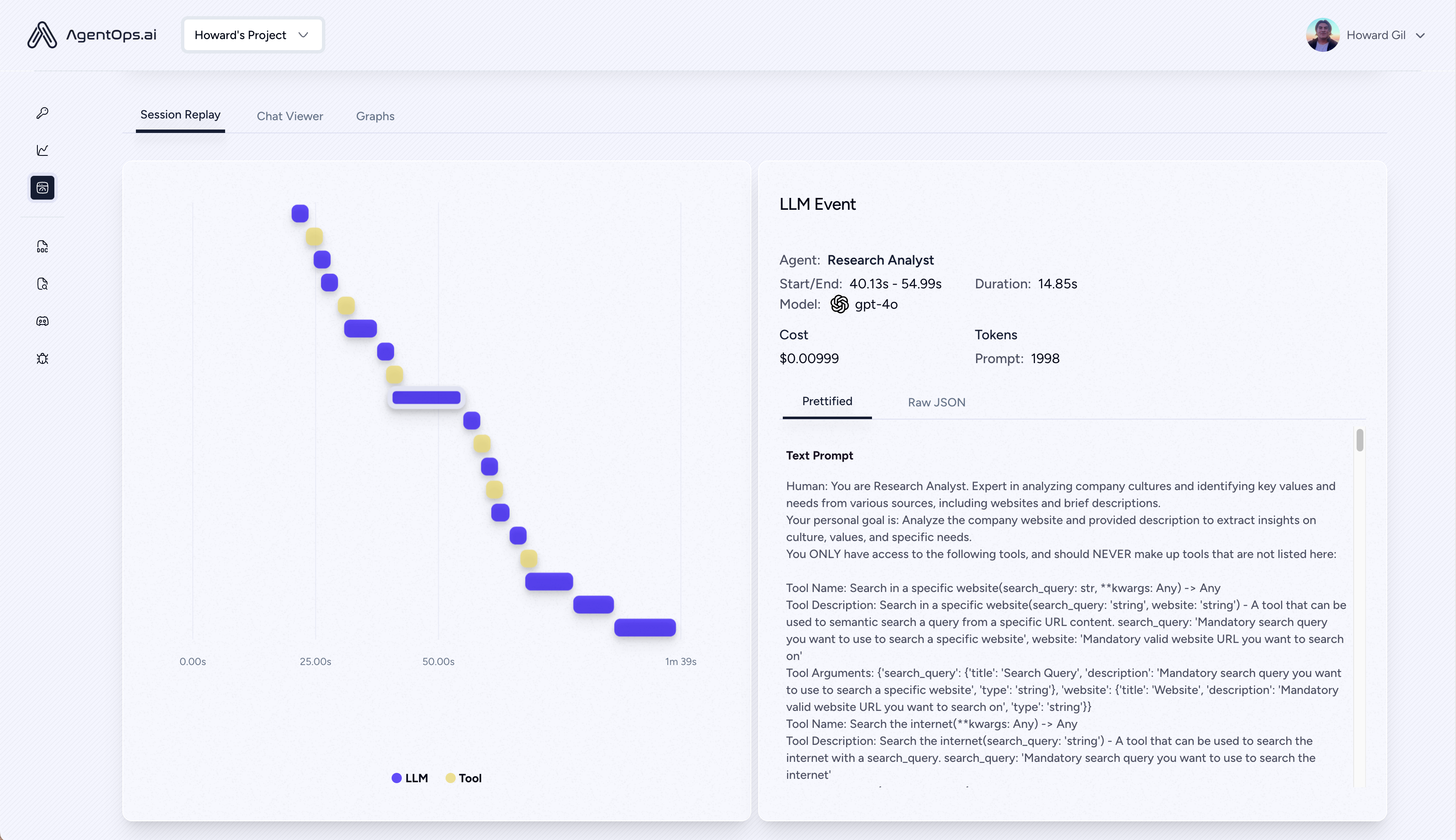

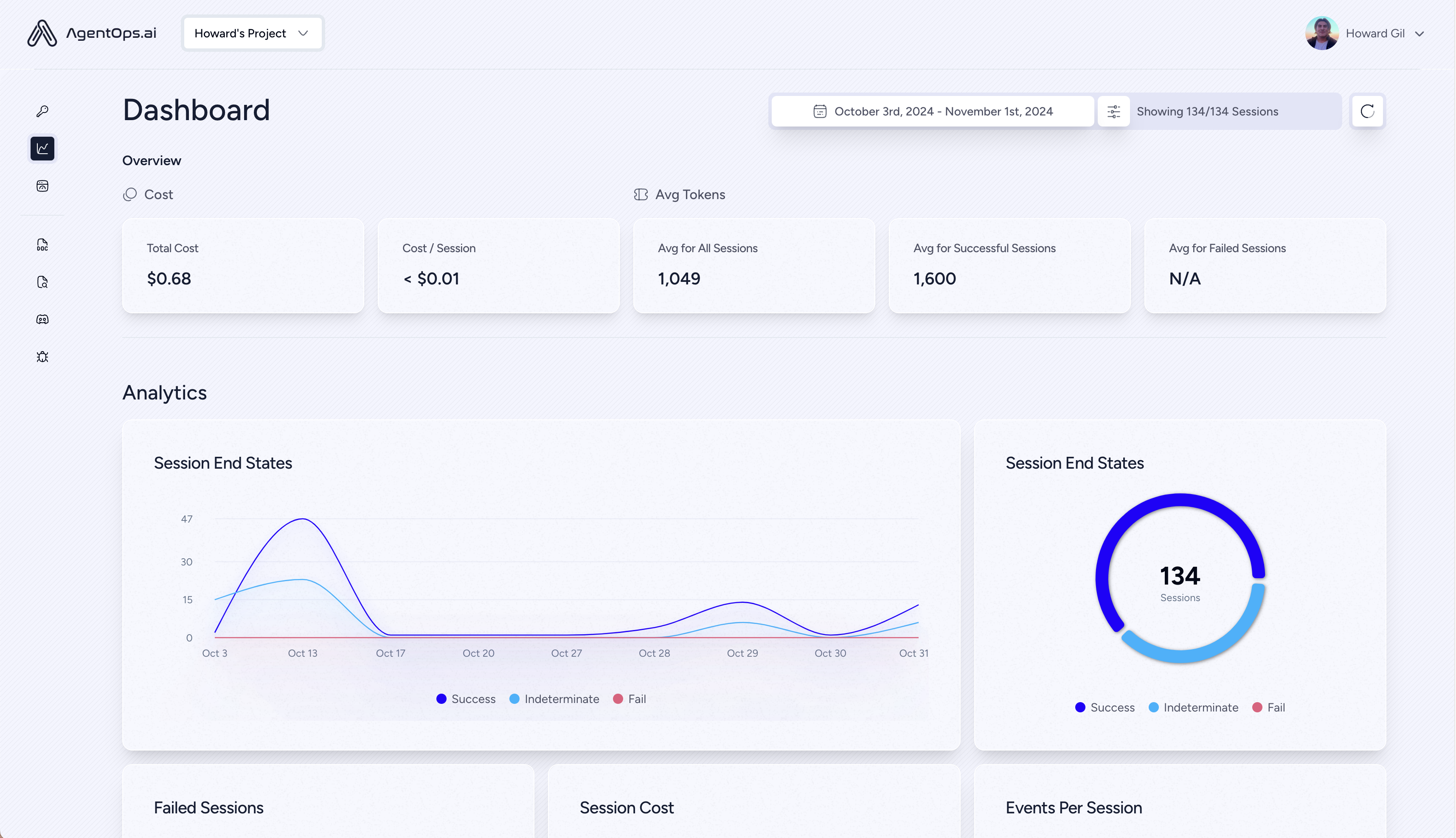

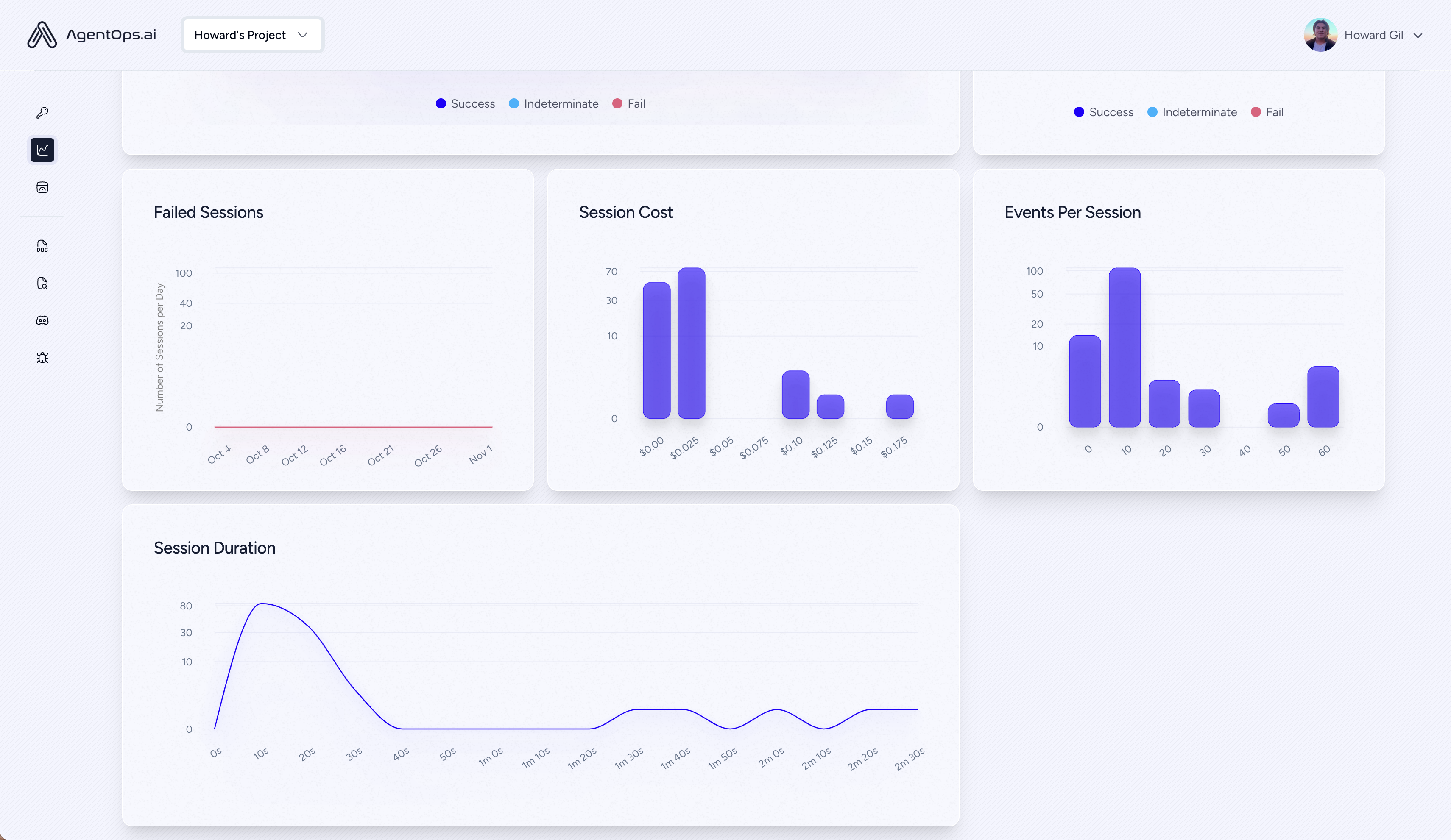

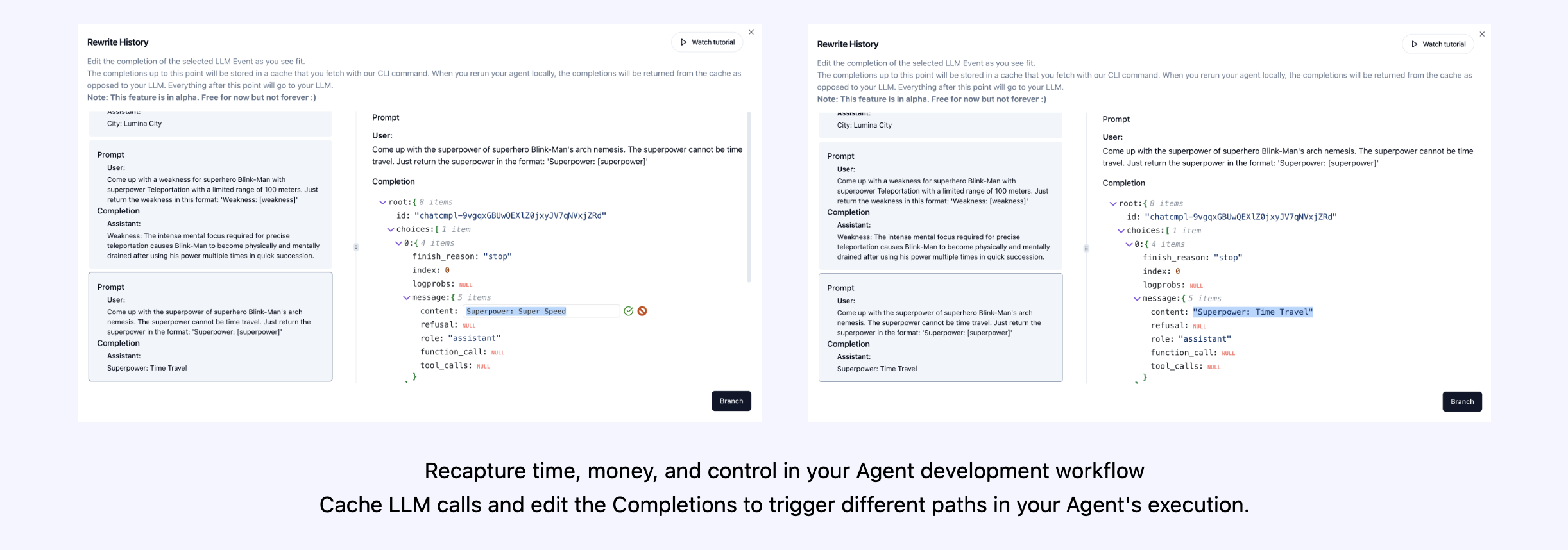

| Reproducir análisis y depuración | Gráficos de ejecución de agentes paso a paso |

| ? Gestión de costos de LLM | Pasar el gasto con proveedores de modelos de la Fundación LLM |

| ? Benchmarking de agentes | Pon a prueba a tus agentes contra más de 1,000 evals |

| ? Cumplimiento y seguridad | Detectar exploits comunes de inyección y exfiltración de datos comunes |

| ? Integraciones de marco | Integraciones nativas con Crewai, Autogen y Langchain |

pip install agentopsInicialice el cliente Agenteps y obtenga automáticamente análisis en todas sus llamadas de LLM.

Obtenga una llave de API

import agentops

# Beginning of your program (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

...

# End of program

agentops . end_session ( 'Success' ) Todas sus sesiones se pueden ver en el tablero de agentes

Agregue una poderosa observabilidad a sus agentes, herramientas y funciones con el menor código posible: una línea a la vez.

Consulte nuestra documentación

# Automatically associate all Events with the agent that originated them

from agentops import track_agent

@ track_agent ( name = 'SomeCustomName' )

class MyAgent :

... # Automatically create ToolEvents for tools that agents will use

from agentops import record_tool

@ record_tool ( 'SampleToolName' )

def sample_tool (...):

... # Automatically create ActionEvents for other functions.

from agentops import record_action

@ agentops . record_action ( 'sample function being record' )

def sample_function (...):

... # Manually record any other Events

from agentops import record , ActionEvent

record ( ActionEvent ( "received_user_input" )) Construya agentes de la tripulación con observabilidad con solo 2 líneas de código. Simplemente establezca un AGENTOPS_API_KEY en su entorno, y sus equipos obtendrán monitoreo automático en el tablero de agentes.

pip install ' crewai[agentops] ' Con solo dos líneas de código, agregue la observabilidad completa y el monitoreo a los agentes de autógenos. Establezca un AGENTOPS_API_KEY en su entorno y llame agentops.init()

Agenteps funciona a la perfección con aplicaciones construidas con Langchain. Para usar el controlador, instale langchain como una dependencia opcional:

pip install agentops[langchain]Para usar el controlador, importar y establecer

import os

from langchain . chat_models import ChatOpenAI

from langchain . agents import initialize_agent , AgentType

from agentops . partners . langchain_callback_handler import LangchainCallbackHandler

AGENTOPS_API_KEY = os . environ [ 'AGENTOPS_API_KEY' ]

handler = LangchainCallbackHandler ( api_key = AGENTOPS_API_KEY , tags = [ 'Langchain Example' ])

llm = ChatOpenAI ( openai_api_key = OPENAI_API_KEY ,

callbacks = [ handler ],

model = 'gpt-3.5-turbo' )

agent = initialize_agent ( tools ,

llm ,

agent = AgentType . CHAT_ZERO_SHOT_REACT_DESCRIPTION ,

verbose = True ,

callbacks = [ handler ], # You must pass in a callback handler to record your agent

handle_parsing_errors = True )Consulte el cuaderno de ejemplos de Langchain para obtener más detalles, incluidos los manejadores de async.

Soporte de primera clase para Cohere (> = 5.4.0). Esta es una integración viva, si necesita alguna funcionalidad adicional, ¡envíenos un mensaje en Discord!

pip install cohere import cohere

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

co = cohere . Client ()

chat = co . chat (

message = "Is it pronounced ceaux-hear or co-hehray?"

)

print ( chat )

agentops . end_session ( 'Success' ) import cohere

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

co = cohere . Client ()

stream = co . chat_stream (

message = "Write me a haiku about the synergies between Cohere and AgentOps"

)

for event in stream :

if event . event_type == "text-generation" :

print ( event . text , end = '' )

agentops . end_session ( 'Success' )Agentes de seguimiento construidos con el SDK de Python antrópico (> = 0.32.0).

pip install anthropic import anthropic

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = anthropic . Anthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

message = client . messages . create (

max_tokens = 1024 ,

messages = [

{

"role" : "user" ,

"content" : "Tell me a cool fact about AgentOps" ,

}

],

model = "claude-3-opus-20240229" ,

)

print ( message . content )

agentops . end_session ( 'Success' )Transmisión

import anthropic

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = anthropic . Anthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

stream = client . messages . create (

max_tokens = 1024 ,

model = "claude-3-opus-20240229" ,

messages = [

{

"role" : "user" ,

"content" : "Tell me something cool about streaming agents" ,

}

],

stream = True ,

)

response = ""

for event in stream :

if event . type == "content_block_delta" :

response += event . delta . text

elif event . type == "message_stop" :

print ( " n " )

print ( response )

print ( " n " )Asíncrata

import asyncio

from anthropic import AsyncAnthropic

client = AsyncAnthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

async def main () -> None :

message = await client . messages . create (

max_tokens = 1024 ,

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async agents" ,

}

],

model = "claude-3-opus-20240229" ,

)

print ( message . content )

await main ()Agentes de seguimiento construidos con el SDK de Python antrópico (> = 0.32.0).

pip install mistralaiSincronización

from mistralai import Mistral

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

message = client . chat . complete (

messages = [

{

"role" : "user" ,

"content" : "Tell me a cool fact about AgentOps" ,

}

],

model = "open-mistral-nemo" ,

)

print ( message . choices [ 0 ]. message . content )

agentops . end_session ( 'Success' )Transmisión

from mistralai import Mistral

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

message = client . chat . stream (

messages = [

{

"role" : "user" ,

"content" : "Tell me something cool about streaming agents" ,

}

],

model = "open-mistral-nemo" ,

)

response = ""

for event in message :

if event . data . choices [ 0 ]. finish_reason == "stop" :

print ( " n " )

print ( response )

print ( " n " )

else :

response += event . text

agentops . end_session ( 'Success' )Asíncrata

import asyncio

from mistralai import Mistral

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

async def main () -> None :

message = await client . chat . complete_async (

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async agents" ,

}

],

model = "open-mistral-nemo" ,

)

print ( message . choices [ 0 ]. message . content )

await main ()Transmisión de asíncrono

import asyncio

from mistralai import Mistral

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

async def main () -> None :

message = await client . chat . stream_async (

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async streaming agents" ,

}

],

model = "open-mistral-nemo" ,

)

response = ""

async for event in message :

if event . data . choices [ 0 ]. finish_reason == "stop" :

print ( " n " )

print ( response )

print ( " n " )

else :

response += event . text

await main ()Agenteps proporciona soporte para litellm (> = 1.3.1), lo que le permite llamar a más de 100 LLM utilizando el mismo formato de entrada/salida.

pip install litellm # Do not use LiteLLM like this

# from litellm import completion

# ...

# response = completion(model="claude-3", messages=messages)

# Use LiteLLM like this

import litellm

...

response = litellm . completion ( model = "claude-3" , messages = messages )

# or

response = await litellm . acompletion ( model = "claude-3" , messages = messages )Agenteps funciona a la perfección con aplicaciones construidas con Llamaindex, un marco para construir aplicaciones generativas de IA generadas con contexto con LLM.

pip install llama-index-instrumentation-agentopsPara usar el controlador, importar y establecer

from llama_index . core import set_global_handler

# NOTE: Feel free to set your AgentOps environment variables (e.g., 'AGENTOPS_API_KEY')

# as outlined in the AgentOps documentation, or pass the equivalent keyword arguments

# anticipated by AgentOps' AOClient as **eval_params in set_global_handler.

set_global_handler ( "agentops" )Echa un vistazo a los documentos de Llamaindex para obtener más detalles.

¡Pruébalo!

(¡muy pronto!)

| Plataforma | Panel | Evals |

|---|---|---|

| ✅ Python SDK | ✅ Métricas de sesión y sesión multisesión | ✅ Métricas de evaluación personalizadas |

| ? API de constructor de evaluaciones | ✅ Seguimiento de etiquetas de evento personalizado | Cuadros de puntaje del agente |

| ✅ JavaScript/TypeScript SDK | ✅ repeticiones de la sesión | Evaluation Playground + Raeperboard |

| Prueba de rendimiento | Entornos | Pruebas de LLM | Pruebas de razonamiento y ejecución |

|---|---|---|---|

| ✅ Análisis de latencia de eventos | Pruebas de entorno no estacionarias | LLM Detección de funciones no deterministas | ? Bucles infinitos y detección de pensamiento recursivo |

| ✅ Precios de ejecución del flujo de trabajo del agente | Entornos multimodales | ? Banderas de desbordamiento del límite de token | Detección de razonamiento defectuoso |

| ? Validadores de éxito (externo) | Contenedores de ejecución | Banderas de desbordamiento del límite de contexto | Validadores de código generativo |

| Controladores de agentes/pruebas de habilidad | ✅ Detección de inyección de honeypot y pronta (prompensarmor) | Seguimiento de facturas de API | Análisis de punto de interrupción de errores |

| Prueba de restricción de contexto de información | Obstáculos anti-agentes (es decir, Captchas) | Verificaciones de integración de CI/CD | |

| Prueba de regresión | Visualización marco de múltiples agentes |

Sin las herramientas adecuadas, los agentes de IA son lentos, caros y poco confiables. Nuestra misión es llevar a su agente del prototipo a la producción. He aquí por qué Agenteps se destaca:

Agenteps está diseñado para facilitar la observabilidad del agente, las pruebas y el monitoreo.

Echa un vistazo a nuestro crecimiento en la comunidad:

| Repositorio | Estrellas |

|---|---|

| geekan / metagpt | 42787 |

| run-llama / llama_index | 34446 |

| Crewaiinc / Crewai | 18287 |

| camel-ai / camello | 5166 |

| supergente-ai / supergente | 5050 |

| Iyaja / Llama-fs | 4713 |

| Hardware basado / OMI | 2723 |

| Mervinpraison / Praisonai | 2007 |

| Agenteps-ai / jaiqu | 272 |

| Strnad / Crewai-Studio | 134 |

| Alejandro-ao / exa-crewai | 55 |

| tonykipkemboi / youtube_yapper_trapperer | 47 |

| Sethcoast / Cover-letter-constructor | 27 |

| bhancockio / chatgpt4o-análisis | 19 |

| ruptura / agente_story_book_workflow | 14 |

| Multi-en / multion-Python | 13 |

Generado con GitHub-Dependents-Info, por Nicolas Vuillamy