Agentops hilft Entwicklern dabei, KI -Agenten aufzubauen, zu bewerten und zu überwachen. Vom Prototyp bis zur Produktion.

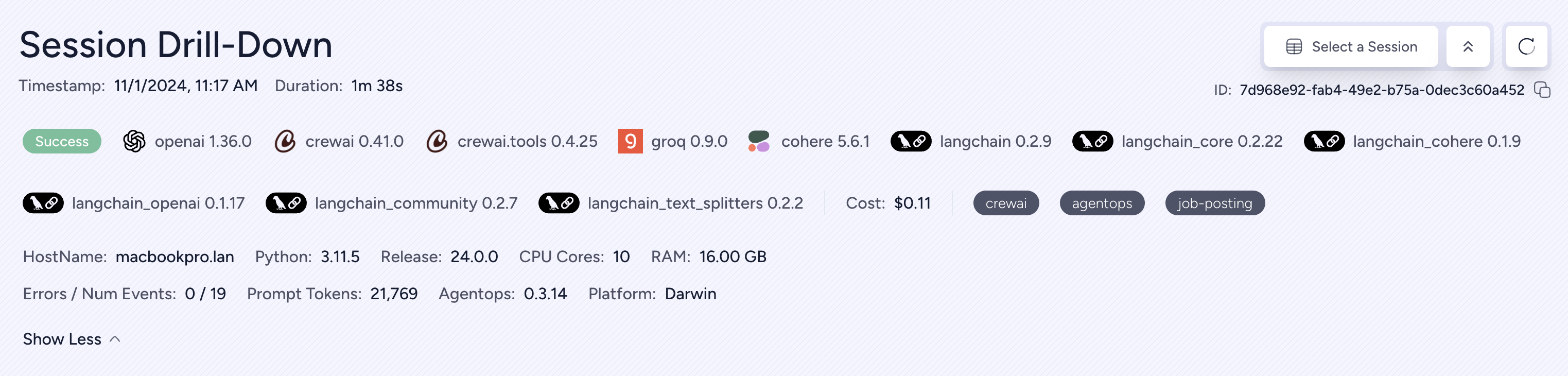

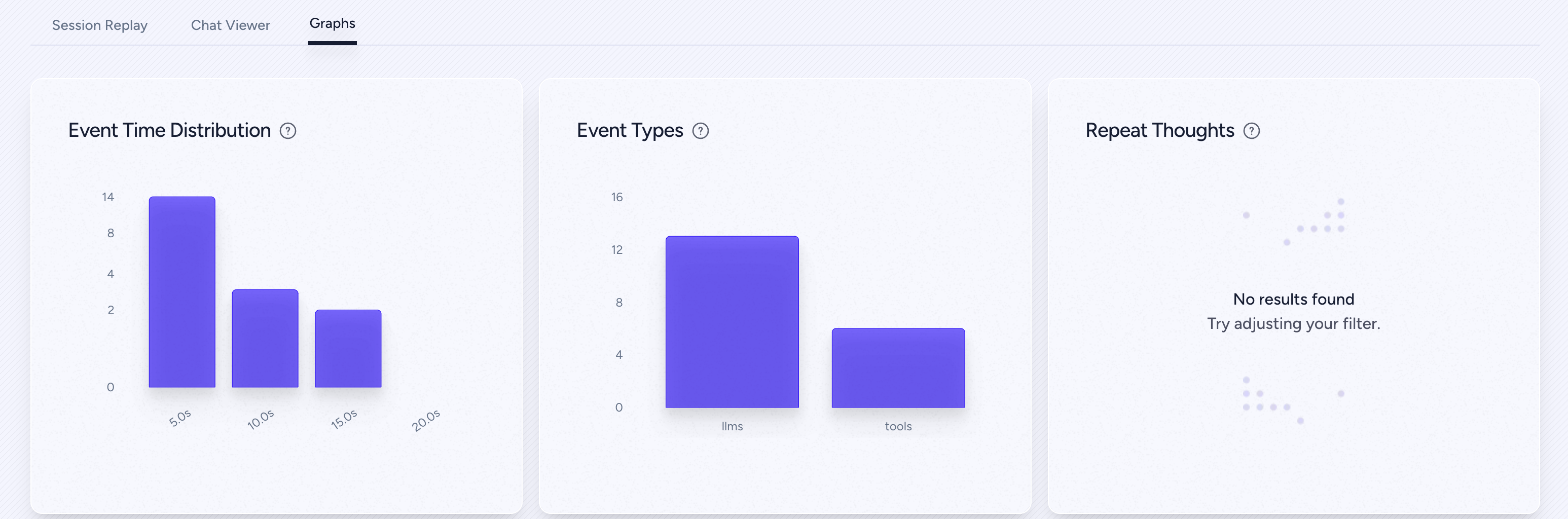

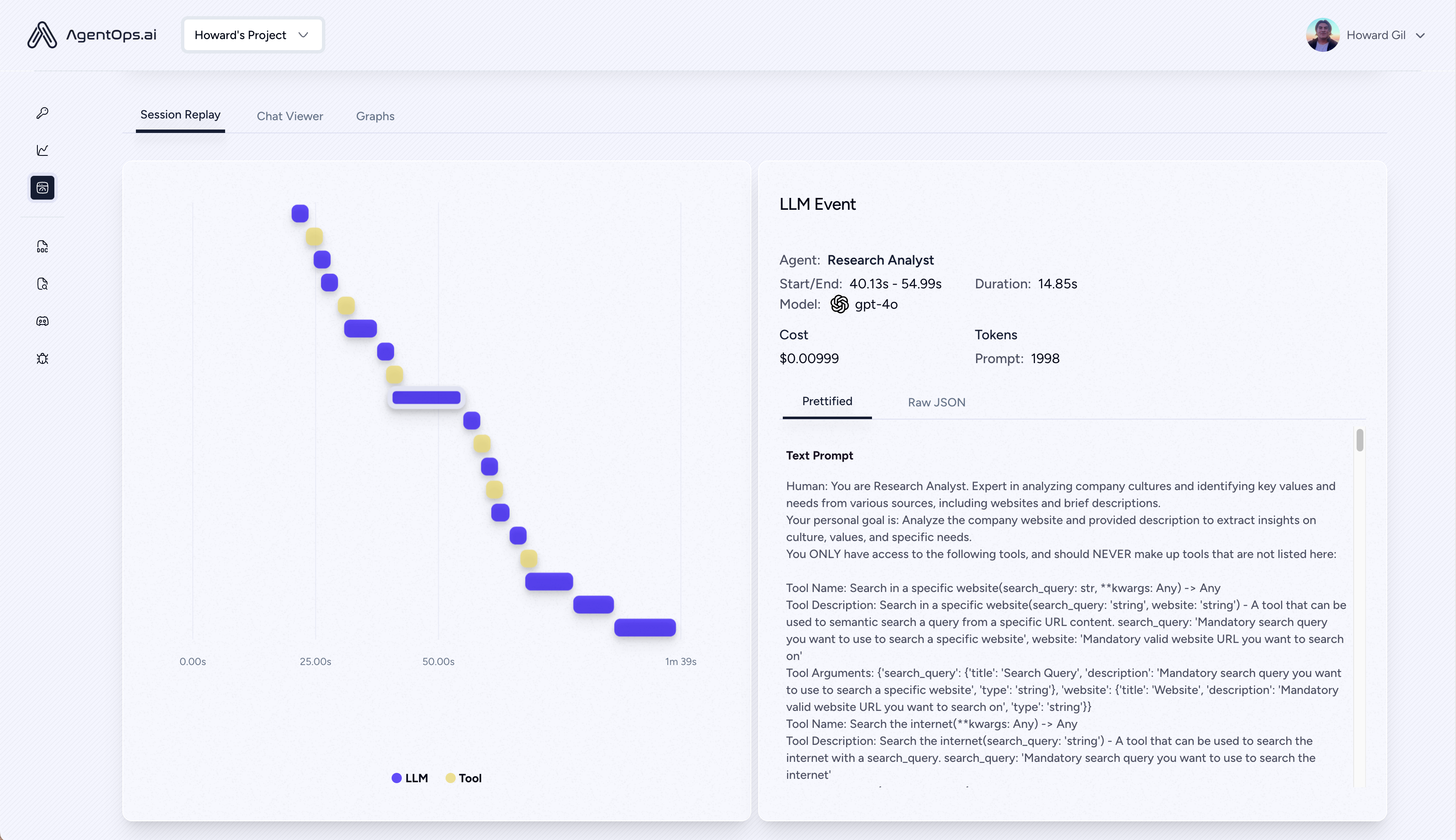

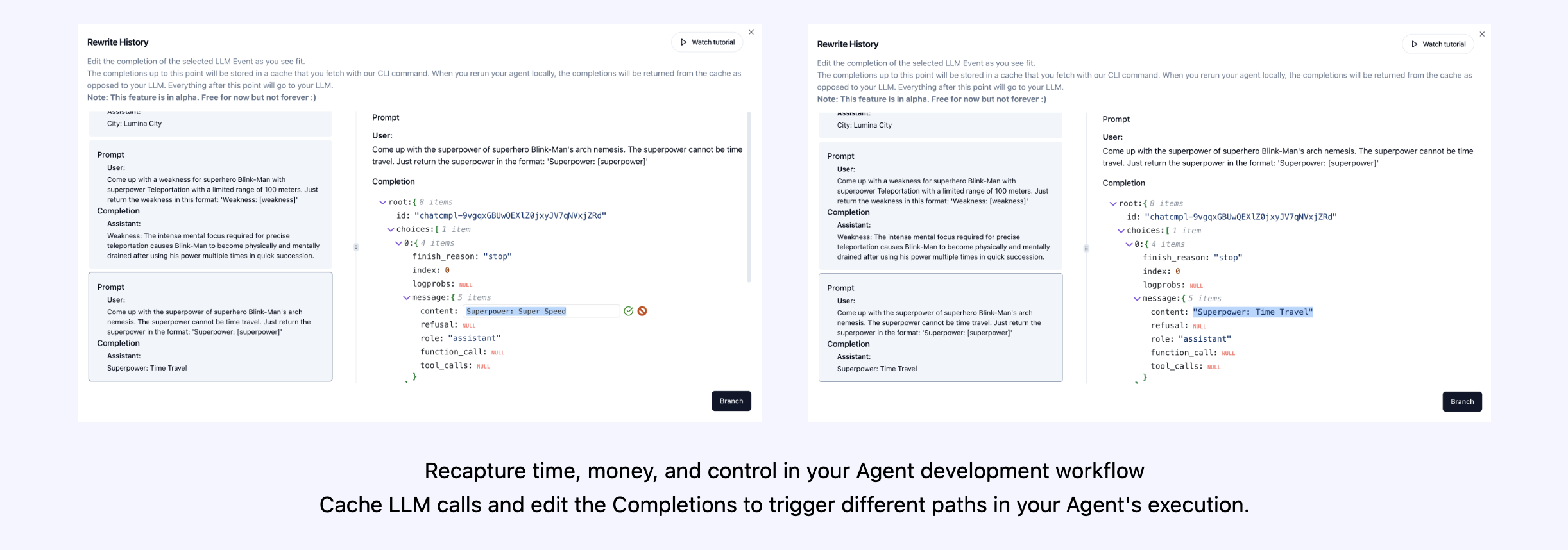

| Wiederholungsanalyse und Debugging | Schritt-für-Schritt-Agentenausführungsdiagramme |

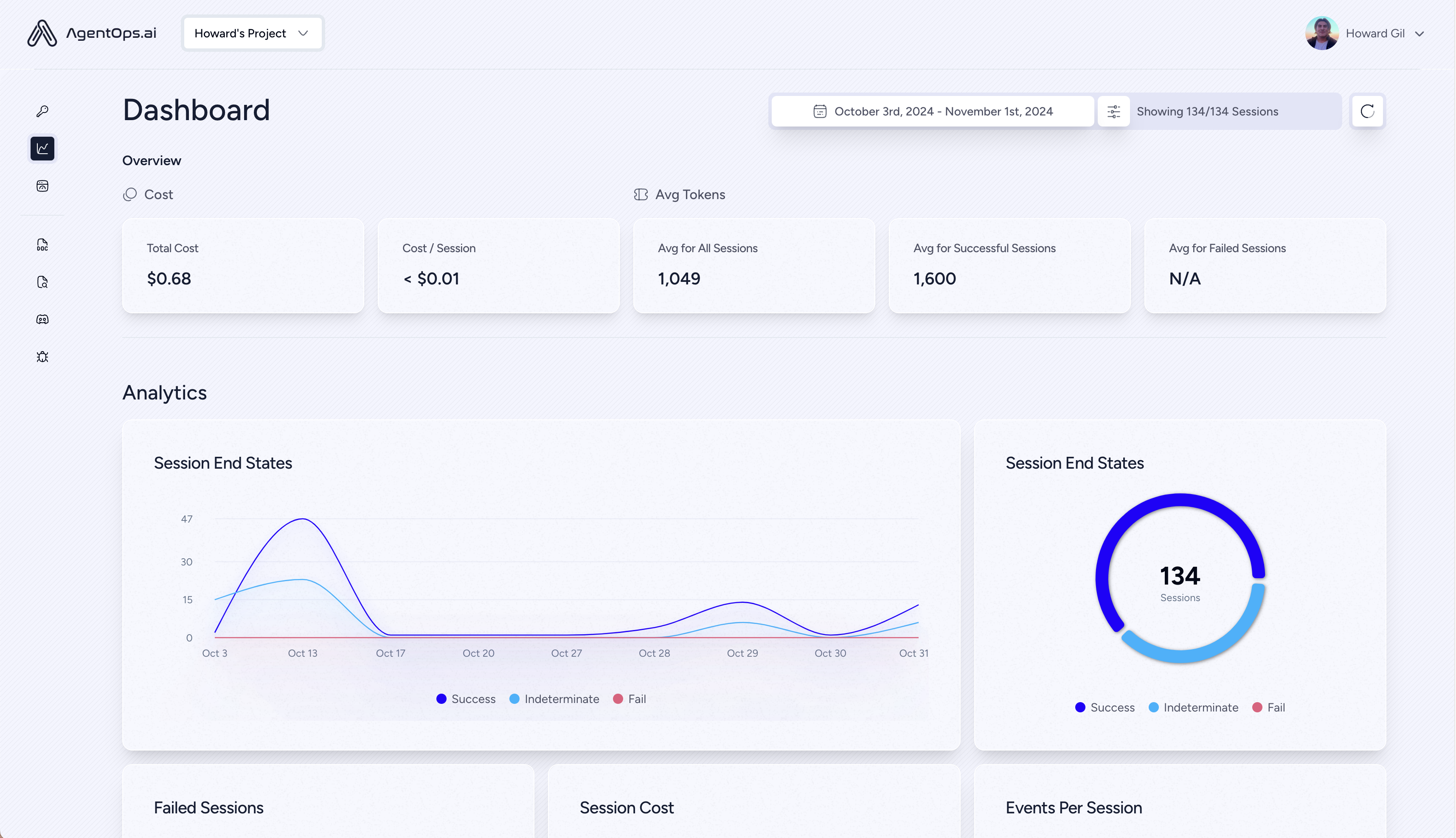

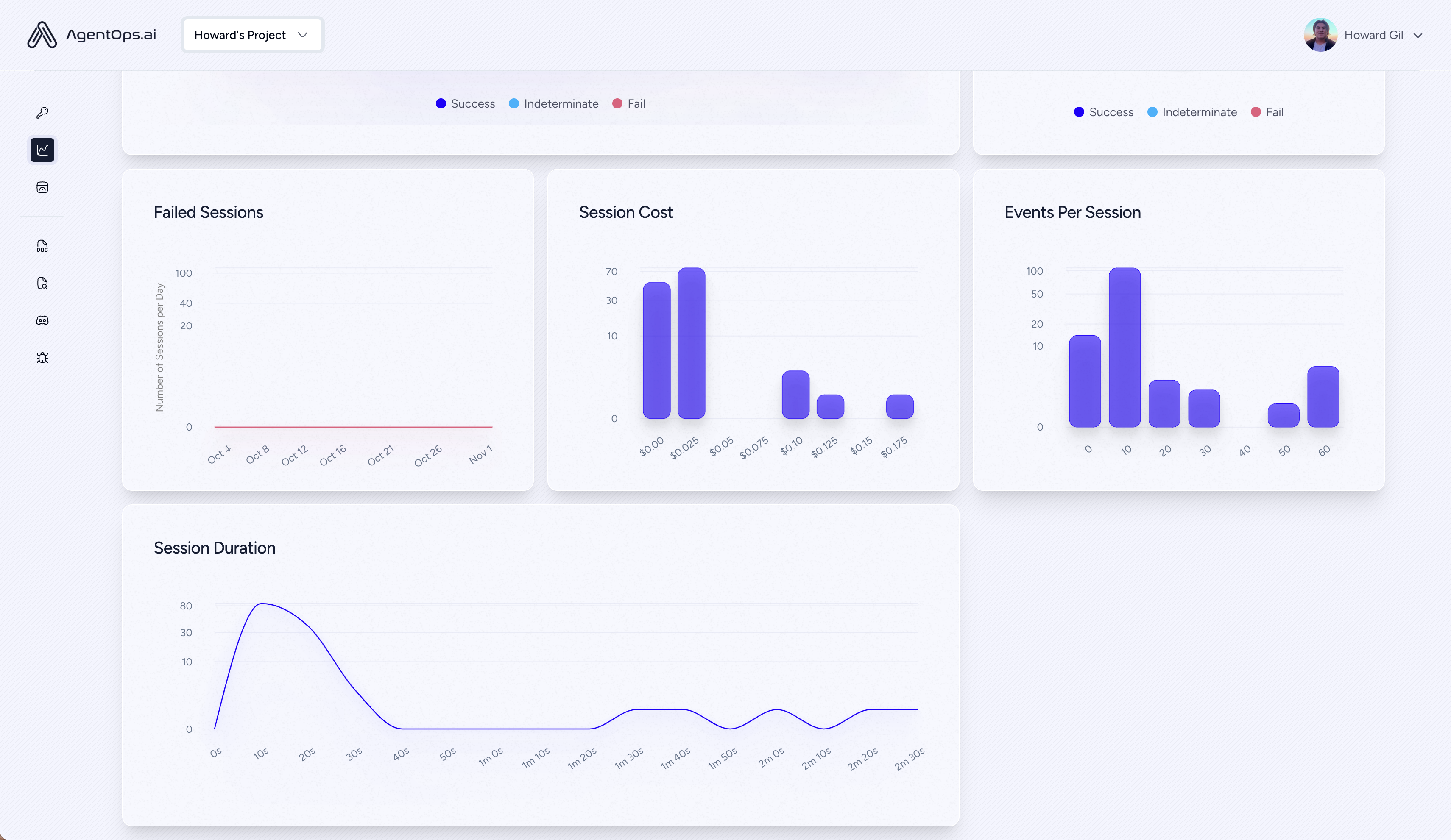

| ? LLM Kostenmanagement | Track -Ausgaben mit LLM Foundation Model Providers |

| ? Agenten -Benchmarking | Testen Sie Ihre Agenten gegen 1.000 Evals |

| ? Konformität und Sicherheit | Erkennen Sie gemeinsame Einspritz- und Daten -Exfiltrationssendungen zur Eingabeaufforderung und Daten |

| ? Framework -Integrationen | Native Integrationen mit Crewai, Autogen & Langchain |

pip install agentopsInitialisieren Sie den AgentOps -Client und erhalten Sie automatisch Analysen für alle Ihre LLM -Anrufe.

Holen Sie sich einen API -Schlüssel

import agentops

# Beginning of your program (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

...

# End of program

agentops . end_session ( 'Success' ) Alle Ihre Sitzungen können auf dem Agentops Dashboard angezeigt werden

Fügen Sie Ihren Agenten, Tools und Funktionen mit so wenig Code wie möglich eine leistungsstarke Beobachtbarkeit hinzu: jeweils eine Zeile.

Siehe unsere Dokumentation

# Automatically associate all Events with the agent that originated them

from agentops import track_agent

@ track_agent ( name = 'SomeCustomName' )

class MyAgent :

... # Automatically create ToolEvents for tools that agents will use

from agentops import record_tool

@ record_tool ( 'SampleToolName' )

def sample_tool (...):

... # Automatically create ActionEvents for other functions.

from agentops import record_action

@ agentops . record_action ( 'sample function being record' )

def sample_function (...):

... # Manually record any other Events

from agentops import record , ActionEvent

record ( ActionEvent ( "received_user_input" )) Bauen Sie Besatzungsmittel mit Beobachtbarkeit mit nur 2 Codezeilen auf. Legen Sie einfach einen AGENTOPS_API_KEY in Ihre Umgebung ein, und Ihre Crews erhalten eine automatische Überwachung auf dem AgentOps -Dashboard.

pip install ' crewai[agentops] ' Fügen Sie mit nur zwei Codezeilen den Autogen -Mitteln die volle Beobachtbarkeit und Überwachung hinzu. Legen Sie einen AGENTOPS_API_KEY in Ihrer Umgebung fest und rufen Sie agentops.init() ein.

Agentops arbeitet nahtlos mit Anwendungen, die mit Langchain erstellt wurden. Um den Handler zu verwenden, installieren Sie Langchain als optionale Abhängigkeit:

pip install agentops[langchain]Um den Handler zu verwenden, importieren und einstellen

import os

from langchain . chat_models import ChatOpenAI

from langchain . agents import initialize_agent , AgentType

from agentops . partners . langchain_callback_handler import LangchainCallbackHandler

AGENTOPS_API_KEY = os . environ [ 'AGENTOPS_API_KEY' ]

handler = LangchainCallbackHandler ( api_key = AGENTOPS_API_KEY , tags = [ 'Langchain Example' ])

llm = ChatOpenAI ( openai_api_key = OPENAI_API_KEY ,

callbacks = [ handler ],

model = 'gpt-3.5-turbo' )

agent = initialize_agent ( tools ,

llm ,

agent = AgentType . CHAT_ZERO_SHOT_REACT_DESCRIPTION ,

verbose = True ,

callbacks = [ handler ], # You must pass in a callback handler to record your agent

handle_parsing_errors = True )Weitere Informationen finden Sie im Langchain -Beispiel -Notizbuch für weitere Details, einschließlich Async -Handler.

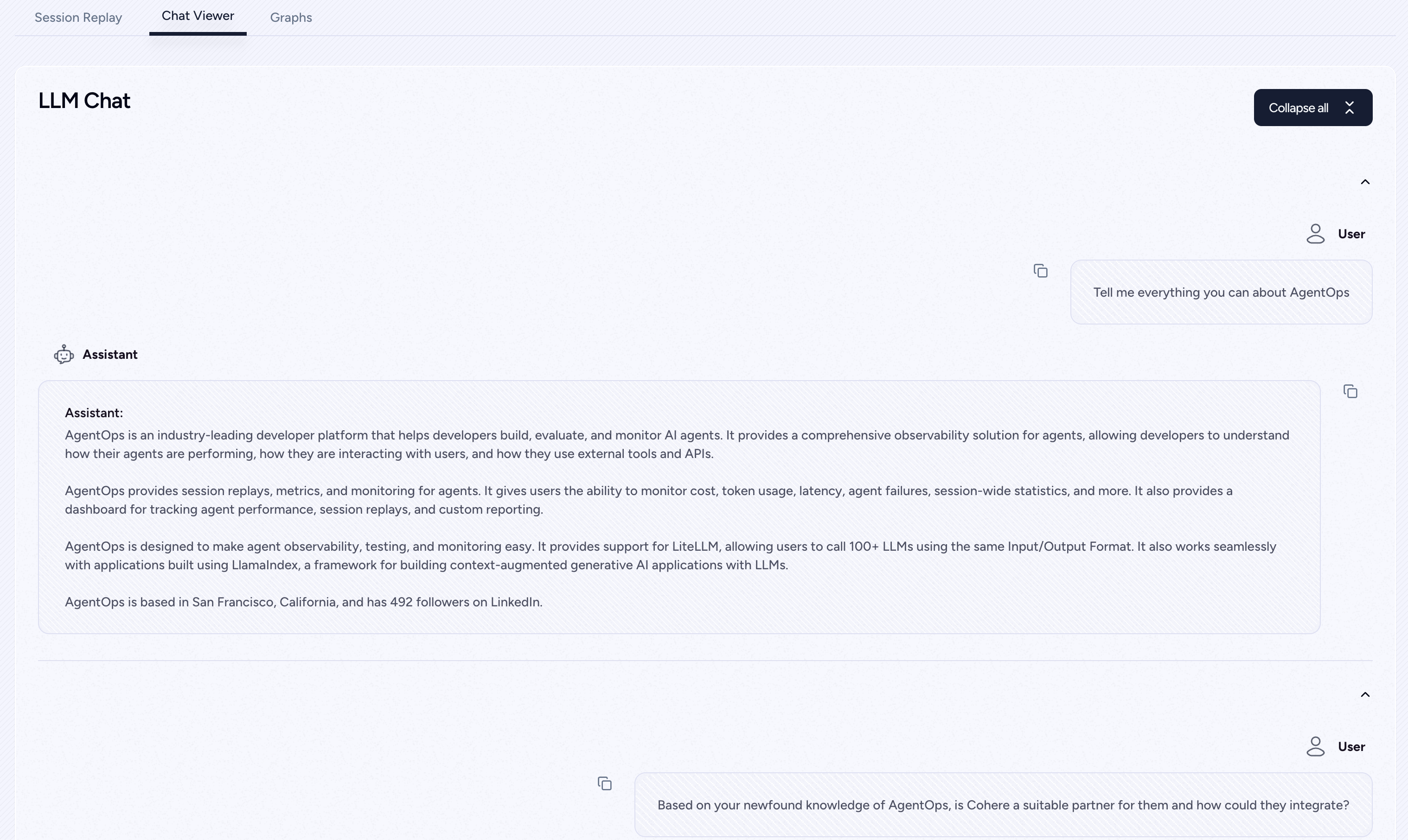

Erste Klasse Unterstützung für Cohere (> = 5.4.0). Dies ist eine lebendige Integration, falls Sie zusätzliche Funktionen benötigen, bitte senden Sie uns eine Nachricht auf Discord!

pip install cohere import cohere

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

co = cohere . Client ()

chat = co . chat (

message = "Is it pronounced ceaux-hear or co-hehray?"

)

print ( chat )

agentops . end_session ( 'Success' ) import cohere

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

co = cohere . Client ()

stream = co . chat_stream (

message = "Write me a haiku about the synergies between Cohere and AgentOps"

)

for event in stream :

if event . event_type == "text-generation" :

print ( event . text , end = '' )

agentops . end_session ( 'Success' )Track -Agenten, die mit dem anthropischen Python SDK (> = 0,32,0) gebaut wurden.

pip install anthropic import anthropic

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = anthropic . Anthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

message = client . messages . create (

max_tokens = 1024 ,

messages = [

{

"role" : "user" ,

"content" : "Tell me a cool fact about AgentOps" ,

}

],

model = "claude-3-opus-20240229" ,

)

print ( message . content )

agentops . end_session ( 'Success' )Streaming

import anthropic

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = anthropic . Anthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

stream = client . messages . create (

max_tokens = 1024 ,

model = "claude-3-opus-20240229" ,

messages = [

{

"role" : "user" ,

"content" : "Tell me something cool about streaming agents" ,

}

],

stream = True ,

)

response = ""

for event in stream :

if event . type == "content_block_delta" :

response += event . delta . text

elif event . type == "message_stop" :

print ( " n " )

print ( response )

print ( " n " )Asynchron

import asyncio

from anthropic import AsyncAnthropic

client = AsyncAnthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

async def main () -> None :

message = await client . messages . create (

max_tokens = 1024 ,

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async agents" ,

}

],

model = "claude-3-opus-20240229" ,

)

print ( message . content )

await main ()Track -Agenten, die mit dem anthropischen Python SDK (> = 0,32,0) gebaut wurden.

pip install mistralaiSynchronisation

from mistralai import Mistral

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

message = client . chat . complete (

messages = [

{

"role" : "user" ,

"content" : "Tell me a cool fact about AgentOps" ,

}

],

model = "open-mistral-nemo" ,

)

print ( message . choices [ 0 ]. message . content )

agentops . end_session ( 'Success' )Streaming

from mistralai import Mistral

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

message = client . chat . stream (

messages = [

{

"role" : "user" ,

"content" : "Tell me something cool about streaming agents" ,

}

],

model = "open-mistral-nemo" ,

)

response = ""

for event in message :

if event . data . choices [ 0 ]. finish_reason == "stop" :

print ( " n " )

print ( response )

print ( " n " )

else :

response += event . text

agentops . end_session ( 'Success' )Asynchron

import asyncio

from mistralai import Mistral

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

async def main () -> None :

message = await client . chat . complete_async (

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async agents" ,

}

],

model = "open-mistral-nemo" ,

)

print ( message . choices [ 0 ]. message . content )

await main ()Asynchrones Streaming

import asyncio

from mistralai import Mistral

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

async def main () -> None :

message = await client . chat . stream_async (

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async streaming agents" ,

}

],

model = "open-mistral-nemo" ,

)

response = ""

async for event in message :

if event . data . choices [ 0 ]. finish_reason == "stop" :

print ( " n " )

print ( response )

print ( " n " )

else :

response += event . text

await main ()AgentOPs unterstützt LitellM (> = 1.3.1), sodass Sie 100+ LLMs mit demselben Eingangs-/Ausgangsformat aufrufen können.

pip install litellm # Do not use LiteLLM like this

# from litellm import completion

# ...

# response = completion(model="claude-3", messages=messages)

# Use LiteLLM like this

import litellm

...

response = litellm . completion ( model = "claude-3" , messages = messages )

# or

response = await litellm . acompletion ( model = "claude-3" , messages = messages )Agentops arbeitet nahtlos mit Anwendungen zusammen, die mit Lamaindex erstellt wurden, einem Rahmen für den Erstellen von kontextversorgten generativen AI-Anwendungen mit LLMs.

pip install llama-index-instrumentation-agentopsUm den Handler zu verwenden, importieren und einstellen

from llama_index . core import set_global_handler

# NOTE: Feel free to set your AgentOps environment variables (e.g., 'AGENTOPS_API_KEY')

# as outlined in the AgentOps documentation, or pass the equivalent keyword arguments

# anticipated by AgentOps' AOClient as **eval_params in set_global_handler.

set_global_handler ( "agentops" )Weitere Informationen finden Sie in den Lamaindex -Dokumenten.

Probieren Sie es aus!

(bald kommen!)

| Plattform | Armaturenbrett | Evale |

|---|---|---|

| ✅ Python SDK | ✅ Metriken mit mehreren Sitzungen und Quersitzungen | ✅ benutzerdefinierte Evalmetriken |

| ? Evaluation Builder API | ✅ Benutzerdefinierte Ereignis -Tag -Tracking | Agent Scorecards |

| ✅ JavaScript/TypeScript SDK | ✅ Sitzung Wiederholungen | Bewertungsspielplatz + Rangliste |

| Leistungstests | Umgebungen | LLM -Tests | Argumentations- und Ausführungstests |

|---|---|---|---|

| ✅ Ereignislatenzanalyse | Nicht-stationäre Umgebungstests | LLM nicht deterministische Funktionserkennung | ? Unendliche Schleifen und rekursive Gedankenerkennung |

| ✅ Preisgestaltung zur Ausführung von Agenten Workflows | Multimodale Umgebungen | ? Token Limit Overflow Flags | Fehlerhafte Argumentationserkennung |

| ? Erfolgsvalidatoren (extern) | Ausführungsbehälter | Kontextgrenze Überlaufflaggen | Generative Code -Validatoren |

| Agentencontroller/Skill -Tests | ✅ Honeypot und Einspritzerkennung (Eingabeaufforderung) | API Bill Tracking | Fehler -Breakpoint -Analyse |

| Informationskontextbeschränkungstests | Anti-Agent-Straßensperren (dh Captchas) | CI/CD -Integrationsprüfungen | |

| Regressionstests | Multi-Agent-Framework-Visualisierung |

Ohne die richtigen Werkzeuge sind KI -Agenten langsam, teuer und unzuverlässig. Unsere Mission ist es, Ihren Agenten vom Prototyp zur Produktion zu bringen. Hier ist der Grund, warum Agentops auffällt:

Agentops ist so konzipiert, dass die Agentenbeobachtbarkeit, das Testen und die Überwachung einfach ist.

Schauen Sie sich unser Wachstum in der Gemeinschaft an:

| Repository | Sterne |

|---|---|

| Geekan / Metagpt | 42787 |

| run-llama / llama_index | 34446 |

| Crewaiinc / Crewai | 18287 |

| Kamel-ai / Kamel | 5166 |

| Superagent-ai / Superagent | 5050 |

| Iyaja / lama-fs | 4713 |

| Basierend Hardware / Omi | 2723 |

| Mervinpraison / Praisonai | 2007 |

| Agentops-AI / Jaiqu | 272 |

| Strnad / Crewai-Studio | 134 |

| Alejandro-ao / exa-crewai | 55 |

| tonykipkemboi / youtube_yapper_trapper | 47 |

| Sethcoast / Cover-Letter-Builder | 27 |

| Bhancockio / Chatgpt4O-Analyse | 19 |

| breakstring / agentic_story_book_workflow | 14 |

| Multi-ON / MULTION-PYTHON | 13 |

Erzeugt mit Github-Abhängigkeit-Info von Nicolas Vuillamy