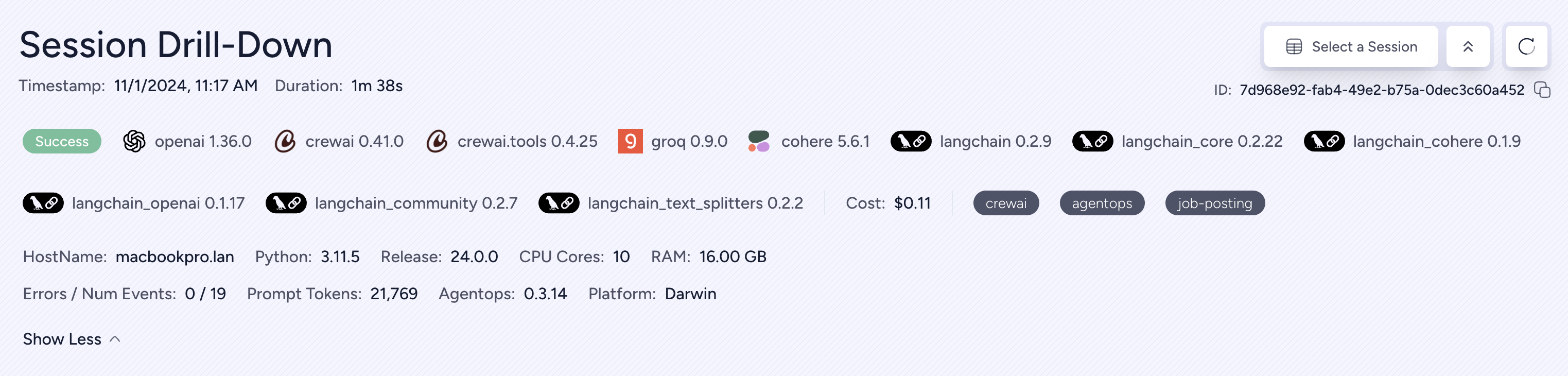

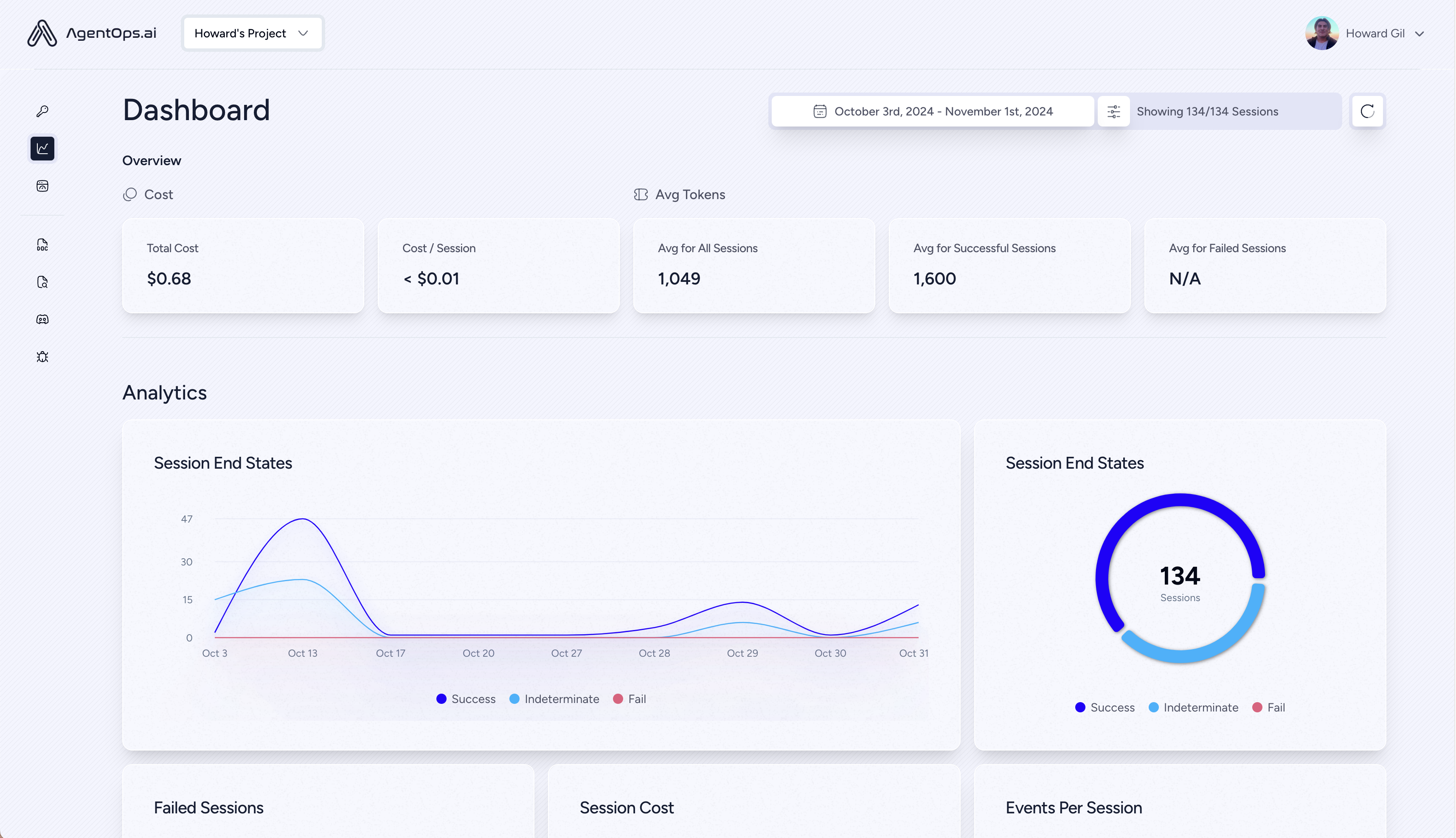

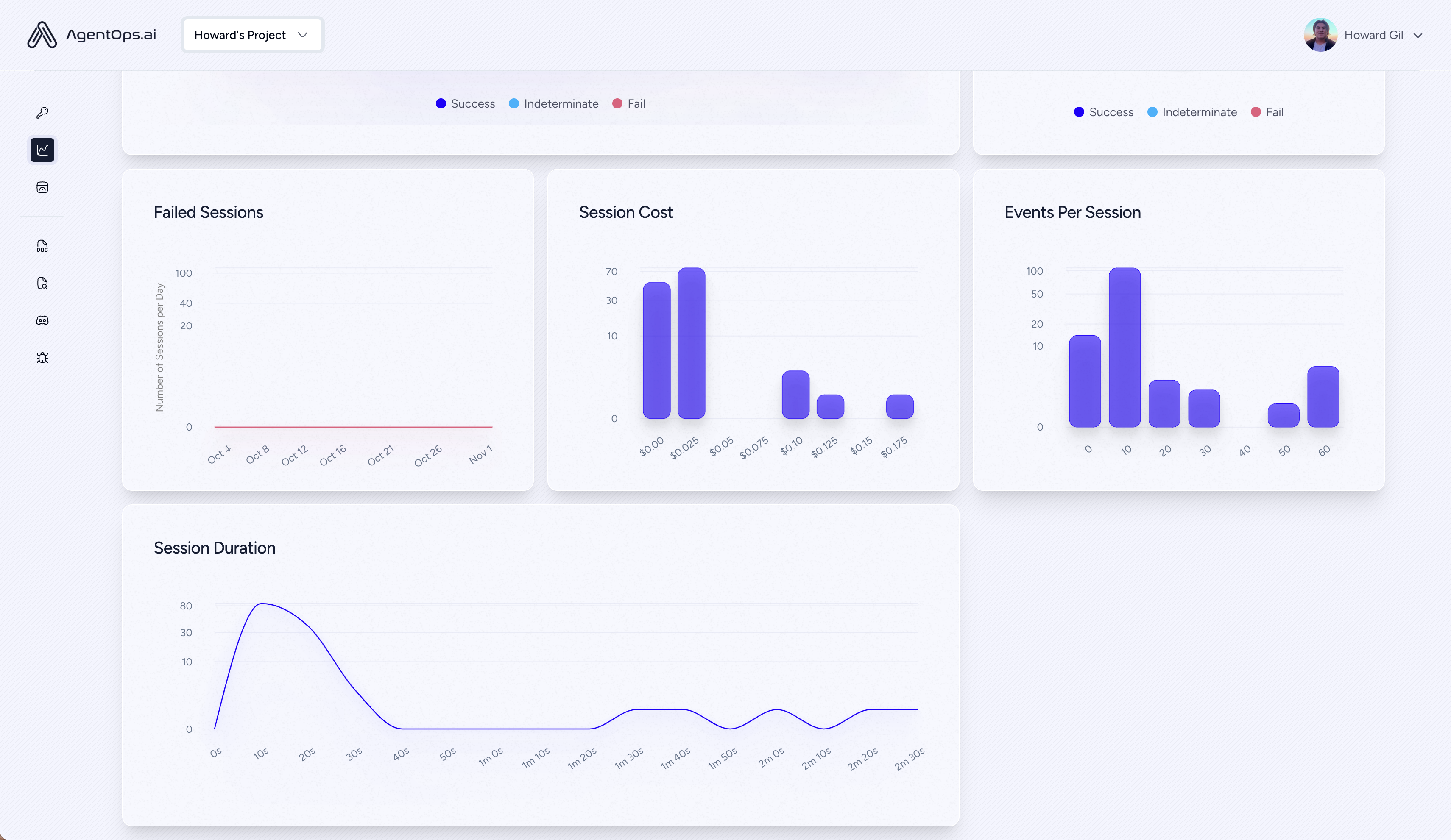

يساعد AgentOps المطورين على بناء وتقييم ومراقبة وكلاء الذكاء الاصطناعي. من النموذج الأولي إلى الإنتاج.

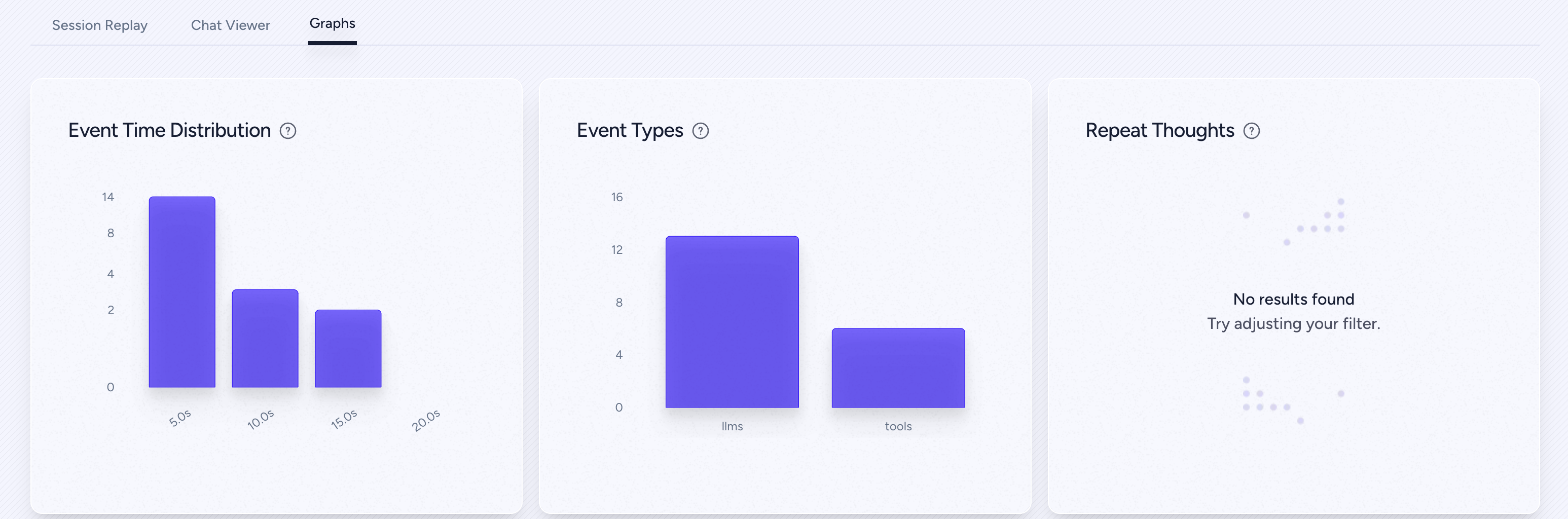

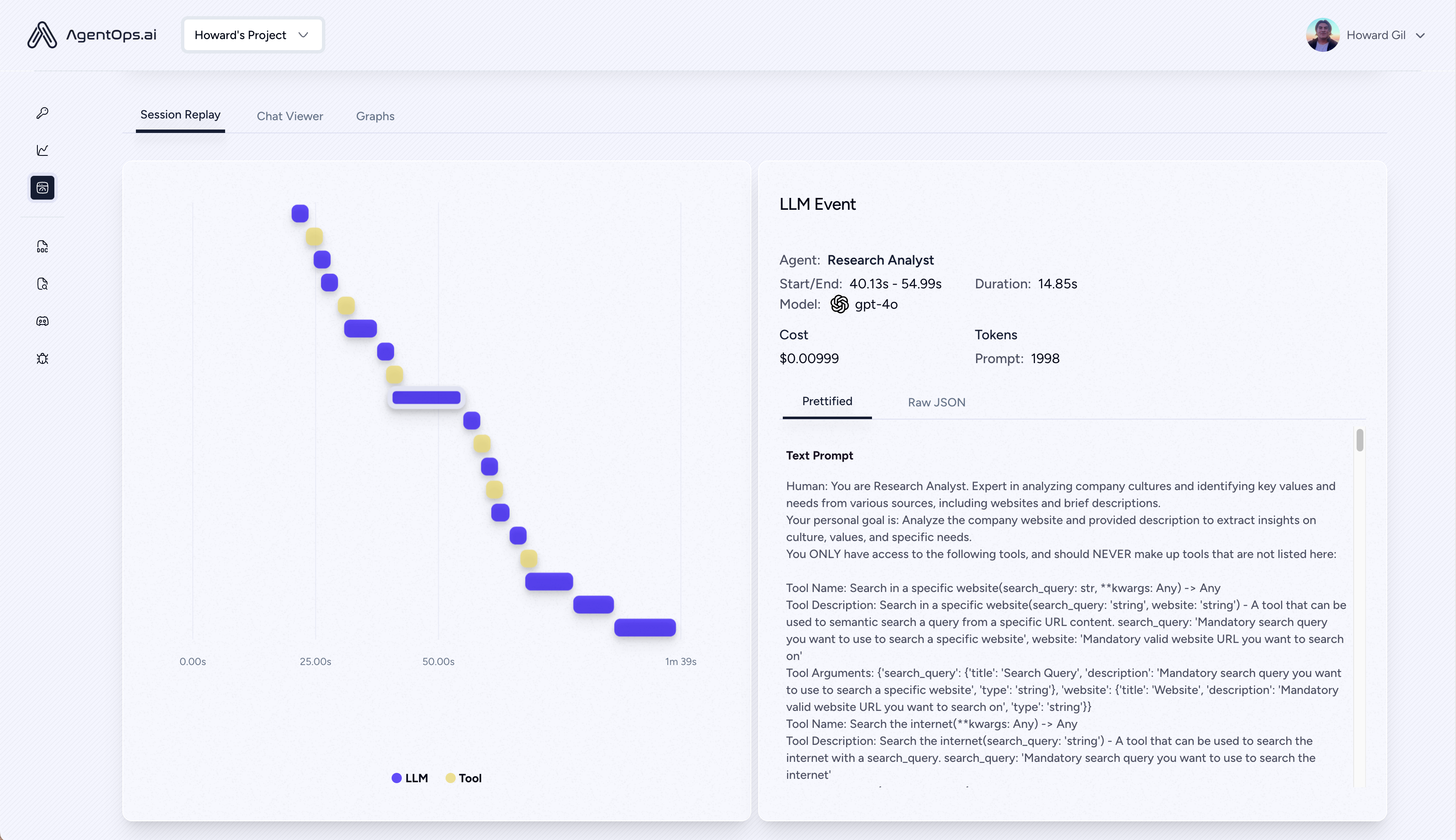

| إعادة تحليل التحليلات وتصحيح الأخطاء | الرسوم البيانية لتنفيذ الوكيل خطوة بخطوة |

| ؟ LLM إدارة التكلفة | تتبع الإنفاق مع موفري نموذج الأساس LLM |

| ؟ وكيل المعايير | اختبر وكلاءك مقابل أكثر من 1000 evals |

| ؟ الامتثال والأمن | اكتشف الحقن السريع الشائع واتجاهات البيانات |

| ؟ تكامل الإطار | التكامل الأصلي مع Crewai و Autogen و Langchain |

pip install agentopsتهيئة عميل AgentOps والحصول على تحليلات تلقائيًا على جميع مكالمات LLM الخاصة بك.

احصل على مفتاح API

import agentops

# Beginning of your program (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

...

# End of program

agentops . end_session ( 'Success' ) يمكن مشاهدة جميع جلساتك على لوحة معلومات AgentOps

أضف قابلية الملاحظة القوية إلى وكلاءك وأدواتك ووظائفك مع كل رمز صغير قدر الإمكان: سطر واحد في وقت واحد.

الرجوع إلى وثائقنا

# Automatically associate all Events with the agent that originated them

from agentops import track_agent

@ track_agent ( name = 'SomeCustomName' )

class MyAgent :

... # Automatically create ToolEvents for tools that agents will use

from agentops import record_tool

@ record_tool ( 'SampleToolName' )

def sample_tool (...):

... # Automatically create ActionEvents for other functions.

from agentops import record_action

@ agentops . record_action ( 'sample function being record' )

def sample_function (...):

... # Manually record any other Events

from agentops import record , ActionEvent

record ( ActionEvent ( "received_user_input" )) بناء وكلاء الطاقم مع الملاحظة مع 2 سطرة فقط من الكود. ما عليك سوى تعيين AGENTOPS_API_KEY في بيئتك ، وستحصل أطقم الطواقم على مراقبة تلقائية على لوحة معلومات AgentOps.

pip install ' crewai[agentops] ' مع سطرين فقط من التعليمات البرمجية ، أضف قابلية الملاحظة والمراقبة إلى عوامل التوسعة التلقائية. قم بتعيين AGENTOPS_API_KEY في بيئتك و Call agentops.init()

يعمل AgentOps بسلاسة مع التطبيقات المصممة باستخدام Langchain. لاستخدام المعالج ، قم بتثبيت Langchain باعتباره تبعية اختيارية:

pip install agentops[langchain]لاستخدام المعالج والاستيراد والتعيين

import os

from langchain . chat_models import ChatOpenAI

from langchain . agents import initialize_agent , AgentType

from agentops . partners . langchain_callback_handler import LangchainCallbackHandler

AGENTOPS_API_KEY = os . environ [ 'AGENTOPS_API_KEY' ]

handler = LangchainCallbackHandler ( api_key = AGENTOPS_API_KEY , tags = [ 'Langchain Example' ])

llm = ChatOpenAI ( openai_api_key = OPENAI_API_KEY ,

callbacks = [ handler ],

model = 'gpt-3.5-turbo' )

agent = initialize_agent ( tools ,

llm ,

agent = AgentType . CHAT_ZERO_SHOT_REACT_DESCRIPTION ,

verbose = True ,

callbacks = [ handler ], # You must pass in a callback handler to record your agent

handle_parsing_errors = True )تحقق من دفتر Langchain Amprobles لمزيد من التفاصيل بما في ذلك معالجات Async.

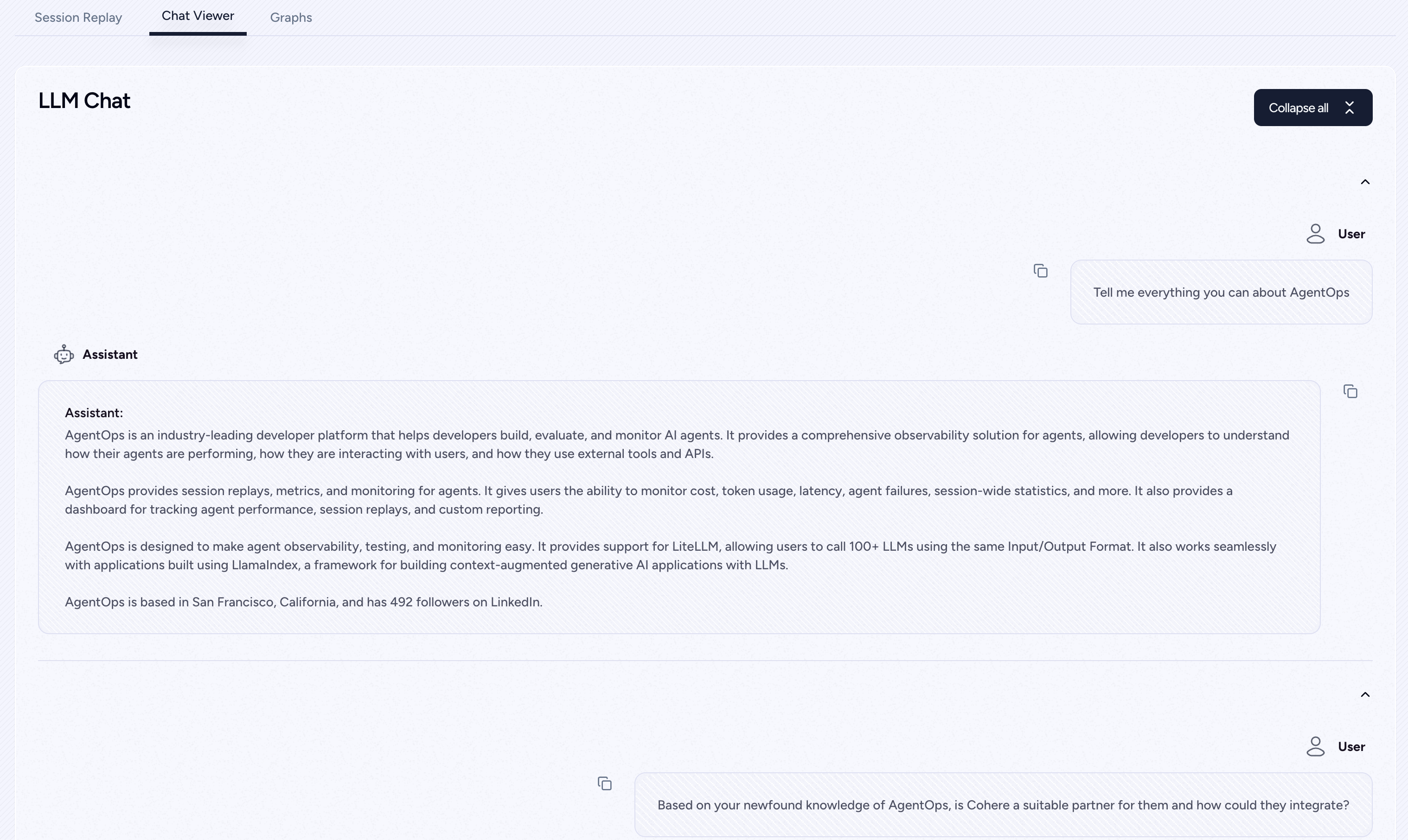

دعم من الدرجة الأولى ل coere (> = 5.4.0). هذا تكامل حي ، إذا كنت بحاجة إلى أي وظيفة إضافية ، يرجى مراسلتنا على Discord!

pip install cohere import cohere

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

co = cohere . Client ()

chat = co . chat (

message = "Is it pronounced ceaux-hear or co-hehray?"

)

print ( chat )

agentops . end_session ( 'Success' ) import cohere

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

co = cohere . Client ()

stream = co . chat_stream (

message = "Write me a haiku about the synergies between Cohere and AgentOps"

)

for event in stream :

if event . event_type == "text-generation" :

print ( event . text , end = '' )

agentops . end_session ( 'Success' )تم تصميم عوامل المسار مع Python SDK البشري (> = 0.32.0).

pip install anthropic import anthropic

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = anthropic . Anthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

message = client . messages . create (

max_tokens = 1024 ,

messages = [

{

"role" : "user" ,

"content" : "Tell me a cool fact about AgentOps" ,

}

],

model = "claude-3-opus-20240229" ,

)

print ( message . content )

agentops . end_session ( 'Success' )جاري

import anthropic

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = anthropic . Anthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

stream = client . messages . create (

max_tokens = 1024 ,

model = "claude-3-opus-20240229" ,

messages = [

{

"role" : "user" ,

"content" : "Tell me something cool about streaming agents" ,

}

],

stream = True ,

)

response = ""

for event in stream :

if event . type == "content_block_delta" :

response += event . delta . text

elif event . type == "message_stop" :

print ( " n " )

print ( response )

print ( " n " )غير متزامن

import asyncio

from anthropic import AsyncAnthropic

client = AsyncAnthropic (

# This is the default and can be omitted

api_key = os . environ . get ( "ANTHROPIC_API_KEY" ),

)

async def main () -> None :

message = await client . messages . create (

max_tokens = 1024 ,

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async agents" ,

}

],

model = "claude-3-opus-20240229" ,

)

print ( message . content )

await main ()تم تصميم عوامل المسار مع Python SDK البشري (> = 0.32.0).

pip install mistralaiالمزامنة

from mistralai import Mistral

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

message = client . chat . complete (

messages = [

{

"role" : "user" ,

"content" : "Tell me a cool fact about AgentOps" ,

}

],

model = "open-mistral-nemo" ,

)

print ( message . choices [ 0 ]. message . content )

agentops . end_session ( 'Success' )جاري

from mistralai import Mistral

import agentops

# Beginning of program's code (i.e. main.py, __init__.py)

agentops . init ( < INSERT YOUR API KEY HERE > )

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

message = client . chat . stream (

messages = [

{

"role" : "user" ,

"content" : "Tell me something cool about streaming agents" ,

}

],

model = "open-mistral-nemo" ,

)

response = ""

for event in message :

if event . data . choices [ 0 ]. finish_reason == "stop" :

print ( " n " )

print ( response )

print ( " n " )

else :

response += event . text

agentops . end_session ( 'Success' )غير متزامن

import asyncio

from mistralai import Mistral

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

async def main () -> None :

message = await client . chat . complete_async (

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async agents" ,

}

],

model = "open-mistral-nemo" ,

)

print ( message . choices [ 0 ]. message . content )

await main ()تدفق غير متزامن

import asyncio

from mistralai import Mistral

client = Mistral (

# This is the default and can be omitted

api_key = os . environ . get ( "MISTRAL_API_KEY" ),

)

async def main () -> None :

message = await client . chat . stream_async (

messages = [

{

"role" : "user" ,

"content" : "Tell me something interesting about async streaming agents" ,

}

],

model = "open-mistral-nemo" ,

)

response = ""

async for event in message :

if event . data . choices [ 0 ]. finish_reason == "stop" :

print ( " n " )

print ( response )

print ( " n " )

else :

response += event . text

await main ()يوفر AgentOps الدعم لـ Litellm (> = 1.3.1) ، مما يسمح لك بالاتصال بـ 100+ LLMs باستخدام نفس تنسيق الإدخال/الإخراج.

pip install litellm # Do not use LiteLLM like this

# from litellm import completion

# ...

# response = completion(model="claude-3", messages=messages)

# Use LiteLLM like this

import litellm

...

response = litellm . completion ( model = "claude-3" , messages = messages )

# or

response = await litellm . acompletion ( model = "claude-3" , messages = messages )يعمل AgentOps بسلاسة مع التطبيقات التي تم إنشاؤها باستخدام Llamaindex ، وهو إطار لبناء تطبيقات الذكاء الاصطناعي المتمثل في السياق مع LLMs.

pip install llama-index-instrumentation-agentopsلاستخدام المعالج والاستيراد والتعيين

from llama_index . core import set_global_handler

# NOTE: Feel free to set your AgentOps environment variables (e.g., 'AGENTOPS_API_KEY')

# as outlined in the AgentOps documentation, or pass the equivalent keyword arguments

# anticipated by AgentOps' AOClient as **eval_params in set_global_handler.

set_global_handler ( "agentops" )تحقق من مستندات Llamaindex لمزيد من التفاصيل.

جربها!

(قريباً!)

| منصة | لوحة القيادة | evals |

|---|---|---|

| ✅ Python SDK | ✅ مقاييس متعددة الجلسات والجلسة | ✅ مقاييس التقييم المخصصة |

| ؟ التقييم باني واجهة برمجة التطبيقات | ✅ تتبع علامة الحدث المخصص | بطاقات الأداء الوكيل |

| ✅ JavaScript/TypeScript SDK | ✅ استعادة الجلسة | ملعب التقييم + المتصدرين |

| اختبار الأداء | البيئات | اختبار LLM | اختبار التفكير والنفذ |

|---|---|---|---|

| ✅ تحليل زمن انتقال الحدث | اختبار البيئة غير الثابتة | LLM الكشف عن الوظائف غير المحددة | ؟ حلقات لانهائي واكتشاف الفكر العودية |

| ✅ أسعار تنفيذ سير عمل الوكيل | بيئات متعددة الوسائط | ؟ رمز الحد الأقصى لعلاج الفائض | الكشف عن التفكير الخاطئ |

| ؟ المدققون النجاح (خارجي) | حاويات التنفيذ | الحد الأقصى للسياق أعلام الفائض | صحة رمز التوليد |

| وحدات تحكم الوكيل/اختبارات المهارات | ✅ هونيوقا واكتشاف الحقن السريع (orderarmor) | تتبع فاتورة API | تحليل نقطة توقف الخطأ |

| اختبار قيود سياق المعلومات | حواجز الطرق المضادة للواحد (أي captchas) | الشيكات تكامل CI/CD | |

| اختبار الانحدار | تصور إطار عمل متعدد الوكلاء |

بدون الأدوات الصحيحة ، يكون عوامل الذكاء الاصطناعى بطيئة ومكلفة وغير موثوقة. مهمتنا هي إحضار وكيلك من النموذج الأولي إلى الإنتاج. هذا هو السبب في أن AgentOps تبرز:

تم تصميم AgentOps لجعل العوامل قابلية الملاحظة والاختبار والمراقبة سهلة.

تحقق من نمونا في المجتمع:

| مستودع | النجوم |

|---|---|

| geekan / metagpt | 42787 |

| Run-Llama / llama_index | 34446 |

| Crewaiinc / Crewai | 18287 |

| جمل أاي / جمل | 5166 |

| superagent-ai / superagent | 5050 |

| Iyaja / llama-fs | 4713 |

| على أساس Hardware / OMI | 2723 |

| Mervinpraison / Praisonai | 2007 |

| Agentops-AA / Jaiqu | 272 |

| Strnad / Crewai-Studio | 134 |

| alejandro-ao / exa-crewai | 55 |

| tonykipkemboi / youtube_yapper_trapper | 47 |

| Sethcoast / تغطية البناء | 27 |

| Bhancockio / chatgpt4o التحليل | 19 |

| BreakString / Agentic_story_book_workflow | 14 |

| متعددة على / multion-python | 13 |

تم إنشاؤ