Nos últimos anos, um progresso significativo foi feito em grandes modelos de idiomas (LLMS) com base na arquitetura do transformador, com novos modelos como Gemini-Pro1.5, Claude-3, GPT-4 e Llama-3.1 capazes de lidar com centenas de tokens. Os poderosos recursos desses modelos trouxeram mudanças revolucionárias ao campo do processamento de linguagem natural, permitindo que tarefas complexas de linguagem sejam concluídas com eficiência.

No entanto, os comprimentos do contexto desses estendidos representam alguns desafios significativos em aplicações práticas. À medida que o comprimento da sequência aumenta, o atraso de decodificação aumenta e os limites de memória também se tornam um gargalo grave. O KV Cache armazena informações de contexto durante a inferência. À medida que o comprimento do contexto aumenta, o tamanho do cache também aumenta proporcionalmente, o que leva à saturação da memória, o que afeta seriamente a eficiência do processamento de sequências de entrada longas, de modo que as soluções de otimização são urgentemente necessárias.

Embora existam alguns métodos sem treinamento no mercado, eles geralmente dependem de obter pesos de atenção para determinar a importância dos pares de valores-chave, o que os torna incompatíveis com algoritmos de atenção eficiente, como a Flashattion. Esses métodos geralmente requerem recalculação parcial da matriz de atenção, introduzindo o tempo e a sobrecarga da memória. Portanto, os algoritmos de compactação existentes são usados principalmente para comprimir as instruções antes de gerar respostas, em vez de otimizar durante a geração restrita de memória. Essa limitação enfatiza a necessidade de desenvolver tecnologias de compressão que possam manter o desempenho do modelo sem a necessidade de modificação arquitetônica.

Uma equipe de pesquisa da Universidade de Sorbonne, o Instituto Nacional Francês de Informação e Automação, a Universidade de Sapinza, a Universidade de Edimburgo e o Miniml.ai propôs filtros Q, uma poderosa tecnologia de compressão de cache de cache KV sem treinamento que utiliza a filtragem baseada em consulta para otimizar o uso da memória enquanto mantém o desempenho do modelo. Os filtros Q avalia a importância de pares de valores-chave associados à consulta atual, em vez de depender de pesos de atenção. Essa abordagem garante a compatibilidade com algoritmos de atenção eficiente sem reciclagem ou modificação da arquitetura. Avaliando e retendo dinamicamente as informações contextuais mais relevantes, os filtros Q atingem uma redução significativa da memória, mantendo a qualidade do raciocínio.

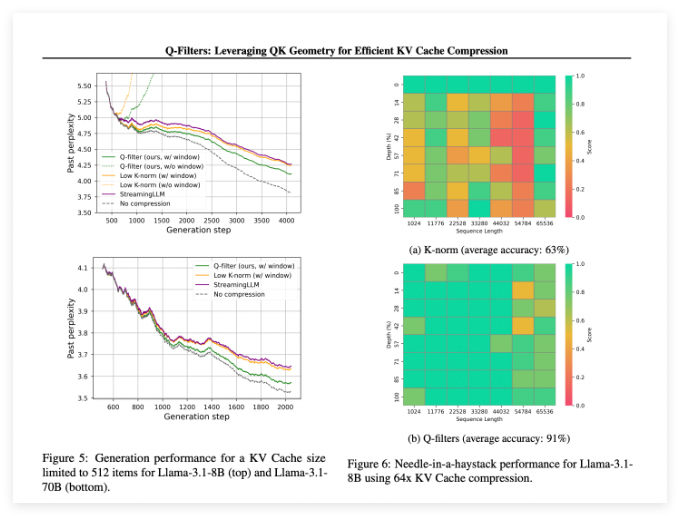

O Q-Filters tem um bom desempenho em vários cenários de avaliação e sempre supera os métodos de compactação de cache KV existentes. No teste de modelagem de idiomas de conjuntos de dados de pilha, essa tecnologia atinge o menor nível de confusão em todos os esquemas de compressão. Especialmente no modelo LLAMA-3.1-70B, os filtros Q mostraram redução significativa na confusão na segunda metade da sequência em que a retenção de contexto foi crítica.

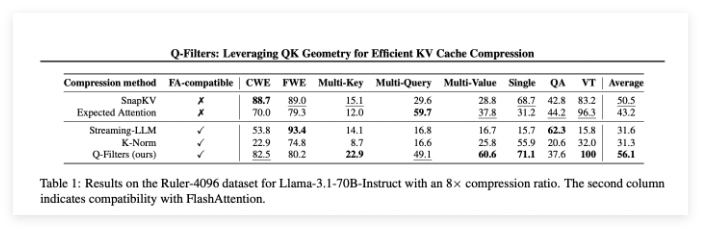

Na tarefa da agulha na palheiro, os filtros Q mantiveram 91% de precisão, economizando com sucesso informações importantes em comprimentos de contexto extremos (de 1K a 64K tokens). A avaliação abrangente também verificou a superioridade do método, especialmente em altas taxas de compressão (32 vezes), onde os filtros Q atingiram a pontuação mais alta no benchmark de modelagem de contexto longo.

Papel: https://arxiv.org/abs/2503.02812

Huggingface: https: //huggingface.co/collections/nthngdy/q-filters-67a4994dcb302a3d37f3d119

Pontos -chave:

O Q-Filters é uma tecnologia de compactação de cache KV sem treinamento que pode efetivamente otimizar o uso da memória sem perder o desempenho do modelo.

Esse método teve um desempenho superior em várias avaliações, especialmente com a menor confusão e maior precisão na modelagem de idiomas e nas tarefas de contexto extremo.

Os filtros Q são compatíveis com algoritmos de atenção eficientes e podem ser usados para aplicações práticas apenas executando uma etapa de preparação após o treinamento do modelo.