최근에는 변압기 아키텍처를 기반으로 한 대형 언어 모델 (LLM)에서 상당한 진전이 있었으며 Gemini-Pro1.5, Claude-3, GPT-4 및 LLAMA-3.1과 같은 새로운 모델이 수백 개의 토큰을 처리 할 수 있습니다. 이러한 모델의 강력한 기능은 자연어 처리 분야에 혁신적인 변화를 가져 왔으며 복잡한 언어 작업을 효율적으로 완료 할 수 있습니다.

그러나 이러한 확장 된 컨텍스트 길이는 실제 응용 분야에서 몇 가지 중요한 과제를 제기합니다. 시퀀스 길이가 증가함에 따라 디코딩 지연이 증가하고 메모리 제한도 심각한 병목 현상이됩니다. KV 캐시는 추론 중 컨텍스트 정보를 저장합니다. 컨텍스트 길이가 증가함에 따라 캐시 크기도 비례하여 증가하여 메모리 채도로 이어져 긴 입력 시퀀스 처리의 효율에 심각한 영향을 미치므로 최적화 솔루션이 시급히 필요합니다.

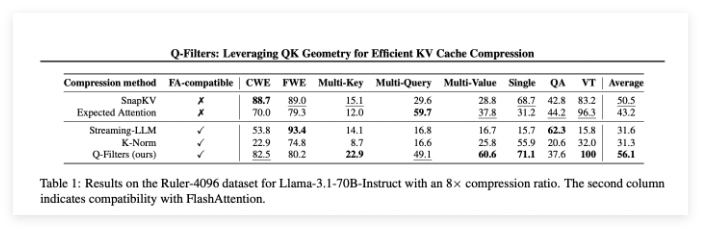

시장에는 몇 가지 훈련이없는 방법이 있지만, 종종 키 값 쌍의 중요성을 결정하기 위해 주의력을 얻는 데 의존하여 FlashAttention과 같은 효율적인주의 알고리즘과 호환되지 않습니다. 이 방법들은 종종 시간과 메모리 오버 헤드를 도입하여주의 매트릭스의 부분 재 계산이 필요합니다. 따라서 기존 압축 알고리즘은 주로 메모리 제한 생성 중 최적화보다는 답변을 생성하기 전에 프롬프트를 압축하는 데 주로 사용됩니다. 이러한 제한은 아키텍처 수정없이 모델 성능을 유지할 수있는 압축 기술을 개발할 필요성을 강조합니다.

Sorbonne University, 프랑스 국립 정보 및 자동화 연구소, Sapinza University, Edinburgh University 및 Miniml.ai의 연구팀은 QF-Filters를 제안했습니다. Q-Filters는주의 가중치에 의존하기보다는 현재 쿼리와 관련된 키 값 쌍의 중요성을 평가합니다. 이 접근법은 재교육 또는 아키텍처 수정없이 효율적인주의 알고리즘과의 호환성을 보장합니다. Q-Filters는 가장 관련성이 높은 상황 정보를 동적으로 평가하고 유지함으로써 추론의 질을 유지하면서 중요한 메모리 감소를 달성합니다.

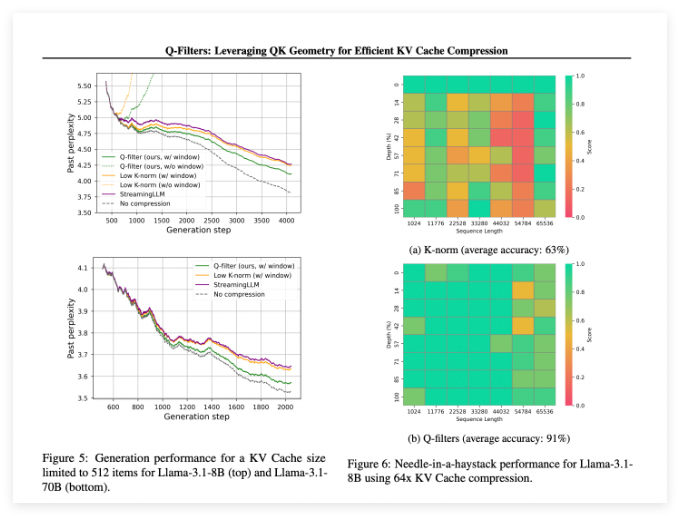

Q-Filters는 여러 평가 시나리오에서 잘 수행되며 항상 기존 KV 캐시 압축 방법을 능가합니다. 파일 데이터 세트의 언어 모델링 테스트 에서이 기술은 모든 압축 체계에서 가장 낮은 수준의 혼란을 달성합니다. 특히 LLAMA-3.1-70B 모델에서 Q-Filters는 컨텍스트 보유가 중요한 시퀀스의 후반부에서 혼란이 크게 감소했습니다.

Haystack 작업의 바늘에서 Q-Filters는 91% 정확도를 유지하여 극단적 인 컨텍스트 길이 (1k ~ 64k 토큰)로 중요한 정보를 성공적으로 저장했습니다. 포괄적 인 평가는 또한 Q-Filters가 긴 컨텍스트 모델링 벤치 마크에서 가장 높은 점수를 얻은 높은 압축 속도 (32 배)에서 방법의 우수성을 확인했습니다.

논문 : https://arxiv.org/abs/2503.02812

Huggingface : https : //huggingface.co/collections/nthngdy/q-filters-67a4994dcb302a3d37f3d119

핵심 사항 :

Q-Filters는 모델 성능을 잃지 않고 메모리 사용량을 효과적으로 최적화 할 수있는 교육이없는 KV 캐시 압축 기술입니다.

이 방법은 다중 평가에서, 특히 언어 모델링 및 극단적 인 컨텍스트 작업에 대한 가장 높은 혼란과 정확도가 가장 높습니다.

Q-Filters는 효율적인주의 알고리즘과 호환되며 모델 교육 후 하나의 준비 단계를 수행 하여만 실제 응용 분야에 사용할 수 있습니다.