In den letzten Jahren wurden in der Transformatorarchitektur mit neuen Modellen wie Gemini-Pro1.5, Claude-3, GPT-4 und LLAMA-3,1 in der Lage, Hunderte von Token zu bearbeiten. Die leistungsstarken Fähigkeiten dieser Modelle haben revolutionäre Änderungen in das Gebiet der Verarbeitung natürlicher Sprache gebracht, sodass komplexe Sprachaufgaben effizient erledigt werden können.

Die Kontextlängen dieser erweiterten Erweiterungen stellen jedoch einige bedeutende Herausforderungen in praktischen Anwendungen dar. Mit zunehmender Sequenzlänge steigt die Dekodierungsverzögerung und Gedächtnisgrenzen werden auch zu einem schwerwiegenden Engpass. KV Cache speichert Kontextinformationen während der Inferenz. Mit zunehmender Kontextlänge steigt die Cache -Größe auch proportional an, was zu Speichersättigung führt, was die Effizienz der Verarbeitung langer Eingangssequenzen ernsthaft beeinflusst, sodass Optimierungslösungen dringend erforderlich sind.

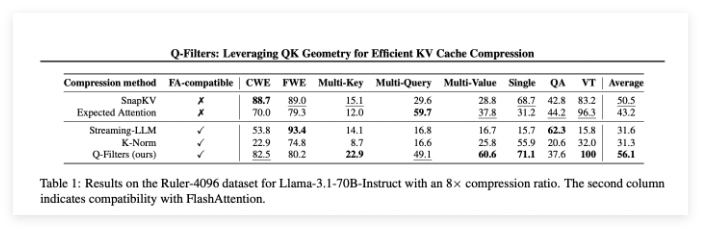

Während es auf dem Markt einige Trainingsfreiheit gibt, verlassen sie sich häufig darauf, Aufmerksamkeitsgewichte zu erhalten, um die Bedeutung von Schlüsselwertpaaren zu bestimmen, was sie mit effizienten Aufmerksamkeitsalgorithmen wie Flashattention inkompatibel macht. Diese Methoden erfordern häufig eine teilweise Neuberechnung der Aufmerksamkeitsmatrix, wodurch Zeit- und Gedächtnisaufwand eingeführt wird. Daher werden vorhandene Komprimierungsalgorithmen hauptsächlich zum Komprimieren von Eingabeaufforderungen verwendet, bevor Antworten erzeugt werden, anstatt die Optimierung bei der Erzeugung von Gedächtnisbeschränkungen. Diese Einschränkung betont die Notwendigkeit, Komprimierungstechnologien zu entwickeln, die die Modellleistung aufrechterhalten können, ohne architektonische Änderungen zu erfordern.

Ein Forschungsteam der Sorbonne University, das französische Nationale Institut für Information und Automatisierung, die Universität Sapinza, die University of Edinburgh und Miniml.ai haben Q-Filter vorgeschlagen, eine leistungsstarke schultrainfreie KV-Cache-Komprimierungstechnologie, mit der abfragebasierte Filterung die Speichernutzung optimiert wird und gleichzeitig die Modellleistung aufrechterhalten wird. Q-Filter bewerten die Bedeutung von Schlüsselwertpaaren, die mit der aktuellen Abfrage verbunden sind, anstatt sich auf Aufmerksamkeitsgewichte zu verlassen. Dieser Ansatz gewährleistet die Kompatibilität mit effizienten Aufmerksamkeitsalgorithmen ohne Umschulung oder Architekturänderung. Durch die dynamische Bewertung und Aufbewahrung der relevantesten Kontextinformationen erreicht Q-Filter eine erhebliche Reduzierung des Gedächtnisses und bei der Aufrechterhaltung der Argumentationsqualität.

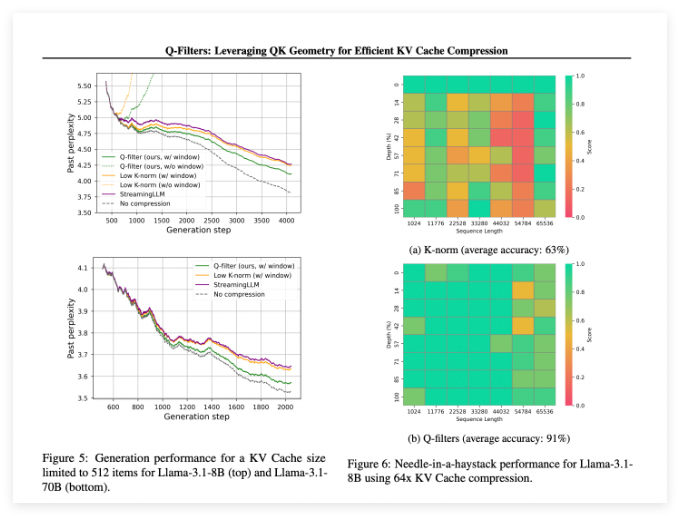

Q-Filter erzielen in mehreren Bewertungsszenarien gut und übertreffen vorhandene KV-Cache-Komprimierungsmethoden immer. Bei den Tests von Stapeldatensätzen erzielt diese Technologie in allen Komprimierungsschemata die niedrigste Verwirrung. Insbesondere auf dem Lama-3.1-70b-Modell zeigten Q-Filter eine signifikante Verringerung der Verwirrung in der zweiten Hälfte der Sequenz, in der die Kontextretention kritisch war.

In der Nadel in der Haystack-Aufgabe haben Q-Filter eine Genauigkeit von 91% beibehalten und wichtige Informationen in extremen Kontextlängen (von 1K bis 64.000 Token) erfolgreich gespeichert. Die umfassende Bewertung überprüfte auch die Überlegenheit der Methode, insbesondere bei hohen Kompressionsraten (32-mal), wobei Q-Filter im Langzeit-Kontext-Modellierungsbenchmark die höchste Punktzahl erzielten.

Papier: https://arxiv.org/abs/2503.02812

Huggingface: https: //huggingface.co/collections/nthngdy/q-filters-67a4994dcb302a3d37f3d119

Schlüsselpunkte:

Q-Filter ist eine Trainingsfreie KV-Cache-Komprimierungstechnologie, mit der die Speicherverwendung effektiv optimieren kann, ohne die Modellleistung zu verlieren.

Diese Methode wurde bei mehreren Bewertungen überlegen, insbesondere bei der niedrigsten Verwirrung und höchsten Genauigkeit bei den Aufgaben der Sprachmodellierung und extremen Kontext.

Q-Filter sind mit effizienten Aufmerksamkeitsalgorithmen kompatibel und können nur für praktische Anwendungen verwendet werden, indem ein Vorbereitungsschritt nach dem Modelltraining durchgeführt wird.