Dalam beberapa tahun terakhir, kemajuan yang signifikan telah dibuat dalam model bahasa besar (LLM) berdasarkan arsitektur transformator, dengan model baru seperti Gemini-Pro1.5, Claude-3, GPT-4, dan LLAMA-3.1 yang mampu menangani ratusan token. Kemampuan yang kuat dari model -model ini telah membawa perubahan revolusioner ke bidang pemrosesan bahasa alami, yang memungkinkan tugas -tugas bahasa yang rumit diselesaikan secara efisien.

Namun, panjang konteks dari perpanjangan ini menimbulkan beberapa tantangan signifikan dalam aplikasi praktis. Ketika panjang urutan meningkat, penundaan decoding meningkat, dan batas memori juga menjadi hambatan yang serius. KV Cache menyimpan informasi konteks selama inferensi. Ketika panjang konteks meningkat, ukuran cache juga meningkat secara proporsional, yang mengarah pada saturasi memori, yang secara serius mempengaruhi efisiensi pemrosesan urutan input yang panjang, sehingga solusi optimasi sangat dibutuhkan.

Meskipun ada beberapa metode bebas pelatihan di pasaran, mereka sering bergantung pada mendapatkan bobot perhatian untuk menentukan pentingnya pasangan nilai kunci, yang membuat mereka tidak kompatibel dengan algoritma perhatian yang efisien seperti flashattention. Metode -metode ini sering membutuhkan perhitungan ulang parsial dari matriks perhatian, memperkenalkan waktu dan overhead memori. Oleh karena itu, algoritma kompresi yang ada terutama digunakan untuk mengompresi petunjuk sebelum menghasilkan jawaban, daripada optimasi selama generasi yang dibatasi memori. Keterbatasan ini menekankan perlunya mengembangkan teknologi kompresi yang dapat mempertahankan kinerja model tanpa memerlukan modifikasi arsitektur.

Sebuah tim peneliti dari Sorbonne University, Institut Informasi dan Otomasi Nasional Prancis, Universitas Sapinza, Universitas Edinburgh dan miniml.ai telah mengusulkan Q-Filters, teknologi kompresi cache KV-bebas pelatihan yang kuat yang menggunakan penyaringan berbasis kueri untuk mengoptimalkan penggunaan memori sambil mempertahankan kinerja model. Q-filters mengevaluasi pentingnya pasangan nilai kunci yang terkait dengan kueri saat ini, daripada mengandalkan bobot perhatian. Pendekatan ini memastikan kompatibilitas dengan algoritma perhatian yang efisien tanpa modifikasi pelatihan ulang atau arsitektur. Dengan mengevaluasi dan mempertahankan informasi kontekstual yang paling relevan secara dinamis, Q-Filters mencapai pengurangan memori yang signifikan sambil mempertahankan kualitas penalaran.

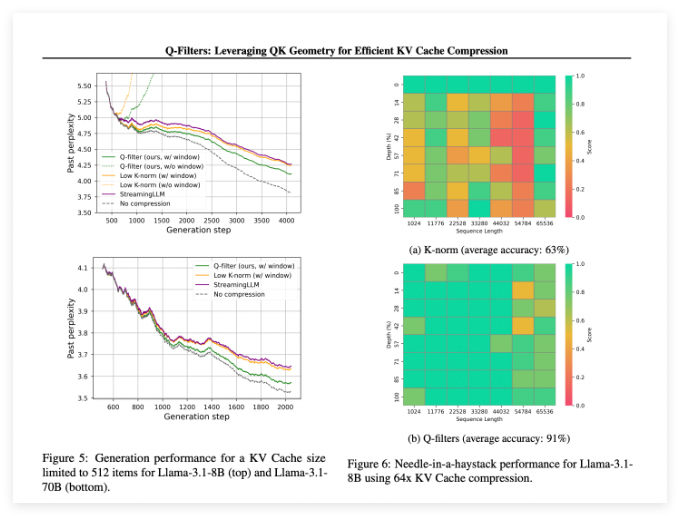

Q-Filters berkinerja baik dalam beberapa skenario evaluasi dan selalu mengungguli metode kompresi cache KV yang ada. Dalam pengujian pemodelan bahasa dari set data, teknologi ini mencapai tingkat kebingungan terendah dalam semua skema kompresi. Khususnya pada model LLAMA-3.1-70B, q-filters menunjukkan pengurangan yang signifikan dalam kebingungan di paruh kedua urutan di mana retensi konteks sangat penting.

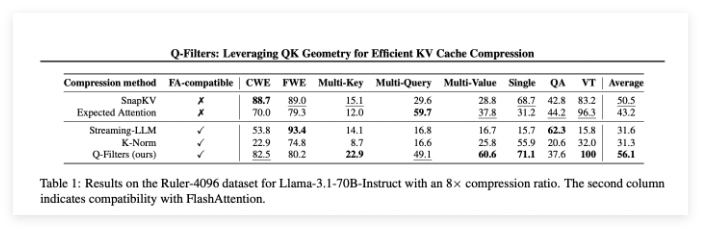

Di tugas jarum di tumpukan jerami, Q-Filters mempertahankan akurasi 91%, berhasil menyimpan informasi penting dalam panjang konteks ekstrem (dari 1K hingga 64K token). Evaluasi komprehensif juga memverifikasi keunggulan metode ini, terutama pada tingkat kompresi tinggi (32 kali), di mana Q-Filters mencapai skor tertinggi dalam tolok ukur pemodelan konteks panjang.

Kertas: https://arxiv.org/abs/2503.02812

HuggingFace: https: //huggingface.co/collections/nthngdy/q-filters-67a4994dcb302a3d37f3d119

Poin -Poin Kunci:

Q-Filters adalah teknologi kompresi cache KV bebas pelatihan yang dapat secara efektif mengoptimalkan penggunaan memori tanpa kehilangan kinerja model.

Metode ini dilakukan secara superior dalam beberapa penilaian, terutama dengan kebingungan terendah dan akurasi tertinggi pada pemodelan bahasa dan tugas konteks ekstrem.

Q-Filters kompatibel dengan algoritma perhatian yang efisien dan dapat digunakan untuk aplikasi praktis hanya dengan melakukan satu langkah persiapan setelah pelatihan model.