Ces dernières années, des progrès significatifs ont été réalisés dans des modèles de grande langue (LLMS) basés sur l'architecture du transformateur, avec de nouveaux modèles tels que Gemini-Pro1.5, Claude-3, GPT-4 et LLAMA-3.1 capables de gérer des centaines de jetons. Les capacités puissantes de ces modèles ont apporté des modifications révolutionnaires dans le domaine du traitement du langage naturel, permettant de terminer les tâches de langage complexes.

Cependant, les durées de contexte de ces étendues posent des défis importants dans les applications pratiques. À mesure que la longueur de séquence augmente, le retard de décodage augmente et les limites de mémoire deviennent également un goulot d'étranglement grave. KV Cache stocke les informations contextuelles pendant l'inférence. À mesure que la longueur du contexte augmente, la taille du cache augmente également proportionnellement, ce qui conduit à la saturation de la mémoire, ce qui affecte sérieusement l'efficacité du traitement des séquences d'entrée longues, de sorte que des solutions d'optimisation sont nécessaires urgemment nécessaires.

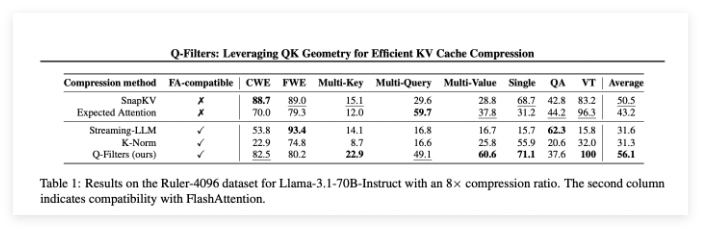

Bien qu'il existe des méthodes sans formation sur le marché, elles comptent souvent sur l'obtention du poids d'attention pour déterminer l'importance des paires de valeurs clés, ce qui les rend incompatibles avec des algorithmes d'attention efficaces tels que FlashAttation. Ces méthodes nécessitent souvent un recalcul partiel de la matrice d'attention, l'introduction du temps et des frais généraux de mémoire. Par conséquent, les algorithmes de compression existants sont principalement utilisés pour comprimer les invites avant de générer des réponses, plutôt que l'optimisation pendant la génération limitée par la mémoire. Cette limitation souligne la nécessité de développer des technologies de compression qui peuvent maintenir les performances du modèle sans nécessiter une modification architecturale.

Une équipe de recherche de l'Université de Sorbonne, de l'Institut national français de l'information et de l'automatisation, de l'Université de Sapinza, de l'Université d'Édimbourg et de Miniml.ai a proposé Q-Filters, une puissante technologie de compression de cache KV sans formation qui utilise le filtrage basé sur les requêtes pour optimiser l'utilisation de la mémoire tout en maintenant les performances du modèle. Les filtres Q évalue l'importance des paires de valeurs clés associées à la requête actuelle, plutôt que de s'appuyer sur des poids d'attention. Cette approche assure la compatibilité avec des algorithmes d'attention efficaces sans recyclage ni modification d'architecture. En évaluant et en conservant dynamiquement les informations contextuelles les plus pertinentes, les filtres Q atteint une réduction significative de la mémoire tout en maintenant la qualité du raisonnement.

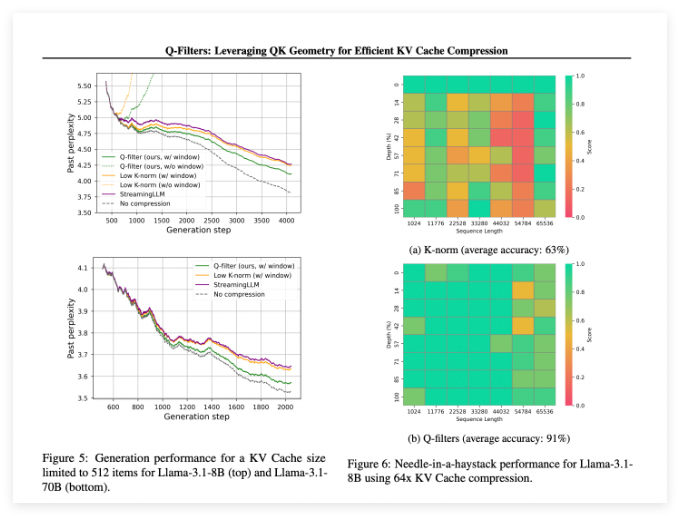

Q-Filters fonctionne bien dans plusieurs scénarios d'évaluation et surpasse toujours les méthodes de compression de cache KV existantes. Dans les tests de modélisation du langage des ensembles de données de pile, cette technologie atteint le niveau de confusion le plus bas dans tous les schémas de compression. Surtout sur le modèle LLAMA-3.1-70B, les filtres Q ont montré une réduction significative de la confusion dans la seconde moitié de la séquence où la rétention du contexte était critique.

Dans l'aiguille dans la tâche de sac de foin, les filtres Q ont maintenu une précision de 91%, enregistrant avec succès des informations importantes dans des longueurs de contexte extrême (de 1k à 64K jetons). L'évaluation complète a également vérifié la supériorité de la méthode, en particulier à des taux de compression élevés (32 fois), où les filtres Q ont obtenu le score le plus élevé dans le référence de modélisation du contexte long.

Papier: https://arxiv.org/abs/2503.02812

Huggingface: https: //huggingface.co/collections/nthngdy/q-filters-67a4994dcb302a3d37f3d119

Points clés:

Q-Filters est une technologie de compression de cache KV sans formation qui peut optimiser efficacement l'utilisation de la mémoire sans perdre les performances du modèle.

Cette méthode s'est produite de manière supérieure dans plusieurs évaluations, en particulier avec la confusion la plus faible et la plus haute précision sur la modélisation du langage et les tâches de contexte extrême.

Les filtres Q sont compatibles avec des algorithmes d'attention efficaces et ne peuvent être utilisés pour les applications pratiques qu'en effectuant une étape de préparation après la formation du modèle.