近年、トランスアーキテクチャに基づいた大規模な言語モデル(LLMS)で大幅な進歩が遂げられており、Gemini-Pro1.5、Claude-3、GPT-4、Llama-3.1などの新しいモデルが何百ものトークンを扱うことができます。これらのモデルの強力な能力は、自然言語処理の分野に革新的な変化をもたらし、複雑な言語タスクを効率的に完了させることができました。

ただし、これらの拡張されたコンテキストの長さは、実際のアプリケーションにいくつかの重要な課題をもたらします。シーケンスの長さが増加すると、デコード遅延が増加し、メモリ制限も深刻なボトルネックになります。 KVキャッシュは、推論中にコンテキスト情報を保存します。コンテキストの長さが増加すると、キャッシュサイズも比例して増加し、メモリの飽和につながり、長い入力シーケンスの処理効率に深刻な影響を与えるため、最適化ソリューションが緊急に必要です。

市場にはいくつかのトレーニングのない方法がありますが、彼らはしばしば注意の重量を得て、キー価値のペアの重要性を判断することに依存しているため、フラッシュアットなどの効率的な注意アルゴリズムと互換性がありません。これらの方法では、多くの場合、注意マトリックスの部分的な再計算が必要であり、時間とメモリのオーバーヘッドを導入します。したがって、既存の圧縮アルゴリズムは、メモリが制約した生成中に最適化するのではなく、回答を生成する前にプロンプトを圧縮するために主に使用されます。この制限は、アーキテクチャの変更を必要とせずにモデルのパフォーマンスを維持できる圧縮技術を開発する必要性を強調しています。

ソルボンヌ大学、フランス国立情報および自動化研究所、サピンザ大学、エディンバラ大学、ミニマイ族の研究チームは、モデルのパフォーマンスを維持しながらメモリ使用量を最適化するためにクエリベースのフィルタリングを利用する強力なトレーニングのないKVキャッシュ圧縮技術であるQ-Filtersを提案しました。 Qフィルターは、注意の重量に依存するのではなく、現在のクエリに関連するキー価値ペアの重要性を評価します。このアプローチにより、再訓練やアーキテクチャの変更なしで効率的な注意アルゴリズムとの互換性が保証されます。最も関連性の高いコンテキスト情報を動的に評価および保持することにより、Q-Filtersは推論の質を維持しながら、大幅なメモリ削減を達成します。

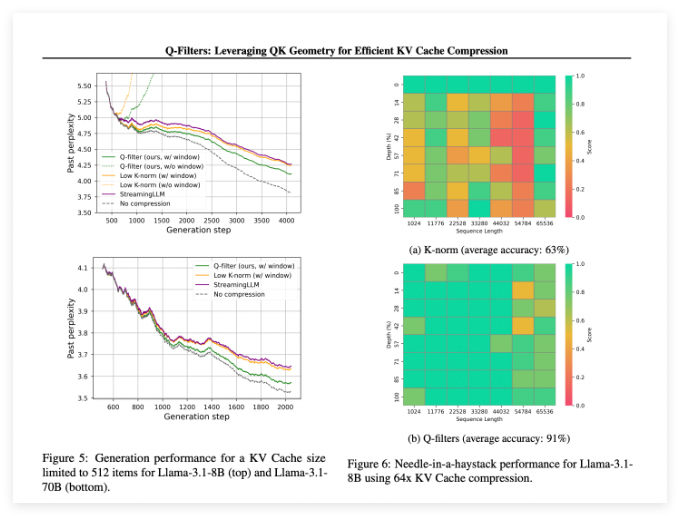

Q-Filtersは、複数の評価シナリオでうまく機能し、既存のKVキャッシュ圧縮方法を常に上回ります。パイルデータセットの言語モデリングテストでは、この技術はすべての圧縮スキームで最も低いレベルの混乱を達成します。特にLlama-3.1-70Bモデルでは、Q-filtersは、コンテキスト保持が重要であるシーケンスの後半で大幅な混乱の減少を示しました。

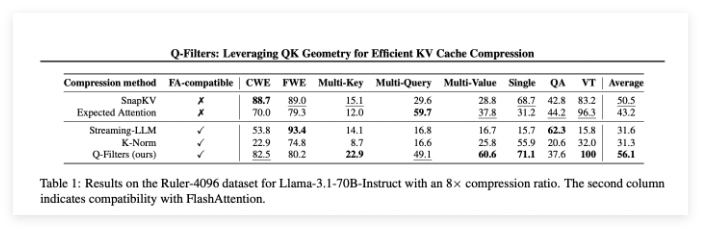

Haystackタスクの針では、Q-Filtersは91%の精度を維持し、重要な情報を極端なコンテキストの長さ(1K〜64Kトークン)で正常に保存しました。包括的な評価により、特に高圧縮速度(32倍)での方法の優位性も検証されました。そこでは、Qフィルターが長いコンテキストモデリングベンチマークで最高のスコアを達成しました。

論文:https://arxiv.org/abs/2503.02812

Huggingface:https://huggingface.co/collections/nthngdy/q-filters-67a4994dcb302a3d37f3d119

キーポイント:

Q-Filtersは、モデルのパフォーマンスを失うことなくメモリ使用を効果的に最適化できるトレーニングなしのKVキャッシュ圧縮テクノロジーです。

この方法は、特に言語モデリングと極端なコンテキストタスクで最も低い混乱と最高の精度で、複数の評価で優れた実行されました。

Qフィルターは、効率的な注意アルゴリズムと互換性があり、モデルトレーニング後に1つの準備ステップを実行することによってのみ、実用的なアプリケーションに使用できます。