En los últimos años, se han realizado progresos significativos en modelos de idiomas grandes (LLM) basados en la arquitectura del transformador, con nuevos modelos como Gemini-Pro1.5, Claude-3, GPT-4 y LLAMA-3.1 capaces de manejar cientos de tokens. Las poderosas capacidades de estos modelos han traído cambios revolucionarios al campo del procesamiento del lenguaje natural, lo que permite que las tareas de lenguaje complejas se completen de manera eficiente.

Sin embargo, las longitudes de contexto de estos plantean algunos desafíos significativos en aplicaciones prácticas. A medida que aumenta la longitud de la secuencia, el retraso de decodificación aumenta y los límites de memoria también se convierten en un cuello de botella grave. KV Cache almacena información de contexto durante la inferencia. A medida que aumenta la longitud de contexto, el tamaño del caché también aumenta proporcionalmente, lo que conduce a la saturación de memoria, lo que afecta seriamente la eficiencia del procesamiento de secuencias de entrada largas, por lo que se necesitan urgentemente soluciones de optimización.

Si bien existen algunos métodos sin capacitación en el mercado, a menudo confían en obtener pesos de atención para determinar la importancia de los pares de valor clave, lo que los hace incompatibles con algoritmos de atención eficientes como la flashatención. Estos métodos a menudo requieren un recalculación parcial de la matriz de atención, introduciendo el tiempo y la sobrecarga de memoria. Por lo tanto, los algoritmos de compresión existentes se utilizan principalmente para comprimir las indicaciones antes de generar respuestas, en lugar de optimización durante la generación limitada por la memoria. Esta limitación enfatiza la necesidad de desarrollar tecnologías de compresión que puedan mantener el rendimiento del modelo sin requerir la modificación arquitectónica.

Un equipo de investigación de la Universidad de Sorbonne, el Instituto Nacional de Información y Automatización de French, la Universidad de Sapinza, la Universidad de Edimburgo y Miniml.Ai, han propuesto Q-Filters, una poderosa tecnología de compresión de caché KV sin capacitación que utiliza el filtrado basado en consultas para optimizar el uso de la memoria mientras mantiene el rendimiento del modelo. Q-Filters evalúa la importancia de los pares de valor clave asociados con la consulta actual, en lugar de depender de los pesos de atención. Este enfoque garantiza la compatibilidad con algoritmos de atención eficientes sin reentrenamiento o modificación de arquitectura. Al evaluar y retener dinámicamente la información contextual más relevante, Q-Filters logra una reducción significativa de la memoria mientras mantiene la calidad del razonamiento.

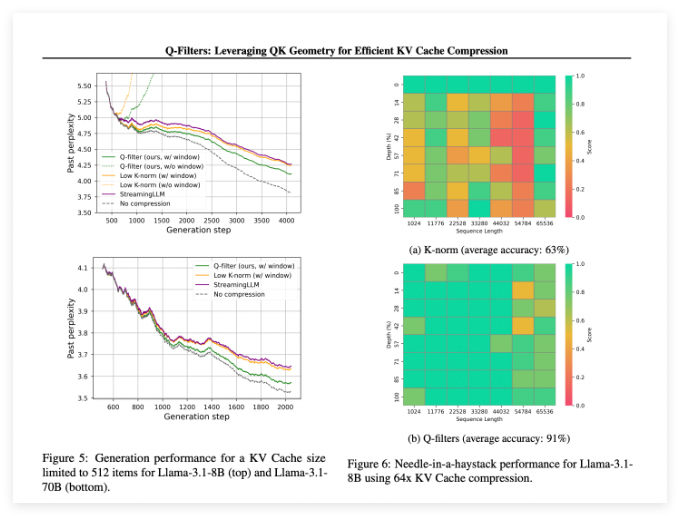

Q-Filters funciona bien en múltiples escenarios de evaluación y siempre supera a los métodos existentes de compresión de caché de KV. En las pruebas de modelado de idiomas de conjuntos de datos de pilotes, esta tecnología logra el nivel más bajo de confusión en todos los esquemas de compresión. Especialmente en el modelo LLAMA-3.1-70B, los filtros Q mostraron una reducción significativa en la confusión en la segunda mitad de la secuencia donde la retención de contexto era crítica.

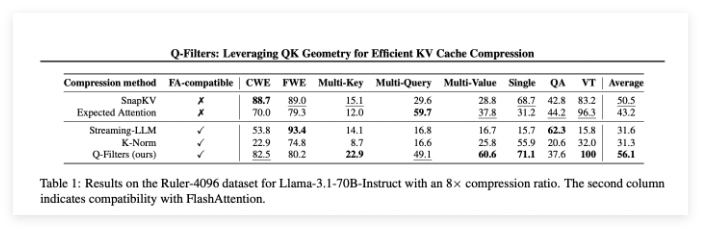

En la tarea de aguja en Haystack, Q-Filters mantuvo una precisión del 91%, guardando con éxito información importante en longitudes de contexto extremas (de 1k a 64k tokens). La evaluación integral también verificó la superioridad del método, especialmente a altas tasas de compresión (32 veces), donde los filtros Q alcanzaron la puntuación más alta en el largo punto de referencia de modelado de contexto.

Documento: https://arxiv.org/abs/2503.02812

Huggingface: https: //huggingface.co/collections/nthngdy/q-filters-67a49994dcb302a3d37f3d119

Puntos clave:

Q-Filters es una tecnología de compresión de caché KV sin entrenamiento que puede optimizar efectivamente el uso de la memoria sin perder el rendimiento del modelo.

Este método funcionó de manera superior en múltiples evaluaciones, especialmente con la confusión más baja y la mayor precisión en el modelado de idiomas y las tareas de contexto extremo.

Los filtros Q son compatibles con algoritmos de atención eficientes y pueden usarse para aplicaciones prácticas solo realizando un paso de preparación después del entrenamiento del modelo.