في السنوات الأخيرة ، تم إحراز تقدم كبير في نماذج اللغة الكبيرة (LLMS) بناءً على بنية المحولات ، مع نماذج جديدة مثل Gemini-Pro1.5 و Claude-3 و GPT-4 و Llama-3.1 قادرة على التعامل مع مئات الرموز. جلبت القدرات القوية لهذه النماذج تغييرات ثورية في مجال معالجة اللغة الطبيعية ، مما يسمح بإكمال مهام اللغة المعقدة بكفاءة.

ومع ذلك ، فإن أطوال سياق هذه الموسعة تشكل بعض التحديات المهمة في التطبيقات العملية. مع زيادة طول التسلسل ، يزداد تأخير فك التشفير ، وتصبح حدود الذاكرة أيضًا عنق الزجاجة الخطيرة. تخزن KV Cache معلومات السياق أثناء الاستدلال. مع زيادة طول السياق ، يزداد حجم ذاكرة التخزين المؤقت أيضًا بشكل متناسب ، مما يؤدي إلى تشبع الذاكرة ، مما يؤثر بشكل خطير على كفاءة معالجة تسلسلات الإدخال الطويلة ، لذلك هناك حاجة إلى حلول التحسين.

في حين أن هناك بعض الأساليب الخالية من التدريب في السوق ، إلا أنها تعتمد غالبًا على الحصول على أوزان الانتباه لتحديد أهمية أزواج القيمة الرئيسية ، مما يجعلها غير متوافقة مع خوارزميات الاهتمام الفعالة مثل Flashattention. غالبًا ما تتطلب هذه الطرق إعادة حساب جزئي لمصفوفة الانتباه ، مما يؤدي إلى إدخال الوقت والذاكرة. لذلك ، تُستخدم خوارزميات الضغط الحالية بشكل أساسي لضغط المطالبات قبل إنشاء إجابات ، بدلاً من التحسين أثناء التوليد المقيد بالذاكرة. يؤكد هذا القيد على الحاجة إلى تطوير تقنيات الضغط التي يمكن أن تحافظ على أداء النموذج دون الحاجة إلى تعديل معماري.

اقترح فريق أبحاث من جامعة سوربون ، والمعهد الوطني الفرنسي للمعلومات والأتمتة ، وجامعة سابينزا ، وجامعة إدنبرة و Miniml.ai المرشحين Q ، وهي تقنية قوية لضغط ذاكرة التخزين المؤقت KV خالية من التدريب والتي تستخدم التصفية المستندة إلى الاستعلام لتحسين استخدام الذاكرة مع الحفاظ على الأداء النموذجي. تقوم المرشحات Q بتقييم أهمية أزواج القيمة الرئيسية المرتبطة بالاستعلام الحالي ، بدلاً من الاعتماد على أوزان الانتباه. يضمن هذا النهج التوافق مع خوارزميات الاهتمام الفعالة دون إعادة التدريب أو تعديل العمارة. من خلال تقييم المعلومات السياقية الأكثر صلة والاحتفاظ بها بشكل ديناميكي ، تحقق المرشحات Q تخفيضًا كبيرًا في الذاكرة مع الحفاظ على جودة التفكير.

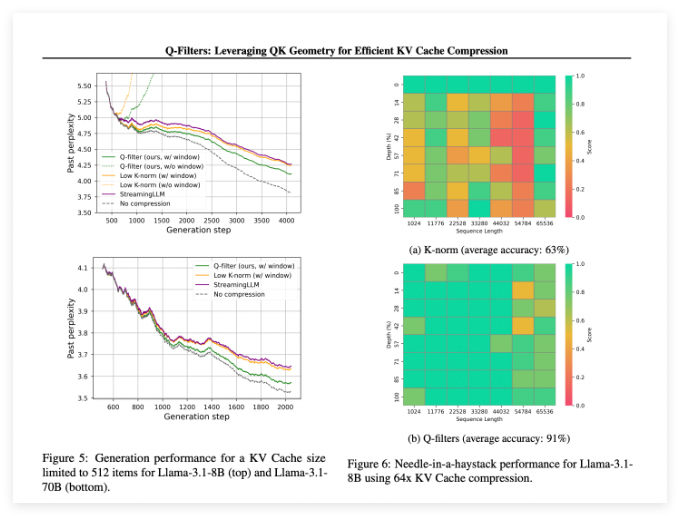

تعمل Q-Filters بشكل جيد في سيناريوهات تقييم متعددة وتتفوق دائمًا على طرق ضغط ذاكرة التخزين المؤقت KV الحالية. في اختبار نمذجة اللغة لمجموعات بيانات الوبر ، تحقق هذه التكنولوجيا أدنى مستوى من الارتباك في جميع مخططات الضغط. خاصة على نموذج LLAMA-3.1-70B ، أظهرت المرشحات Q انخفاضًا كبيرًا في الارتباك في النصف الثاني من التسلسل حيث كان الاحتفاظ بالسياق أمرًا بالغ الأهمية.

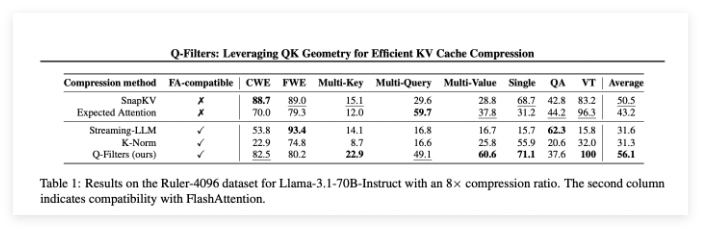

في مهمة الإبرة في مهمة Haystack ، حافظت المرشحات Q على دقة 91 ٪ ، وتوفير معلومات مهمة بنجاح في أطوال السياق القصوى (من 1K إلى 64 كيلو رموز). كما تحقق التقييم الشامل من تفوق الطريقة ، خاصة في معدلات الضغط العالية (32 مرة) ، حيث حققت المرشحات Q أعلى درجة في معيار نمذجة السياق الطويل.

ورقة: https://arxiv.org/abs/2503.02812

Huggingface: https: //huggingface.co/Collections/nthngdy/q-filters-67a4994dcb302a3d37f3d119

النقاط الرئيسية:

Q-Filters هي تقنية ضغط ذاكرة التخزين المؤقت KV خالية من التدريب يمكنها تحسين استخدام الذاكرة بشكل فعال دون فقدان أداء النموذج.

تم أداء هذه الطريقة بشكل متفوق في تقييمات متعددة ، خاصة مع أدنى ارتباك وأعلى دقة في نمذجة اللغة ومهام السياق القصوى.

تتوافق المرشحات Q مع خوارزميات الاهتمام الفعالة ويمكن استخدامها للتطبيقات العملية فقط عن طريق إجراء خطوة إعداد واحدة بعد التدريب النموذجي.