Este repositório contém os scripts para modelos de referência de Coco-LM de ajuste fino em referências de cola e esquadrão 2.0.

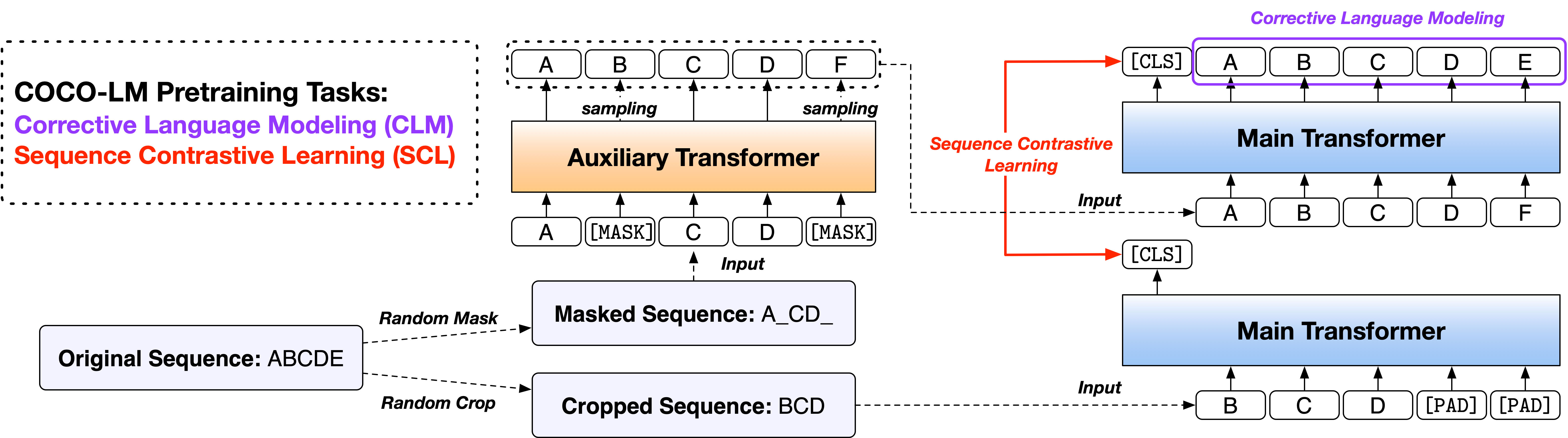

Papel: Coco-lm: Sequências de texto de correção e contraste para o modelo de idioma pré-treinamento

Fornecemos os scripts em duas versões, com base em duas bases de código de código aberto amplamente usadas, a Biblioteca Fairseq e a Biblioteca de Transformers do Huggingface. As duas versões de código são principalmente equivalentes em funcionalidade e você é livre para usar qualquer uma delas. No entanto, observamos que a versão Fairseq é o que usamos em nossos experimentos e melhor reproduzirá os resultados no artigo; A versão Huggingface é implementada posteriormente para fornecer compatibilidade com a Biblioteca de Transformers do Huggingface e pode produzir resultados ligeiramente diferentes.

Siga os arquivos ReadMe nos dois diretórios para executar o código.

O benchmark de avaliação de Entendendo a Linguagem Geral (CLUE) é uma coleção de tarefas de compreensão de idiomas de frases ou pares de frases para avaliar e analisar sistemas de compreensão de linguagem natural.

Cola dev definido os resultados dos modelos Coco-lm Base ++ e Grande ++ são os seguintes (mediana de 5 sementes aleatórias diferentes):

| Modelo | Mnli-m/mm | Qqp | Qnli | SST-2 | Cola | Rte | Mrpc | STS-B | Avg |

|---|---|---|---|---|---|---|---|---|---|

| Base coco-lm ++ | 90.2/90.0 | 92.2 | 94.2 | 94.6 | 67.3 | 87.4 | 91.2 | 91.8 | 88.6 |

| Coco-lm grande ++ | 91.4/91.6 | 92.8 | 95.7 | 96.9 | 73.9 | 91.0 | 92.2 | 92.7 | 90.8 |

Conjunto de testes de cola Os resultados dos modelos Coco-LM Base ++ e Grande ++ são os seguintes (sem conjunto, truques específicos de tarefas, etc.):

| Modelo | Mnli-m/mm | Qqp | Qnli | SST-2 | Cola | Rte | Mrpc | STS-B | Avg |

|---|---|---|---|---|---|---|---|---|---|

| Base coco-lm ++ | 89.8/89.3 | 89.8 | 94.2 | 95.6 | 68.6 | 82.3 | 88.5 | 90.3 | 87.4 |

| Coco-lm grande ++ | 91.6/91.1 | 90.5 | 95.8 | 96.7 | 70.5 | 89.2 | 88.4 | 91.8 | 89.3 |

O conjunto de dados de resposta a Stanford para resposta a Stanford é um conjunto de dados de compreensão de leitura, consistindo em perguntas colocadas pelos trabalhadores de multidão em um conjunto de artigos da Wikipedia, onde a resposta para todas as perguntas é um segmento de texto ou extensão, da passagem de leitura correspondente, ou a pergunta pode ser insensível.

Esquadrão 2.0 Definir os resultados dos modelos Coco-LM Base ++ e Grande ++ são os seguintes (mediana de 5 sementes aleatórias diferentes):

| Modelo | Em | F1 |

|---|---|---|

| Base coco-lm ++ | 85.4 | 88.1 |

| Coco-lm grande ++ | 88.2 | 91.0 |

Se você achar o código e os modelos úteis para sua pesquisa, cite o seguinte artigo:

@inproceedings{meng2021cocolm,

title={{COCO-LM}: Correcting and contrasting text sequences for language model pretraining},

author={Meng, Yu and Xiong, Chenyan and Bajaj, Payal and Tiwary, Saurabh and Bennett, Paul and Han, Jiawei and Song, Xia},

booktitle={Conference on Neural Information Processing Systems},

year={2021}

}

Este projeto recebe contribuições e sugestões. A maioria das contribuições exige que você concorde com um Contrato de Licença de Colaborador (CLA) declarando que você tem o direito e, na verdade, concede -nos os direitos de usar sua contribuição. Para detalhes, visite https://cla.opensource.microsoft.com.

Quando você envia uma solicitação de tração, um BOT do CLA determina automaticamente se você precisa fornecer um CLA e decorar o PR adequadamente (por exemplo, verificação de status, comentar). Simplesmente siga as instruções fornecidas pelo bot. Você só precisará fazer isso uma vez em todos os repositórios usando nosso CLA.

Este projeto adotou o Código de Conduta Open Microsoft. Para obter mais informações, consulte o Código de Conduta Perguntas frequentes ou entre em contato com [email protected] com quaisquer perguntas ou comentários adicionais.