يحتوي هذا المستودع على البرامج النصية لضبط نماذج Coco-LM المسبق على معايير الغراء والفرق 2.0.

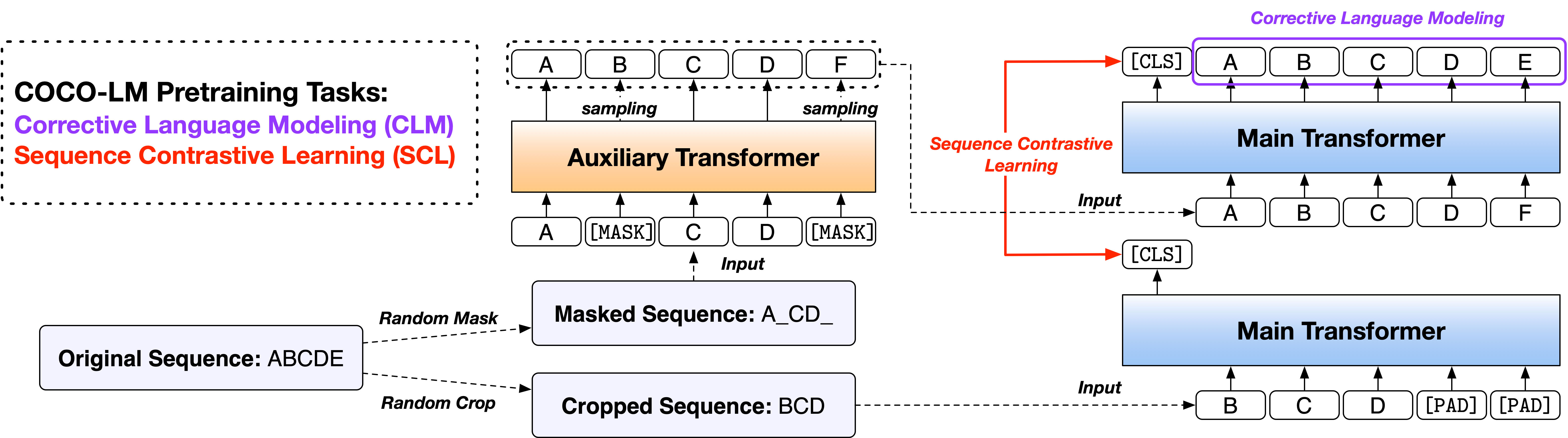

الورق: Coco-LM: تصحيح وتسلسلات النص المتناقضة لنموذج اللغة قبل التدريب

نحن نقدم البرامج النصية في نسختين ، استنادًا إلى اثنين من قواعد الكود مفتوحة المصدر المستخدمة على نطاق واسع ، ومكتبة Fairseq ومكتبة Huggingface Transformers. نسختان من الكود مكافئ في الغالب في الوظائف ، وأنت حر في استخدام أي منهما. ومع ذلك ، نلاحظ أن إصدار FairSeq هو ما استخدمناه في تجاربنا ، وسيؤدي إلى إعادة إنتاج النتائج في الورقة بشكل أفضل ؛ يتم تنفيذ إصدار HuggingFace لاحقًا لتوفير التوافق مع مكتبة HuggingFace Transformers ، وقد تسفر عن نتائج مختلفة قليلاً.

يرجى اتباع ملفات ReadMe ضمن الدليلين لتشغيل الرمز.

إن تقييم فهم اللغة العامة (GLUE) هو مجموعة من مهام فهم لغة الجملة أو الجملة من الجملة لتقييم أنظمة فهم اللغة الطبيعية وتحليلها.

Glue Dev Set نتائج لقاعدة Coco-LM ++ ونماذج ++ كبيرة كما يلي (متوسط 5 بذور عشوائية مختلفة):

| نموذج | mnli-m/mm | QQP | qnli | SST-2 | كولا | RTE | MRPC | STS-B | متوسط |

|---|---|---|---|---|---|---|---|---|---|

| قاعدة Coco-LM ++ | 90.2/90.0 | 92.2 | 94.2 | 94.6 | 67.3 | 87.4 | 91.2 | 91.8 | 88.6 |

| Coco-LM كبير ++ | 91.4/91.6 | 92.8 | 95.7 | 96.9 | 73.9 | 91.0 | 92.2 | 92.7 | 90.8 |

تعد نتائج اختبار اختبار الغراء لقاعدة Coco-LM ++ ونماذج ++ كبيرة كما يلي (لا توجد مجموعة ، حيل خاصة بالمهمة ، إلخ):

| نموذج | mnli-m/mm | QQP | qnli | SST-2 | كولا | RTE | MRPC | STS-B | متوسط |

|---|---|---|---|---|---|---|---|---|---|

| قاعدة Coco-LM ++ | 89.8/89.3 | 89.8 | 94.2 | 95.6 | 68.6 | 82.3 | 88.5 | 90.3 | 87.4 |

| Coco-LM كبير ++ | 91.6/91.1 | 90.5 | 95.8 | 96.7 | 70.5 | 89.2 | 88.4 | 91.8 | 89.3 |

Stanford Question Repling DataSet (Squad) هي مجموعة بيانات فهم للقراءة ، تتكون من أسئلة طرحها عمال الحشد على مجموعة من مقالات ويكيبيديا ، حيث قد تكون الإجابة على كل سؤال عبارة عن جزء من النص ، أو تمتد ، من مقطع القراءة المقابل ، أو قد يكون السؤال غير قابل للإجابة.

Squad 2.0 Dev Set نتائج من BASE ++ ونماذج ++ كبيرة هي كما يلي (متوسط من 5 بذور عشوائية مختلفة):

| نموذج | م | F1 |

|---|---|---|

| قاعدة Coco-LM ++ | 85.4 | 88.1 |

| Coco-LM كبير ++ | 88.2 | 91.0 |

إذا وجدت الرمز والنماذج مفيدة لبحثك ، فيرجى الاستشهاد بالورقة التالية:

@inproceedings{meng2021cocolm,

title={{COCO-LM}: Correcting and contrasting text sequences for language model pretraining},

author={Meng, Yu and Xiong, Chenyan and Bajaj, Payal and Tiwary, Saurabh and Bennett, Paul and Han, Jiawei and Song, Xia},

booktitle={Conference on Neural Information Processing Systems},

year={2021}

}

يرحب هذا المشروع بالمساهمات والاقتراحات. تطلب منك معظم المساهمات الموافقة على اتفاقية ترخيص المساهم (CLA) مع إعلان أن لديك الحق في ذلك في الواقع ، ويفعلنا في الواقع حقوق استخدام مساهمتك. لمزيد من التفاصيل ، تفضل بزيارة https://cla.opensource.microsoft.com.

عند إرسال طلب سحب ، سيحدد CLA Bot تلقائيًا ما إذا كنت بحاجة إلى توفير CLA وتزيين العلاقات العامة بشكل مناسب (على سبيل المثال ، فحص الحالة ، التعليق). ببساطة اتبع الإرشادات التي يقدمها الروبوت. ستحتاج فقط إلى القيام بذلك مرة واحدة عبر جميع عمليات إعادة الشراء باستخدام CLA لدينا.

اعتمد هذا المشروع رمز سلوك المصدر المفتوح Microsoft. لمزيد من المعلومات ، راجع مدونة الشهادة الأسئلة الشائعة أو الاتصال بـ [email protected] مع أي أسئلة أو تعليقات إضافية.