このリポジトリには、接着剤および分隊2.0ベンチマークに微調整されたココ-LM事前補助モデルのスクリプトが含まれています。

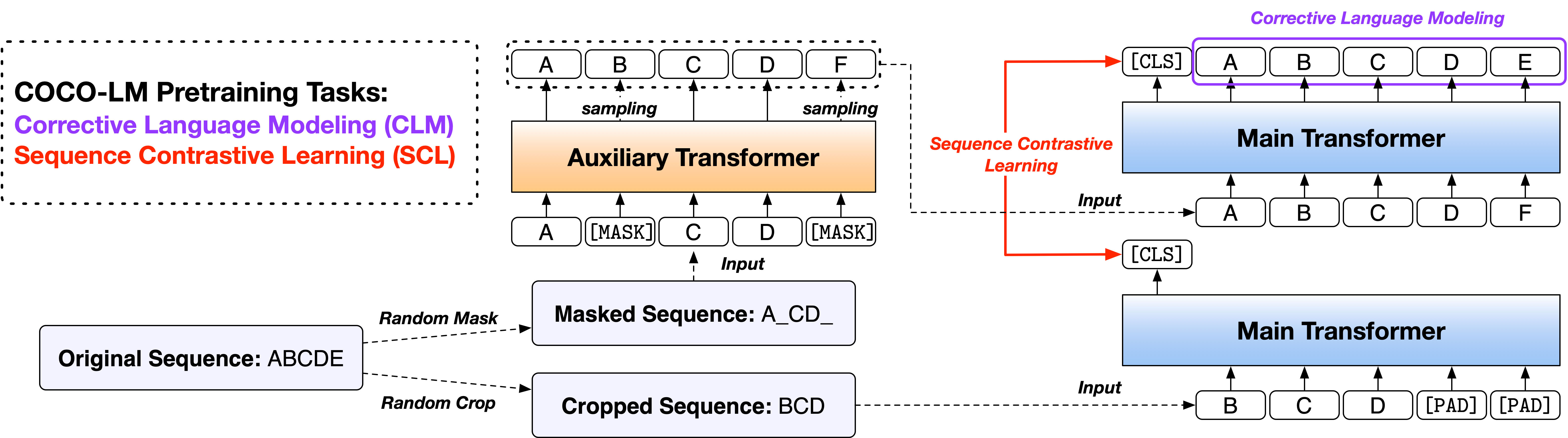

論文:CoCo-LM:言語モデルの前orの修正と対照的なテキストシーケンス

2つの広く使用されているオープンソースコードベース、FairSeqライブラリとHuggingface Transformersライブラリに基づいて、2つのバージョンでスクリプトを提供します。 2つのコードバージョンは機能がほとんど同等であり、それらのいずれかを自由に使用できます。ただし、FairSeqバージョンは実験で使用したものであり、その結果を論文で再現するのが最適であることに注意してください。 Huggingfaceバージョンは後で実装され、Huggingface Transformersライブラリとの互換性を提供し、わずかに異なる結果が得られる場合があります。

コードを実行するために、2つのディレクトリの下のReadMeファイルに従ってください。

一般的な言語理解評価(接着剤)ベンチマークは、自然言語理解システムを評価および分析するための文または文のペア理解タスクのコレクションです。

ココ-LMベース++および大++モデルの接着剤DEVセット結果は次のとおりです(5つの異なるランダムシードの中央値):

| モデル | mnli-m/mm | QQP | Qnli | SST-2 | コーラ | rte | MRPC | sts-b | 平均 |

|---|---|---|---|---|---|---|---|---|---|

| ココ-LMベース++ | 90.2/90.0 | 92.2 | 94.2 | 94.6 | 67.3 | 87.4 | 91.2 | 91.8 | 88.6 |

| ココ-LMラージ++ | 91.4/91.6 | 92.8 | 95.7 | 96.9 | 73.9 | 91.0 | 92.2 | 92.7 | 90.8 |

ココ-LMベース++および大++モデルの接着テストセット結果は次のとおりです(アンサンブル、タスク固有のトリックなど):

| モデル | mnli-m/mm | QQP | Qnli | SST-2 | コーラ | rte | MRPC | sts-b | 平均 |

|---|---|---|---|---|---|---|---|---|---|

| ココ-LMベース++ | 89.8/89.3 | 89.8 | 94.2 | 95.6 | 68.6 | 82.3 | 88.5 | 90.3 | 87.4 |

| ココ-LMラージ++ | 91.6/91.1 | 90.5 | 95.8 | 96.7 | 70.5 | 89.2 | 88.4 | 91.8 | 89.3 |

Stanfordの質問Dataset(Squad)は読解データセットであり、Wikipediaの記事のセットで群衆労働者が提起した質問で構成されています。すべての質問に対する答えは、対応する読み取りの文章からのテキストまたはスパンのセグメントであるか、質問が答えられない場合があります。

Squad 2.0 DEV DEV SET COCO-LM BASE ++および大規模++モデルの結果は次のとおりです(5つの異なるランダムシードの中央値):

| モデル | em | F1 |

|---|---|---|

| ココ-LMベース++ | 85.4 | 88.1 |

| ココ-LMラージ++ | 88.2 | 91.0 |

コードとモデルが研究に役立つ場合は、次の論文を引用してください。

@inproceedings{meng2021cocolm,

title={{COCO-LM}: Correcting and contrasting text sequences for language model pretraining},

author={Meng, Yu and Xiong, Chenyan and Bajaj, Payal and Tiwary, Saurabh and Bennett, Paul and Han, Jiawei and Song, Xia},

booktitle={Conference on Neural Information Processing Systems},

year={2021}

}

このプロジェクトは、貢献と提案を歓迎します。ほとんどの貢献では、貢献者ライセンス契約(CLA)に同意する必要があります。詳細については、https://cla.opensource.microsoft.comをご覧ください。

プルリクエストを送信すると、CLAボットはCLAを提供し、PRを適切に飾る必要があるかどうかを自動的に決定します(たとえば、ステータスチェック、コメント)。ボットが提供する指示に従うだけです。 CLAを使用して、すべてのレポでこれを1回だけ行う必要があります。

このプロジェクトは、Microsoftのオープンソース行動規範を採用しています。詳細については、FAQのコードを参照するか、追加の質問やコメントについては[email protected]にお問い合わせください。