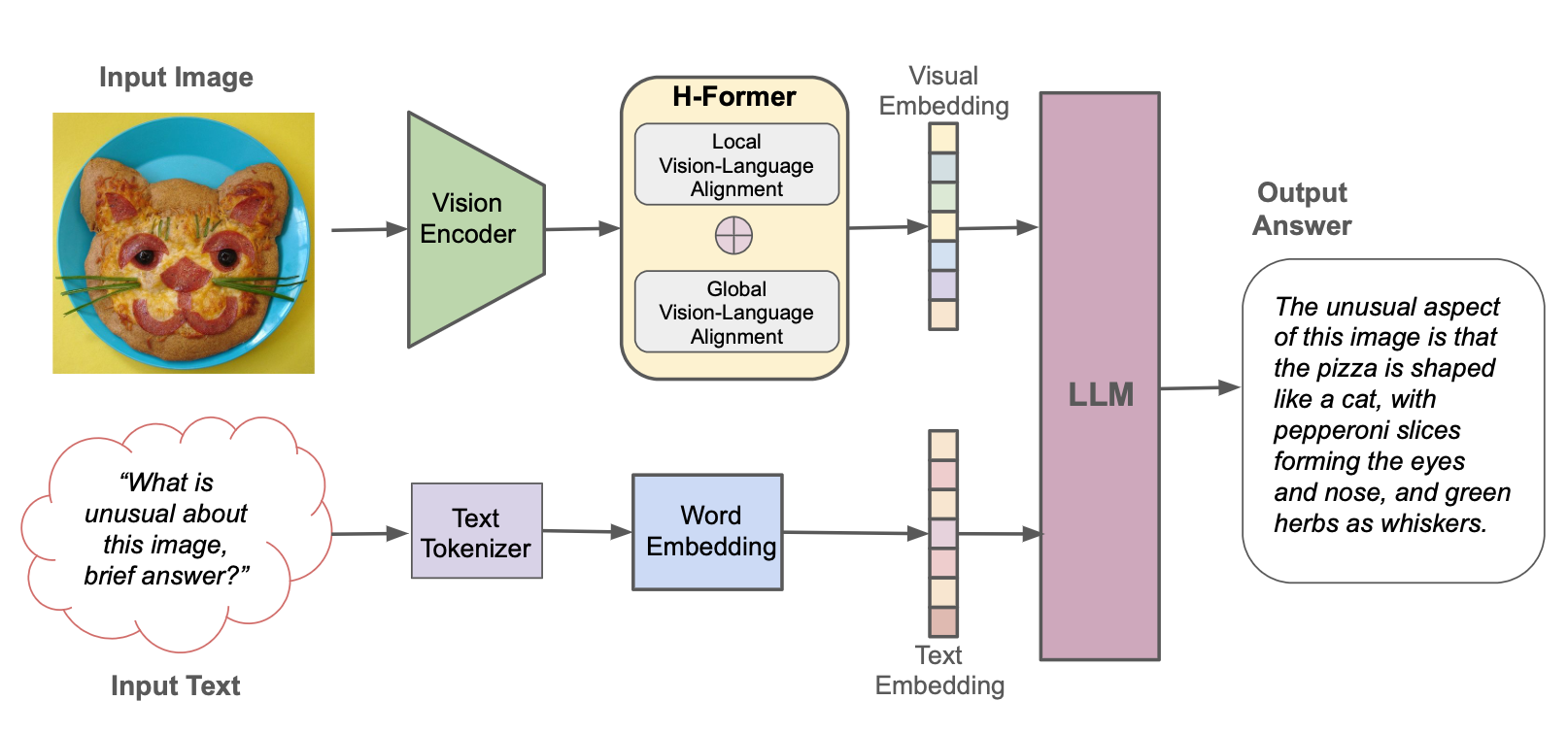

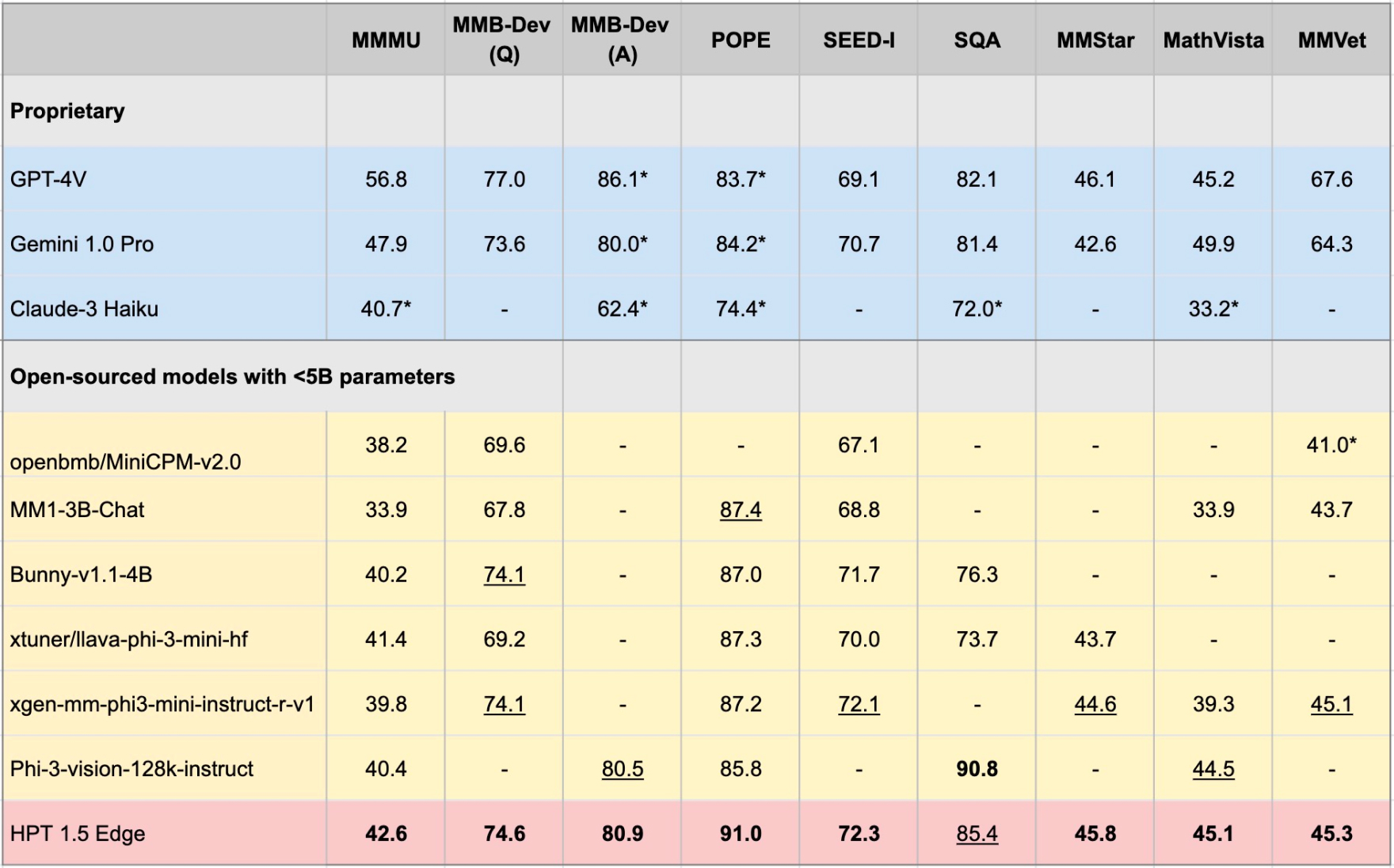

Transformadores hiperpretiados (HPT) é uma nova estrutura multimodal de LLM da Hypergai e foi treinada para modelos de linguagem de visão capazes de entender as entradas textuais e visuais. O HPT alcançou resultados altamente competitivos com modelos de última geração em uma variedade de benchmarks multimodais LLM. Este repositório contém a implementação de código aberto do código de inferência para reproduzir os resultados da avaliação do HPT em diferentes benchmarks.

Lançamos o HPT 1.5 Edge como nosso mais recente modelo de código aberto, adaptado aos dispositivos de borda. Apesar de seu tamanho (<5b), o Edge demonstra recursos impressionantes e é extremamente eficiente. Lançamos o HPT 1.5 Edge publicamente no Huggingface e no GitHub sob a licença Apache 2.0.

pip install -r requirements.txt

pip install -e .

Você pode baixar os pesos do modelo de HF no seu [caminho local] e definir o global_model_path como seu [caminho local] no arquivo de configuração do modelo:

git lfs install

git clone https://huggingface.co/HyperGAI/HPT1_5-Edge [Local Path]

Você também pode definir outras estratégias no arquivo de configuração que são diferentes das nossas configurações padrão.

Depois de configurar o arquivo de configuração, inicie a demonstração do modelo para uma avaliação rápida:

python demo/demo.py --image_path [Image] --text [Text] --model [Config]

Exemplo:

python demo/demo.py --image_path demo/einstein.jpg --text 'What is unusual about this image?' --model hpt-edge-1-5

Inicie o modelo para avaliação:

torchrun --nproc-per-node=8 run.py --data [Dataset] --model [Config]

Exemplo para HPT 1.5 Edge:

torchrun --nproc-per-node=8 run.py --data MMMU_DEV_VAL --model hpt-edge-1-5

Para HPT 1.5 Edge

HPT 1.5 Edge

LLM pré-treinado: phi-3-mini-4K-instruct

Codificador visual pré-treinado: Siglip-SO400M-PACK14-384

HPT 1.5 Ar

LLM pré-treinado: LLAMA3-8B-INSTRUTA

Codificador visual pré-treinado: Siglip-SO400M-PACK14-384

HPT 1.0 Ar

LLM pré-terenciado: Yi-6b-chat

Codificador visual pré-treinado: clip-vit-large-Patch14-336

Observe que o HPT Air é um lançamento rápido de nossos modelos para facilitar a pesquisa aberta e responsável da IA e o desenvolvimento da comunidade. Não possui nenhum mecanismo de moderação e não oferece garantias sobre seus resultados. Esperamos se envolver com a comunidade para fazer com que o modelo respeite o GuardaRails finamente para permitir adoções práticas em aplicativos do mundo real que requerem saídas moderadas.

Este projeto é lançado sob a licença Apache 2.0. Partes deste projeto contêm código e modelos de outras fontes, que estão sujeitas a suas respectivas licenças e você precisa aplicar a respectiva licença, se quiser usar para fins comerciais.

O código de avaliação para executar essa demonstração foi estendido com base no projeto VLMevalkit. Agradecemos também a OpenAI por saber seus modelos de codificadores visuais, 01.ai, Meta e Microsoft por fontes abertas de seus grandes modelos de idiomas.