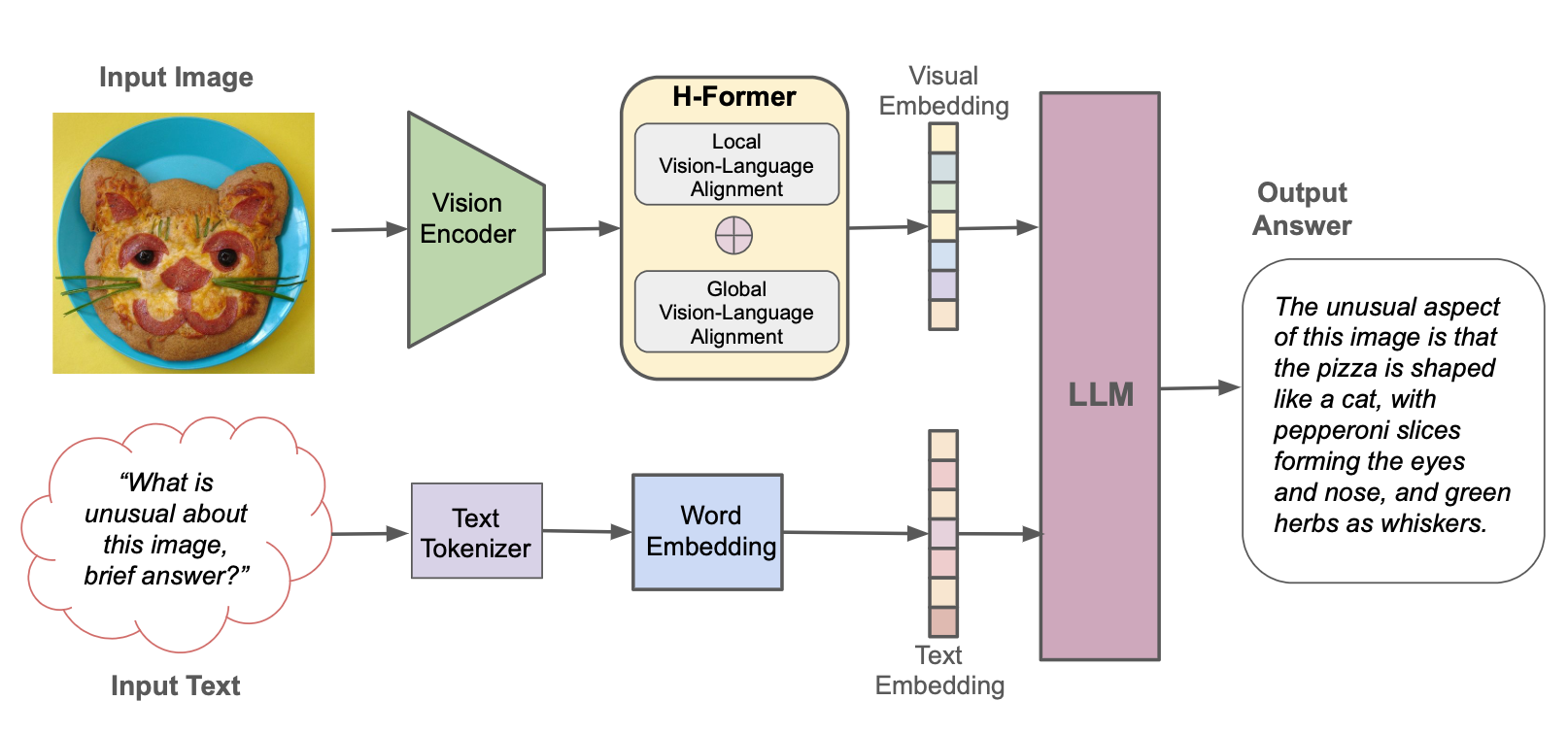

HPT (Hyper-exprained Transformers)는 Hypergai의 새로운 멀티 모달 LLM 프레임 워크이며 텍스트 및 시각적 입력을 모두 이해할 수있는 비전 언어 모델에 대해 교육을 받았습니다. HPT는 다양한 멀티 모달 LLM 벤치 마크에서 최첨단 모델로 경쟁력있는 결과를 얻었습니다. 이 저장소에는 다른 벤치 마크에서 HPT의 평가 결과를 재현하기위한 추론 코드의 오픈 소스 구현이 포함되어 있습니다.

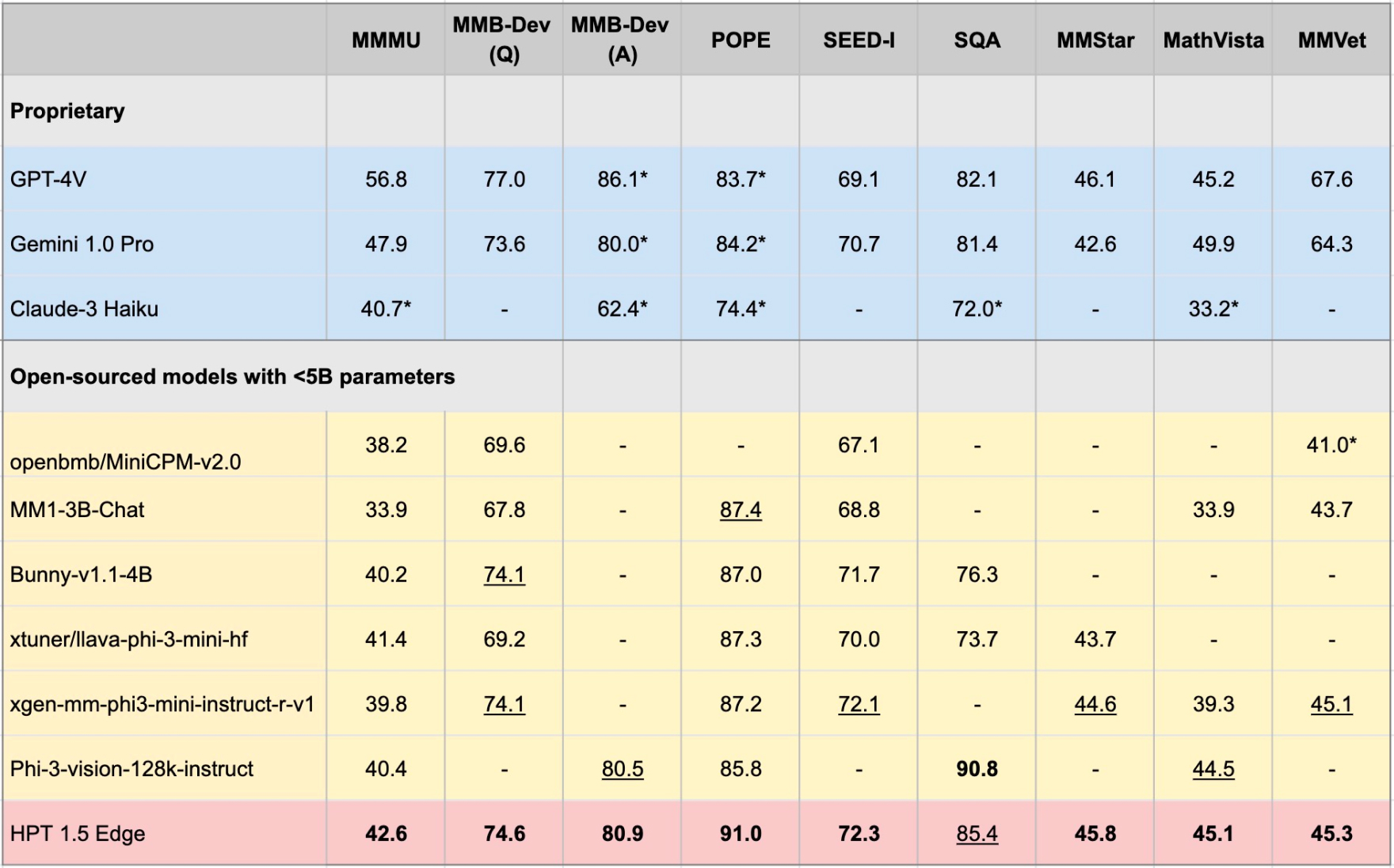

Edge 장치에 맞게 조정 된 최신 Open-Sources 모델로 HPT 1.5 Edge를 출시합니다. 크기 (<5b)에도 불구하고 Edge는 매우 효율적이면서 인상적인 기능을 보여줍니다. 우리는 Apache 2.0 라이센스에 따라 Huggingf

pip install -r requirements.txt

pip install -e .

HF에서 [로컬 경로]로 모델 가중치를 다운로드하고 모델 구성 파일에서 global_model_path [로컬 경로]로 설정할 수 있습니다.

git lfs install

git clone https://huggingface.co/HyperGAI/HPT1_5-Edge [Local Path]

기본 설정과 다른 구성 파일에서 다른 전략을 설정할 수도 있습니다.

구성 파일을 설정 한 후 빠른 시험을 위해 모델 데모를 시작하십시오.

python demo/demo.py --image_path [Image] --text [Text] --model [Config]

예:

python demo/demo.py --image_path demo/einstein.jpg --text 'What is unusual about this image?' --model hpt-edge-1-5

평가 모델을 시작하십시오.

torchrun --nproc-per-node=8 run.py --data [Dataset] --model [Config]

HPT 1.5 에지의 예 :

torchrun --nproc-per-node=8 run.py --data MMMU_DEV_VAL --model hpt-edge-1-5

HPT 1.5 에지의 경우

HPT 1.5 엣지

사전 상사 LLM : PHI-3-MINI-4K-비율

사전에 시각적 인 시각적 엔코더 : Siglip-SO400M-PATCH14-384

HPT 1.5 공기

사전 상사 LLM : LLAMA3-8B 비축

사전에 시각적 인 시각적 엔코더 : Siglip-SO400M-PATCH14-384

HPT 1.0 에어

사전에 사전 LLM : Yi-6B-Chat

사전에 미리 시각적 인 인코더 : 클립-비트-래지-패치 14-336

HPT Air는 개방적이고 책임있는 AI 연구 및 지역 사회 개발을 용이하게하기 위해 우리 모델을 빠르게 공개합니다. 중재 메커니즘이 없으며 결과에 대한 보장을 제공하지 않습니다. 우리는 커뮤니티와 교류하여 모델이 가드 레일을 잘 존중하여 중재 된 출력이 필요한 실제 응용 프로그램에서 실질적인 채택을 허용하기를 희망합니다.

이 프로젝트는 Apache 2.0 라이센스에 따라 릴리스됩니다. 이 프로젝트의 일부에는 해당 라이센스가 적용되는 다른 소스의 코드 및 모델이 포함되어 있으며 상업적 목적으로 사용하려는 경우 해당 라이센스를 적용해야합니다.

이 데모를 실행하기위한 평가 코드는 VLMevalkit 프로젝트를 기반으로 확장되었습니다. 또한 대형 언어 모델 오픈 소싱을 위해 Visual Encoder 모델, 01.ai, Meta 및 Microsoft 오픈 소싱에 대한 OpenAi에 감사드립니다.