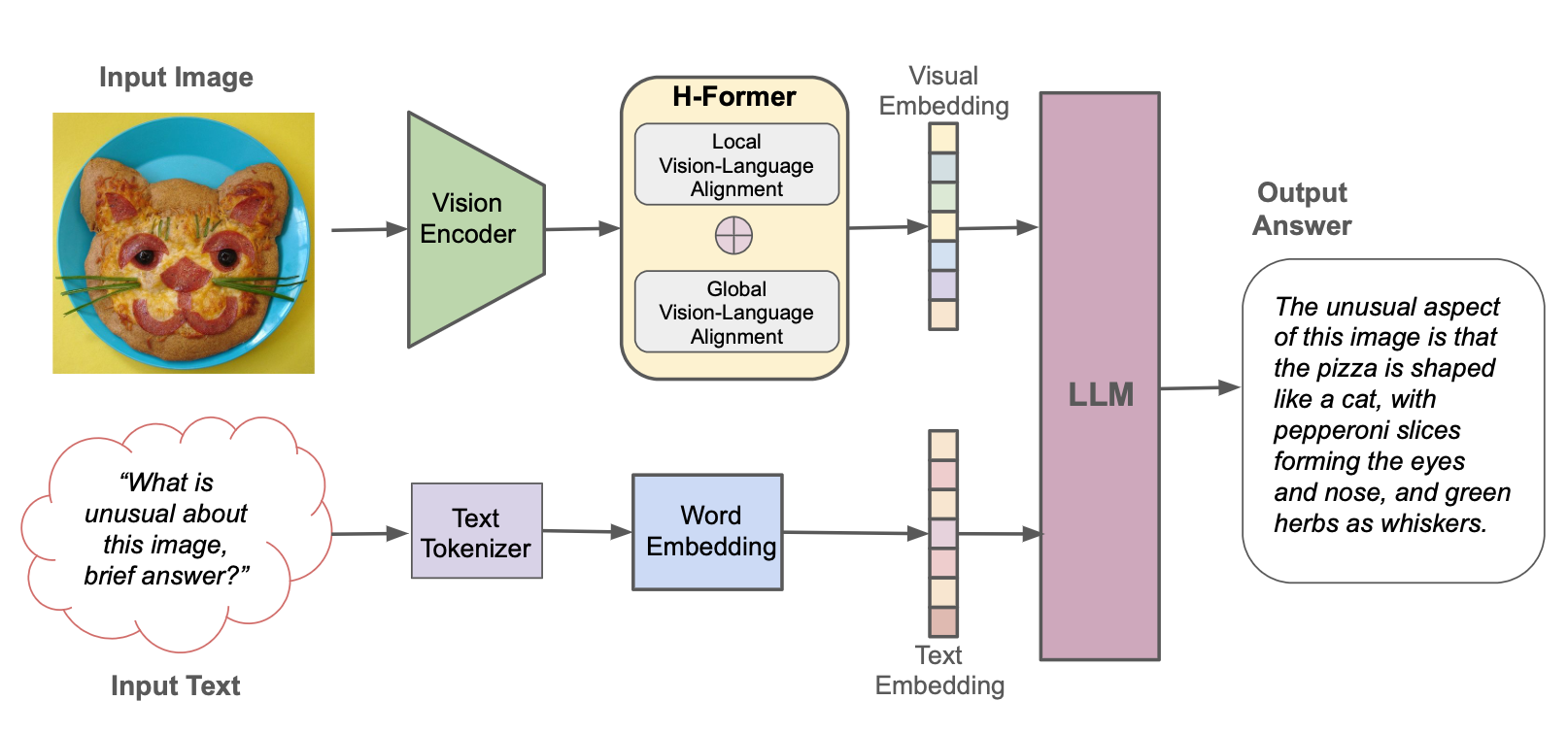

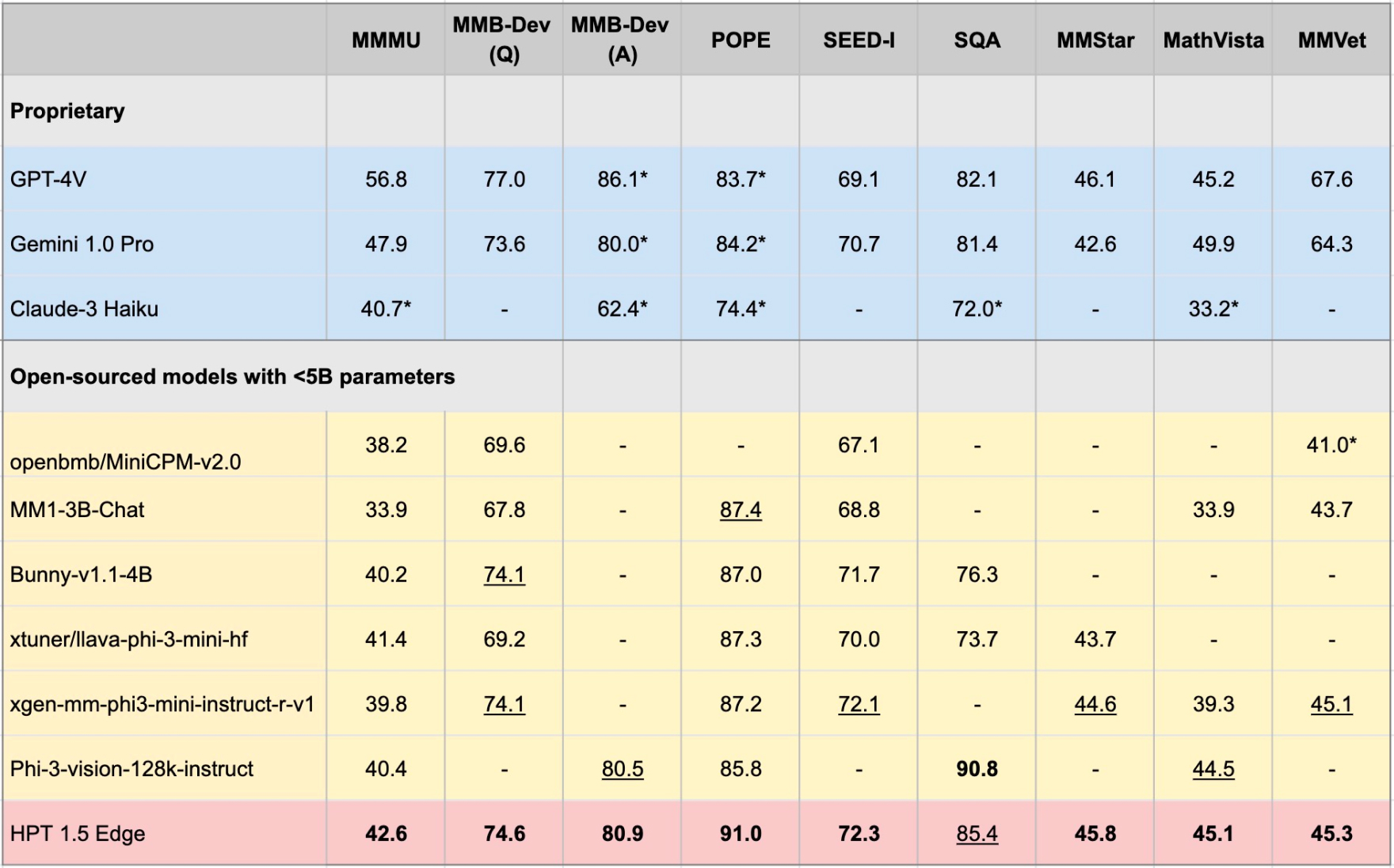

Hyper-pretrained transformers (HPT) adalah kerangka kerja LLM multimodal baru dari Hypergai, dan telah dilatih untuk model bahasa penglihatan yang mampu memahami input tekstual dan visual. HPT telah mencapai hasil yang sangat kompetitif dengan model canggih pada berbagai tolok ukur LLM multimodal. Repositori ini berisi implementasi open-source dari kode inferensi untuk mereproduksi hasil evaluasi HPT pada tolok ukur yang berbeda.

Kami merilis HPT 1.5 Edge sebagai model sumber terbuka terbaru kami yang dirancang untuk perangkat EDGE. Meskipun ukurannya (<5b), Edge menunjukkan kemampuan yang mengesankan sambil menjadi sangat efisien. Kami merilis HPT 1.5 Edge secara publik di Huggingface dan Github di bawah lisensi Apache 2.0.

pip install -r requirements.txt

pip install -e .

Anda dapat mengunduh bobot model dari HF ke [jalur lokal] Anda dan mengatur global_model_path sebagai [jalur lokal] Anda di file konfigurasi model:

git lfs install

git clone https://huggingface.co/HyperGAI/HPT1_5-Edge [Local Path]

Anda juga dapat menetapkan strategi lain dalam file konfigurasi yang berbeda dari pengaturan default kami.

Setelah menyiapkan file konfigurasi, luncurkan demo model untuk uji coba cepat:

python demo/demo.py --image_path [Image] --text [Text] --model [Config]

Contoh:

python demo/demo.py --image_path demo/einstein.jpg --text 'What is unusual about this image?' --model hpt-edge-1-5

Luncurkan model untuk evaluasi:

torchrun --nproc-per-node=8 run.py --data [Dataset] --model [Config]

Contoh untuk HPT 1.5 Edge:

torchrun --nproc-per-node=8 run.py --data MMMU_DEV_VAL --model hpt-edge-1-5

Untuk HPT 1.5 Edge

HPT 1.5 Edge

Pretrained llm: phi-3-mini-4k-instruct

Encoder Visual Pretrained: Siglip-SO400M-Patch14-384

HPT 1,5 udara

Pretrained llm: llama3-8b-instruct

Encoder Visual Pretrained: Siglip-SO400M-Patch14-384

HPT 1.0 AIR

Pretrained llm: yi-6b-chat

Encoder visual pretrained: clip-vit-large-patch14-336

Perhatikan bahwa HPT Air adalah rilis cepat dari model kami untuk memfasilitasi penelitian AI yang terbuka dan bertanggung jawab dan pengembangan masyarakat. Itu tidak memiliki mekanisme moderasi dan tidak memberikan jaminan pada hasilnya. Kami berharap dapat terlibat dengan masyarakat untuk membuat model ini menghormati pagar pembatas untuk memungkinkan adopsi praktis dalam aplikasi dunia nyata yang membutuhkan output moderat.

Proyek ini dirilis di bawah lisensi Apache 2.0. Bagian dari proyek ini berisi kode dan model dari sumber lain, yang tunduk pada lisensi masing -masing dan Anda perlu menerapkan lisensi masing -masing jika Anda ingin menggunakan untuk tujuan komersial.

Kode evaluasi untuk menjalankan demo ini diperluas berdasarkan proyek VLMevalkit. Kami juga berterima kasih kepada OpenAI untuk open-sourcing model enkoder visual mereka, 01.ai, Meta dan Microsoft untuk open-sourcing model bahasa besar mereka.