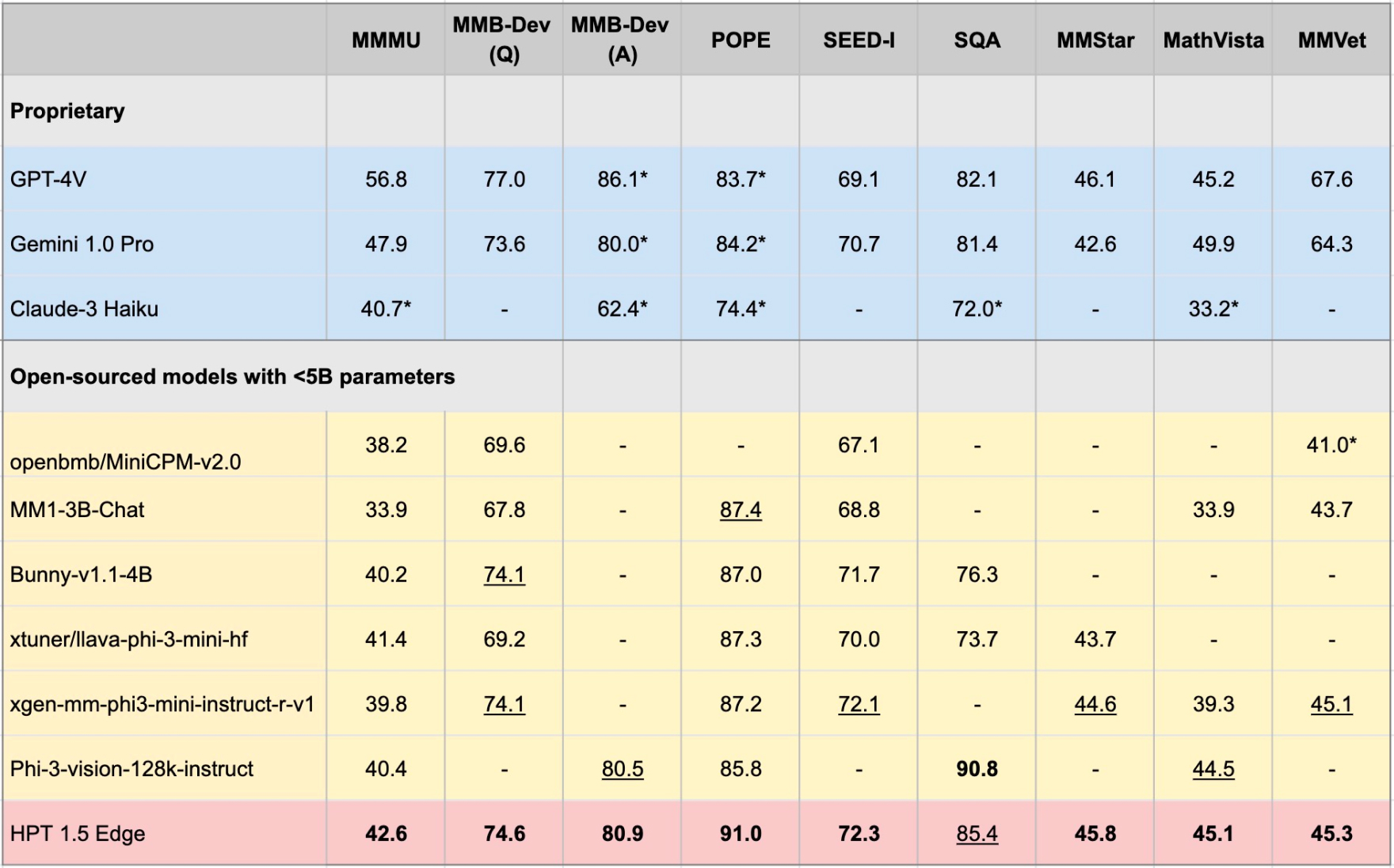

Hyper-vorab-Transformers (HPT) ist ein neuartiges multimodales LLM-Framework aus Hypergai und wurde für Visionsprachel-Modelle ausgebildet, die sowohl textliche als auch visuelle Eingaben verstehen können. HPT hat mit hochmodernen Modellen für eine Vielzahl multimodaler LLM-Benchmarks hoch wettbewerbsfähige Ergebnisse erzielt. Dieses Repository enthält die Open-Source-Implementierung von Inferenzcode, um die Bewertungsergebnisse von HPT an verschiedenen Benchmarks zu reproduzieren.

Wir veröffentlichen HPT 1.5 Edge als unser neuestes Open-Sources-Modell, das auf Edge-Geräte zugeschnitten ist. Trotz seiner Größe (<5b) zeigt Edge beeindruckende Fähigkeiten und ist äußerst effizient. Wir veröffentlichen HPT 1.5 Edge öffentlich bei Huggingface und GitHub unter der Apache 2.0 -Lizenz.

pip install -r requirements.txt

pip install -e .

Sie können die Modellgewichte von HF in Ihren [lokalen Pfad] herunterladen und den global_model_path als [lokaler Pfad] in der Modellkonfigurationsdatei festlegen:

git lfs install

git clone https://huggingface.co/HyperGAI/HPT1_5-Edge [Local Path]

Sie können auch andere Strategien in der Konfigurationsdatei festlegen, die sich von unseren Standardeinstellungen unterscheiden.

Starten Sie nach dem Einrichten der Konfigurationsdatei die Modelldemo für eine kurze Testversion:

python demo/demo.py --image_path [Image] --text [Text] --model [Config]

Beispiel:

python demo/demo.py --image_path demo/einstein.jpg --text 'What is unusual about this image?' --model hpt-edge-1-5

Starten Sie das Modell zur Bewertung:

torchrun --nproc-per-node=8 run.py --data [Dataset] --model [Config]

Beispiel für HPT 1.5 Edge:

torchrun --nproc-per-node=8 run.py --data MMMU_DEV_VAL --model hpt-edge-1-5

Für HPT 1.5 Kante

HPT 1,5 Kante

Vorbereitetes LLM: PHI-3-Mini-4K-Instruktur

Vorbereiteter visueller Encoder: Siglip-SO400M-Patch14-384

HPT 1.5 Luft

Vorbereitetes LLM: LLAMA3-8B-Instruct

Vorbereiteter visueller Encoder: Siglip-SO400M-Patch14-384

HPT 1.0 Luft

Vorbereitetes LLM: Yi-6b-Chat

PretRained Visual Encoder: Clip-Vit-Large-Patch14-336

Beachten Sie, dass die HPT Air eine schnelle offene Veröffentlichung unserer Modelle ist, um die offene, verantwortungsvolle AI -Forschung und die Entwicklung der Gemeinschaft zu erleichtern. Es hat keinen Mäßigungsmechanismus und bietet keine Garantien für ihre Ergebnisse. Wir hoffen, mit der Community in Kontakt zu treten, damit das Modell Leitplanken fein respektiert, um praktische Adoptionen in realen Anwendungen zu ermöglichen, die moderierte Ausgaben erfordern.

Dieses Projekt wird unter der Apache 2.0 -Lizenz veröffentlicht. Teile dieses Projekts enthalten Code und Modelle aus anderen Quellen, die ihren jeweiligen Lizenzen unterliegen, und Sie müssen ihre jeweilige Lizenz anwenden, wenn Sie für kommerzielle Zwecke verwenden möchten.

Der Bewertungscode für die Ausführung dieser Demo wurde basierend auf dem VLMevalkit -Projekt erweitert. Wir danken auch Openai für das Open-Souring-Modellen für visuelle Encoder, 01.AI, Meta und Microsoft, für Open-Sourcing ihrer großen Sprachmodelle.