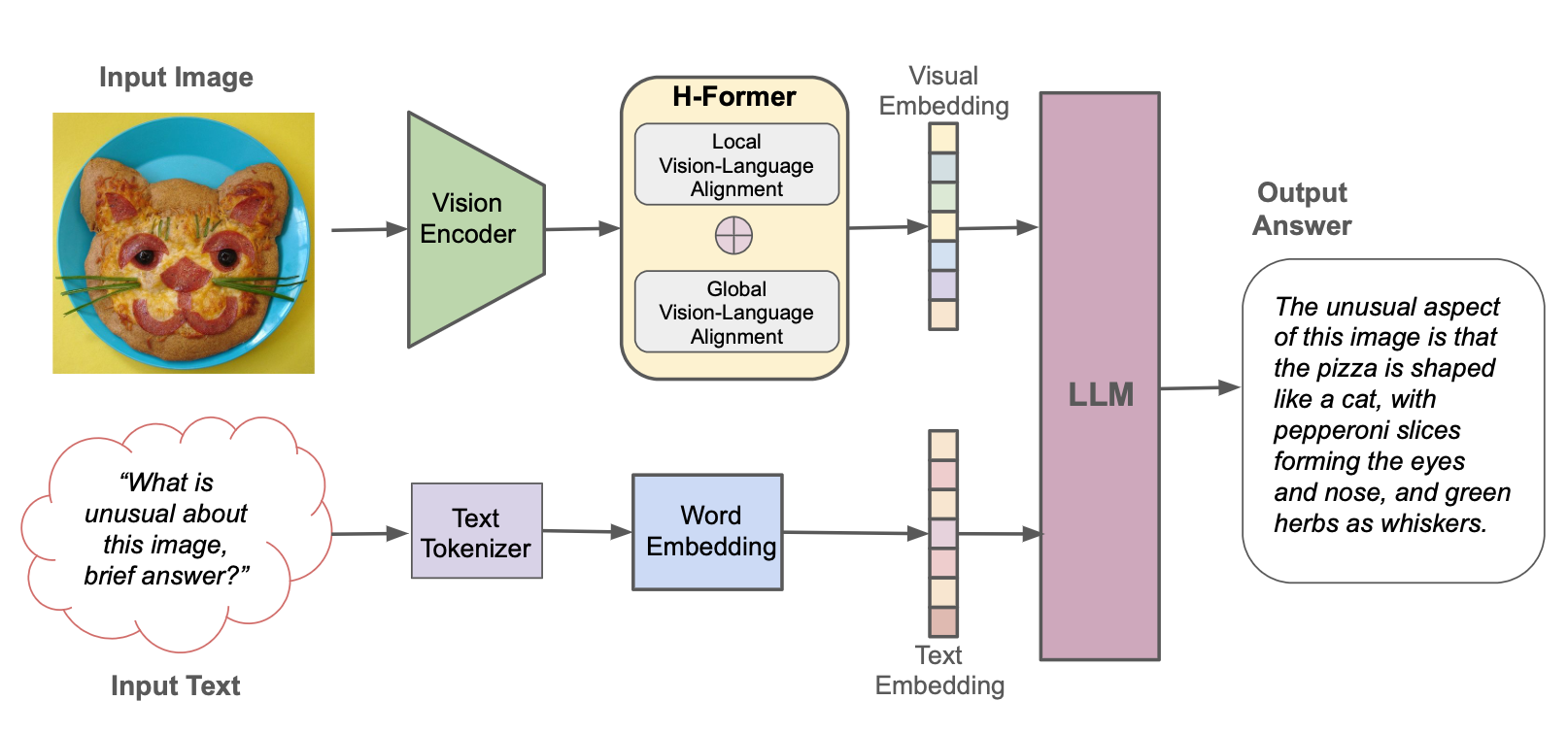

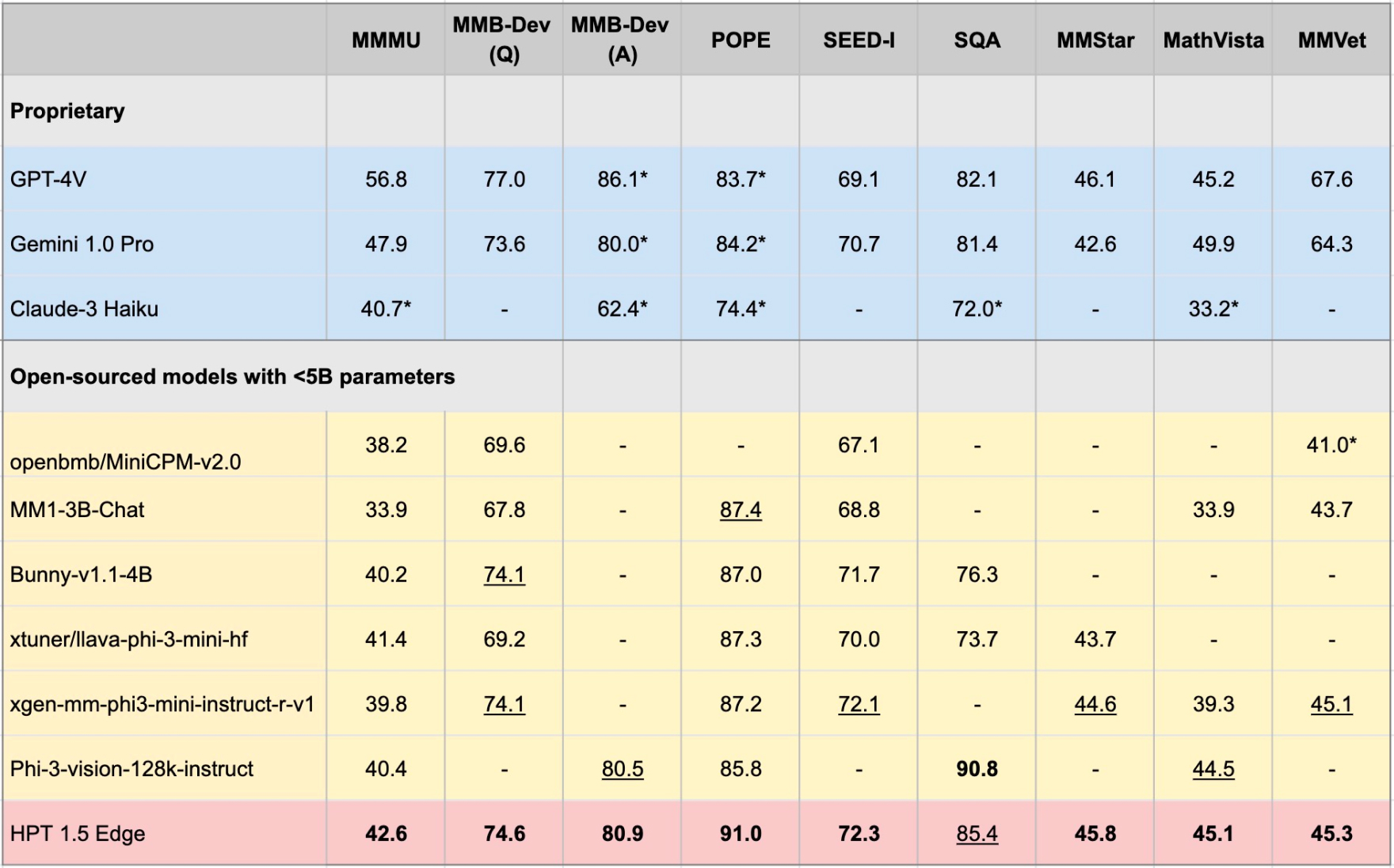

Les transformateurs hyper-prétraités (HPT) sont un nouveau cadre LLM multimodal d'Hypergai, et a été formé pour des modèles de vision qui sont capables de comprendre les entrées textuelles et visuelles. HPT a obtenu des résultats très compétitifs avec des modèles de pointe sur une variété de repères LLM multimodaux. Ce référentiel contient l'implémentation open source du code d'inférence pour reproduire les résultats d'évaluation de HPT sur différents repères.

Nous publions HPT 1.5 Edge en tant que dernier modèle open-source adapté aux périphériques Edge. Malgré sa taille (<5b), Edge montre des capacités impressionnantes tout en étant extrêmement efficace. Nous publions publiquement HPT 1.5 Edge sur HuggingFace et GitHub sous la licence Apache 2.0.

pip install -r requirements.txt

pip install -e .

Vous pouvez télécharger les poids du modèle à partir de HF dans votre [chemin local] et définir le global_model_path comme [chemin local] dans le fichier de configuration du modèle:

git lfs install

git clone https://huggingface.co/HyperGAI/HPT1_5-Edge [Local Path]

Vous pouvez également définir d'autres stratégies dans le fichier de configuration qui sont différentes de nos paramètres par défaut.

Après avoir configuré le fichier de configuration, lancez la démo du modèle pour un essai rapide:

python demo/demo.py --image_path [Image] --text [Text] --model [Config]

Exemple:

python demo/demo.py --image_path demo/einstein.jpg --text 'What is unusual about this image?' --model hpt-edge-1-5

Lancez le modèle d'évaluation:

torchrun --nproc-per-node=8 run.py --data [Dataset] --model [Config]

Exemple pour HPT 1.5 Edge:

torchrun --nproc-per-node=8 run.py --data MMMU_DEV_VAL --model hpt-edge-1-5

Pour HPT 1.5 Edge

HPT 1.5 Edge

LLM pré-entraîné: PHI-3-MINI-4K-INSTRUCT

Encodeur visuel pré-entraîné: Siglip-SO400M-Patch14-384

HPT 1.5 Air

Pré-entraînement LLM: LLAMA3-8B-INSTRUCT

Encodeur visuel pré-entraîné: Siglip-SO400M-Patch14-384

HPT 1.0 Air

LLM pré-entraîné: YI-6B-CHAT

Encodeur visuel pré-entraîné: Clip-Vit-Garn-Patch14-336

Notez que le HPT Air est une version rapide de nos modèles pour faciliter la recherche ouverte et responsable de l'IA et le développement communautaire. Il n'a aucun mécanisme de modération et ne fournit aucune garantie sur leurs résultats. Nous espérons s'engager avec la communauté pour que le modèle respecte les garde-corps finement pour permettre des adoptions pratiques dans les applications du monde réel nécessitant des résultats modérés.

Ce projet est publié sous la licence Apache 2.0. Certaines parties de ce projet contiennent du code et des modèles provenant d'autres sources, qui sont soumises à leurs licences respectives et vous devez appliquer leur licence respective si vous souhaitez utiliser à des fins commerciales.

Le code d'évaluation pour l'exécution de cette démo a été étendu sur la base du projet VLMevalkit. Nous remercions également Openai pour l'ouverture de leurs modèles d'encodeur visuels, 01.ai, Meta et Microsoft pour l'ouverture de leurs grands modèles de langue.