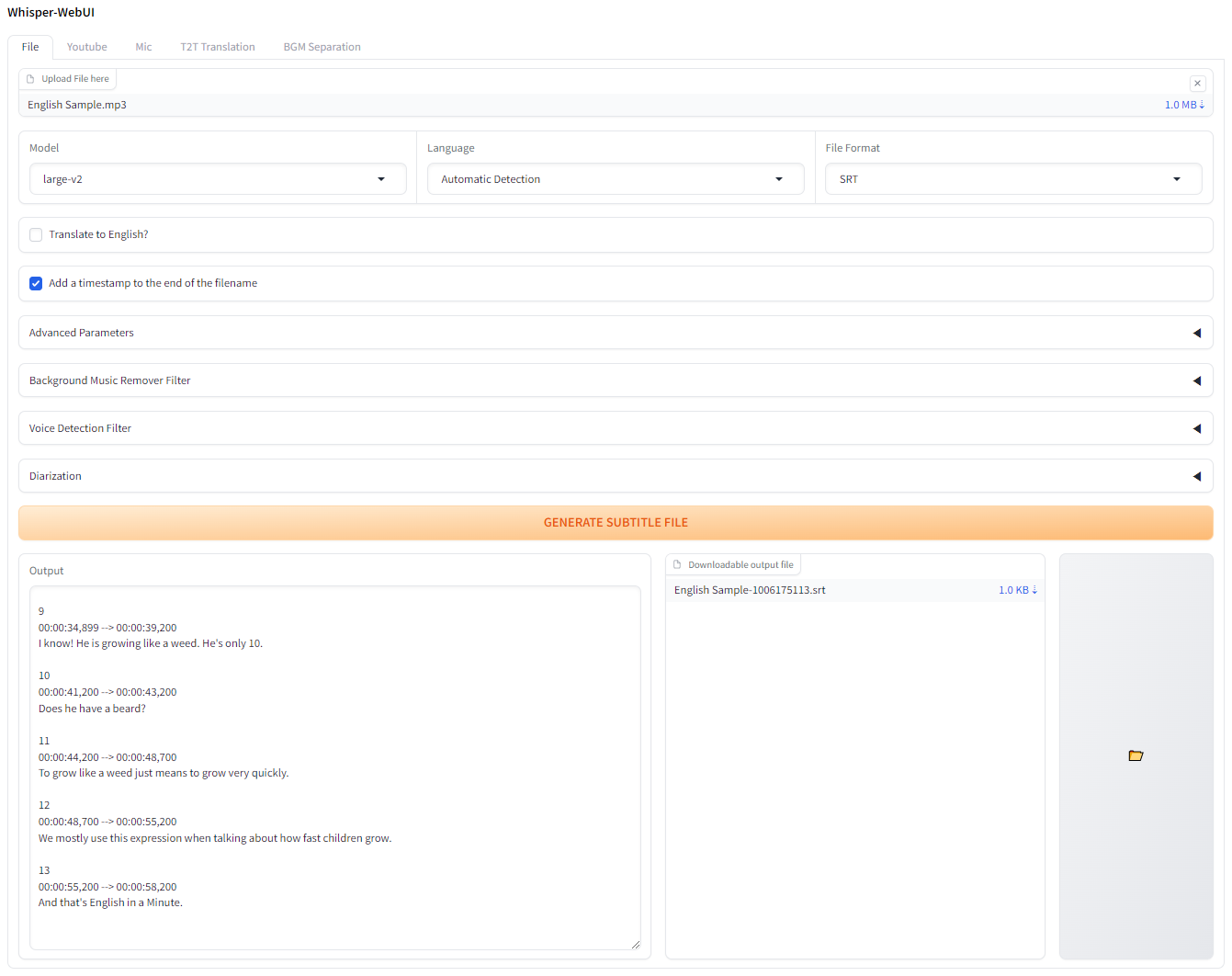

Uma interface de navegador baseada em graduação para Whisper. Você pode usá -lo como um gerador de legenda fácil!

Se você deseja experimentar isso no Colab, pode fazê -lo aqui!

O aplicativo é capaz de executar com Pinokio.

http://localhost:7860 . Instale e inicie o Docker-Desktop.

Clone git o repositório

git clone https://github.com/jhj0517/Whisper-WebUI.gitdocker compose build docker compose uphttp://localhost:7860 Se necessário, atualize o docker-compose.yaml para corresponder ao seu ambiente.

Para executar este webui, você precisa ter git , 3.10 <= python <= 3.12 , FFmpeg .

E se você não estiver usando uma GPU da NVIDA ou usando uma versão CUDA diferente de 12.4, edite os requirements.txt para corresponder ao seu ambiente.

Siga os links abaixo para instalar o software necessário:

3.10 ~ 3.12 é recomendado. Depois de instalar o FFMPEG, adicione a pasta FFmpeg/bin ao caminho do sistema!

git clone https://github.com/jhj0517/Whisper-WebUI.gitinstall.bat ou install.sh para instalar dependências. (Ele criará um diretório venv e instalará dependências lá.)start-webui.bat ou start-webui.sh (ele executará python app.py após ativar o Venv)E você também pode executar o projeto com argumentos da linha de comando, se quiser, consulte o Wiki para um guia de argumentos.

Este projeto é integrado com mais rápido e mais rápido por padrão para melhor uso de VRAM e velocidade de transcrição.

De acordo com mais rápido, a eficiência do modelo de sussurro otimizado é o seguinte:

| Implementação | Precisão | Tamanho do feixe | Tempo | Máx. Memória da GPU | Máx. Memória da CPU |

|---|---|---|---|---|---|

| Openai/sussurro | FP16 | 5 | 4m30s | 11325MB | 9439MB |

| mais rápido | FP16 | 5 | 54s | 4755MB | 3244MB |

Se você deseja usar uma implementação que não seja mais rápida, use --whisper_type arg e o nome do repositório.

Leia o Wiki para obter mais informações sobre a CLI Args.

Esta é a tabela de uso original do VRAM do Whisper para modelos.

| Tamanho | Parâmetros | Modelo somente em inglês | Modelo multilíngue | VRAM necessário | Velocidade relativa |

|---|---|---|---|---|---|

| pequeno | 39 m | tiny.en | tiny | ~ 1 GB | ~ 32x |

| base | 74 m | base.en | base | ~ 1 GB | ~ 16x |

| pequeno | 244 m | small.en | small | ~ 2 GB | ~ 6x |

| médio | 769 m | medium.en | medium | ~ 5 GB | ~ 2x |

| grande | 1550 m | N / D | large | ~ 10 GB | 1x |

.en Modelos são apenas para inglês, e o legal é que você pode usar a opção Translate to English dos modelos "grandes"!

Qualquer PRS que traduz o idioma em tradução. YAML seria muito apreciado!