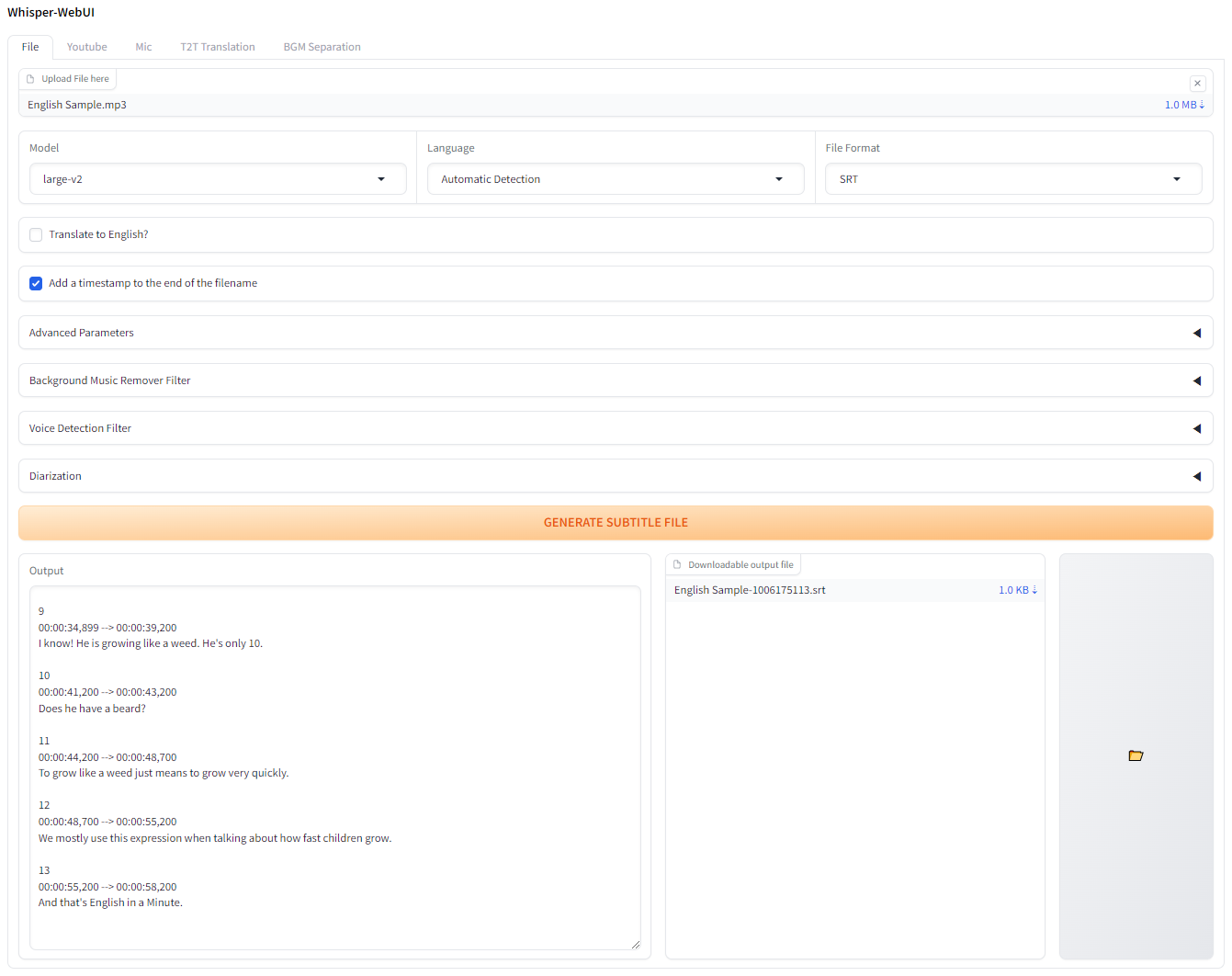

Eine basierte Browser-Schnittstelle für Flüsterung. Sie können es als einfachen Untertitelgenerator verwenden!

Wenn Sie dies auf Colab versuchen möchten, können Sie es hier tun!

Die App kann mit Pinokio ausgeführt werden.

http://localhost:7860 . Installieren und starten Sie Docker-Desktop.

Git -Klon das Repository

git clone https://github.com/jhj0517/Whisper-WebUI.gitdocker compose build docker compose uphttp://localhost:7860 eine Verbindung zum Webui her Aktualisieren Sie bei Bedarf die docker-compose.yaml so, dass sie Ihrer Umgebung entspricht.

Um dieses Webui auszuführen, müssen Sie git , 3.10 <= python <= 3.12 , FFmpeg haben.

Und wenn Sie keine NVIDA -GPU oder eine andere CUDA -Version als 12,4 verwenden, bearbeiten Sie die requirements.txt , um Ihre Umgebung zu entsprechen.

Bitte folgen Sie den folgenden Links, um die erforderliche Software zu installieren:

3.10 ~ 3.12 wird empfohlen. Stellen Sie nach dem Installieren von FFMPEG den Ordner FFmpeg/bin zu Ihrem Systempfad hin!

git clone https://github.com/jhj0517/Whisper-WebUI.gitinstall.bat oder install.sh aus, um Abhängigkeiten zu installieren. (Es wird ein venv -Verzeichnis erstellt und dort Abhängigkeiten installiert.)start-webui.bat oder start-webui.sh (es wird python app.py nach Aktivierung des Venvs ausgeführt)Und Sie können das Projekt auch mit Befehlszeilenargumenten ausführen, wenn Sie möchten, finden Sie in Wiki eine Anleitung zu Argumenten.

Dieses Projekt ist standardmäßig in schnellerer WHISPER integriert, um eine bessere VRAM-Nutzung und Transkriptionsgeschwindigkeit zu erzielen.

Laut schnellerem Whisper ist die Effizienz des optimierten Flüstungsmodells wie folgt:

| Durchführung | Präzision | Strahlgröße | Zeit | Max. GPU -Speicher | Max. CPU -Speicher |

|---|---|---|---|---|---|

| Openai/Whisper | FP16 | 5 | 4m30s | 11325MB | 9439MB |

| schneller-Whisper | FP16 | 5 | 54s | 4755 MB | 3244MB |

Wenn Sie eine andere Implementierung als schneller-Whisper verwenden möchten, verwenden Sie --whisper_type arg und den Repository-Namen.

Lesen Sie Wiki für weitere Informationen zu CLI Args.

Dies ist Whispers ursprünglicher VRAM -Nutzungstisch für Modelle.

| Größe | Parameter | Nur Englischmodell | Mehrsprachiger Modell | Erforderliches VRAM | Relative Geschwindigkeit |

|---|---|---|---|---|---|

| winzig | 39 m | tiny.en | tiny | ~ 1 GB | ~ 32x |

| Base | 74 m | base.en | base | ~ 1 GB | ~ 16x |

| klein | 244 m | small.en | small | ~ 2 GB | ~ 6x |

| Medium | 769 m | medium.en | medium | ~ 5 GB | ~ 2x |

| groß | 1550 m | N / A | large | ~ 10 GB | 1x |

.en -Modelle sind nur für Englisch, und das Coole ist, dass Sie die Option " Translate to English Option" aus den "großen" Modellen verwenden können!

Alle PRs, die die Sprache in Übersetzung übersetzen. Yaml wäre sehr geschätzt!