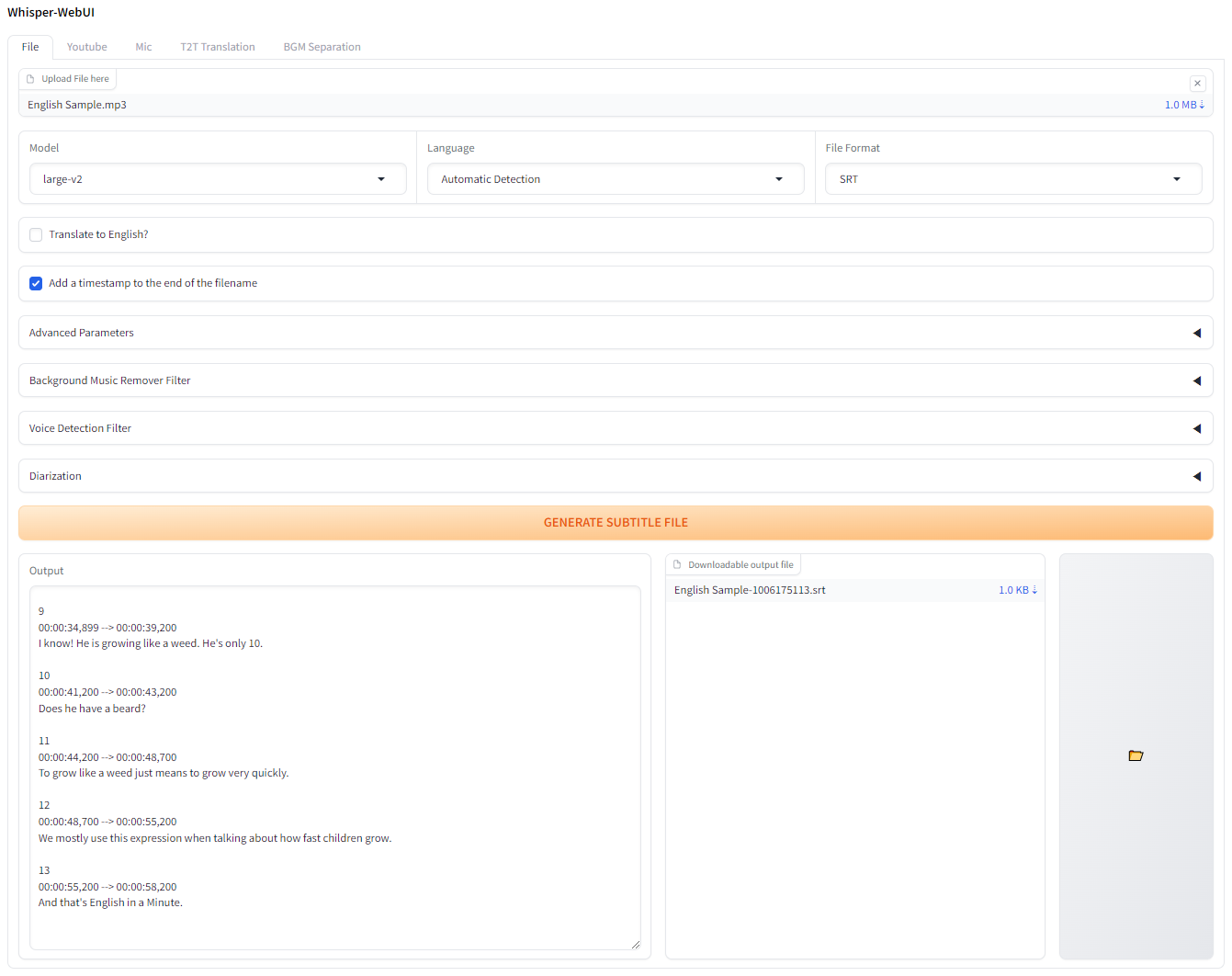

Une interface de navigateur basée sur Gradio pour Whisper. Vous pouvez l'utiliser comme un générateur de sous-titre facile!

Si vous souhaitez essayer ceci sur Colab, vous pouvez le faire ici!

L'application est capable de s'exécuter avec Pinokio.

http://localhost:7860 . Installez et lancez Docker-desktop.

Git clone le référentiel

git clone https://github.com/jhj0517/Whisper-WebUI.gitdocker compose build docker compose uphttp://localhost:7860 Si nécessaire, mettez à jour le docker-compose.yaml pour correspondre à votre environnement.

Pour exécuter ce webui, vous devez avoir git , 3.10 <= python <= 3.12 , FFmpeg .

Et si vous n'utilisez pas un GPU NVIDA ou si vous n'utilisez pas une version CUDA différente de 12.4, modifiez les requirements.txt pour correspondre à votre environnement.

Veuillez suivre les liens ci-dessous pour installer le logiciel nécessaire:

3.10 ~ 3.12 est recommandé. Après avoir installé FFMPEG, assurez-vous d'ajouter le dossier FFmpeg/bin à votre chemin système!

git clone https://github.com/jhj0517/Whisper-WebUI.gitinstall.bat ou install.sh pour installer les dépendances. (Il créera un répertoire venv et y installera des dépendances.)start-webui.bat ou start-webui.sh (il exécutera python app.py après l'activation du venv)Et vous pouvez également exécuter le projet avec des arguments de ligne de commande si vous le souhaitez, voir Wiki pour un guide des arguments.

Ce projet est intégré à un Whisper plus rapide par défaut pour une meilleure utilisation VRAM et une vitesse de transcription.

Selon plus rapide, l'efficacité du modèle de chuchotement optimisé est la suivante:

| Mise en œuvre | Précision | Taille de faisceau | Temps | Max. Mémoire de GPU | Max. Mémoire du processeur |

|---|---|---|---|---|---|

| Openai / Whisper | FP16 | 5 | 4m30 | 11325 Mo | 9439 Mo |

| plus rapide | FP16 | 5 | 54S | 4755 Mo | 3244 Mo |

Si vous souhaitez utiliser une implémentation autre que plus rapide, utilisez --whisper_type Arg et le nom du référentiel.

Lisez le wiki pour plus d'informations sur CLI Args.

Il s'agit de la table d'utilisation VRAM originale de Whisper pour les modèles.

| Taille | Paramètres | Modèle uniquement en anglais | Modèle multilingue | Requis VRAM | Vitesse relative |

|---|---|---|---|---|---|

| minuscule | 39 m | tiny.en | tiny | ~ 1 Go | ~ 32x |

| base | 74 m | base.en | base | ~ 1 Go | ~ 16x |

| petit | 244 m | small.en | small | ~ 2 Go | ~ 6x |

| moyen | 769 m | medium.en | medium | ~ 5 Go | ~ 2x |

| grand | 1550 m | N / A | large | ~ 10 Go | 1x |

.en modèles sont pour l'anglais uniquement, et ce qui est cool est que vous pouvez utiliser l'option Translate to English des "grands" modèles!

Tout PRS qui traduit la langue en traduction.yaml serait grandement apprécié!