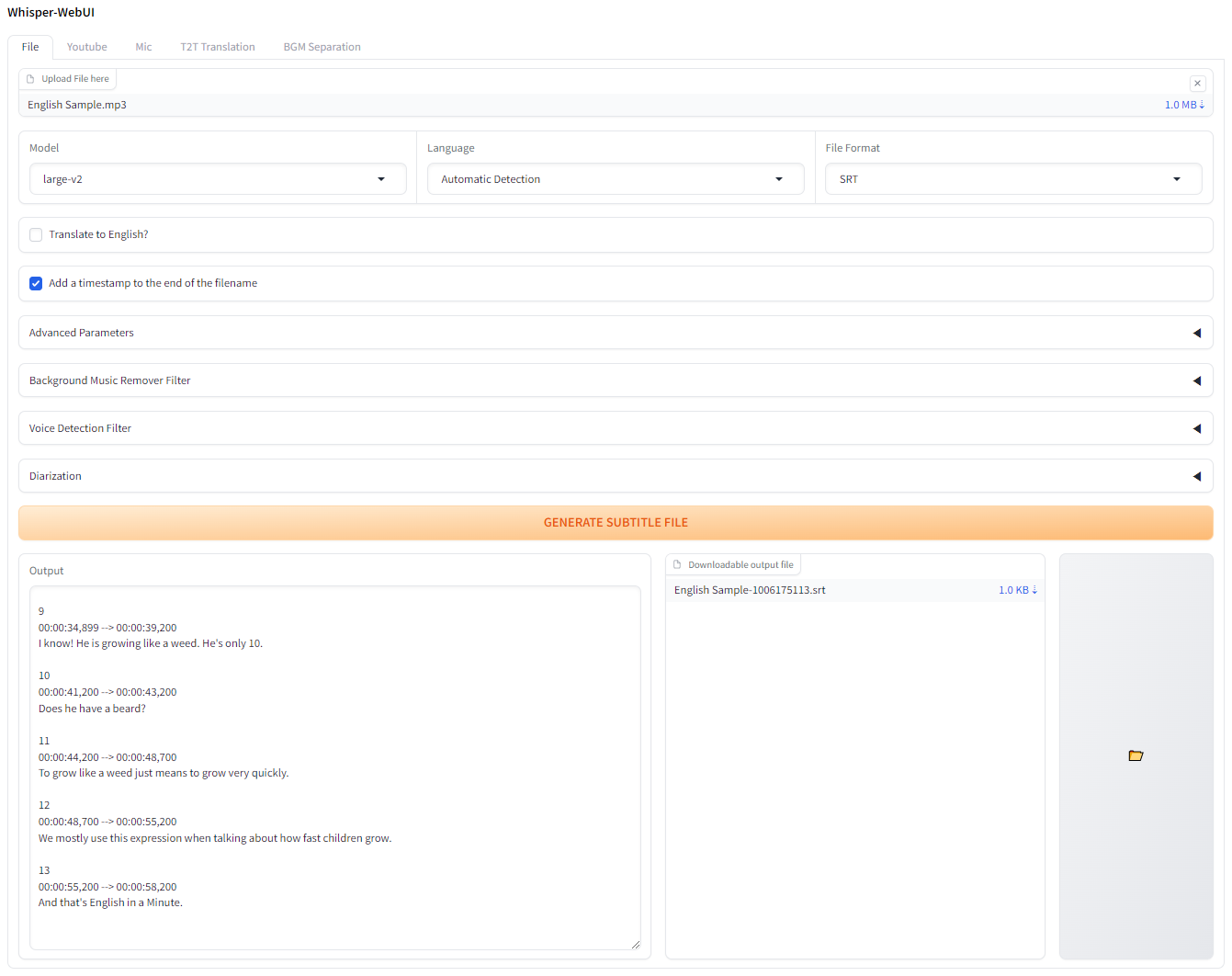

Antarmuka browser berbasis gradio untuk Whisper. Anda dapat menggunakannya sebagai generator subtitle yang mudah!

Jika Anda ingin mencoba ini di Colab, Anda dapat melakukannya di sini!

Aplikasi ini dapat berjalan dengan Pinokio.

http://localhost:7860 . Instal dan luncurkan Docker-Desktop.

Git mengkloning repositori

git clone https://github.com/jhj0517/Whisper-WebUI.gitdocker compose build docker compose uphttp://localhost:7860 Jika perlu, perbarui docker-compose.yaml untuk mencocokkan lingkungan Anda.

Untuk menjalankan webui ini, Anda harus memiliki git , 3.10 <= python <= 3.12 , FFmpeg .

Dan jika Anda tidak menggunakan GPU NVIDA, atau menggunakan versi CUDA yang berbeda dari 12.4, edit requirements.txt untuk mencocokkan lingkungan Anda.

Ikuti tautan di bawah ini untuk menginstal perangkat lunak yang diperlukan:

3.10 ~ 3.12 direkomendasikan. Setelah menginstal FFMPEG, pastikan untuk menambahkan folder FFmpeg/bin ke jalur sistem Anda!

git clone https://github.com/jhj0517/Whisper-WebUI.gitinstall.bat atau install.sh untuk menginstal dependensi. (Ini akan membuat direktori venv dan menginstal dependensi di sana.)start-webui.bat atau start-webui.sh (itu akan menjalankan python app.py setelah mengaktifkan venv)Dan Anda juga dapat menjalankan proyek dengan argumen baris perintah jika Anda suka, lihat wiki untuk panduan argumen.

Proyek ini terintegrasi dengan lebih cepat whisper secara default untuk penggunaan VRAM dan kecepatan transkripsi yang lebih baik.

Menurut lebih cepat-whisper, efisiensi model bisikan yang dioptimalkan adalah sebagai berikut:

| Pelaksanaan | Presisi | Ukuran balok | Waktu | Max. Memori GPU | Max. Memori CPU |

|---|---|---|---|---|---|

| Openai/Whisper | FP16 | 5 | 4m30 -an | 11325MB | 9439MB |

| lebih cepat whisper | FP16 | 5 | 54S | 4755MB | 3244MB |

Jika Anda ingin menggunakan implementasi selain lebih cepat, gunakan --whisper_type arg dan nama repositori.

Baca Wiki untuk info lebih lanjut tentang CLI Args.

Ini adalah tabel penggunaan VRAM asli Whisper untuk model.

| Ukuran | Parameter | Model hanya bahasa Inggris | Model multibahasa | Diperlukan vram | Kecepatan relatif |

|---|---|---|---|---|---|

| kecil | 39 m | tiny.en | tiny | ~ 1 GB | ~ 32x |

| basis | 74 m | base.en | base | ~ 1 GB | ~ 16x |

| kecil | 244 m | small.en | small | ~ 2 GB | ~ 6x |

| sedang | 769 m | medium.en | medium | ~ 5 GB | ~ 2x |

| besar | 1550 m | N/a | large | ~ 10 GB | 1x |

Model .en hanya untuk bahasa Inggris, dan yang keren adalah Anda dapat menggunakan opsi Translate to English dari model "besar"!

PRS apa pun yang menerjemahkan bahasa menjadi terjemahan. Yl akan sangat dihargai!