다음은 RZV 데이터 엔지니어링 시리즈 교육 과정의 공개 에피소드입니다. 오늘 밤에 켜지는 시리즈를 선택하십시오 - 인생에서 당신을 산만하게 할 시리즈 또는 기술을 배우고 만들 수있는 기회를 줄 수있는 시리즈!

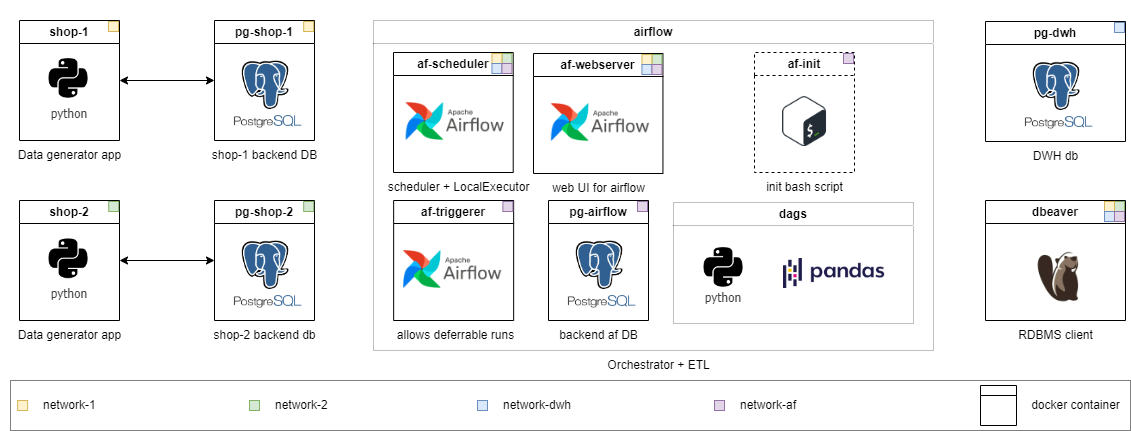

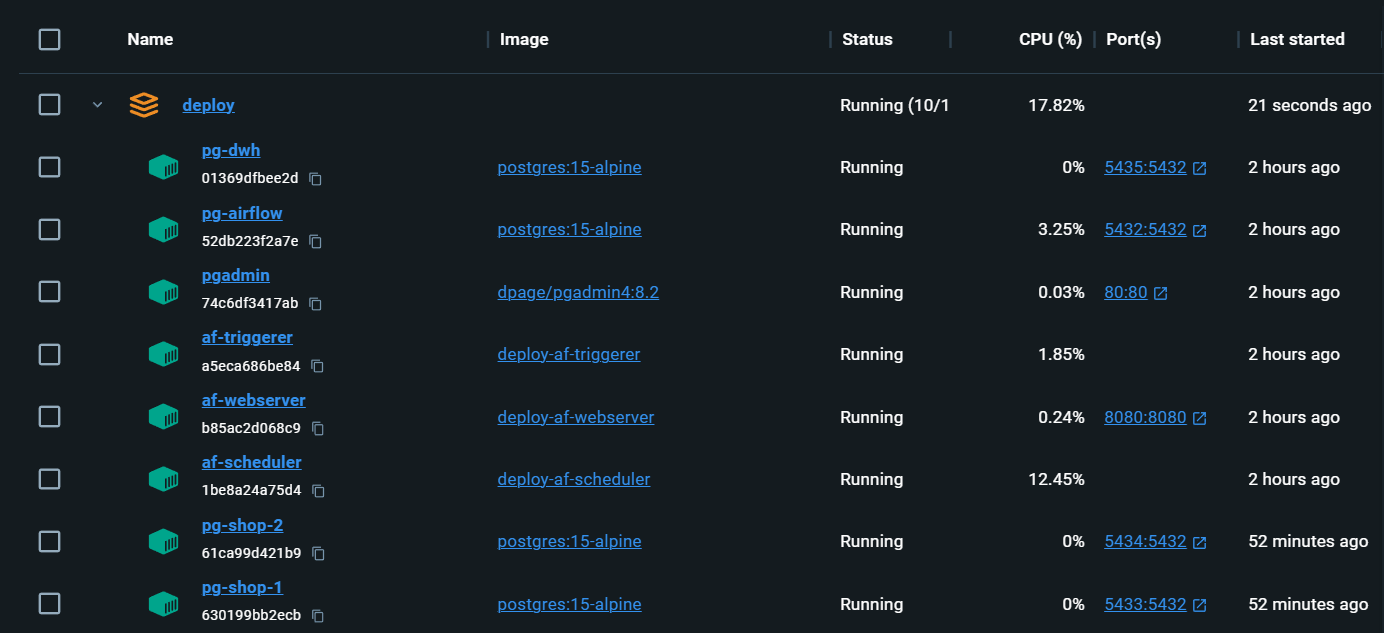

이 과정은 자체적으로 진행되는 형식으로 진행되며 인프라는 Docker 컨테이너에 로컬로 배치됩니다. 나는 당신이 당신의 질문에 스스로 질문에 답할 수있는 자료를 찾아 일반 채팅에서 그것들을 논의 할 것으로 기대합니다. 솔루션은 중간 수준의 작업에 적용됩니다. 작업은 다른 난이도로 나뉩니다. 가장 편안한 느낌을 시작하고 길을 가십시오. 등급이 높을수록 문제 진술이 더 추상적입니다. 인생에서와 같습니다.

코스 중에 습득하는 기술은 거의 쉽게 작업 연습을 위해 전송 될 수 있습니다. 그리고 대부분의 과정과 달리 여기에서는 실시간으로 생성되는 "라이브"데이터로 작업합니다 (단순화 된 방식). 시리즈의 첫 시즌이 끝날 무렵, 데이터 엔지니어링 문제를 실제로 경험하고 솔루션을 직접 쓸 수 있습니다.

코스에 따라 더 많은 모듈이 "비즈니스 개발"에 따라 첨부됩니다.

추신 : 메인 디렉토리의 루트에서 번역 된 readme.md 버전을 확인하십시오 : [RU]를 사용할 수 있습니다.

이것은 Apache Airflow를 통한 증분 로딩 기능을 다루는 첫 번째 에피소드입니다. 중간 및 고위 수준에서 작업을 수행하는 과정에서 실제 작업 실무에 존재하는 많은 어려움을 겪게됩니다. 동시에, 주니어와 인턴 작업조차도 새로운 개념을 소개하고 점차 복잡한 작업을 준비 할 것입니다.

먼저 문제를 직접 해결 한 다음 내 버전을 보도록 권장합니다.

당신은 배울 것입니다 :

각 레벨에는 자체 디렉토리가 있습니다. 각 레벨마다 즉시 실행할 수있는 코드의 양을 줄이고 작업의 복잡성을 높입니다. 디렉토리의 내용은 약간 다르지만 인프라는 어디서나 사용할 수 있습니다. 자세한 작업은 각 학년의 README.md 에 설명되어 있습니다. 당신을 선택하고 필요한 경우 레벨을 자유롭게 낮추십시오.

연수생 : 모든 코드는 이미 중산층 문제에 대해 구현되었습니다. 시작하고 탐색하십시오. 또한이 방법으로 솔루션을 구현 한 이유를 설명하는 메모를 찾을 수 있습니다.

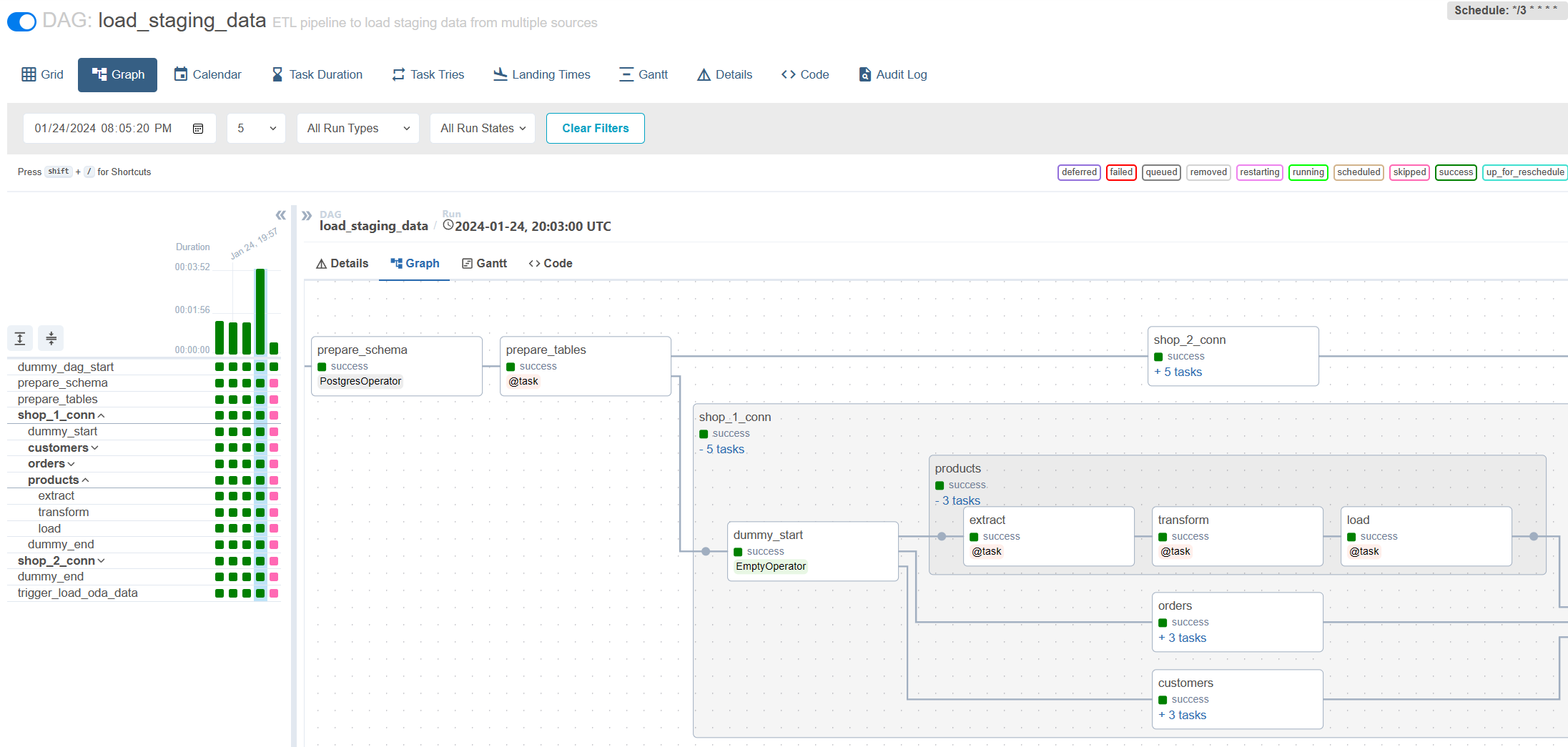

인턴 : 서면 DAG가 새 소스 및 새 테이블에서 데이터를로드하기 시작하도록 기존 구성을 확장하십시오. 파일 시스템으로 작업하기위한 간단한 DAG를 작성하여 Bashoperator를 사용하여 임시 파일을 정리하십시오.

주니어 : 역사적 저장소를 고려하지 않고 증분 로딩을 쓰십시오. 소스의 데이터가 업데이트되지 않습니다.

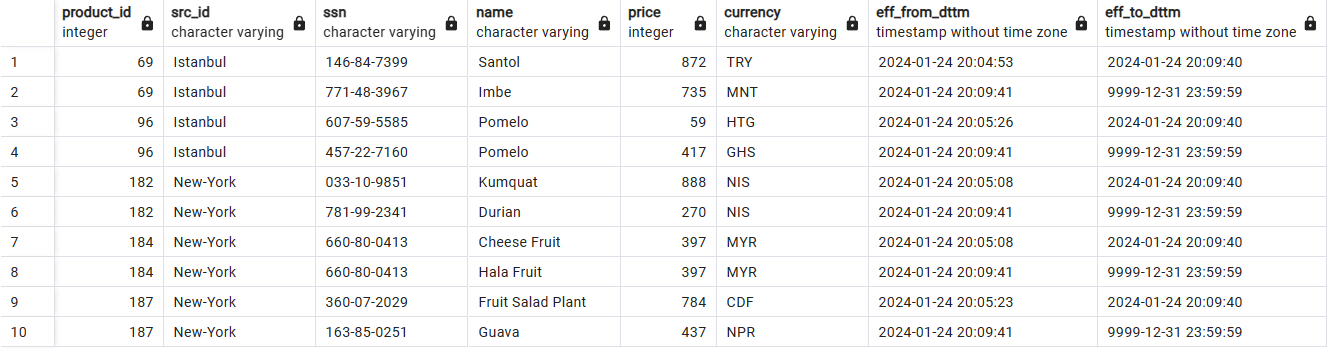

중간 : SCD2 테이블에 증분 하중을 작성하십시오. 데이터가 소스에서 업데이트 될 수 있습니다.

Senior : Middle + Setup Writ

SCD2를 사용한 과거 데이터 저장 :

공기 흐름을 통한 증분 로딩 :

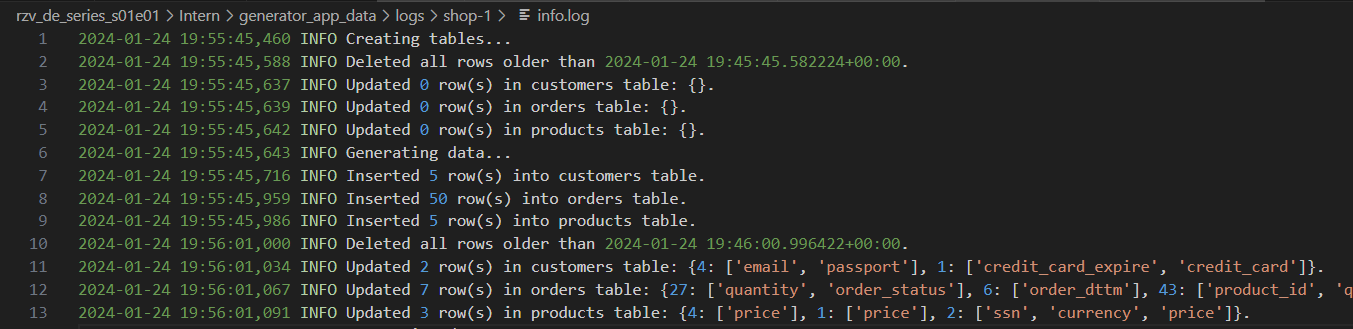

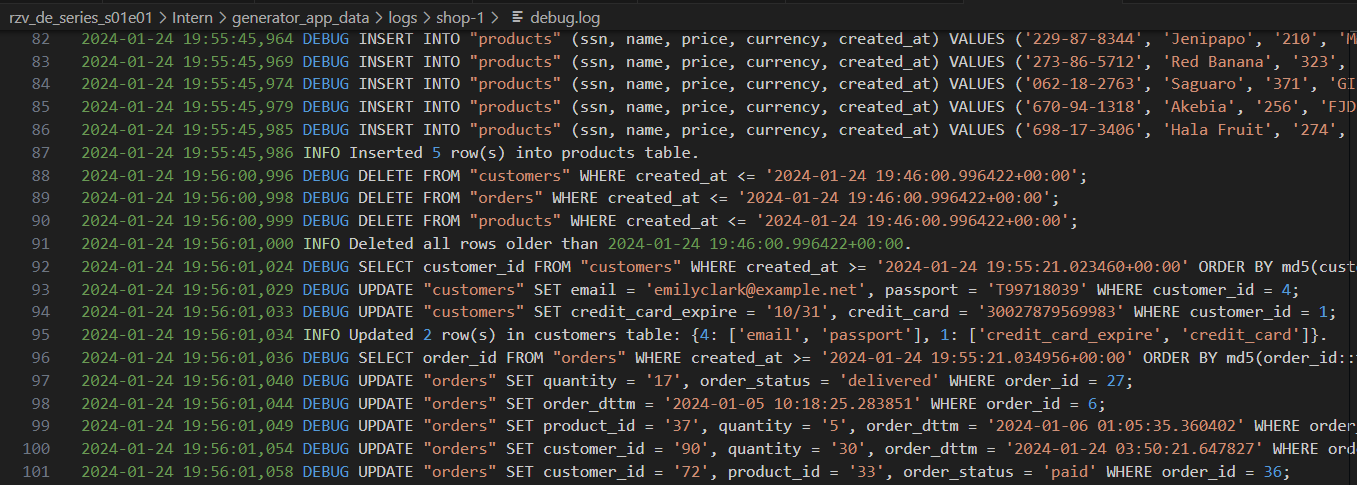

다양한 수준의 세부 사항을 가진 발전기 로그 :

필요한 모든 것을 갖춘 완전히 로컬 인프라 :

localhost:80/#/admin , 로그인 한 다음 메인 페이지 localhost/#/ 로 돌아갑니다. docker compose up Airflow를 재현 한 후마다. DAG는 저장되었지만 Connections 및 Variables 다시 채워야합니다. Aleksei Razvodov, 업계에서 5 년 이상의 경험을 가진 데이터 엔지니어. 나는 데이터 엔지니어의 작업에 대한 이해를 전달 하고이 길을 따라 개발하는 사람들을 돕기 위해 노력합니다.

이 저장소가 당신을 도와 주었고 당신이 그것을 좋아한다면, 그것을주고 소셜 네트워크를 구독하십시오.