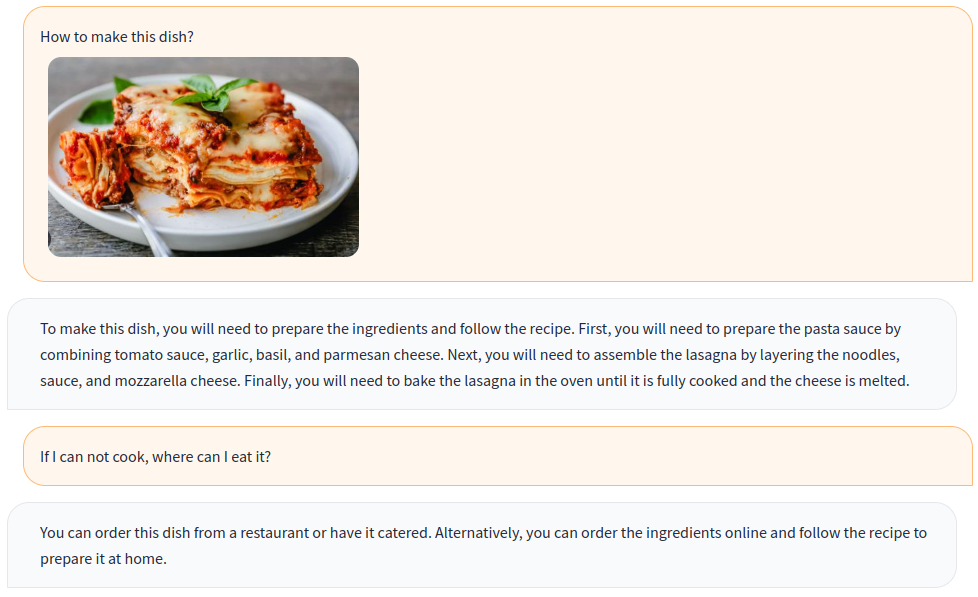

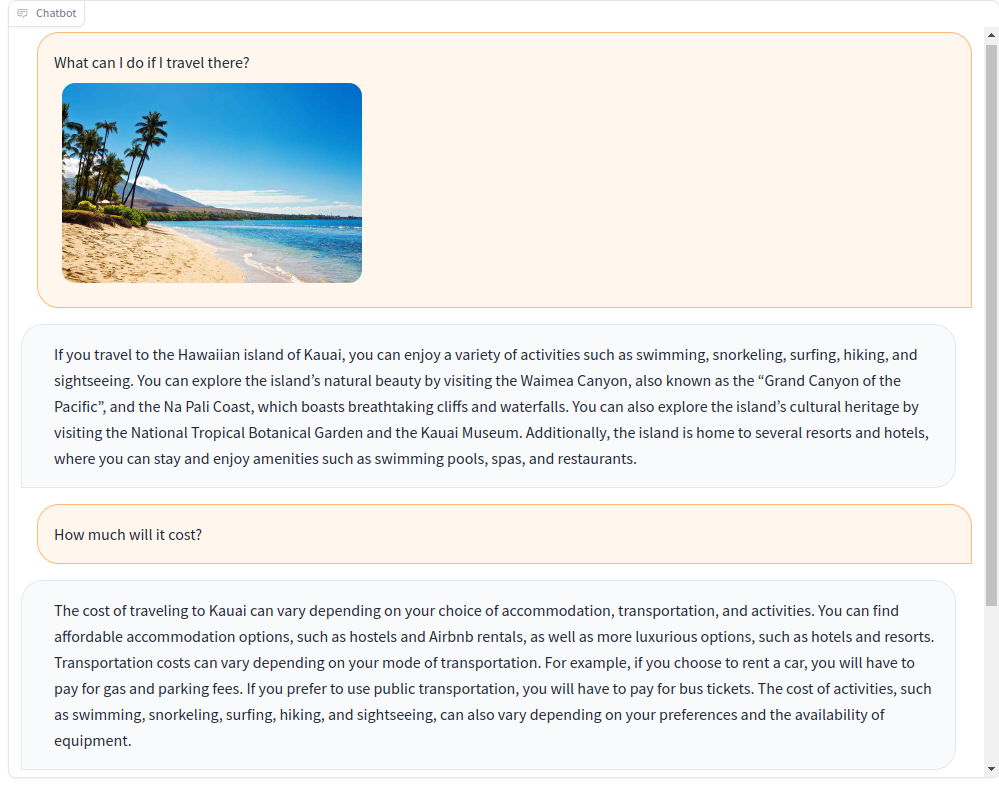

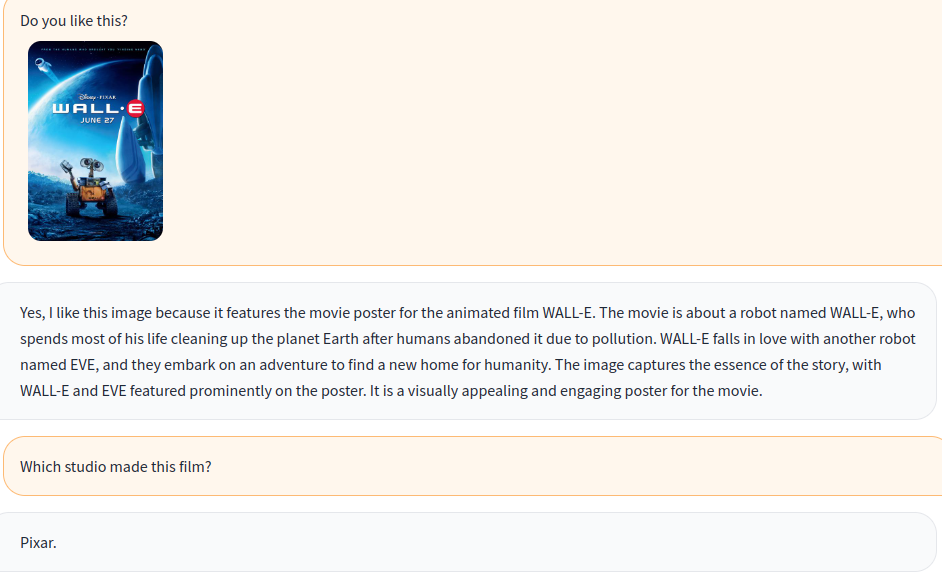

시각 및 언어 지침으로 멀티 모달 챗봇을 훈련하십시오!

오픈 소스 멀티 모달 모델 OpenFlamingo를 기반으로 VQA, 이미지 캡션, 시각적 추론, 텍스트 OCR 및 시각적 대화를 포함한 열린 데이터 세트로 다양한 시각적 명령 데이터를 만듭니다. 또한 언어 전용 명령 데이터 만 사용하여 OpenFlamingo의 언어 모델 구성 요소를 교육합니다.

시각 및 언어 지침의 공동 교육은 모델의 성능을 효과적으로 향상시킵니다! 자세한 내용은 기술 보고서를 참조하십시오.

우리와 함께 오신 것을 환영합니다!

영어 | 简体中文

기존 환경에 패키지를 설치하려면 실행하십시오

git clone https://github.com/open-mmlab/Multimodal-GPT.git

cd Multimodal-GPT

pip install -r requirements.txt

pip install -v -e .또는 새로운 콘다 환경을 만듭니다

conda env create -f environment.yml미리 훈련 된 무게를 다운로드하십시오.

이 스크립트를 사용하여 라마 가중치를 포옹 얼굴 형식으로 변환하십시오.

OpenFlamingo/OpenFlamingo-9B에서 OpenFlamingo 사전 훈련 된 모델을 다운로드하십시오.

여기에서 Lora 무게를 다운로드하십시오.

그런 다음이 모델을 다음과 같은 checkpoints 폴더에 배치하십시오.

checkpoints

├── llama-7b_hf

│ ├── config.json

│ ├── pytorch_model-00001-of-00002.bin

│ ├── ......

│ └── tokenizer.model

├── OpenFlamingo-9B

│ └──checkpoint.pt

├──mmgpt-lora-v0-release.pt

Gradio 데모를 시작하십시오

python app.py

a-kvqa

이 링크에서 주석을 다운로드하고 data/aokvqa/annotations 에 대한 압축을 풀어주십시오.

또한 여기에서 다운로드 할 수있는 Coco Dataset의 이미지가 필요합니다.

코코 캡션

이 링크에서 다운로드하고 data/coco 에 대한 압축을 다운로드하십시오.

또한 여기에서 다운로드 할 수있는 Coco Dataset의 이미지가 필요합니다.

OCR VQA

이 링크에서 다운로드하고 data/OCR_VQA/ 에 배치하십시오.

llava

liuhaotian/llava-instruct-150k에서 다운로드하고 data/llava/ 에 배치하십시오.

또한 여기에서 다운로드 할 수있는 Coco Dataset의 이미지가 필요합니다.

미니 GPT4

Vision-Cair/CC_SBU_ALIGN에서 다운로드하고 data/cc_sbu_align/ 의 위치.

돌리 15K

Databricks/Databricks-Dolly-15K에서 다운로드하여 data/dolly/databricks-dolly-15k.jsonl 에 배치하십시오.

알파카 GPT4

이 링크에서 다운로드하여 data/alpaca_gpt4/alpaca_gpt4_data.json 에 배치하십시오.

configs/dataset_config.py에서 데이터 경로를 사용자 정의 할 수도 있습니다.

Baize

이 링크에서 다운로드하여 data/baize/quora_chat_data.json 에 배치하십시오.

torchrun --nproc_per_node=8 mmgpt/train/instruction_finetune.py

--lm_path checkpoints/llama-7b_hf

--tokenizer_path checkpoints/llama-7b_hf

--pretrained_path checkpoints/OpenFlamingo-9B/checkpoint.pt

--run_name train-my-gpt4

--learning_rate 1e-5

--lr_scheduler cosine

--batch_size 1

--tuning_config configs/lora_config.py

--dataset_config configs/dataset_config.py

--report_to_wandb우리의 프로젝트가 귀하의 연구 및 응용 프로그램에 유용하다고 생각되면이 Bibtex를 사용하여 인용하십시오.

@misc { gong2023multimodalgpt ,

title = { MultiModal-GPT: A Vision and Language Model for Dialogue with Humans } ,

author = { Tao Gong and Chengqi Lyu and Shilong Zhang and Yudong Wang and Miao Zheng and Qian Zhao and Kuikun Liu and Wenwei Zhang and Ping Luo and Kai Chen } ,

year = { 2023 } ,

eprint = { 2305.04790 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}