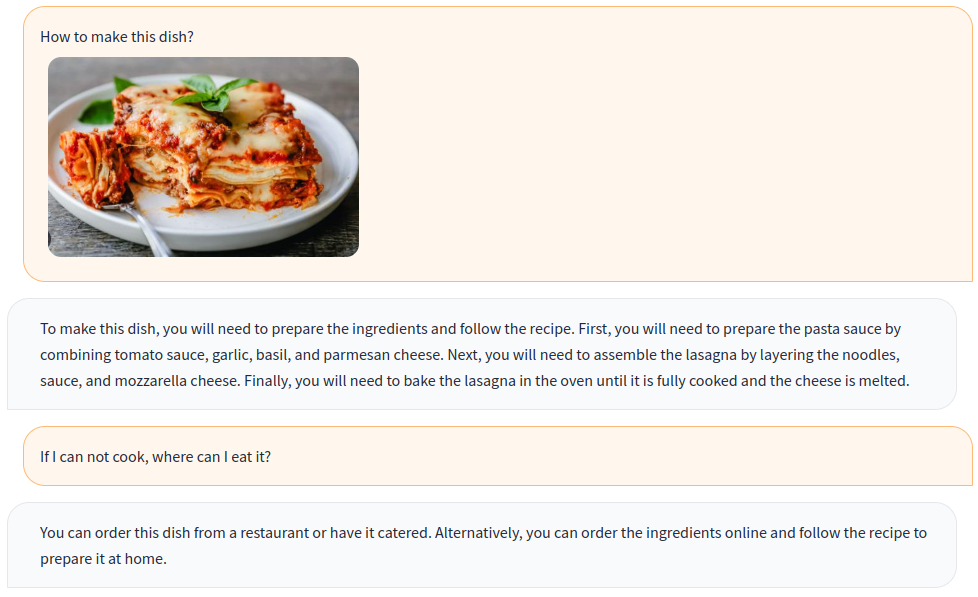

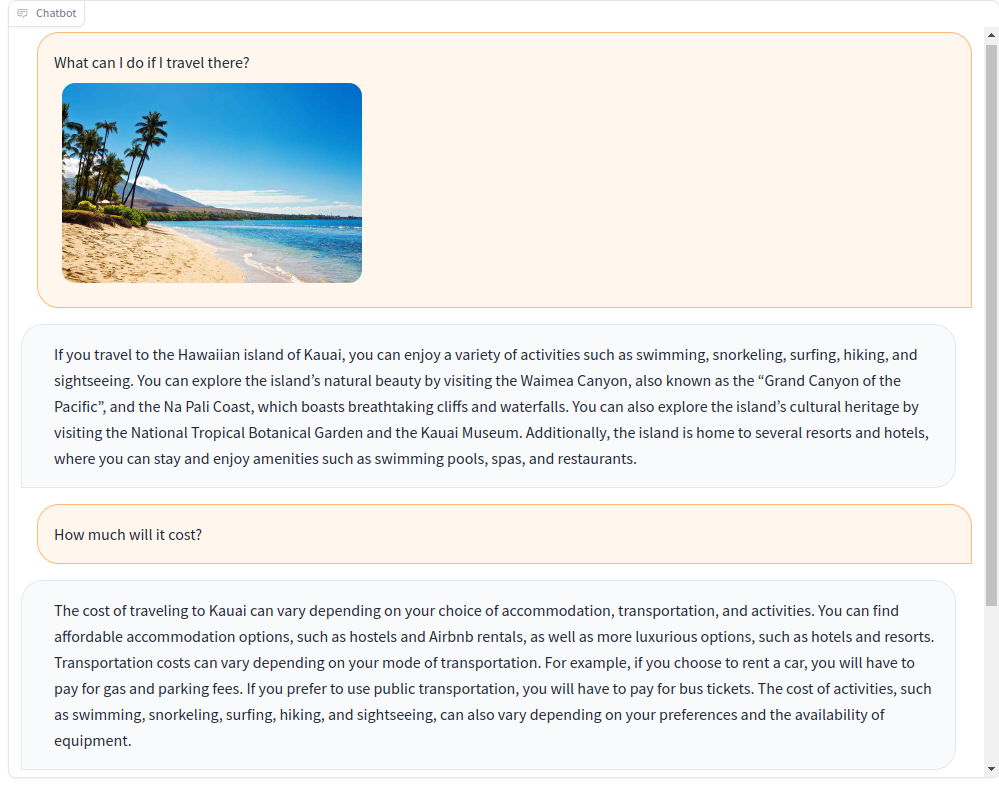

تدريب chatbot متعددة الوسائط مع تعليمات مرئية ولغة!

استنادًا إلى نموذج OpenFlamingo متعدد المصادر مفتوح المصدر ، نقوم بإنشاء بيانات تعليمات مرئية مختلفة مع مجموعات بيانات مفتوحة ، بما في ذلك VQA ، تسميات توضيحية للصور ، التفكير البصري ، النص التعريفي ، والحوار المرئي. بالإضافة إلى ذلك ، نقوم أيضًا بتدريب مكون نموذج اللغة في OpenFlamingo باستخدام بيانات التعليمات اللغوية فقط.

التدريب المشترك للتعليمات المرئية واللغوية يحسن بشكل فعال أداء النموذج! لمزيد من التفاصيل ، يرجى الرجوع إلى تقريرنا الفني.

مرحبًا بك للانضمام إلينا!

الإنجليزية | 简体中文

لتثبيت الحزمة في بيئة موجودة ، قم بتشغيل

git clone https://github.com/open-mmlab/Multimodal-GPT.git

cd Multimodal-GPT

pip install -r requirements.txt

pip install -v -e .أو إنشاء بيئة جديدة

conda env create -f environment.ymlقم بتنزيل الأوزان التي تم تدريبها مسبقًا.

استخدم هذا البرنامج النصي لتحويل أوزان اللاما إلى تعانق تنسيق الوجه.

قم بتنزيل نموذج OpenFlamingo مسبقًا من OpenFlamingo/OpenFlamingo-9b.

قم بتنزيل وزن Lora من هنا.

ثم ضع هذه النماذج في مجلدات checkpoints مثل هذا:

checkpoints

├── llama-7b_hf

│ ├── config.json

│ ├── pytorch_model-00001-of-00002.bin

│ ├── ......

│ └── tokenizer.model

├── OpenFlamingo-9B

│ └──checkpoint.pt

├──mmgpt-lora-v0-release.pt

إطلاق تجريبي Gradio

python app.py

A-OKVQA

قم بتنزيل التعليقات التوضيحية من هذا الرابط وفك الضغط على data/aokvqa/annotations .

كما يتطلب صورًا من مجموعة بيانات Coco التي يمكن تنزيلها من هنا.

تعليق كوكو

قم بتنزيل من هذا الرابط وفك الضغط على data/coco .

كما يتطلب صورًا من مجموعة بيانات Coco التي يمكن تنزيلها من هنا.

OCR VQA

قم بتنزيل من هذا الرابط والمكان في data/OCR_VQA/ .

llava

قم بتنزيل من Liuhaotian/llava-instruct-150k ووضعها في data/llava/ .

كما يتطلب صورًا من مجموعة بيانات Coco التي يمكن تنزيلها من هنا.

Mini-GPT4

قم بتنزيل من Vision-Cair/CC_SBU_ALIGN ووضعها في data/cc_sbu_align/ .

دوللي 15K

قم بتنزيل من Databricks/Databricks-Dolly-15K ووضعه في data/dolly/databricks-dolly-15k.jsonl .

الألبكة GPT4

قم بتنزيله من هذا الرابط ووضعه في data/alpaca_gpt4/alpaca_gpt4_data.json .

يمكنك أيضًا تخصيص مسار البيانات في configs/dataset_config.py.

بايز

قم بتنزيله من هذا الرابط ووضعه في data/baize/quora_chat_data.json .

torchrun --nproc_per_node=8 mmgpt/train/instruction_finetune.py

--lm_path checkpoints/llama-7b_hf

--tokenizer_path checkpoints/llama-7b_hf

--pretrained_path checkpoints/OpenFlamingo-9B/checkpoint.pt

--run_name train-my-gpt4

--learning_rate 1e-5

--lr_scheduler cosine

--batch_size 1

--tuning_config configs/lora_config.py

--dataset_config configs/dataset_config.py

--report_to_wandbإذا وجدت مشروعنا مفيدًا للبحث والتطبيقات ، فيرجى الاستشهاد باستخدام هذا bibtex:

@misc { gong2023multimodalgpt ,

title = { MultiModal-GPT: A Vision and Language Model for Dialogue with Humans } ,

author = { Tao Gong and Chengqi Lyu and Shilong Zhang and Yudong Wang and Miao Zheng and Qian Zhao and Kuikun Liu and Wenwei Zhang and Ping Luo and Kai Chen } ,

year = { 2023 } ,

eprint = { 2305.04790 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}