GTC2025会議で、Nvidiaは次世代の人工知能(AI)チッププラットフォームを正式に発表し、「Vera Rubin」と名付け、有名なアメリカの天文学者Vera Rubinに敬意を表し、Nvidiaの科学者に名前を付けたという伝統を継続しました。シリーズの最初の製品であるVera Rubin NVL144は、2026年後半にリリースされる予定です。

Nvidia CEOのJensen Huangは、Rubinのパフォーマンスが現在のホッパーアーキテクチャの900倍に達すると述べました。それに比べて、最新のブラックウェルアーキテクチャはホッパーで68倍のパフォーマンス改善を達成し、ルービンがコンピューティングパワーに別の大きな飛躍をもたらすことを示しています。

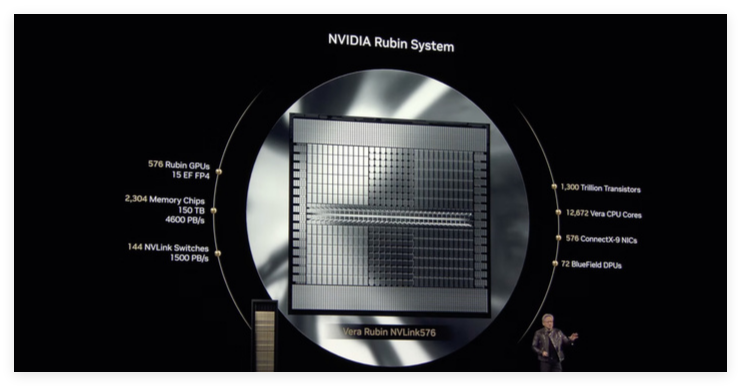

公式情報によると、Vera Rubin NVL144は、FP4精度の下で最大3.6exaFlopsの推論コンピューティングパワーを持ち、FP8精度でのトレーニングパフォーマンスは1.2exaflopsです。 GB300NVL72と比較して、パフォーマンスは3.3倍高くなっています。ルービンには、最新のHBM4ビデオメモリが装備されており、13TB/sと75TBの高速メモリ、前世代の1.6倍の驚くべき帯域幅があります。相互接続に関しては、RubinはNVLink6とCX9をサポートし、帯域幅はそれぞれ260TB/sと28.8TB/sに達し、どちらも前世代の2倍です。

ルービンチップの標準バージョンにはHBM4ビデオメモリが装備されており、その全体的なパフォーマンスは現在のフラッグシップホッパーH100チップをはるかに上回ります。

Rubinプラットフォームは、Grace CPUの後継者としてVeruと呼ばれる新しいCPUも導入することに言及する価値があります。 Veruには88のカスタマイズされたアームコアが含まれており、それぞれが176個のスレッドをサポートし、NVLink-C2Cを介して最大1.8TB/sの高い帯域幅接続を有効にします。 Nvidia氏によると、カスタムVera CPUは昨年、Grace Blackwellチップで使用されているCPUの速度を2倍にすると言います。

Vera CPUで使用すると、推論タスクでのRubinのコンピューティングパワーは、Blackwell20PetaFlopsの2倍以上に達する可能性があります。さらに、Rubinは最大288GBのHBM4メモリをサポートします。これは、大規模なAIモデルを処理する必要がある開発者にとって重要です。

ブラックウェルと同様に、ルービンは実際に2つのGPUで構成されており、高度なパッケージングテクノロジーを通じて1つの全体的な動作に統合されており、全体的なコンピューティング効率とパフォーマンスがさらに向上しています。ルービンのリリースは、間違いなく再びAIチップの分野におけるNvidiaの強力なイノベーション能力と、将来のコンピューティングパワーニーズに関するその深い洞察を示しています。