Auf der GTC2025 -Konferenz kündigte die NVIDIA offiziell die nächste Generation der KI -Plattform für künstliche Intelligenz (KI) an und nannte sie "Vera Rubin", die dem berühmten amerikanischen Astronomen Vera Rubin Tribut zollte und die Tradition von Nvidia nach Wissenschaftlern fortsetzte. Das erste Produkt der Serie, Vera Rubin NVL144, wird in der zweiten Hälfte von 2026 voraussichtlich veröffentlicht.

Jensen Huang, CEO von Nvidia, sagte, dass Rubins Leistung das 900 -fache der aktuellen Hopper -Architektur erreichen wird. Im Vergleich dazu hat die neueste Blackwell-Architektur eine 68-fache Leistungsverbesserung gegenüber Hopper erzielt, was darauf hinweist, dass Rubin einen weiteren großen Sprung in der Rechenleistung bringen wird.

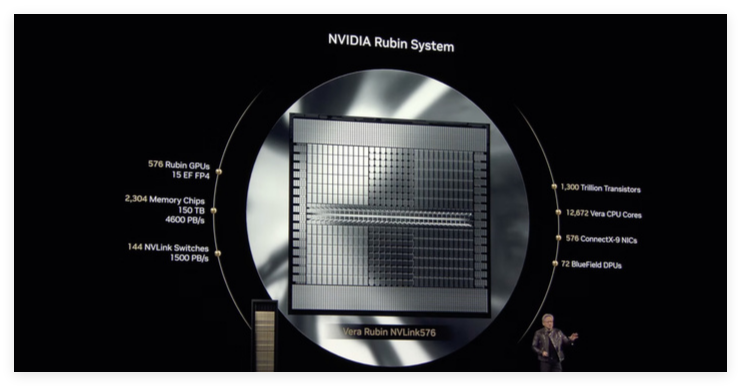

Nach den offiziellen Informationen verfügt der Vera Rubin NVL144 unter FP4 -Genauigkeit über eine Inferenz -Rechenleistung von bis zu 3,6xaflops, und die Schulungsleistung unter FP8 -Genauigkeit beträgt 1,2xaflops. Im Vergleich zum GB300NVL72 ist die Leistung 3,3 -mal höher. Rubin wird mit dem neuesten HBM4 -Video -Speicher mit einer erstaunlichen Bandbreite von 13 TB/s und 75 TB Fast Memory ausgestattet sein, das 1,6 -fache der vorherigen Generation. In Bezug auf die Verbindung unterstützt Rubin NVLink6 und CX9, wobei Bandbreiten 260 TB/S bzw. 28,8 TB/s erreichen, die beide doppelt so hoch sind.

Die Standardversion des Rubin -Chips wird mit dem HBM4 -Videospeicher ausgestattet, und seine Gesamtleistung wird den aktuellen Flaggschiff -Trichter H100 -Chip bei weitem überschreiten.

Es ist erwähnenswert, dass die Rubin -Plattform auch eine brandneue CPU namens Veru als Nachfolger von Grace CPU einführen wird. Veru enthält 88 benutzerdefinierte Armkerne, die jeweils 176 Threads unterstützen und über NVLink-C2C mit hoher Bandbreitenverbindungen bis zu 1,8 TB/s ermöglicht. Laut Nvidia wird die benutzerdefinierte Vera -CPU die Geschwindigkeit der CPU verdoppeln, die im vergangenen Jahr im Grace Blackwell -Chip verwendet wird.

Bei der Verwendung mit Vera CPU können Rubins Rechenleistung in Inferenzaufgaben 50petaflops erreichen, mehr als doppelt so hoch wie die von Blackwell20Petaflops. Darüber hinaus unterstützt Rubin bis zu 288 GB HBM4 -Speicher, was für Entwickler von entscheidender Bedeutung ist, die große KI -Modelle bewältigen müssen.

Ähnlich wie Blackwell besteht Rubin tatsächlich aus zwei GPUs, die durch fortschrittliche Verpackungstechnologie in einen Gesamtbetrieb integriert sind, wodurch die gesamte Recheneffizienz und -leistung weiter verbessert wird. Die Veröffentlichung von Rubin zeigt zweifellos erneut die starken Innovationsfähigkeiten von Nvidia auf dem Gebiet der AI -Chips und seinen tiefgreifenden Einblick in die zukünftigen Rechenleistung.