Switchable Normalization

1.0.0

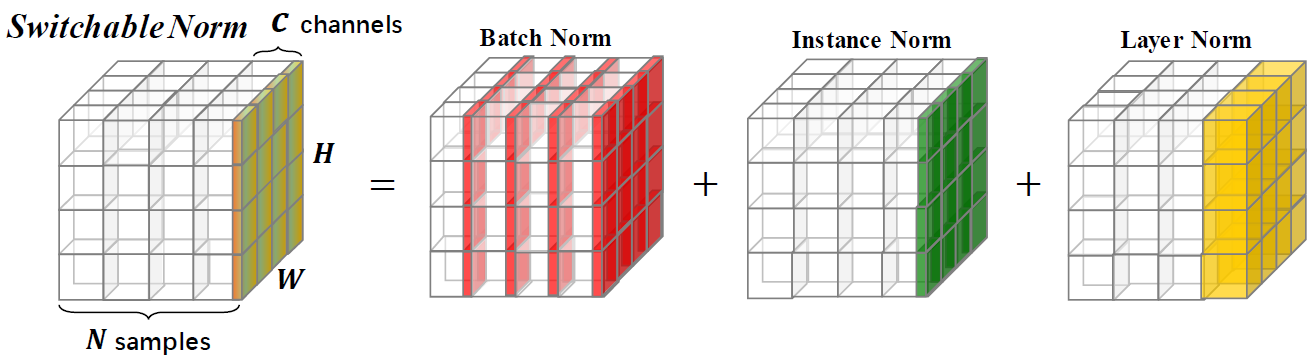

切り替え可能な正規化は、エンドツーエンドの方法で深いニューラルネットワークで異なる正規化レイヤーの異なる正規化操作を学習できる正規化手法です。

このリポジトリは、イメージネット分類の結果と、切り替え可能な正規化でトレーニングされたモデルを提供します。研究でSNを使用する場合は、次の論文を引用することをお勧めします。

@article{SwitchableNorm,

title={Differentiable Learning-to-Normalize via Switchable Normalization},

author={Ping Luo and Jiamin Ren and Zhanglin Peng and Ruimao Zhang and Jingyu Li},

journal={International Conference on Learning Representation (ICLR)},

year={2019}

}

さまざまなバッチサイズ設定でSN、BN、およびGNでトレーニングされたRESNET50を使用して、ImagENETの検証セットでのTOP-1精度の比較。ブラケット(・、・・#gpus、#samples fer gpu)を示します。下部では、「Gn-BN」はGNとBNの精度の違いを示します。 BNの(8、1)の「 - 」は、収束しないことを示しています。

| (8,32) | (8,16) | (8,8) | (8,4) | (8,2) | (1,16) | (1,32) | (8,1) | (1,8) | |

| bn | 76.4 | 76.3 | 75.2 | 72.7 | 65.3 | 76.2 | 76.5 | - | 75.4 |

| Gn | 75.9 | 75.8 | 76.0 | 75.8 | 75.9 | 75.9 | 75.8 | 75.5 | 75.5 |

| sn | 76.9 | 76.7 | 76.7 | 75.9 | 75.6 | 76.3 | 76.6 | 75.0 * | 75.9 |

| gn - bn | -0.5 | -0.5 | 0.8 | 3.1 | 10.6 | -0.3 | -0.7 | - | 0.1 |

| sn - bn | 0.5 | 0.4 | 1.5 | 3.2 | 10.3 | 0.1 | 0.1 | - | 0.5 |

| sn - gn | 1.0 | 0.9 | 0.7 | 0.1 | -0.3 | 0.4 | 0.8 | -0.5 | 0.4 |

Imagenet上のSNで前処理されたモデルを提供し、参照としてBNで前処理されたモデルと比較します。これらのモデルを研究で使用する場合は、SNペーパーを引用してください。 SNの構成は(#GPUS、GPUあたりの#images)として示されます。

| モデル | Top-1 * | トップ5 * | エポック | LRスケジューラ | 重量減衰 | ダウンロード |

|---|---|---|---|---|---|---|

| resnet101v2+sn(8,32) | 78.81% | 94.16% | 120 | ウォームアップ +コサインLR | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet101v1+sn(8,32) | 78.54% | 94.10% | 120 | ウォームアップ +コサインLR | 1E-4 | [Google Drive] [Baidu Pan] |

| Resnet50v2+SN(8,32) | 77.57% | 93.65% | 120 | ウォームアップ +コサインLR | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet50v1+sn(8,32) | 77.49% | 93.32% | 120 | ウォームアップ +コサインLR | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet50v1+sn(8,32) | 76.92% | 93.26% | 100 | 初期LR = 0.1減衰= 0.1ステップ[30,60,90,10] | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet50v1+sn(8,4) | 75.85% | 92.7% | 100 | 初期LR = 0.0125減衰= 0.1ステップ[30,60,90,10] | 1E-4 | [Google Drive] [Baidu Pan] |

| Resnet50v1+SN(8,1) † | 75.94% | 92.7% | 100 | 初期LR = 0.003125減衰= 0.1ステップ[30,60,90,10] | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet50v1+bn | 75.20% | 92.20% | - | 段階的な減衰 | - | [Tensorflowモデル] |

| resnet50v1+bn | 76.00% | 92.98% | - | 段階的な減衰 | - | [Pytorch Vision] |

| resnet50v1+bn | 75.30% | 92.20% | - | 段階的な減衰 | - | [MSRA] |

| resnet50v1+bn | 75.99% | 92.98% | - | 段階的な減衰 | - | [FBトーチ] |

*Imagenetのシングルクロップ検証精度(短いサイドでサイズ変更された画像からの224x224センタークロップ= 256)

†(8,1)の場合、snはBnを含むとlnを含みます。Bnはトレーニング中と同じです。このモデルを使用する場合、YAMLファイルにusing_bn : Falseを追加する必要があります。

このリポジトリのすべての資料は、CC-by-NC 4.0ライセンスの下でリリースされます。