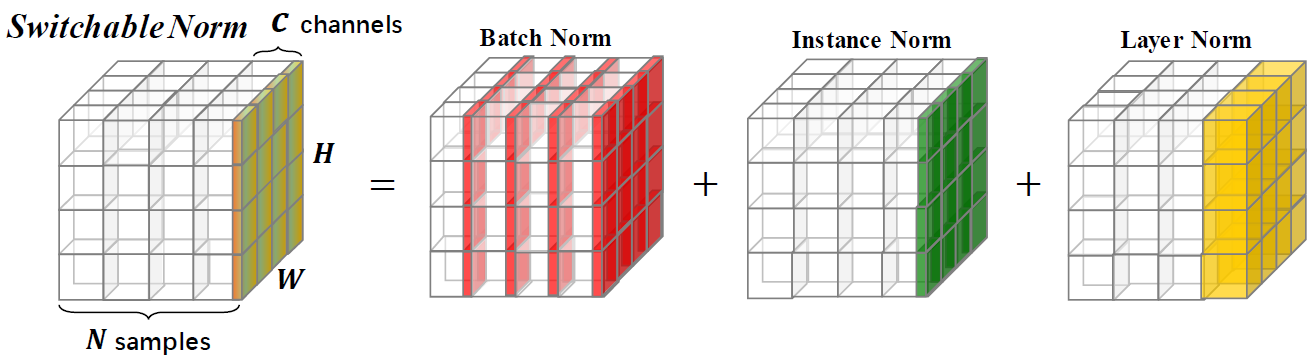

التطبيع القابل للتبديل هو تقنية تطبيع قادرة على تعلم عمليات التطبيع المختلفة لطبقات التطبيع المختلفة في شبكة عصبية عميقة بطريقة شاملة.

يوفر هذا المستودع نتائج تصنيف ImageNet والنماذج المدربة مع تطبيع قابلة للتبديل. نشجعك على الاستشهاد بالورقة التالية إذا كنت تستخدم SN في البحث.

@article{SwitchableNorm,

title={Differentiable Learning-to-Normalize via Switchable Normalization},

author={Ping Luo and Jiamin Ren and Zhanglin Peng and Ruimao Zhang and Jingyu Li},

journal={International Conference on Learning Representation (ICLR)},

year={2019}

}

مقارنات من أعلى الدقة 1 على مجموعة التحقق من الصحة ، باستخدام Resnet50 المدربة مع SN و BN و GN في إعدادات حجم الدُفعة المختلفة. يدل القوس (· ، ·) (#وحدات معالجة الرسومات ،#عينات لكل وحدة معالجة الرسومات). في الجزء السفلي ، يشير "GN-BN" إلى الفرق بين دقة GN و BN. يشير "-" في (8 ، 1) من BN إلى أنه لا يتقارب.

| (8،32) | (8،16) | (8،8) | (8،4) | (8،2) | (1،16) | (1،32) | (8،1) | (1،8) | |

| مليار | 76.4 | 76.3 | 75.2 | 72.7 | 65.3 | 76.2 | 76.5 | - | 75.4 |

| GN | 75.9 | 75.8 | 76.0 | 75.8 | 75.9 | 75.9 | 75.8 | 75.5 | 75.5 |

| Sn | 76.9 | 76.7 | 76.7 | 75.9 | 75.6 | 76.3 | 76.6 | 75.0 * | 75.9 |

| gn - bn | -0.5 | -0.5 | 0.8 | 3.1 | 10.6 | -0.3 | -0.7 | - | 0.1 |

| sn - bn | 0.5 | 0.4 | 1.5 | 3.2 | 10.3 | 0.1 | 0.1 | - | 0.5 |

| sn - gn | 1.0 | 0.9 | 0.7 | 0.1 | -0.3 | 0.4 | 0.8 | -0.5 | 0.4 |

نحن نقدم نماذج مسبقة مع SN على ImageNet ، ومقارنة مع تلك pretried مع BN كمرجع. إذا كنت تستخدم هذه النماذج في البحث ، فيرجى الاستشهاد بالورقة SN. يشار إلى تكوين SN على أنه (#gpus ، #Images لكل وحدة معالجة الرسومات).

| نموذج | أعلى 1 * | أعلى 5 * | الحقبة | جدولة LR | انحلال الوزن | تحميل |

|---|---|---|---|---|---|---|

| resnet101v2+sn (8،32) | 78.81 ٪ | 94.16 ٪ | 120 | الاحماء + جيب التمام LR | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet101v1+sn (8،32) | 78.54 ٪ | 94.10 ٪ | 120 | الاحماء + جيب التمام LR | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet50v2+sn (8،32) | 77.57 ٪ | 93.65 ٪ | 120 | الاحماء + جيب التمام LR | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet50v1+sn (8،32) | 77.49 ٪ | 93.32 ٪ | 120 | الاحماء + جيب التمام LR | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet50v1+sn (8،32) | 76.92 ٪ | 93.26 ٪ | 100 | LR الأولي = 0.1 تحلل = 0.1 خطوات [30،60،90،10] | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet50v1+sn (8،4) | 75.85 ٪ | 92.7 ٪ | 100 | LR الأولي = 0.0125 تحلل = 0.1 خطوات [30،60،90،10] | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet50v1+sn (8،1) † | 75.94 ٪ | 92.7 ٪ | 100 | LR الأولي = 0.003125 تحلل = 0.1 خطوات [30،60،90،10] | 1E-4 | [Google Drive] [Baidu Pan] |

| resnet50v1+bn | 75.20 ٪ | 92.20 ٪ | - | تحلل تدريجي | - | [نماذج TensorFlow] |

| resnet50v1+bn | 76.00 ٪ | 92.98 ٪ | - | تحلل تدريجي | - | [رؤية Pytorch] |

| resnet50v1+bn | 75.30 ٪ | 92.20 ٪ | - | تحلل تدريجي | - | [MSRA] |

| resnet50v1+bn | 75.99 ٪ | 92.98 ٪ | - | تحلل تدريجي | - | [FB Torch] |

*دقة التحقق من الصحة الفردية على ImageNet (محصول مركزي 224 × 224 من الصورة المغيّرة مع جانب أقصر = 256)

† لـ (8،1) ، يحتوي SN على LN دون BN ، كما هو الحال في BN هو نفسه في التدريب. عند استخدام هذا النموذج ، يجب عليك إضافة using_bn : False في ملف yaml.

يتم إصدار جميع المواد في هذا المستودع بموجب ترخيص CC-BY-NC 4.0.