Recherchez Google Dorks comme Chad. Basé sur Ivan-Sincek / Nagooglesearch.

Testé sur Kali Linux V2024.2 (64 bits).

Fait à des fins éducatives. J'espère que cela aidera!

Plans futurs:

linkedin-user . pip3 install --upgrade playwright

playwright install chromiumAssurez-vous chaque fois que vous améliorez votre dépendance du dramaturge pour réinstaller Chromium; Sinon, vous pourriez obtenir une erreur en utilisant le navigateur sans tête dans l'extracteur Chad.

pip3 install --upgrade google-chadgit clone https://github.com/ivan-sincek/chad && cd chad

python3 -m pip install --upgrade build

python3 -m build

python3 -m pip install dist/google_chad-7.0-py3-none-any.whlchad -q ' intitle:"index of /" intext:"parent directory" ' Avez-vous dit Metagoofil ?!

mkdir downloads

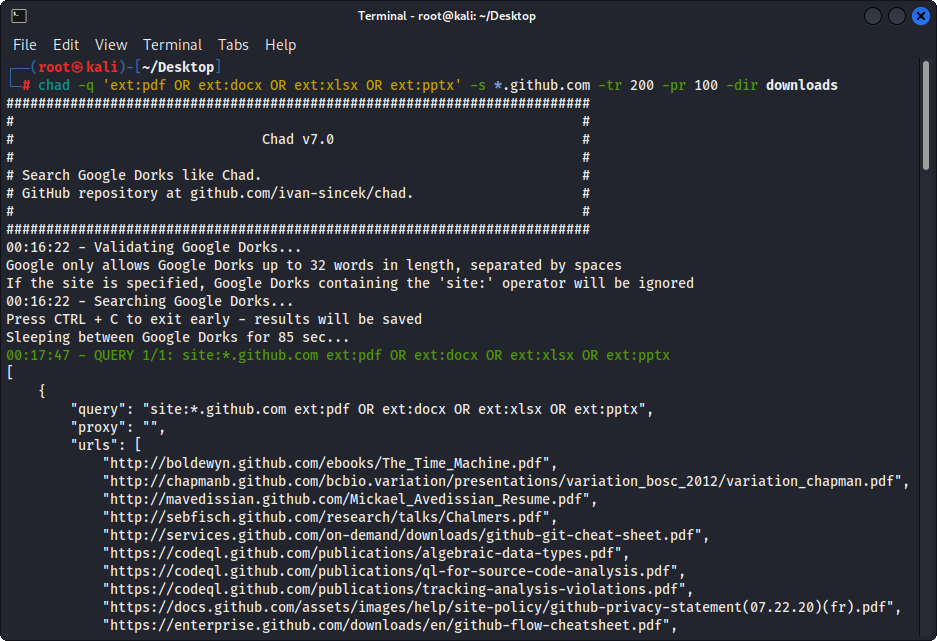

chad -q " ext:pdf OR ext:docx OR ext:xlsx OR ext:pptx " -s * .example.com -tr 200 -dir downloadsLa fonction de téléchargement de fichiers de Chad est basée sur la dépendance des demandes Python.

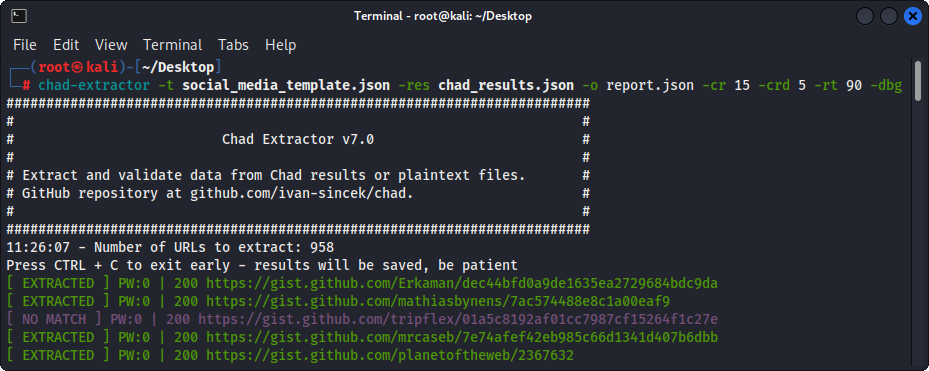

Chad Extracteur est un outil puissant basé sur le robot Web de Scrapy et le navigateur Chromium sans tête de Playwright, conçu pour gratter efficacement le contenu Web; Contrairement à Python demande la dépendance, qui ne peut pas rendre HTML codé en JavaScript JavaScript et est facilement bloqué par des solutions anti-bot.

Principalement, l'extracteur Chad est conçu pour extraire et valider les données des fichiers de résultats Chad. Cependant, il peut également être utilisé pour extraire et valider des données à partir de fichiers en texte clair en utilisant l'option -pt .

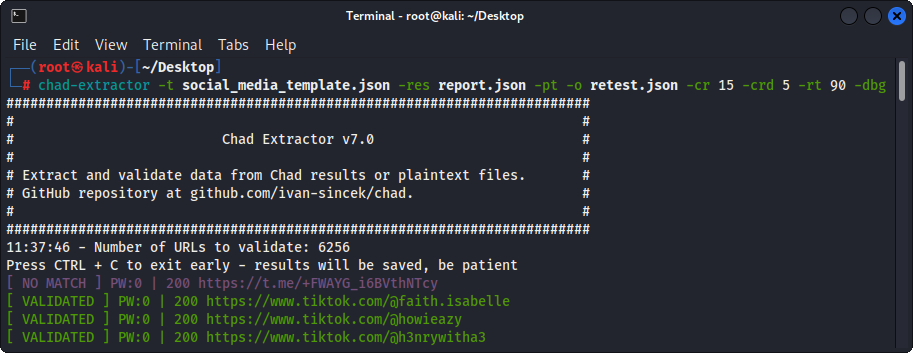

Si l'option -pt est utilisée, les fichiers en texte clair seront traités comme des réponses du serveur et la logique d'extraction sera appliquée, suivie d'une validation. Ceci est également utile si vous souhaitez re-tester les rapports de l'extracteur Chad précédent, par exemple, en utilisant -res report.json -pt -o retest.json .

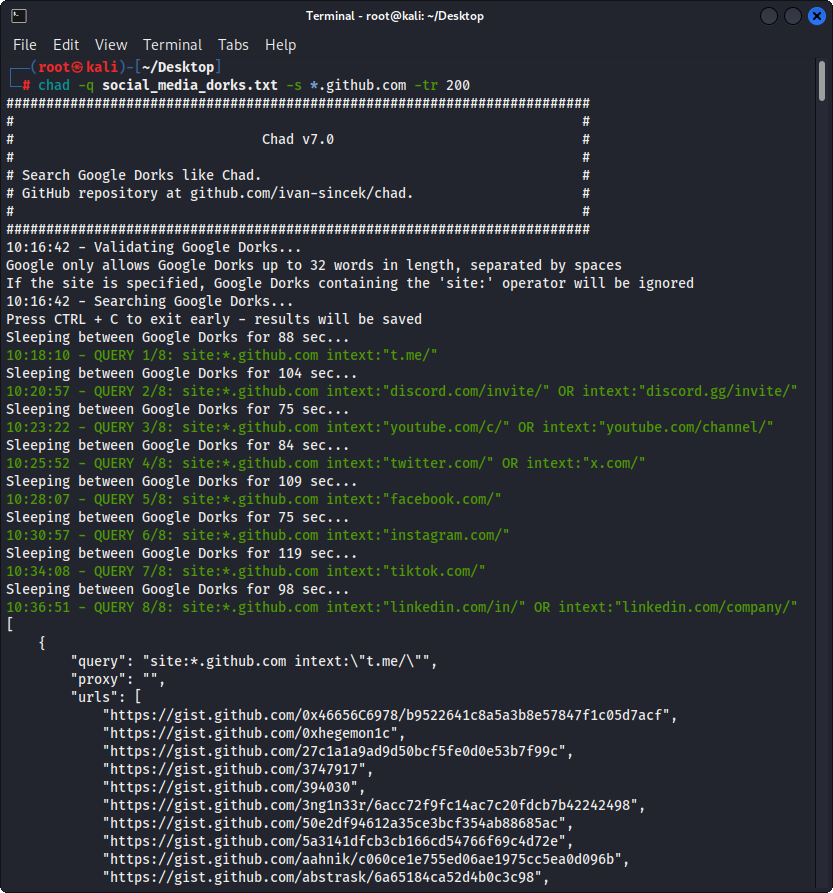

Préparez le fichier Google Dorks en tant que Social_Media_Dorks.txt:

intext:"t.me/"

intext:"discord.com/invite/" OR intext:"discord.gg/invite/"

intext:"youtube.com/c/" OR intext:"youtube.com/channel/"

intext:"twitter.com/" OR intext:"x.com/"

intext:"facebook.com/"

intext:"instagram.com/"

intext:"tiktok.com/"

intext:"linkedin.com/in/" OR intext:"linkedin.com/company/"

Préparez le modèle en tant que fichier social_media_template.json:

{

"telegram" :{

"extract" : " t \ .me \ /(?:(?!(?:share)(?:(?: \ /| \ ?| \\ | " | \ <)*$|(?: \ /| \ ?| \\ | \" | \ <)[ \ s \ S]))[ \ w \ d \ . \ _ \ - \ + \ @]+)(?<! \ .) " ,

"extract_prepend" : " https:// " ,

"validate" : " <meta property= " og:title " content= " Telegram: Contact .+? " > "

},

"discord" :{

"extract" : " discord \ .(?:com|gg) \ /invite \ /[ \ w \ d \ . \ _ \ - \ + \ @]+(?<! \ .) " ,

"extract_prepend" : " https:// " ,

"validate" : " Invite Invalid " ,

"validate_browser" : true ,

"validate_browser_wait" : 6

},

"youtube" :{

"extract" : " youtube \ .com \ /(?:c|channel) \ /[ \ w \ d \ . \ _ \ - \ + \ @]+(?<! \ .) " ,

"extract_prepend" : " https://www. " ,

"validate" : " <iframe.+?src= "\ /error \ ?src=404.+? " > " ,

"validate_cookies" :{

"SOCS" : " CAESEwgDEgk2OTk3ODk2MzcaAmVuIAEaBgiAn5S6Bg "

}

},

"twitter" :{

"extract" : " (?<=(?<!pic \ .)twitter|(?<!pic \ .)x) \ .com \ /(?:(?!(?:[ \ w]{2} \ /)*(?:explore|hashtag|home|i|intent|library|media|personalization|privacy|search|share|tos|widgets \ .js)(?:(?: \ /| \ ?| \\ | " | \ <)*$|(?: \ /| \ ?| \\ | \" | \ <)[ \ s \ S]))[ \ w \ d \ . \ _ \ - \ + \ @]+)(?<! \ .) " ,

"extract_prepend" : " https://x " ,

"validate" : " This account doesn.?t exist " ,

"validate_browser" : true ,

"validate_cookies" :{

"night_mode" : " 2 "

}

},

"facebook" :{

"extract" : " facebook \ .com \ /(?:(?!(?:about|dialog|gaming|groups|public|sharer|share \ .php|terms \ .php)(?:(?: \ /| \ ?| \\ | " | \ <)*$|(?: \ /| \ ?| \\ | \" | \ <)[ \ s \ S]))[ \ w \ d \ . \ _ \ - \ + \ @]+)(?<! \ .) " ,

"extract_prepend" : " https://www. " ,

"validate" : " This (?:content|page) isn't available " ,

"validate_browser" : true

},

"instagram" :{

"extract" : " instagram \ .com \ /(?:(?!(?:about|accounts|ar|explore|p)(?:(?: \ /| \ ?| \\ | " | \ <)*$|(?: \ /| \ ?| \\ | \" | \ <)[ \ s \ S]))[ \ w \ d \ . \ _ \ - \ + \ @]+)(?<! \ .) " ,

"extract_prepend" : " https://www. " ,

"extract_append" : " / " ,

"validate" : " Sorry, this page isn't available \ . " ,

"validate_browser" : true

},

"tiktok" :{

"extract" : " (?<!vt \ .)tiktok \ .com \ / \ @[ \ w \ d \ . \ _ \ - \ + \ @]+(?<! \ .) " ,

"extract_prepend" : " https://www. " ,

"validate" : " Couldn't find this account "

},

"linkedin-company" :{

"extract" : " linkedin \ .com \ /company \ /[ \ w \ d \ . \ _ \ - \ + \ @ \ &]+(?<! \ .) " ,

"extract_prepend" : " https://www. " ,

"validate" : " Page not found " ,

"validate_cookies" :{

"bcookie" : " v=2 " ,

"lang" : " v=2&lang=en-us "

}

},

"linkedin-user" :{

"extract" : " linkedin \ .com \ /in \ /[ \ w \ d \ . \ _ \ - \ + \ @ \ &]+(?<! \ .) " ,

"extract_prepend" : " https://www. " ,

"validate" : " An exact match for .+ could not be found \ . "

}

} Assurez-vous que vos expressions régulières ne renvoient qu'un seul groupe de capture, par exemple, [1, 2, 3, 4] ; et non un touple, par exemple, [(1, 2), (3, 4)] .

Assurez-vous d'échapper correctement aux symboles spécifiques de l'expression régulière dans votre fichier de modèle, par exemple, assurez-vous d'échapper au point . comme \. et Slash / As \/ , etc.

Toutes les recherches d'expression régulières sont insensibles à la cas.

Le contenu Web obtenu à partir des URL dans les fichiers de résultats Chad sera égalé à toutes les expressions régulières (définies par les attributs extract ) dans le fichier de modèle pour trouver autant de données pertinentes que possible.

Pour extraire les données sans validation, omettez simplement les attributs validate du fichier de modèle si nécessaire.

| Portée | Nom | Taper | Requis | Description |

|---|---|---|---|---|

| extraction | extrait | Str | Oui | Requête d'expression régulière. |

| extraction | extrait_prepennd | Str | Non | String pour appliquer à toutes les données extraites. |

| extraction | Extract_append | Str | Non | Chaîne à ajouter pour extraire les données. |

| validation | valider | Str | Non | Requête d'expression régulière. |

| validation | valider_browser | bool | Non | Que ce soit pour utiliser le navigateur sans tête ou non. |

| validation | valider_browser_wait | flotter | Non | Attendez le temps en quelques secondes avant de récupérer le contenu de la page du navigateur sans tête. |

| validation | valider_headers | dict [str, str] | Non | En-têtes de demande HTTP au format de valeur clé. L'en-tête Cookie est ignoré. |

| validation | valider_cookies | dict [str, str] | Non | HTTP demande des cookies au format de valeur clé. |

Tableau 1 - Attributs du modèle

chad -q social_media_dorks.txt -s * .example.com -tr 200 -pr 100 -o results.json

chad-extractor -t social_media_template.json -res results.json -o report.json Préparez les domaines / sous-domaines en tant que fichier sites.txt , de la même manière que vous les utiliseriez avec le site: Option dans Google:

*.example.com

*.example.com -www

Courir:

mkdir chad_results

IFS= $' n ' ; count=0 ; for site in $( cat sites.txt ) ; do count= $(( count + 1 )) ; echo " # ${count} | ${site} " ; chad -q social_media_dorks.txt -s " ${site} " -tr 200 -pr 100 -o " chad_results/results_ ${count} .json " ; done

chad-extractor -t social_media_template.json -res chad_results -o report.json -v Vérifiez manuellement si les URL des médias sociaux brisées dans results[summary][validated] sont vulnérables à la prise de contrôle:

{

"started_at" : " 2023-12-23 03:30:10 " ,

"ended_at" : " 2023-12-23 04:20:00 " ,

"summary" :{

"validated" :[

" https://t.me/does_not_exist " // might be vulnerable to takeover

],

"extracted" :[

" https://discord.com/invite/exists " ,

" https://t.me/does_not_exist " ,

" https://t.me/exists "

]

},

"failed" :{

"validation" :[],

"extraction" :[]

},

"full" :[

{

"url" : " https://example.com/about " ,

"results" :{

"telegram" :[

" https://t.me/does_not_exist " ,

" https://t.me/exists "

],

"discord" :[

" https://discord.com/invite/exists "

]

}

}

]

}La période de refroidissement de Google peut aller de quelques heures à une journée entière.

Pour éviter de frapper les limites de taux de Google avec le Tchad, augmentez le sommeil minimum et maximum entre les requêtes et / ou les pages de Google; ou utilisez des proxys gratuits ou payés. Cependant, les procurations libres sont souvent bloquées et instables.

Pour télécharger une liste de procurations gratuites, exécutez:

curl -s ' https://proxylist.geonode.com/api/proxy-list?limit=50&page=1&sort_by=lastChecked&sort_type=desc ' -H ' Referer: https://proxylist.geonode.com/ ' | jq -r ' .data[] | "(.protocols[])://(.ip):(.port)" ' > proxies.txtSi vous utilisez des proxys, vous voudrez peut-être augmenter le délai d'expiration de la demande, car les réponses auront besoin de plus de temps pour arriver.

De plus, pour éviter d'atteindre des limites de taux sur des plates-formes comme Instagram tout en utilisant l'extracteur Chad, envisagez de réduire le nombre de demandes simultanées par domaine et d'augmenter les temps de sommeil et d'attente.

Chad v7.0 ( github.com/ivan-sincek/chad )

Usage: chad -q queries [-s site ] [-x proxies ] [-o out ]

Example: chad -q queries.txt [-s *.example.com] [-x proxies.txt] [-o results.json]

DESCRIPTION

Search Google Dorks like Chad

QUERIES

File containing Google Dorks or a single query to use

-q, --queries = queries.txt | intext:password | "ext:tar OR ext:zip" | etc.

SITE

Domain[s] to search

-s, --site = example.com | sub.example.com | *.example.com | "*.example.com -www" | etc.

TIME

Get results not older than the specified time in months

-t, --time = 6 | 12 | 24 | etc.

TOTAL RESULTS

Total number of unique results

Default: 100

-tr, --total-results = 200 | etc.

PAGE RESULTS

Number of results per page - capped at 100 by Google

Default: randint(70, 100)

-pr, --page-results = 50 | etc.

MINIMUM QUERIES

Minimum sleep time in seconds between Google queries

Default: 75

-min-q, --minimum-queries = 120 | etc.

MAXIMUM QUERIES

Maximum sleep time between Google queries

Default: minimum + 50

-max-q, --maximum-queries = 180 | etc.

MINIMUM PAGES

Minimum sleep time between Google pages

Default: 15

-min-p, --minimum-pages = 30 | etc.

MAXIMUM PAGES

Maximum sleep time between Google pages

Default: minimum + 10

-max-p, --maximum-pages = 60 | etc.

USER AGENTS

User agents to use

Default: random-all

-a, --user-agents = user_agents.txt | random(-all) | curl/3.30.1 | etc.

PROXIES

File containing web proxies or a single web proxy to use

-x, --proxies = proxies.txt | http://127.0.0.1:8080 | etc.

DIRECTORY

Downloads directory

All downloaded files will be saved in this directory

-dir, --directory = downloads | etc.

THREADS

Number of files to download in parallel

Default: 5

-th, --threads = 20 | etc.

OUT

Output file

-o, --out = results.json | etc.

NO SLEEP ON START

Disable the safety feature to prevent triggering rate limits by accident

-nsos, --no-sleep-on-start

DEBUG

Enable debug output

-dbg, --debug

Chad Extractor v7.0 ( github.com/ivan-sincek/chad )

Usage: chad-extractor -t template -res results -o out [-s sleep] [-rs random-sleep]

Example: chad-extractor -t template.json -res chad_results -o report.json [-s 1.5 ] [-rs ]

DESCRIPTION

Extract and validate data from Chad results or plaintext files

TEMPLATE

File containing extraction and validation details

-t, --template = template.json | etc.

RESULTS

Directory containing Chad results or plaintext files, or a single file

If a directory is specified, files ending with '.report.json' will be ignored

-res, --results = chad_results | results.json | urls.txt | etc.

PLAINTEXT

Treat all the results as plaintext files / server responses

-pt, --plaintext

EXCLUDES

File containing regular expressions or a single regular expression to exclude content from the page

Applies only for extraction

-e, --excludes = regexes.txt | "<div id="seo">.+?</div>" | etc.

PLAYWRIGHT

Use Playwright's headless browser

Applies only for extraction

-p, --playwright

PLAYWRIGHT WAIT

Wait time in seconds before fetching the page content

Applies only for extraction

-pw, --playwright-wait = 0.5 | 2 | 4 | etc.

CONCURRENT REQUESTS

Number of concurrent requests

Default: 15

-cr, --concurrent-requests = 30 | 45 | etc.

CONCURRENT REQUESTS PER DOMAIN

Number of concurrent requests per domain

Default: 5

-crd, --concurrent-requests-domain = 10 | 15 | etc.

SLEEP

Sleep time in seconds between two consecutive requests to the same domain

-s, --sleep = 1.5 | 3 | etc.

RANDOM SLEEP

Randomize the sleep time between requests to vary between '0.5 * sleep' and '1.5 * sleep'

-rs, --random-sleep

AUTO THROTTLE

Auto throttle concurrent requests based on the load and latency

Sleep time is still respected

-at, --auto-throttle = 0.5 | 10 | 15 | 45 | etc.

RETRIES

Number of retries per URL

Default: 2

-r, --retries = 0 | 4 | etc.

REQUEST TIMEOUT

Request timeout in seconds

Default: 60

-rt, --request-timeout = 30 | 90 | etc.

USER AGENTS

User agents to use

Default: random-all

-a, --user-agents = user_agents.txt | random(-all) | curl/3.30.1 | etc.

PROXY

Web proxy to use

-x, --proxy = http://127.0.0.1:8080 | etc.

OUT

Output file

-o, --out = report.json | etc.

VERBOSE

Create additional supporting output files that end with '.report.json'

-v, --verbose

DEBUG

Enable debug output

-dbg, --debug

Figure 1 - (THAD) Téléchargement de fichiers - Single Google Dork

Figure 2 - (Chad) Broken Link Rijacking - plusieurs google dorks

Figure 3 - Extraction (extracteur Chad)

Figure 4 - Validation (extracteur Chad)