Awesome Efficient LLM

1.0.0

Una lista curada para modelos de idiomas grandes eficientes

Si desea incluir su documento o debe actualizar cualquier detalle, como información de conferencia o URL de código, no dude en enviar una solicitud de extracción. Puede generar el formato de Markdown requerido para cada documento completando la información en generate_item.py y ejecutar python generate_item.py . Apreciamos calurosamente sus contribuciones a esta lista. Alternativamente, puede enviarme un correo electrónico con los enlaces a su papel y código, y agregaría su documento a la lista lo antes posible.

Para cada tema, hemos seleccionado una lista de documentos recomendados que han obtenido muchas estrellas o citas de GitHub.

| Título y autores | Introducción | Campo de golf |

|---|---|---|

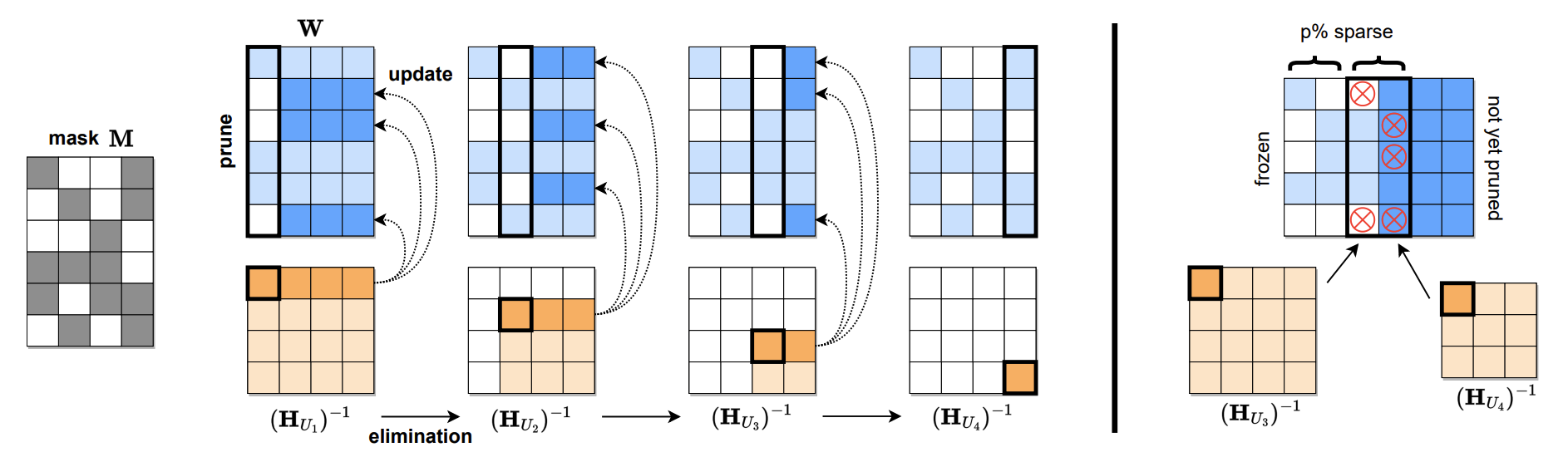

SPARSEGPT: los modelos de lenguaje masivo se pueden podar con precisión en un solo disparo Elias Frantar, Dan Alistarh |  | Papel github |

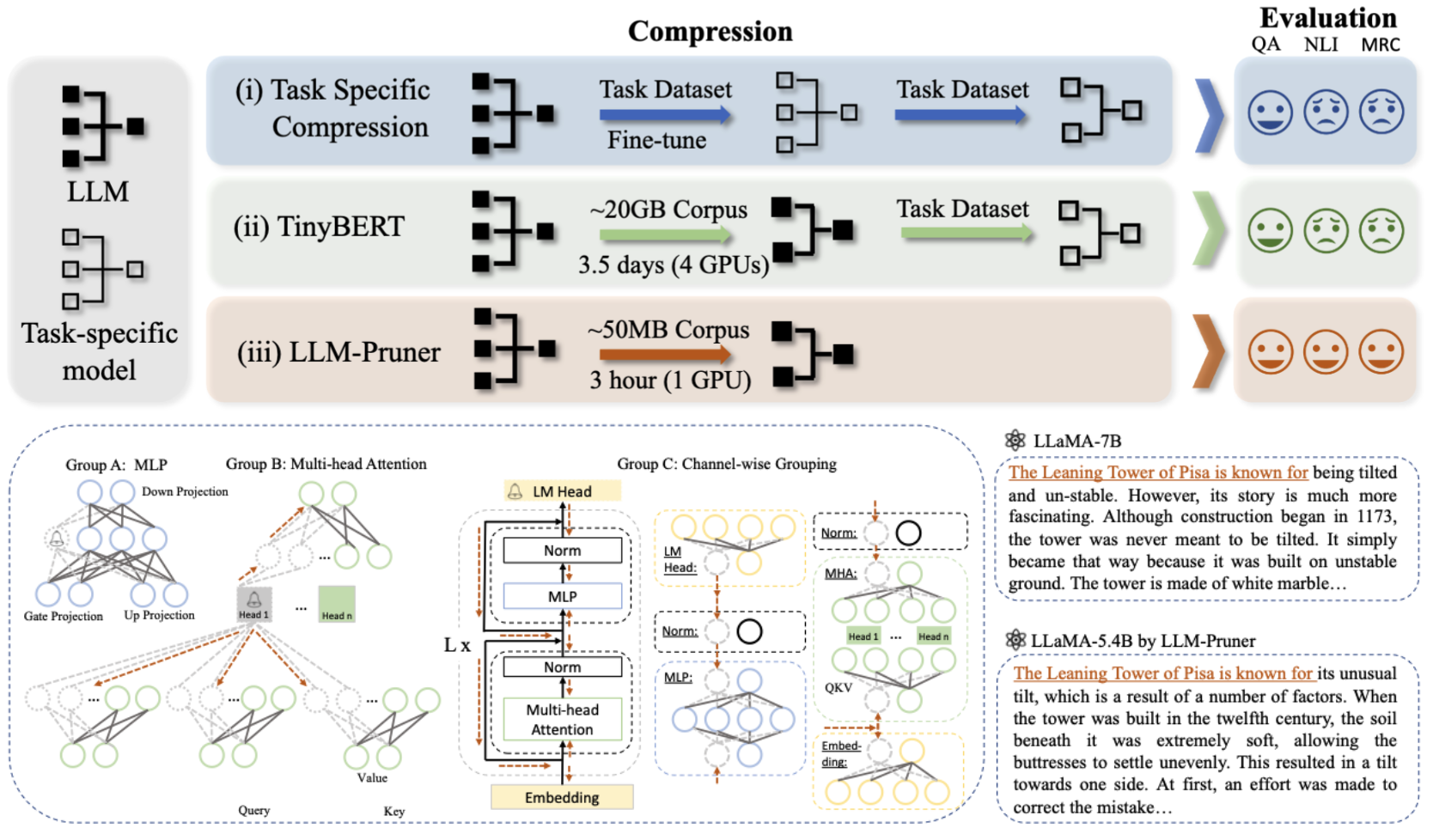

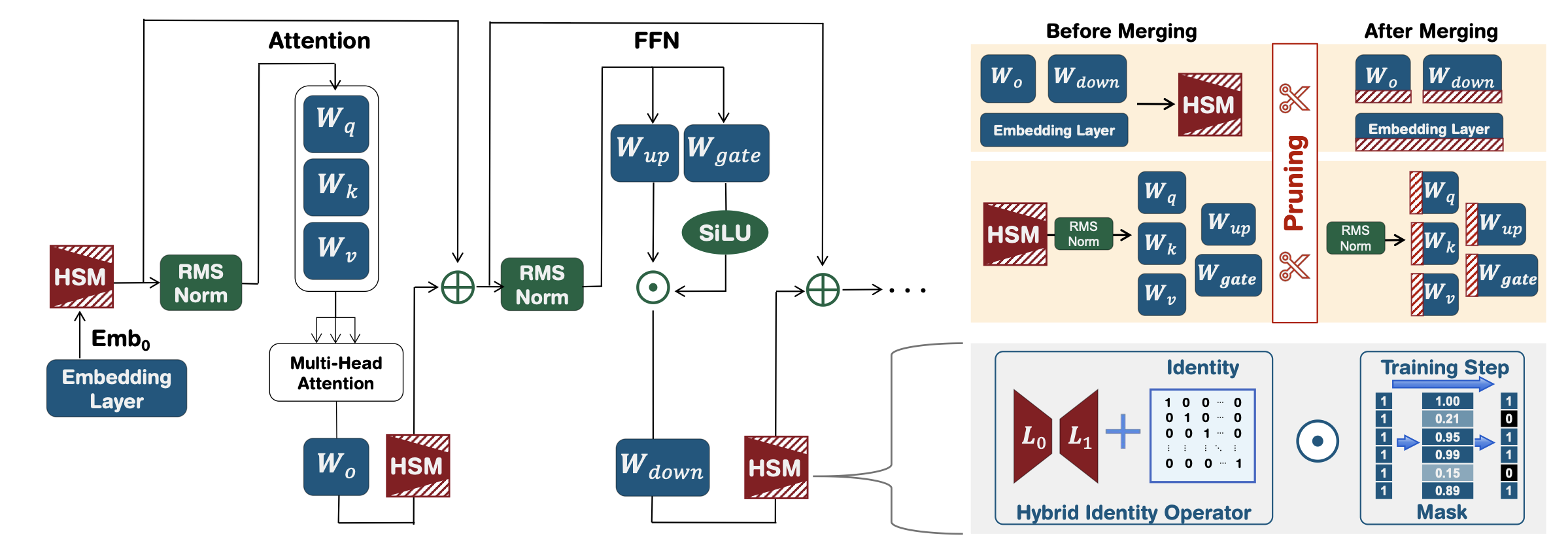

LLM-PRIMER: Sobre la poda estructural de modelos de idiomas grandes Xinyin MA, Gongfan Fang, Xinchao Wang |  | Papel github |

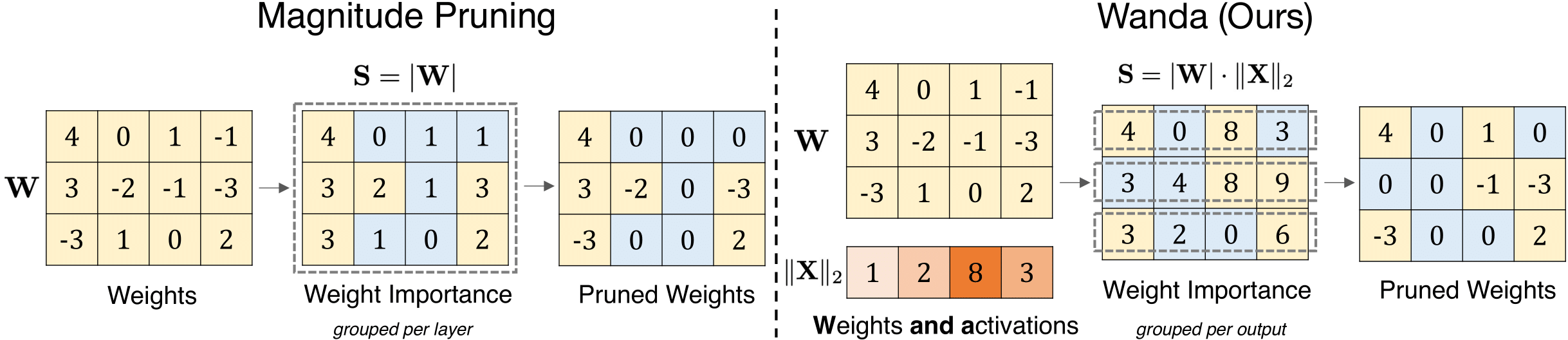

Un enfoque de poda simple y efectivo para modelos de idiomas grandes Mingjie Sun, Zhuang Liu, Anna Bair, J. Zico Kolter |  | Github Papel |

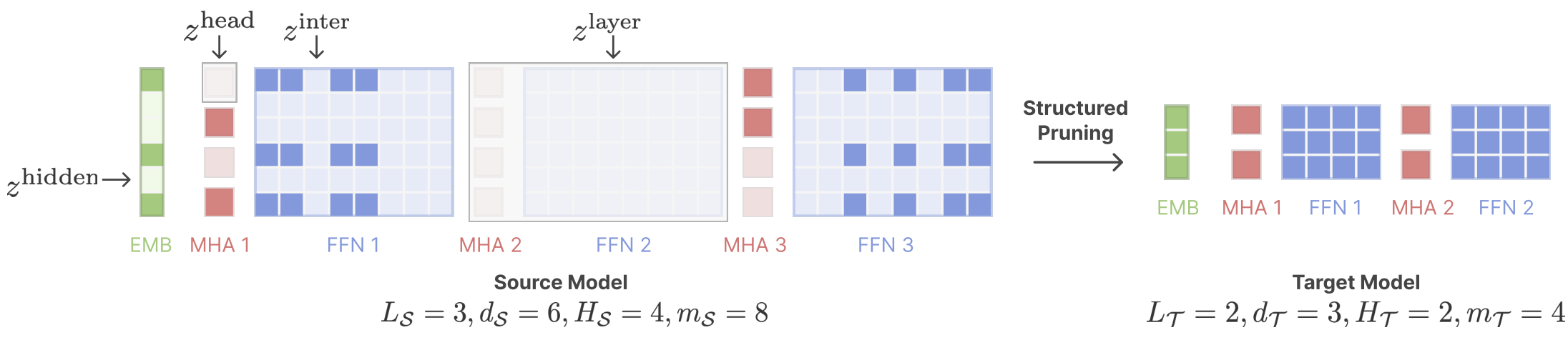

LLAMA CELED: el modelo de lenguaje de aceleración previa al entrenamiento a través de la poda estructurada Mengzhou Xia, Tianyu Gao, Zhiyuan Zeng, Danqi Chen |  | Github Papel |

| Inferencia de LLM eficiente utilizando la poda de entrada dinámica y el enmascaramiento de caché consciente Marco Federici, Davide Belli, Mart Van Baalen, Amir Jalalirad, Andrii Skliar, Bence Major, Markus Nagel, Paul Whatmough | Papel | |

| Rompecabezas: NAS basado en la destilación para LLMS optimizados por inferencia Akhiad Bercovich, Tomer Ronen, Talor Abramovich, Nir Ailon, Nave Assaf, Mohammad Dabbah et al. | Papel | |

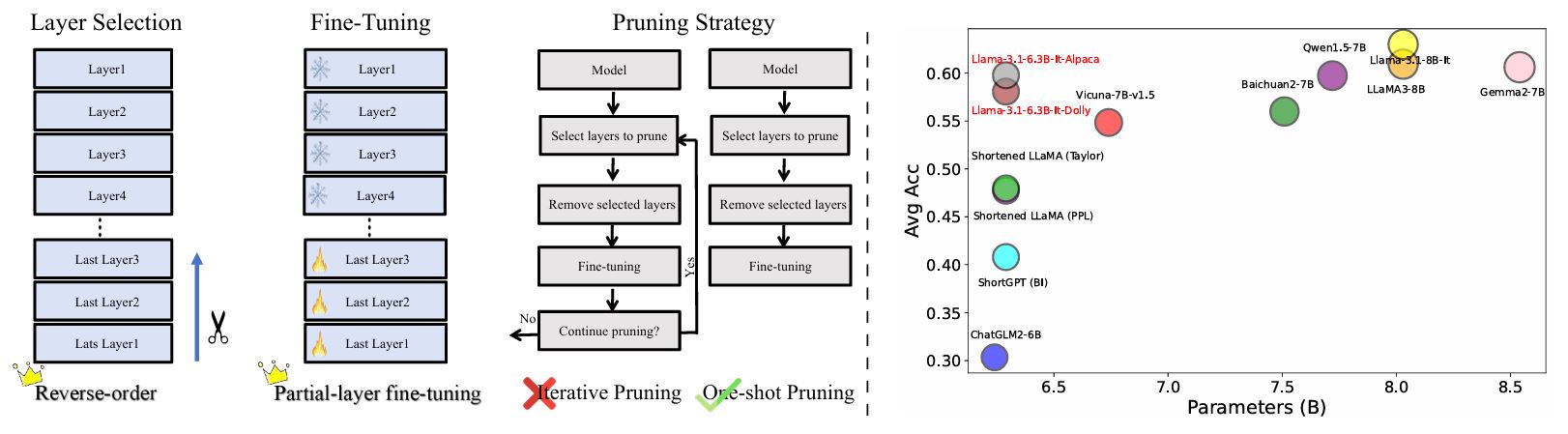

Reevaluar la poda de capa en LLM: nuevas ideas y métodos Yao Lu, Hao Cheng, Yujie Fang, Zeyu Wang, Jiaheng Wei, Dongwei Xu, Qi Xuan, Xiaoniu Yang, Zhaowei Zhu |  | Github Papel |

| Importancia de la capa y análisis de alucinación en modelos de lenguaje grande a través de la varianza de activación mejorada Canción de Zichen, Sitan Huang, Yuxin Wu, Zhongfeng Kang | Papel | |

Ameballm: Construcción de modelos de lenguaje grande en cualquier forma para una implementación eficiente e instantánea Yonggan Fu, Zhongzhi Yu, Junwei Li, Jiayi Qian, Yongan Zhang, Xiangchi Yuan, Dachuan Shi, Roman Yakunin, Yingyan Celine Lin | Github Papel | |

| Ley de escala para la poda posterior al modelo después de la poda Xiaodong Chen, Yuxuan Hu, Jing Zhang, Xiaokang Zhang, Cuiping Li, Hong Chen | Papel | |

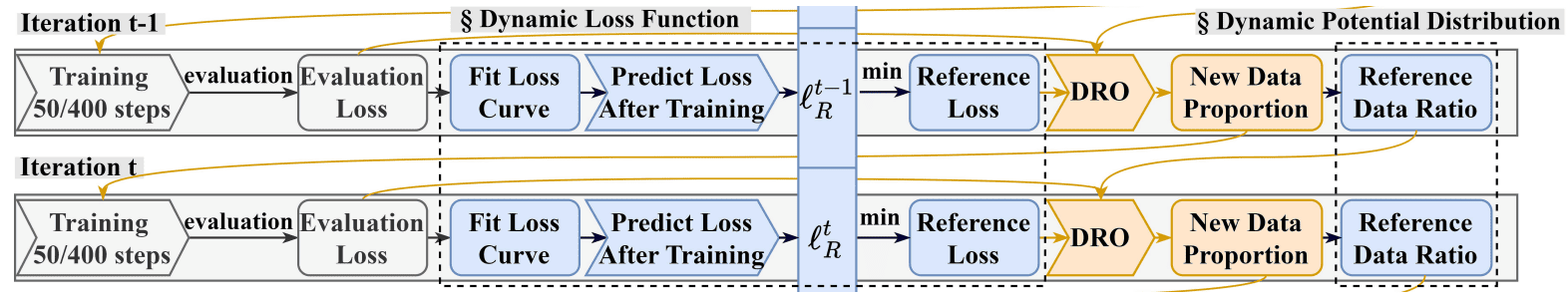

Drpruning: poda de modelo de lenguaje grande eficiente a través de una optimización distributionalmente robusta Hexuan Deng, Wenxiang Jiao, Xuebo Liu, Min Zhang, Zhaopeng Tu |  | Github Papel |

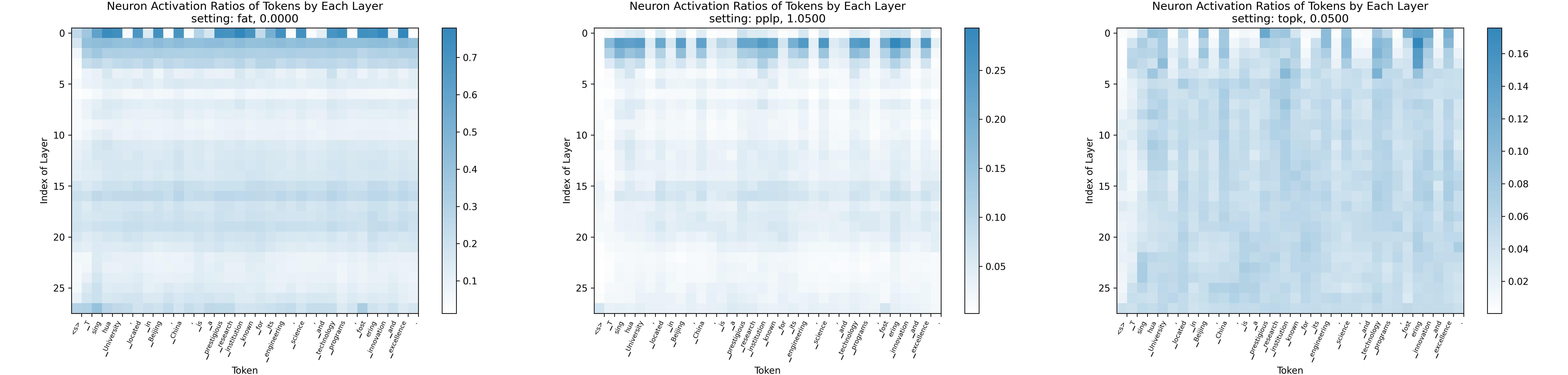

Ley de empalme: hacia grandes modelos de idiomas con mayor escasez de activación Yuqi Luo, Chenyang Song, Xu Han, Yingfa Chen, Chaojun Xiao, Zhiyuan Liu, Maosong Sun |  | Github Papel |

| AVSS: Evaluación de importancia de capa en modelos de lenguaje grande a través del análisis de varianza de la varianza de activación Song de Zichen, Yuxin Wu, Sitan Huang, Zhongfeng Kang | Papel | |

| Sastraned-Llama: Optimización del aprendizaje de pocos disparos en modelos podados de LLAMA con indicaciones específicas de la tarea Danyal Aftab, Steven Davy | Papel | |

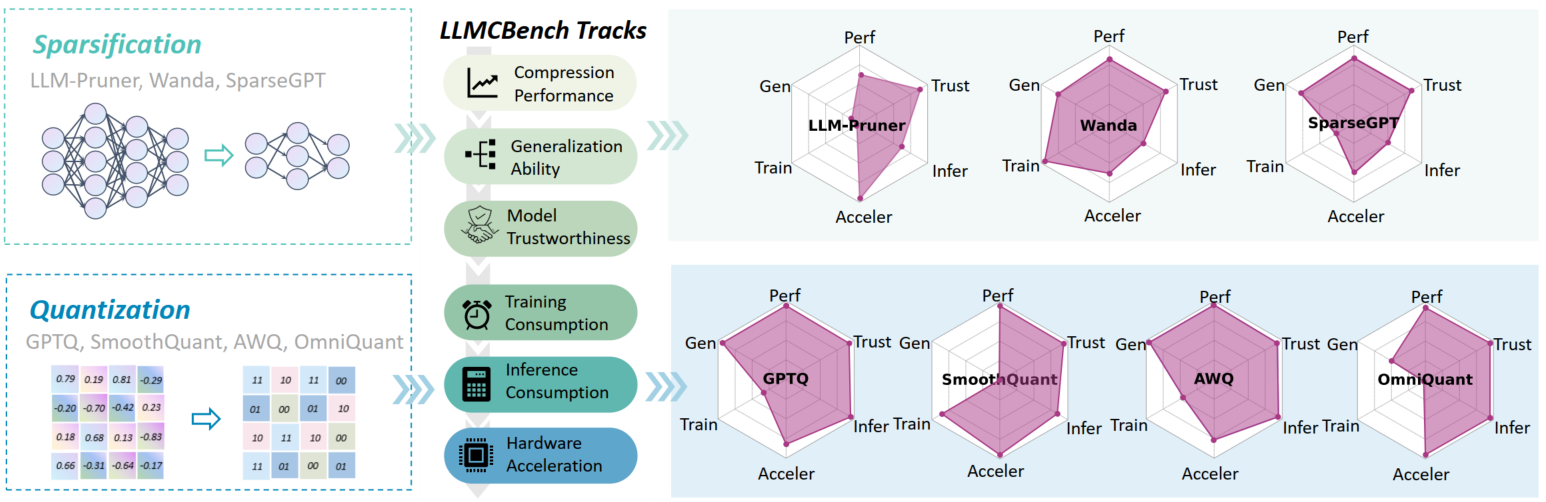

LLMCBIGH: Benchmarking de compresión del modelo de idioma grande para una implementación eficiente Ge Yang, Changyi He, Jinyang Guo, Jianyu Wu, Yifu Ding, Aishan Liu, Haotong Qin, Pengliang Ji, Xianglong Liu |  | Github Papel |

| Más allá de 2: 4: Explorando V: N: M Sparsity para una inferencia de transformador eficiente en GPU Kang Zhao, Tao Yuan, Han Bao, Zhenfeng Su, Chang Gao, Zhaofeng Sun, Zichen Liang, Liping Jing, Jianfei Chen | Papel | |

Evasión: hacia la compresión óptima del modelo dinámico a través de la búsqueda evolutiva Oliver Sieberling, Denis Kuznedelev, Eldar Kurtic, Dan Alistarh |  | Github Papel |

| Fedspallm: poda federada de modelos de idiomas grandes Guangji Bai, Yijiang Li, Zilinghan Li, Liang Zhao, Kibaek Kim | Papel | |

Modelos de la Fundación de poda para alta precisión sin reentrenamiento Pu Zhao, Fei Sun, Xuan Shen, Pinrui Yu, Zhenglun Kong, Yanzhi Wang, Xue Lin | Github Papel | |

| Autocalibración para cuantización y poda del modelo de lenguaje Miles Williams, George Chrysostomou, Nikolaos Aletras | Papel | |

| Tenga cuidado con los datos de calibración para podar modelos de idiomas grandes Yixin Ji, Yang Xiang, Juntao Li, Qingrong Xia, Ping Li, Xinyu Duan, Zhefeng Wang, Min Zhang | Papel | |

Alphapruning: Uso de la teoría de auto regularización de cola pesada para una poda mejorada en la capa de modelos de idiomas grandes Haiquan Lu, Yefan Zhou, Shiwei Liu, Zhangyang Wang, Michael W. Mahoney, Yaoqing Yang | Github Papel | |

| Más allá de las aproximaciones lineales: un enfoque de poda novedoso para la matriz de atención Yingyu Liang, Jiangxuan Long, Zhenmei Shi, Zhao Song, Yufa Zhou | Papel | |

Disp-llm: poda estructural independiente de dimensiones para modelos de idiomas grandes Shangqian Gao, Chi-Heng Lin, Ting Hua, Tang Zheng, Yilin Shen, Hongxia Jin, Yen-Chang Hsu | Papel | |

Destilación de autodatos para recuperar la calidad en modelos de lenguaje grande podado Vithursan Thangarasa, Ganesh Venkatesh, Nish Sinnadurai, Sean Lie | Papel | |

| LLM-Rank: un enfoque teórico gráfico para podar modelos de lenguaje grande David Hoffmann, Kailash Budhathoki, Matthaeus Kleindessner | Papel | |

¿Es el conjunto de datos C4 óptimo para la poda? Una investigación de los datos de calibración para la poda de LLM Abhinav Bandari, Lu Yin, Cheng-yu Hsieh, Ajay Kumar Jaiswal, Tianlong Chen, Li Shen, Ranjay Krishna, Shiwei Liu | Github Papel | |

| Mitigando el sesgo de copia en el aprendizaje en contexto a través de la poda de neuronas Ameen Ali, Lior Wolf, Ivan Titov |  | Papel |

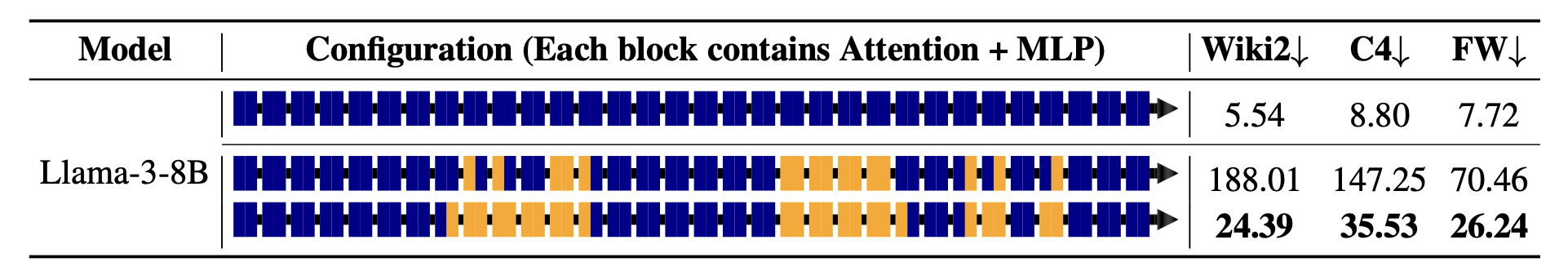

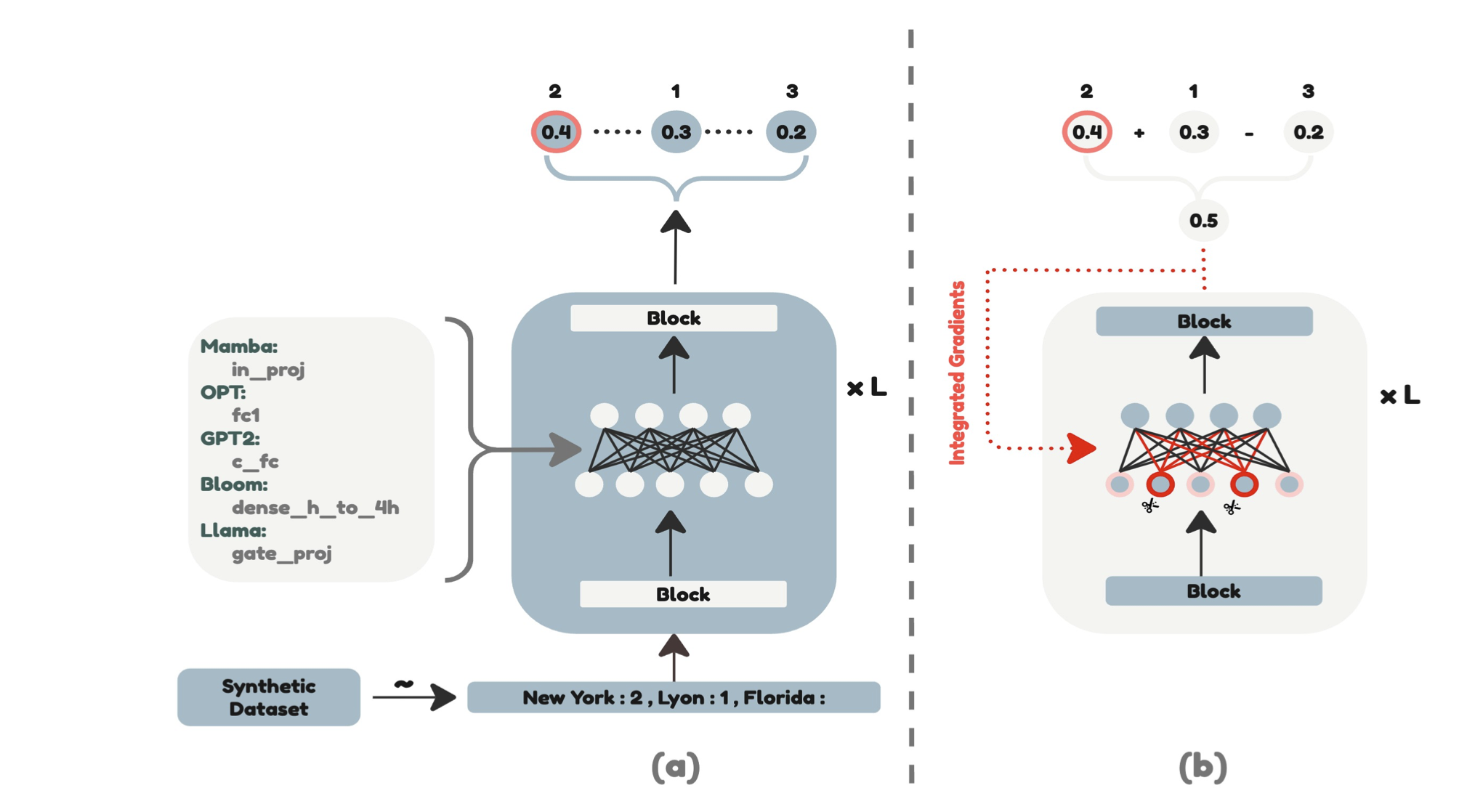

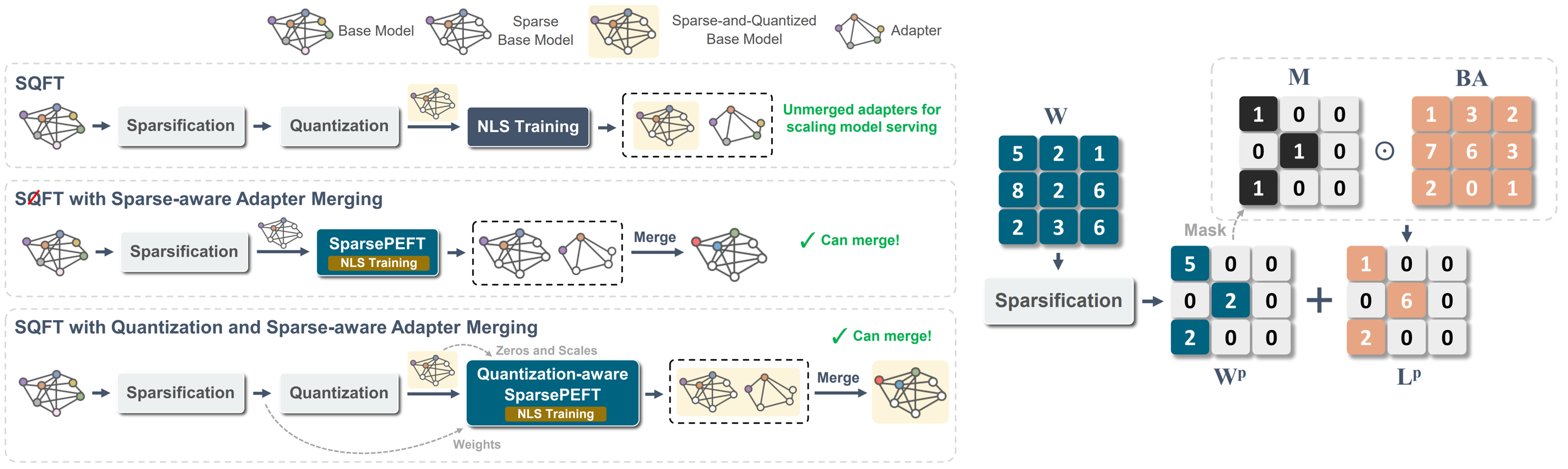

SQFT: adaptación al modelo de bajo costo en modelos de base dispersos de baja precisión Juan Pablo Muñoz, Jinjie Yuan, Nilesh Jain |  | Github Papel |

Maskllm: Sparsidad semiestructurada aprendida para modelos de idiomas grandes Gongfan Fang, Hongxu Yin, Saurav Muralidharan, Greg Heinrich, Jeff Pool, Jan Kautz, Pavlo Molchanov, Xinchao Wang |  | Github Papel |

Buscar modelos de idiomas grandes eficientes Xuan Shen, Pu Zhao, Yifan Gong, Zhenglun Kong, Zheng Zhan, Yushu Wu, Ming Lin, Chao Wu, Xue Lin, Yanzhi Wang | Papel | |

CFSP: un marco de poda estructurado eficiente para LLM con información de activación gruesa a fina Yuxin Wang, Minghua MA, Zekun Wang, Jingchang Chen, Huiming Fan, Liping Shan, Qing Yang, Dongliang Xu, Ming Liu, Bing Qin | Github Papel | |

| Avena: poda atípica a través de la descomposición escasa y de bajo rango Stephen Zhang, Vardan Papyan | Papel | |

| KVPruner: poda estructural para modelos de lenguaje grande más rápido y eficiente en la memoria Bo lv, Quan Zhou, Xuanang Ding, Yan Wang, Zeming Ma | Papel | |

| Evaluación del impacto de las técnicas de compresión en el rendimiento específico de la tarea de modelos de idiomas grandes Bishwash Khanal, Jeffery M. Capone | Papel | |

| Stun: poda estructurada por lo que no estre a estructura para la poda de MOE escalable Jaeseong Lee, Seung-Won Hwang, Aurick Qiao, Daniel F Campos, Zhewei Yao, Yuxiong HE | Papel | |

PAT: ANIMINACIÓN DE LENGUACIÓN ADMABILLACIÓN Yijiang Liu, Huanrui Yang, Yoxin Chen, Rongyu Zhang, Miao Wang, Yuan du, Li du |  | Github Papel |

| Título y autores | Introducción | Campo de golf |

|---|---|---|

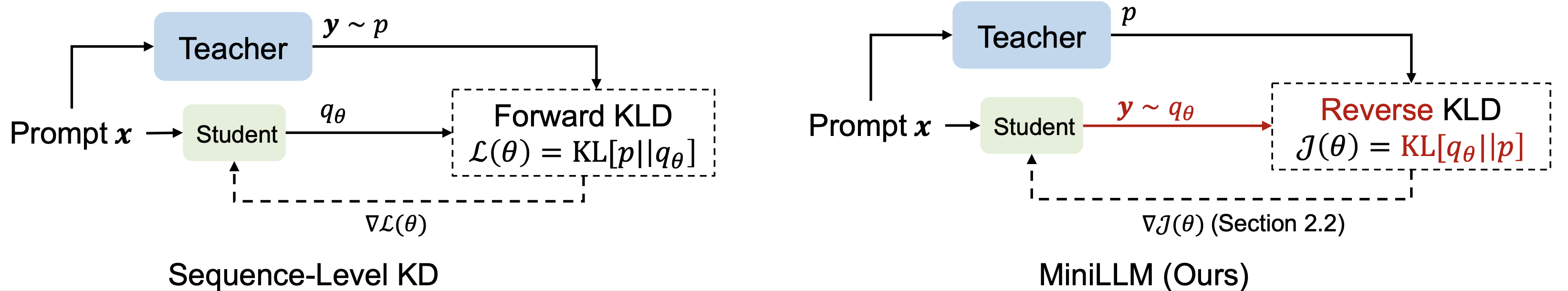

| Destilación del conocimiento de modelos de idiomas grandes Yuxian GU, Li Dong, Furu Wei, Minlie Huang |  | Github Papel |

| Mejora de las capacidades de razonamiento matemático de modelos de idiomas pequeños a través de la destilación basada en retroalimentación Xunyu Zhu, Jian Li, Can Ma, Weiping Wang | Papel | |

Destilación de contexto generativo Haebin Shin, Lei Ji, Yeyun Gong, Sungdong Kim, Eunbi Choi, Minjoon Seo |  | Github Papel |

| Switch: Estudiar con el maestro para la destilación de conocimiento de modelos de idiomas grandes Jahyun Koo, Yerin Hwang, Yongil Kim, Taegwan Kang, Hyunkyung Bae, Kyomin Jung |  | Papel |

Más allá de la autorregresión: Fast LLMS a través de la autodistilación a través del tiempo Justin Deschenaux, Caglar Gulcehre | Github Papel | |

| Destilación previa al entrenamiento para modelos de idiomas grandes: una exploración espacial de diseño Hao Peng, Xin LV, Yushi Bai, Zijun Yao, Jiajie Zhang, Lei Hou, Juanzi Li | Papel | |

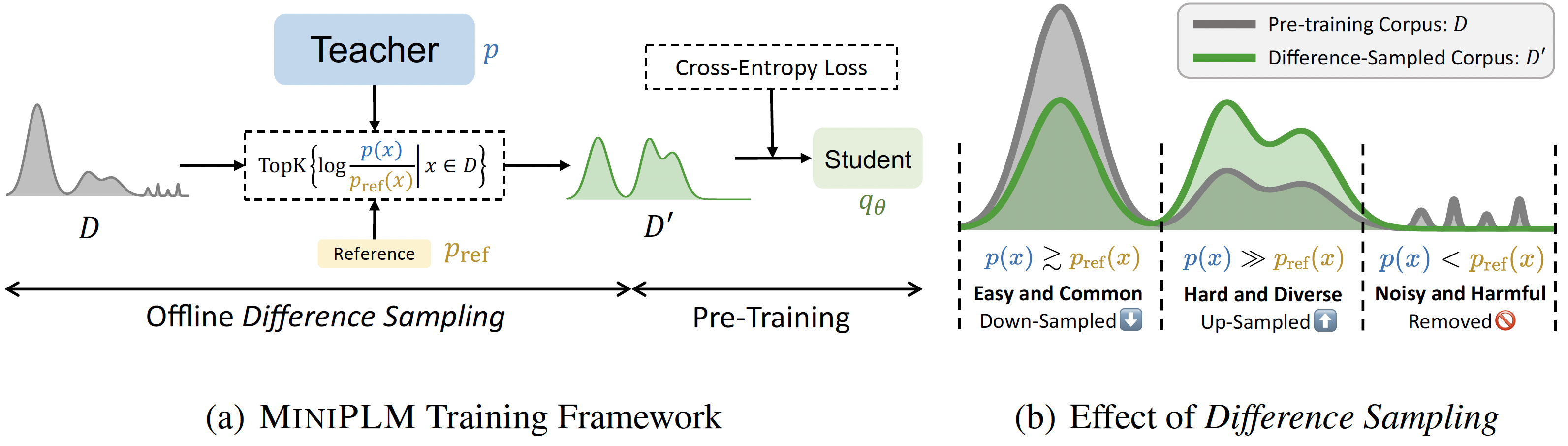

MiniPlm: Destilación del conocimiento para los modelos de lenguaje previo a la capacitación Yuxian GU, Hao Zhou, Fandong Meng, Jie Zhou, Minlie Huang |  | Github Papel |

| Destilación del conocimiento especulativo: unir la brecha del maestro-alumno a través del muestreo entrelazado Wenda Xu, Rujun Han, Zifeng Wang, Long T. Le, Dhruv Madeka, Lei Li, William Yang Wang, Rishabh Agarwal, Chen-Yu Lee, Tomas Pfister | Papel | |

| Destilación evolutiva contrastante para la alineación del modelo de idioma Julian Katz-Samuels, Zheng Li, Hyokun Yun, Priyanka Nigam, Yi Xu, Vaclav Petricek, Bing Yin, Trishul Chilimbi | Papel | |

| Babyllama-2: los modelos designados en conjunto superan a los maestros con datos limitados Jean-Loup Tastet, Inar Timiryasov | Papel | |

| Ecoatt: asistir, copiar, luego ajuste para modelos de lenguaje grande más eficientes Hossein Rajabzadeh, Aref Jafari, Aman Sharma, Benyamin Jami, Hyock Ju Kwon, Ali Ghodsi, Boxing Chen, Mehdi rezagholizadeh | Papel | |

Skintern: internalización de conocimiento simbólico para destilar mejores capacidades de cot en modelos de lenguaje pequeños Huanxuan Liao, Shizhu He, Yupu Hao, Xiang Li, Yuanzhe Zhang, Kang Liu, Jun Zhao | Github Papel | |

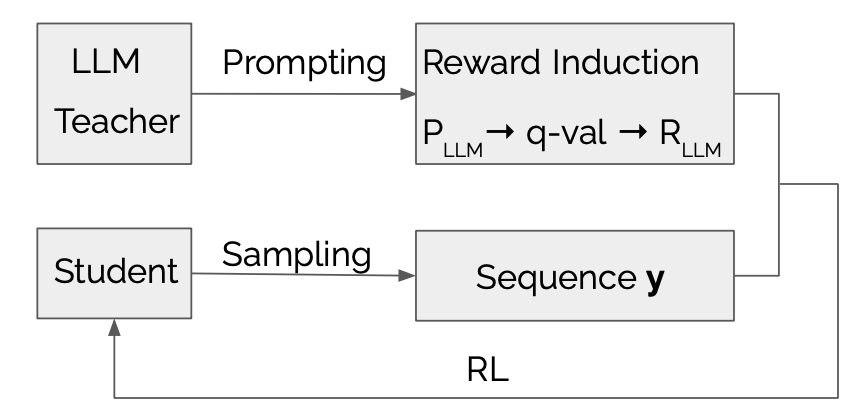

LLMR: Destilación del conocimiento con una recompensa inducida por el modelo de idioma grande Dongheng Li, Yongchang Hao, Lili Mou |  | Github Papel |

| Explorar y mejorar la transferencia de distribución en la destilación de conocimiento para modelos de lenguaje autorregresivo Jun Rao, Xuebo Liu, Zepeng Lin, Liang Ding, Jing Li, Dacheng Tao | Papel | |

| Destilación de conocimiento eficiente: empoderamiento de modelos de lenguaje pequeño con ideas del modelo de maestro MOHAMAD PLOLEOUT, ULF KRUMNACK, Gunther Heidemann, Kai-Uwe Kühnberger | Papel | |

El Mamba en la Llama: Modelos híbridos de destilación y aceleración Junxiong Wang, Daniele Paliotta, Avner May, Alexander M. Rush, Tri Dao | Github Papel |

| Título y autores | Introducción | Campo de golf |

|---|---|---|

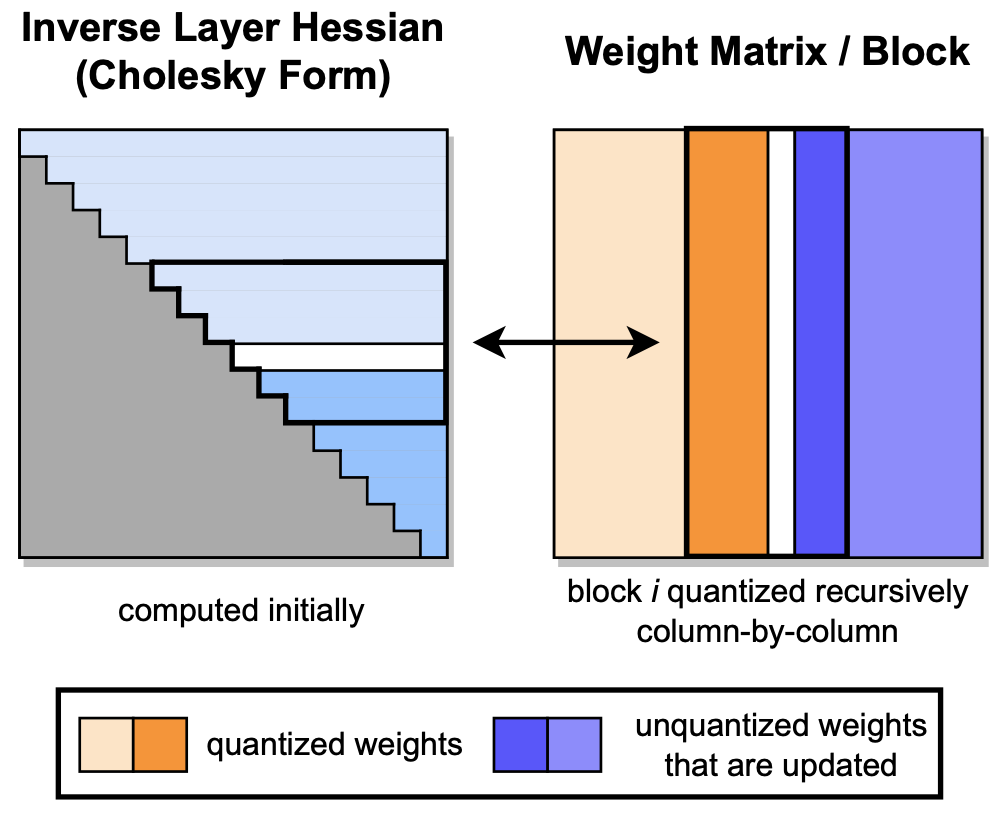

GPTQ: cuantización precisa posterior a la capacitación para transformadores generativos previamente capacitados Elias Frantar, Saleh Ashkboos, Torsten Hoefler, Dan Alistarh |  | Github Papel |

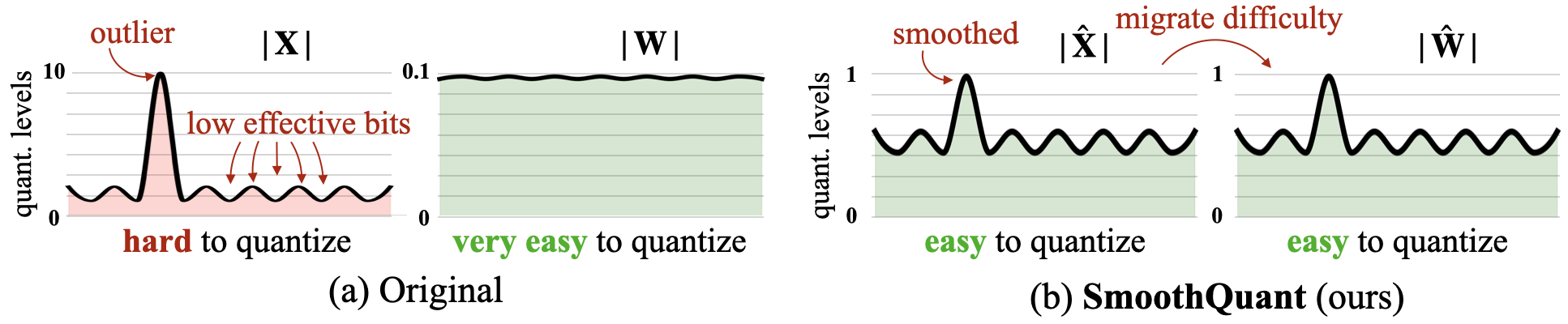

Smoothquant: cuantización precisa y eficiente posterior a la capacitación para modelos de lenguaje grande Guangxuan Xiao, Ji Lin, Mickael Seznec, Hao Wu, Julien Demouth, Song Han |  | Github Papel |

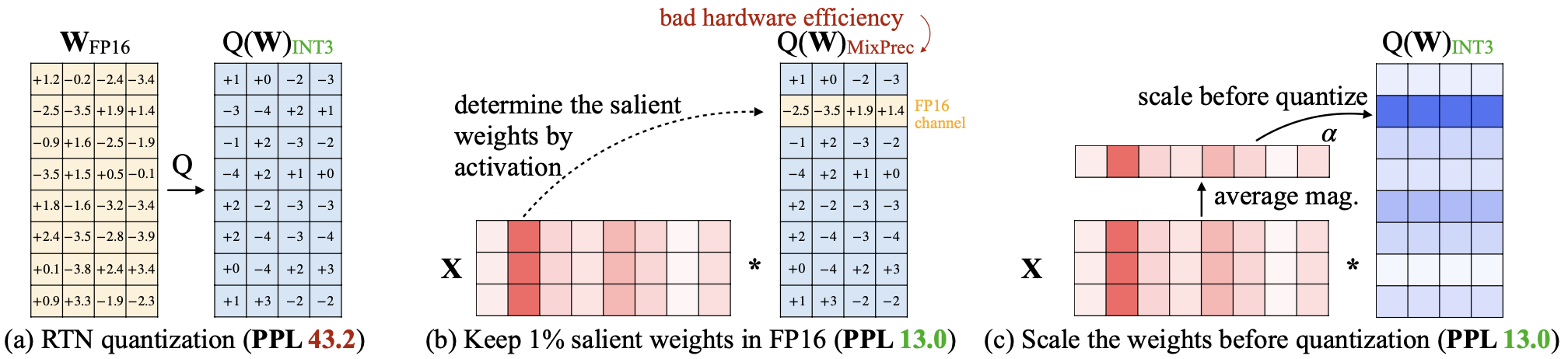

AWQ: cuantificación de peso consciente de activación para compresión y aceleración de LLM Ji Lin, Jiaming Tang, Haotian Tang, Shang Yang, Xingyu Dang, Song Han |  | Github Papel |

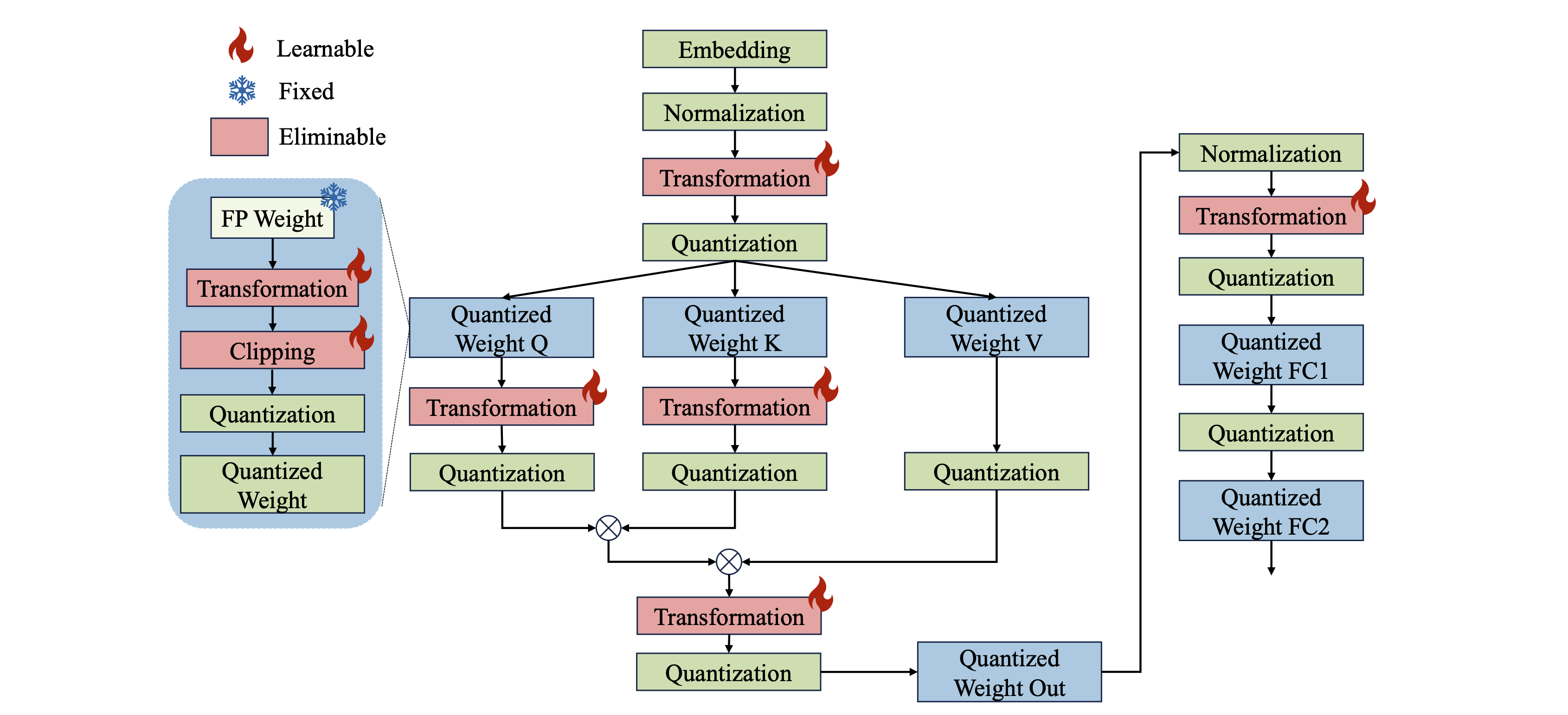

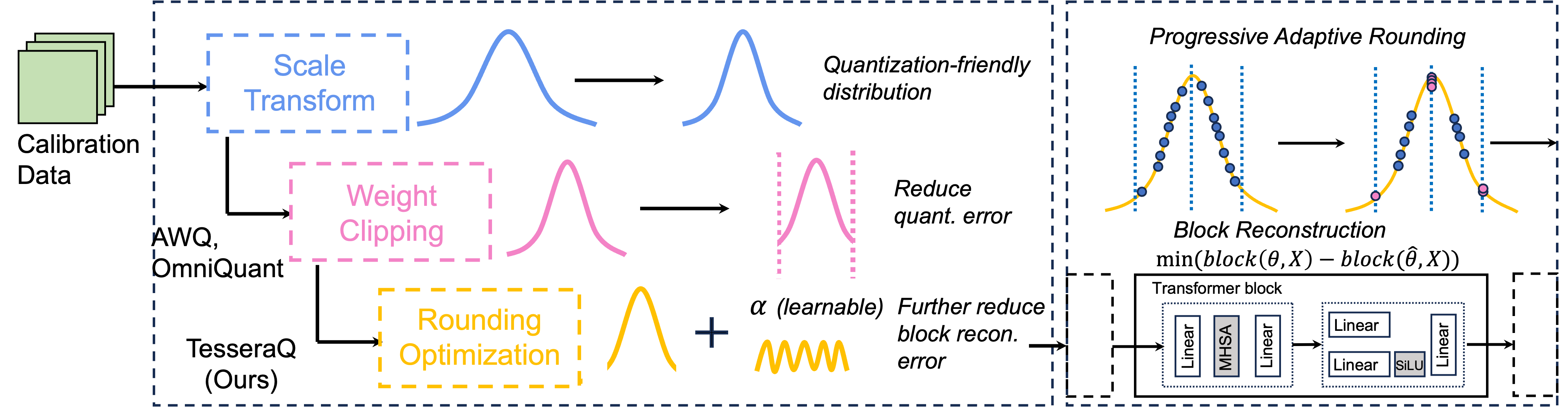

Omniquant: cuantificación omnidireccional calibrada para modelos de idiomas grandes Wenqi Shao, Mengzhao Chen, Zhaoyang Zhang, Peng Xu, Lirui Zhao, Zhiqian Li, Kaipeng Zhang, Peng Gao, Yu Qiao, Ping Luo |  | Github Papel |

| SKIM: Cuantización en cualquier bit que empujan los límites de la cuantización posterior al entrenamiento Runsheng Bai, Qiang Liu, Bo Liu | Papel | |

| CPTQUANT: una novedosa técnica de cuantificación de postrante de precisión mixta para modelos de idiomas grandes Amitash Nanda, Sree Bhargavi Balija, Debashis Sahoo | Papel | |

Anda: Desbloqueo de inferencia de LLM eficiente con un formato de datos de activación agrupados de longitud variable Chao Fang, Man Shi, Robin Geens, Arne Symons, Zhongfeng Wang, Marian Verhelst | Papel | |

| MixPE: cuantificación y conjunto de hardware para una inferencia de LLM eficiente Yu Zhang, Mingzi Wang, Lancheng Zou, Wulong Liu, Hui-Ling Zhen, Mingxuan Yuan, Bei Yu | Papel | |

BitMod: Aceleración de la mezcla de bits-serial de Datatype LLM Yuzong Chen, Ahmed F. Aboulhamayed, Xilai Dai, Yang Wang, Marta Andronic, George A. Constantinides, Mohamed S. Abdelfattah | Github Papel | |

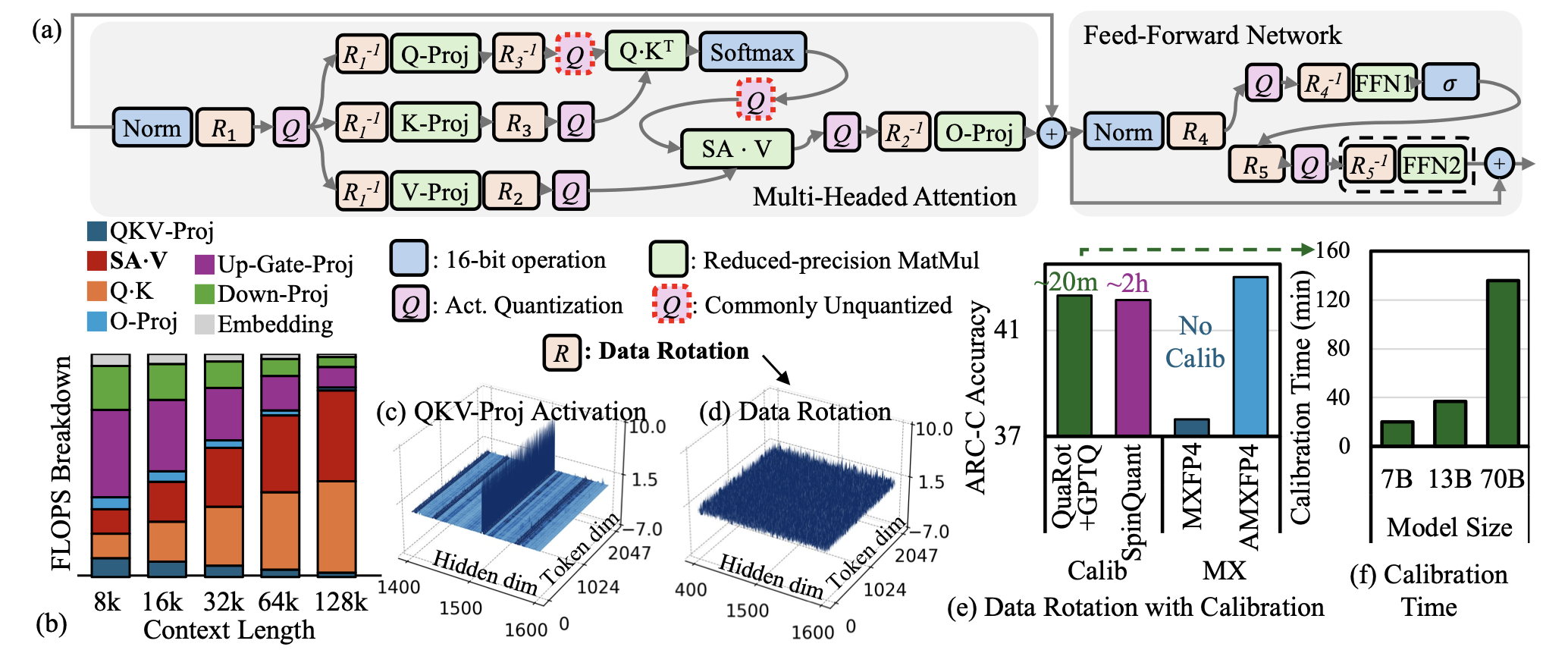

| AMXFP4: Los valores atípicos de la activación en domicilio con punto flotante de microscaluación asimétrica para inferencia LLM de 4 bits Janghwan Lee, Jiwoong Park, Jinseok Kim, Yongjik Kim, Jungju Oh, Jinwook Oh, Jungwook Choi |  | Papel |

| Bi-Mamba: Hacia modelos de espacio de estado de 1 bits precisos Shengkun Tang, Liqun MA, Haonan Li, Mingjie Sun, Zhiqiang Shen | Papel | |

| "¿Dame BF16 o dame la muerte"? Compensaciones de rendimiento de precisión en cuantización de LLM Eldar Kurtic, Alexandre Marques, Shubhra Pandit, Mark Kurtz, Dan Alistarh | Papel | |

| GWQ: cuantificación de peso consciente de los gradientes para modelos de idiomas grandes Yihua Shao, Siyu Liang, Xiaolin Lin, Zijian Ling, Zixian Zhu et al. | Papel | |

| Un estudio exhaustivo sobre técnicas de cuantización para modelos de idiomas grandes Jiedong Lang, Zhehao Guo, Shuyu Huang | Papel | |

| Bitnet A4.8: activaciones de 4 bits para LLM de 1 bits Hongyu Wang, Shuming Ma, Furu Wei | Papel | |

Tesseraq: cuantificación de post-entrenamiento LLM ultra baja con reconstrucción de bloques Yuhang Li, Priyadarshini Panda |  | Github Papel |

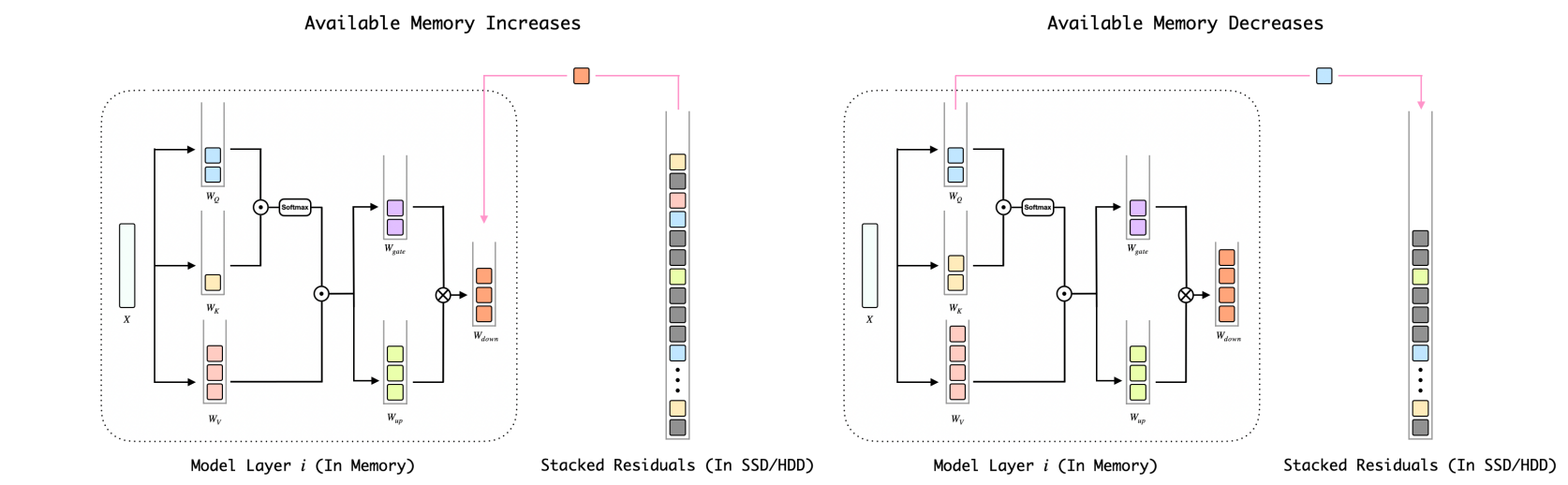

BitStack: control de tamaño de grano fino para modelos de lenguaje grande comprimido en entornos de memoria variable Xinghao Wang, Pengyu Wang, Bo Wang, Dong Zhang, Yunhua Zhou, Xipeng Qiu |  | Github Papel |

| El impacto de las estrategias de aceleración de inferencia en el sesgo de LLMS Elisabeth Kirsten, Ivan Habernal, Vedant Nanda, Muhammad Bilal Zafar | Papel | |

| Comprender la dificultad de la cuantización posterior al entrenamiento de baja precisión de modelos de idiomas grandes Zifei Xu, Sayeh Sharify, Wanzin Yazar, Tristan Webb, Xin Wang | Papel | |

Infra AI de 1 bits: Parte 1.1, Bitnet rápida y sin pérdida Bitnet B1.58 Inferencia en CPU Jinheng Wang, Hansong Zhou, Ting Song, Shaoguang Mao, Shuming MA, Hongyu Wang, Yan Xia, Furu Wei | Github Papel | |

| Quailora: inicialización de cuantización para Lora Neal Lawton, Aishwarya Padmakumar, Judith Gaspers, Jack Fitzgerald, Anoop Kumar, Greg Ver Steeg, Aram Galstyan | Papel | |

| Evaluación de modelos de lenguaje grande cuantificados para la generación de códigos en puntos de referencia de lenguaje de bajo recurso Enkhbold nyamsuren | Papel | |

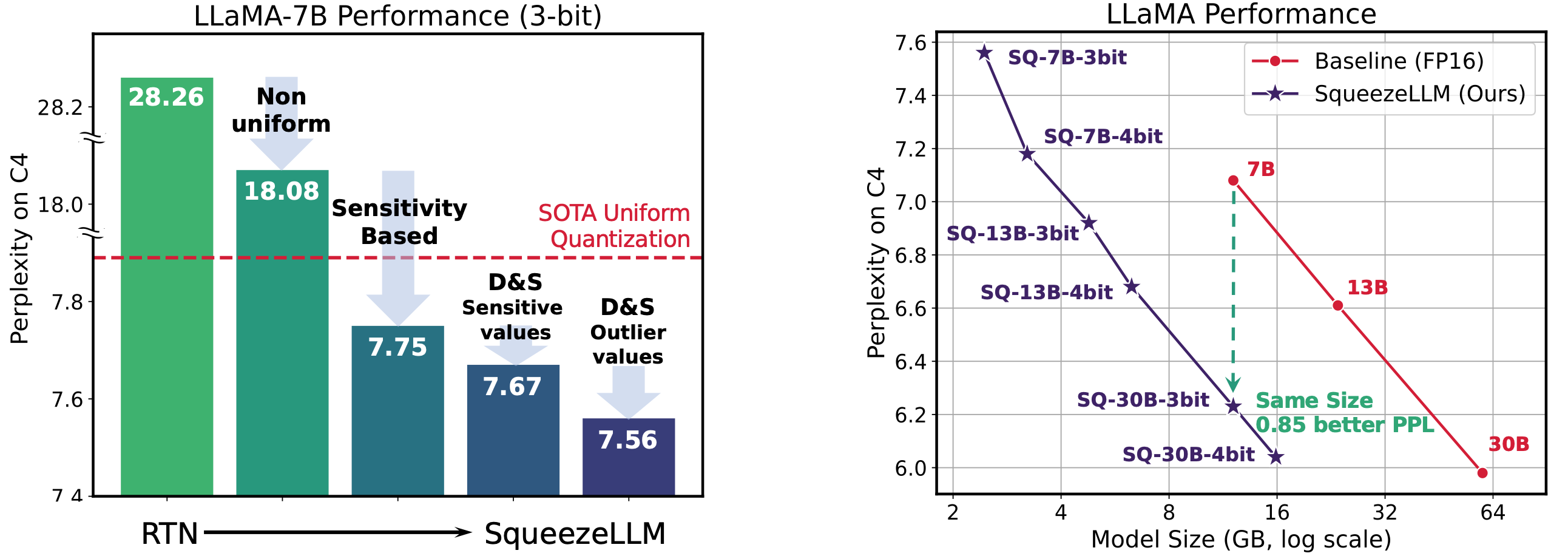

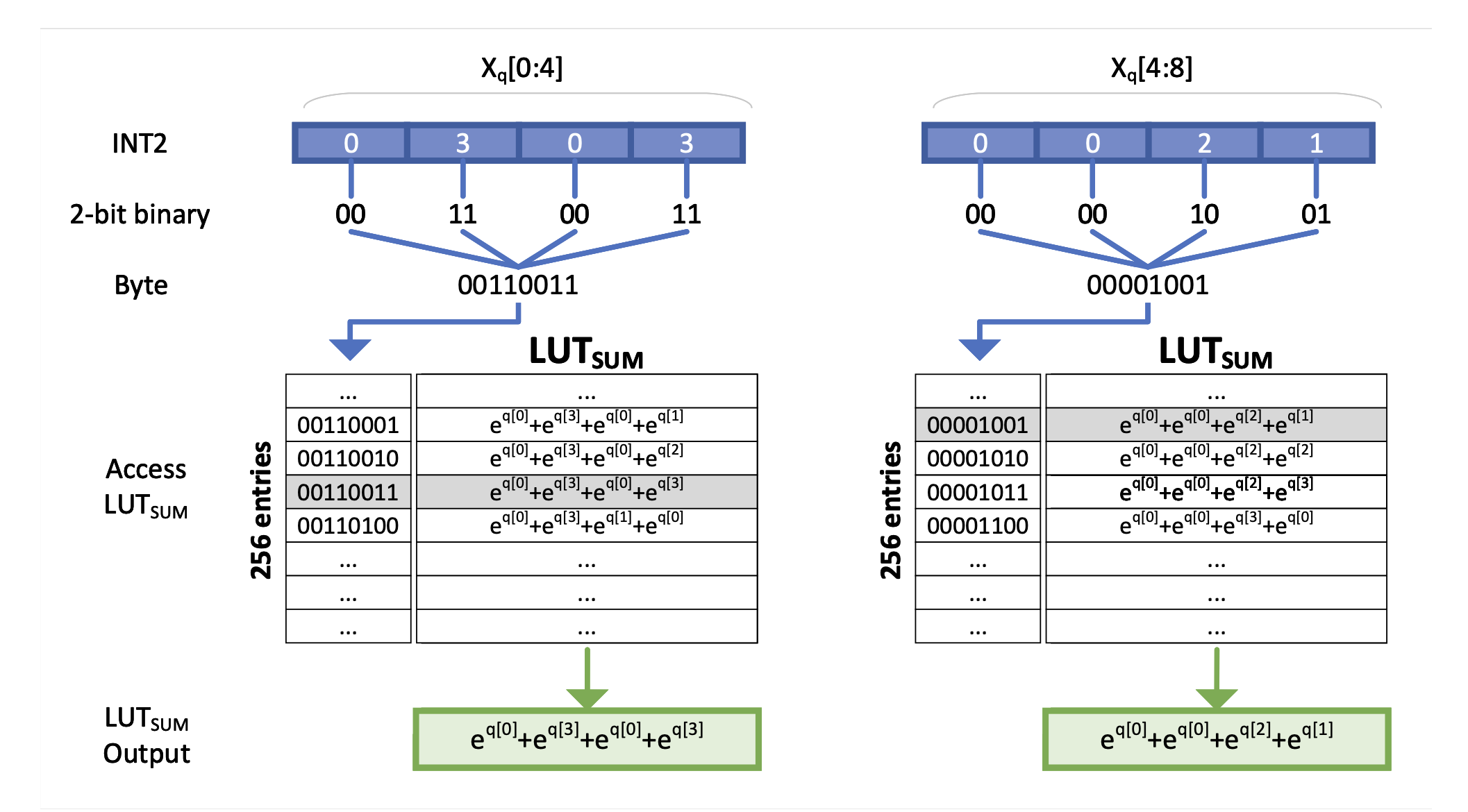

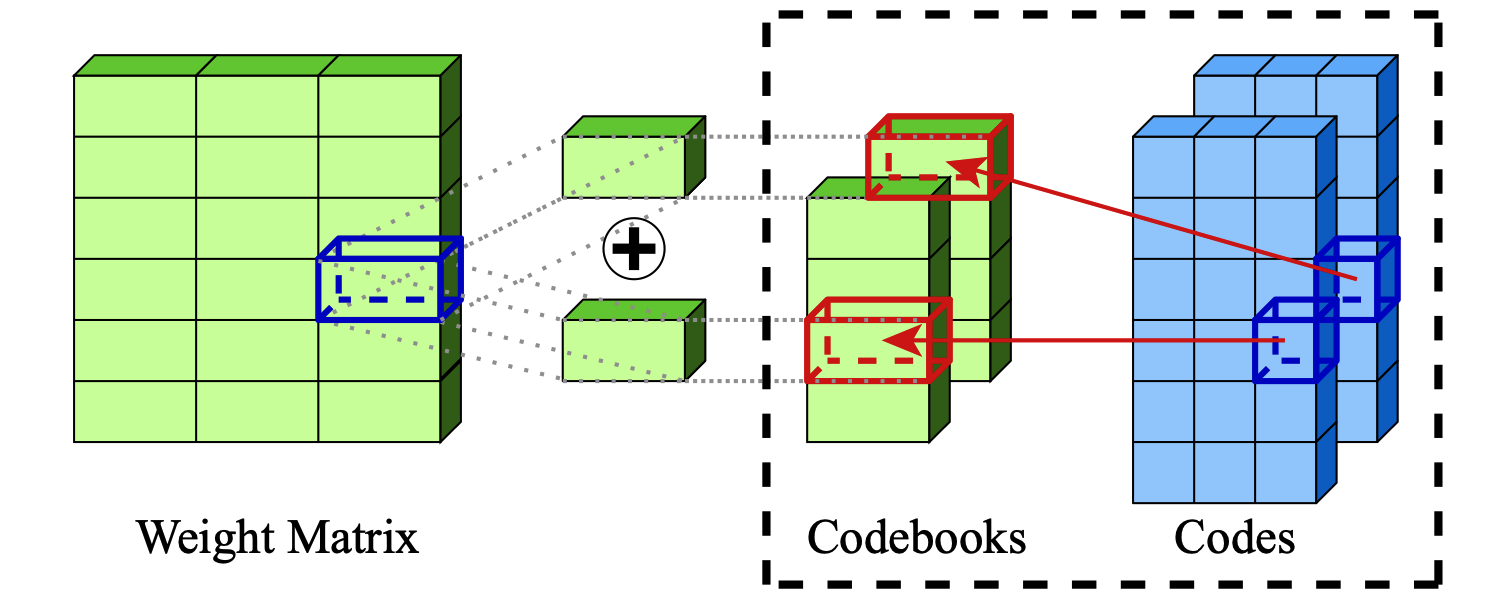

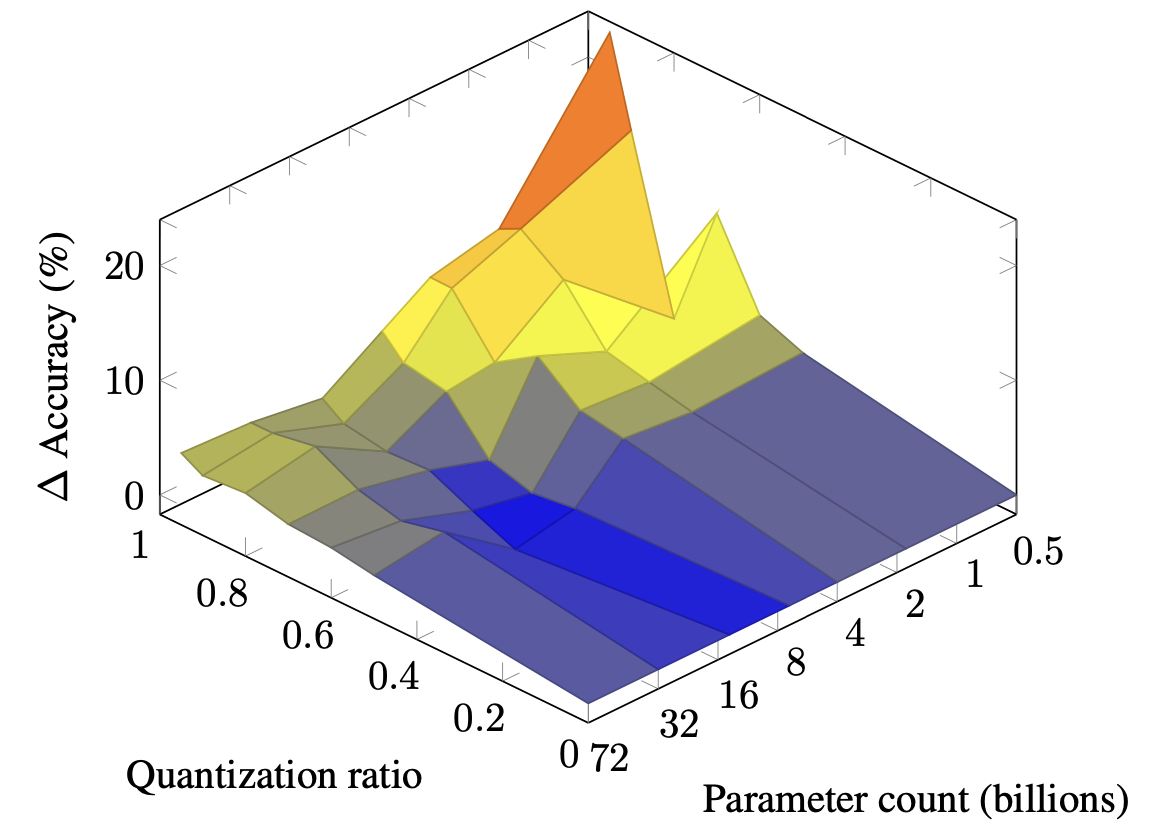

Squeezellm: cuantificación densa y plastificación Sehoon Kim, Coleman Hooper, Amir Gholami, Zhen Dong, Xiuyu Li, Sheng Shen, Michael W. Mahoney, Kurt Keutzer |  | Github Papel |

| Cuantización del vector piramidal para LLMS Tycho fa van der Ouderaa, Maximilian L. Croci, Agrin Hilmkil, James Hensman | Papel | |

| Seedlm: comprimir pesos de LLM en semillas de generadores pseudo-aleatorios Rasoul Shafipour, David Harrison, Maxwell Horton, Jeffrey Marker, Houman Bedayat, Sachin Mehta, Mohammad Rastegari, Mahyar Najibi, Saman Naderiparizi | Papel | |

Flatquant: Flatness es importante para la cuantización de LLM Yuxuan Sun, Ruikang Liu, Haoli Bai, Han Bao, Kang Zhao, Yuening Li, Jiaxin Hu, Xianzhi Yu, Lu Hou, Chun Yuan, Xin Jiang, Wulong Liu, Jun Yao | Github Papel | |

Slim: escasez cuantificado de una sola aproximación de bajo rango de LLMS Mohammad Mozaffari, Maryam Mehri Dehnavi | Github Papel | |

| Leyes de escala para modelos de lenguaje grande cuantificados posteriores al entrenamiento Zifei Xu, Alexander Lan, Wanzin Yazar, Tristan Webb, Sayeh Sharify, Xin Wang | Papel | |

| Aproximaciones continuas para mejorar la capacitación consciente de cuantización de LLMS Él Li, Jianhang Hong, Yuanzhuo Wu, Snehal Adbol, Zonglin Li | Papel | |

DAQ: cuantización de peso posterior al entrenamiento consciente de la densidad para LLMS para LLM Yingsong Luo, Ling Chen | Github Papel | |

Quamba: una receta de cuantificación posterior al entrenamiento para modelos de espacio de estado selectivo Hung-Yueh Chiang, Chi-Chih Chang, Natalia Frumkin, Kai-Chiang Wu, Diana Marculescu | Github Papel | |

| AsyMKV: habilitando la cuantización de 1 bits de caché de kV con configuraciones de cuantización asimétrica en forma de capa Qian Tao, Wenyuan Yu, Jingren Zhou | Papel | |

| Cuantización de precisión mixta en forma de canal para modelos de idiomas grandes Zihan Chen, Bike Xie, Jundong Li, Cong Shen | Papel | |

| Decodificación de precisión mixta progresiva para una inferencia de LLM eficiente Hao Mark Chen, Fuwen Tan, Alexandros Kouris, Royson Lee, Fan de Hongxiang, Stylianos I. Venieris | Papel | |

EXAQ: cuantización consciente de exponentes para la aceleración de LLMS Moran Shkolnik, Maxim Fishman, Brian Chmiel, Hilla Ben-Yaacov, Ron Banner, Kfir Yehuda Levy |  | Github Papel |

Prefixquant: la cuantización estática supera la dinámica a través de valores atípicos prefijados en LLMS Mengzhao Chen, Yi Liu, Jiahao Wang, Yi Bin, Wenqi Shao, Ping Luo | Github Papel | |

Compresión extrema de modelos de lenguaje grande a través de cuantización aditiva Vage Egiazarian, Andrei Panferov, Denis Kuznedelev, Elias Frantar, Artem Babenko, Dan Alistarh |  | Github Papel |

| Leyes de escala para cuantización mixta en modelos de idiomas grandes Zeyu Cao, Cheng Zhang, Pedro Gimenes, Jianqiao Lu, Jianyi Cheng, Yiren Zhao |  | Papel |

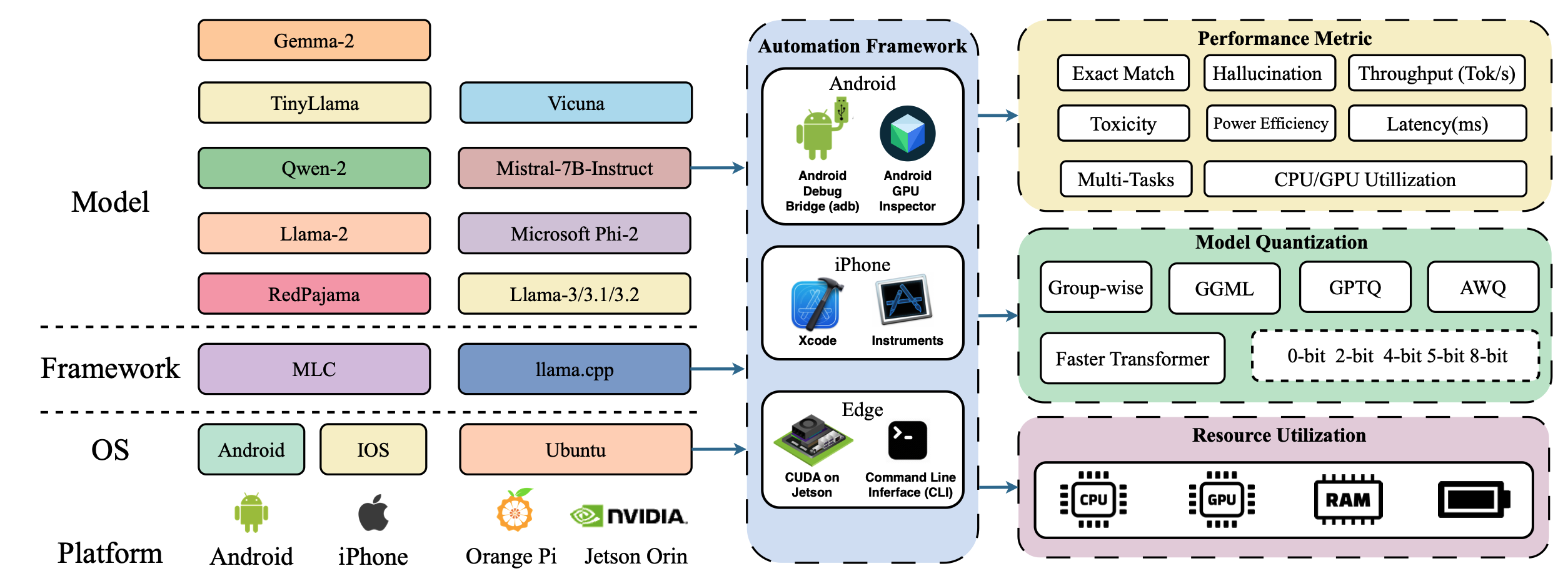

| Palmbench: un punto de referencia integral de modelos de lenguaje grandes comprimidos en plataformas móviles Yilong Li, Jingyu Liu, Hao Zhang, M Badri Narayanan, Utkarsh Sharma, Shuai Zhang, Pan Hu, Yijing Zeng, Jayaram Raghuram, Suman Banerjee |  | Papel |

| Crossquant: un método de cuantización posterior al entrenamiento con un núcleo de cuantización más pequeño para una compresión precisa del modelo de lenguaje grande Wenyuan Liu, Xindian MA, Peng Zhang, Yan Wang | Papel | |

| Sagaattention: atención precisa de 8 bits para la aceleración de inferencia de plug-and-play Jintao Zhang, Jia Wei, Pengle Zhang, Jun Zhu, Jianfei Chen | Papel | |

| La adición es todo lo que necesita para modelos de idiomas de eficiencia energética Hongyin Luo, Wei Sun | Papel | |

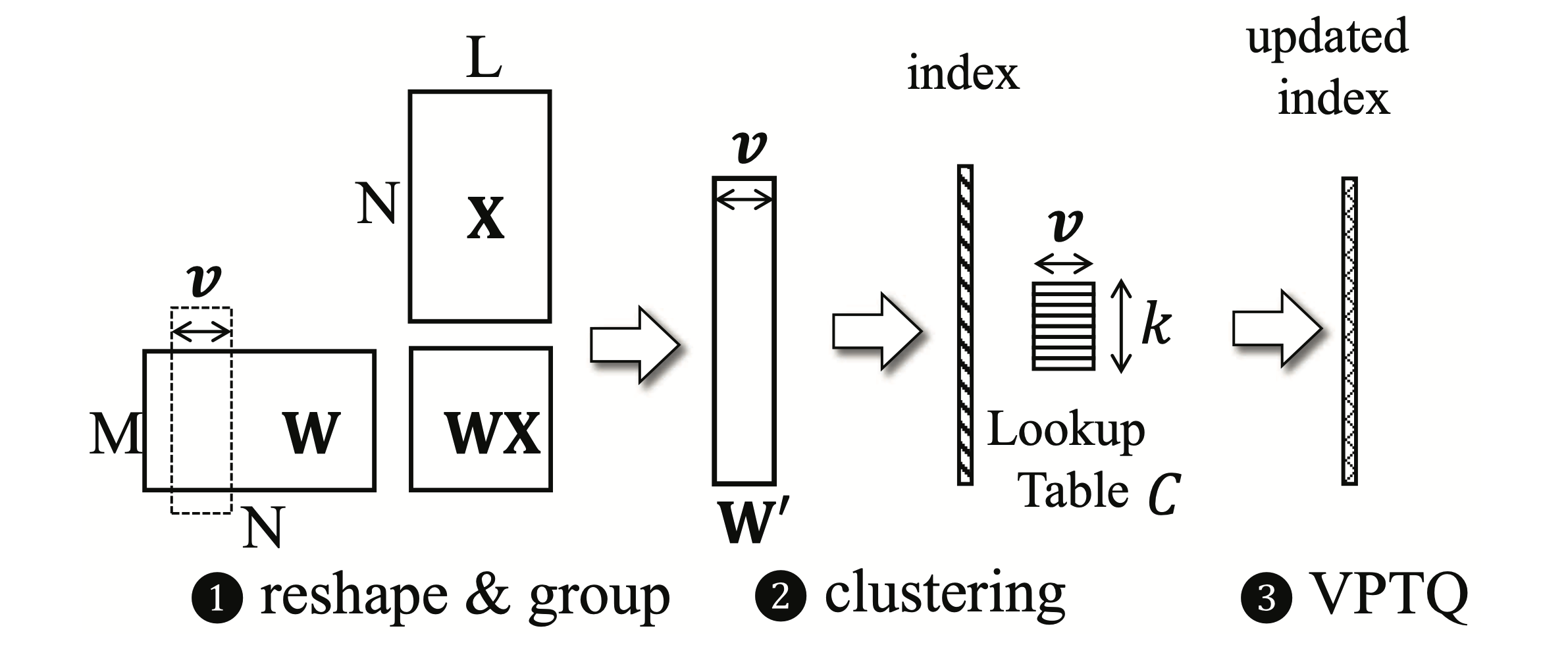

VPTQ: cuantificación de vectores de baja bits extremo para modelos de idiomas grandes Yifei Liu, Jicheng Wen, Yang Wang, Shengyu Ye, Li Lyna Zhang, Ting Cao, Cheng Li, Mao Yang |  | Github Papel |

Int-flashatent: habilitar la atención de flash para la cuantización int8 Shimao Chen, Zirui Liu, Zhiying Wu, Ce Zheng, Peizhuang Cong, Zihan Jiang, Yuhan Wu, Lei Su, Tong Yang | Github Papel | |

| Cuantización posterior al entrenamiento consciente del acumulador Ian Colbert, Fabian Grob, Giuseppe Franco, Jinjie Zhang, Rayan Saab | Papel | |

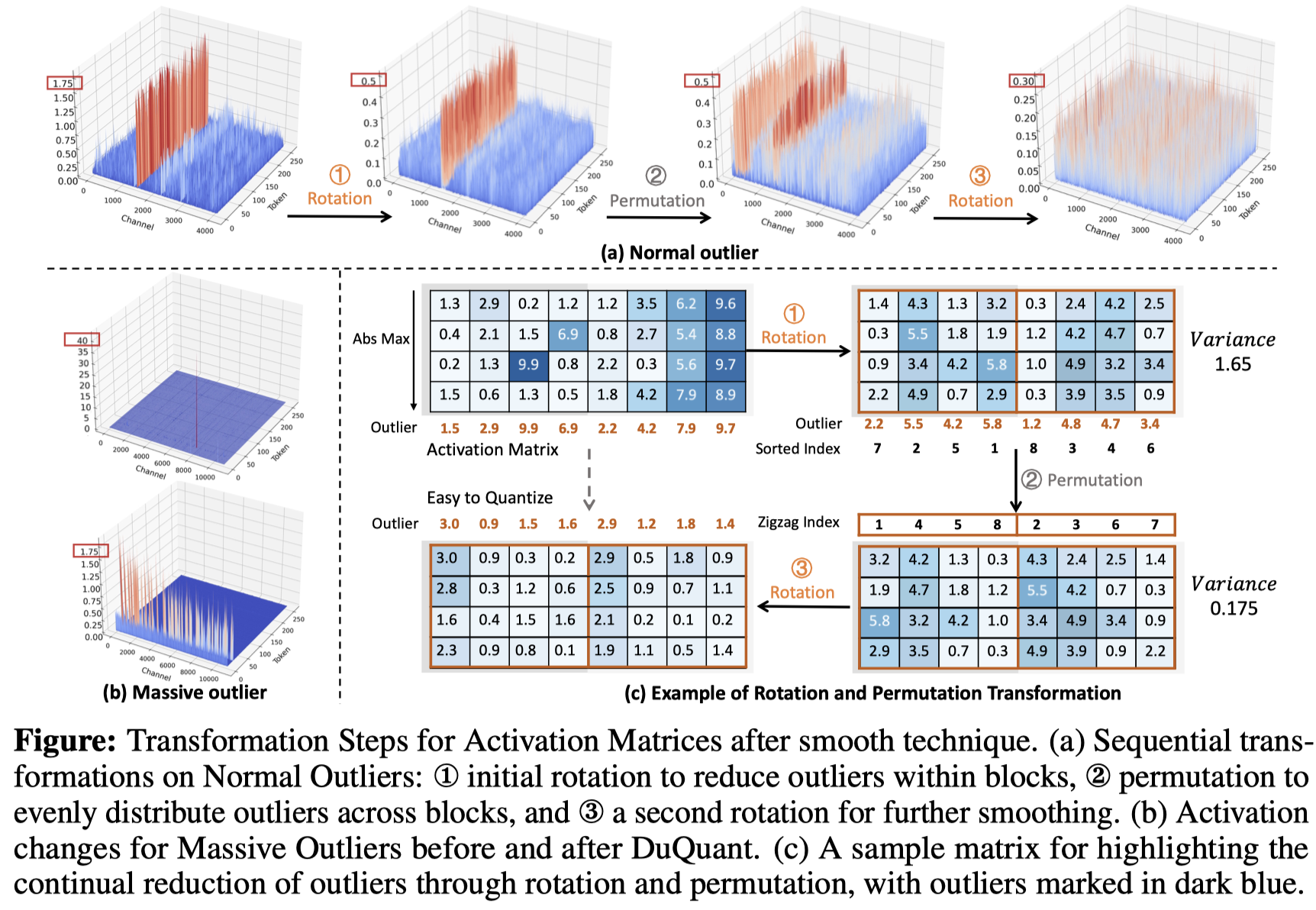

Duquant: la distribución de valores atípicos a través de la transformación dual hace que los LLM cuantizados más fuertes Haokun Lin, Haobo Xu, Yichen Wu, Jingzhi Cui, Yingtao Zhang, Linzhan Mou, Linqi Song, Zhenan Sun, Ying Wei |  | Github Papel |

| Una evaluación completa de los modelos de lenguaje grande cuantificados ajustados a la instrucción: un análisis experimental de hasta 405b Jemin Lee, Sihyeong Park, Jinse Kwon, Jihun Oh, Yongin Kwon | Papel | |

| La singularidad de Llama3-70B con cuantización por canal: un estudio empírico Minghai Qin | Papel |

| Título y autores | Introducción | Campo de golf |

|---|---|---|

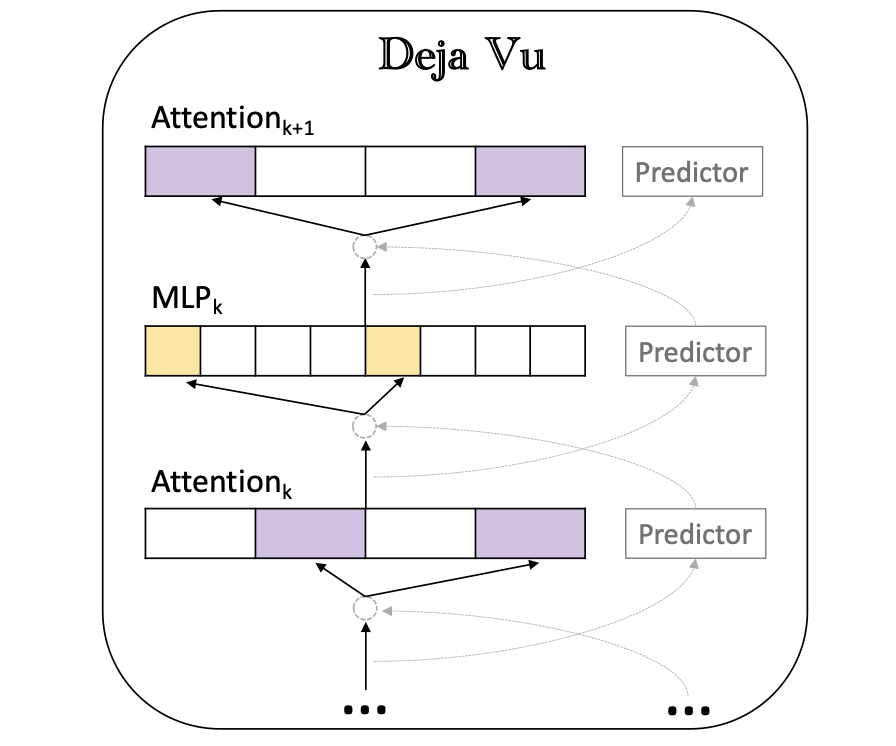

Deja Vu: escasez contextual para LLM eficientes en el momento de la inferencia Zichang Liu, Jue Wang, Tri Dao, Tianyi Zhou, Binhang Yuan, Zhao Song, Anshumali Shrivastava, Ce Zhang, Yuandong Tian, Christopher RE, Beidi Chen |  | Github Papel |

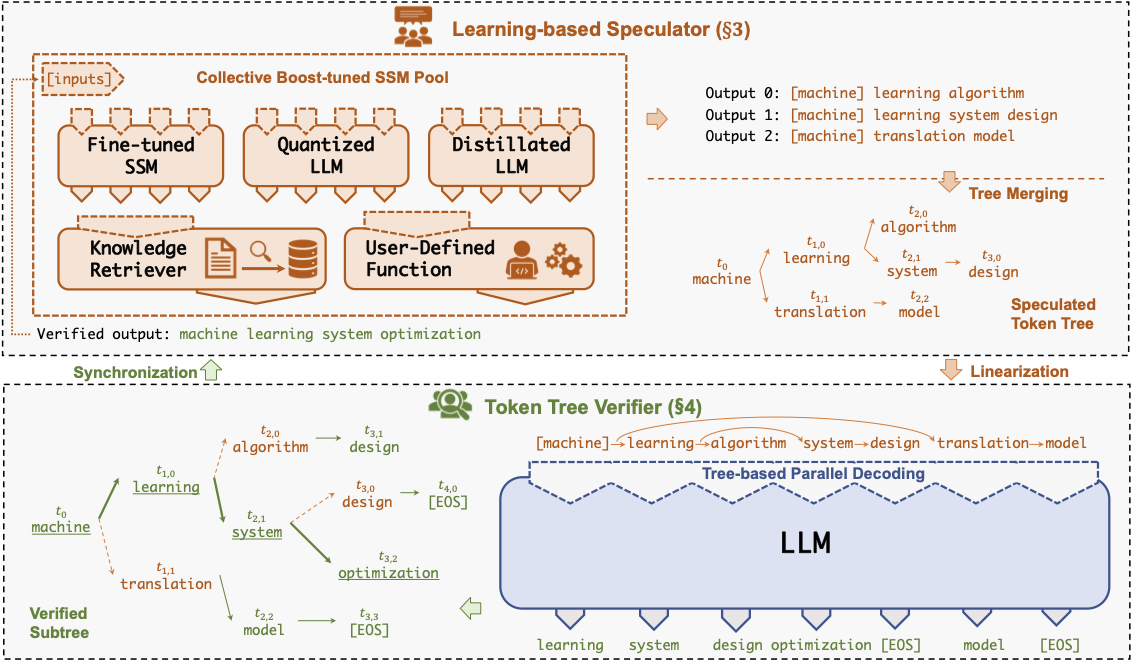

Specinfer: Acelerar Generation LLM Siring con inferencia especulativa y verificación de árboles de token Xupeng Miao, Gabriele Oliaro, Zhihao Zhang, Xinhao Cheng, Zeyu Wang, Rae Ying Yee Wong, Zhuoming Chen, Daiyaan Arfeen, Reyna Abhyankar, Zhihao Jia |  | Github papel |

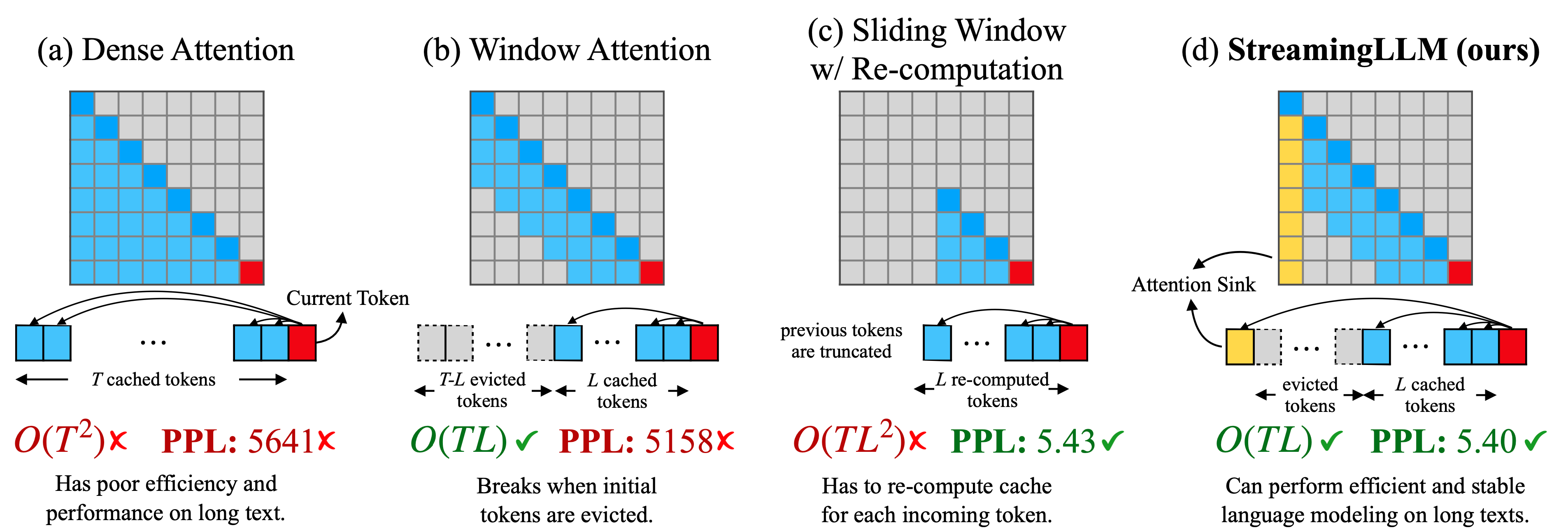

Modelos de lenguaje de transmisión eficientes con sumideros de atención Guangxuan Xiao, Yuandong Tian, Beidi Chen, Song Han, Mike Lewis |  | Github Papel |

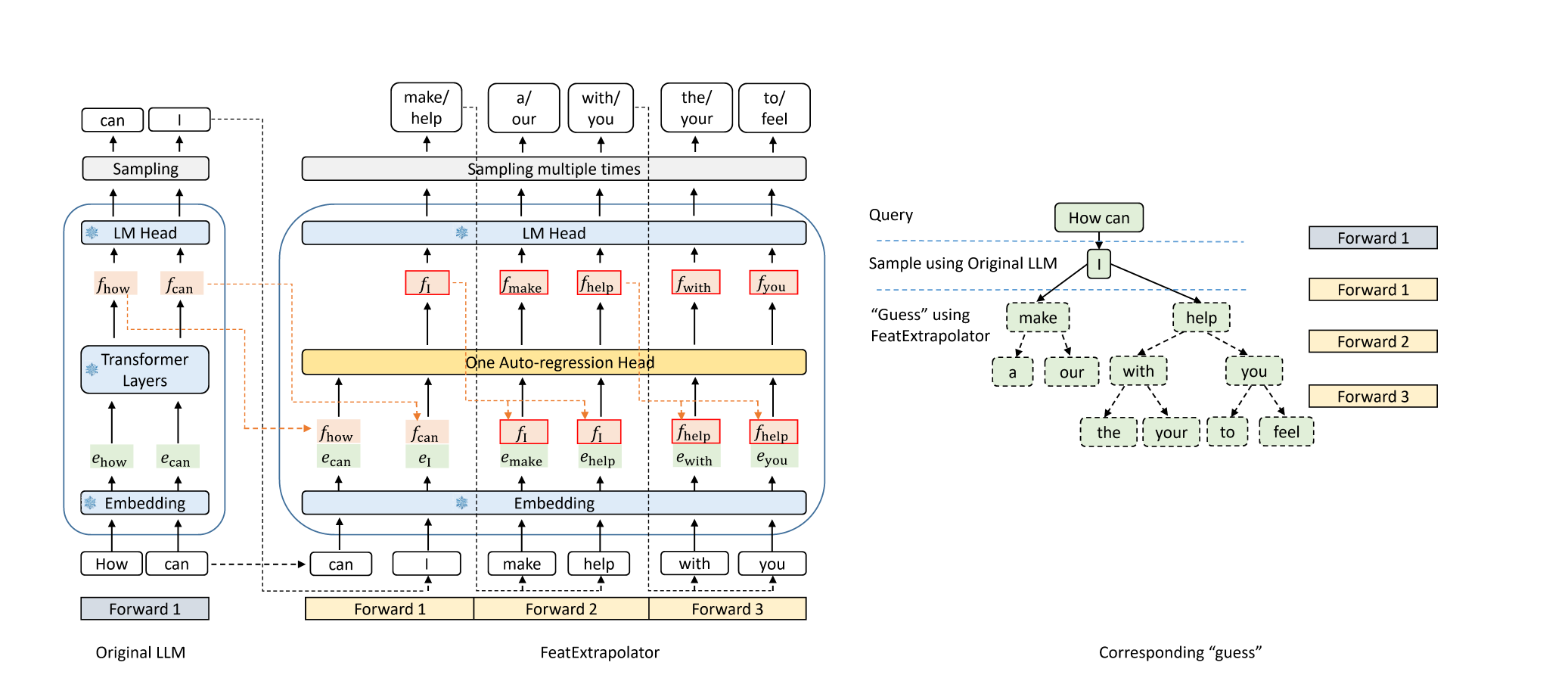

Eagle: Aceleración sin pérdidas de la decodificación de LLM por extrapolación de características Yuhui Li, Chao Zhang y Hongyang Zhang |  | Github Blog |

Medusa: marco de aceleración de inferencia LLM simple con múltiples cabezas de decodificación Tianle Cai, Yuhong Li, Zhengyang Geng, Hongwu Peng, Jason D. Lee, Deming Chen, Tri Dao | Github Papel | |

| Decodificación especulativa con modelo de borrador basado en CTC para la aceleración de inferencia de LLM Zhuofan Wen, Shangtong Gui, Yang Feng | Papel | |

| PLD+: Acelerar la inferencia LLM aprovechando los artefactos del modelo de lenguaje Shwetha Somasundaram, Anirudh Phukan, Apoorv Saxena | Papel | |

FastDraft: cómo entrenar su borrador Ofir Zafrir, Igor Margulis, Dorin Shteyman, Guy Boudoukh | Papel | |

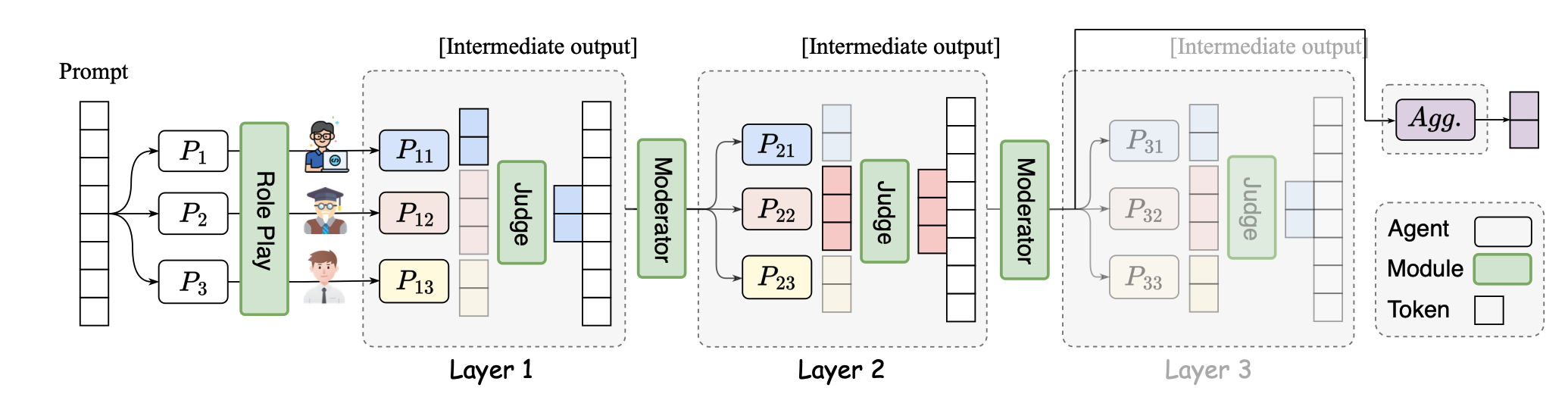

SMOA: Mejora de modelos de idiomas grandes de agentes con una mezcla escasa de los agentes Dawei Li, Zhen Tan, Peijia Qian, Yifan Li, Kumar Satvik Chaudhary, Lijie Hu, Jiayi Shen |  | Github Papel |

| The N-Grammys: Acelerar la inferencia autorregresiva con especulación por lotes sin aprendizaje Lawrence Stewart, Matthew Trager, Sujan Kumar Gonugondla, Stefano Soatto | Papel | |

| Inferencia AI acelerada a través de métodos de ejecución dinámica Haim Barad, Jascha Achterberg, Tien Pei Chou, Jean Yu | Papel | |

| SuffixDecoding: un enfoque sin modelo para acelerar la inferencia de modelos de lenguaje grande Gabriele Oliaro, Zhihao Jia, Daniel Campos, Aurick Qiao | Papel | |

| Planificación de estrategia dinámica para la respuesta de preguntas eficientes con modelos de idiomas grandes Tanmay Parekh, Pradyot Prakash, Alexander Radovic, Akshay Shekher, Denis Savenkov | Papel | |

MagicPig: muestreo LSH para una generación eficiente de LLM Zhuoming Chen, Ranajoy Sadhukhan, Zihao Ye, Yang Zhou, Jianyu Zhang, Niklas Nolte, Yuandong Tian, Matthijs Douze, Leon Botou, Zhihao Jia, Beidi Chen | Github Papel | |

| Modelos de idiomas más rápidos con una mejor predicción múltiple utilizando descomposición tensor Artem Basharin, Andrei Chertkov, Ivan Oseledets |  | Papel |

| Inferencia eficiente para modelos de idiomas grandes aumentados Rana Shahout, Cong Liang, Shiji Xin, Qianru Lao, Yong Cui, Minlan Yu, Michael Mitzenmacher | Papel | |

Poda de vocabulario dinámico en LLM de Elex-Exit Jort Vincenti, Karim Abdel Sadek, Joan Velja, Matteo Nulli, Metod Jazbec |  | Github Papel |

CoreInfer: Acelerar la inferencia del modelo de lenguaje grande con activación dispersa adaptativa inspirada en la semántica Qinsi Wang, Saeed Vahidian, Hancheng Ye, Jianyang GU, Jianyi Zhang, Yiran Chen | Github Papel | |

DuoTentent: inferencia eficiente de larga duración LLM con cabezales de recuperación y transmisión Guangxuan Xiao, Jiaming Tang, Jingwei Zuo, Junxian Guo, Shang Yang, Haotian Tang, Yao Fu, Song Han |  | Github Papel |

| Dyspec: decodificación especulativa más rápida con estructura de árbol token dinámico Yunfan Xiong, Ruoyu Zhang, Yanzeng Li, Tianhao Wu, Lei Zou | Papel | |

| QSPEC: decodificación especulativa con esquemas de cuantificación complementarios Juntao Zhao, Wenhao Lu, Sheng Wang, Lingpeng Kong, Chuan Wu | Papel | |

| TidalDecode: decodificación de LLM rápida y precisa con posición de atención escasa persistente Lijie Yang, Zhihao Zhang, Zhuofu Chen, Zikun Li, Zhihao Jia | Papel | |

| Parallelspec: redactor paralelo para una decodificación especulativa eficiente Zilin Xiao, Hongming Zhang, Tao GE, Siru Ouyang, Vicente Ordonez, Dong Yu | Papel | |

Swift: decodificación autopeculativa sobre la marcha para la aceleración de inferencia de LLM Heming Xia, Yongqi Li, Jun Zhang, Cunxiao Du, Wenjie Li |  | Github Papel |

Turborag: Generación acelerada de recuperación con acompañamiento con cachés de KV precomputados para texto fortado Songshuo Lu, Hua Wang, Yutian Rong, Zhi Chen, Yaohua Tang |  | Github Papel |

| Un poco hace un largo camino: capacitación de contexto e eficiente e inferencia con contextos parciales Suyu GE, Xihui Lin, Yunan Zhang, Jiawei Han, Hao Peng | Papel | |

| Mnemosyne: estrategias de paralelización para servir de manera eficiente las solicitudes de inferencia de longitud de contexto sin aproximaciones sin aproximaciones Amey Agrawal, Junda Chen, íñigo Goiri, Ramachandran Ramjee, Chaojie Zhang, Alexey Tumanov, Esha Choukse | Papel | |

Descubriendo las gemas en las primeras capas: acelerando LLM de contexto largo con 1000X Reducción del token de entrada Zhenmei Shi, Yifei Ming, Xuan-Phi Nguyen, Yingyu Liang, Shafiq Joty | Github Papel | |

| Decodificación del haz especulativo de ancho dinámico para una inferencia de LLM eficiente Zongyue Qin, Zifan He, Neha Prakriya, Jason Cong, Yizhou Sun | Papel | |

CRITIPREFILL: un enfoque basado en la criticidad en el segmento para la aceleración previa a la aceleración en LLMS Junlin LV, Yuan Feng, Xike Xie, Xin Jia, Qirong Peng, Guiming Xie | Github Papel | |

| Recuperación de recuperación: acelerar la inferencia LLM de contexto largo a través de la recuperación de vectores Di Liu, Meng Chen, Baotong Lu, Huiqiang Jiang Jiang, Zhenhua Han, Qianxi Zhang, Qi Chen, Chengruidong Zhang, Bailu Ding, Kai Zhang, Chen Chen, Fan Yang, Yuqing Yang, Lili Qiu | Papel | |

Sirius: escasez contextual con corrección para LLM eficientes Yang Zhou, Zhuoming Chen, Zhaozhuo Xu, Victoria Lin, Beidi Chen | Github Papel | |

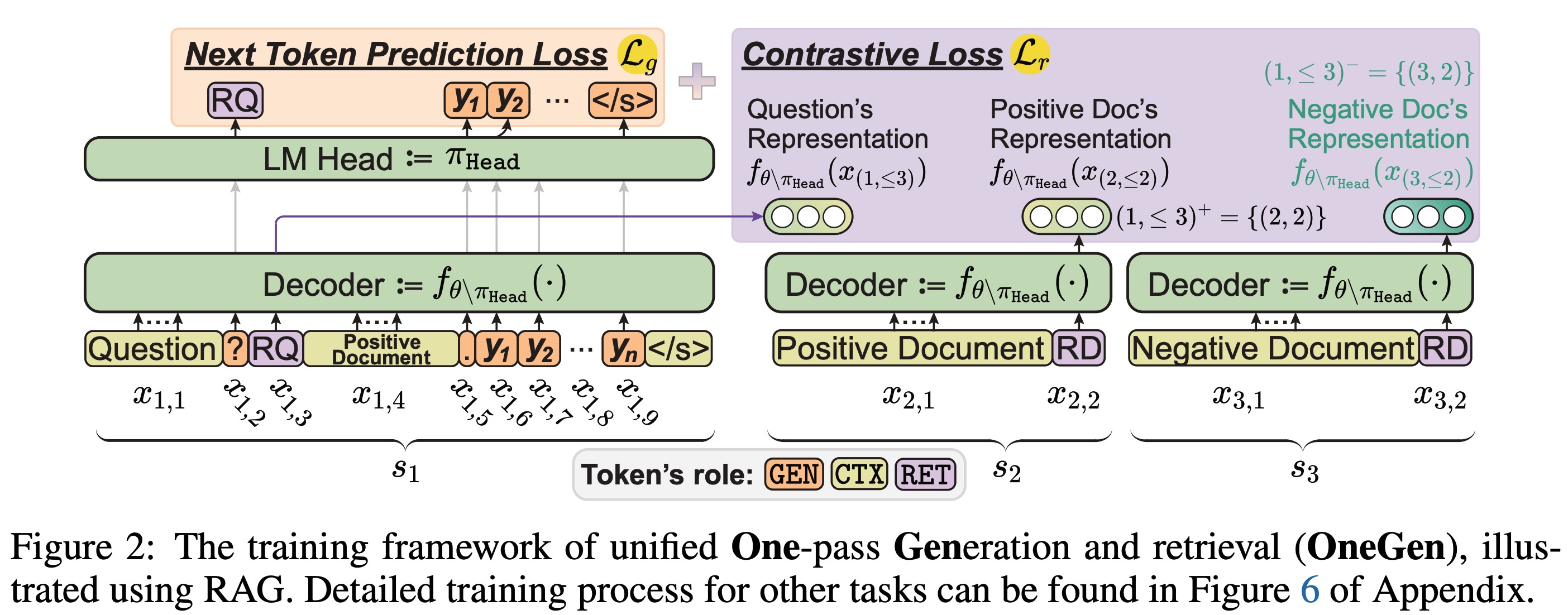

OneGen: generación y recuperación unificadas de un paso eficiente para LLMS Jintian Zhang, Cheng Peng, Mengshu Sun, Xiang Chen, Lei Liang, Zhiqiang Zhang, Jun Zhou, Huajun Chen, Ningyu Zhang |  | Github Papel |

| Consistencia de la ruta: mejora del prefijo para una inferencia eficiente en LLM Jiace Zhu, Yingtao Shen, Jie Zhao, un zou | Papel | |

| Aumento de la decodificación especulativa sin pérdidas mediante muestreo de características y destilación de alineación parcial Lujun Gui, Bin Xiao, Lei Su, Weipeng Chen | Papel |

| Título y autores | Introducción | Campo de golf |

|---|---|---|

Inferencia rápida de los modelos de lenguaje de la mezcla de expertos con descarga Artyom Eliseev, Denis Mazur |  | Github Papel |

Condensar, no solo poda: mejorar la eficiencia y el rendimiento en la poda de capa MOE Mingyu Cao, Gen Li, Jie Ji, Jiaqi Zhang, Xiaolong MA, Shiwei Liu, Lu Yin | Github Papel | |

| Mezcla de expertos en caché para una inferencia eficiente de dispositivos móviles Andrii Skliar, Ties Van Rozendaal, Romain Lepert, Todor Boinovski, Mart Van Baalen, Markus Nagel, Paul Whatmough, Babak Ehteshami Bejnordi | Papel | |

MONTA: Aceleración de la capacitación de la mezcla de expertos con optimización paralela consciente de la red Jingming Guo, Yan Liu, Yu Meng, Zhiwei Tao, Banglan Liu, Gang Chen, Xiang Li | Github Papel | |

MOE-I2: Mezcla de compresión de modelos de expertos a través de la poda interexperima y la descomposición de bajo rango intra-experto Cheng Yang, Yang Sui, Jinqi Xiao, Lingyi Huang, Yu Gong, Yuanlin Duan, Wenqi Jia, Miao Yin, Yu Cheng, Bo Yuan | Github Papel | |

| Hobbit: un sistema de descarga de expertos en precisión mixto para inferencia rápida de MOE Peng Tang, Jiacheng Liu, Xiaofeng Hou, Yifei PU, Jing Wang, Pheng-Ann Heng, Chao Li, Minyi Guo | Papel | |

| PROMOE: Servicio LLM con sede en MOE Fast MOE utilizando almacenamiento en caché Proactive Xiaoniu Song, Zihang Zhong, Rong Chen | Papel | |

| ExpertFlow: activación de expertos optimizada y asignación de tokens para una inferencia eficiente de mezcla de expertos Xin He, Shunkang Zhang, Yuxin Wang, Haiyan Yin, Zihao Zeng, Shaohuai Shi, Zhenheng Tang, Xiaowen Chu, Ivor Tsang, Ong Yew pronto | Papel | |

| EPS-MOE: Programador de tuberías de expertos para la inferencia MOE rentable Yulei Qian, Fengcun Li, Xiangyang Ji, Xiaoyu Zhao, Jiancao Tan, Kefeng Zhang, Xunliang Cai | Papel | |

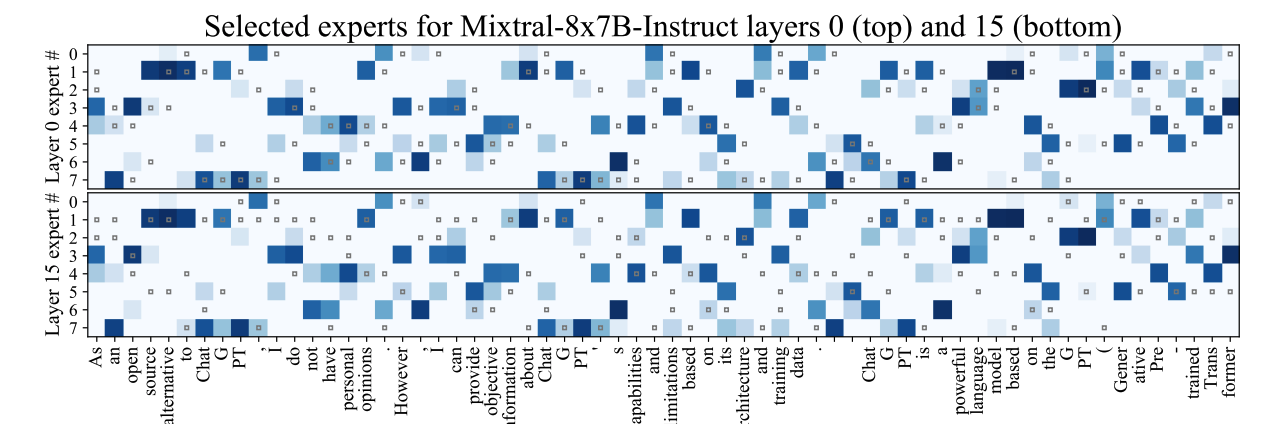

MC-MOE: Compresor de mezcla para la mezcla de expertos en LLMS gana más Wei Huang, Yue Liao, Jianhui Liu, Ruifei He, Haoru Tan, Shiming Zhang, Hongsheng Li, Si Liu, Xiaojuan Qi |  | Github Papel |

| Título y autores | Introducción | Campo de golf |

|---|---|---|

Mobillama: hacia GPT, totalmente transparente preciso y liviano Omkar Thawakar, Ashmal Vayani, Salman Khan, Hisham Cholakal, Rao M. Anwer, Michael Felsberg, Tim Baldwin, Eric P. Xing, Fahad Shahbaz Khan |  | Github Papel Modelo |

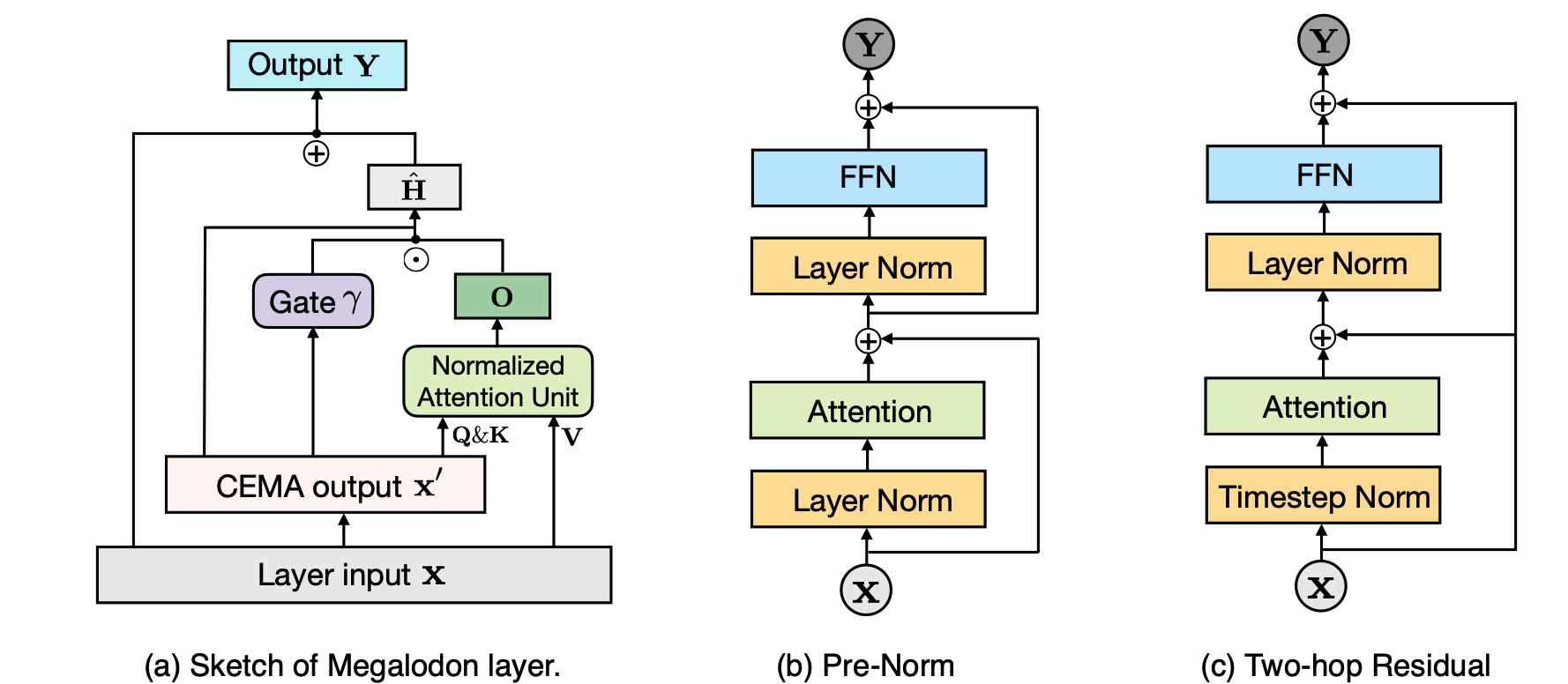

MEGALODON: Eficiente LLM Pretratening e inferencia con una longitud de contexto ilimitado Xuezhe MA, Xiaomeng Yang, Wenhan Xiong, Beidi Chen, Lili Yu, Hao Zhang, Jonathan May, Luke Zettlemoyer, Omer Levy, Chunning Zhou |  | Github Papel |

| Taipan: modelos de lenguaje espacial estatal eficiente y expresivo con atención selectiva Chien Van Nguyen, Huy Huu Nguyen, Thang M. Pham, Ruiyi Zhang, Hanieh Deilamsalehy, Puneet Mathur, Ryan A. Rossi, Trung Bui, Viet Dac Lai, Franck Dernoncourt, Thien Huu Nguyen | Papel | |

SEERATENCIÓN: Aprender atención intrínseca escasa en sus LLMS Yizhao Gao, Zhichen Zeng, Dayou du, Shijie Cao, Hayden Kwok-jay So, Ting Cao, Fan Yang, Mao Yang | Github Papel | |

Compartir bases: compartir parámetros de capas cruzadas para compresión del modelo de idioma grande Jingcun Wang, Yu-Guang Chen, Ing-Chao Lin, Bing Li, Grace Li Zhang | Github Papel | |

| Rodimus*: Rompiendo la compensación de la eficiencia de precisión con atenciones eficientes Zhihao He, Hang Yu, Zi Gong, Shizhan Liu, Jianguo Li, Weiyao Lin | Papel |

| Título y autores | Introducción | Campo de golf |

|---|---|---|

| El modelo le dice qué descartar: compresión adaptativa de caché de KV para LLMS Suyu GE, Yunan Zhang, Liyuan Liu, Minjia Zhang, Jiawei Han, Jianfeng Gao |  | Papel |

| Clusterkv: manipulación de caché LLM KV en un espacio semántico para la compresión recordable Guangda Liu, Chengwei Li, Jieru Zhao, Chenqi Zhang, Minyi Guo | Papel | |

| Unificación de la compresión de caché de KV para modelos de idiomas grandes con LeanKV Yanqi Zhang, Yuwei Hu, Runyuan Zhao, John CS Lui, Haibo Chen | Papel | |

| Compresión de caché KV para inferencia LLM de contexto largo con similitud de atención entre capas Da MA, Lu Chen, Situo Zhang, Yuxun Miao, Su Zhu, Zhi Chen, Hongshen Xu, Hanqi Li, Shuai Fan, Lei Pan, Kai Yu | Papel | |

| MINIKV: Presionando los límites de la inferencia LLM a través de un caché de KV discriminativo de 2 bits Akshat Sharma, Hangliang Ding, Jianping Li, Neel Dani, Minjia Zhang | Papel | |

| TokenSelect: Extrapolación eficiente de inferencia y longitud de largo contexto para LLM a través de la selección dinámica de caché de KV a nivel de token Wei Wu, Zhuoshi Pan, Chao Wang, Liyi Chen, Yunchu Bai, Kun Fu, Zheng Wang, Hui Xiong | Papel | |

No todas las cabezas son importantes: un método de compresión de caché KV de nivel principal con recuperación y razonamiento integrados Yu Fu, Zefan Cai, Abedelkadir Asi, Wayne Xiong, Yue Dong, Wen Xiao |  | Github Papel |

Buzz: caché de KV disperso estructurado con colmena con bateadores pesados segmentados para una inferencia de LLM eficiente Junqi Zhao, Zhijin Fang, Shu Li, Shaohui Yang, Shichao él | Github Papel | |

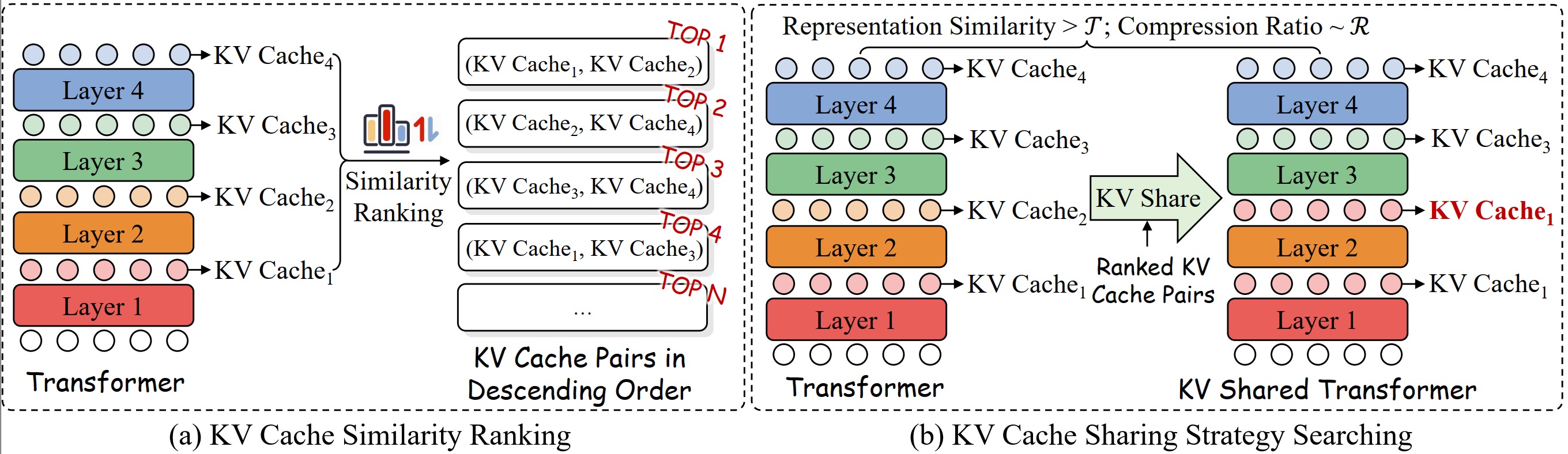

Un estudio sistemático del intercambio de KV de capa cruzada para una inferencia de LLM eficiente Tu wu, haoyi wu, kewei tu |  | Github Papel |

| Compresión de caché de KV sin pérdidas al 2% Zhen Yang, Jnhan, Kan Wu, Ruobing Xie, An Wang, Xingwu Sun, Zhanhui Kang | Papel | |

| Matryoshkakv: compresión adaptativa de KV a través de una proyección ortogonal entrenable Bokai Lin, Zihao Zeng, Zipeng Xiao, Siqi Kou, Tianqi Hou, Xiaofeng Gao, Hao Zhang, Zhijie Deng | Papel | |

Cuantización vectorial residual para compresión de caché de KV en un modelo de lenguaje grande Ankur Kumar | Github Papel | |

KVSHARER: Inferencia eficiente a través de la capa de caché de KV diferente de la capa. Yifei Yang, Zouying Cao, Qiguang Chen, Libo Qin, Dongjie Yang, Hai Zhao, Zhi Chen |  | Github Papel |

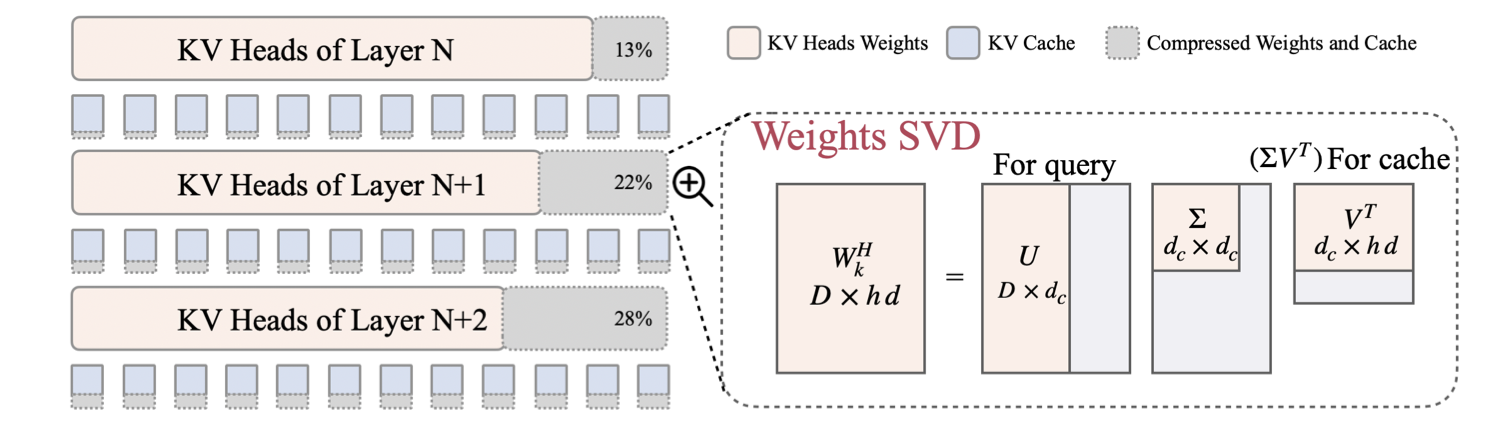

| LORC: compresión de bajo rango para caché de KV LLMS con una estrategia de compresión progresiva Rongzhi Zhang, Kuang Wang, Liyuan Liu, Shuohang Wang, Hao Cheng, Chao Zhang, Yelong Shen |  | Papel |

| SWIFTKV: inferencia rápida optimizada con anticipación con la transformación del modelo que presenta el conocimiento Aurick Qiao, Zhewei Yao, Samyam Rajbhandari, yuxiong él | Papel | |

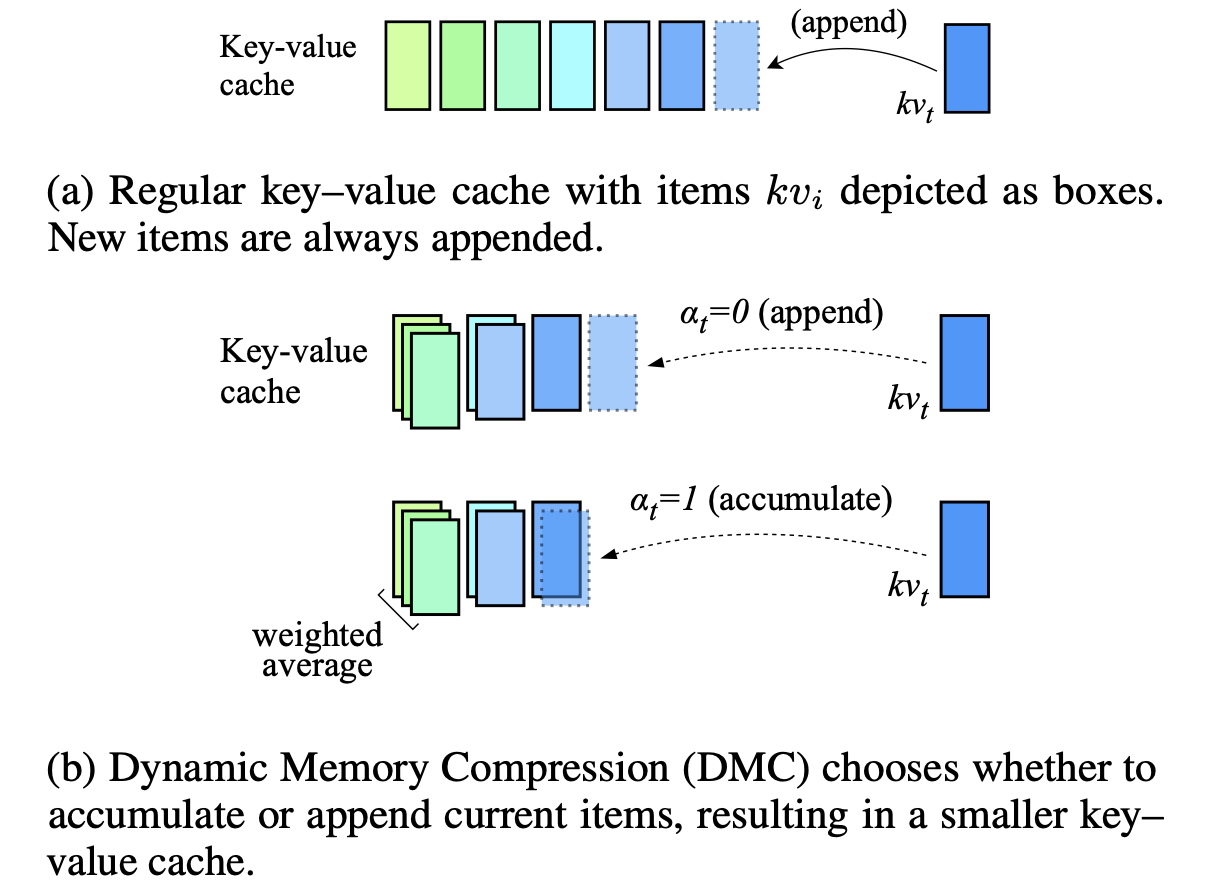

Compresión de memoria dinámica: modernización de LLM para inferencia acelerada Piotr Nawrot, Adrian łańcucki, Marcin Chhowski, David Tarjan, Edoardo M. Ponti |  | Papel |

| KV-Compress: compresión de KV-Cache con tasas de compresión variables por cabeza Isaac rehg | Papel | |

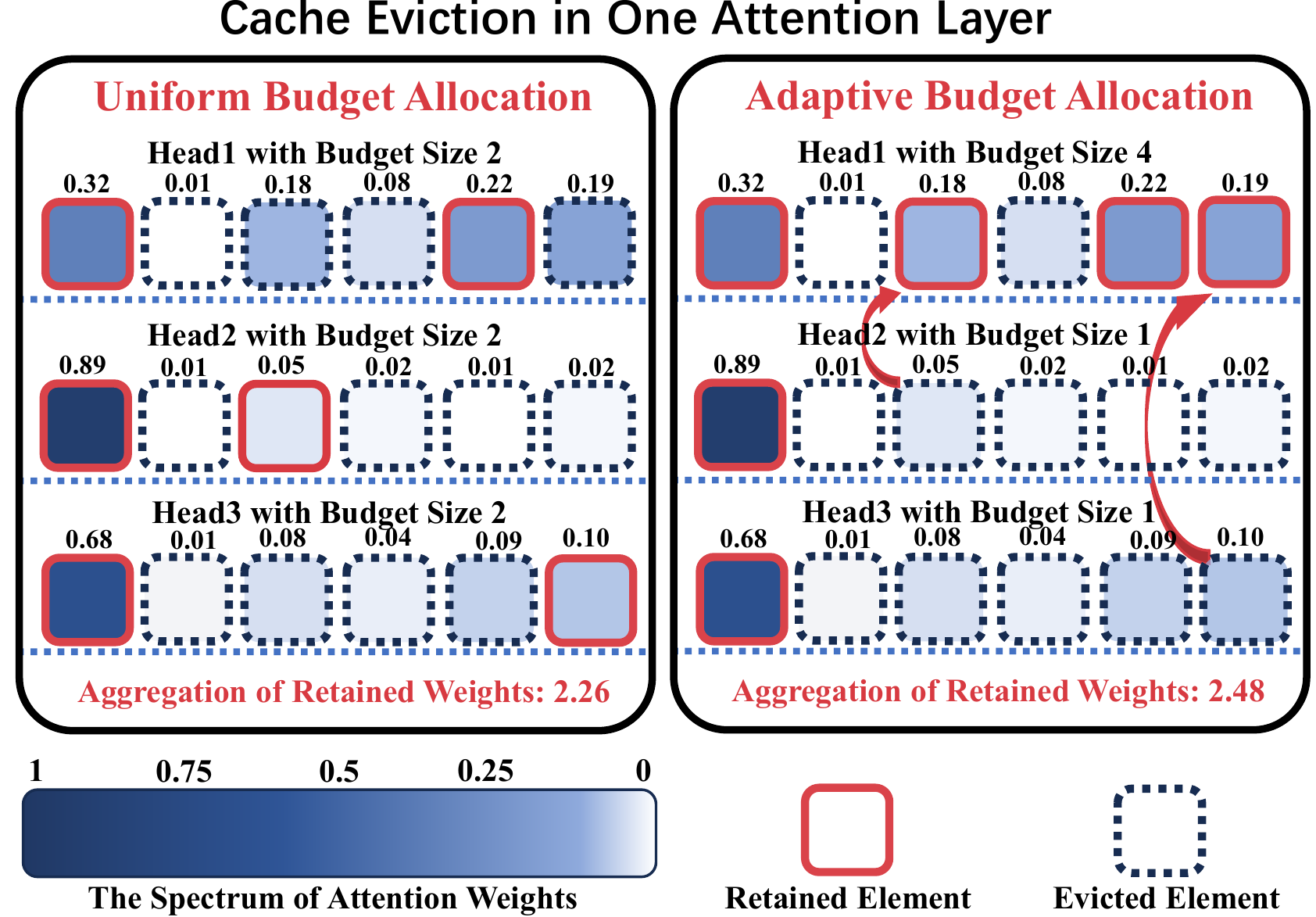

ADA-KV: Optimización del desalojo de caché de KV por asignación de presupuesto adaptativo para una inferencia de LLM eficiente Yuan Feng, Junlin LV, Yukun Cao, Xike Xie, S. Kevin Zhou |  | Github Papel |

AlignedKV: Reducción del acceso a la memoria de KV-Cache con cuantización alineada con precisión Yifan Tan, Haoze Wang, Chao Yan, Yangdong Deng | Github Papel | |

| CSKV: Controlación de canales eficientes en entrenamiento para caché de KV en escenarios de contexto largo Luning Wang, Shiyao Li, Xuefei Ning, Zhihang Yuan, Shengen Yan, Guohao Dai, Yu Wang | Papel | |

| Un primer vistazo a la inferencia LLM eficiente y segura en el dispositivo contra la fuga de KV Huan Yang, Deyu Zhang, Yudong Zhao, Yuanchun Li, Yunxin Liu | Papel |

| Título y autores | Introducción | Campo de golf |

|---|---|---|

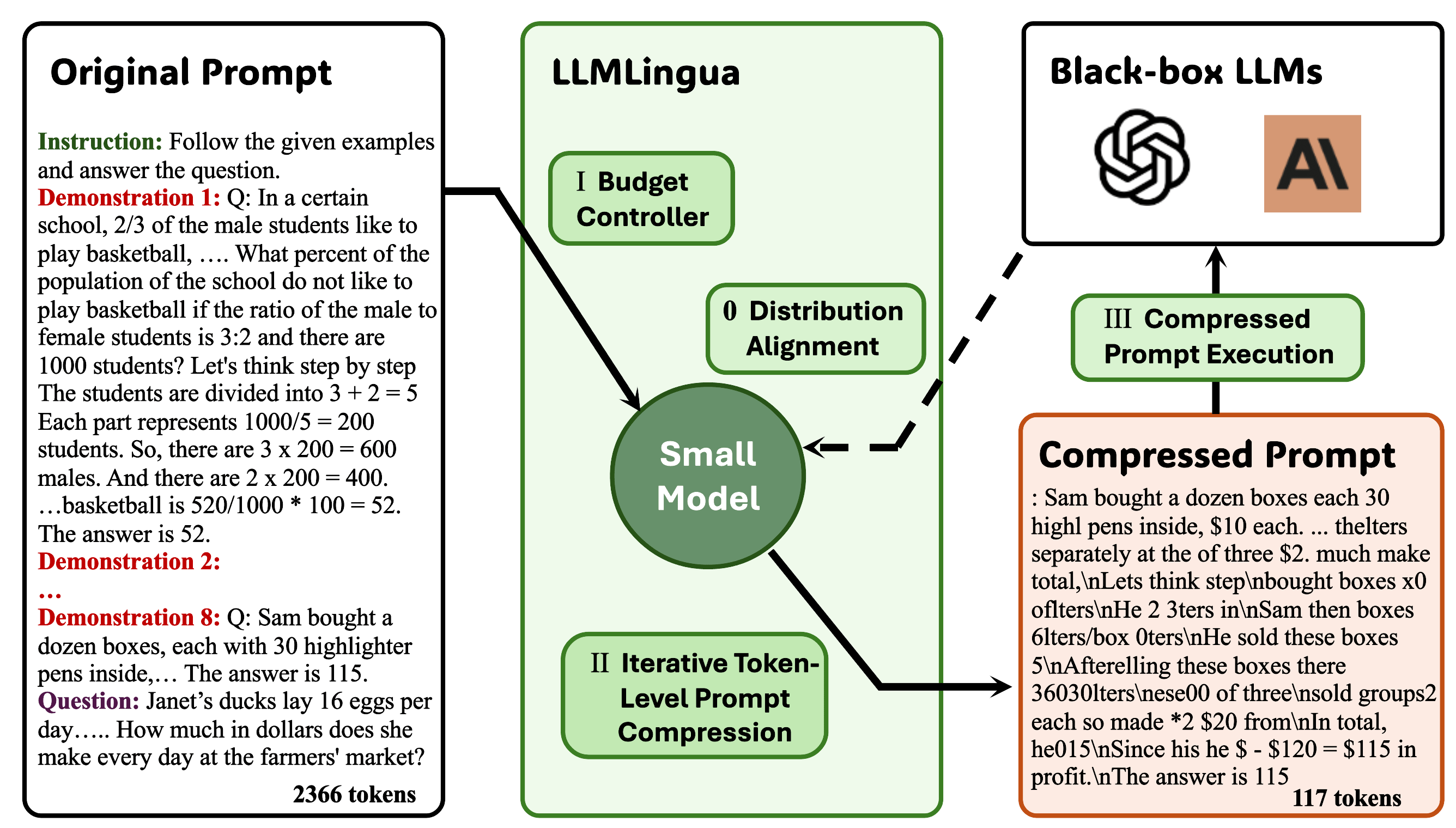

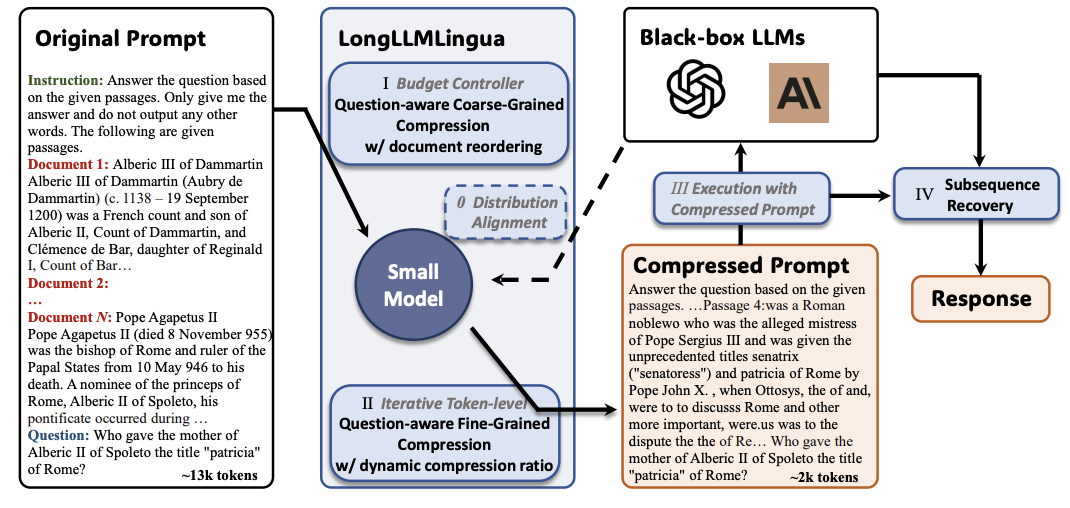

Llmlingua: indicaciones de comprimir para la inferencia acelerada de modelos de idiomas grandes Huiqiang Jiang, Qianhui Wu, Chin-Yew Lin, Yuqing Yang, Lili Qiu |  | Github Papel |

Longllmlingua: Acelerar y mejorar LLM en escenarios de contexto largo a través de una compresión rápida Huiqiang Jiang, Qianhui Wu, Xufang Luo, Dongsheng Li, Chin-Yew Lin, Yuqing Yang, Lili Qiu |  | Github Papel |

| JPO: potencia conjunta y optimización rápida para servicios de modelos de lenguaje grande acelerado Feiran You, Hongyang Du, Kaibin Huang, Abbas Jamalipour | Papel | |

Destilación de contexto generativo Haebin Shin, Lei Ji, Yeyun Gong, Sungdong Kim, Eunbi Choi, Minjoon Seo |  | Github Papel |

MultITOK: Tokenización de longitud variable para LLM eficientes adaptados de la compresión LZW Noel Elias, Homa Esfahanizadeh, Kaan Kale, Sriram Vishwanath, Muriel Medard | Github Papel | |

Selección-P: compresión rápida de tarea auto-supervisada para la fidelidad y la transferibilidad Tsz Ting Chung, Leyang Cui, Lemao Liu, Xinting Huang, Shuming Shi, Dit-Yan Yeung | Papel | |

Desde la lectura hasta la compresión: explorar el lector de múltiples documentos para la compresión rápida Eunseong Choi, Sunkyung Lee, Minjin Choi, June Park, Jongwuk Lee | Papel | |

| Compresor de percepción: un método de compresión inmediata sin entrenamiento en largos escenarios de contexto Jiwei Tang, Jin Xu, Tingwei Lu, Hai Lin, Yiming Zhao, Hai-Tao Zheng | Papel | |

FINEZIP: empujando los límites de los modelos de lenguaje grande para la compresión práctica de texto sin pérdidas sin pérdidas Fazal Mittu, Yihuan Bu, Akshat Gupta, Ashok Devireddy, Alp Eren Ozdarendeli, Anant Singh, Gopala Anumanchipalli | Github Papel | |

Paneos guiados guiados LLM Compresión rápida Wenhao Mao, Chengbin Hou, Tianyu Zhang, Xinyu Lin, Ke Tang, Hairong LV | Github Papel | |

Alphazip: compresión de texto sin pérdidas con redes neuronales con redes neuronales Swathi Shree Narashiman, Nitin Chandrachoodan | Github Papel | |

| Taco-RL: Optimización de compresión rápida consciente de la tarea con aprendizaje de refuerzo Shivam Shandilya, Menglin Xia, Supriyo Ghosh, Huiqiang Jiang, Jue Zhang, Qianhui Wu, Victor Rühle | Papel | |

| Destilación de contexto eficiente de LLM Rajesh Upadhayayaya, Zachary Smith, Chritopher Kottmyer, Manish Raj Osti | Papel | |

Mejorar y acelerar modelos de lenguaje grande a través de la compresión contextual consciente de las instrucciones Haowen Hou, Fei MA, Binwen Bai, Xinxin Zhu, Fei Yu | Github Papel |

| Título y autores | Introducción | Campo de golf |

|---|---|---|

En abundancia natural: acelerar en abundancia para el entrenamiento de LLM y ajuste de memoria. Arijit das | Github Papel | |

| Compacto: activaciones comprimidas para el entrenamiento LLM de eficiencia de memoria Yara Shamshoum, Nitzan Hodos, Yuval Sieradzki, Assaf Schuster | Papel | |

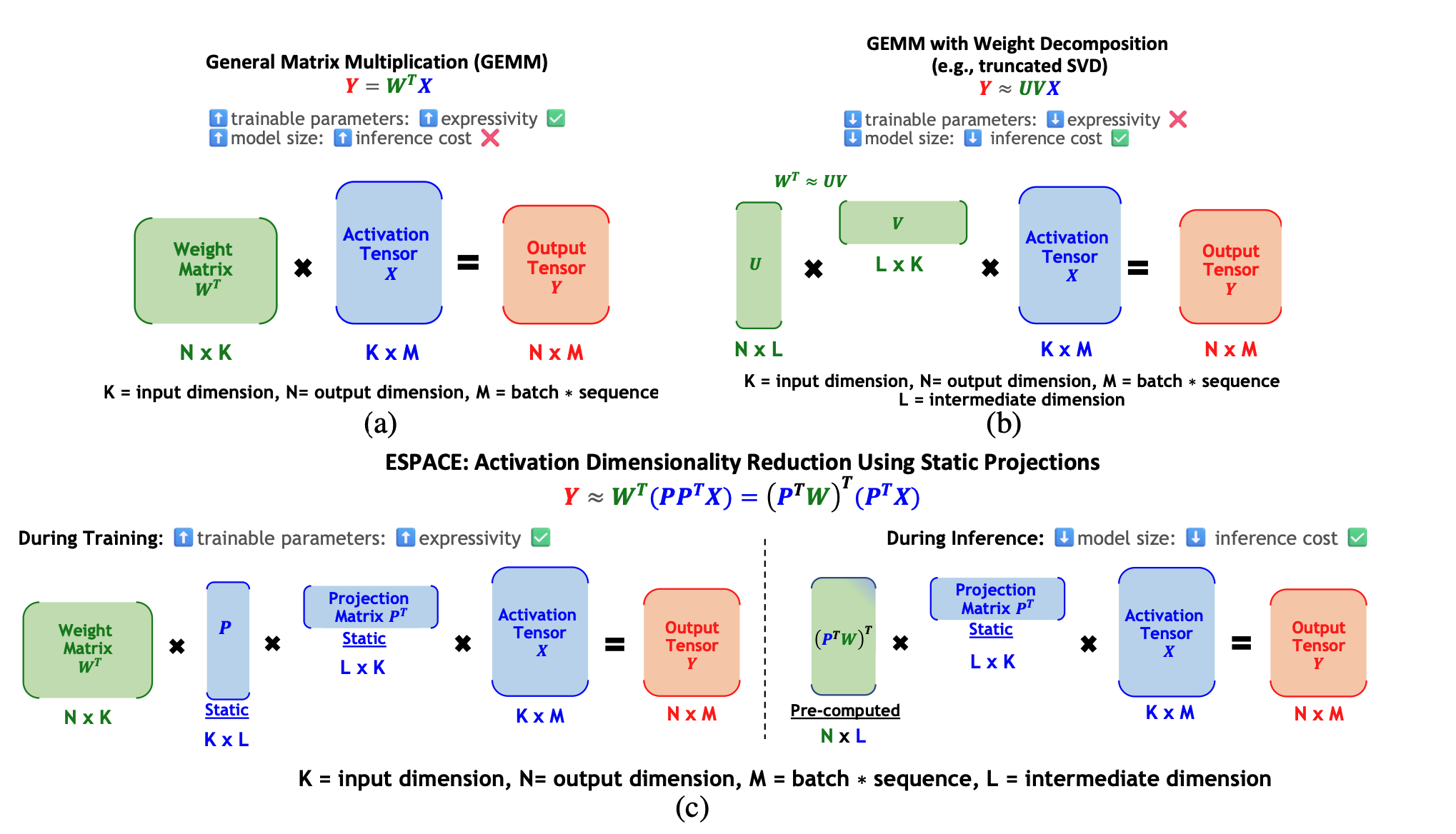

Espace: Dimensionalidad Reducción de activaciones para la compresión del modelo Charbel Sakr, Brucek Khailany |  | Papel |

| Título y autores | Introducción | Campo de golf |

|---|---|---|

| Fast Switch: optimización de la eficiencia del cambio de contexto en la seriedad Ao Shen, Zhiyao Li, Mingyu Gao | Papel | |

| CELM CELM: modelos de lenguaje grande eficientes y adaptativos a través de la colaboración de borde de la nube Hongpeng Jin, Yanzhao Wu | Papel | |

| Ripple: Acelerar la inferencia de LLM en teléfonos inteligentes con el manejo de neuronas conscientes de la correlación Tuowei Wang, Fan de Ruwen, Minxing Huang, Zixu Hao, Kun Li, Ting Cao, Youyu Lu, Yaoxue Zhang, Ju Ren | Papel | |

ALISE: Accelerating Large Language Model Serving with Speculative Scheduling Youpeng Zhao, Jun Wang | Papel | |

| EPIC: Efficient Position-Independent Context Caching for Serving Large Language Models Junhao Hu, Wenrui Huang, Haoyi Wang, Weidong Wang, Tiancheng Hu, Qin Zhang, Hao Feng, Xusheng Chen, Yizhou Shan, Tao Xie | Papel | |

SDP4Bit: Toward 4-bit Communication Quantization in Sharded Data Parallelism for LLM Training Jinda Jia, Cong Xie, Hanlin Lu, Daoce Wang, Hao Feng, Chengming Zhang, Baixi Sun, Haibin Lin, Zhi Zhang, Xin Liu, Dingwen Tao | Papel | |

| FastAttention: Extend FlashAttention2 to NPUs and Low-resource GPUs Haoran Lin, Xianzhi Yu, Kang Zhao, Lu Hou, Zongyuan Zhan et al | Papel | |

| POD-Attention: Unlocking Full Prefill-Decode Overlap for Faster LLM Inference Aditya K Kamath, Ramya Prabhu, Jayashree Mohan, Simon Peter, Ramachandran Ramjee, Ashish Panwar | Papel | |

TPI-LLM: Serving 70B-scale LLMs Efficiently on Low-resource Edge Devices Zonghang Li, Wenjiao Feng, Mohsen Guizani, Hongfang Yu | Github Papel | |

Efficient Arbitrary Precision Acceleration for Large Language Models on GPU Tensor Cores Shaobo Ma, Chao Fang, Haikuo Shao, Zhongfeng Wang | Papel | |

OPAL: Outlier-Preserved Microscaling Quantization A ccelerator for Generative Large Language Models Jahyun Koo, Dahoon Park, Sangwoo Jung, Jaeha Kung | Papel | |

| Accelerating Large Language Model Training with Hybrid GPU-based Compression Lang Xu, Quentin Anthony, Qinghua Zhou, Nawras Alnaasan, Radha R. Gulhane, Aamir Shafi, Hari Subramoni, Dhabaleswar K. Panda | Papel |

| Title & Authors | Introducción | Campo de golf |

|---|---|---|

| HELENE: Hessian Layer-wise Clipping and Gradient Annealing for Accelerating Fine-tuning LLM with Zeroth-order Optimization Huaqin Zhao, Jiaxi Li, Yi Pan, Shizhe Liang, Xiaofeng Yang, Wei Liu, Xiang Li, Fei Dou, Tianming Liu, Jin Lu | Papel | |

Robust and Efficient Fine-tuning of LLMs with Bayesian Reparameterization of Low-Rank Adaptation Ayan Sengupta, Vaibhav Seth, Arinjay Pathak, Natraj Raman, Sriram Gopalakrishnan, Tanmoy Chakraborty | Github Papel | |

MiLoRA: Efficient Mixture of Low-Rank Adaptation for Large Language Models Fine-tuning Jingfan Zhang, Yi Zhao, Dan Chen, Xing Tian, Huanran Zheng, Wei Zhu | Papel | |

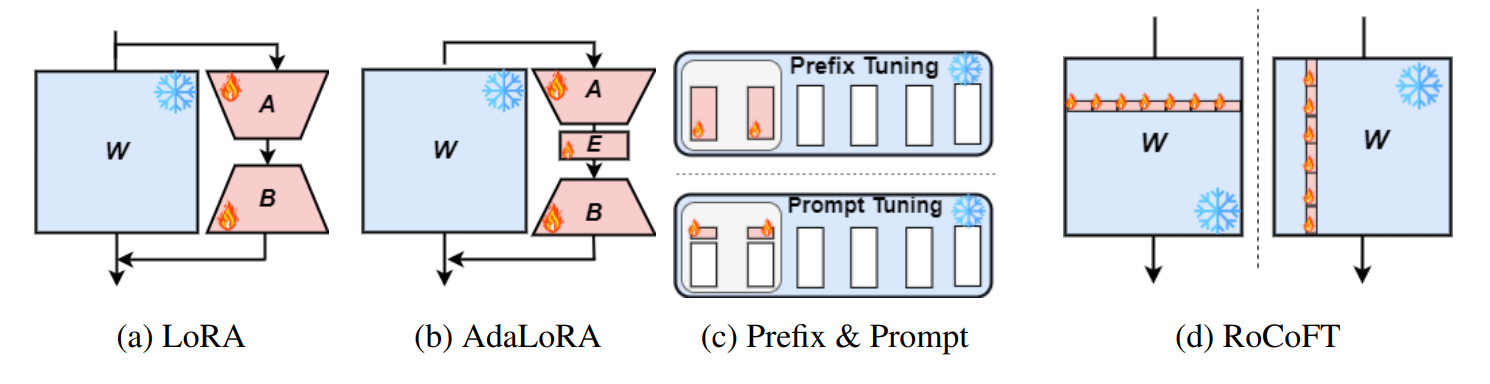

RoCoFT: Efficient Finetuning of Large Language Models with Row-Column Updates Md Kowsher, Tara Esmaeilbeig, Chun-Nam Yu, Mojtaba Soltanalian, Niloofar Yousefi |  | Github Papel |

Layer-wise Importance Matters: Less Memory for Better Performance in Parameter-efficient Fine-tuning of Large Language Models Kai Yao, Penlei Gao, Lichun Li, Yuan Zhao, Xiaofeng Wang, Wei Wang, Jianke Zhu | Github Papel | |

Parameter-Efficient Fine-Tuning of Large Language Models using Semantic Knowledge Tuning Nusrat Jahan Prottasha, Asif Mahmud, Md. Shohanur Islam Sobuj, Prakash Bhat, Md Kowsher, Niloofar Yousefi, Ozlem Ozmen Garibay | Papel | |

QEFT: Quantization for Efficient Fine-Tuning of LLMs Changhun Lee, Jun-gyu Jin, Younghyun Cho, Eunhyeok Park | Github Papel | |

BIPEFT: Budget-Guided Iterative Search for Parameter Efficient Fine-Tuning of Large Pretrained Language Models Aofei Chang, Jiaqi Wang, Han Liu, Parminder Bhatia, Cao Xiao, Ting Wang, Fenglong Ma | Github Papel | |

SparseGrad: A Selective Method for Efficient Fine-tuning of MLP Layers Viktoriia Chekalina, Anna Rudenko, Gleb Mezentsev, Alexander Mikhalev, Alexander Panchenko, Ivan Oseledets | Github Papel | |

| SpaLLM: Unified Compressive Adaptation of Large Language Models with Sketching Tianyi Zhang, Junda Su, Oscar Wu, Zhaozhuo Xu, Anshumali Shrivastava | Papel | |

Bone: Block Affine Transformation as Parameter Efficient Fine-tuning Methods for Large Language Models Jiale Kang | Github Papel | |

| Enabling Resource-Efficient On-Device Fine-Tuning of LLMs Using Only Inference Engines Lei Gao, Amir Ziashahabi, Yue Niu, Salman Avestimehr, Murali Annavaram |  | Papel |

| Title & Authors | Introducción | Campo de golf |

|---|---|---|

| AutoMixQ: Self-Adjusting Quantization for High Performance Memory-Efficient Fine-Tuning Changhai Zhou, Shiyang Zhang, Yuhua Zhou, Zekai Liu, Shichao Weng |  | Papel |

Scalable Efficient Training of Large Language Models with Low-dimensional Projected Attention Xingtai Lv, Ning Ding, Kaiyan Zhang, Ermo Hua, Ganqu Cui, Bowen Zhou | Github Papel | |

| Less is More: Extreme Gradient Boost Rank-1 Adaption for Efficient Finetuning of LLMs Yifei Zhang, Hao Zhu, Aiwei Liu, Han Yu, Piotr Koniusz, Irwin King | Papel | |

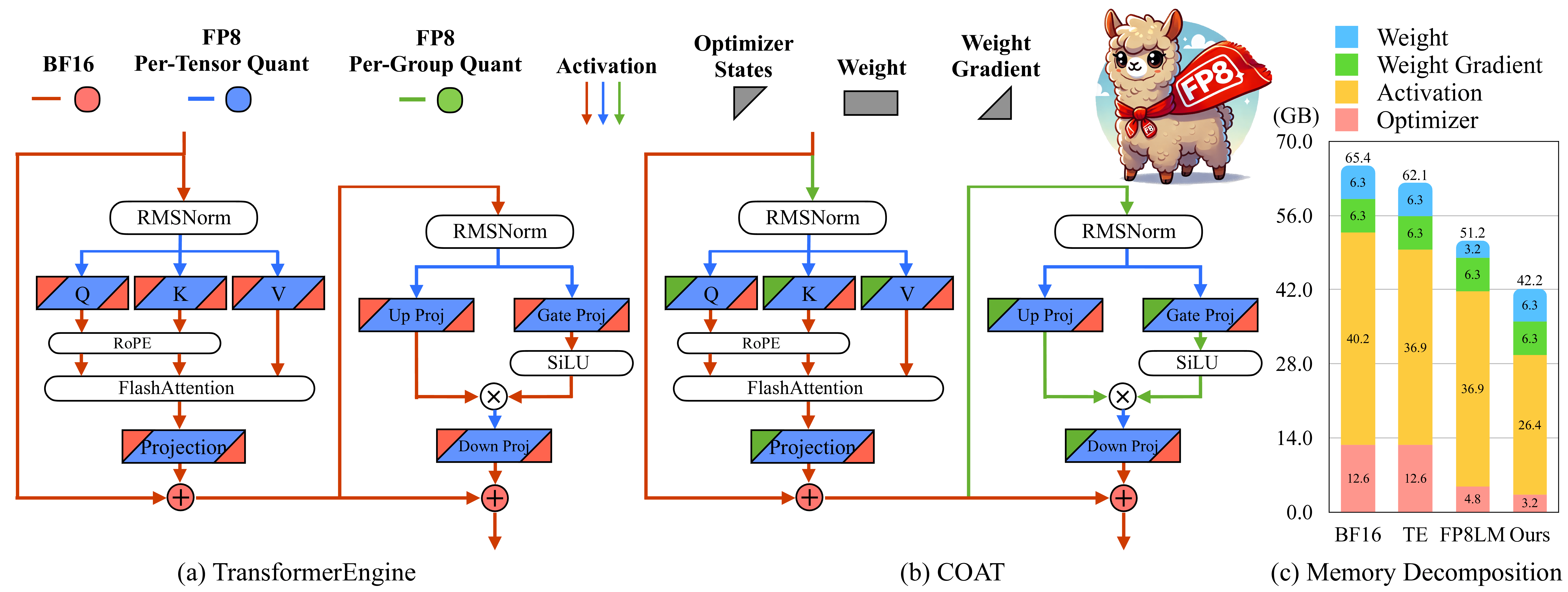

COAT: Compressing Optimizer states and Activation for Memory-Efficient FP8 Training Haocheng Xi, Han Cai, Ligeng Zhu, Yao Lu, Kurt Keutzer, Jianfei Chen, Song Han |  | Github Papel |

BitPipe: Bidirectional Interleaved Pipeline Parallelism for Accelerating Large Models Training Houming Wu, Ling Chen, Wenjie Yu |  | Github Papel |

| Title & Authors | Introducción | Campo de golf |

|---|---|---|

| Closer Look at Efficient Inference Methods: A Survey of Speculative Decoding Hyun Ryu, Eric Kim | Papel | |

LLM-Inference-Bench: Inference Benchmarking of Large Language Models on AI Accelerators Krishna Teja Chitty-Venkata, Siddhisanket Raskar, Bharat Kale, Farah Ferdaus et al | Github Papel | |

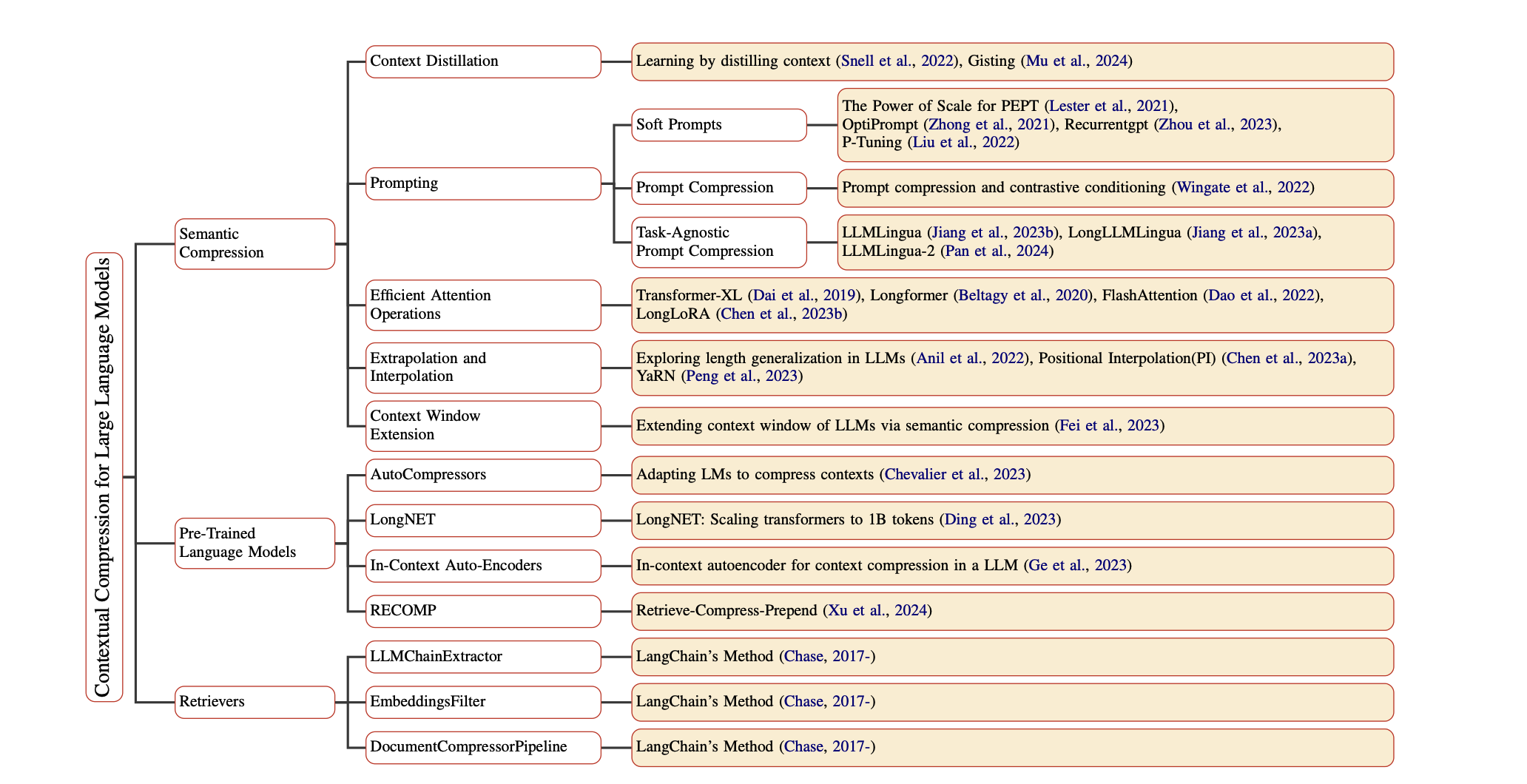

Prompt Compression for Large Language Models: A Survey Zongqian Li, Yinhong Liu, Yixuan Su, Nigel Collier | Github Papel | |

| Large Language Model Inference Acceleration: A Comprehensive Hardware Perspective Jinhao Li, Jiaming Xu, Shan Huang, Yonghua Chen, Wen Li, Jun Liu, Yaoxiu Lian, Jiayi Pan, Li Ding, Hao Zhou, Guohao Dai | Papel | |

| A Survey of Low-bit Large Language Models: Basics, Systems, and Algorithms Ruihao Gong, Yifu Ding, Zining Wang, Chengtao Lv, Xingyu Zheng, Jinyang Du, Haotong Qin, Jinyang Guo, Michele Magno, Xianglong Liu | Papel | |

Contextual Compression in Retrieval-Augmented Generation for Large Language Models: A Survey Sourav Verma |  | Github Papel |

| Art and Science of Quantizing Large-Scale Models: A Comprehensive Overview Yanshu Wang, Tong Yang, Xiyan Liang, Guoan Wang, Hanning Lu, Xu Zhe, Yaoming Li, Li Weitao | Papel | |

| Hardware Acceleration of LLMs: A comprehensive survey and comparison Nikoletta Koilia, Christoforos Kachris | Papel | |

| A Survey on Symbolic Knowledge Distillation of Large Language Models Kamal Acharya, Alvaro Velasquez, Houbing Herbert Song | Papel |