Awesome Efficient LLM

1.0.0

Eine kuratierte Liste für effiziente Großsprachmodelle

Wenn Sie Ihr Papier einfügen möchten oder Details wie Konferenzinformationen oder Code -URLs aktualisieren müssen, können Sie eine Pull -Anfrage senden. Sie können das erforderliche Markdown -Format für jedes Papier erstellen, indem Sie die Informationen in generate_item.py ausfüllen und python generate_item.py ausführen. Wir schätzen Ihre Beiträge zu dieser Liste herzlich. Alternativ können Sie mir die Links zu Ihrem Papier und Ihrem Code per E -Mail senden, und ich würde Ihr Papier in meiner frühesten Bequemlichkeit zur Liste hinzufügen.

Für jedes Thema haben wir eine Liste empfohlener Papiere zusammengestellt, die viele Github -Sterne oder -zitate erhalten haben.

| Titel & Autoren | Einführung | Links |

|---|---|---|

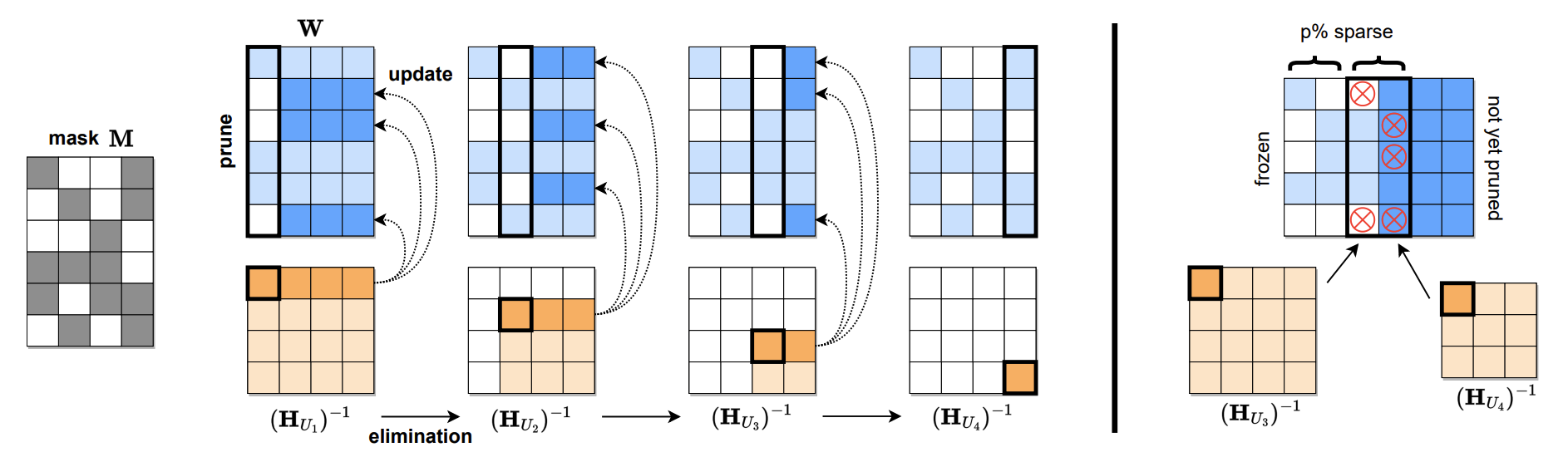

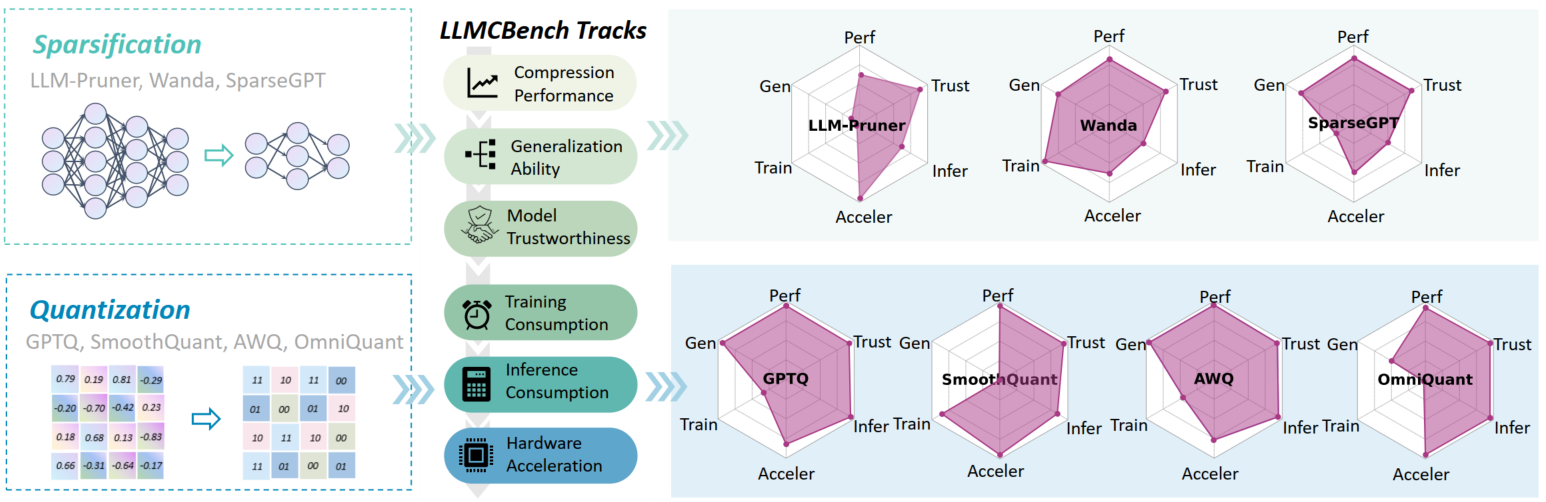

Sparsegpt: Massive Sprachmodelle können in One-Shot genau beschnitten werden Elias Frantar, Dan Alistarh |  | Github -Papier |

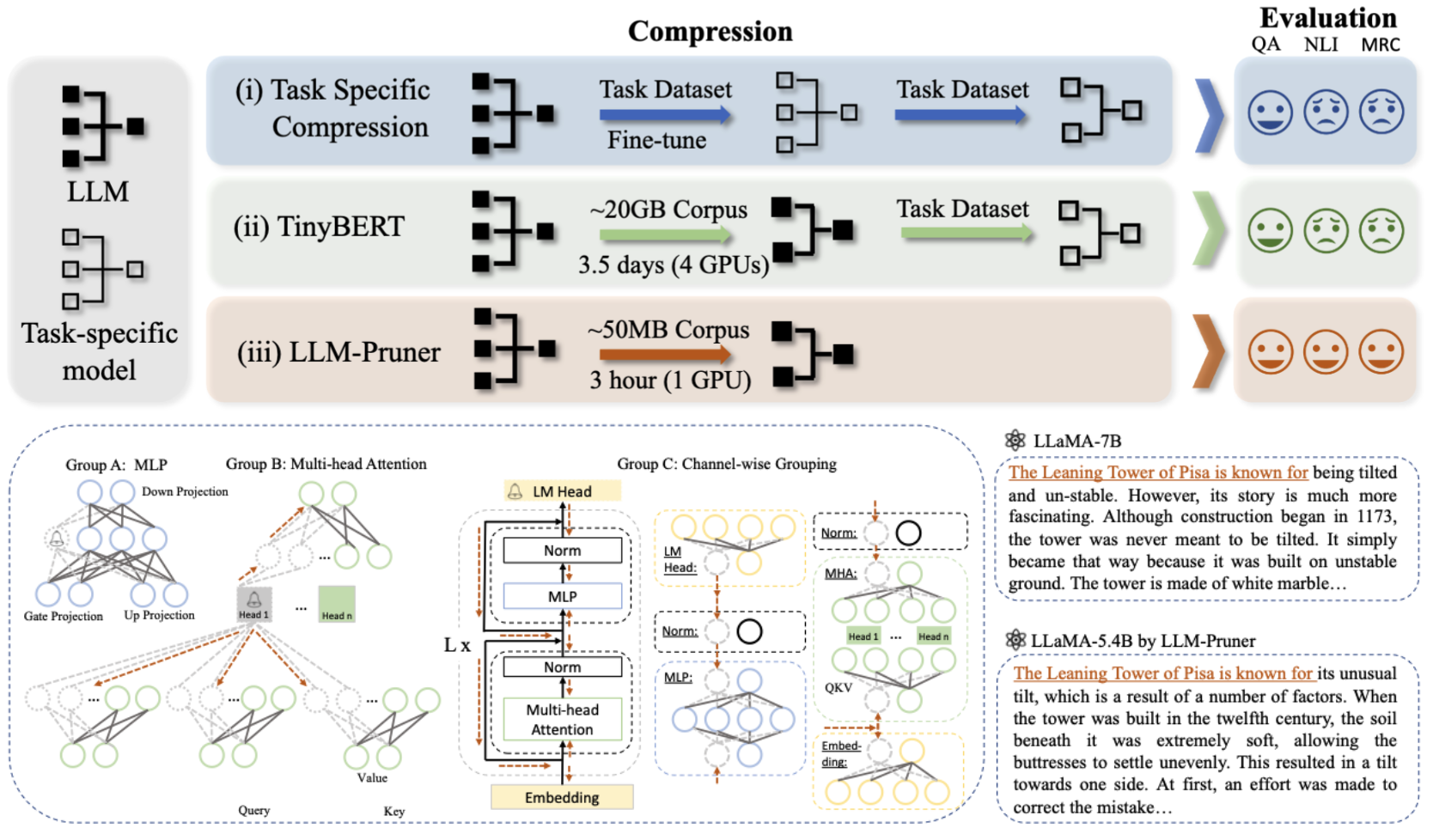

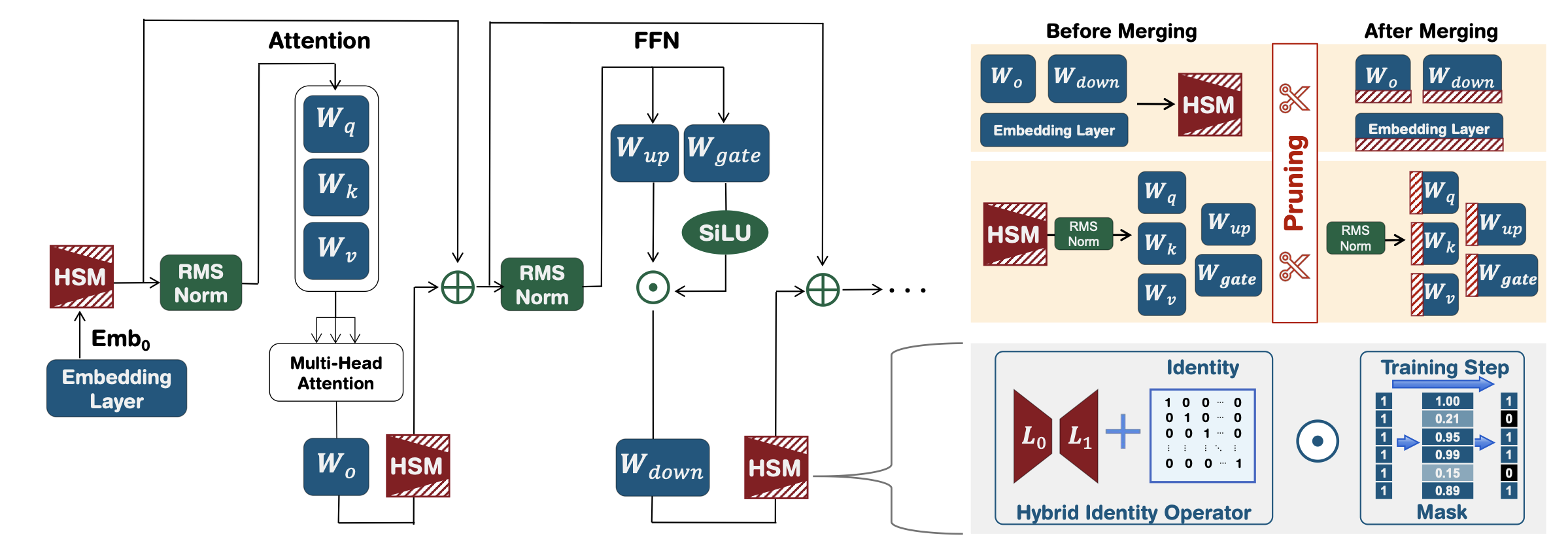

LLM-Pruner: Über das strukturelle Beschneiden großer Sprachmodelle Xinyin MA, Gongfan Fang, Xinchao Wang |  | Github -Papier |

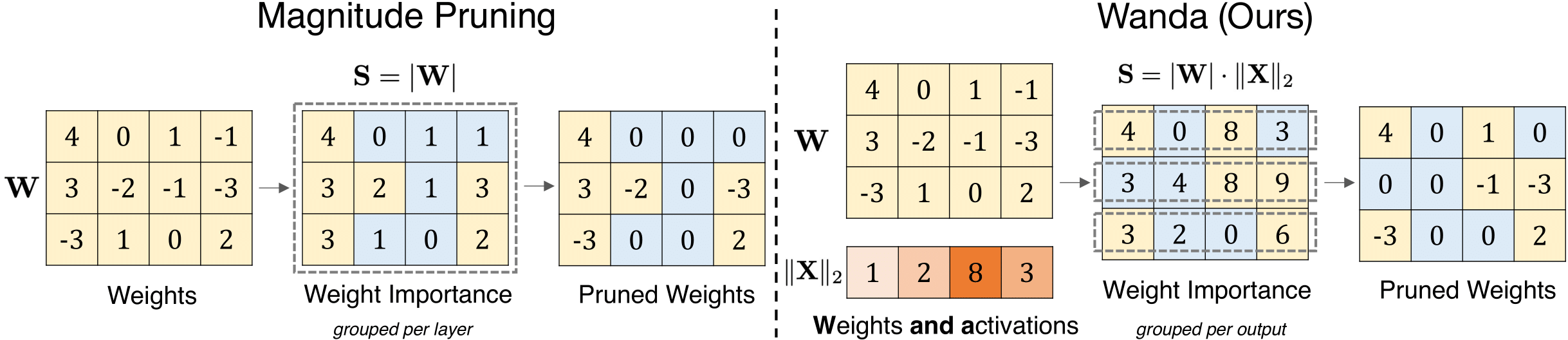

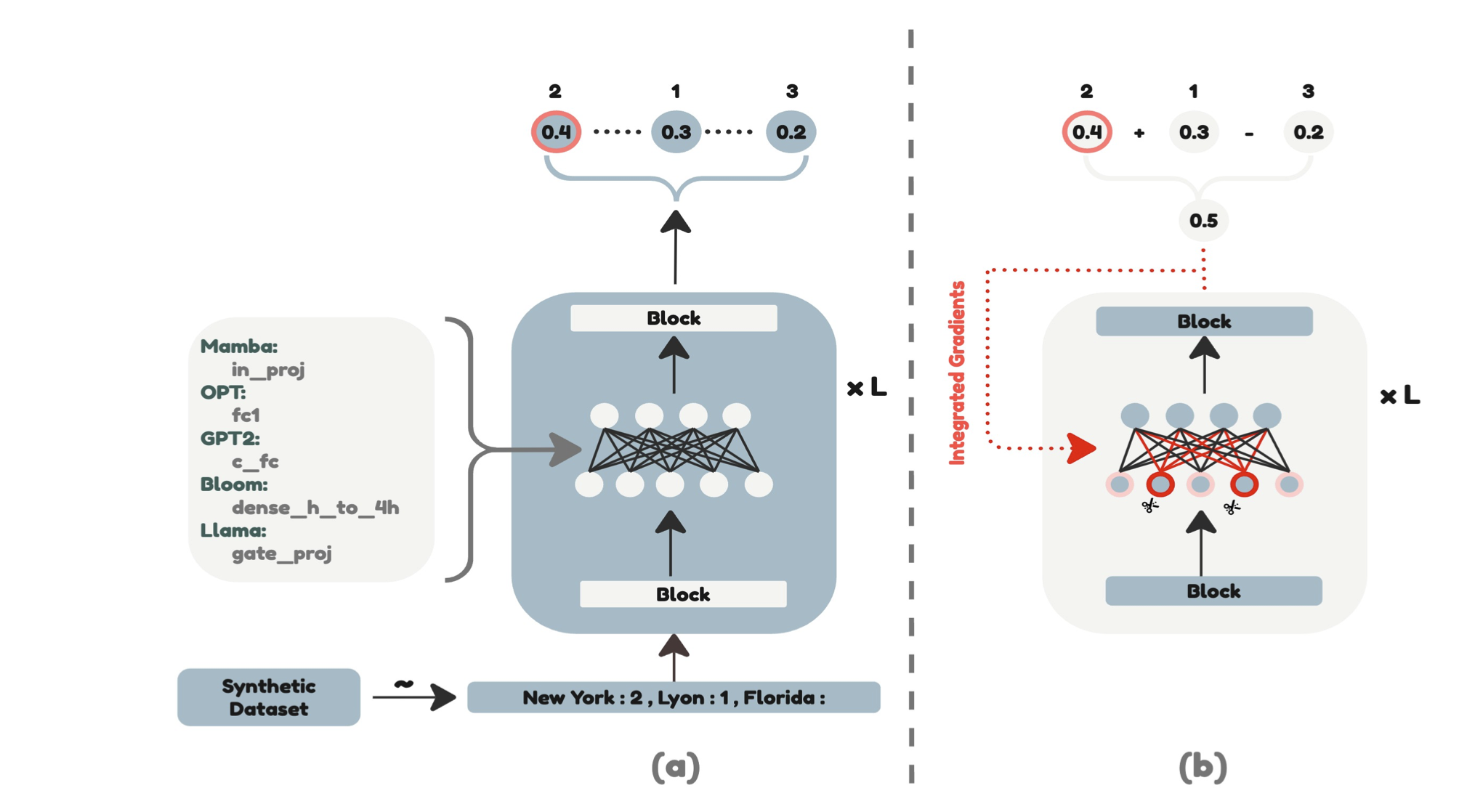

Ein einfacher und effektiver Schnittansatz für große Sprachmodelle Mingjie Sun, Zhuang Liu, Anna Bair, J. Zico Kolter |  | Github Papier |

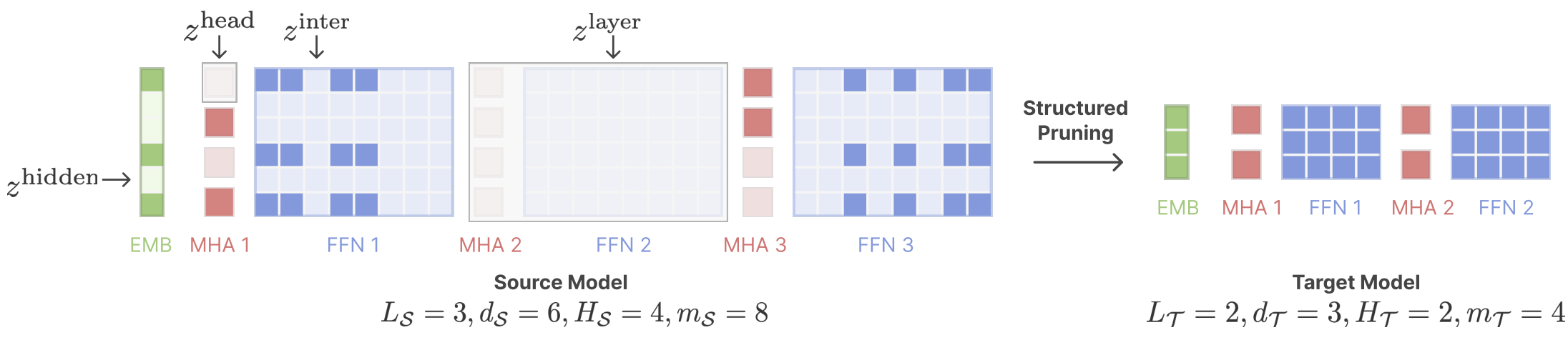

Scherte Lama: Beschleunigen des Sprachmodells vor dem Training über strukturiertes Beschneiden Mengzhou Xia, Tianyu Gao, Zhiyuan Zeng, Danqi Chen |  | Github Papier |

| Effiziente LLM-Inferenz mit dynamischem Eingangsbeschnitten und Cache-Wahrnehmungsmaskierung Marco Federici, Davide Belli, Mart Van Baalen, Amir Jalalirad, Andrii Skliar, Bence Major, Markus Nagel, Paul wie | Papier | |

| Puzzle: Destillationsbasierte NAS für inferenzoptimierte LLMs Akhiad Bercovich, Tomer Ronen, Talor Abramovich, Nir Ailon, Nave Assaf, Mohammad Dabbah et al. | Papier | |

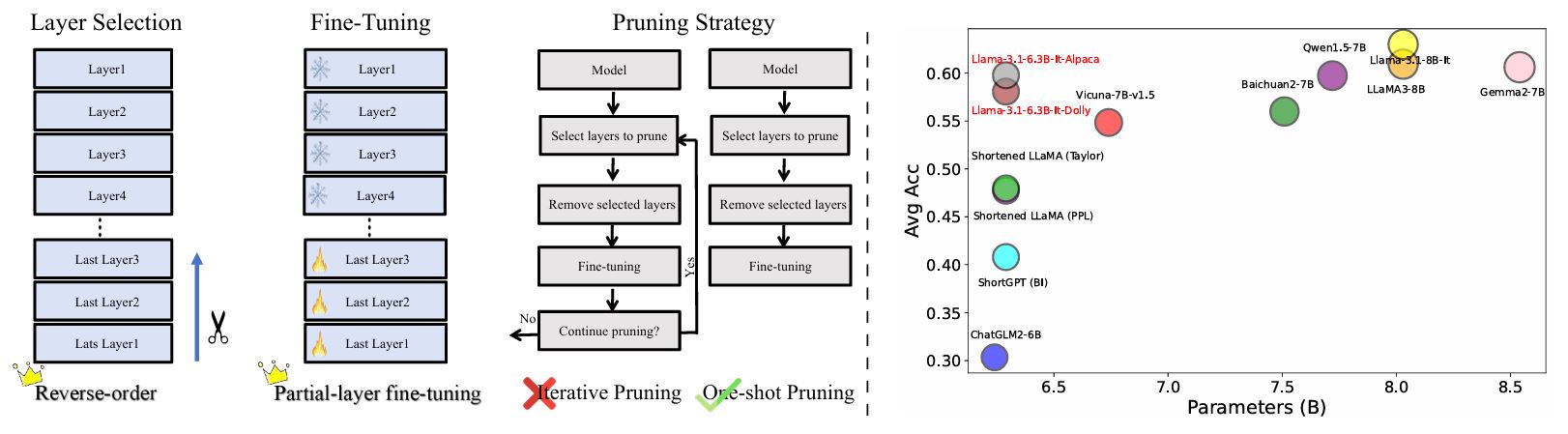

Überprüfung der Schichtbeschnitte in LLMs: Neue Erkenntnisse und Methoden Yao Lu, Hao Cheng, Yujie Fang, Zeyu Wang, Jiaheng Wei, Dongwei Xu, Qi Xuan, Xiaoniu Yang, Zhaowei Zhu |  | Github Papier |

| Schichtwichtigkeit und Halluzinationsanalyse in Großsprachenmodellen durch verbesserte Aktivierungsvarianzsparsität Zichen Song, Sitan Huang, Yuxin Wu, Zhongfeng Kang | Papier | |

AMOEBALLM: Erstellen von großer Sprachmodellen für effiziente und sofortige Bereitstellung Any-Form-Modelle Yonggan Fu, Zhongzhi Yu, Junwei Li, Jiyi Qian, Yongan Zhang, Xiangchi Yuan, Dachuan Shi, Roman Yakunin, Yingyan Celine Lin | Github Papier | |

| Skalierungsgesetz für die Nachbildung nach Modellbeschnitten Xiaodong Chen, Yuxuan Hu, Jing Zhang, Xiaokang Zhang, Cuiping Li, Hong Chen | Papier | |

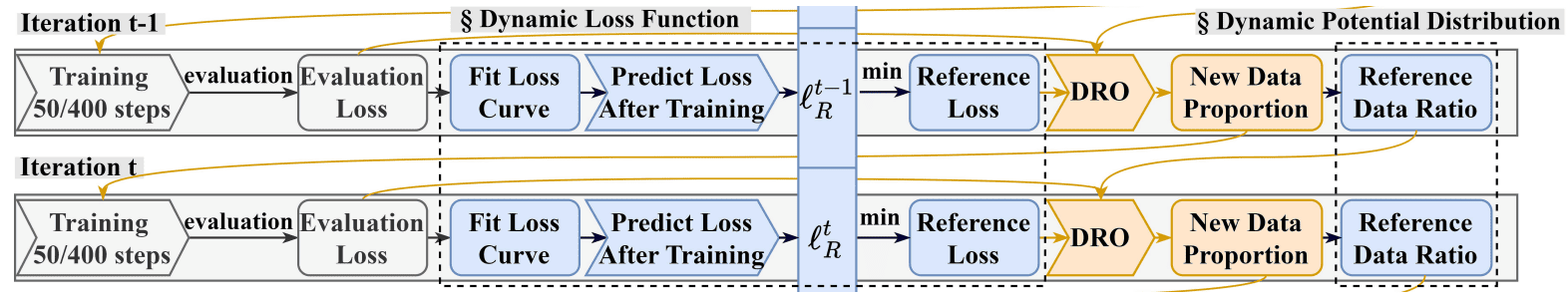

DRPRUNINING: Effizientes Großsprachmodell -Beschneidung durch verteilt robuste Optimierung Hexuan Deng, Wenxiang Jiao, Xuebo Liu, Min Zhang, Zhaopeng TU |  | Github Papier |

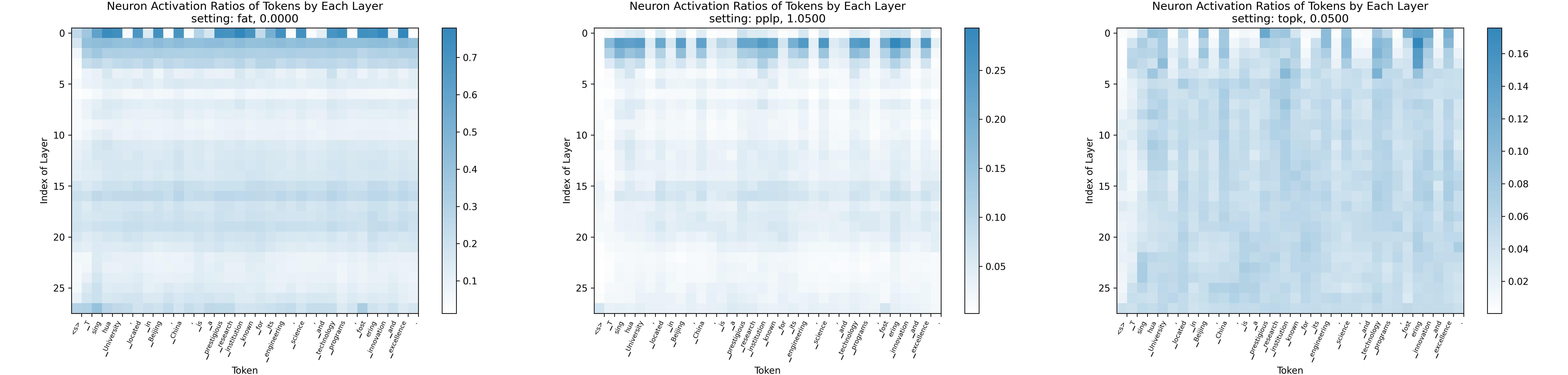

Sparsing -Gesetz: Auf dem Weg zu großen Sprachmodellen mit größerer Aktivierungssparität Yuqi Luo, Chenyang Song, Xu Han, Yingfa Chen, Chaojun Xiao, Zhiyuan Liu, Maosong Sun |  | Github Papier |

| AVSS: Schicht Bedeutung Bewertung in Großsprachenmodellen durch Aktivierungsvarianzsparsitätsanalyse Zichen Song, Yuxin Wu, Sitan Huang, Zhongfeng Kang | Papier | |

| Schneiderungslama: Optimieren Sie das Lernen von Wenig-Shot-Lernen in beschnittenen Lama-Modellen mit aufgabenspezifischen Eingaben Danyal Aftab, Steven Davy | Papier | |

LLMCBench: Benchmarking Großsprachmodellkomprimierung für eine effiziente Bereitstellung Ge Yang, Changyi He, Jinyang Guo, Jianyu Wu, Yifu Ding, Aishan Liu, Haotong Qin, Pengliang Ji, Xianglong Liu |  | Github Papier |

| Jenseits 2: 4: Erkundung von V: N: M Sparsity für eine effiziente Transformatorinferenz bei GPUs Kang Zhao, Tao Yuan, Han Bao, Zhenfeng Su, Chang Gao, Zhaofeng Sun, Zichen Liang, Liping Jing, Jianfei Chen | Papier | |

Evopress: Auf dem Weg zur optimalen dynamischen Modellkomprimierung durch evolutionäre Suche Oliver Sieberling, Denis Kuznedelev, Eldar Kurtic, Dan Alistarh |  | Github Papier |

| FEDSPALLM: Verbesserte Beschneidung großer Sprachmodelle Guangji Bai, Yijiang Li, Zilinghan Li, Liang Zhao, Kibaek Kim | Papier | |

Beschneidungsstiftungsmodelle für hohe Genauigkeit ohne Umschulung Pu Zhao, Fei Sun, Xuan Shen, Pinrui Yu, Zhenglun Kong, Yanzhi Wang, Xue Lin | Github Papier | |

| Selbstkalibrierung für Sprachmodellquantisierung und Beschneidung Miles Williams, George Chrysostomou, Nikolaos Aletras | Papier | |

| Achten Sie auf Kalibrierungsdaten für das Beschneiden von großsprachigen Modellen Yixin Ji, Yang Xiang, Juntao Li, Qingrong Xia, Ping Li, Xinyu Duan, Zhefeng Wang, Min Zhang | Papier | |

Alphapruning: Verwenden der Theorie zur Selbstregulierung mit schwerer Self-Regularisierung für eine verbesserte Schicht-Beschneidung großer Sprachmodelle Haiquan Lu, Yefan Zhou, Shiwei Liu, Zhangyang Wang, Michael W. Mahoney, Yaoqing Yang | Github Papier | |

| Über lineare Annäherungen hinaus: Ein neuer Schnittansatz für die Aufmerksamkeitsmatrix Yingyu Liang, Jiangxuan Long, Zhenmei Shi, Zhao Song, Yufa Zhou | Papier | |

Displm Shangqian Gao, Chi-Heng Lin, Ting Hua, Tang Zheng, Yilin Shen, Hongxia Jin, Yen-Chang Hsu | Papier | |

Selbstdata-Destillation zur Wiederherstellung der Qualität in beschnittenen Großsprachenmodellen Vithursan Thangarasa, Ganesh Venkatesh, Nish Sinnadurai, Sean Lüge | Papier | |

| LLM-Rank: Ein Diagramm theoretischer Ansatz zum Beschneiden großer Sprachmodelle David Hoffmann, Kailash Budhathoki, Matthäus Kleindessner | Papier | |

Ist C4 -Datensatz optimal für das Beschneiden? Eine Untersuchung von Kalibrierungsdaten für LLM -Beschneidung Abhinav Bandari, Lu Yin, Cheng-Yu Hsieh, Ajay Kumar Jaiswal, Tianlong Chen, Li Shen, Ranjay Krishna, Shiwei Liu | Github Papier | |

| Minderung der Kopienverzerrung im Kontextlernen durch Neuronbeschneidung Ameen Ali, Lior Wolf, Ivan Titov |  | Papier |

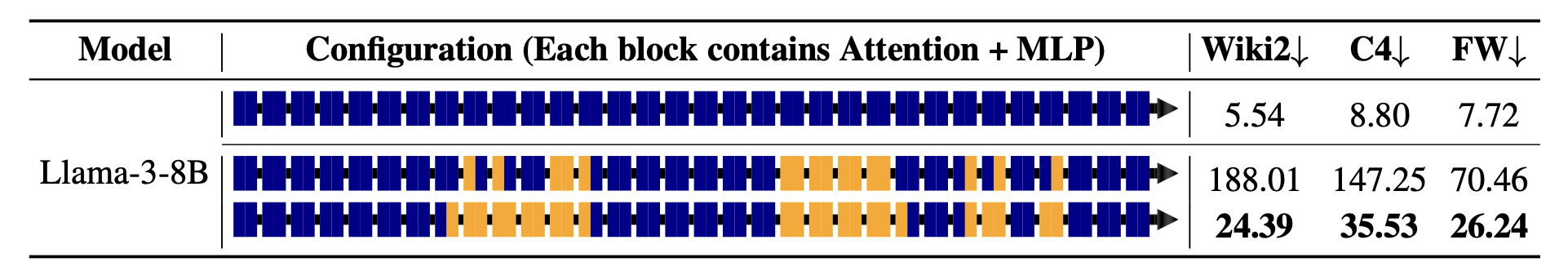

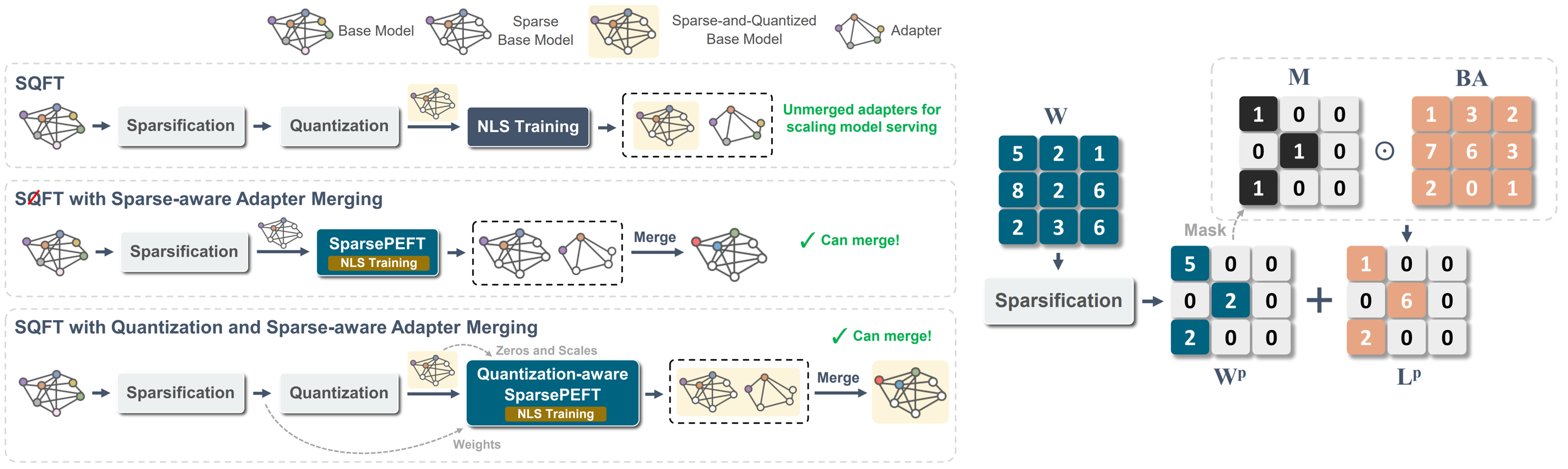

SQFT: Ein kostengünstiges Modellanpassung in mit niedrig präzise spärlichen Fundamentmodellen Juan Pablo Munoz, Jinjie Yuan, Nilesh Jain |  | Github Papier |

Maskllm: Lernbare halbstrukturierte Sparsität für große Sprachmodelle Gongfan Fang, Hongxu Yin, Saurav Muralidharan, Greg Heinrich, Jeff Pool, Jan Kautz, Pavlo Molchanov, Xinchao Wang |  | Github Papier |

Suchen Sie nach effizienten großsprachigen Modellen Xuan Shen, Pu Zhao, Yifan Gong, Zhenglun Kong, Zheng Zhan, Yushu Wu, Ming Lin, Chao Wu, Xue Lin, Yanzhi Wang | Papier | |

CFSP: Ein effizientes strukturiertes Schnittrahmen für LLMs mit groben Aktivierungsinformationen Yuxin Wang, Minghua MA, Zekun Wang, Jingchang Chen, Huiming -Fan, Liping Shan, Qing Yang, Dongliang Xu, Ming Liu, Bing Qin | Github Papier | |

| Hafer: Ausreißerbewusstes Beschneiden durch spärliche und geringe Zersetzung Stephen Zhang, Vardan Papyan | Papier | |

| KVPRUNER: Strukturelles Beschneiden für schnellere und erinnerteffiziente große Sprachmodelle Bo lv, Quan Zhou, Xuanang Ding, Yan Wang, Zeming MA | Papier | |

| Bewertung der Auswirkungen von Komprimierungstechniken auf die aufgabenspezifische Leistung großer Sprachmodelle Bishasch Khanal, Jeffery M. Capone | Papier | |

| Stun: Strukturiertes, nicht mehr verstrukturiertes Beschneiden für skalierbares MOE-Beschneidung Jaeseong Lee, Seung-Won Hwang, Aurick Qiao, Daniel F Campos, Zhewe Yao, Yuxiong He | Papier | |

PAT: Beschnittene-bewusstes Tuning für große Sprachmodelle Yijiang Liu, Huanrui Yang, Youxin Chen, Rongyu Zhang, Miao Wang, Yuan du, Li du |  | Github Papier |

| Titel & Autoren | Einführung | Links |

|---|---|---|

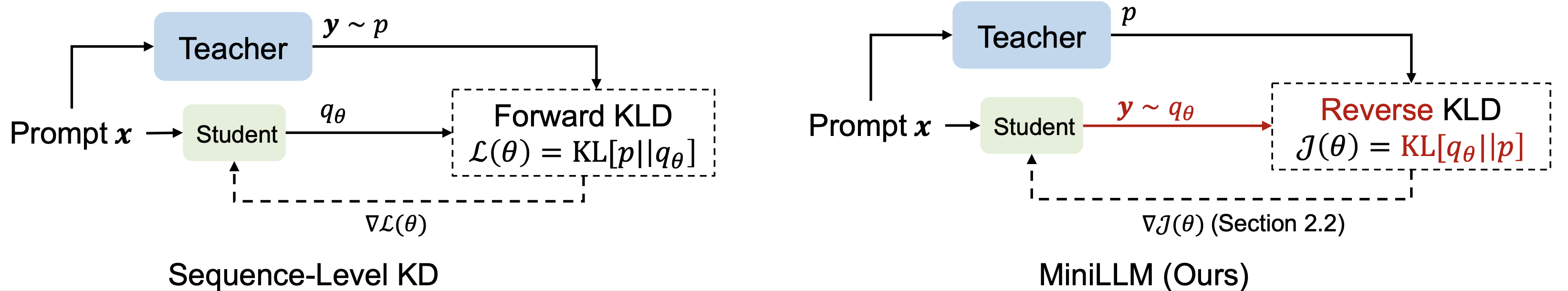

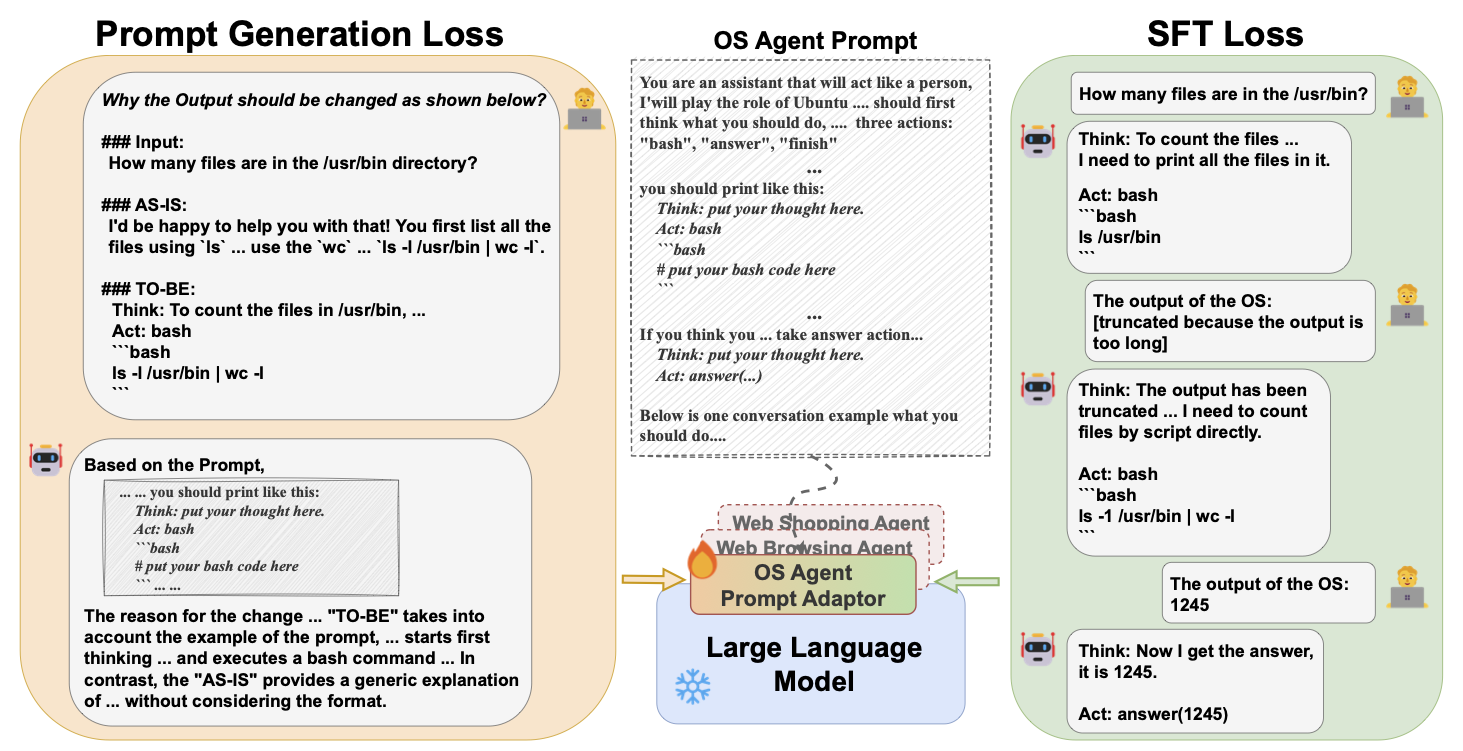

| Wissensdestillation großer Sprachmodelle Yuxian Gu, Li Dong, Furu Wei, Minlie Huang |  | Github Papier |

| Verbesserung der Funktionen der mathematischen Argumentation kleiner Sprachmodelle durch feedback-gesteuerte Destillation Xunyu Zhu, Jian li, kann Ma, wang wang | Papier | |

Generative Kontextdestillation Haebin Shin, Lei Ji, Yeyun Gong, Sungdong Kim, Eunbi Choi, Minjoon Seo |  | Github Papier |

| Switch: Studieren mit Lehrer zur Wissensdestillation von Großsprachmodellen Jahyun Koo, Yerin Hwang, Yongil Kim, Taegwan Kang, Hyunkyung Bae, Kyomin Jung |  | Papier |

Jenseits Autoregression: schnelle LLMs über Selbstdestillation durch die Zeit Justin Deschenaux, Caglar Gulcehre | Github Papier | |

| Destillation vor der Ausbildung für Großsprachmodelle: Eine Erkundung von Designfläche Hao Peng, Xin LV, Yushi Bai, Zijun Yao, Jiajie Zhang, Lei Hou, Juanzi Li | Papier | |

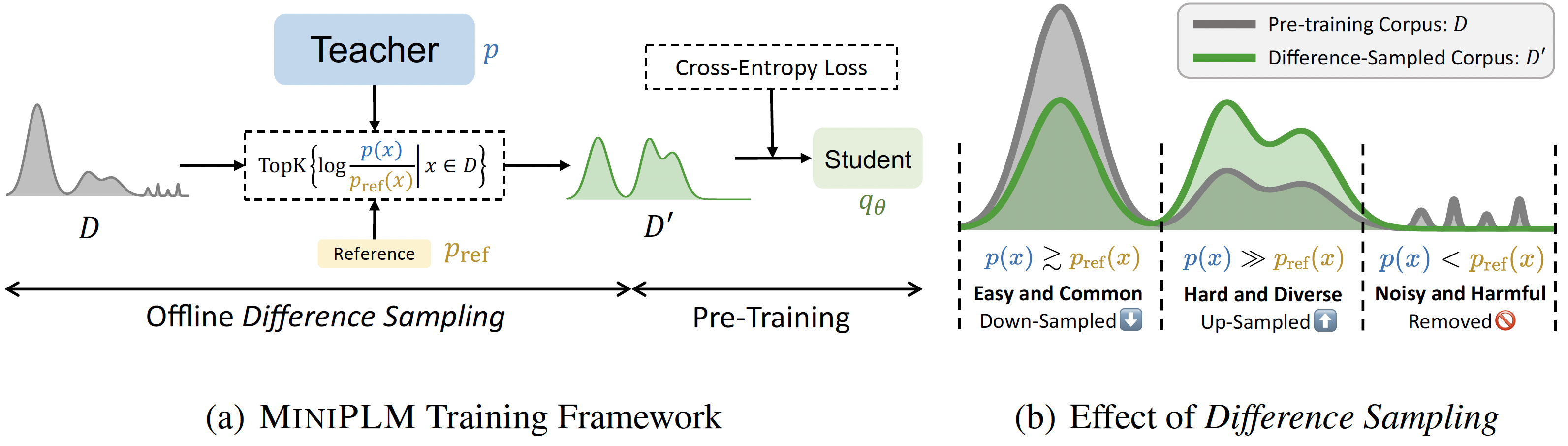

Miniplm: Wissensdestillation für Sprachmodelle vor der Ausbildung Yuxian Gu, Hao Zhou, Fandong Meng, Jie Zhou, Minlie Huang |  | Github Papier |

| Spekulative Wissensdestillation: Überbrückung der Lehrerlücke durch die Lehrer durch verschachtelte Stichproben Wenda Xu, Rujun Han, Zifeng Wang, Long T. Le, Dhruv Madeka, Lei Li, William Yang Wang, Rishabh Agarwal, Chen-yu Lee, Tomas Pfister | Papier | |

| Evolutionäre kontrastive Destillation für die Sprachmodellausrichtung Julian Katz-Samuels, Zheng Li, Hyokun Yun, Priyanka Nigam, Yi Xu, Vaclav Petricek, Bing Yin, Trishul Chilimbi | Papier | |

| Babyllama-2: Ensemble-destillierte Modelle übertreffen Lehrer konsequent mit begrenzten Daten Jean-Loup Tastet, Inar Timiryasov | Papier | |

| Echoatt: Nehmen, kopieren, dann effizientere Großsprachenmodelle anpassen Hossein Rajabzadeh, Aref Jafari, Aman Sharma, Benyamin Jami, Hyock Ju Kwon, Ali Ghodsi, Boxing Chen, Mehdi Rezagholizadeh | Papier | |

Skintern: Internalisiert symbolisches Wissen zur Distillierung besserer COT -Fähigkeiten in kleine Sprachmodelle Huanxuan Liao, Shizhu He, Yupu Hao, Xiang Li, Yuanzhe Zhang, Kang Liu, Jun Zhao | Github Papier | |

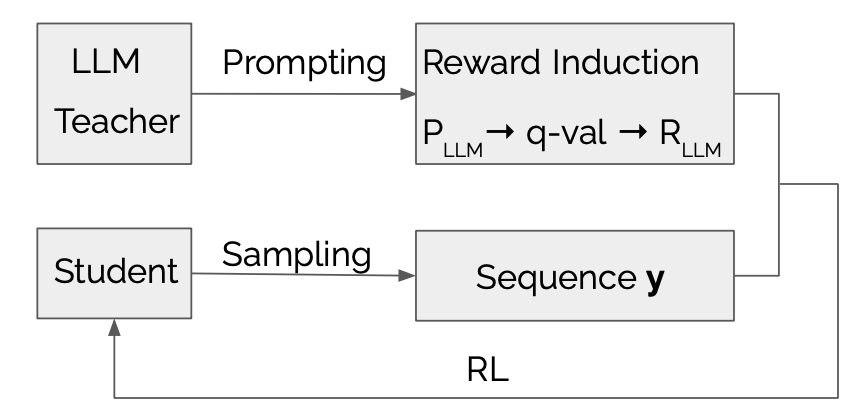

LLMR: Wissensdestillation mit einer großsprachigen Modell-induzierten Belohnung Dongheng Li, Yongchang Hao, Lili Mou |  | Github Papier |

| Erkundung und Verbesserung des Übertragers der Verteilung in der Wissensdestillation für autoregressive Sprachmodelle Jun Rao, Xuebo Liu, Zepeng Lin, Liang Ding, Jing Li, Dacheng Tao | Papier | |

| Effiziente Wissensdestillation: Stärkung kleiner Sprachmodelle mit Lehrermodell -Erkenntnissen befähigen Mohamad Ballout, Ulf Krumnack, Gunther Heidemann, Kai-Uwe Kühnberger | Papier | |

Die Mamba im Lama: Destillieren und Beschleunigen von Hybridmodellen Junxiong Wang, Daniele Paliotta, Avner May, Alexander M. Rush, Tri Dao | Github Papier |

| Titel & Autoren | Einführung | Links |

|---|---|---|

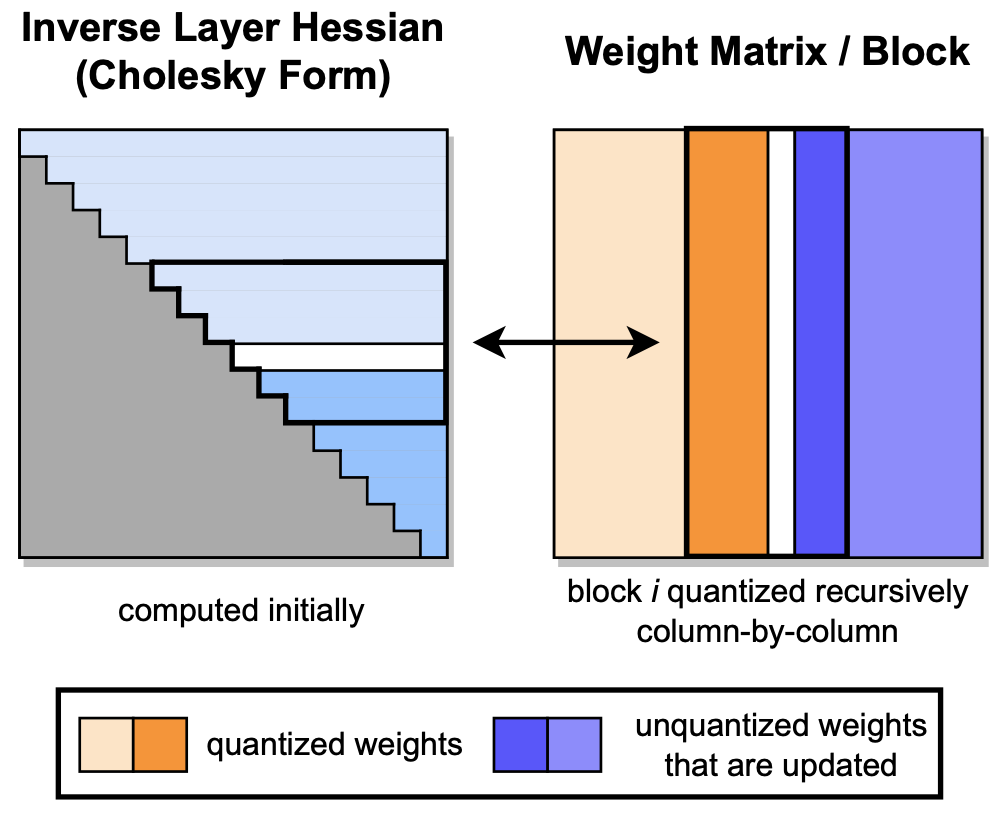

GPTQ: Genaue Nachtraining-Quantisierung für generative vorgebrachte Transformatoren Elias Frantar, Saleh Ashkboos, Torsten Hoefler, Dan Alistarh |  | Github Papier |

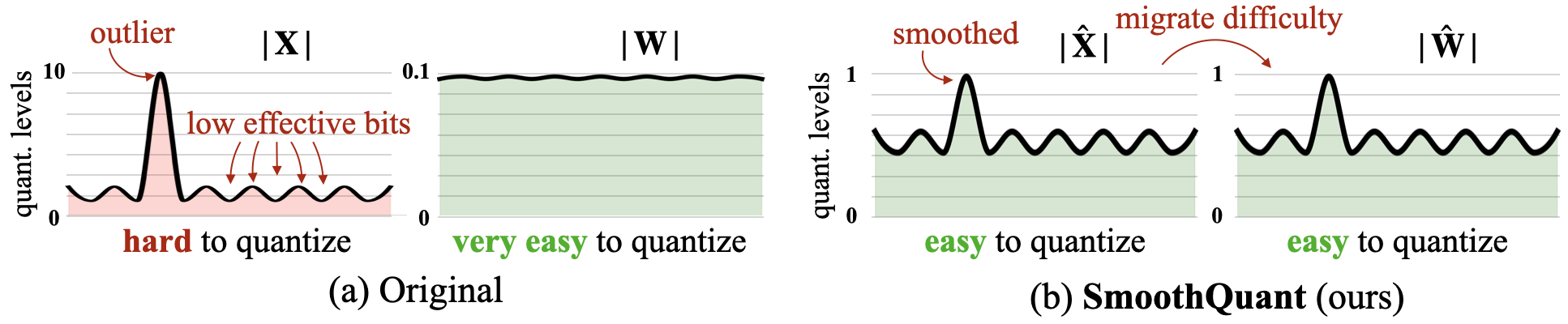

Smoothquant: Genaue und effiziente Quantisierung nach dem Training für große Sprachmodelle Guangxuan Xiao, Ji Lin, Mickael Seznec, Hao Wu, Julien Demouth, Lied Han |  | Github Papier |

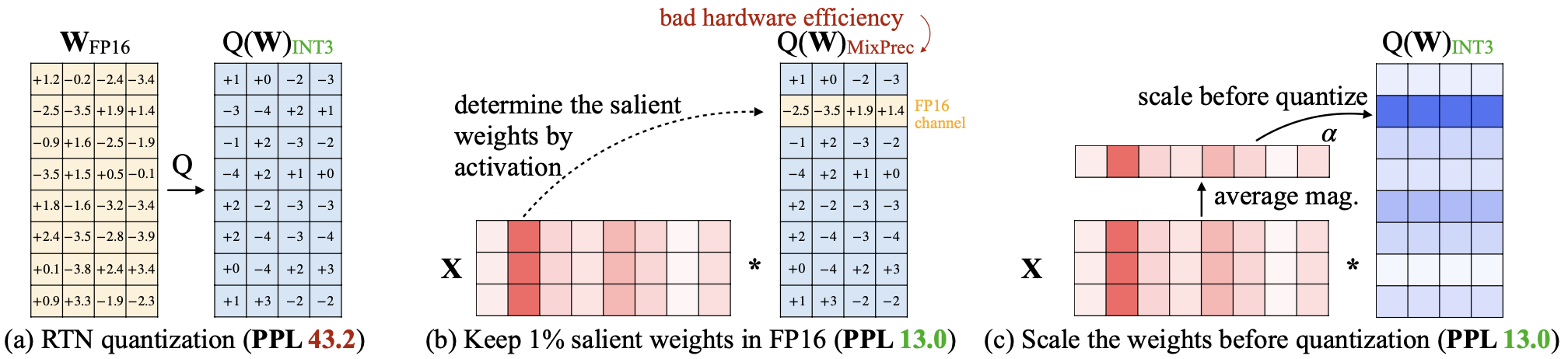

AWQ: Aktivierungsbewusstes Gewichtsquantisierung für die LLM-Komprimierung und -beschleunigung Ji Lin, Jiaming Tang, Haotian Tang, Shang Yang, Xingyu Dang, Lied Han |  | Github Papier |

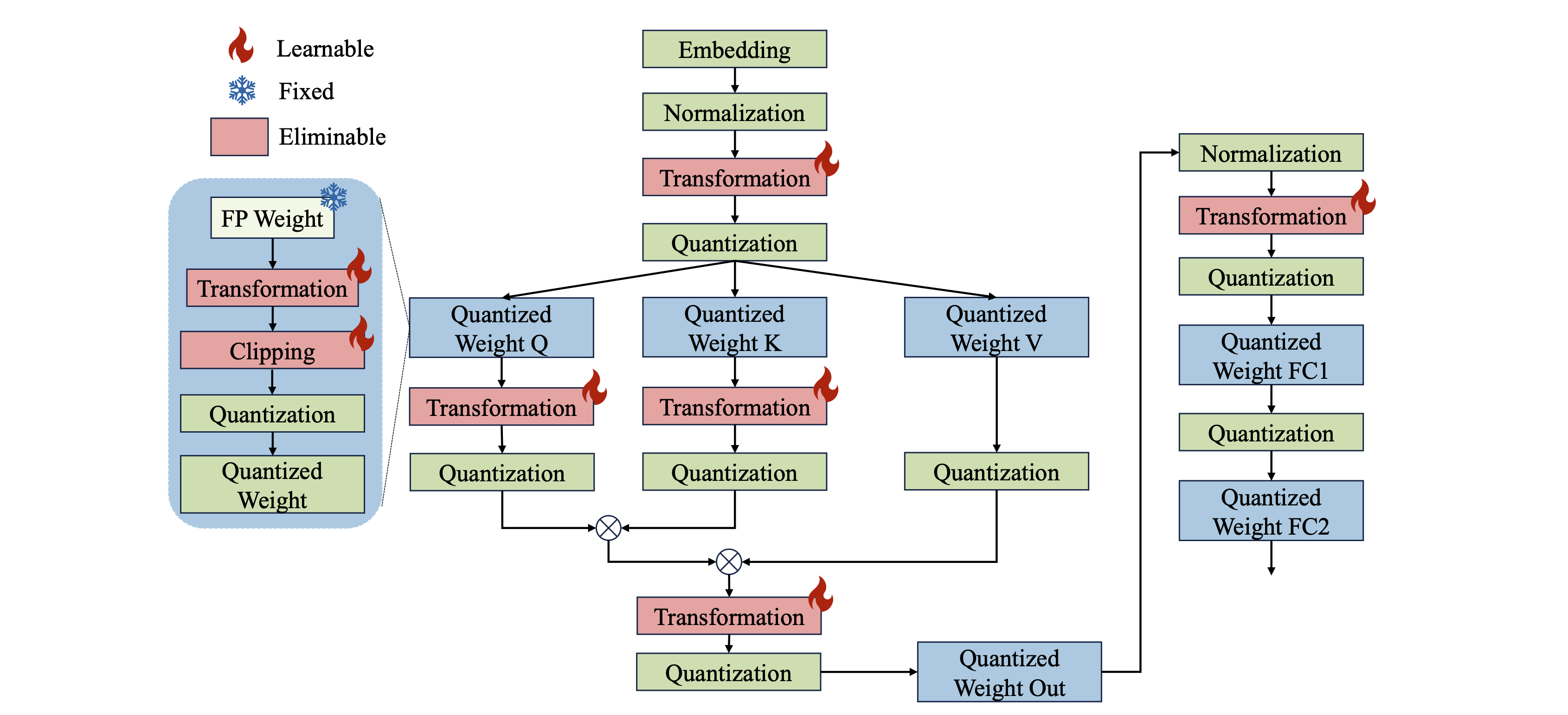

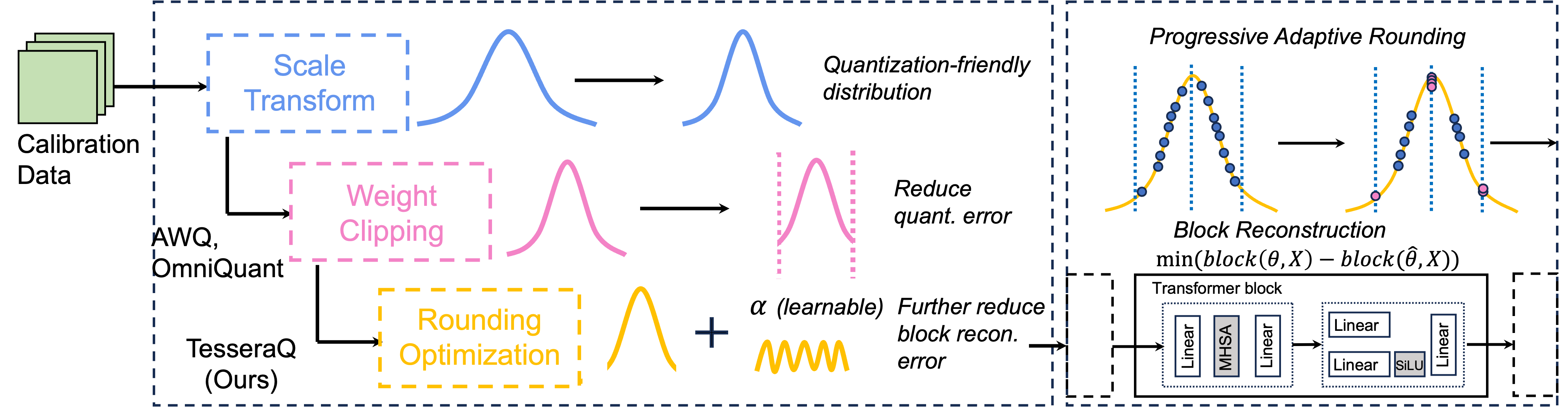

Omniquant: omnidirektional kalibrierte Quantisierung für große Sprachmodelle Wenqi Shao, Mengzhao Chen, Zhaoyang Zhang, Peng Xu, Lirui Zhao, Zhiqian Li, Kaipeng Zhang, Peng Gao, Yu Qiao, Ping Luo |  | Github Papier |

| Skim: Any-Bit-Quantisierung, die die Grenzen der Quantisierung nach dem Training drückt Runsheng Bai, Qiang Liu, Bo Liu | Papier | |

| CPTQUANT-Eine neuartige Quantisierungstechniken nach dem Training nach der Training für große Sprachmodelle Amitash Nanda, Sree Bhargavi Balija, Debashis Sahoo | Papier | |

ANDA: Entsperren Sie eine effiziente LLM-Inferenz mit einem gruppierten Aktivierungsdatenformat mit variabler Länge Chao Fang, Mann Shi, Robin Geens, Arne Symons, Zhongfeng Wang, Marian Verhelst | Papier | |

| MixPe: Quantisierung und Hardware-Co-Design für eine effiziente LLM-Inferenz Yu Zhang, Mingzi Wang, Lancheng Zou, Wulong Liu, Hui-Ling Zhen, Mingxuan Yuan, Bei Yu | Papier | |

Bitmod: Bit-seriale Mischung vom Datenpunkt LLM Beschleunigung Yuzong Chen, Ahmed F. Abouelhamayed, Xilai Dai, Yang Wang, Marta Andronic, George A. Konstantinides, Mohamed S. Abdelfattah | Github Papier | |

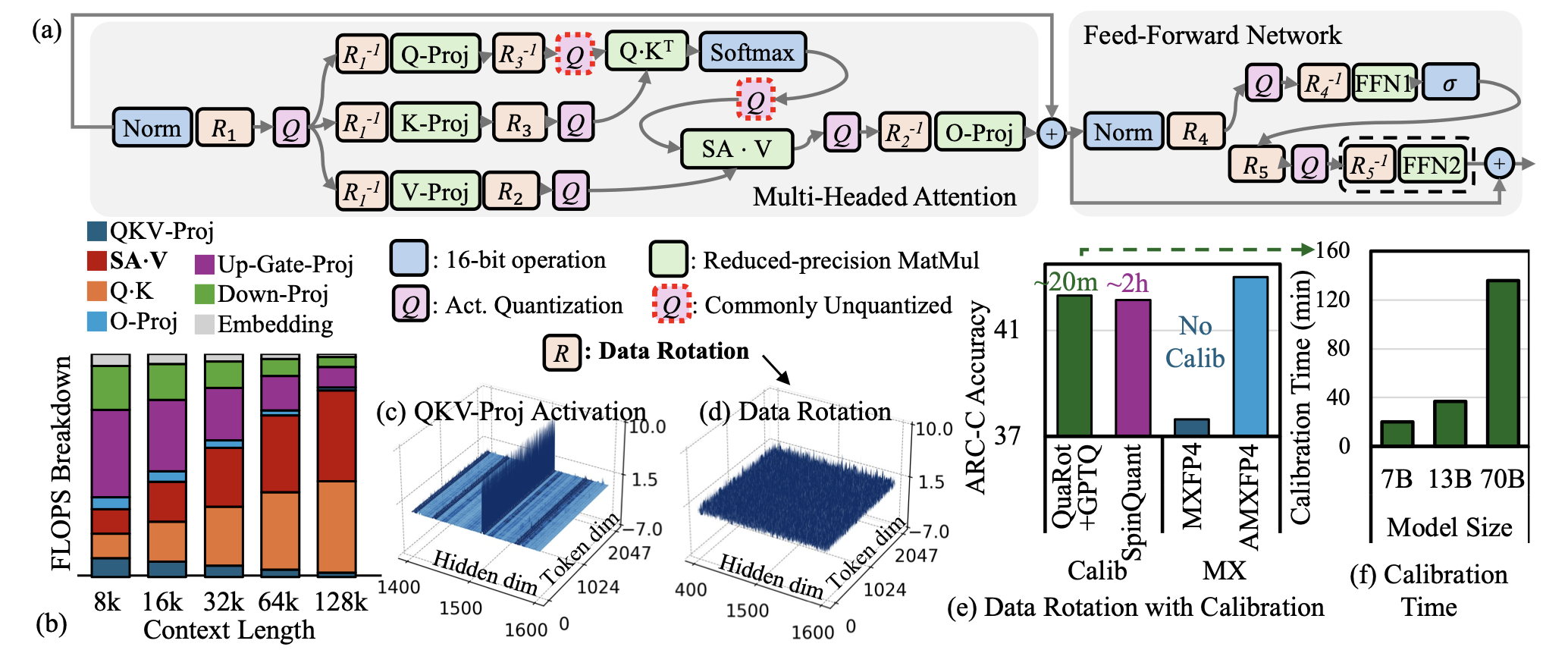

| AMXFP4: Aktivierungsausreißer mit asymmetrischer Mikroskalierungspunkt für 4-Bit-LLM-Inferenz zähmen Janghwan Lee, Jiwoong Park, Jinseok Kim, Yongjik Kim, Jungju Oh, Jinwook Oh, Jungwook Choi |  | Papier |

| Bi-mamba: Auf dem Weg zu genauen 1-Bit-Zustandsraummodellen Shengkun Tang, Liqun MA, Haonan Li, Mingjie Sun, Zhiqiang Shen | Papier | |

| "Gib mir BF16 oder gib mir den Tod"? Kompromisse für Genauigkeitsleistung bei der LLM-Quantisierung Eldar Kurtic, Alexandre Marques, Shubhra Pandit, Mark Kurtz, Dan Alistarh | Papier | |

| GWQ: Gradientenbewusstliche Gewichtsquantisierung für Großsprachenmodelle Yihua Shao, Siyu Liang, Xiaolin Lin, Zijian Ling, Zixian Zhu et al. | Papier | |

| Eine umfassende Studie zu Quantisierungstechniken für Großsprachenmodelle Jiedong Lang, Zhehao Guo, Shuyu Huang | Papier | |

| Bitnet A4.8: 4-Bit-Aktivierungen für 1-Bit-LLMs Hongyu Wang, Shuming Ma, Furu Wei | Papier | |

Tesseraq: Ultra-niedrige LLM-LLM-Quantisierung mit Blockrekonstruktion mit Blockrekonstruktion Yuhang Li, Priyadarshini Panda |  | Github Papier |

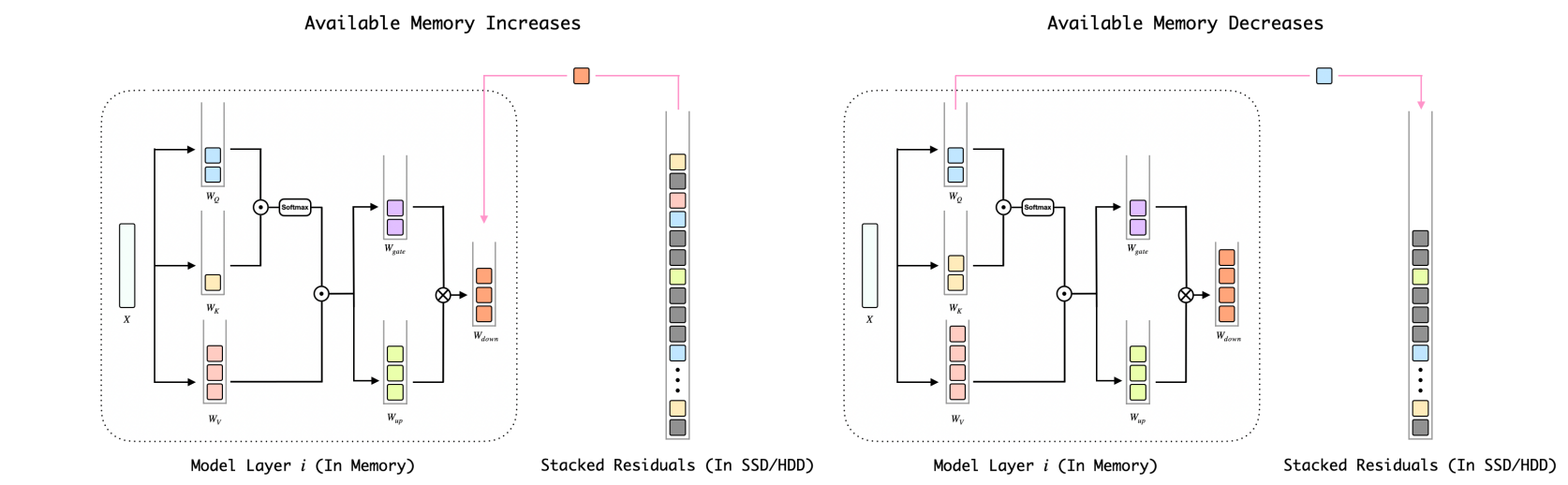

Bitstack: Feinkörnige Größenregelung für komprimierte Großsprachenmodelle in variablen Speicherumgebungen Xinghao Wang, Pengyu Wang, Bo Wang, Dong Zhang, Yunhua Zhou, Xipeng Qiu |  | Github Papier |

| Die Auswirkungen von Inferenzbeschleunigungsstrategien auf die Verzerrung von LLMs Elisabeth Kirsten, Ivan Heieral, Vedant Nanda, Muhammad Bilal Zafar | Papier | |

| Verständnis der Schwierigkeit der Quantisierung von großer Sprachmodellen nach dem Training nach dem Training mit niedriger Präzision Zifei Xu, Sayeh Sharify, Wanzin Yazar, Tristan Webb, Xin Wang | Papier | |

1-Bit AI Infra: Teil 1.1, schnell und verlustfreie Bitnet B1.58 Inferenz auf CPUs Jinheng Wang, Hansong Zhou, Ting Song, Shaoguang Mao, Shuming MA, Hongyu Wang, Yan Xia, Furu Wei | Github Papier | |

| Quailora: quantisierungsbewusste Initialisierung für Lora Neal Lawton, Aishwarya Padmakumar, Judith Gaspers, Jack Fitzgerald, Anoop Kumar, Greg Ver Steeg, Aram Galstyan | Papier | |

| Bewertung quantisierter Großsprachenmodelle für die Codegenerierung auf Low-Ress-Sprach-Benchmarks Enkhbold Nyamsuren | Papier | |

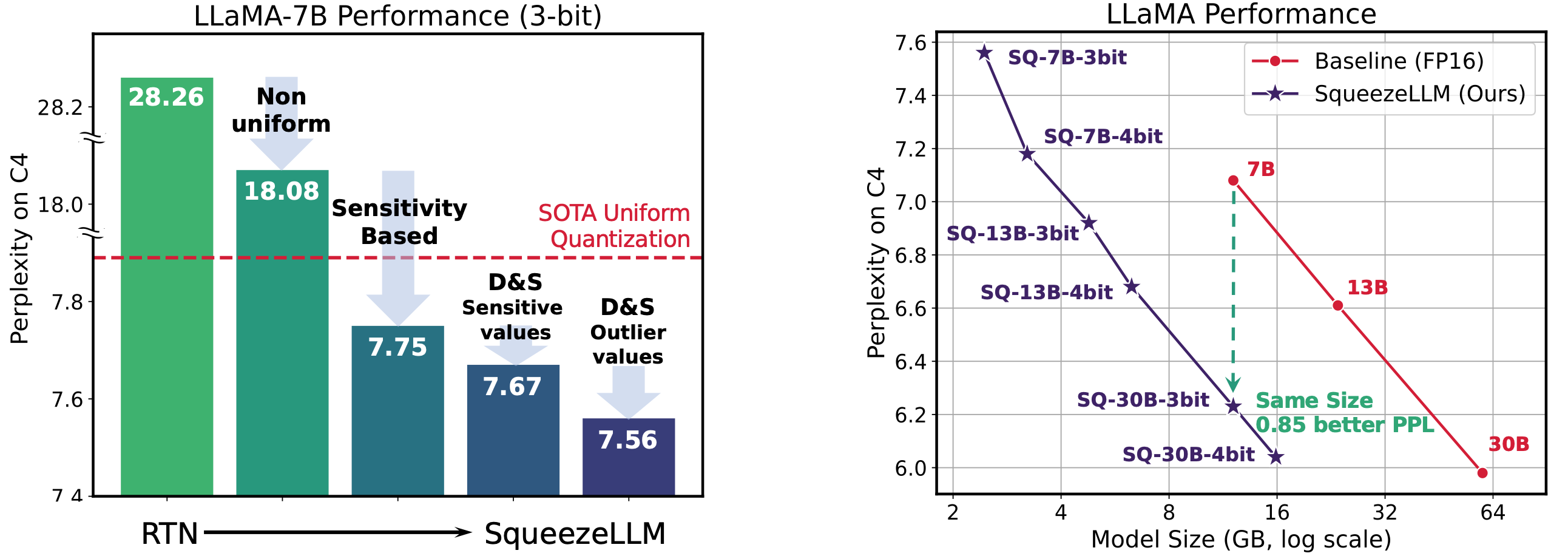

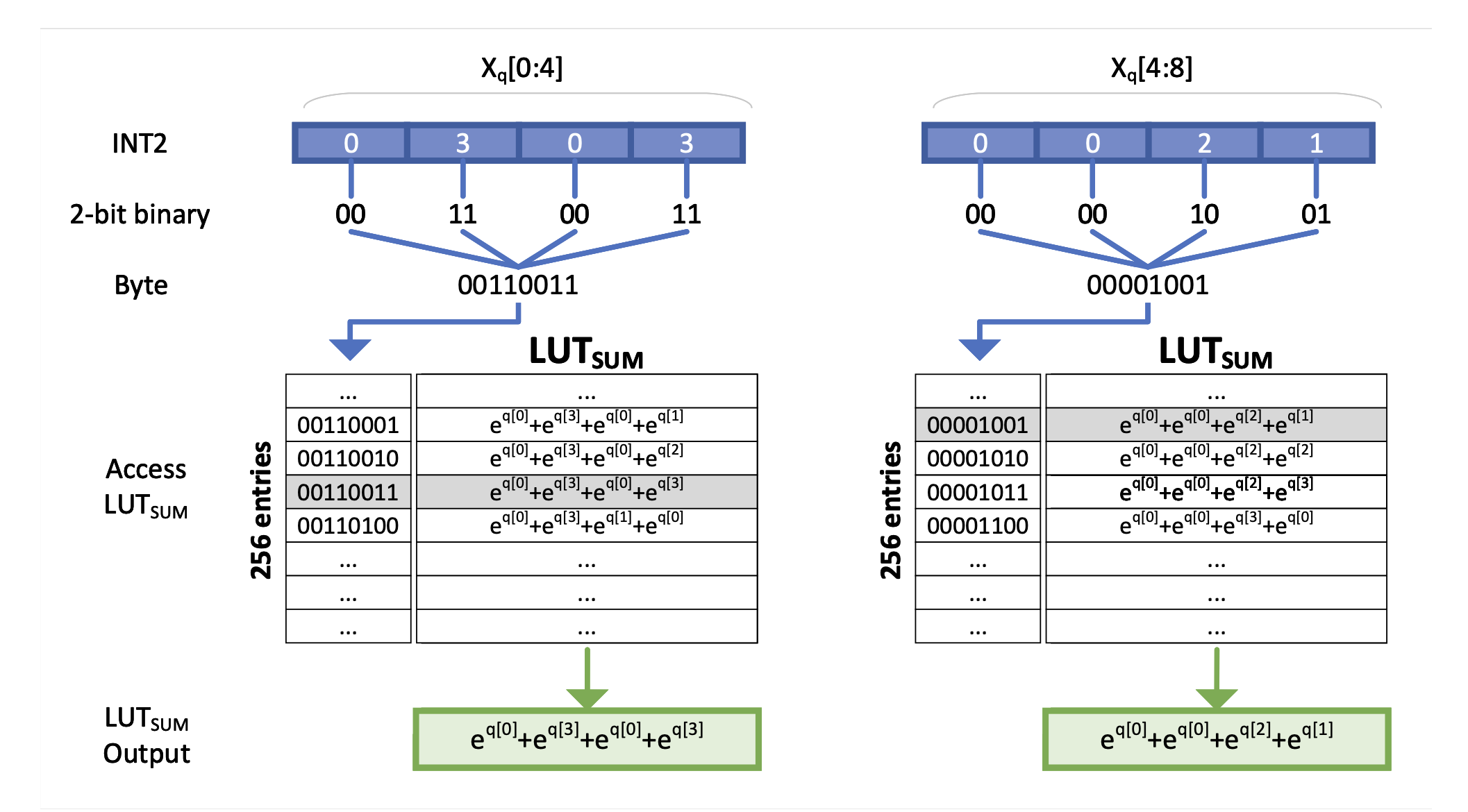

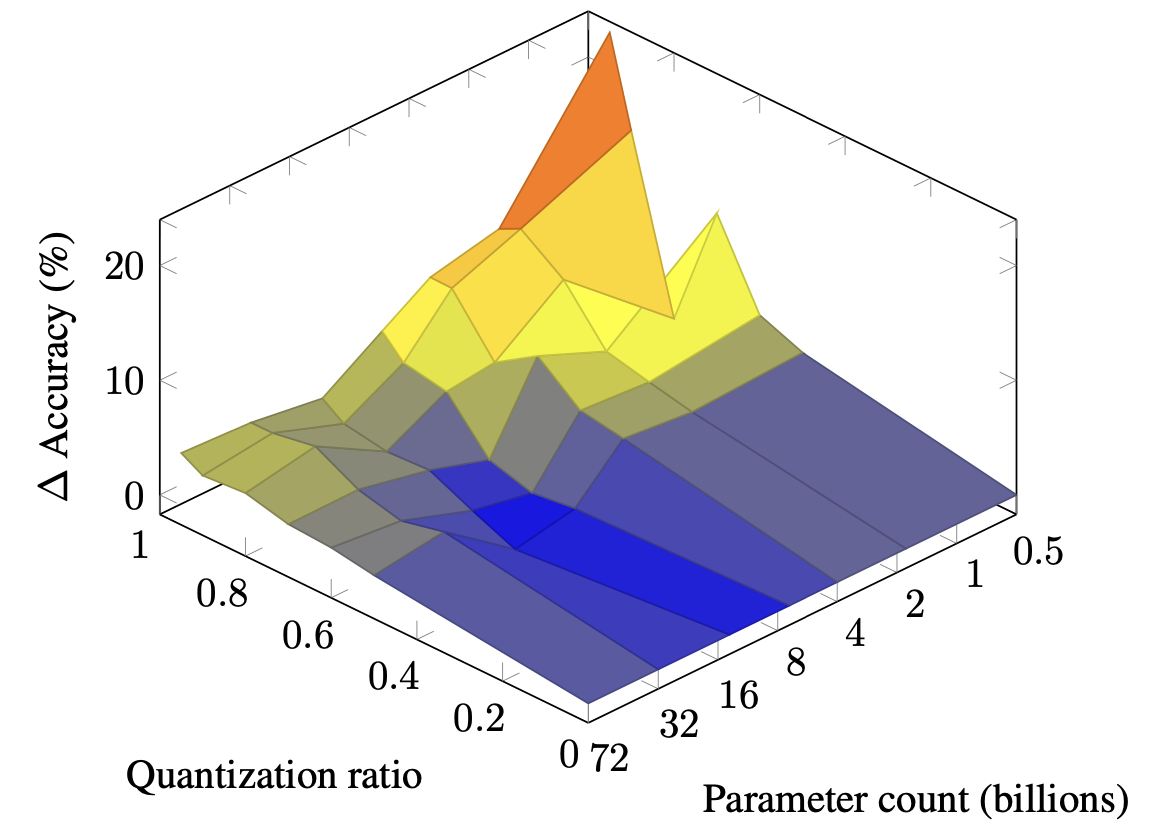

Squeezellm: Dicht und absparende Quantisierung Sehoon Kim, Coleman Hooper, Amir Gholami, Zhen Dong, Xiuyu Li, Sheng Shen, Michael W. Mahoney, Kurt Ketzer |  | Github Papier |

| Pyramidenvektorquantisierung für LLMs Tycho Fa van der Ousaa, Maximilian L. Croci, Agrin Hilmkil, James Hensman | Papier | |

| Sämlm: Komprimieren von LLM-Gewichten in Samen von Pseudo-Random-Generatoren Rasoul Shafipour, David Harrison, Maxwell Horton, Jeffrey Marker, Houman Bedayat, Sachin Mehta, Mohammad Rastegari, Mahyar Najibi, Saman Naderiparzizi | Papier | |

Flatquant: Flatness ist für die LLM -Quantisierung von Bedeutung Yuxuan Sun, Ruikang Liu, Haoli Bai, Han Bao, Kang Zhao, Yuening Li, Jiaxin Hu, Xianzhi Yu, Lu Hou, Chun Yuan, Xin Jiang, Wulong Liu, Jun Yaoo | Github Papier | |

Slim: One-Shot-quantisierter Spärmer plus niedriger Annäherung an LLMs Mohammad Mozaffari, Maryam Mehri Dehnavi | Github Papier | |

| Skalierungsgesetze für quantisierte große Sprachmodelle nach dem Training Zifei Xu, Alexander Lan, Wanzin Yazar, Tristan Webb, Sayeh Sharify, Xin Wang | Papier | |

| Kontinuierliche Näherungen zur Verbesserung der Quantisierung bewusstes Training von LLMs Er Li, Jianhang Hong, Yuanzhuo Wu, Snehal Adbol, Zonglin Li | Papier | |

DAQ: Dichte-bewusstes Gewichtsquantisierung nach dem Training für LLMs Yingsong Luo, Ling Chen | Github Papier | |

Quamba: Ein Quantisierungsrezept nach dem Training für selektive Zustandsraummodelle Hung-Yueh Chiang, Chi-Chih Chang, Natalia Frumkin, Kai-Chiang Wu, Diana Marculescu | Github Papier | |

| ASYMKV: Aktivierung der 1-Bit-Quantisierung von KV-Cache mit schichtweisen asymmetrischen Quantisierungskonfigurationen Qian Tao, Wenyuan Yu, Jingren Zhou | Papier | |

| Kanalweise Quantisierung mit gemischter Präzision für Großsprachenmodelle Zihan Chen, Fahrrad Xie, Jundong Li, Cong Shen | Papier | |

| Progressive Dekodierung mit gemischter Präzision für eine effiziente LLM-Inferenz Hao Mark Chen, Fuwen Tan, Alexandros Kouris, Royson Lee, Hongxiang -Fan, Stylianos I. Venieris | Papier | |

Exaq: Exponent Awesare Quantisierung für die Beschleunigung von LLMs Moran Shkolnik, Maxim Fishman, Brian Chmiel, Hilla Ben-Yaacov, Ron Banner, Kfir Yehuda Levy |  | Github Papier |

Präfixquant: Statische Quantisierung überträgt dynamisch durch vorangestellte Ausreißer in LLMs Mengzhao Chen, Yi Liu, Jiahao Wang, Yi Bin, Wenqi Shao, Ping Luo | Github Papier | |

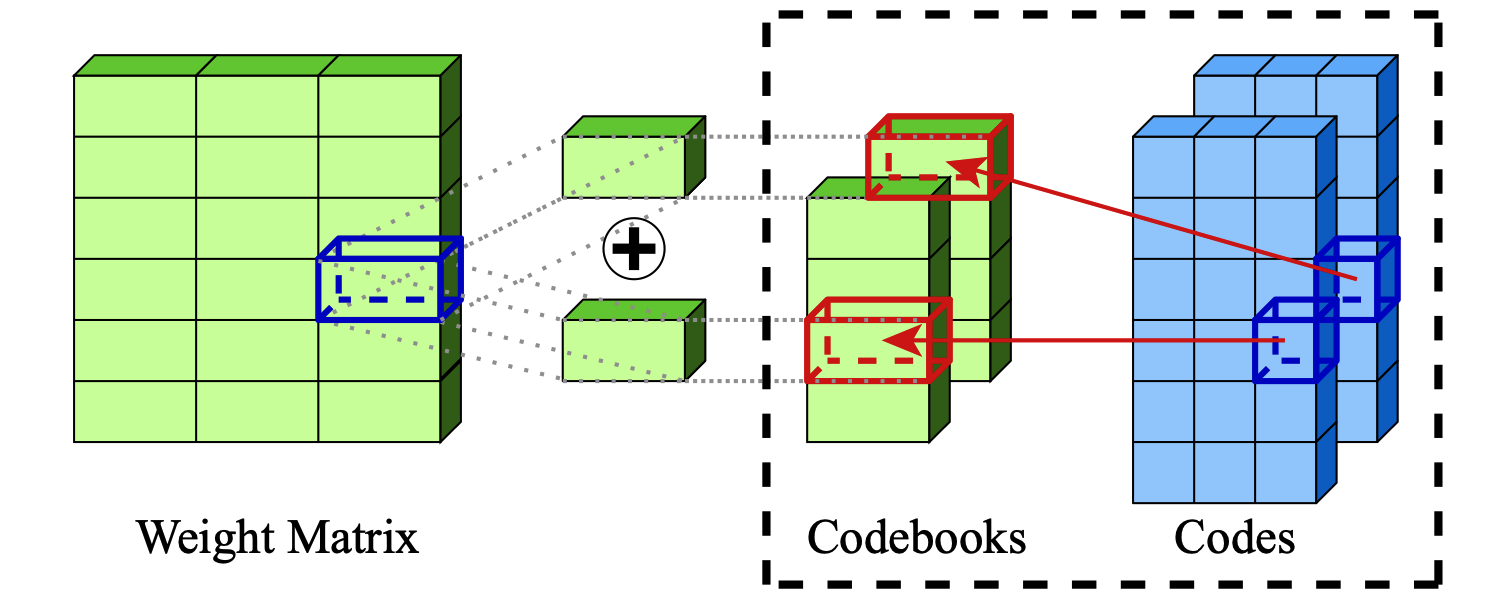

Extreme Komprimierung großer Sprachmodelle durch additive Quantisierung Vage Egiazarian, Andrei Panferov, Denis Kuznedelev, Elias Frantar, Artem Billenko, Dan Alistarh |  | Github Papier |

| Skalierungsgesetze für die gemischte Quantisierung in Großsprachenmodellen Zeyu Cao, Cheng Zhang, Pedro Gimenes, Jianqiao Lu, Jianyi Cheng, Yiren Zhao |  | Papier |

| Palmbench: Ein umfassender Benchmark für komprimierte Großsprachenmodelle auf mobilen Plattformen Yilong Li, Jingyu Liu, Hao Zhang, M Badri Narayanan, Utkarsh Sharma, Shuai Zhang, Pan Hu, Yijing Zeng, Jayaram Raghuram, Suman Banerjee |  | Papier |

| Kreuzquerant: Eine Quantisierungsmethode nach dem Training mit kleinerem Quantisierungskern für präzise Großsprachenmodellkomprimierung Wenyuan Liu, Xindian MA, Peng Zhang, Yan Wang | Papier | |

| Sageattention: Genauige 8-Bit-Aufmerksamkeit für Plug-and-Play-Inferenzbeschleunigung Jintao Zhang, Jia Wei, Pengle Zhang, Jun Zhu, Jianfei Chen | Papier | |

| Addition ist alles, was Sie für energieeffiziente Sprachmodelle benötigen Hongyin Luo, Wei Sonne | Papier | |

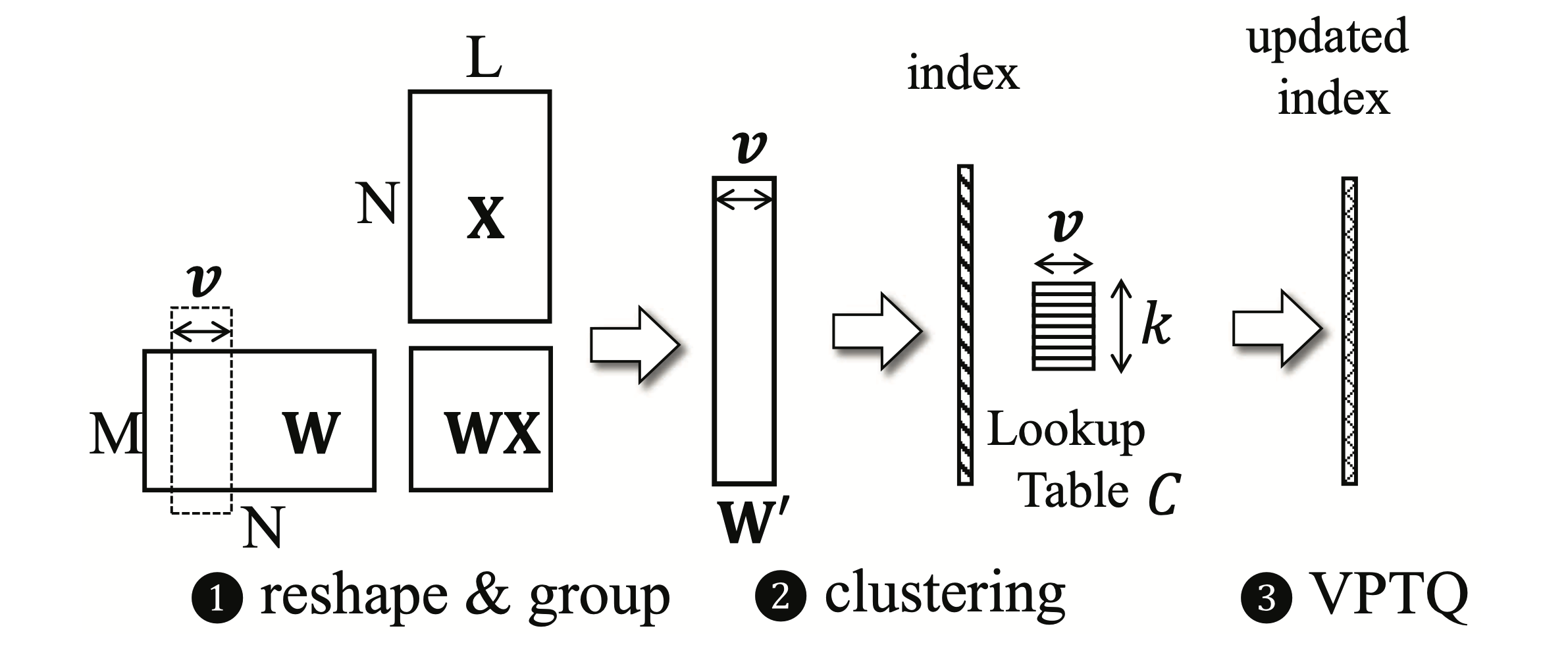

VPTQ: Extreme Niedrig-Bit-Vektor-Quantisierung für große Sprachmodelle nach dem Training Yifei Liu, Jicheng Wen, Yang Wang, Shengyu Ye, Li Lyna Zhang, Ting Cao, Cheng Li, Mao Yang |  | Github Papier |

INT-Flashattention: Ermöglichen Shimao Chen, Zirui Liu, Zhiying Wu, CE Zheng, Peizhuang Cong, Zihan Jiang, Yuhan Wu, Lei Su, Tong Yang | Github Papier | |

| Akkumulator-bewusstes Nachtraining-Quantisierung Ian Colbert, Fabian Grob, Giuseppe Franco, Jinjie Zhang, Rayan Saab | Papier | |

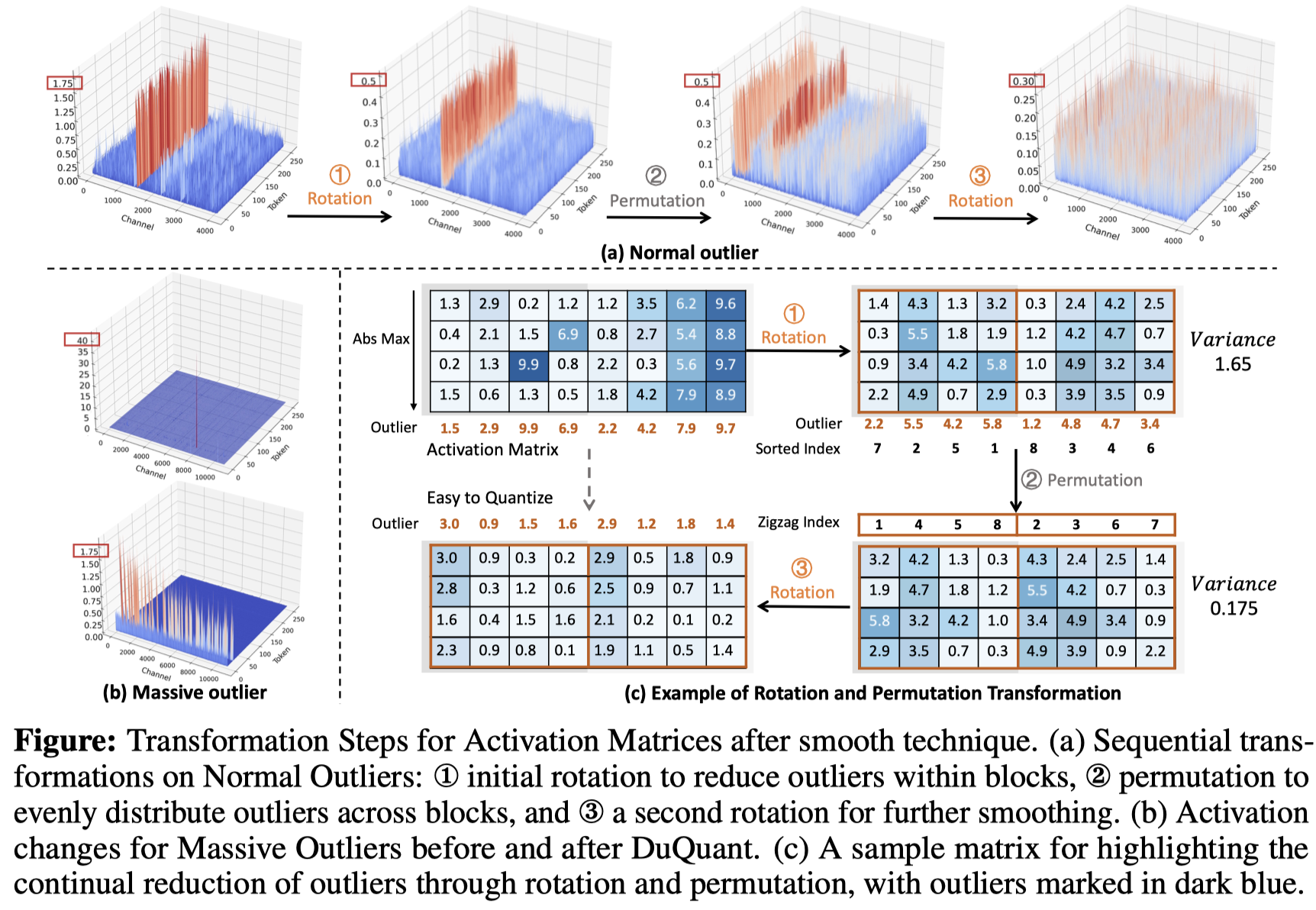

Duquant: Die Verteilung von Ausreißern über duale Transformation macht stärker quantisierte LLMs Haokun Lin, Haobo Xu, Yichen Wu, Jingzhi Cui, Yingtao Zhang, Linzhan Mou, Linqi Song, Zhenan Sun, Ying Wei |  | Github Papier |

| Eine umfassende Bewertung quantisierter modellierter modellanweisender großer Sprachmodelle: Eine experimentelle Analyse bis zu 405b Jemin Lee, Sihyeong Park, Jinse Kwon, Jihun OH, Yongin Kwon | Papier | |

| Die Einzigartigkeit von LLAMA3-70B mit pro-kanaler Quantisierung: Eine empirische Studie Minghai Qin | Papier |

| Titel & Autoren | Einführung | Links |

|---|---|---|

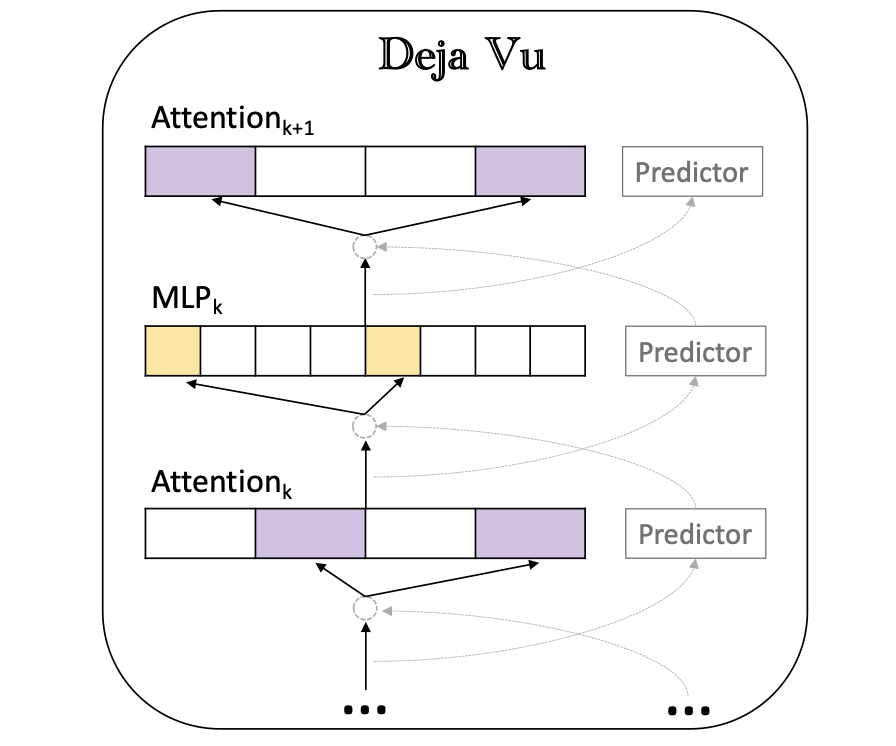

Deja Vu: Kontextsparsity für effiziente LLMs zur Inferenzzeit Zichang Liu, Jue Wang, Tri Dao, Tianyi Zhou, Binhang Yuan, Zhao -Lied, Anshumali Shrivastava, CE Zhang, Yuandong Tian, Christopher RE, Beidi Chen |  | Github Papier |

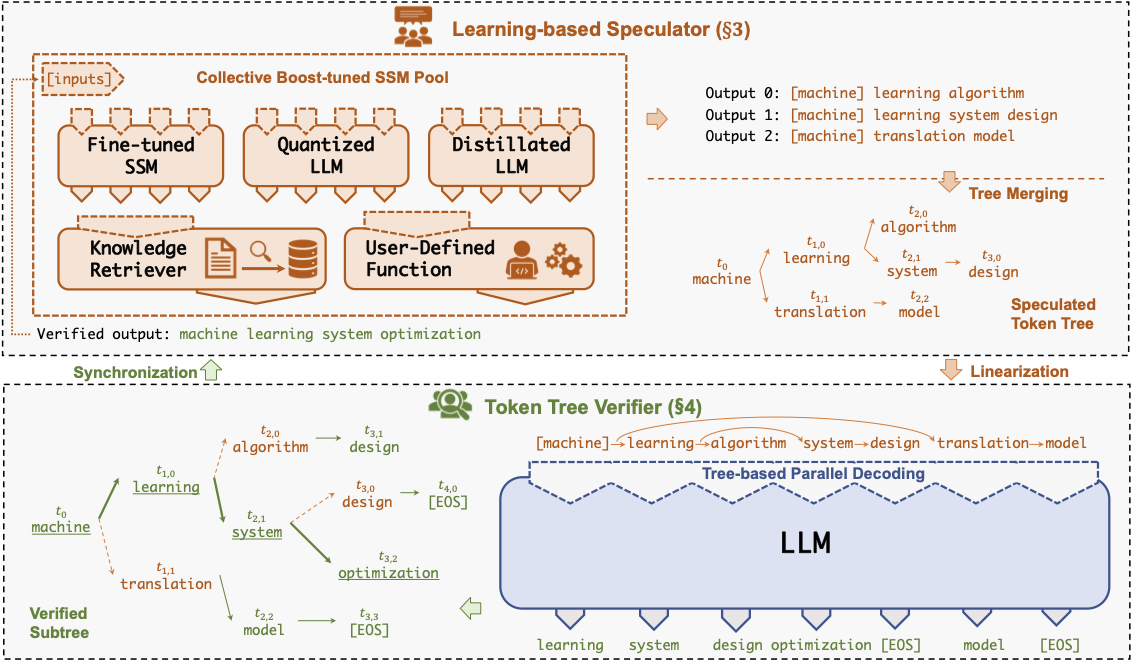

Specinfer: Beschleunigen generative LLM, die mit spekulativen Inferenz- und Tokenbaumverifizierung dient Xupeng Miao, Gabriele Oliaro, Zhihao Zhang, Xinhao Cheng, Zeyu Wang, Rae Ying Yee Wong, Zhuoming Chen, Daiyaan Arfeen, Reyna Abhyankar, Zhihao Jia |  | Github Papier |

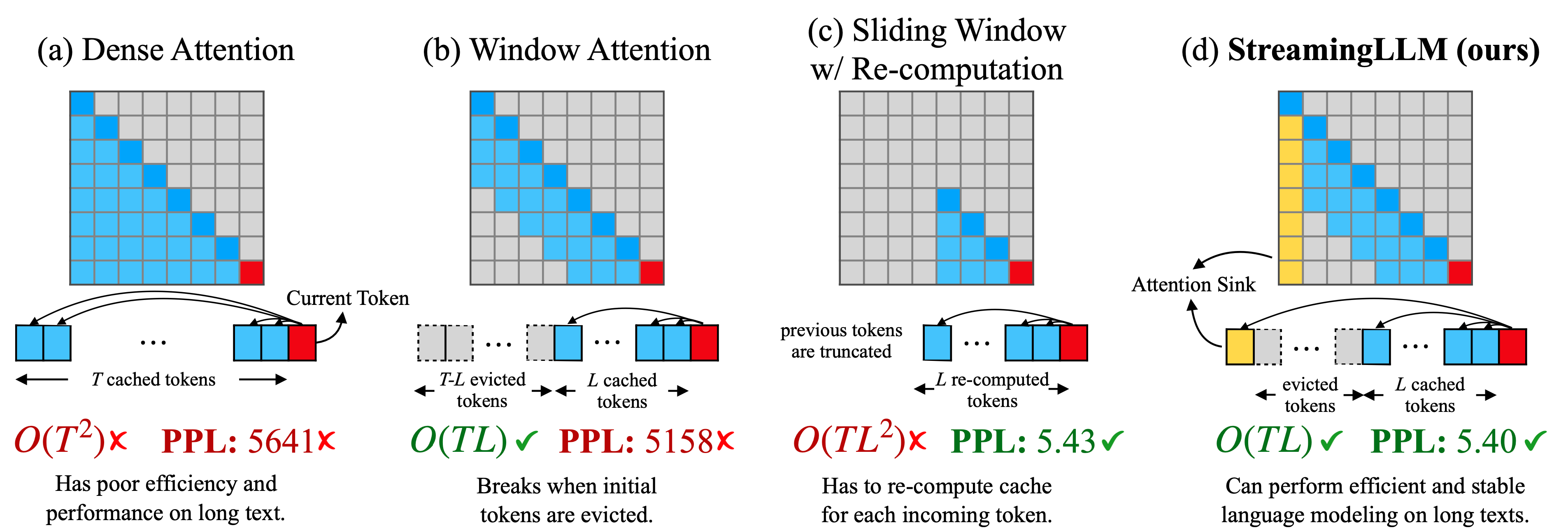

Effiziente Streaming -Sprachmodelle mit Aufmerksamkeits sinken Guangxuan Xiao, Yuandong Tian, Beidi Chen, Lied Han, Mike Lewis |  | Github Papier |

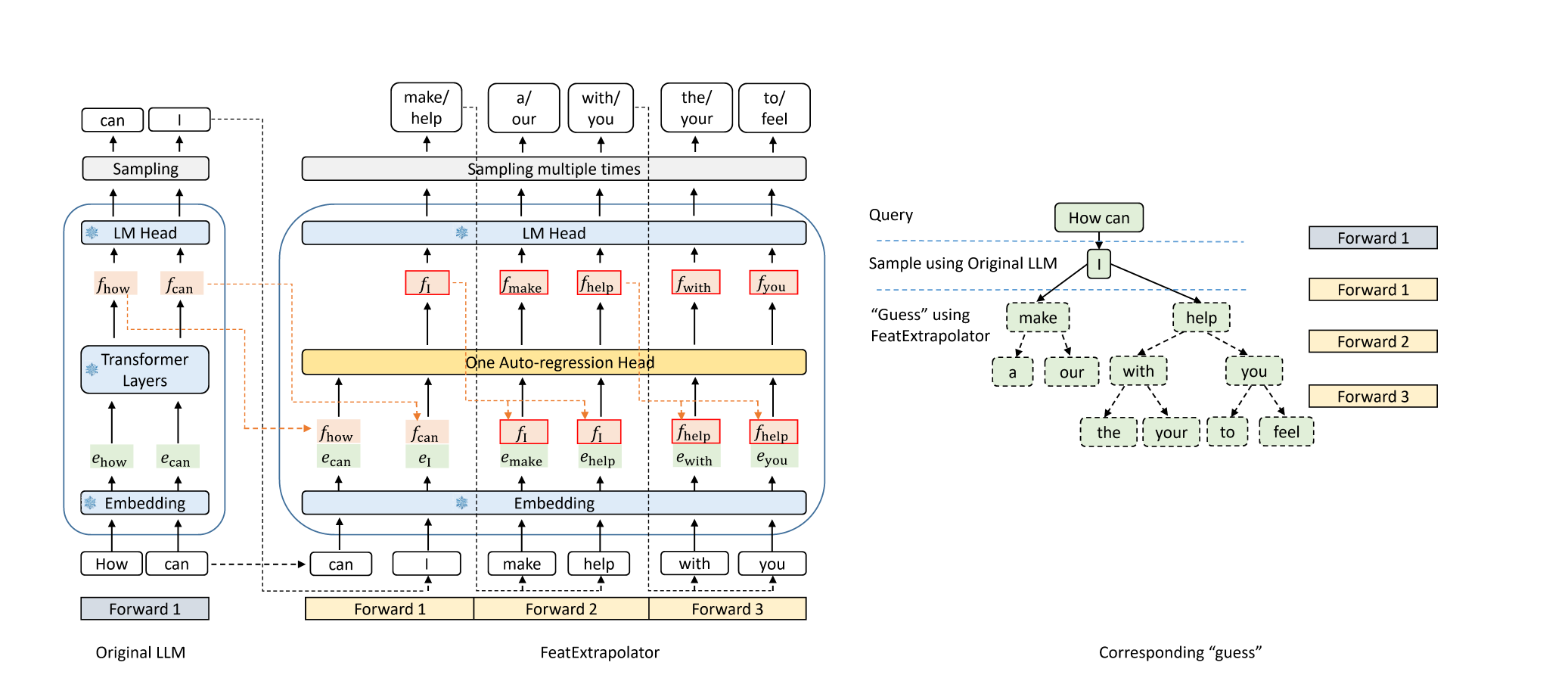

Adler: Verlustlose Beschleunigung der LLM -Decodierung durch Merkmalextrapolation Yuhui Li, Chao Zhang und Hongjang Zhang |  | Github Blog |

Medusa: Einfache LLM -Inferenzbeschleunigungs -Framework mit mehreren Dekodierungsköpfen Tianle Cai, Yuhong Li, Zhengyang Geng, Hongwu Peng, Jason D. Lee, Deming Chen, Tri Dao | Github Papier | |

| Spekulative Decodierung mit CTC-basierten Entwurfsmodell für LLM-Inferenzbeschleunigung Zhuofan Wen, Shangtong GUI, Yang Feng | Papier | |

| PLD+: Beschleunigung von LLM -Inferenz durch Nutzung von Sprachmodellartefakten Shwetha Somasundaram, Anirudh Phukan, Apoorv Saxena | Papier | |

FastDraft: So trainieren Sie Ihren Entwurf Ofir Zafrir, Igor Margulis, Dorin Shteyman, Guy Boudoukh | Papier | |

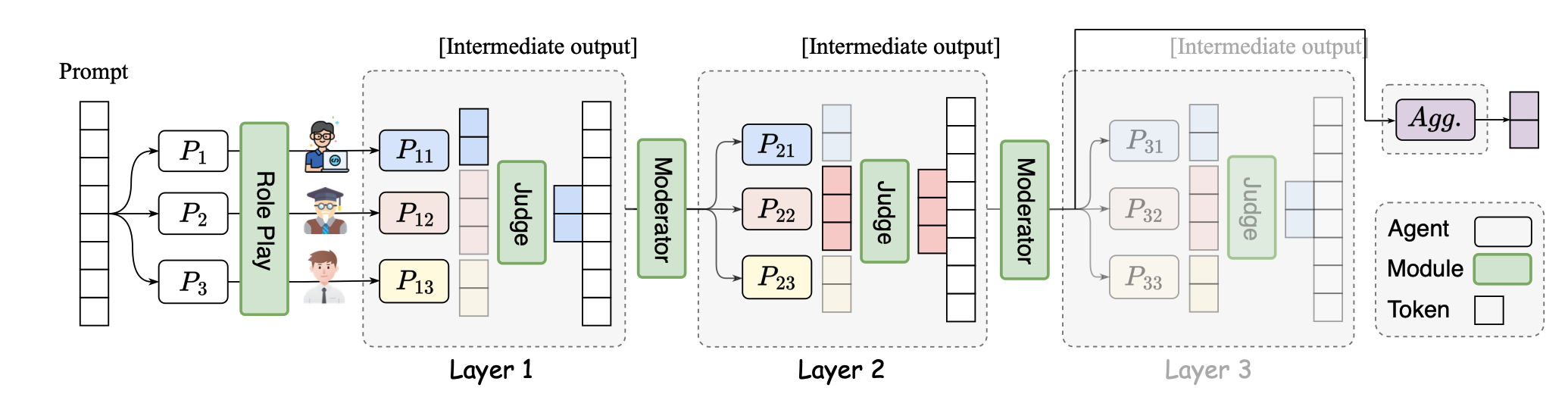

SMOA: Verbesserung von Großsprachenmodellen mit spärlicher Mischung von Agenten Dawei Li, Zhen Tan, Peijia Qian, Yifan Li, Kumar Satvik Chaudhary, Lijie Hu, Jiayi Shen |  | Github Papier |

| Das N-Grammys: Beschleunigung der autoregressiven Inferenz mit lernfreien Spekulationen Lawrence Stewart, Matthew Trager, Sujan Kumar Gonugondla, Stefano Soatto | Papier | |

| Beschleunigte KI -Inferenz über dynamische Ausführungsmethoden Haim Barad, Jascha Achterberg, Tien Pei Chou, Jean Yu | Papier | |

| SuffixDecoding: Ein modellfreier Ansatz zur Beschleunigung des großen Sprachmodellinferenz Gabriele Oliaro, Zhihao Jia, Daniel Campos, Aurick Qiao | Papier | |

| Dynamische Strategieplanung für eine effiziente Beantwortung von Großsprachmodellen für effiziente Frage Tanmay Parekh, Pradyot Prakash, Alexander Radovic, Akshay Shekher, Denis Savenkov | Papier | |

MagicPig: LSH -Probenahme für die effiziente LLM -Generation Zhuoming Chen, Ranajoy Sadhukhan, Zihao Ye, Yang Zhou, Jianyu Zhang, Niklas Nolte, Yuandong Tian, Matthijs Douze, Leon Bottou, Zhihao Jia, Beidi Chen | Github Papier | |

| Schnellere Sprachmodelle mit einer besseren Mehrfachvorhersage mithilfe der Tensor-Zerlegung Artem Basharin, Andrei Chertkov, Ivan Oseledets |  | Papier |

| Effiziente Schlussfolgerung für erweiterte Großsprachmodelle Rana Shahout, Cong Liang, Shiji Xin, Qianru Lao, Yong Cui, Minlan Yu, Michael Mitzenmacher | Papier | |

Dynamische Vokabularbeschnitten in frühen LLMs Jort Vincenti, Karim Abdel Sadek, Joan Velja, Matteo Nulli, Metod Jazbec |  | Github Papier |

CoreInfer: Beschleunigung von großer Sprachmodellinferenz mit semantisch inspirierter adaptiver spärlicher Aktivierung Qinsi Wang, Saeed Vahidian, Hancheng Ye, Jianyang Gu, Jianyi Zhang, Yiran Chen | Github Papier | |

DuoAttention: Effiziente Lontext-LLM-Inferenz mit Abruf- und Streaming-Köpfen Guangxuan Xiao, Jiaming Tang, Jingwei Zuo, Junxian Guo, Shang Yang, Haotian Tang, Yao Fu, Lied Han |  | Github Papier |

| Dyspec: schneller spekulative Decodierung mit dynamischer Tokenbaumstruktur Yunfan Xiong, Ruoyu Zhang, Yanzeng Li, Tianhao Wu, Lei Zou | Papier | |

| QSPEC: Spekulative Decodierung mit komplementären Quantisierungsschemata Juntao Zhao, Wenhao Lu, Sheng Wang, Lingpeng Kong, Chuan Wu | Papier | |

| TIDADECODE: Schnelle und genaue LLM -Dekodierung mit Position anhaltender spärlicher Aufmerksamkeit Lijie Yang, Zhihao Zhang, Zhuofu Chen, Zikun Li, Zhihao Jia | Papier | |

| Parallelspec: Parallele Verfasser für eine effiziente spekulative Dekodierung Zilin Xiao, Hongming Zhang, Tao GE, Siru Ouyang, Vicente Ordonez, Dong Yu | Papier | |

Swift: Selbstspezifische Dekodierung im Fliege für LLM-Inferenzbeschleunigung Heming Xia, Yongqi Li, Jun Zhang, Cunxiao du, Wenjie Li |  | Github Papier |

Turborag: Beschleunigung der abträgigen Generation mit vorberechtigtem KV-Caches für Tischtext Songshuo Lu, Hua Wang, Yutian Rong, Zhi Chen, Yaohua Tang |  | Github Papier |

| Ein wenig geht ein langer Weg: effizientes langes Kontexttraining und Schluss Suyu Ge, Xihui Lin, Yunan Zhang, Jiawei Han, Hao Peng | Papier | |

| Mnemosyne: Parallelisierungsstrategien zur effizienten Dienste von mehreren Millionen Kontextlängen LLM-Inferenzanfragen ohne Annäherungen Amey Agrawal, Junda Chen, íñigo goiri, Ramachandran Ramjee, Chaojie Zhang, Alexey Tumanov, Esha Choukse | Papier | |

Entdecken Sie die Edelsteine in frühen Schichten: Beschleunigung von LLMs mit langer Kontext mit 1000-facher Eingangs-Token-Reduktion Zhenmei Shi, Yifei Ming, Xuan-Phi Nguyen, Yingyu Liang, Shafiq Joty | Github Papier | |

| Spekulative Strahldecodierung der Dynamikbreite für eine effiziente LLM-Inferenz Zongyue Qin, Zifan HE, Neha Prakriya, Jason Cong, Yizhou Sun | Papier | |

Kritik: Ein segment- und kritisch-basierter Ansatz für die Vorabbeschleunigung in LLMs Junlin LV, Yuan Feng, Xike Xie, Xin Jia, Qirong Peng, Guiming Xie | Github Papier | |

| Abrufung: Beschleunigung von Lontext-LLM-Inferenz durch Vektor-Abruf beschleunigt Di liu, Meng Chen, Baotong Lu, Huiqiang Jiang, Zhenhua Han, Qianxi Zhang, Qi Chen, Chengruidong Zhang, Bailu Ding, Kai Zhang, Chen Chen, Fan Yang, Yuqing Yang, Lili Qiu | Papier | |

Sirius: Kontextsparalität mit Korrektur für effiziente LLMs Yang Zhou, Zhuoming Chen, Zhaozhuo Xu, Victoria Lin, Beidi Chen | Github Papier | |

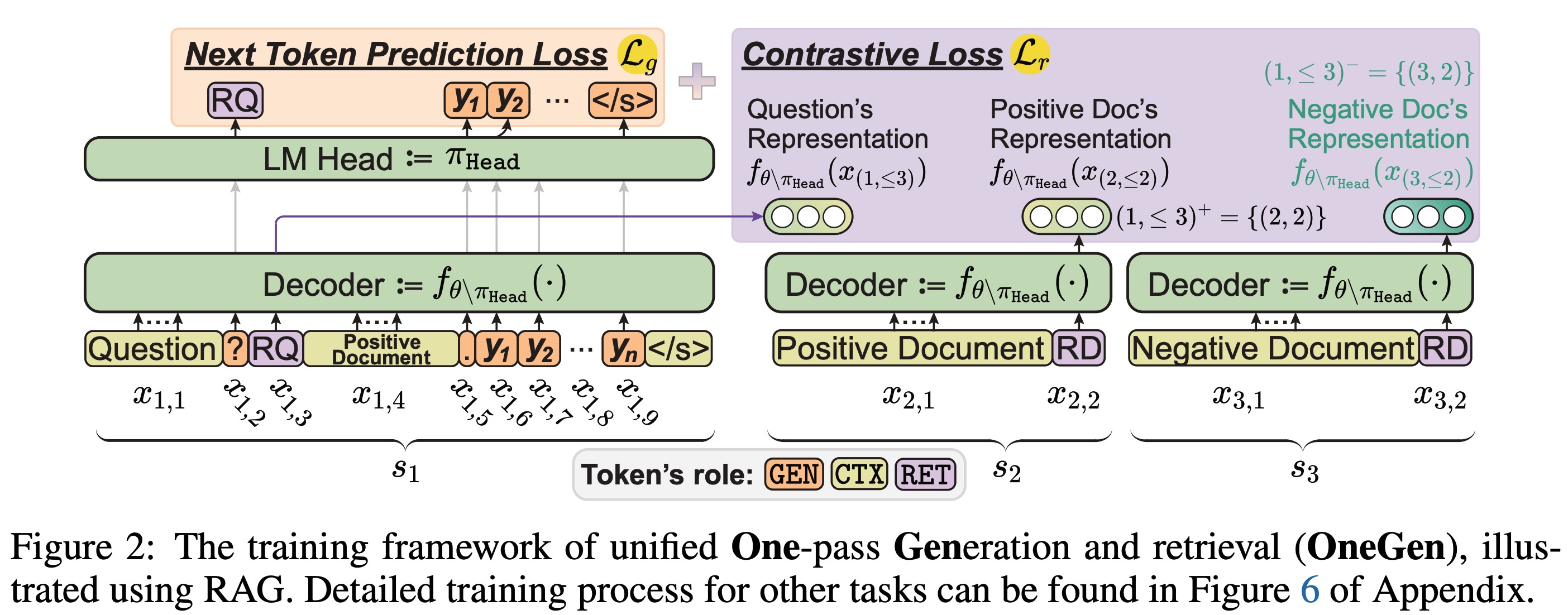

Einengen: Effiziente Ein-Pass-Einheitserzeugung und -abruf für LLMs Jintian Zhang, Cheng Peng, Mengshu Sun, Xiang Chen, Lei Liang, Zhiqiang Zhang, Jun Zhou, Huajun Chen, Ningyu Zhang |  | Github Papier |

| Pfadkonsistenz: Präfixverstärkung für eine effiziente Inferenz in LLM Jiace Zhu, Yingtao Shen, Jie Zhao, ein Zou | Papier | |

| Steigerung der verlustfreien spekulativen Decodierung durch Merkmalsabtastung und teilweise Ausrichtung Destillation Lujun GUI, bin Xiao, Lei Su, Weipg Chen | Papier |

| Titel & Autoren | Einführung | Links |

|---|---|---|

Schnelle Inferenz von Sprachmodellen der Experten mit Ausladung Artyom Eliseev, Denis Mazur |  | Github Papier |

Kondenslich, nicht nur beschnitten: Effizienz und Leistung beim MOE -Schicht -Beschneiden verbessern Mingyu Cao, Gen Li, Jie Ji, Jiaqi Zhang, Xiaolong MA, Shiwei Liu, Lu Yin | Github Papier | |

| Mischung aus Cache-konditionellen Experten für eine effiziente Inferenz für Mobilgeräte Andrii Skliar, Krawatten van Rozendaal, Romain Lepert, Todor Boinovski, Mart Van Baalen, Markus Nagel, Paul wie | Papier | |

Monta: Beschleunigungsmischung der Experten mit netzwerktraffc-bewusster paralleler Optimierung Jingming Guo, Yan Liu, Yu Meng, Zhiwei Tao, Banglan Liu, Gang Chen, Xiang Li | Github Papier | |

MOE-I2: Komprimierungsmisch Cheng Yang, Yang Sui, Jinqi Xiao, Lingyi Huang, Yu Gong, Yuanlin Duan, Wenqi Jia, Miao Yin, Yu Cheng, Bo Yuan | Github Papier | |

| Hobbit: Ein gemischtes Präzisionsexperten -Ausladungssystem für schnelle MOE -Inferenz Peng Tang, Jiachen Liu, Xiaofeng Hou, Yifei Pu, Jing Wang, Pheng-Ann Heng, Chao Li, Minyi Guo | Papier | |

| Promoe: Fast MOE-basierte LLM serviert mit proaktivem Caching Xiaoniu Song, Zihang Zhong, Rong Chen | Papier | |

| Expertenflow: Optimierte Expertenaktivierung und Tokenallokation für eine effiziente Inferenzmischung der Experten Xin He, Shunkang Zhang, Yuxin Wang, Haiyan Yin, Zihao Zeng, Shaohuai Shi, Zhenheng Tang, Xiaowen Chu, Ivor Tsang, Ong Yew bald | Papier | |

| EPS-MOE: Experten-Pipeline-Scheduler für kosteneffiziente MOE-Inferenz Yulei Qian, Fengcun Li, Xiangyang Ji, Xiaoyu Zhao, Jianchao Tan, Kefeng Zhang, Xunliang Cai | Papier | |

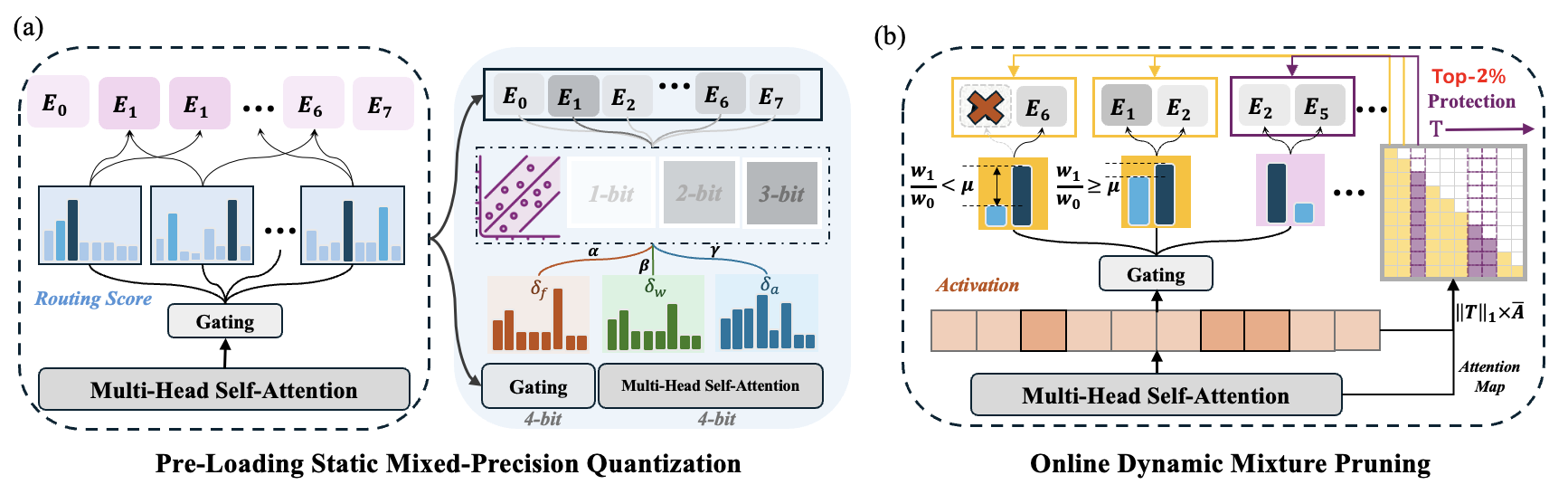

MC-MOE: Mischkompressor für Mischung von Experten LLMs Gewinne mehr Gewinne Wei Huang, Yue Liao, Jianhui Liu, Ruifeei He, Haoru Tan, Shiming Zhang, Hongsheng Li, Si Liu, Xiaojuan Qi |  | Github Papier |

| Titel & Autoren | Einführung | Links |

|---|---|---|

Mobillama: Auf dem Weg zu genauem und leichtem voll transparentem GPT Omkar Thawakar, Ashmal Vayani, Salman Khan, Hisham Cholakal, Rao M. Anwer, Michael Felsberg, Tim Baldwin, Eric P. Xing, Fahad Shahbaz Khan |  | Github Papier Modell |

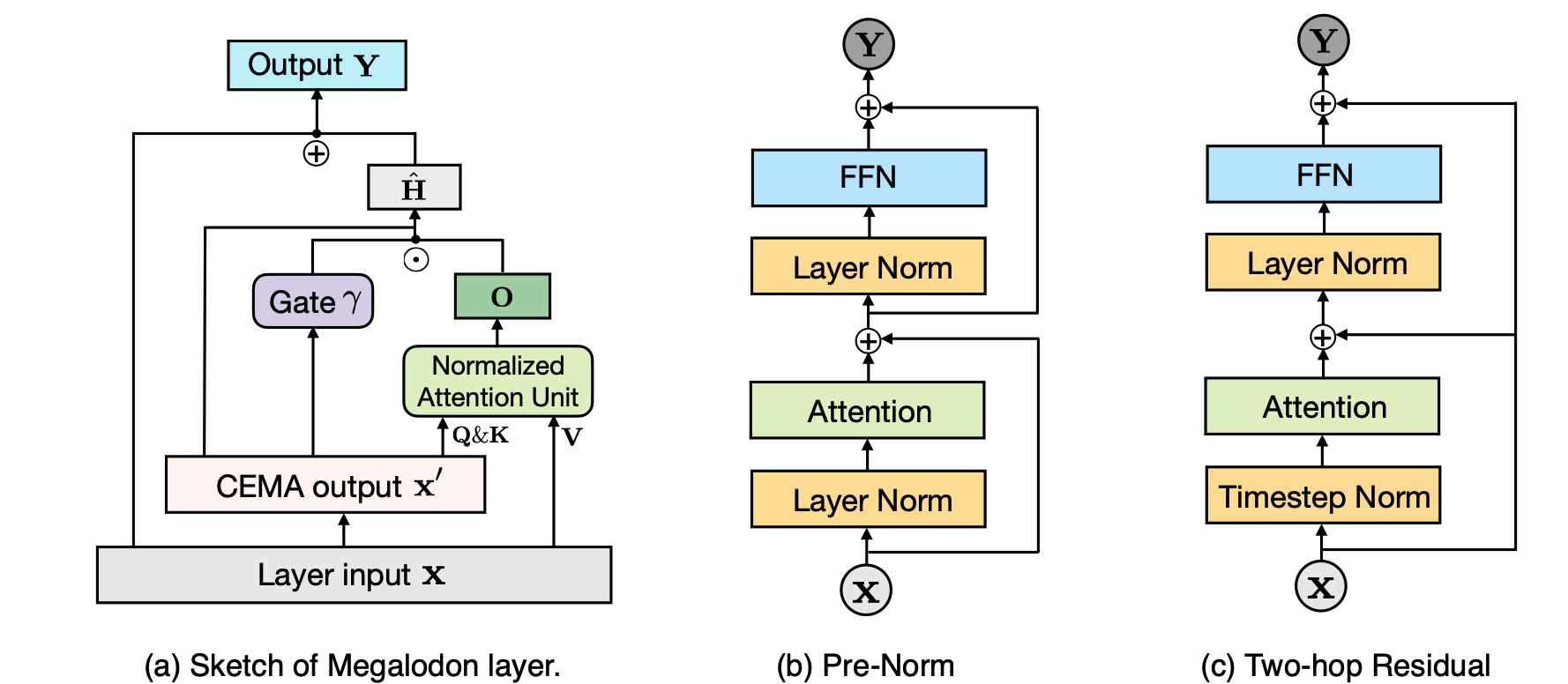

Megalodon: Effizientes LLM -Vorbau und Schlussfolgerung mit unbegrenzter Kontextlänge Xuezhe MA, Xiaomeng Yang, Wenhan Xiong, Beidi Chen, Lili Yu, Hao Zhang, Jonathan May, Luke Zettlemoyer, Omer Levy, Chunting Zhou |  | Github Papier |

| Taipan: Effiziente und ausdrucksstarke Raumsprachenmodelle mit selektiver Aufmerksamkeit Chien van Nguyen, Huy Huu Nguyen, Thang M. Pham, Ruiyi Zhang, Hanieh Deilamsalehy, Puneet Mathur, Ryan A. Rossi, Trung Bui, Viet Dac Lai, Franck Dernoncourt, Thien Huu Nguyen | Papier | |

Seherschaft: Intrinsische spärliche Aufmerksamkeit in Ihren LLMs lernen Yizhao Gao, Zhichen Zeng, Dayou du, Shijie Cao, Hayden Kwok-Hay SO, Ting Cao, Fan Yang, Mao Yang | Github Papier | |

Basisfreigabe: Verschleppungsparameterfreigabe für die Komprimierung des Modells in großer Sprache Jingcun Wang, Yu-Guang Chen, Ing-Chao Lin, Bing Li, Grace Li Zhang | Github Papier | |

| Rodimus*: Der Kompromiss der Genauigkeitseffizienz mit effizienten Aufmerksamkeit Zhihao er, hänge yu, zi gong, shizhan liu, jiangguo li, weiyao lin | Papier |

| Titel & Autoren | Einführung | Links |

|---|---|---|

| Das Modell sagt Ihnen, was zu verwerfen ist: adaptive KV -Cache -Komprimierung für LLMs Suyu Ge, Yunan Zhang, Liyuan Liu, Minjia Zhang, Jiawei Han, Jianfeng Gao |  | Papier |

| Clusterkv: Manipulation von LLM -KV -Cache im semantischen Raum für die Rückrufkomprimierung Guangda Liu, Chengwei Li, Jieru Zhao, Chenqi Zhang, Minyi Guo | Papier | |

| Vereinheitliche KV -Cache -Komprimierung für Großsprachmodelle mit LeanKV Yanqi Zhang, Yuwei Hu, Runyuan Zhao, John CS Lui, Haibo Chen | Papier | |

| Komprimierung des KV-Cache für langkontext-LLM-Inferenz mit Ähnlichkeit zwischen den Schichten mit der Aufmerksamkeit zwischen den Schichten Da Ma, Lu Chen, situo Zhang, Yuxun Miao, Su Zhu, Zhi Chen, Hongshen Xu, Hanqi Li, Shuai -Fan, Lei Pan, Kai Yu | Papier | |

| Minikv: Drücken Sie die Grenzen der LLM-Inferenz über 2-Bit-Schicht-diskriminierende KV-Cache Akshat Sharma, Hangliang Ding, Jianping Li, Neel Dani, Minjia Zhang | Papier | |

| TokenSelect: Effiziente Langkontextinferenz und Längenextrapolation für LLMs über Dynamic Token-Level-KV-Cache-Auswahl Wei Wu, Zhuoshi Pan, Chao Wang, Liyi Chen, Yunchu Bai, Kun Fu, Zheng Wang, Hui Xiong | Papier | |

Nicht alle Köpfe sind wichtig: eine KV-Cache-Komprimierungsmethode auf Kopfhöhe mit integriertem Abruf und Argumentation Yu Fu, Zefan Cai, ABEDELKADIR ASI, WAYNE XIONG, YUE DONG, WEN XIAO |  | Github Papier |

Buzz: Beehive-strukturiertes spärliches KV-Cache mit segmentierten schweren Schlägern für eine effiziente LLM-Inferenz Junqi Zhao, Zhijin Fang, Shu Li, Shaohui Yang, Shichao er | Github Papier | |

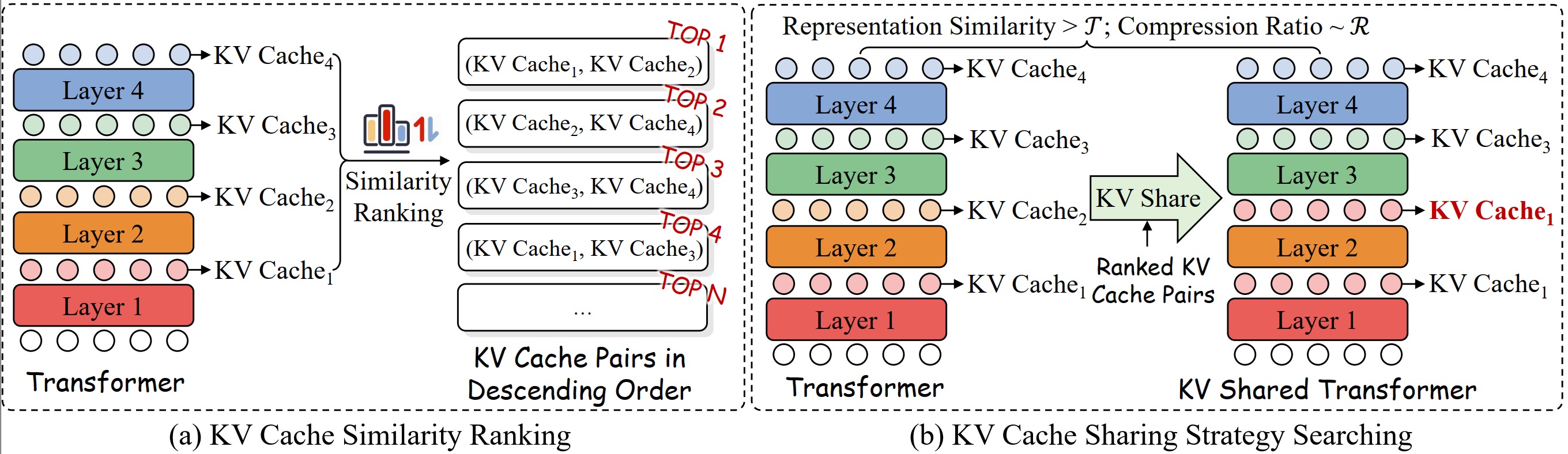

Eine systematische Untersuchung des KV-Teilens der Verschleppung für eine effiziente LLM-Inferenz Sie Wu, Haoyi Wu, Kewei Tu |  | Github Papier |

| Verlustlose KV -Cache -Komprimierung auf 2% Zhen Yang, Jnhan, Kan Wu, Ruobing Xie, ein Wang, Xingwu Sun, Zhanhui Kang | Papier | |

| Matryoshkakv: adaptive KV -Komprimierung durch trainierbare orthogonale Projektion Bokai Lin, Zihao Zeng, Zipeng Xiao, Siqi Kou, Tianqi Hou, Xiaofeng Gao, Hao Zhang, Zhijie Deng | Papier | |

Restvektorquantisierung für die KV -Cache -Komprimierung im Großsprachenmodell Ankur Kumar | Github Papier | |

KVSHARER: Effiziente Inferenz über schichtweise unterschiedlicher KV-Cache-Sharing Yifei Yang, Zouying Cao, Qiguang Chen, Libo Qin, Dongjie Yang, Hai Zhao, Zhi Chen |  | Github Papier |

| LORC: Niedrige Komprimierung für LLMS-KV-Cache mit einer progressiven Komprimierungsstrategie Rongzhi Zhang, Kuang Wang, Liyuan Liu, Shuohang Wang, Hao Cheng, Chao Zhang, Yelong Shen |  | Papier |

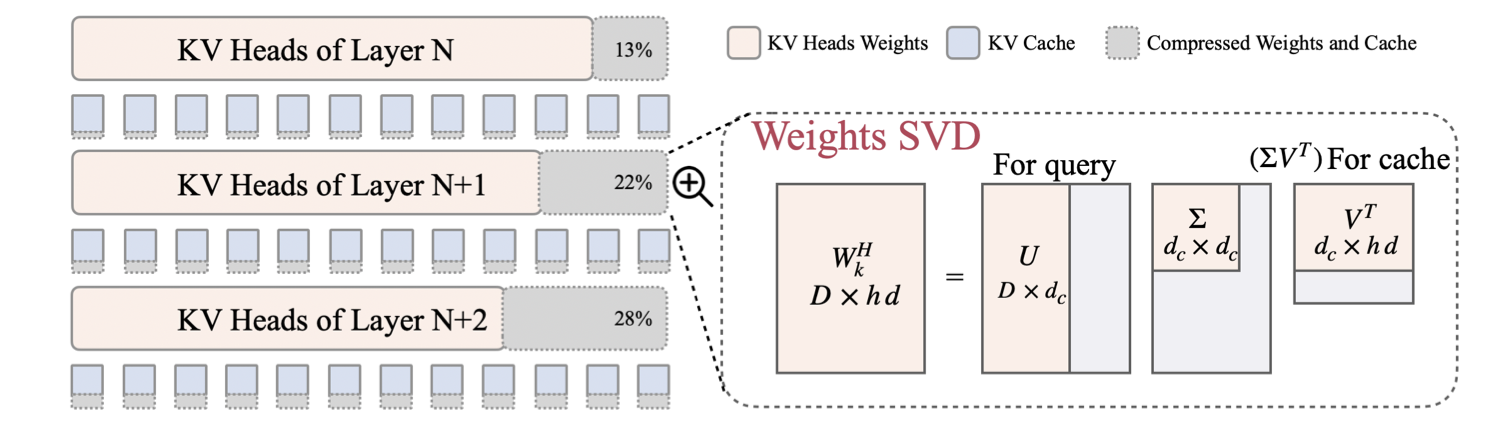

| SWIRKKV: Schnelloptimierte Inferenz mit Wissensverschreibungsmodelltransformation Aurick Qiao, Zhewe Yao, Samyam Rajbhandari, Yuxiong He | Papier | |

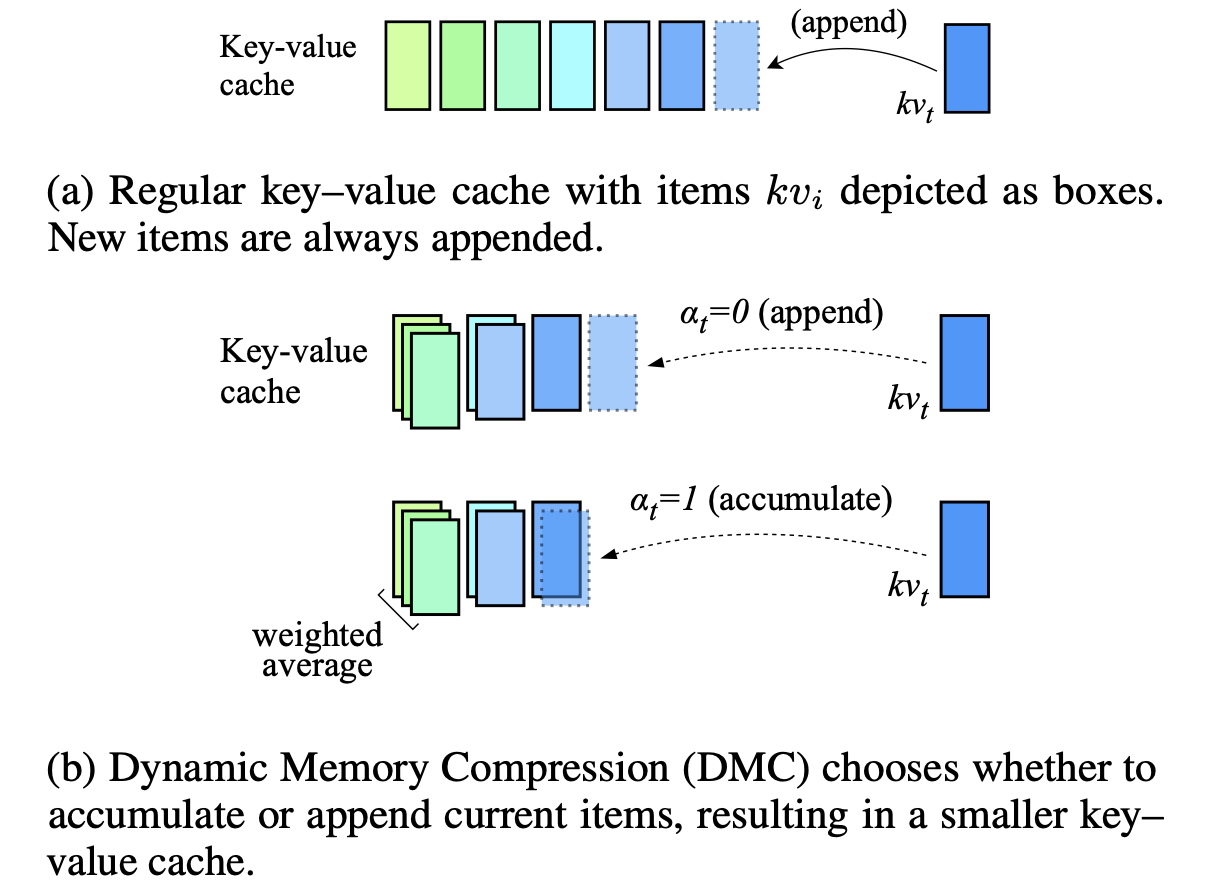

Dynamische Speicherkomprimierung: Nachrüsten von LLMs für beschleunigte Inferenz Piotr Nawrot, Adrian łańcucki, Marcin Chochowski, David Tarjan, Edoardo M. Ponti |  | Papier |

| KV-Kompress: PAGED KV-CACHE-Komprimierung mit variablen Komprimierungsraten pro Aufmerksamkeitskopf Isaac Rehg | Papier | |

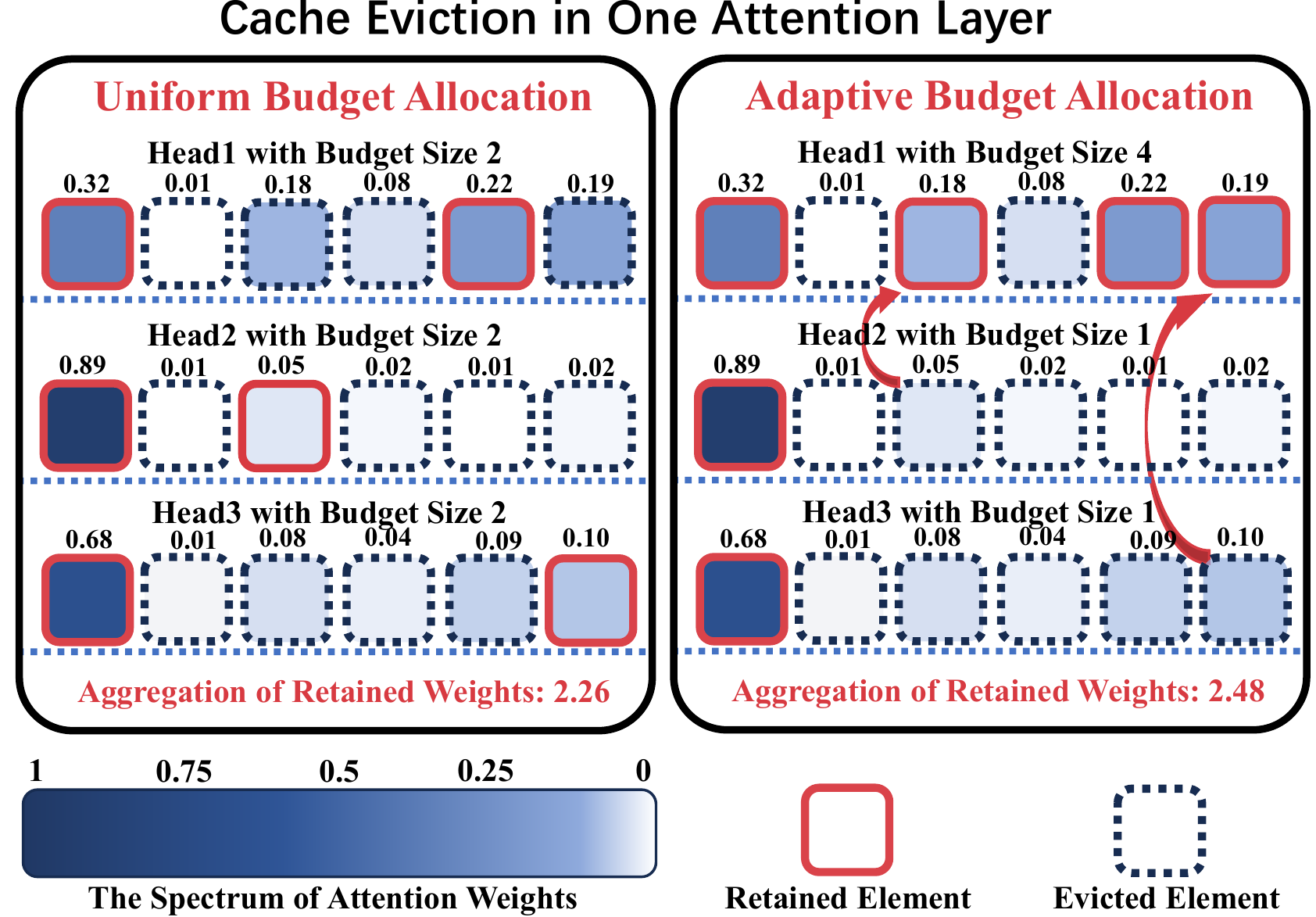

ADA-KV: Optimierung der KV-Cache-Räumung durch adaptive Budgetzuweisung für eine effiziente LLM-Inferenz Yuan Feng, Junlin LV, Yukun Cao, Xike Xie, S. Kevin Zhou |  | Github Papier |

AlignedKV: Reduzierung des Speicherzugriffs von KV-Cache mit präzisionsgerichteter Quantisierung Yifan Tan, Haoze Wang, Chao Yan, Yangdong Deng | Github Papier | |

| CSKV: Training-effizientes Kanal schrumpft für KV-Cache in Langkontext-Szenarien Luning Wang, Shiyao Li, Xuefei Ning, Zhihang Yuan, Shengen Yan, Guohao Dai, Yu Wang | Papier | |

| Ein erster Blick auf eine effiziente und sichere LLM-Inferenz für das Gerät gegen KV-Leckage Huan Yang, Deyu Zhang, Yudong Zhao, Yuanchun Li, Yunxin Liu | Papier |

| Titel & Autoren | Einführung | Links |

|---|---|---|

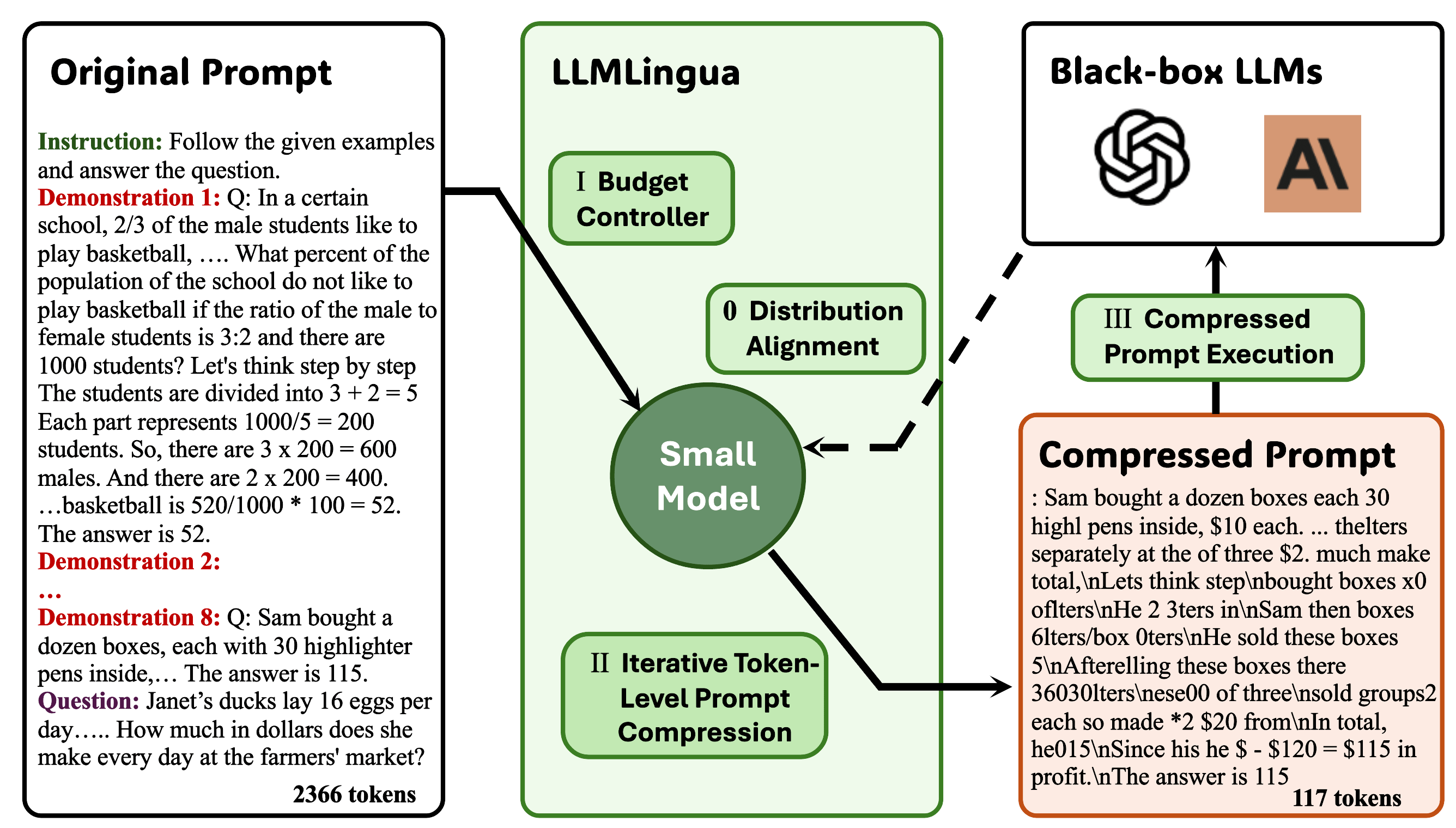

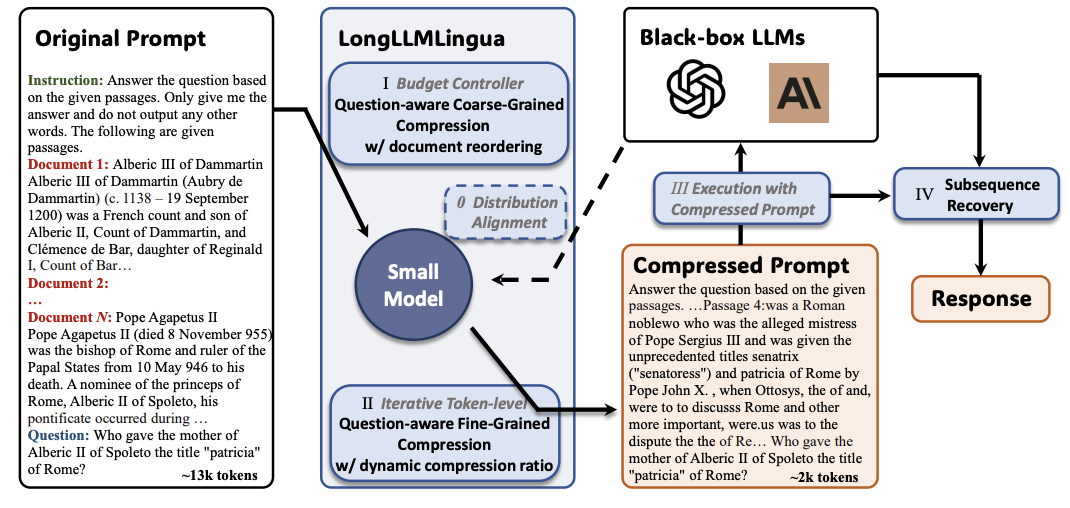

Llmlingua: Komprimierende Eingabeaufforderungen für beschleunigte Inferenz von großsprachigen Modellen Huiqiang Jiang, Qianhui Wu, Chin-Yew Lin, Yuqing Yang, Lili Qiu |  | Github Papier |

Longllmlingua: Beschleunigen und Verbesserung von LLMs in langen Kontextszenarien durch schnelle Komprimierung Huiqiang Jiang, Qianhui Wu, Xufang Luo, Dongsheng Li, Chin-Yew Lin, Yuqing Yang, Lili Qiu |  | Github Papier |

| JPPO: Gemeinsame Leistung und sofortige Optimierung für beschleunigte Großsprachenmodelldienste Feiran du, Hongyang du, Kaiibin Huang, Abbas Jamalipour | Papier | |

Generative Kontextdestillation Haebin Shin, Lei Ji, Yeyun Gong, Sungdong Kim, Eunbi Choi, Minjoon Seo |  | Github Papier |

Multitok: Tokenisierung variabler Länge für effiziente LLMs, die aus der LZW-Komprimierung angepasst sind Noel Elias, Homa Esfahanizadeh, Kaan Kale, Sriram Vishwanath, Muriel Medard | Github Papier | |

Selektion-P: Selbstbewertetes task-agnostische Druckkomprimierung für Treue und Übertragbarkeit Tsz Ting Chung, Leyang Cui, Lemao Liu, Xinting Huang, Shuming Shi, Dit-Yan Yeung | Papier | |

Vom Lesen bis zum Komprimieren: Erkundung des Multi-Dokument-Lesers für die schnelle Komprimierung Eunseong Choi, Sunkyung Lee, Minjin Choi, June Park, Jongwuk Lee | Papier | |

| Wahrnehmungskompressor: Eine trainingfreie Eingabeaufforderung-Komprimierungsmethode in langen Kontextszenarien Jiwei Tang, Jin Xu, Tingwei Lu, Hai Lin, Yiming Zhao, Hai-Tao Zheng | Papier | |

Finezip: Schieben Sie die Grenzen großer Sprachmodelle für die praktische verlustfreie Textkomprimierung Fazal Mittu, Yihuan Bu, Akshat Gupta, Ashok Devireddy, Alp Eren Ozdarendeli, Anant Singh, Gopala Anumanchipalli | Github Papier | |

Bäume analysieren LLM -LLM -Eingabeaufforderungkomprimierung Wenhao Mao, Chengbin Hou, Tianyu Zhang, Xinyu Lin, Ke Tang, Hairong Lv | Github Papier | |

Alphazip: Neuronales Netzwerk verstärkt verlustfreier Textkomprimierung Swathi Shree Narashiman, Nitin Chandrachoodan | Github Papier | |

| TACO-RL: Aufgabe bewusst eine schnelle Komprimierungsoptimierung mit Verstärkungslernen Shivam Shandilya, Mengel Xia, Supriyo Ghosh, Huiqiang Jiang, Jue Zhang, Qianhui Wu, Victor Rühle | Papier | |

| Effiziente LLM -Kontextdestillation Rajesh upadhayayaya, Zachary Smith, Chritopher Kottmyer, Manish Raj Osti | Papier | |

Verbesserung und Beschleunigung von großsprachigen Modellen durch unterrichtsbewusste kontextbezogene Komprimierung Haowen Hou, Fei MA, Binwen Bai, Xinxin Zhu, Fei Yu | Github Papier |

| Titel & Autoren | Einführung | Links |

|---|---|---|

Natürliches Allgemeine: In Hiene für ein speicheres effizientes LLM-Training und die Feinabstimmung beschleunigen Arijit Das | Github Papier | |

| Kompakt: Komprimierte Aktivierungen für das speichereffiziente LLM-Training Yara Shamshoum, Nitzan Hodos, Yuval Sieradzki, Assaf Schuster | Papier | |

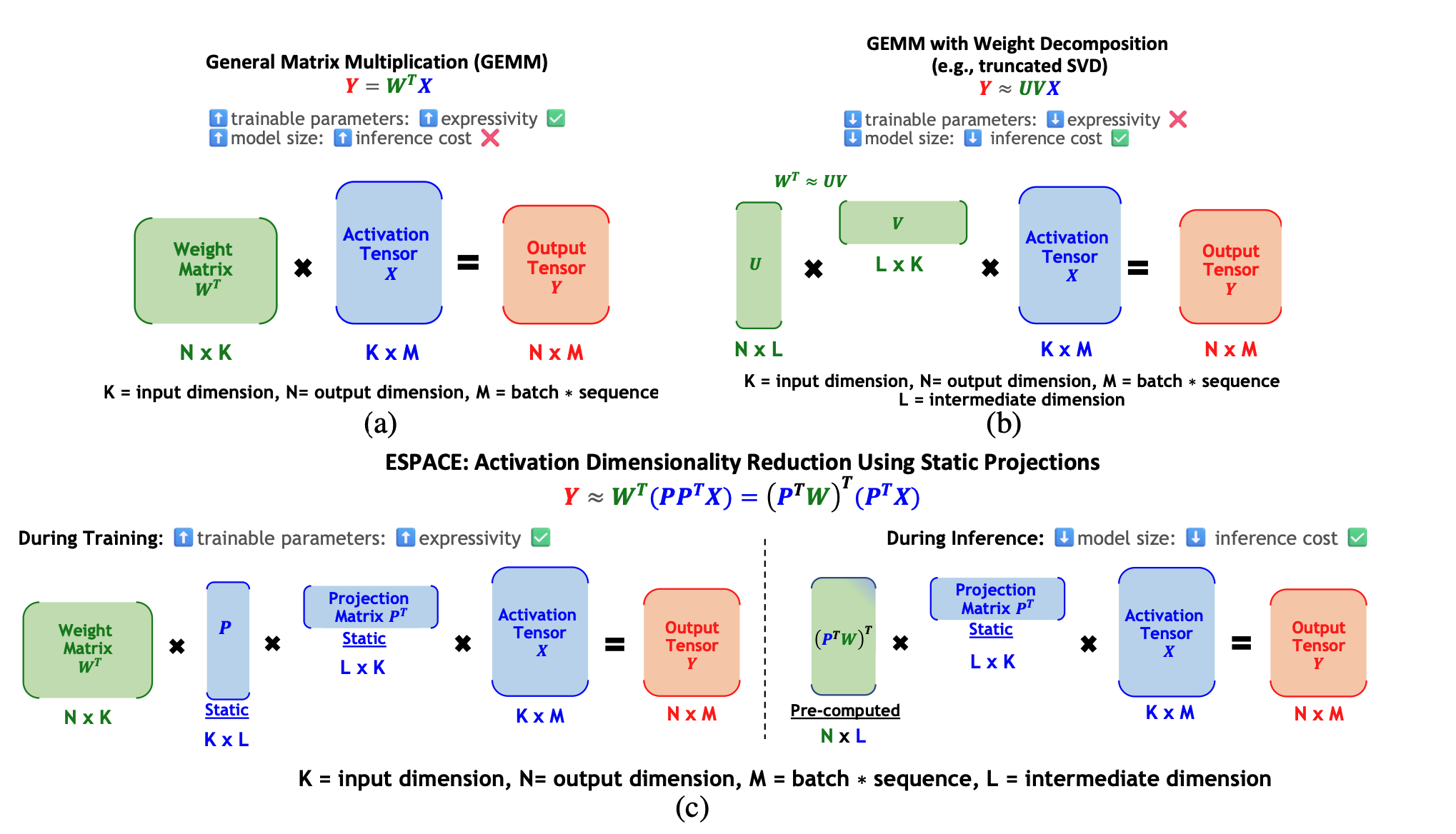

ESPACE: Dimensionality Reduction of Activations for Model Compression Charbel Sakr, Brucek Khailany |  | Papier |

| Title & Authors | Einführung | Links |

|---|---|---|

| FastSwitch: Optimizing Context Switching Efficiency in Fairness-aware Large Language Model Serving Ao Shen, Zhiyao Li, Mingyu Gao | Papier | |

| CE-CoLLM: Efficient and Adaptive Large Language Models Through Cloud-Edge Collaboration Hongpeng Jin, Yanzhao Wu | Papier | |

| Ripple: Accelerating LLM Inference on Smartphones with Correlation-Aware Neuron Management Tuowei Wang, Ruwen Fan, Minxing Huang, Zixu Hao, Kun Li, Ting Cao, Youyou Lu, Yaoxue Zhang, Ju Ren | Papier | |

ALISE: Accelerating Large Language Model Serving with Speculative Scheduling Youpeng Zhao, Jun Wang | Papier | |

| EPIC: Efficient Position-Independent Context Caching for Serving Large Language Models Junhao Hu, Wenrui Huang, Haoyi Wang, Weidong Wang, Tiancheng Hu, Qin Zhang, Hao Feng, Xusheng Chen, Yizhou Shan, Tao Xie | Papier | |

SDP4Bit: Toward 4-bit Communication Quantization in Sharded Data Parallelism for LLM Training Jinda Jia, Cong Xie, Hanlin Lu, Daoce Wang, Hao Feng, Chengming Zhang, Baixi Sun, Haibin Lin, Zhi Zhang, Xin Liu, Dingwen Tao | Papier | |

| FastAttention: Extend FlashAttention2 to NPUs and Low-resource GPUs Haoran Lin, Xianzhi Yu, Kang Zhao, Lu Hou, Zongyuan Zhan et al | Papier | |

| POD-Attention: Unlocking Full Prefill-Decode Overlap for Faster LLM Inference Aditya K Kamath, Ramya Prabhu, Jayashree Mohan, Simon Peter, Ramachandran Ramjee, Ashish Panwar | Papier | |

TPI-LLM: Serving 70B-scale LLMs Efficiently on Low-resource Edge Devices Zonghang Li, Wenjiao Feng, Mohsen Guizani, Hongfang Yu | Github Papier | |

Efficient Arbitrary Precision Acceleration for Large Language Models on GPU Tensor Cores Shaobo Ma, Chao Fang, Haikuo Shao, Zhongfeng Wang | Papier | |

OPAL: Outlier-Preserved Microscaling Quantization A ccelerator for Generative Large Language Models Jahyun Koo, Dahoon Park, Sangwoo Jung, Jaeha Kung | Papier | |

| Accelerating Large Language Model Training with Hybrid GPU-based Compression Lang Xu, Quentin Anthony, Qinghua Zhou, Nawras Alnaasan, Radha R. Gulhane, Aamir Shafi, Hari Subramoni, Dhabaleswar K. Panda | Papier |

| Title & Authors | Einführung | Links |

|---|---|---|

| HELENE: Hessian Layer-wise Clipping and Gradient Annealing for Accelerating Fine-tuning LLM with Zeroth-order Optimization Huaqin Zhao, Jiaxi Li, Yi Pan, Shizhe Liang, Xiaofeng Yang, Wei Liu, Xiang Li, Fei Dou, Tianming Liu, Jin Lu | Papier | |

Robust and Efficient Fine-tuning of LLMs with Bayesian Reparameterization of Low-Rank Adaptation Ayan Sengupta, Vaibhav Seth, Arinjay Pathak, Natraj Raman, Sriram Gopalakrishnan, Tanmoy Chakraborty | Github Papier | |

MiLoRA: Efficient Mixture of Low-Rank Adaptation for Large Language Models Fine-tuning Jingfan Zhang, Yi Zhao, Dan Chen, Xing Tian, Huanran Zheng, Wei Zhu | Papier | |

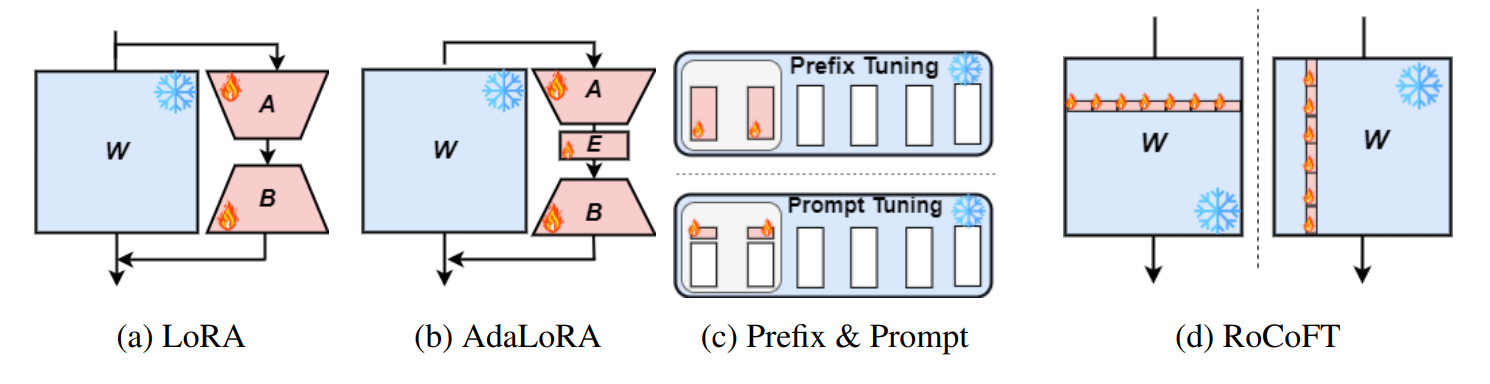

RoCoFT: Efficient Finetuning of Large Language Models with Row-Column Updates Md Kowsher, Tara Esmaeilbeig, Chun-Nam Yu, Mojtaba Soltanalian, Niloofar Yousefi |  | Github Papier |

Layer-wise Importance Matters: Less Memory for Better Performance in Parameter-efficient Fine-tuning of Large Language Models Kai Yao, Penlei Gao, Lichun Li, Yuan Zhao, Xiaofeng Wang, Wei Wang, Jianke Zhu | Github Papier | |

Parameter-Efficient Fine-Tuning of Large Language Models using Semantic Knowledge Tuning Nusrat Jahan Prottasha, Asif Mahmud, Md. Shohanur Islam Sobuj, Prakash Bhat, Md Kowsher, Niloofar Yousefi, Ozlem Ozmen Garibay | Papier | |

QEFT: Quantization for Efficient Fine-Tuning of LLMs Changhun Lee, Jun-gyu Jin, Younghyun Cho, Eunhyeok Park | Github Papier | |

BIPEFT: Budget-Guided Iterative Search for Parameter Efficient Fine-Tuning of Large Pretrained Language Models Aofei Chang, Jiaqi Wang, Han Liu, Parminder Bhatia, Cao Xiao, Ting Wang, Fenglong Ma | Github Papier | |

SparseGrad: A Selective Method for Efficient Fine-tuning of MLP Layers Viktoriia Chekalina, Anna Rudenko, Gleb Mezentsev, Alexander Mikhalev, Alexander Panchenko, Ivan Oseledets | Github Papier | |

| SpaLLM: Unified Compressive Adaptation of Large Language Models with Sketching Tianyi Zhang, Junda Su, Oscar Wu, Zhaozhuo Xu, Anshumali Shrivastava | Papier | |

Bone: Block Affine Transformation as Parameter Efficient Fine-tuning Methods for Large Language Models Jiale Kang | Github Papier | |

| Enabling Resource-Efficient On-Device Fine-Tuning of LLMs Using Only Inference Engines Lei Gao, Amir Ziashahabi, Yue Niu, Salman Avestimehr, Murali Annavaram |  | Papier |

| Title & Authors | Einführung | Links |

|---|---|---|

| AutoMixQ: Self-Adjusting Quantization for High Performance Memory-Efficient Fine-Tuning Changhai Zhou, Shiyang Zhang, Yuhua Zhou, Zekai Liu, Shichao Weng |  | Papier |

Scalable Efficient Training of Large Language Models with Low-dimensional Projected Attention Xingtai Lv, Ning Ding, Kaiyan Zhang, Ermo Hua, Ganqu Cui, Bowen Zhou | Github Papier | |

| Less is More: Extreme Gradient Boost Rank-1 Adaption for Efficient Finetuning of LLMs Yifei Zhang, Hao Zhu, Aiwei Liu, Han Yu, Piotr Koniusz, Irwin King | Papier | |

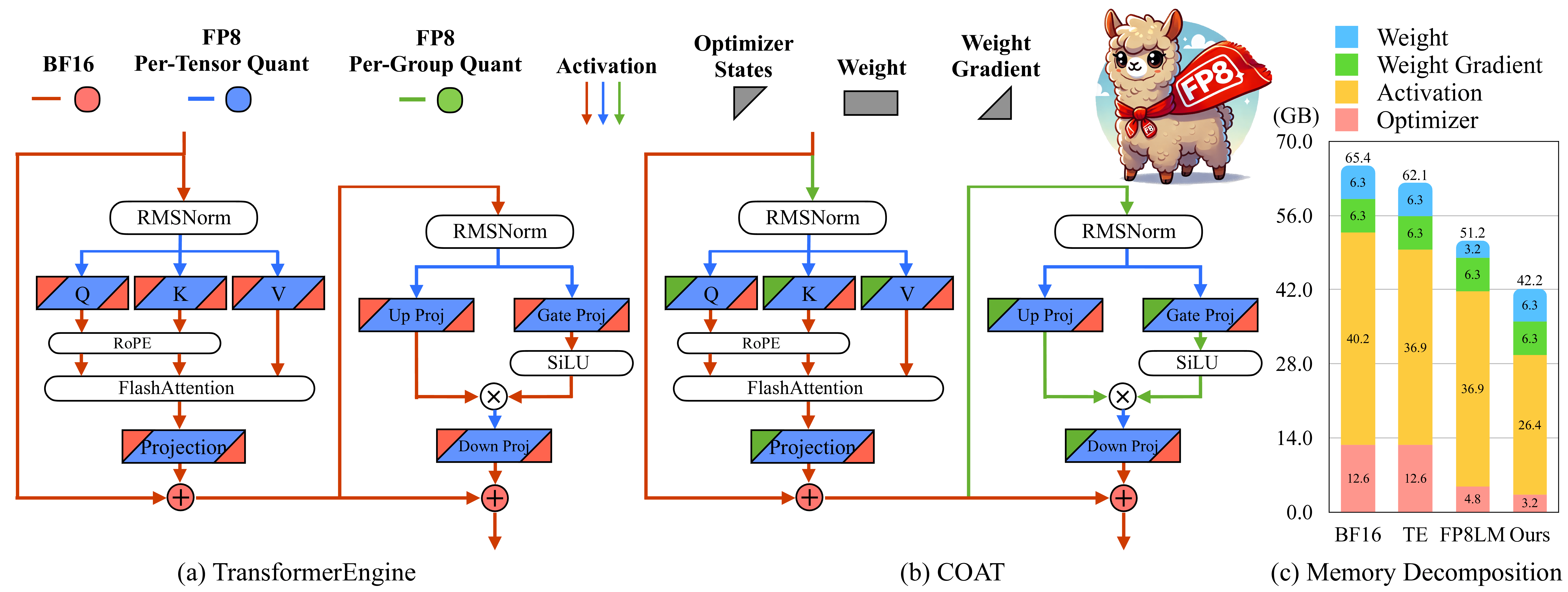

COAT: Compressing Optimizer states and Activation for Memory-Efficient FP8 Training Haocheng Xi, Han Cai, Ligeng Zhu, Yao Lu, Kurt Keutzer, Jianfei Chen, Song Han |  | Github Papier |

BitPipe: Bidirectional Interleaved Pipeline Parallelism for Accelerating Large Models Training Houming Wu, Ling Chen, Wenjie Yu |  | Github Papier |

| Title & Authors | Einführung | Links |

|---|---|---|

| Closer Look at Efficient Inference Methods: A Survey of Speculative Decoding Hyun Ryu, Eric Kim | Papier | |

LLM-Inference-Bench: Inference Benchmarking of Large Language Models on AI Accelerators Krishna Teja Chitty-Venkata, Siddhisanket Raskar, Bharat Kale, Farah Ferdaus et al | Github Papier | |

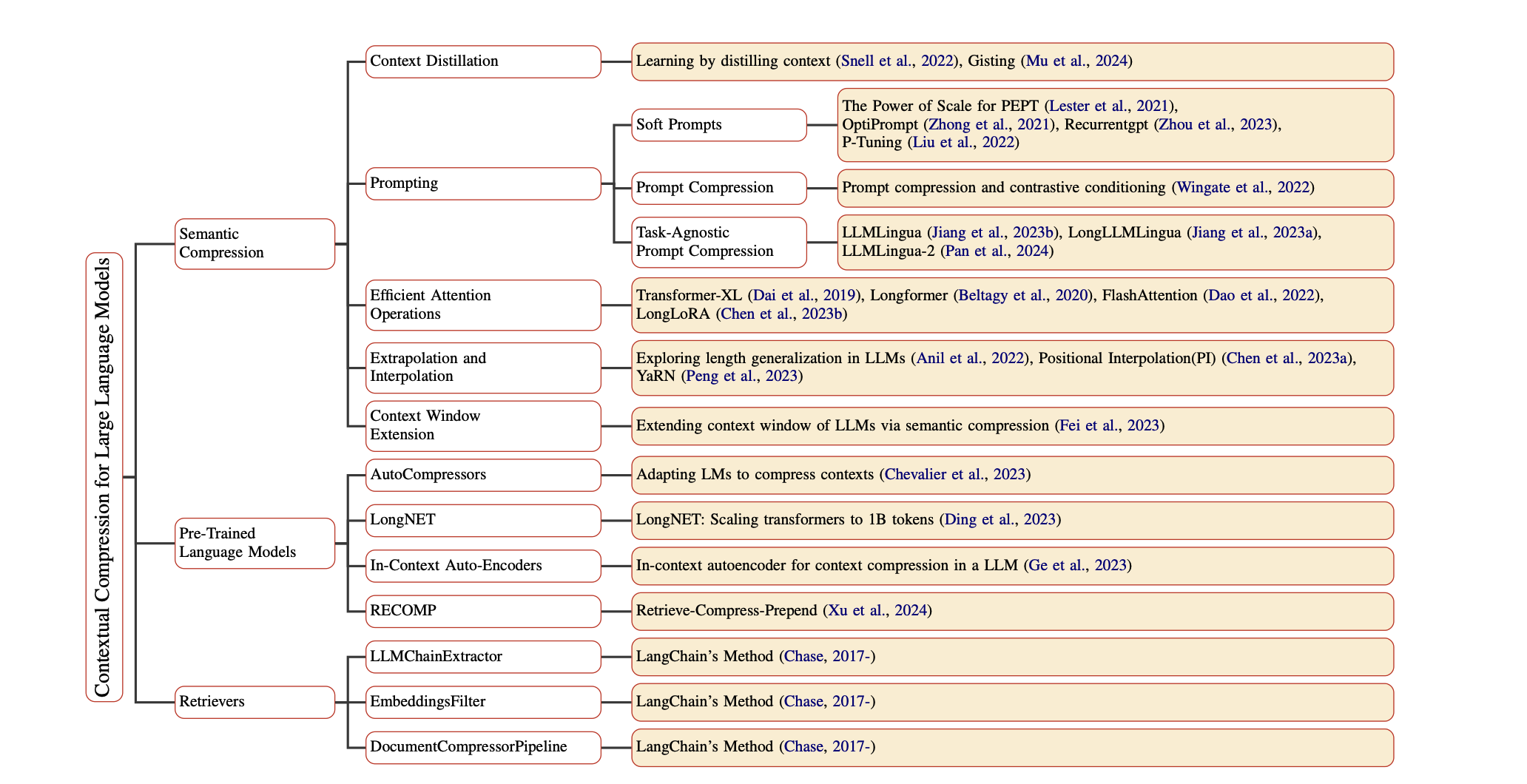

Prompt Compression for Large Language Models: A Survey Zongqian Li, Yinhong Liu, Yixuan Su, Nigel Collier | Github Papier | |

| Large Language Model Inference Acceleration: A Comprehensive Hardware Perspective Jinhao Li, Jiaming Xu, Shan Huang, Yonghua Chen, Wen Li, Jun Liu, Yaoxiu Lian, Jiayi Pan, Li Ding, Hao Zhou, Guohao Dai | Papier | |

| A Survey of Low-bit Large Language Models: Basics, Systems, and Algorithms Ruihao Gong, Yifu Ding, Zining Wang, Chengtao Lv, Xingyu Zheng, Jinyang Du, Haotong Qin, Jinyang Guo, Michele Magno, Xianglong Liu | Papier | |

Contextual Compression in Retrieval-Augmented Generation for Large Language Models: A Survey Sourav Verma |  | Github Papier |

| Art and Science of Quantizing Large-Scale Models: A Comprehensive Overview Yanshu Wang, Tong Yang, Xiyan Liang, Guoan Wang, Hanning Lu, Xu Zhe, Yaoming Li, Li Weitao | Papier | |

| Hardware Acceleration of LLMs: A comprehensive survey and comparison Nikoletta Koilia, Christoforos Kachris | Papier | |

| A Survey on Symbolic Knowledge Distillation of Large Language Models Kamal Acharya, Alvaro Velasquez, Houbing Herbert Song | Papier |