El proyecto ahora tiene una versión portátil, por lo que no tiene que tener la molestia de instalar todas las dependencias.

Haga clic aquí para descargar

No necesita nada más que Windows y una tarjeta gráfica NVIDIA con 6 GB de memoria de video para ejecutarla.

Inglés

ruso

Português

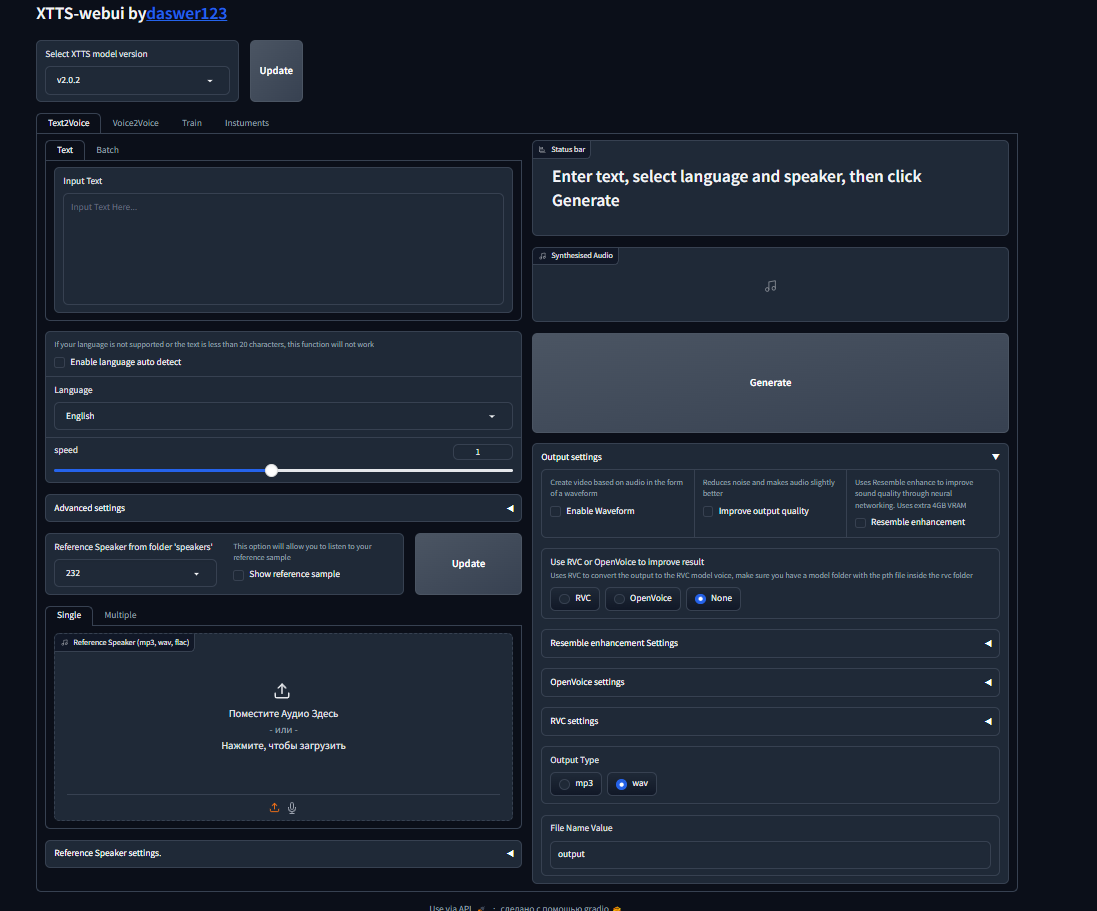

XTTS-Webui es una interfaz web que le permite aprovechar al máximo XTTS. Hay otras redes neuronales alrededor de esta interfaz que mejorarán sus resultados. También puede ajustar el modelo y obtener un modelo de voz de alta calidad.

Use esta interfaz de usuario web a través de Google Colab

Asegúrese de tener Python 3.10.x o Python 3.11, CUDA 11.8 o CUDA 12.1, Microsoft Builder Tools 2019 con el paquete C ++ y FFMPEG instalado

Para comenzar:

Para comenzar:

Siga estos pasos para la instalación:

Asegúrese de que CUDA esté instalado

Clone The Reposyory: git clone https://github.com/daswer123/xtts-webui

Navegue en el directorio: cd xtts-webui

Crear un entorno virtual: python -m venv venv

Active el entorno virtual:

venvscriptsactivatesource venvbinactivateInstale Pytorch y Torchaudio con el comando PIP:

pip install torch==2.1.1+cu118 torchaudio==2.1.1+cu118 --index-url https://download.pytorch.org/whl/cu118

Instale todas las dependencias de requisitos.txt:

pip install -r requirements.txt

Para iniciar la interfaz, siga estos pasos:

Active su entorno virtual:

venv/scripts/activateo si estás en Linux,

source venv/bin/activateLuego inicie el webUI para XTTS ejecutando este comando:

python app.pyAquí hay algunos argumentos de tiempo de ejecución que se pueden usar al comenzar la aplicación:

| Argumento | Valor predeterminado | Descripción |

|---|---|---|

| -hs, --host | 127.0.0.1 | El anfitrión para vincular a |

| -p, --port | 8010 | El número de puerto para escuchar |

| -d, --device | cuda | Qué dispositivo usar (CPU o CUDA) |

| -sf,-speaker_folder | altavoces/ | Directorio que contiene muestras TTS |

| -o,-salida | "producción/" | Directorio de salida |

| -l,-lenguaje | "auto" | Idioma de Webui, puede ver las traducciones disponibles en la carpeta I18N/Locale. |

| -Ms,-Fuente del modelo | "local" | Defina la fuente del modelo: 'API' para la última versión del repositorio, inferencia de API o 'local' para usar la inferencia local y el modelo v2.0.2 |

| -v, -versión | "v2.0.2" | Puede especificar qué versión de XTTS usar. Puede especificar el nombre del modelo personalizado para este propósito, coloque la carpeta en los modelos y especifique el nombre de la carpeta en este indicador. |

| --lowvram | Habilitar el modo VRAM bajo que cambia el modelo a RAM cuando no procesa activamente | |

| --profundidad | Habilite la aceleración de la velocidad profunda. Funciona en Windows en Python 3.10 y 3.11 | |

| --compartir | Permite compartir la interfaz fuera de la computadora local | |

| --RVC | Habilitar el procesamiento posterior a RVC, todos los modelos deben ubicarse en la carpeta RVC |

Módulo Para RVC, puede habilitar el módulo RVC para posterior al proceso recibido para esto, debe agregar el indicador - -RVC si se está ejecutando en la consola o escribirlo en el archivo de inicio

Para que el modelo funcione en la configuración de RVC, debe seleccionar un modelo que primero debe cargar en la carpeta Voice2Voice/RVC, el modelo y el archivo de índice deben estar juntos, el archivo de índice es opcional, cada modelo debe estar en una carpeta separada.