مسح SLM

دراسة شاملة لنماذج اللغة الصغيرة: التكنولوجيا ، وتطبيقات على الأجهزة ، والكفاءة ، والتحسينات لـ LLMS ، والجدارة بالثقة

يتضمن هذا الريبو الأوراق التي تمت مناقشتها في أحدث ورقة مسح لدينا حول نماذج اللغة الصغيرة.

اقرأ الورقة الكاملة هنا: الرابط الورقي

أخبار

- 2024/11/04: الإصدار الأول من استطلاعنا هو على Arxiv!

مرجع

إذا كان الاستطلاع الخاص بنا مفيدًا لبحثك ، فيرجى الاستشهاد بورقةنا:

@article{wang2024comprehensive,

title={A Comprehensive Survey of Small Language Models in the Era of Large Language Models: Techniques, Enhancements, Applications, Collaboration with LLMs, and Trustworthiness},

author={Wang, Fali and Zhang, Zhiwei and Zhang, Xianren and Wu, Zongyu and Mo, Tzuhao and Lu, Qiuhao and Wang, Wanjing and Li, Rui and Xu, Junjie and Tang, Xianfeng and others},

journal={arXiv preprint arXiv:2411.03350},

year={2024}

}

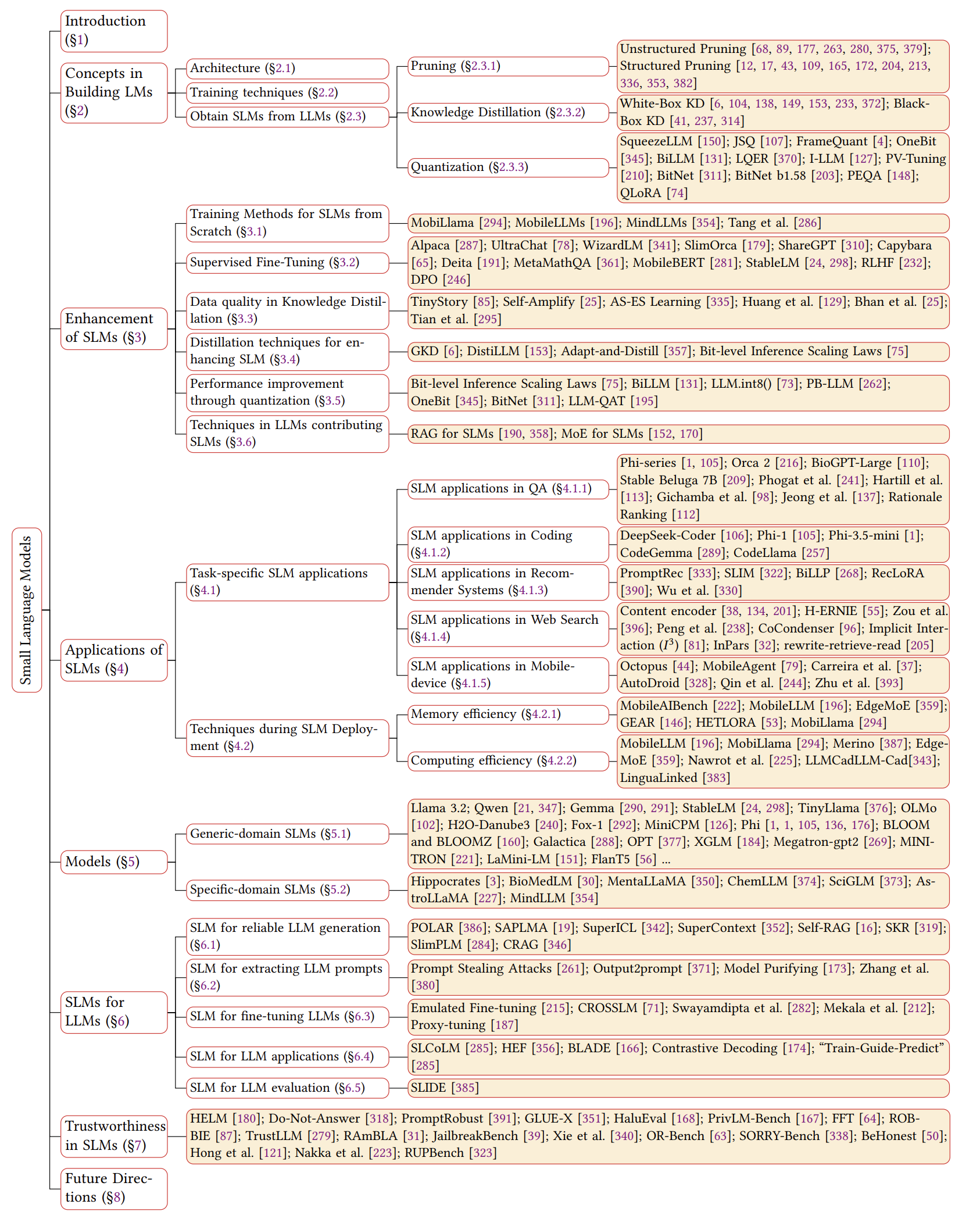

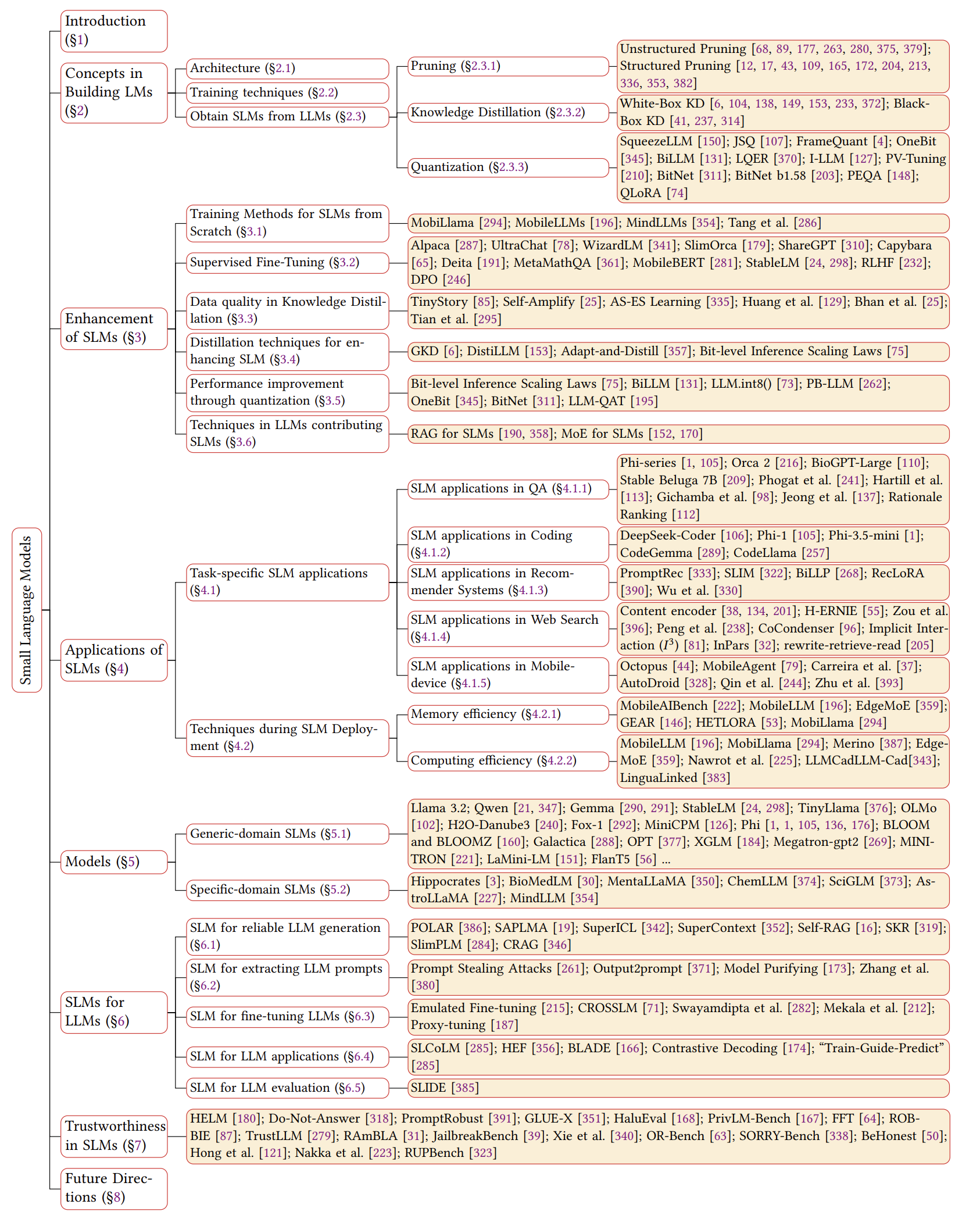

نظرة عامة على SLMs

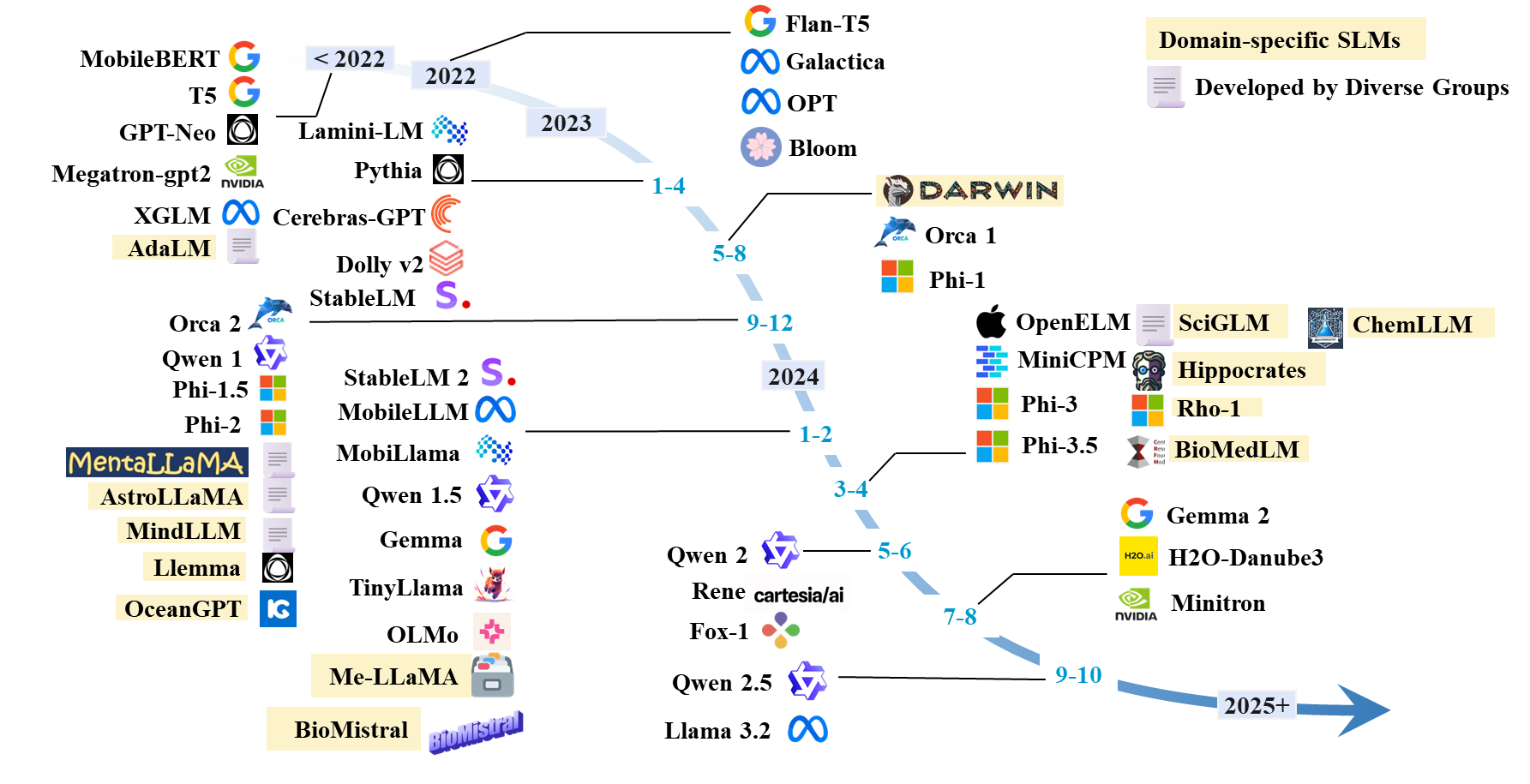

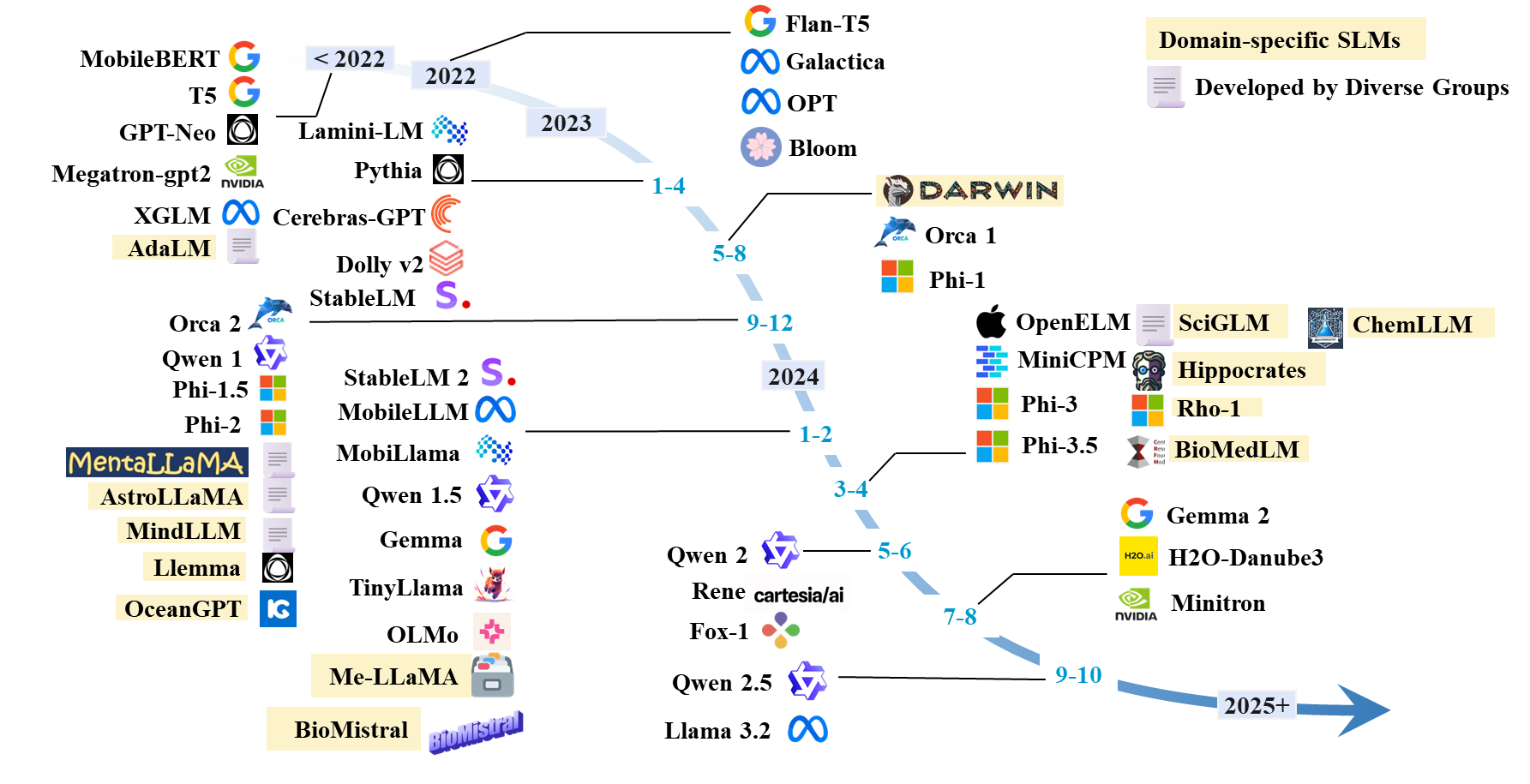

الجدول الزمني لـ SLMs

قائمة الورق SLMS

SLMs الحالية

| نموذج | #Params | تاريخ | نموذج | اِختِصاص | شفرة | نموذج HF | ورقة/مدونة |

|---|

| لاما 3.2 | 1 ب ؛ 3 ب | 2024.9 | قبل التدريب | نوعي | جيثب | HF | مدونة |

| Qwen 1 | 1.8 ب ؛ 7 ب ؛ 14 ب ؛ 72 ب | 2023.12 | قبل التدريب | نوعي | جيثب | HF | ورق |

| Qwen 1.5 | 0.5b 1.8 ب ؛ 4 ب. 7 ب ؛ 14 ب ؛ 32 ب ؛ 72 ب | 2024.2 | قبل التدريب | نوعي | جيثب | HF | ورق |

| Qwen 2 | 0.5b 1.5 ب ؛ 7 ب ؛ 57 ب ؛ 72 ب | 2024.6 | قبل التدريب | نوعي | جيثب | HF | ورق |

| Qwen 2.5 | 0.5b 1.5 ب ؛ 3 ب ؛ 7 ب ؛ 14 ب ؛ 32 ب ؛ 72 ب | 2024.9 | قبل التدريب | نوعي | جيثب | HF | ورق |

| جيما | 2 ب. 7 ب | 2024.2 | قبل التدريب | نوعي | | HF | ورق |

| جيما 2 | 2 ب. 9 ب ؛ 27 ب | 2024.7 | قبل التدريب | نوعي | | HF | ورق |

| H2O-Danube3 | 500 متر ؛ 4 ب | 2024.7 | قبل التدريب | نوعي | | HF | ورق |

| LLM-NEO | 1 ب | 2024.11 | التدريب المستمر | نوعي | | HF | ورق |

| فوكس -1 | 1.6 ب | 2024.6 | قبل التدريب | نوعي | | HF | مدونة |

| رينيه | 1.3 ب | 2024.5 | قبل التدريب | نوعي | | HF | ورق |

| minicpm | 1.2 ب ؛ 2.4 ب | 2024.4 | قبل التدريب | نوعي | جيثب | HF | ورق |

| أولمو | 1 ب ؛ 7 ب | 2024.2 | قبل التدريب | نوعي | جيثب | HF | ورق |

| Tinyllama | 1 ب | 2024.1 | قبل التدريب | نوعي | جيثب | HF | ورق |

| PHI-1 | 1.3 ب | 2023.6 | قبل التدريب | الترميز | | HF | ورق |

| PHI-1.5 | 1.3 ب | 2023.9 | قبل التدريب | نوعي | | HF | ورق |

| PHI-2 | 2.7 ب | 2023.12 | قبل التدريب | نوعي | | HF | ورق |

| PHI-3 | 3.8 ب ؛ 7 ب ؛ 14 ب | 2024.4 | قبل التدريب | نوعي | | HF | ورق |

| PHI-3.5 | 3.8 ب ؛ 4.2b ؛ 6.6b | 2024.4 | قبل التدريب | نوعي | | HF | ورق |

| Openelm | 270 م ؛ 450m ؛ 1.1 ب ؛ 3 ب | 2024.4 | قبل التدريب | نوعي | جيثب | HF | ورق |

| موبيلاما | 0.5b 0.8b | 2024.2 | قبل التدريب | نوعي | جيثب | HF | ورق |

| Mobilellm | 125m ؛ 350 متر | 2024.2 | قبل التدريب | نوعي | جيثب | HF | ورق |

| Stablelm | 3 ب ؛ 7 ب | 2023.4 | قبل التدريب | نوعي | جيثب | HF | ورق |

| Stablelm 2 | 1.6 ب | 2024.2 | قبل التدريب | نوعي | جيثب | HF | ورق |

| الدماغ-GPT | 111M-13B | 2023.4 | قبل التدريب | نوعي | | HF | ورق |

| بلوم ، بلومز | 560 م ؛ 1.1 ب ؛ 1.7 ب ؛ 3 ب ؛ 7.1b ؛ 176 ب | 2022.11 | قبل التدريب | نوعي | | HF | ورق |

| OPT | 125m ؛ 350 م ؛ 1.3 ب ؛ 2.7 ب ؛ 5.7b | 2022.5 | قبل التدريب | نوعي | | HF | ورق |

| XGLM | 1.7 ب ؛ 2.9b ؛ 7.5b | 2021.12 | قبل التدريب | نوعي | جيثب | HF | ورق |

| GPT-NEO | 125m ؛ 350 م ؛ 1.3 ب ؛ 2.7 ب | 2021.5 | قبل التدريب | نوعي | جيثب | | ورق |

| Megatron-GPT2 | 355 م ؛ 2.5 ب ؛ 8.3b | 2019.9 | قبل التدريب | نوعي | جيثب | | ورقة ، مدونة |

| Minitron | 4 ب. 8 ب. 15 ب | 2024.7 | التقليم والتقطير | نوعي | جيثب | HF | ورق |

| الحد الأدنى | 7 ب | 2024.7 | قبل التدريب | نوعي | جيثب | HF | ورق |

| الحد الأدنى 2 | 1 ب ؛ 3 ب | 2023.12 | قبل التدريب | نوعي | جيثب | HF | ورق |

| الحد الأدنى | 3 ب | 2023.11 | التقليم والتقطير | نوعي | جيثب | HF | ورق |

| orca 2 | 7 ب | 2023.11 | التقطير | نوعي | | HF | ورق |

| Dolly-V2 | 3 ب ؛ 7 ب ؛ 12 ب | 2023.4 | ضبط التعليمات | نوعي | جيثب | HF | مدونة |

| Lamini-LM | 61 م-7 ب | 2023.4 | التقطير | نوعي | جيثب | HF | مدونة |

| متخصص flant5 | 250 م ؛ 760 م ؛ 3 ب | 2023.1 | ضبط التعليمات | عام (الرياضيات) | جيثب | - | ورق |

| flant5 | 80M ؛ 250 م ؛ 780 م ؛ 3 ب | 2022.10 | ضبط التعليمات | نوعي | جهوب | HF | ورق |

| T5 | 60 م ؛ 220 م ؛ 770 م ؛ 3 ب ؛ 11 ب | 2019.9 | قبل التدريب | نوعي | جيثب | HF | ورق |

SLM العمارة

- المحول: الاهتمام هو كل ما تحتاجه. آشيش فاسواني . Neupips 2017.

- Mamba 1: Mamba: نمذجة تسلسل الوقت الخطي مع مسافات الحالة الانتقائية. ألبرت غو و تري داو . Colm 2024. [ورقة].

- MAMBA 2: المحولات هي SSMS: النماذج المعممة والخوارزميات الفعالة من خلال ازدواجية مساحة الدولة المنظمة. تري داو وألبرت غو . ICML 2024. [ورقة] [رمز]

تعزيز ل SLM

التدريب من الصفر

- Mobillama: "Mobillama: نحو GPT دقيقة وخفيفة الوزن تمامًا" . Omkar Thawakar ، Ashmal Vayani ، Salman Khan ، Hisham Cholakal ، Rao M. Anwer ، Michael Felsberg ، Tim Baldwin ، Eric P. Xing ، Fahad Shahbaz Khan. Arxiv 2024. [Paper] [Github] [Huggingface]

- Mobilellm: "Mobilellm: تحسين نماذج لغة المعلمة الفرعية للمليون لحالات استخدام الجهاز" . Zechun Liu ، Changsheng Zhao ، Forrest Iandola ، Chen Lai ، Yuandong Tian ، Igor Fedorov ، Yunyang Xiong ، Ernie Chang ، Yangyang Shi ، Raghuraman Krishnamoorthi ، Liangzhen Lai ، Vikas Chandra Icml 2024.

- إعادة التفكير في التحسين والهندسة المعمارية لنماذج اللغة الصغيرة. Yehui Tang ، Fangcheng Liu ، Yunsheng Ni ، Yuchuan Tian ، Zheyuan Bai ، Yi-Qi Hu ، Sichao Liu ، Shangling Jui ، Kai Han ، و Yunhe Wang. ICML 2024. [ورقة] [رمز]

- Mindllm: "Mindllm: نموذج لغة كبير خفيفة الوزن قبل التدريب من الصفر والتقييمات وتطبيقات المجال" . Yizhe Yang ، Huashan Sun ، Jiawei Li ، Runheng Liu ، Yinghao Li ، Yuhang Liu ، Heyan Huang ، Yang Gao . Arxiv 2023. [Paper] [Huggingface]

صقل خاضع للإشراف

- تحسين التفضيل المباشر: نموذج لغتك هو نموذج مكافأة سراً. رافائيل رافيلوف ، أرشت شارما ، إريك ميتشل ، كريستوفر دي مانينغ ، ستيفانو إيرمون ، وتشيلسي فين. Neupips ، 2024. [ورقة] [رمز]

- تعزيز نماذج لغة الدردشة عن طريق توسيع نطاق المحادثات التعليمية عالية الجودة. Ning Ding ، Yulin Chen ، Bokai Xu ، Yujia Qin ، Zhi Zheng ، Shengding Hu ، Zhiyuan Liu ، Maosong Sun ، و Bowen Zhou. EMNLP 2023. [ورقة] [رمز]

- Slimorca: مجموعة بيانات مفتوحة من آثار التفكير الفلان المعزز GPT-4 ، مع التحقق. Wing Lian ، Guan Wang ، Bleys Goodson ، Eugene Pentland ، Austin Cook ، Chanvichet Vong ، و "Teknium". Huggingface ، 2023. [البيانات]

- ستانفورد الألباكا: نموذج لاما يتبع التعليمات. روهان تاوري ، إيشان جولراجاني ، تيانيي تشانغ ، يان دوبوا ، شويشن لي ، كارلوس غوسترين ، بيرسي ليانغ ، وتاتسونوري ب. هاشيموتو. Github ، 2023. [Blog] [Github] [Huggingface]

- OpenChat: تقدم نماذج لغة مفتوحة المصدر مع بيانات مختلطة الجودة. Guan Wang ، Sijie Cheng ، Xianyuan Zhan ، Xiangang Li ، Sen Song ، Yang Liu. ICLR ، 2024. [Paper] [Code] [Huggingface]

- نماذج لغة التدريب لمتابعة التعليمات مع ردود الفعل البشرية. Long Ouyang ، Jeffrey Wu ، Xu Jiang ، Diogo Almeida ، Carroll Wainwright ، Pamela Mishkin ، Chong Zhang ، Sandhini Agarwal ، Katarina Slama ، Alex Ray ، John Schulman ، Jacob Hilton ، Fraser Kelton ، Luke Miller ، Maddie Simens ، ريان لوي. Neups ، 2022. [ورقة]

- RLHF: "نماذج لغة التدريب لمتابعة التعليمات مع التعليقات البشرية" . Long Ouyang ، Jeff Wu ، Xu Jiang ، Diogo Almeida ، Carroll L. Wainwright ، Pamela Mishkin ، Chong Zhang ، Sandhini Agarwal ، Katarina Slama ، Alex Ray ، John Schulman ، Jacob Hilton ، Fraser Kelton ، Luke Miller ، Maddie Simens ريان لوي. 2022. [ورقة]

- MobileBert: "MobileBert: BERT المدمج للمهمة المدمجة للأجهزة المحدودة للموارد" . Zhiqing Sun ، Hongkun Yu ، Xiaodan Song ، Renjie Liu ، Yiming Yang ، Denny Zhou. ACL 2020. [Paper] [Github] [Huggingface]

- نماذج اللغة هي متعلمين غير خاضعين للإشراف على المهام المتعددة. أليك رادفورد ، جيفري وو ، ريون تشايلد ، ديفيد لوان ، داريو أمودي ، إيليا سوتسكفر. مدونة Openai ، 2019. [ورقة]

جودة البيانات في KD

- TinyStory: "Tinystories: ما مدى صغر نماذج اللغة وما زالت تتحدث الإنجليزية المتماسكة؟" . رونين إلدان ، يوانزي لي. 2023. [ورقة] [Huggingface]

- AS-ES: "التعلم AS-ES: نحو التعلم السرير الكفاءة في نماذج صغيرة" . Nuwa XI ، Yuhan Chen ، Sendong Zhao ، Haochun Wang ، Bing Qin ، Ting Liu. 2024. [ورقة]

- التضخيم الذاتي: "تسخين ذاتي: تحسين نماذج اللغة الصغيرة مع تفسيرات ما بعد الذات" . ميلان بهان ، جان نويل فيتاو ، نيكولاس تشيسنو ، ماري جين ليوت. 2024. [ورقة]

- نماذج اللغة الكبيرة يمكن أن تضعف ذاتيا. Jiaxin Huang ، Shixiang Shane Gu ، Le Hou ، Yuexin Wu ، Xuezhi Wang ، Hongkun Yu ، and Jiawei Han. EMNLP 2023. [ورقة]

- نحو تحسين الذات لـ LLMS عبر الخيال والبحث والانتقاد. يي تيان ، باولين بينغ ، أغنية Linfeng ، Lifeng Jin ، Dian Yu ، Haitao MI ، و Dong Yu. Neups 2024. [ورقة] [رمز]

التقطير ل SLM

- GKD: "التقطير على الجودة لنماذج اللغة: التعلم من الأخطاء المولدة ذاتيا" . ريشاب أغاروال وآخرون. ICLR 2024. [ورقة]

- Distilllm: "Distillm: نحو تقطير مبسط لنماذج اللغة الكبيرة" . Jongwoo Ko et al. ICML 2024. [Paper] [Github]

- التكيف والانقراض: "التكيف والانقاذ: تطوير نماذج لغة صغيرة وسريعة وفعالة للمجالات" . يونزهي ياو وآخرون. ACL2021. [ورقة] [جيثب]

- AKL: "إعادة التفكير في تباعد Kullback-Leibler في تقطير المعرفة لنماذج اللغة الكبيرة" . Taiqiang Wu ، Chaofan Tao ، Jiahao Wang ، Runging Yang ، Zhe Zhao ، Ngai Wong. Arxiv 2024. [ورقة] [جيثب]

- التقطير المصاب بالوزن لضغوط Bert-Agnostic Agnostic Taiqiang Wu ، Cheng Hou ، Shanshan Lao ، Jiayi Li ، Ngai Wong ، Zhe Zhao ، Yujiu Yang Naacl ، 2024 ، [Paper] [Code]

الكمية

- SmoothQuant: "SmoothQuant: كمية دقيقة وفعالة بعد التدريب لنماذج اللغة الكبيرة" . Guangxuan Xiao ، Ji Lin ، Mickael Seznec ، Hao Wu ، Julien Demouth ، Song Han. ICML 2023. [Paper] [Github] [Slides] [Video]

- Billm: "Billm: دفع الحد من كمية ما بعد التدريب لـ LLMS" . Wei Huang ، Yangdong Liu ، Haotong Qin ، Ying Li ، Shiming Zhang ، Xianglong Liu ، Michele Magno ، Xiaojuan Qi. 2024. [ورقة] [جيثب]

- LLM-QAT: "LLM-QAT: تدريب الكميات الخالي من البيانات لنماذج اللغة الكبيرة" . Zechun Liu ، Barlas Oguz ، Changsheng Zhao ، Ernie Chang ، Pierre Stock ، Yashar Mehdad ، Yangyang Shi ، Raghuraman Krishnamoorthi ، Vikas Chandra. 2023. [ورقة]

- PB-LLM: "PB-LLM: نماذج لغوية كبيرة جزئيًا" . Zhihang Yuan ، Yuzhang Shang ، Zhen Dong. ICLR 2024. [ورقة] [جيثب]

- Onebit: "Onebit: نحو نماذج لغة كبيرة منخفضة البت للغاية" . Yuzhuang Xu ، Xu Han ، Zonghan Yang ، Shuo Wang ، Qingfu Zhu ، Zhiyuan Liu ، Weidong Liu ، Wanxiang Che. Neups 2024. [ورقة]

- Bitnet: "Bitnet: تحجيم محولات 1 بت لنماذج اللغة الكبيرة" . Hongyu Wang ، Shuming MA ، Li Dong ، Shaohan Huang ، Huaijie Wang ، Lingxiao MA ، Fan Yang ، Ruiping Wang ، Yi Wu ، Furu Wei. 2023. [ورقة]

- Bitnet B1.58: "عصر LLMs 1 بت: جميع نماذج اللغة الكبيرة في 1.58 بت" . Shuming MA ، Hongyu Wang ، Lingxiao MA ، Lei Wang ، Wenhui Wang ، Shaohan Huang ، Li Dong ، Ruiping Wang ، Jilong Xue ، Furu Wei. 2024. [ورقة]

- squeezellm : سيهون كيم ، كولمان هوبر ، أمير جهولامي ، تشن دونغ ، شيويو لي ، شنغ شين ، مايكل دبليو ماهوني ، كورت كيوتزر. ICML 2024. [Paper] [Github]

- JSQ: "ضغط نماذج اللغة الكبيرة عن طريق التباين المشترك والتكميلية" . Jinyang Guo ، Jianyu Wu ، Zining Wang ، Jiaheng Liu ، Ge Yang ، Yifu Ding ، Ruihao Gong ، Haotong Qin ، Xianglong Liu. ICML 2024. [Paper] [Github]

- Framequant: "Framequant: كمية منخفضة بتات مرنة للمحولات" . Harshavardhan Adepu ، Zhanpeng Zeng ، Li Zhang ، Vikas Singh. 2024. [ورقة] [جيثب]

- Billm: "Billm: دفع الحد من كمية ما بعد التدريب لـ LLMS" . Wei Huang ، Yangdong Liu ، Haotong Qin ، Ying Li ، Shiming Zhang ، Xianglong Liu ، Michele Magno ، Xiaojuan Qi. 2024. [ورقة] [جيثب]

- LQER: "LQER: إعادة بناء خطأ كمية منخفضة الرتبة لـ LLMS" . تشنغ تشانغ ، جياني تشنغ ، جورج أ. كونستانتينيدس ، يرين تشاو. ICML 2024. [Paper] [Github]

- I-LLM: "I-LLM: الاستدلال الصحيح الفعال فقط لنماذج لغة كبيرة منخفضة الأجزاء كافية بالكامل" . Xing Hu ، Yuan Cheng ، Dawei Yang ، Zhihang Yuan ، Jiangyong Yu ، Chen Xu ، Sifan Zhou. 2024. [ورقة] [جيثب]

- الضبع الكهروضوئي: "التثبيت الكهروضوئي: ما وراء التقدير المباشر لضغط LLM المتطرف" . فلاديمير مالينوفسكي ، دينيس مازور ، إيفان إيلين ، دينيس كوزنفيليف ، كونستانتين بيرلاشينكو ، كاي يي ، دان أليستاره ، بيتر ريتشتاريك. 2024. [ورقة]

- PEQA: "صقل دقيق للذاكرة لنماذج اللغة الكبيرة المضغوطة عبر كمية عدد صحيح Sub-4 بت" . Jeonghoon Kim ، Jung Hyun Lee ، Sungdong Kim ، Joonsuk Park ، Kang Min Yoo ، Se Jung Kwon ، Dongsoo Lee. NIPS 2023. [ورقة]

- qlora: "qlora: عملية فنية فعالة من LLMs الكمية" . Tim Dettmers ، Artidoro Pagnoni ، Ari Holtzman ، Luke Zettlemoyerauthors info & ادعاءات. NIPS 2023. [ورقة] [جيثب]

تقنيات LLM لـ SLMS

- MA et al.: "نموذج اللغة الكبيرة ليس مستخرجًا جيدًا من المعلومات ، ولكنه Reranker جيدًا للعينات الصعبة!" . Yubo MA ، Yixin Cao ، Yongching Hong ، Aixin Sun. EMNLP 2023. [ورقة] [github]

- MOQE: "مزيج من الخبراء الكميين (MOQE): التأثير التكميلي للكميات المنخفضة والمتانة" . يونغ جين كيم ، رافي فهيم ، هاني حسن عوادالا. 2023. [ورقة]

- SLM-RAG: "هل يمكن أن تحل النماذج اللغوية الصغيرة ذات الجيل المتمثل في الاسترداد محل نماذج لغة كبيرة عند تعلم علوم الكمبيوتر؟" . Suqing Liu ، Zezhu Yu ، Feiran Huang ، Yousef Bulbulia ، Andreas Bergen ، Michael Liut. iticse 2024. [ورقة]

تطبيقات SLM الخاصة بالمهمة

SLM في QA

- الألبكة: "الألبكة: نموذج قوي للتربية القابل للتكرار" . روهان تاوري ، إيشان جولراجاني ، تيانيي تشانغ ، يان دوبوا ، شويشن لي ، كارلوس غوسترين ، بيرسي ليانغ ، تاتسونوري ب. هاشيموتو. 2023.

- مستقر Beluga 7B: "مستقر Beluga 2" . ماهان وداكوتا وكارلو وريان وكاستيرو ، لويس وكوبر ، ناثان ولافورت ، كريستيان. 2023. [Huggingface]

- Biogpt Guo et al.: "تحسين نماذج اللغة الصغيرة على PubMedQA عبر زيادة البيانات التوليدية" . Zhen Guo ، Peiqi Wang ، Yanwei Wang ، Shangdi Yu. 2023. [ورقة]

- SLMs المالية: "صياغة نماذج لغة أصغر للإجابة على المستندات المالية" . Karmvir Singh Phogat Karmvir Singh Phogat ، Sai Akhil Puranam ، Sridhar Dasaratha ، Chetan Harsha ، Shashishekar Ramakrishna. 2024. [ورقة]

- كولبيرت: "كولبيرت استرجاع وسجل الاستجابة لاستجابة اللغة الإجابة على أسئلة نموذج اللغة" . أليكس جيتشامبا ، تودروس كيدريرالا إدريس ، براين إبيو ، إريك نيبرغ ، تيروكو ميتامورا. IEEE 2024. [ورقة]

- T-SAS: "اختبار النماذج اللغوية ذاتية التكيف مع الإجابة على الأسئلة" . Soyeong Jeong ، Jinheon Baek ، Sukmin Cho ، Sung Hwang ، Jong Park. ACL 2023. [ورقة] [جيثب]

- ترتيب الأساس المنطقي: "الإجابة على الأسئلة غير المرئية مع نماذج لغة أصغر باستخدام توليد الأساس المنطقي واسترجاع كثيف" . تيم هارتيل ، ديانا بينافيدز-برادو ، مايكل ويبروك ، باتريشيا ج. ريدل. 2023. [ورقة]

SLM في الترميز

- PHI-3.5-MINI: "التقرير الفني PHI-3: نموذج لغة قادر للغاية محليًا على هاتفك" . ماراه عبدان ، جيوتي أنيجا ، هاني عودالا ، أحمد عودا الله ، عمار أحمد عوان ، نغوين باخ ، أميت باهري ، أراش باختياري ، جيانمين باو ، هاركيرات بيهل ، ... 2024. [ورقة] [Huggingface] [موقع ويب]

- Tinyllama: "Tinyllama: نموذج لغة صغير مفتوح المصدر" . Peiyuan Zhang ، Guangtao Zeng ، Tianduo Wang ، Wei Lu. 2024.

- Codellama: "Code Llama: Open Foundation Models for Code" . Baptiste Rozière ، Jonas Gehring ، Fabian Gloeckle ، Sten Sootla ، Itai Gat ، Xiaoqing Ellen Tan ، Yossi Adi ، Jingyu Liu ، Romain Sauvestre ، ST Remez ، ... 2024. [ورقة] [Huggingface]

- CodeGemma: "CodeGemma: Open Code Models على أساس Gemma" . فريق Codegemma: Heri Zhao ، Jeffrey Hui ، Joshua Howland ، Nam Nguyen ، Siqi Zuo ، Andrea Hu ، Christopher A. Choquette-Choo ، Jingyue Shen ، Joe Kelley ، Kshitij Bansal ، ... ، Kathy Korevec ، Kelly Schaefer ، Scott. 2024. [ورقة] [Huggingface]

SLM في التوصية

- PROMPTREC: "هل يمكن أن تعمل نماذج اللغة الصغيرة كتوصيات؟ تجاه توصيات البداية الباردة التي تركز على البيانات" . Xuansheng Wu ، Huachi Zhou ، Yucheng Shi ، Wenlin Yao ، Xiao Huang ، Ninghao Liu. 2024. [ورقة] [جيثب]

- Slim: "هل يمكن أن تكون نماذج اللغة الصغيرة أسبابًا جيدة للتوصية المتسلسلة؟" . Yuling Wang ، Changxin Tian ، Binbin Hu ، Yanhua Yu ، Ziqi Liu ، Zhiqiang Zhang ، Jun Zhou ، Liang Pang ، Xiao Wang. 2024. [ورقة]

- بيلب: "نماذج اللغة الكبيرة هي مخططي قابلة للتعلم للحصول على توصية طويلة الأجل" . Wentao Shi ، Xiangnan He ، Yang Zhang ، Chongming Gao ، Xinyue Li ، Jizhi Zhang ، Qifan Wang ، Fuli Feng. 2024. [ورقة]

- مرة واحدة: "مرة واحدة: تعزيز التوصية القائمة على المحتوى مع كل من نماذج اللغة الكبيرة المفتوحة والمغلقة" . Qijiong Liu ، Nuo Chen ، Tetsuya Sakai ، Xiao-Ming Wu. WSDM 2024. [ورقة] [github]

- RECLORA: "التكيف المخصص مدى الحياة منخفضة الرتبة لنماذج اللغة الكبيرة للتوصية" . Jiachen Zhu ، Jianghao Lin ، Xinyi Dai ، Bo Chen ، Rong Shan ، Jieming Zhu ، Ruiming Tang ، Yong Yu ، Weinan Zhang. 2024. [ورقة]

SLM في البحث على شبكة الإنترنت

- تشفير المحتوى: "مهام التدريب قبل التدريب لدمج الاسترجاع على نطاق واسع" . Wei-Cheng Chang ، Felix X. Yu ، Yin-Wen Chang ، Yiming Yang ، Sanjiv Kumar. ICLR 2020. [ورقة]

- أجهزة البوليت: "أدوات البوليات: بنيات المحولات واستراتيجيات ما قبل التدريب لتسجيل متعدد الحواس سريع ودقيق" . صموئيل همو ، كورت شوستر ، ماري آن لاشوكس ، جيسون ويستون. ICLR 2020. [ورقة]

- التوأم بيرت: "Twinbert: تقطير المعرفة لنماذج Bert ذاتية منظمة لاسترجاعها الفعالة" . Wenhao Lu ، Jian Jiao ، Ruofei Zhang. 2020. [ورقة]

- H-ernie: "H-ernie: نموذج لغة متعددة الحجبات مسبقًا للبحث عن الويب" . Xiaokai Chu ، Jiashu Zhao ، Lixin Zou ، Dawei Yin. Sigir 2022. [ورقة]

- رانكر: "مرور إعادة التصنيف مع بيرت" . رودريغو نوجيرا ، كيونغيون تشو. 2019. [ورقة] [جيثب]

- Rewriter: "استعلام إعادة كتابة نماذج اللغة الكبيرة التي تم التغلب عليها" . Xinbei MA ، Yeyun Gong ، Pengcheng He ، Hai Zhao ، Nan Duan. EMNLP2023. [ورقة] [جيثب]

SLM في الجهاز المحمول

- الأخطبوط: "الأخطبوط: نموذج لغة على الجهاز لاستدعاء وظيفة واجهات برمجة تطبيقات البرامج" . Wei Chen ، Zhiyuan Li ، Mingyuan MA. 2024. [ورقة] [Huggingface]

- MobiLeAgent: "Mobile-Agent-V2: مساعد تشغيل الأجهزة المحمولة مع التنقل الفعال عبر تعاون متعدد الوكلاء" . Junyang Wang ، Haiyang Xu ، Haitao Jia ، Xi Zhang ، Ming Yan ، Weizhou Shen ، Ji Zhang ، Fei Huang ، Jitao Sang. 2024. [ورقة] [github] [Huggingface]

- إحداث ثورة في التفاعل عبر الهاتف المحمول: "إحداث ثورة في التفاعل عبر الهاتف المحمول: تمكين 3 مليارات معلمة GPT LLM على الهاتف المحمول" . صموئيل كارريرا ، توماس ماركيز ، خوسيه ريبيرو ، كارلوس جريلو. 2023. [ورقة]

- التلقائي: "Autodroid: أتمتة المهام التي تعمل بزعم LLM في Android" . Hao Wen ، Yuanchun Li ، Guohong Liu ، Shanhui Zhao ، Tao Yu ، Toby Jia-Jun Li ، Shiqi Jiang ، Yunhao Liu ، Yaqin Zhang ، Yunxin Liu. 2023. [ورقة]

- وكيل على الجهاز لإعادة كتابة النص: "نحو وكيل على الجهاز لإعادة كتابة النص" . يون تشو ، يينسيا ليو ، فيليكس ستالبرغ ، شانكار كومار ، يو هوي تشن ، ليانغشن لوو ، لي شو ، رينجي ليو ، جيندونغ تشن ، لي مينغ. 2023. [ورقة]

تقنيات تحسين نشر الجهاز

تحسين كفاءة الذاكرة

- Edge-LLM: "Edge-LLM: تمكين تكيف نموذج اللغة الكبير الفعال على أجهزة الحافة عبر الضغط الموحد للطبقة وضبط الطبقة التكيفية والتصويت" . Zhongzhi Yu ، Zheng Wang ، Yuhan Li ، Haoran You ، Ruijie Gao ، Xiaoya Zhou ، Sreenidhi Reedy Bommu ، Yang Katie Zhao ، Yingyan Celine Lin. 2024. [ورقة] [جيثب]

- LLM-PQ: "LLM-PQ: خدمة LLM على مجموعات غير متجانسة مع قسم مدرك للمرحلة والكمية التكيفية" . Juntao Zhao ، Borui Wan ، Yanghua Peng ، Haibin Lin ، Chuan Wu. 2024. [ورقة] [جيثب]

- AWQ: "AWQ: كمية وزن التنشيط لضغط LLM والتسارع" . Ji Lin ، Jiaming Tang ، Haotian Tang ، Shang Yang ، Wei-Ming Chen ، Wei-Chen Wang ، Guangxuan Xiao ، Xingyu Dang ، Chuang Gan ، Song Han. MLSYS 2024. [ورقة] [جيثب]

- MobileAibench: "Mobileaibench: المعايير LLMs و LMMS لحالات استخدام الجهاز" . Rithesh Murthy ، Liangwei Yang ، Juntao Tan ، Tulika Manoj Awalgaonkar ، Yilun Zhou ، Shelby Heinecke ، Sachin Desai ، Jason Wu ، Ran Xu ، Sarah ، Jianguo Zhang ، Zhiwei Liu ، Shirley Kokan Silvio Savaresel. 2024. [ورقة] [جيثب]

- Mobilellm: "Mobilellm: تحسين نماذج لغة المعلمة الفرعية للمليون لحالات استخدام الجهاز" . Zechun Liu ، Changsheng Zhao ، Forrest Iandola ، Chen Lai ، Yuandong Tian ، Igor Fedorov ، Yunyang Xiong ، Ernie Chang ، Yangyang Shi ، Raghuraman Krishnamoorthi ، Liangzhen Lai ، Vikas Chandra. ICML 2024. [Paper] [Github] [Huggingface]

- Edgemoe: "Edgemoe: Fast On Device Inference لنماذج اللغة الكبيرة القائمة على Moe" . Rongjie Yi ، Liwei Guo ، Shiyun Wei ، Ao Zhou ، Shangguang Wang ، Mengwei Xu. 2023. [ورقة] [جيثب]

- التروس: "الترس: وصفة فعالة لضغط ذاكرة التخزين المؤقت KV للاستدلال التوليدي شبه الخسارة لـ LLM" . Hao Kang ، Qingru Zhang ، Souvik Kundu ، Geonhwa Jeong ، Zaoxing Liu ، Tushar Krishna ، Tuo Zhao. 2024. [ورقة] [جيثب]

- DMC: "ضغط الذاكرة الديناميكي: التعديل التحديثي LLMs للاستدلال المتسارع" . Piotr Nawrot ، Adrian łańcucki ، Marcin Chochowski ، David Tarjan ، Edoardo M. Ponti. 2024. [ورقة]

- Transformer-Lite: "Transformer-Lite: نشر عالي الكفاءة لنماذج اللغة الكبيرة على وحدات معالجة الرسومات الهاتف المحمول" . Luchang Li ، Sheng Qian ، Jie Lu ، Lunxi Yuan ، Rui Wang ، Qin Xie. 2024. [ورقة]

- LLMAAS: "LLM كخدمة نظام على الأجهزة المحمولة" . Wangsong Yin ، Mengwei Xu ، Yuanchun Li ، Xuanzhe Liu. 2024. [ورقة]

تحسين كفاءة وقت التشغيل

- Edgemoe: "Edgemoe: Fast On Device Inference لنماذج اللغة الكبيرة القائمة على Moe" . Rongjie Yi ، Liwei Guo ، Shiyun Wei ، Ao Zhou ، Shangguang Wang ، Mengwei Xu. 2023. [ورقة] [جيثب]

- LLMCAD: "llmcad: سريع وقابل للتطوير على الجهاز الاستدلال النموذج اللغة" . Daliang Xu ، Wangsong Yin ، Xin Jin ، Ying Zhang ، Shiyun Wei ، Mengwei Xu ، Xuanzhe Liu. 2023. [ورقة]

- Lingualinked: "Lingualinked: نظام استنتاج نموذج لغة كبير موزع للأجهزة المحمولة" . Junchen Zhao ، Yurun Song ، Simeng Liu ، Ian G. Harris ، Sangeetha Abdu Jyothi. 2023 [ورقة]

SLMS تعزيز LLMS

SLMS لمعايرة LLM والكشف عن الهلوسة

- معايرة نماذج اللغة الكبيرة باستخدام أجيالها فقط. دينيس أولمر ، مارتن جوبري ، هواران لي ، سانغدو يون ، سيونغ جون أوه . ACL 2024 Long ، [PDF] [رمز]

- باريتو التعلم الأمثل لتقدير أخطاء نموذج اللغة الكبيرة. ثيودور تشاو ، مو وي ، ج. صموئيل بريستون ، هيفونج بون . ACL 2024 Long ، [PDF]

- تعرف الحالة الداخلية لـ LLM متى تكذب. عاموس أزاريا ، توم ميتشل . نتائج EMNLP 2023. [PDF]

- وكيل صغير يمكن أيضا صخرة! تمكين نماذج اللغة الصغيرة ككاشف الهلوسة. Xiaoxue Cheng ، Junyi Li ، Wayne Xin Zhao ، Hongzhi Zhang ، Fuzheng Zhang ، Di Zhang ، Kun Gai ، Ji-Rong Wen. EMNLP 2024 طويلة. [PDF]

- إعادة تكوين LLMs من منظور فقدان التجميع. Lihu Chen ، Alexandre Perez-Lebel ، Fabian M. Suchanek ، Gaël Varoquaux. نتائج EMNLP 2024. [PDF]

SLMS لـ LLM RAG

- النماذج الصغيرة ، الرؤى الكبيرة: الاستفادة من نماذج الوكيل النحيفة لتحديد متى وماذا لاسترداد LLMs. Jiejun Tan ، Zhicheng Dou ، Yutao Zhu ، Peidong Guo ، Kun Fang ، Ji-Rong Wen. ACL 2024 طويل. [PDF] [رمز] [Huggingface]

- الرفق الذاتي: تعلم استرداد وتوليد ونقد من خلال التفكير الذاتي. Akari Asai ، Zeqiu Wu ، Yizhong Wang ، Avirup Sil ، Hannaneh Hajishirzi. ICLR 2024 عن طريق الفم. [PDF] [Huggingface] [رمز] [موقع ويب] [نموذج] [بيانات]

- Longllmlingua: تسريع وتعزيز LLMs في سيناريوهات السياق الطويل عبر ضغط سريع. Huiqiang Jiang ، Qianhui Wu ، Xufang Luo ، Dongsheng Li ، Chin-Yew Lin ، Yuqing Yang ، Lili Qiu. ICLR 2024 ورشة عمل ملصق ME-FOMO. [PDF]

- استرجاع التصحيحية الجيل المعزز. Shi-Qi Yan ، Jia-Chen Gu ، Yun Zhu ، Zhen-Hua Ling. Arxiv 2024.1. [PDF] [رمز]

- المعرفة الذاتية موجهة زيادة الاسترجاع لنماذج اللغة الكبيرة. ييل وانغ ، بينغ لي ، موسونج صن ، يانغ ليو. نتائج EMNLP 2023. [PDF] [رمز]

- نماذج اللغة التي يتم استرجاعها في السياق. Ori Ram ، Yoav Levine ، Itay Dalmedigos ، Dor Muhlgay ، Amnon Shashua ، Kevin Leyton-Brown ، Yoav Shoham. TACL 2023. [PDF] [رمز]

- RA-ISS: تعلم الإجابة والفهم من زيادة الاسترجاع من خلال التغذية الذاتية التكرارية. Liu ، Yanming and Peng ، Xinyue and Zhang ، Xuhong and Liu ، Weihao and Yin ، Jianwei and Cao ، Jiannan and Du ، Tianyu. ACL 2024 النتائج. [PDF]

- أقل هو أكثر: جعل نماذج اللغة الأصغر مسترجعة مختصة من أجل multi-hop {KGQA}. Wenyu Huang ، Guancheng Zhou ، Hongru Wang ، Pavlos Vougiouklis ، Mirella Lapata ، Jeff Z. Pan. نتائج EMNLP 2024. [PDF]

SLMS لمنطق LLM

- Canwen Xu و Yichong Xu و Shuohang Wang و Yang Liu و Chenguang Zhu و Julian Mcauley. النماذج الصغيرة هي المكونات الإضافية القيمة لنماذج اللغة الكبيرة. ACL 2024 النتائج. [PDF]

- Linyi Yang ، Shuibai Zhang ، Zhuohao Yu ، Guangsheng Bao ، Yidong Wang ، Jindong Wang ، Ruochen Xu ، Wei Ye ، Xing Xie ، Weizhu Chen ، and Yue Zhang. المعرفة الخاضعة للإشراف تجعل نماذج اللغة الكبيرة أفضل متعلمين في السياق. ملصق ICLR 2024. [PDF]

- Zhuofeng Wu ، He Bai ، Aonan Zhang ، Jiatao Gu ، VG Vydiswaran ، Navdeep Jaitly ، و Yizhe Zhang. تقسيم أو قهر؟ أي جزء يجب أن تقطير LLM الخاص بك؟ نتائج EMNLP 2024. [PDF]

SLMS لتخفيف حقوق الطبع والنشر وخصوصية LLMS

- Tianlin Li و Qian Liu و Tianyu Pang و Chao Du و Qing Guo و Yang Liu و Min Lin. تنقية نماذج اللغة الكبيرة عن طريق فرقة نموذج لغة صغيرة. Arxiv 2024. [PDF]

SLMS لاستخراج مطالبات LLM

- Yiming Zhang و Nicholas Carlini و Daphne Ippolito. استخراج فوري فعال من نماذج اللغة. Colm 2024 [PDF]

- زيانغ شا ويانغ تشانغ. سرقة فوري هجمات ضد نماذج اللغة الكبيرة. Arxiv (2024). [PDF]

- كولين تشانغ ، جون س موريس ، وفيتالي شمواتيكوف. استخراج المطالبات عن طريق قلب مخرجات LLM. [PDF]

SLMs لضبط LLMS

- إريك ميتشل ، رافائيل رافيلوف ، أرشت شارما ، تشيلسي فين ، وكريستوفر دي مانينغ. 2024. محاكي لصقل نماذج اللغة الكبيرة باستخدام نماذج لغة صغيرة. ICLR 2024. [PDF]

- أليسا ليو ، Xiaochuang Han ، Yizhong Wang ، Yulia Tsvetkov ، Yejin Choi ، و Noah A Smith. 2024. نماذج لغة ضبط بالوكالة. Colm 2024. [PDF]

- Dheeraj Mekala ، Alex Nguyen ، و Jingbo Shang. 2024. نماذج لغة أصغر قادرة على اختيار بيانات تدريب تعليمات لتصنيع التعليمات لنماذج اللغة الأكبر. ACL 2024 النتائج. [PDF]

- Yongheng Deng و Ziqing Qiao و Ju Ren و Yang Liu و Yaoxue Zhang. 2023. التحسين المتبادل لنماذج اللغة الكبيرة والصغيرة مع نقل المعرفة عبر silo. Arxiv 2023. [PDF]

- Smalltolarge (S2L): اختيار البيانات القابلة للتطوير لضبط نماذج اللغة الكبيرة من خلال تلخيص مسارات التدريب للنماذج الصغيرة. يو يانغ · سيدهارثا ميشرا · جيفري تشيانغ NIPS 2024 ملصق. [PDF]

- البحث الضعيف إلى القوي: محاذاة نماذج لغة كبيرة من خلال البحث على نماذج اللغة الصغيرة. Zhanhui Zhou · Zhixuan Liu · Jie Liu · Zhichen Dong · Chao Yang · Yu Qiao. NIPS 2024 ملصق. [PDF]

SLMS لسلامة LLM

- حارس Llama: حماية مدخلات مخرجات قائمة على LLM لمحادثات Human-AA. Meta Arxiv 2024 [PDF]

- SLM كما الوصي: سلامة AI الرائدة مع نموذج اللغة الصغيرة. Ohjoon Kwon ، Donghyeon Jeon ، Nayoung Choi ، Gyu-Hwung Cho ، Hwiyeol Jo ، Changbong Kim ، Hyunwoo Lee ، Inho Kang ، Sun Kim ، Taiwoo Park. EMNLP 2024. [PDF]

SLM لتقييم LLM

- كون تشاو ، بوهاو يانغ ، تشن تانغ ، تشنغوا لين ، وليانغ تشان . 2024. الشريحة: إطار عمل دمج نماذج لغة صغيرة وكبيرة لتقييم حوارات المجال المفتوح . ACL 2024 النتائج. [PDF]

- عدم اليقين الدلالي: الثنائي اللغوي لتقدير عدم اليقين في توليد اللغة الطبيعية. لورينز كون ، يارين جال ، سيباستيان فاركوهار. ICLR 2023. [PDF]

- SelfCheckGPT: اكتشاف الهلوسة صفر صفر الصندوق الأسود لنماذج اللغة الكبيرة التوليدية. Potsawee Manakul ، Adian Liusie ، Mark Gales. EMNLP 2023 الرئيسية. [PDF]

- ProxylM: التنبؤ بأداء نموذج اللغة على المهام متعددة اللغات عبر نماذج الوكيل. ديفيد أنوغراها ، جنتا إندرا ويناتا ، تشينيو لي ، باتريك أماديوس إيروان ، تري آني لي. Arxiv 2024. [PDF]

- FactScore: التقييم الذري ذو الحبيبات الدقيقة للدقة الواقعية في توليد النصوص الطويلة. Sewon Min ، Kalpesh Krishna ، Xinxi Lyu ، Mike Lewis ، Wen-Tau Yih ، Pang Koh ، Mohit Iyyer ، Luke Zettlemoyer ، Hannaneh Hajishirzi. EMNLP 2023 الرئيسية. [PDF]

- انظر قبل أن تقفز: دراسة استكشافية لقياس عدم اليقين لنماذج اللغة الكبيرة. Yuheng Huang ، Jiayang Song ، Zhijie Wang ، Shengming Zhao ، Huaming Chen ، Felix Juefei-Xu ، Lei Ma Arxiv 2023. [PDF]

تاريخ النجوم