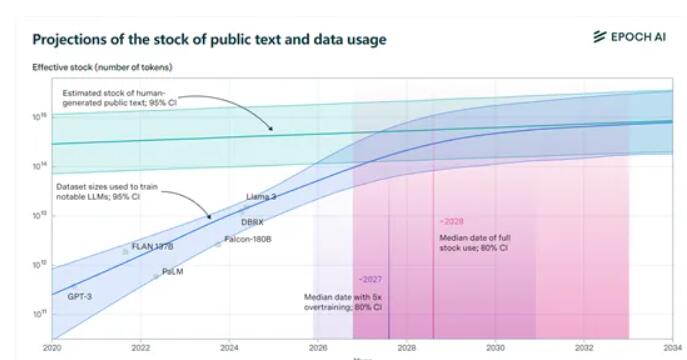

Epochai機構發布的最新報告指出,全球公開的高品質文字訓練資料集將在未來幾年內被大型語言模型耗盡。報告預測,在2026年到2032年間,現有的約300兆tokens的數據將被用完,而模型的「過度訓練」更是加速了這一進程。 Meta的Llama3 8B版本的過度訓練就達到了驚人的100倍,如果所有模型都採用這種方式,數據可能在2025年就會耗盡。面對即將到來的“數據荒”,Epochai機構提出了四種潛在的解決方案,為人工智慧領域的數據獲取提供了新的方向。

研究人員特別指出,「過度訓練」是加速消耗訓練資料的罪魁禍首。例如Meta最新開源的Llama3,8B版本的過度訓練竟然達到了驚人的100倍!如果所有模型都這麼玩,咱們的數據可能在2025年就得說拜拜了。

但別急,咱們還有招。 Epoch ai給了四種獲取訓練資料的新方法,讓AI界的「資料荒」不再是夢魘。

1)合成數據: 就像用料理包做出的大餐,合成數據利用深度學習模擬真實數據,產生全新的數據。但別高興太早,合成資料的品質可能參差不齊,容易過度擬合,缺乏真實文字的細微語言特徵。

2)多模態與跨領域資料學習: 這種方法不僅限於文本,還包括圖像、視訊、音訊等多種資料類型。就像在KTV裡,不僅能唱,還能跳,還能演,多模態學習讓模型更全面地理解和處理複雜任務。

3)私有資料: 目前全球文字資料的私有總量大約是3100萬億tokens,是公開資料的10倍多!但使用私有資料得小心翼翼,畢竟隱私和安全性是大事。而且,取得和整合非公共資料的過程可能非常複雜。

4)與真實世界即時互動學習: 讓模型透過與真實世界的直接互動來學習和進步。這種方法要求模型具備自主性和適應性,能夠準確地理解使用者指令,並在現實世界中採取行動。

Epochai提出的這四種方法,各有優劣,也面臨不同的挑戰。未來,如何有效解決數據問題,將直接影響人工智慧技術的發展和應用。 這需要科學研究人員和產業界共同努力,探索更有效的資料取得和利用方式,才能確保人工智慧持續健康發展。